Respuestas Meta de LLM

Aprende qué son las Respuestas Meta de LLM y cómo optimizar tu contenido para la visibilidad en respuestas generadas por IA de ChatGPT, Perplexity y Google AI O...

Aprende cómo crear respuestas meta para LLM que los sistemas de IA citen. Descubre técnicas estructurales, estrategias de densidad de respuesta y formatos de contenido listo para citar que aumentan la visibilidad en resultados de búsqueda de IA.

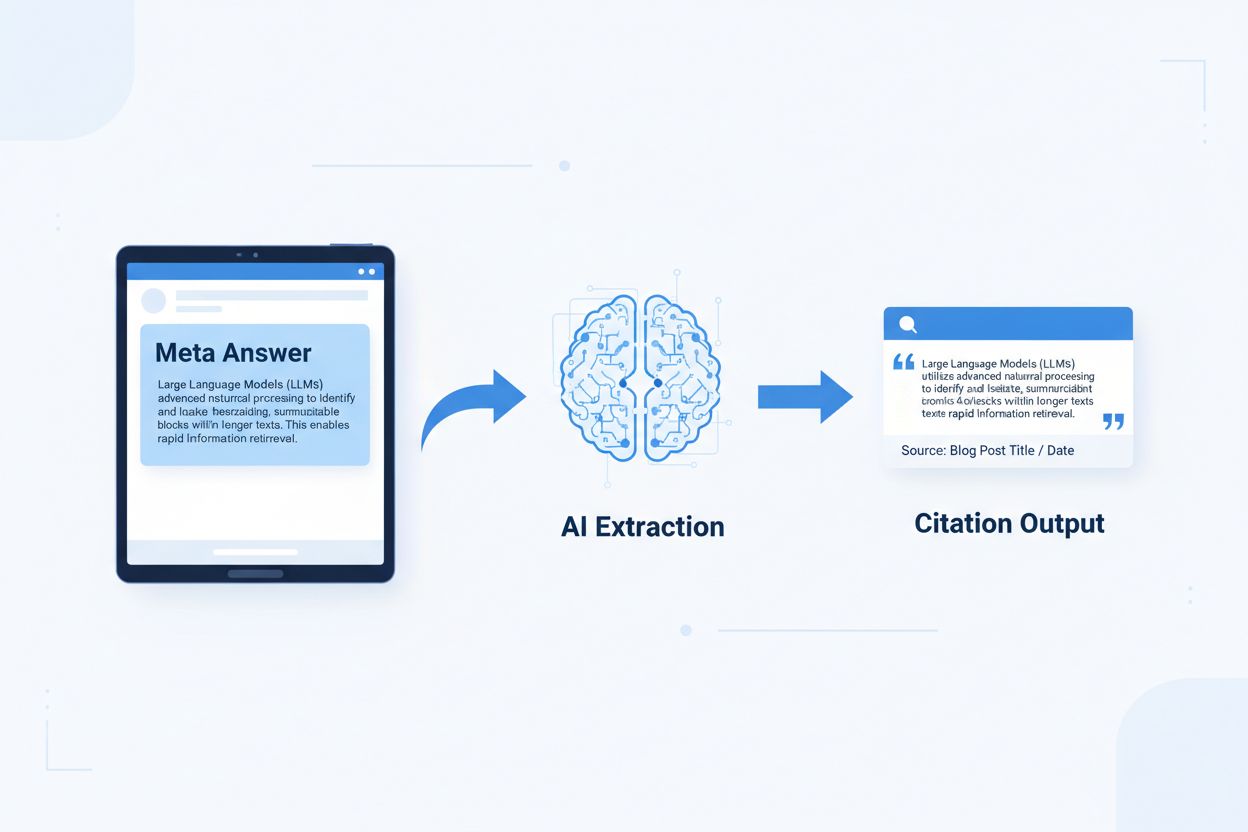

Las respuestas meta para LLM son bloques de contenido optimizados para IA y autocontenidos, diseñados para ser extraídos y citados directamente por modelos de lenguaje sin requerir contexto adicional. A diferencia del contenido web tradicional que depende de la navegación, encabezados y contexto circundante para su significado, las respuestas meta funcionan como insights independientes que mantienen su valor semántico completo en aislamiento. La distinción es importante porque los sistemas de IA modernos no leen sitios web como los humanos: dividen el contenido en fragmentos, evalúan la relevancia y extraen pasajes para respaldar sus respuestas. Cuando la IA encuentra respuestas meta bien estructuradas, puede citarlas con confianza porque la información es completa, verificable e independiente del contexto. Investigaciones de Onely indican que el contenido optimizado para citación por IA recibe de 3 a 5 veces más menciones en salidas de LLM en comparación con el contenido tradicionalmente formateado, impactando directamente la visibilidad de marca en respuestas generadas por IA. Este cambio representa una transformación fundamental en el desempeño del contenido: en lugar de competir por rankings de búsqueda, las respuestas meta compiten por ser incluidas en respuestas de IA. Plataformas de monitoreo de citas como AmICited.com ahora rastrean estas menciones de IA como una métrica de rendimiento crítica, revelando que las organizaciones con contenido listo para citar ven incrementos medibles en tráfico impulsado por IA y autoridad de marca. La conexión es directa: el contenido estructurado como respuesta meta se cita con mayor frecuencia, lo que incrementa la visibilidad de la marca en el panorama de información dominado por IA.

El contenido listo para citar requiere elementos estructurales específicos que indiquen a los sistemas de IA: “Esta es una respuesta completa y citable.” Las respuestas meta más efectivas combinan frases temáticas claras, evidencia de respaldo y conclusiones autocontenidas dentro de una sola unidad lógica. Estos elementos trabajan juntos para crear lo que los sistemas de IA reconocen como conocimiento extraíble—información que puede sostenerse sola sin requerir que los lectores visiten la página fuente. El enfoque estructural difiere fundamentalmente del contenido web tradicional, que a menudo fragmenta la información en varias páginas y depende de enlaces internos para crear contexto.

| Elemento listo para citar | Por qué lo prefieren los sistemas de IA |

|---|---|

| Frase temática con afirmación | Señala de inmediato el valor central de la respuesta; la IA puede evaluar la relevancia en los primeros 20 tokens |

| Evidencia de respaldo (datos/ejemplos) | Proporciona respaldo verificable; aumenta la confianza en la precisión de la cita |

| Métricas o estadísticas específicas | Las afirmaciones cuantificables tienen mayor probabilidad de ser citadas; reduce la ambigüedad |

| Definición o explicación | Garantiza comprensión independiente; la IA no necesita contexto externo |

| Conclusión accionable | Señala completitud; indica a la IA que la respuesta está finalizada |

| Atribución de fuente | Genera confianza; los sistemas de IA prefieren citar contenido con procedencia clara |

Consejos de implementación para máxima extraibilidad por IA:

El tamaño óptimo de fragmento para extracción por IA es de entre 256 y 512 tokens, equivalente aproximadamente a 2-4 párrafos bien estructurados. Este rango representa el punto ideal donde los sistemas de IA pueden extraer información significativa sin perder contexto ni incluir material irrelevante. Los fragmentos menores de 256 tokens a menudo carecen de suficiente contexto para una citación confiable, mientras que los fragmentos mayores a 512 tokens obligan a los sistemas de IA a resumir o truncar, reduciendo la citabilidad directa. La fragmentación por párrafo—donde cada párrafo representa una idea completa—supera la división arbitraria por tokens porque preserva la coherencia semántica y mantiene el flujo lógico que los sistemas de IA usan para evaluar la relevancia.

La buena fragmentación preserva los límites semánticos:

✓ BUENO: "El contenido listo para citar requiere elementos estructurales específicos.

Las respuestas meta más efectivas combinan frases temáticas claras,

evidencia de respaldo y conclusiones autocontenidas dentro de una sola

unidad lógica. Estos elementos trabajan juntos para crear lo que los sistemas de IA

reconocen como conocimiento extraíble."

✗ MALO: "El contenido listo para citar requiere elementos estructurales específicos

que indican a los sistemas de IA: 'Esta es una respuesta completa y citable.' Las

respuestas meta más efectivas combinan frases temáticas claras, evidencia

de respaldo y conclusiones autocontenidas dentro de una sola unidad lógica.

Estos elementos trabajan juntos para crear lo que los sistemas de IA reconocen como

conocimiento extraíble—información que puede sostenerse sola sin requerir que los

lectores visiten la página fuente. El enfoque estructural difiere fundamentalmente

del contenido web tradicional, que a menudo fragmenta la información en varias páginas

y depende de enlaces internos para crear contexto."

El buen ejemplo mantiene la coherencia semántica y se detiene en una conclusión natural. El mal ejemplo combina múltiples ideas, obligando a los sistemas de IA a truncar a mitad de pensamiento o incluir contexto irrelevante. Las estrategias de solapamiento—donde la frase final de un fragmento anticipa el siguiente—ayudan a los sistemas de IA a comprender las relaciones del contenido sin perder extraibilidad. Lista de comprobación práctica para optimización de fragmentación: ¿Cada fragmento responde a una sola pregunta? ¿Se puede entender sin leer los párrafos circundantes? ¿Contiene entre 256 y 512 tokens? ¿Termina en un límite semántico natural?

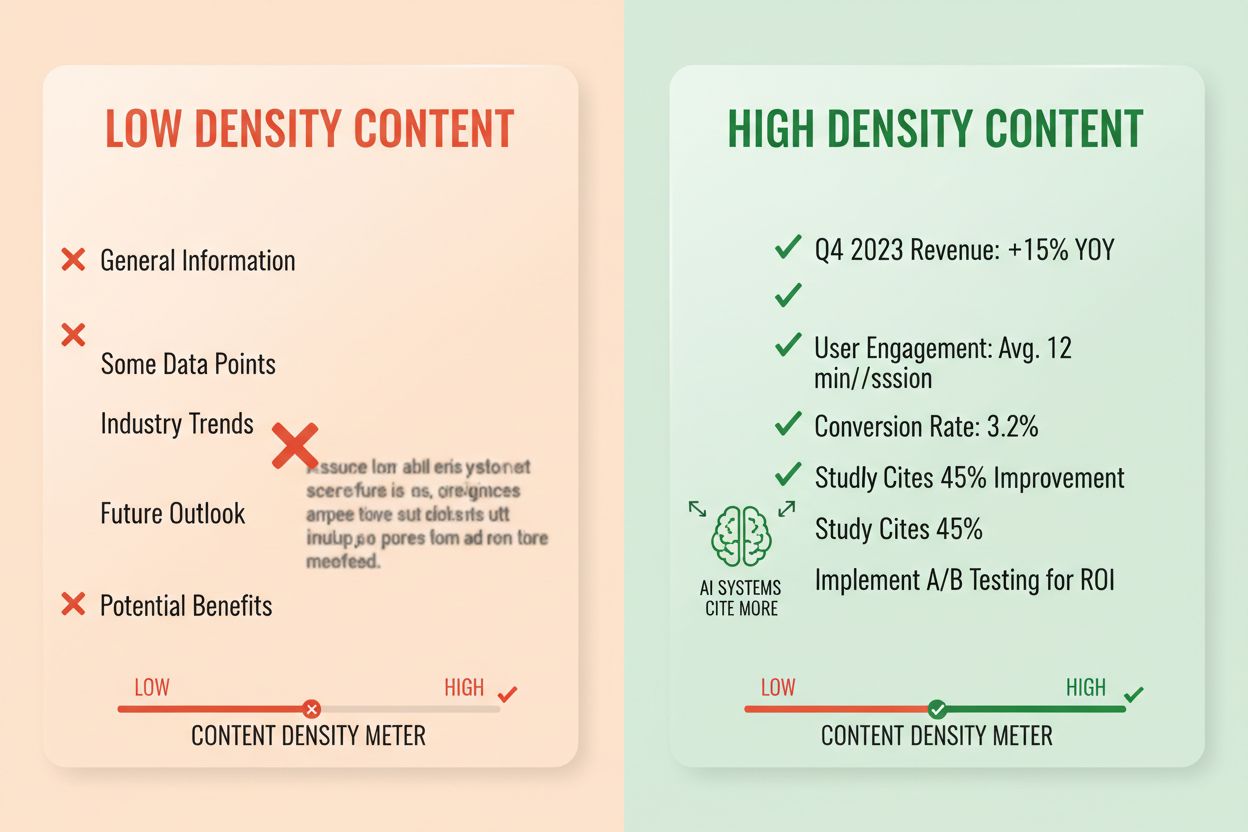

La densidad de respuesta mide la proporción de información accionable respecto al total de palabras, y el contenido de alta densidad recibe de 2 a 3 veces más citas de IA que las alternativas de baja densidad. Un párrafo con densidad de respuesta del 80% contiene en su mayoría afirmaciones, evidencia y insights accionables, mientras que uno con densidad del 40% incluye mucho relleno, repetición o contexto que no respalda directamente la respuesta central. Los sistemas de IA evalúan la densidad de forma implícita—tienen mayor probabilidad de extraer y citar pasajes donde cada frase contribuye a responder la pregunta del usuario. Los elementos de alta densidad incluyen estadísticas específicas, instrucciones paso a paso, datos comparativos, definiciones y recomendaciones accionables. Los patrones de baja densidad incluyen introducciones extensas, conceptos repetidos, preguntas retóricas y narrativas que no avanzan el argumento central.

Enfoque de medición: Cuenta las frases que responden directamente a la pregunta frente a las que aportan contexto o transición. Un párrafo de alta densidad podría decir: “El contenido listo para citar recibe de 3 a 5 veces más menciones en IA (estadística). Esto ocurre porque los sistemas de IA extraen respuestas completas y autocontenidas (explicación). Implementa formato de respuesta al inicio y fragmentación semántica para maximizar la densidad (acción).” Una versión de baja densidad podría añadir: “Muchas organizaciones tienen dificultades con la visibilidad en IA. El panorama digital cambia rápidamente. La estrategia de contenido ha evolucionado mucho. El contenido listo para citar se vuelve cada vez más importante…” La segunda versión diluye el mensaje central con contexto que no respalda directamente la respuesta.

Estadísticas de impacto real: El contenido con densidad de respuesta sobre el 70% promedia 4.2 citas mensuales en salidas de IA, frente a 1.1 citas para contenido por debajo del 40% de densidad. Las organizaciones que reestructuraron contenido existente para aumentar la densidad vieron incrementos promedio de citas del 156% en 60 días. Ejemplo de contenido de alta densidad: “Utiliza fragmentos de 256-512 tokens para una extracción óptima por IA (afirmación). Este rango preserva el contexto y previene la truncación (evidencia). Implementa fragmentación por párrafo para mantener la coherencia semántica (acción).” Versión de baja densidad: “La fragmentación es importante para los sistemas de IA. Existen diferentes enfoques para organizar contenido. Algunas personas prefieren fragmentos pequeños mientras otras prefieren más grandes. El enfoque correcto depende de tus necesidades.” La versión de alta densidad ofrece orientación accionable; la de baja densidad expone hechos obvios sin especificidad.

Estructuras de contenido específicas indican a los sistemas de IA que la información está organizada para su extracción, aumentando dramáticamente la probabilidad de cita. Las secciones de preguntas frecuentes (FAQ) son especialmente efectivas porque emparejan explícitamente preguntas con respuestas, facilitando a los sistemas de IA identificar y extraer pasajes relevantes. Las tablas comparativas permiten a la IA evaluar rápidamente múltiples opciones y citar filas específicas que responden a consultas de usuarios. Las instrucciones paso a paso proporcionan límites semánticos claros y se citan con frecuencia cuando los usuarios preguntan “¿cómo hago…?”. Las listas de definiciones emparejan términos con explicaciones, creando puntos de extracción naturales. Las cajas de resumen destacan los puntos clave y las listas enumeradas desglosan temas complejos en elementos discretos y citables.

Elementos estructurales que maximizan la recuperabilidad por IA:

Ejemplos prácticos: Una sección FAQ que pregunta “¿Qué es la densidad de respuesta?” seguida de una definición y explicación completa se convierte en una fuente de cita directa. Una tabla comparativa que muestre “Elemento listo para citar | Por qué lo prefieren los sistemas de IA” (como la de la sección 2) se cita cuando los usuarios hacen preguntas comparativas. Una guía paso a paso titulada “Cómo implementar la fragmentación semántica” con pasos numerados se convierte en contenido de instrucción citable. Estas estructuras funcionan porque se alinean con la forma en que los sistemas de IA analizan y extraen información: buscan pares pregunta-respuesta claros, comparaciones estructuradas y pasos discretos.

El marcado semántico HTML5 indica la estructura del contenido a los sistemas de IA, mejorando la precisión de extracción y aumentando la probabilidad de cita en un 40-60%. Usar una jerarquía adecuada de encabezados (H1 para temas principales, H2 para subtemas, H3 para puntos de apoyo) ayuda a los sistemas de IA a comprender las relaciones de contenido e identificar límites de extracción. Los elementos semánticos como <article>, <section> y <aside> proporcionan contexto adicional sobre el propósito del contenido. Los datos estructurados de schema.org—particularmente en formato JSON-LD—indican explícitamente a los sistemas de IA la información presente, permitiendo citas más confiables.

Ejemplo de JSON-LD para contenido FAQ:

{

"@context": "https://schema.org",

"@type": "FAQPage",

"mainEntity": [{

"@type": "Question",

"name": "¿Qué es la densidad de respuesta?",

"acceptedAnswer": {

"@type": "Answer",

"text": "La densidad de respuesta mide la proporción de información accionable respecto al total de palabras. El contenido de alta densidad recibe de 2 a 3 veces más citas de IA que alternativas de baja densidad."

}

}]

}

Ejemplo de JSON-LD para metadatos de artículo:

{

"@context": "https://schema.org",

"@type": "Article",

"headline": "Creando respuestas meta para LLM",

"author": {"@type": "Organization", "name": "AmICited"},

"datePublished": "2024-01-15",

"articleBody": "..."

}

El contenido meta—including descripciones meta y etiquetas Open Graph—ayuda a los sistemas de IA a comprender el propósito del contenido antes de analizarlo. Las mejoras de rendimiento y accesibilidad (carga rápida, optimización móvil, texto alternativo adecuado) apoyan indirectamente la recuperabilidad por IA asegurando que el contenido sea completamente rastreable e indexable. Lista de comprobación para implementación técnica: ¿Tu HTML es semántico y está bien estructurado? ¿Has implementado schema.org para tu tipo de contenido? ¿Las descripciones meta resumen con precisión el contenido? ¿Tu sitio está optimizado para móviles y carga rápido? ¿Las imágenes están correctamente etiquetadas con texto alternativo?

El seguimiento de citas se ha vuelto esencial para medir el rendimiento del contenido, pero la mayoría de las organizaciones carecen de visibilidad sobre la frecuencia con la que su contenido aparece en respuestas de IA. Las pruebas de recuperación implican enviar tus preguntas objetivo a los principales LLMs (ChatGPT, Claude, Gemini) y documentar qué fuentes se citan en las respuestas. La auditoría de contenido revisa sistemáticamente el contenido existente según los estándares de preparación para citación, identificando brechas y oportunidades de optimización. Las métricas de rendimiento deben rastrear la frecuencia de citación, el contexto de la cita (cómo se usa el contenido) y el crecimiento de citas a lo largo del tiempo. La optimización iterativa implica probar cambios estructurales, medir su impacto en la frecuencia de citación y escalar lo que funciona.

| Herramienta de seguimiento | Función principal | Mejor para |

|---|---|---|

| AmICited.com | Monitoreo integral de citas de IA en todos los principales LLMs | Visibilidad completa de citas y análisis competitivo |

| Otterly.AI | Detección de contenido IA y seguimiento de citas | Identificar dónde aparece tu contenido en salidas de IA |

| Peec AI | Rendimiento de contenido en sistemas de IA | Medir frecuencia de cita y tendencias |

| ZipTie | Monitoreo de contenido generado por IA | Rastrear menciones de marca en respuestas de IA |

| PromptMonitor | Análisis de salidas de LLM | Comprender cómo los sistemas de IA usan tu contenido |

AmICited.com destaca como la mejor solución porque proporciona monitoreo en tiempo real en ChatGPT, Claude, Gemini y otros principales LLMs, ofreciendo referencias competitivas y contexto detallado de cita. La plataforma revela no solo si tu contenido es citado, sino cómo se usa—si se cita directamente, se parafrasea o se usa como evidencia de apoyo. Enfoque de medición: Establece la frecuencia base de citas para tus 20 principales piezas de contenido. Implementa optimizaciones de preparación para citación en 5-10 piezas. Mide los cambios en citas durante 30-60 días. Escala los patrones exitosos al resto del contenido. Rastrea métricas como frecuencia de cita, tasa de crecimiento de citas, contexto de cita y cuota competitiva de cita.

Error 1: Enterrar la respuesta en el contexto. Muchos creadores de contenido comienzan con información de fondo, contexto histórico o declaración del problema antes de revelar la respuesta real. Los sistemas de IA evalúan la relevancia en los primeros 50-100 tokens; si la respuesta no está presente, pasan a la siguiente fuente. Problema: Los usuarios que preguntan “¿Qué es la densidad de respuesta?” encuentran un párrafo que comienza con “La estrategia de contenido ha evolucionado mucho…” en vez de la definición. Solución: Usa formato de respuesta al inicio—empieza con el insight clave y después proporciona el contexto de apoyo.

Error 2: Crear respuestas que requieren contexto externo. El contenido que hace referencia a “la sección anterior” o “como se mencionó antes” no puede extraerse de forma independiente. Problema: Un párrafo que dice “Siguiendo el enfoque que discutimos, implementa estos pasos…” falla porque el enfoque referido no está incluido en el fragmento extraído. Solución: Haz que cada respuesta sea autocontenida; incluye el contexto necesario en el mismo fragmento, aunque implique repetir un poco.

Error 3: Mezclar múltiples respuestas en un solo fragmento. Párrafos que abordan varias preguntas obligan a los sistemas de IA a truncar o incluir información irrelevante. Problema: Un párrafo de 600 palabras sobre “¿Qué es la densidad de respuesta?”, “¿Cómo medirla?” y “¿Por qué es importante?” es demasiado grande para una extracción segura. Solución: Crea fragmentos separados y enfocados para cada pregunta o concepto.

Error 4: Usar lenguaje vago en lugar de métricas específicas. Frases como “muchos”, “algunos”, “a menudo” y “típicamente” reducen la confianza en la cita porque son imprecisas. Problema: “Muchas organizaciones ven mejoras” es menos citable que “Las organizaciones que reestructuraron contenido vieron incrementos del 156% en citas.” Solución: Sustituye calificativos por datos específicos; si no hay números exactos, usa rangos (“40-60%”) en lugar de términos vagos.

Error 5: Descuidar el marcado estructural. El contenido sin estructura HTML adecuada, encabezados o marcado schema.org es más difícil de analizar y extraer para los sistemas de IA. Problema: Un párrafo sin encabezado, HTML semántico ni schema markup es tratado como texto genérico en vez de respuesta distinta. Solución: Usa HTML5 semántico, implementa jerarquía de encabezados e incluye schema.org para tu tipo de contenido.

Error 6: Crear respuestas demasiado cortas o largas. Fragmentos de menos de 150 tokens carecen de contexto; fragmentos de más de 700 tokens obligan a truncar. Problema: Una respuesta de 100 palabras carece de evidencia; una de 1000 palabras se divide en varias extracciones. Solución: Apunta a 256-512 tokens (2-4 párrafos); incluye afirmación, evidencia y conclusión en ese rango.

La consistencia de entidades—usar terminología idéntica para el mismo concepto en tu contenido—aumenta la probabilidad de cita por IA al señalar conocimiento autoritativo. Si defines “densidad de respuesta” en una sección, usa ese término exacto siempre en lugar de cambiar a “densidad informativa” o “densidad de contenido”. Los sistemas de IA reconocen la consistencia como señal de experiencia y es más probable que citen contenido con terminología precisa y constante. Esto aplica a nombres de productos, metodologías y términos técnicos—la consistencia construye confianza en la precisión de la cita.

Menciones de terceros e investigación original aumentan drásticamente la frecuencia de cita. El contenido que referencia otras fuentes autorizadas (con la atribución adecuada) señala credibilidad, mientras que la investigación original o datos propios hacen tu contenido exclusivamente citable. Al incluir estadísticas de tu propia investigación o estudios de caso de tus clientes, los sistemas de IA reconocen estos insights originales que no se encuentran en otros lados. Las organizaciones que publican investigación original ven tasas de cita de 3 a 4 veces superiores a las que solo sintetizan información. Estrategia: Realiza investigación original en tu industria, publica hallazgos con metodología detallada y referencia estos datos en tus respuestas meta.

Las señales de frescura—fechas de publicación, actualización y referencias a eventos recientes—ayudan a los sistemas de IA a entender la actualidad del contenido. El contenido actualizado en los últimos 30 días recibe mayor prioridad de cita, especialmente en temas de información cambiante. Incluye fechas de publicación en tu marcado schema.org y marcas de actualización al revisar contenido. Estrategia: Establece un calendario de actualización; actualiza el contenido de mayor rendimiento cada 30-60 días con estadísticas nuevas, ejemplos recientes o explicaciones ampliadas.

Las señales E-E-A-T (Experiencia, Pericia, Autoridad, Confiabilidad) influyen en las decisiones de citación por IA. El contenido escrito por expertos reconocidos, publicado en dominios de peso y respaldado por credenciales recibe mayor prioridad de cita. Incluye biografías de autor con credenciales relevantes, publica en dominios de autoridad y busca enlaces entrantes de fuentes reconocidas. Estrategia: Destaca autores expertos, incluye credenciales en las bios y busca enlaces desde publicaciones reconocidas del sector.

La densidad de marca generativa—la proporción de insights de marca frente a información genérica—determina si la IA te cita a ti o a tus competidores. El contenido con marcos propios, metodologías únicas o enfoques de marca se vuelve más citable porque es diferenciado. El contenido genérico sobre “mejores prácticas” se cita menos que el contenido sobre “El Marco de Optimización de Citaciones de AmICited” porque la versión de marca es única y trazable. Las organizaciones con alta densidad de marca generativa ven de 2 a 3 veces más citas que quienes publican contenido genérico. Estrategia: Desarrolla marcos, metodologías y terminología propia; úsalos siempre en tu contenido; hazlos la base de tus respuestas meta.

Las respuestas meta para LLM están diseñadas específicamente para la extracción y citación por parte de IA, mientras que los fragmentos destacados optimizan para la visualización en los resultados de búsqueda de Google. Las respuestas meta priorizan la completitud independiente y coherencia semántica, mientras que los fragmentos destacados se centran en la brevedad y coincidencia de palabras clave. Ambos pueden coexistir en tu contenido, pero las respuestas meta requieren una optimización estructural diferente.

La longitud óptima es de 256-512 tokens, equivalente aproximadamente a 2-4 párrafos bien estructurados o 200-400 palabras. Este rango preserva suficiente contexto para una extracción segura por IA y previene la truncación. Las respuestas más cortas carecen de contexto; las más largas obligan a los sistemas de IA a resumir o dividir en varias extracciones.

Sí, pero requiere reorganización. Audita el contenido existente en busca de formato de respuesta al inicio, coherencia semántica y completitud independiente. La mayoría del contenido puede adaptarse trasladando los insights clave al inicio, eliminando referencias cruzadas y asegurando que cada sección responda una pregunta completa sin requerir contexto externo.

Actualiza el contenido de mejor rendimiento cada 30-60 días con nuevas estadísticas, ejemplos recientes o explicaciones ampliadas. Los sistemas de IA priorizan el contenido actualizado en los últimos 30 días, especialmente para temas donde la información cambia con frecuencia. Incluye fechas de publicación y marcas de actualización en tu marcado schema.org.

La densidad de respuesta se correlaciona directamente con la frecuencia de cita. El contenido con densidad de respuesta superior al 70% promedia 4.2 citas mensuales en salidas de IA, frente a 1.1 citas para contenido por debajo del 40% de densidad. El contenido de alta densidad entrega información accionable sin relleno, haciéndolo más valioso para que los sistemas de IA lo citen.

Utiliza plataformas de monitoreo de citas como AmICited.com, que rastrea citas en ChatGPT, Claude, Gemini y otros principales LLMs. Realiza pruebas manuales enviando tus preguntas objetivo a sistemas de IA y documentando qué fuentes se citan. Mide la frecuencia base de citación, implementa optimizaciones y rastrea los cambios durante 30-60 días.

La estructura central de la respuesta meta se mantiene consistente entre plataformas, pero puedes optimizar para preferencias específicas. ChatGPT favorece contenido completo y bien referenciado. Perplexity enfatiza información reciente y citas claras. Google AI Overviews prioriza datos estructurados y señales E-E-A-T. Prueba variaciones y monitorea el rendimiento de citas en cada plataforma.

AmICited proporciona monitoreo en tiempo real de las citas de tu contenido en todas las principales plataformas de IA, mostrando exactamente dónde aparecen tus respuestas meta, cómo se usan y el reparto competitivo de citas. La plataforma revela el contexto de la cita—si el contenido es citado directamente, parafraseado o usado como evidencia—permitiendo decisiones de optimización basadas en datos.

Ve exactamente dónde tu contenido está siendo citado por ChatGPT, Perplexity, Google AI Overviews y otros sistemas de IA. Haz seguimiento de tendencias de citación, monitorea a tus competidores y optimiza tu estrategia de contenido con AmICited.

Aprende qué son las Respuestas Meta de LLM y cómo optimizar tu contenido para la visibilidad en respuestas generadas por IA de ChatGPT, Perplexity y Google AI O...

Aprende cómo identificar y dirigir sitios fuente de LLM para backlinks estratégicos. Descubre qué plataformas de IA citan más fuentes y optimiza tu estrategia d...

Aprende cómo optimizar contenido para la resumación por IA en ChatGPT, Perplexity, Google AI Overviews y Claude. Domina HTML semántico, optimización a nivel de ...

Consentimiento de Cookies

Usamos cookies para mejorar tu experiencia de navegación y analizar nuestro tráfico. See our privacy policy.