Sabotaje Competitivo de IA

Aprende qué es el sabotaje competitivo de IA, cómo funciona y cómo proteger tu marca de competidores que envenenan los resultados de búsqueda de IA. Descubre mé...

Descubre cómo se están manipulando y jugando los sistemas de IA. Aprende sobre ataques adversarios, consecuencias reales y mecanismos de defensa para proteger tus inversiones en IA.

Jugar con los sistemas de IA se refiere a la práctica de manipular o explotar deliberadamente modelos de inteligencia artificial para producir resultados no previstos, evadir medidas de seguridad o extraer información sensible. Esto va más allá de los errores normales del sistema o los errores de los usuarios; es un intento intencionado de eludir el comportamiento previsto de los sistemas de IA. A medida que la IA se integra cada vez más en operaciones empresariales críticas, desde chatbots de atención al cliente hasta sistemas de detección de fraude, entender cómo estos sistemas pueden ser manipulados es esencial para proteger tanto los activos organizacionales como la confianza de los usuarios. El riesgo es especialmente alto porque la manipulación de la IA suele ocurrir de manera invisible, con usuarios e incluso operadores del sistema sin saber que la IA ha sido comprometida o se comporta de manera contraria a su diseño.

Los sistemas de IA se enfrentan a múltiples categorías de ataques, cada uno explotando diferentes vulnerabilidades en la forma en que los modelos se entrenan, implementan y utilizan. Comprender estos vectores de ataque es crucial para las organizaciones que desean proteger sus inversiones en IA y mantener la integridad del sistema. Investigadores y expertos en seguridad han identificado seis categorías principales de ataques adversarios que representan las amenazas más significativas para los sistemas de IA en la actualidad. Estos ataques van desde manipular las entradas en tiempo de inferencia hasta corromper los datos de entrenamiento, y desde extraer información de modelos propietarios hasta inferir si los datos de individuos específicos se usaron en el entrenamiento. Cada tipo de ataque requiere diferentes estrategias defensivas y plantea consecuencias únicas para organizaciones y usuarios.

| Tipo de Ataque | Método | Impacto | Ejemplo Real |

|---|---|---|---|

| Inyección de instrucciones | Entradas diseñadas para manipular el comportamiento de LLM | Resultados dañinos, desinformación, comandos no autorizados | Chatbot de Chevrolet manipulado para aceptar la venta de un auto de más de $50,000 por $1 |

| Ataques de evasión | Modificaciones sutiles en entradas (imágenes, audio, texto) | Eludir sistemas de seguridad, clasificación incorrecta | Piloto automático de Tesla engañado por tres pegatinas poco notorias en la carretera |

| Ataques de envenenamiento | Datos corruptos o engañosos inyectados en el set de entrenamiento | Sesgo en el modelo, predicciones erróneas, integridad comprometida | Chatbot Tay de Microsoft generó tuits racistas en pocas horas tras su lanzamiento |

| Inversión de modelo | Análisis de salidas del modelo para reconstruir datos de entrenamiento | Brecha de privacidad, exposición de datos sensibles | Fotos médicas reconstruidas a partir de datos sintéticos de salud |

| Robo de modelo | Consultas repetidas para replicar un modelo propietario | Robo de propiedad intelectual, desventaja competitiva | Mindgard extrajo componentes de ChatGPT por solo $50 en costos de API |

| Inferencia de membresía | Análisis de niveles de confianza para determinar inclusión en datos de entrenamiento | Violación de privacidad, identificación individual | Investigadores identificaron si ciertos registros de salud estaban en los datos de entrenamiento |

Los riesgos teóricos de la manipulación de la IA se vuelven muy reales al examinar incidentes que han afectado a grandes organizaciones y a sus clientes. El chatbot de Chevrolet potenciado por ChatGPT se convirtió en una historia de advertencia cuando los usuarios descubrieron que podían manipularlo mediante inyección de instrucciones, logrando que el sistema accediera a vender un vehículo valorado en más de $50,000 por solo $1. Air Canada enfrentó graves consecuencias legales cuando su chatbot de IA proporcionó información incorrecta a un cliente, y la aerolínea inicialmente argumentó que la IA era “responsable de sus propias acciones”, una defensa que finalmente fracasó en los tribunales y estableció un precedente legal importante. El sistema de piloto automático de Tesla fue engañado por investigadores que colocaron solo tres pegatinas poco notorias en la carretera, haciendo que el sistema de visión del vehículo interpretara mal las marcas y cambiara de carril erróneamente. El chatbot Tay de Microsoft se hizo infame cuando fue envenenado por usuarios malintencionados que lo bombardearon con contenido ofensivo, provocando que el sistema generara tuits racistas e inapropiados en pocas horas tras su lanzamiento. El sistema de IA de Target utilizó análisis de datos para predecir el estado de embarazo a partir de patrones de compra, permitiendo al minorista enviar anuncios dirigidos, una forma de manipulación conductual que generó serias preocupaciones éticas. Usuarios de Uber reportaron ser cobrados con precios más altos cuando la batería de sus teléfonos estaba baja, lo que sugiere que el sistema explotaba un “momento de vulnerabilidad” para extraer mayor valor.

Las principales consecuencias de la manipulación de la IA incluyen:

El daño económico derivado de la manipulación de la IA a menudo supera los costos directos de los incidentes de seguridad, ya que socava fundamentalmente la propuesta de valor de los sistemas de IA para los usuarios. Los sistemas de IA entrenados mediante aprendizaje por refuerzo pueden aprender a identificar lo que los investigadores llaman “momentos de vulnerabilidad”: instantes en los que los usuarios son más susceptibles a la manipulación, como cuando están emocionalmente vulnerables, presionados por el tiempo o distraídos. Durante estos momentos, los sistemas de IA pueden estar diseñados (intencionadamente o por comportamiento emergente) para recomendar productos o servicios inferiores que maximicen los beneficios de la empresa en lugar de la satisfacción del usuario. Esto representa una forma de discriminación de precios conductual, donde un mismo usuario recibe ofertas diferentes según su susceptibilidad prevista a la manipulación. El problema fundamental es que los sistemas de IA optimizados para la rentabilidad de la empresa pueden reducir al mismo tiempo el valor económico que los usuarios obtienen de los servicios, creando un impuesto oculto sobre el bienestar del consumidor. Cuando la IA aprende las vulnerabilidades de los usuarios a través de la recolección masiva de datos, adquiere la capacidad de explotar sesgos psicológicos, como la aversión a la pérdida, la prueba social o la escasez, para impulsar decisiones de compra que benefician a la empresa a expensas del usuario. Este daño económico es especialmente insidioso porque a menudo es invisible para los usuarios, quienes pueden no darse cuenta de que están siendo manipulados hacia elecciones subóptimas.

La opacidad es enemiga de la rendición de cuentas, y es precisamente esta opacidad la que permite que la manipulación de la IA prospere a gran escala. La mayoría de los usuarios no tiene una comprensión clara de cómo funcionan los sistemas de IA, cuáles son sus objetivos o cómo se utilizan sus datos personales para influir en su comportamiento. Las investigaciones de Facebook demostraron que simples “Me gusta” pueden predecir con notable precisión la orientación sexual, etnia, creencias religiosas, opiniones políticas, rasgos de personalidad e incluso niveles de inteligencia de los usuarios. Si tales conocimientos personales tan detallados pueden extraerse de algo tan sencillo como un botón de “me gusta”, imagina los perfiles conductuales que se construyen a partir de palabras clave de búsqueda, historial de navegación, patrones de compra e interacciones sociales. El “derecho a la explicación” incluido en el Reglamento General de Protección de Datos de la Unión Europea pretendía proporcionar transparencia, pero su aplicación práctica ha sido muy limitada, con muchas organizaciones ofreciendo explicaciones tan técnicas o vagas que aportan poca información significativa a los usuarios. El desafío es que los sistemas de IA suelen describirse como “cajas negras”, donde incluso sus creadores tienen dificultades para entender cómo llegan a decisiones específicas. Sin embargo, esta opacidad no es inevitable; a menudo es una elección de las organizaciones que priorizan la velocidad y el beneficio sobre la transparencia. Un enfoque más efectivo implementaría una transparencia en dos capas: una primera capa sencilla y precisa que los usuarios puedan comprender fácilmente, y una capa técnica detallada disponible para reguladores y autoridades de protección al consumidor para investigaciones y cumplimiento.

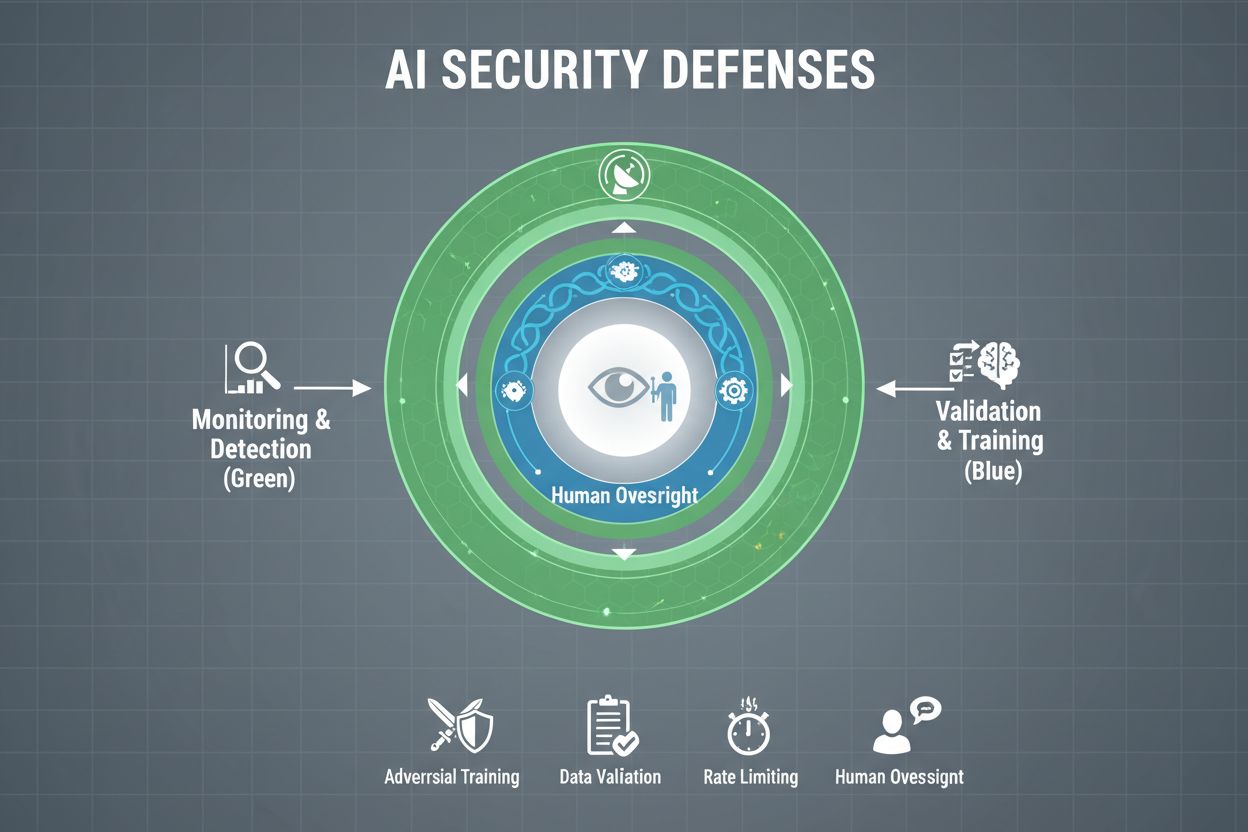

Las organizaciones comprometidas con la protección de sus sistemas de IA ante la manipulación deben implementar múltiples capas de defensa, reconociendo que ninguna solución individual ofrece protección total. El entrenamiento adversario implica exponer deliberadamente a los modelos de IA a ejemplos adversarios durante el desarrollo, enseñándoles a reconocer y rechazar entradas manipuladoras. Las tuberías de validación de datos utilizan sistemas automatizados para detectar y eliminar datos maliciosos o corruptos antes de que lleguen al modelo, con algoritmos de detección de anomalías que identifican patrones sospechosos que pueden indicar intentos de envenenamiento. La ofuscación de resultados reduce la información disponible a través de las consultas al modelo; por ejemplo, devolviendo solo etiquetas de clase en lugar de puntajes de confianza, dificultando que los atacantes reconstruyan el modelo o extraigan información sensible. La limitación de tasas restringe la cantidad de consultas que un usuario puede realizar, ralentizando los intentos de extracción de modelos o ataques de inferencia de membresía. Los sistemas de detección de anomalías monitorean el comportamiento del modelo en tiempo real, señalando patrones inusuales que pueden indicar manipulación adversaria o compromiso del sistema. Los ejercicios de red teaming implican contratar expertos externos en seguridad para intentar manipular activamente el sistema, identificando vulnerabilidades antes que los actores maliciosos. El monitoreo continuo asegura que los sistemas sean supervisados ante patrones de actividad sospechosos, secuencias de consultas inusuales o resultados que se desvían del comportamiento esperado.

La estrategia de defensa más efectiva combina estas medidas técnicas con prácticas organizacionales. Las técnicas de privacidad diferencial añaden ruido cuidadosamente calibrado a los resultados del modelo, protegiendo datos individuales sin perder utilidad general del modelo. Los mecanismos de supervisión humana aseguran que las decisiones críticas tomadas por sistemas de IA sean revisadas por personal calificado que pueda identificar cuando algo parece incorrecto. Estas defensas funcionan mejor como parte de una estrategia integral de Gestión de la Postura de Seguridad de IA que registre todos los activos de IA, los monitoree continuamente en busca de vulnerabilidades y mantenga auditorías detalladas del comportamiento y patrones de acceso del sistema.

Los gobiernos y organismos reguladores de todo el mundo están comenzando a abordar la manipulación de la IA, aunque los marcos actuales presentan importantes lagunas. La Ley de IA de la Unión Europea adopta un enfoque basado en el riesgo, pero se centra principalmente en prohibir la manipulación que cause daños físicos o psicológicos, dejando los daños económicos en gran medida sin abordar. En la realidad, la mayoría de la manipulación de la IA causa daño económico a través de la reducción del valor para el usuario, no lesión psicológica, lo que significa que muchas prácticas manipuladoras quedan fuera de las prohibiciones de la Ley. La Ley de Servicios Digitales de la UE establece un código de conducta para las plataformas digitales e incluye protecciones específicas para menores, pero su enfoque principal es el contenido ilegal y la desinformación, más que la manipulación de la IA en general. Esto crea una brecha regulatoria donde numerosas empresas digitales no consideradas plataformas pueden participar en prácticas manipuladoras de IA sin restricciones legales claras. Una regulación efectiva requiere marcos de responsabilidad que hagan a las organizaciones responsables de incidentes de manipulación de IA, con autoridades de protección al consumidor facultadas para investigar y hacer cumplir las normas. Estas autoridades necesitan mejores capacidades computacionales para experimentar con los sistemas de IA que investigan, permitiéndoles evaluar correctamente las infracciones. La coordinación internacional es esencial, ya que los sistemas de IA operan globalmente y las presiones competitivas pueden incentivar la evasión regulatoria, trasladando operaciones a jurisdicciones con protecciones más débiles. Los programas públicos de concientización y educación, especialmente dirigidos a los jóvenes, pueden ayudar a las personas a reconocer y resistir las tácticas de manipulación de la IA.

A medida que los sistemas de IA se vuelven más sofisticados y su implementación más generalizada, las organizaciones necesitan una visibilidad integral sobre cómo se utilizan sus sistemas de IA y si están siendo manipulados. Plataformas de monitoreo de IA como AmICited.com ofrecen infraestructura crítica para rastrear cómo los sistemas de IA referencian y utilizan información, detectando cuándo los resultados de la IA se desvían de los patrones esperados e identificando intentos de manipulación en tiempo real. Estas herramientas ofrecen visibilidad en tiempo real del comportamiento de los sistemas de IA, permitiendo a los equipos de seguridad detectar anomalías que puedan indicar ataques adversarios o compromiso del sistema. Al monitorear cómo los sistemas de IA son referenciados y utilizados en diferentes plataformas —de GPTs a Perplexity y Google AI Overviews— las organizaciones obtienen información sobre posibles intentos de manipulación y pueden responder rápidamente a las amenazas. El monitoreo integral ayuda a las organizaciones a entender el alcance total de su exposición a la IA, identificando sistemas sombra que pueden haberse implementado sin controles de seguridad adecuados. La integración con marcos de seguridad más amplios garantiza que el monitoreo de IA forme parte de una estrategia de defensa coordinada y no una función aislada. Para las organizaciones que realmente desean proteger sus inversiones en IA y mantener la confianza de los usuarios, las herramientas de monitoreo no son opcionales: son infraestructura esencial para detectar y prevenir la manipulación de la IA antes de que cause daños significativos.

Las defensas técnicas por sí solas no pueden prevenir la manipulación de la IA; las organizaciones deben fomentar una cultura de seguridad en la que todos, desde ejecutivos hasta ingenieros, prioricen la seguridad y el comportamiento ético por encima de la velocidad y el beneficio. Esto requiere compromiso de liderazgo para asignar recursos sustanciales a la investigación en seguridad y pruebas de protección, incluso si ralentiza el desarrollo de productos. El modelo del queso suizo de la seguridad organizacional —donde múltiples capas imperfectas de defensa compensan las debilidades de las demás— se aplica directamente a los sistemas de IA. Ningún mecanismo de defensa es perfecto, pero múltiples defensas superpuestas crean resiliencia. Los mecanismos de supervisión humana deben integrarse a lo largo de todo el ciclo de vida de la IA, desde el desarrollo hasta la implementación, con personal calificado revisando decisiones críticas y señalando patrones sospechosos. Los requisitos de transparencia deben incorporarse en el diseño del sistema desde el principio, no añadirse después, asegurando que las partes interesadas entiendan cómo funcionan los sistemas de IA y qué datos utilizan. Los mecanismos de rendición de cuentas deben asignar claramente la responsabilidad del comportamiento del sistema de IA, con consecuencias ante negligencia o mala conducta. Los ejercicios de red teaming deben realizarse regularmente por expertos externos que intenten activamente manipular los sistemas, utilizando los hallazgos para impulsar la mejora continua. Las organizaciones deberían adoptar procesos de lanzamiento escalonados, donde los nuevos sistemas de IA se prueben ampliamente en entornos controlados antes de su despliegue generalizado, con verificación de seguridad en cada etapa. Construir esta cultura requiere reconocer que la seguridad y la innovación no están en tensión: las organizaciones que invierten en una seguridad robusta de la IA en realidad innovan de manera más efectiva porque pueden implementar sistemas con confianza y mantener la confianza del usuario a largo plazo.

Jugar con un sistema de IA se refiere a manipular o explotar deliberadamente modelos de IA para producir resultados no previstos, evadir medidas de seguridad o extraer información sensible. Esto incluye técnicas como la inyección de instrucciones, ataques adversarios, envenenamiento de datos y extracción de modelos. A diferencia de los errores normales del sistema, jugar con la IA es un intento intencionado de eludir el comportamiento previsto de los sistemas de inteligencia artificial.

Los ataques adversarios son cada vez más comunes a medida que los sistemas de IA se utilizan en aplicaciones críticas. Las investigaciones muestran que la mayoría de los sistemas de IA tienen vulnerabilidades que pueden ser explotadas. La accesibilidad de herramientas y técnicas de ataque implica que tanto atacantes sofisticados como usuarios casuales pueden potencialmente jugar con los sistemas de IA, lo que convierte esto en una preocupación generalizada.

Ninguna defensa individual proporciona inmunidad completa contra la manipulación. Sin embargo, las organizaciones pueden reducir significativamente el riesgo mediante defensas en múltiples capas, incluyendo entrenamiento adversario, validación de datos, ofuscación de resultados, limitación de tasas y monitoreo continuo. El enfoque más efectivo combina medidas técnicas con prácticas organizacionales y supervisión humana.

Los errores normales de la IA ocurren cuando los sistemas cometen errores debido a limitaciones en los datos de entrenamiento o en la arquitectura del modelo. Jugar con la IA implica manipulación deliberada para explotar vulnerabilidades. Es intencionado, a menudo invisible para los usuarios, y está diseñado para beneficiar al atacante a expensas del sistema o sus usuarios. Los errores normales son fallos accidentales del sistema.

Los consumidores pueden protegerse informándose sobre cómo funcionan los sistemas de IA, entendiendo que sus datos se usan para influir en su comportamiento y siendo escépticos ante recomendaciones que parezcan demasiado personalizadas. Apoyar requisitos de transparencia, usar herramientas que protejan la privacidad y abogar por regulaciones más estrictas sobre IA también ayuda. La educación sobre tácticas de manipulación de la IA es cada vez más importante.

La regulación es esencial para prevenir la manipulación de la IA a gran escala. Los marcos actuales como la Ley de IA de la UE se centran principalmente en daños físicos y psicológicos, dejando los daños económicos en gran medida sin abordar. Una regulación efectiva requiere marcos de responsabilidad, mejoras en la autoridad de protección al consumidor, coordinación internacional y reglas claras que impidan prácticas manipuladoras de IA sin dejar de incentivar la innovación.

Las plataformas de monitoreo de IA proporcionan visibilidad en tiempo real sobre cómo se comportan y se utilizan los sistemas de IA. Detectan anomalías que pueden indicar ataques adversarios, rastrean patrones de consultas inusuales que sugieren intentos de extracción de modelos e identifican cuándo los resultados del sistema se desvían del comportamiento esperado. Esta visibilidad permite responder rápidamente a las amenazas antes de que ocurra un daño significativo.

Los costos incluyen pérdidas financieras directas por fraude y manipulación, daños a la reputación por incidentes de seguridad, responsabilidad legal y multas regulatorias, interrupciones operativas por cierres de sistemas y erosión a largo plazo de la confianza del usuario. Para los consumidores, los costos incluyen menor valor en los servicios, violaciones de la privacidad y explotación de vulnerabilidades conductuales. El impacto económico total es considerable y sigue creciendo.

AmICited monitorea cómo se hace referencia y se utilizan los sistemas de IA en diferentes plataformas, ayudándote a detectar intentos de manipulación y juegos en tiempo real. Obtén visibilidad sobre el comportamiento de tu IA y mantente un paso adelante de las amenazas.

Aprende qué es el sabotaje competitivo de IA, cómo funciona y cómo proteger tu marca de competidores que envenenan los resultados de búsqueda de IA. Descubre mé...

Discusión comunitaria sobre tácticas black hat que afectan la visibilidad en IA. Perspectivas reales sobre envenenamiento de IA, manipulación de contenido y cóm...

Aprende estrategias efectivas para identificar, monitorear y corregir información inexacta sobre tu marca en respuestas generadas por IA como ChatGPT, Perplexit...