¿Qué es el Contenido Multimodal para la IA? Definición y Ejemplos

Aprende qué es el contenido multimodal para la IA, cómo funciona y por qué es importante. Descubre ejemplos de sistemas de IA multimodal y sus aplicaciones en d...

Aprende cómo optimizar texto, imágenes y video para sistemas de IA multimodal. Descubre estrategias para mejorar las citas y visibilidad de tu contenido en ChatGPT, Gemini y Perplexity.

La IA multimodal representa un cambio fundamental en la forma en que los sistemas de inteligencia artificial procesan y entienden la información. A diferencia de los sistemas unimodales que manejan solo texto, imágenes o video de forma independiente, la IA multimodal integra múltiples tipos de datos simultáneamente para crear una comprensión más completa de información compleja. Este enfoque refleja cómo los humanos procesamos naturalmente el mundo: no separamos lo que vemos de lo que oímos o leemos, sino que sintetizamos todas las entradas juntas. El mercado de IA multimodal, valorado en 1.600 millones de dólares en 2024, está experimentando un crecimiento explosivo con una tasa de crecimiento anual compuesta (CAGR) del 32,7%, reflejando la importancia crítica de la tecnología para las estrategias empresariales de IA. Los analistas del sector proyectan que el 40% de todas las soluciones de IA generativa serán multimodales en 2027, según investigaciones de Gartner. Esta transición no es meramente incremental; representa un cambio de paradigma en cómo las organizaciones aprovechan la IA para obtener ventajas competitivas. La convergencia de las capacidades de procesamiento de texto, imagen y video permite a los sistemas de IA ofrecer perspectivas y capacidades que antes eran imposibles con enfoques de una sola modalidad.

Los sistemas de IA multimodal emplean componentes arquitectónicos sofisticados para manejar diversos tipos de datos sin inconvenientes. Los codificadores son redes neuronales especializadas que convierten cada tipo de dato—texto, imágenes y video—en una representación numérica unificada llamada embeddings. Estos embeddings capturan el significado semántico de cada modalidad en un espacio matemático compartido, permitiendo al sistema comparar y relacionar información entre diferentes tipos de contenido. El mecanismo de fusión combina estos embeddings, ya sea mediante concatenación, suma o técnicas avanzadas de fusión aprendida que determinan cuánto peso debe aportar cada modalidad al resultado final. Los mecanismos de cross-attention permiten que el modelo enfoque dinámicamente la información relevante entre modalidades; por ejemplo, al analizar una imagen de producto con texto acompañante, el sistema puede atender a características visuales específicas que correspondan a descripciones textuales. Este proceso de múltiples etapas permite a los sistemas multimodales lograr una comprensión contextual que los sistemas unimodales no pueden replicar. La siguiente tabla ilustra las diferencias de capacidades:

| Capacidad | IA Unimodal | IA Multimodal |

|---|---|---|

| Análisis de Texto | Excelente | Excelente |

| Comprensión de Imágenes | Limitada/Ninguna | Excelente |

| Procesamiento de Video | Limitada/Ninguna | Excelente |

| Razonamiento Cruzado | No posible | Excelente |

| Integración de Contexto | Fuente única | Múltiples fuentes |

| Precisión en el Mundo Real | 60-75% | 85-95% |

| Velocidad de Procesamiento | Rápida | Rápida Optimizada |

El panorama de la IA multimodal está dominado por varias plataformas poderosas que han marcado nuevos estándares para el procesamiento integrado. GPT-4o de OpenAI representa un modelo multimodal emblemático, manejando texto, imágenes y video de manera nativa e integrada entre todas las modalidades. Google Gemini ofrece capacidades multimodales de nivel empresarial con especial fortaleza en la comprensión de documentos visuales complejos y contenido de video de larga duración. Claude de Anthropic proporciona razonamiento multimodal sofisticado con énfasis en precisión y comprensión matizada de entradas de texto e imagen. La tecnología ImageBind de Meta demuestra un enfoque arquitectónico diferente, creando un espacio de embeddings unificado para seis modalidades, incluyendo texto, imagen, audio, profundidad, térmico y datos IMU. Estas plataformas representan la vanguardia de la tecnología multimodal, cada una aportando innovaciones arquitectónicas y estrategias de optimización distintivas. Las organizaciones que seleccionan plataformas multimodales deben evaluar no solo la amplitud de capacidades, sino también la optimización de rendimiento, eficiencia de costos e integración con flujos de trabajo existentes.

La IA multimodal está transformando las operaciones en prácticamente todos los sectores industriales, logrando mejoras medibles en eficiencia, precisión y experiencia del cliente. Las organizaciones que implementan estas tecnologías reportan resultados notables:

Salud: Los radiólogos utilizan IA multimodal para analizar imágenes médicas combinadas con registros de pacientes y notas clínicas, mejorando la precisión diagnóstica y reduciendo el tiempo de análisis hasta en un 40%. Los sistemas de IA pueden correlacionar hallazgos visuales con historiales médicos textuales para identificar patrones que los humanos podrían pasar por alto.

Retail: Empresas de moda y comercio electrónico aprovechan la IA multimodal para emparejar descripciones de clientes con inventario visual, habilitando capacidades de “búsqueda por descripción” que aumentan las tasas de conversión. Las recomendaciones de productos mejoran significativamente cuando la IA comprende tanto preferencias visuales como retroalimentación textual.

Manufactura: Los procesos de control de calidad se aceleran dramáticamente con sistemas de inspección multimodal que combinan detección visual de defectos con datos de sensores y registros de mantenimiento, logrando catalogación de incidencias 100 veces más rápida que los procesos manuales.

Creación de Contenido: Empresas de medios usan IA multimodal para generar automáticamente subtítulos, transcripciones y metadatos para contenido de video, con el 72% de los ejecutivos de medios que usan IA generativa reportando retorno positivo de inversión.

Atención al Cliente: Los chatbots mejorados con capacidades multimodales pueden procesar imágenes de problemas enviadas por clientes junto con descripciones de texto, proporcionando soluciones de soporte más precisas y contextuales.

Agricultura: Los agricultores despliegan sistemas multimodales que analizan imágenes de cultivos, datos meteorológicos y lecturas de sensores de suelo para optimizar decisiones de riego, fertilización y manejo de plagas.

Robótica: Los sistemas autónomos utilizan percepción multimodal para navegar entornos complejos, combinando entradas visuales con señales de audio y retroalimentación táctil para operaciones más seguras e inteligentes.

Para maximizar la efectividad de los sistemas de IA multimodal, el contenido textual requiere estrategias deliberadas de optimización que mejoren la legibilidad por máquina y la comprensión contextual. El marcado de datos estructurados usando los estándares de schema.org ayuda a los sistemas de IA a entender las relaciones semánticas dentro de tu contenido, permitiendo conexiones más precisas entre modalidades. Implementar lenguaje conversacional en lugar de prosa puramente formal permite a los sistemas multimodales comprender mejor la intención y el contexto, especialmente cuando el texto se procesa junto con elementos visuales o de video. Encabezados y subencabezados descriptivos cumplen un doble propósito: guían a los lectores y ofrecen señales estructurales cruciales para que los sistemas de IA organicen y prioricen la información. Incluir palabras clave relevantes en contextos naturales—en lugar de forzar la densidad de palabras clave—garantiza que el contenido textual se alinee con la forma en que los sistemas multimodales identifican relaciones temáticas entre modalidades. La optimización de metadatos, incluyendo etiquetas de título, descripciones meta y atributos de datos estructurados, proporciona señales explícitas sobre el significado del contenido que los sistemas multimodales pueden aprovechar. Las organizaciones también deben considerar cómo el texto complementa el contenido visual; los subtítulos y el texto alternativo no son solo características de accesibilidad—son elementos críticos de optimización que permiten a la IA multimodal comprender la relación entre la información textual y visual.

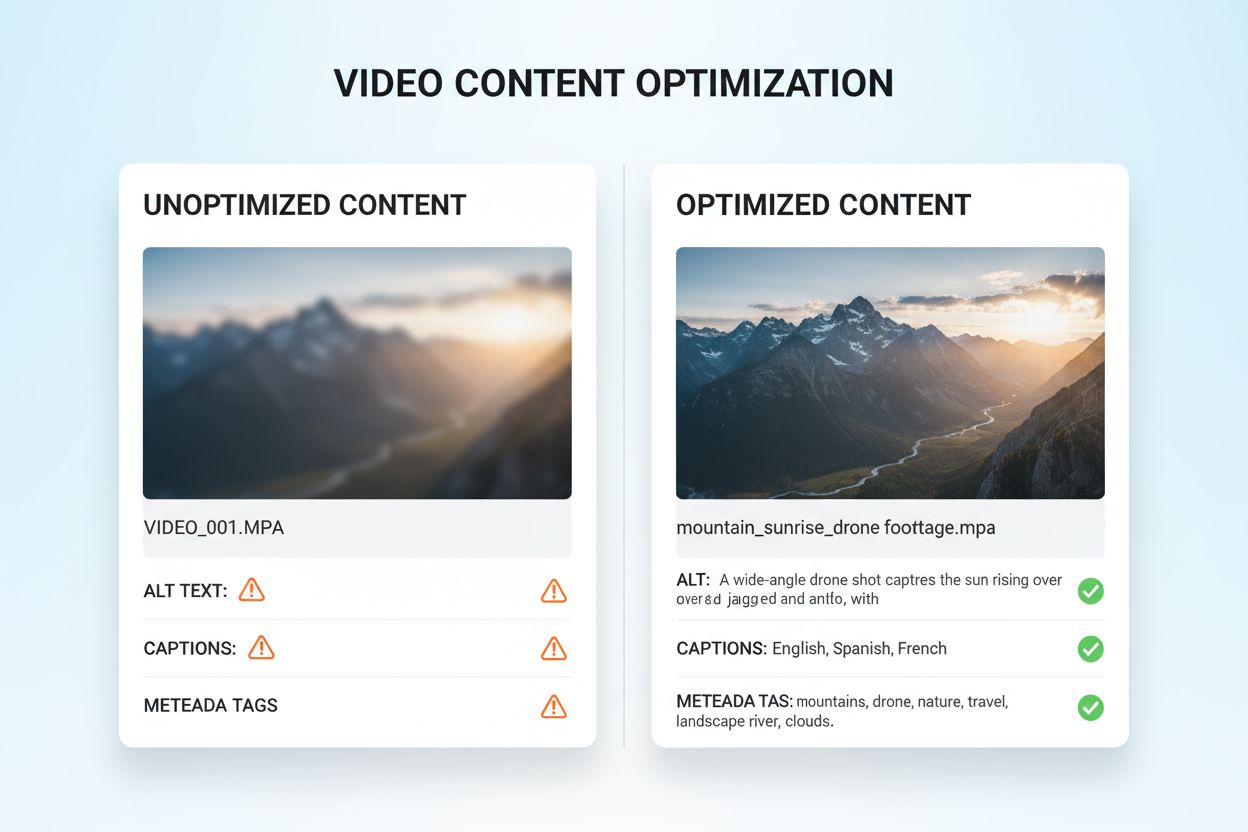

La optimización de contenido visual y de video para IA multimodal requiere un enfoque integral que va mucho más allá de las prácticas tradicionales de SEO. El texto alternativo descriptivo es fundamental; en lugar de descripciones genéricas, el texto alternativo debe capturar el significado semántico, el contexto y los detalles relevantes que ayuden a los sistemas de IA a comprender lo que transmite la imagen. Las convenciones de nombres de archivo son muy importantes: nombres descriptivos como “cuadro-comparativo-productos-2024.jpg” proporcionan contexto crucial que los sistemas de IA utilizan para entender el propósito del contenido. Los subtítulos y transcripciones de video son elementos esenciales de optimización; permiten que los sistemas multimodales correlacionen el contenido hablado con los elementos visuales, mejorando drásticamente la comprensión de material de video complejo. Los campos de metadatos como título, descripción y etiquetas deben ser completados con especificidad y precisión, ya que influyen directamente en cómo los sistemas de IA categorizan y relacionan el contenido visual con otras modalidades. La compresión de imágenes y la optimización técnica aseguran que la calidad visual sea suficientemente alta para el análisis por IA, manteniendo tiempos de carga rápidos. Los datos estructurados para contenido visual, incluyendo marcado para imágenes, videos y galerías, ofrecen señales explícitas sobre relaciones de contenido. Las organizaciones también deben considerar metadatos temporales para contenido de video: marcar momentos clave, cambios de escena y transiciones de tema ayuda a los sistemas multimodales a comprender la estructura narrativa y extraer segmentos relevantes.

Los sistemas de IA multimodal emplean dos enfoques arquitectónicos principales, cada uno con ventajas y compensaciones distintas. Las arquitecturas unificadas procesan todas las modalidades a través de una sola red neuronal integrada que aprende representaciones conjuntas desde el inicio del procesamiento. Este enfoque suele ofrecer razonamiento cruzado superior porque el sistema desarrolla una comprensión profunda de cómo se relacionan las modalidades, pero requiere más recursos computacionales y tiempos de entrenamiento más largos. Las arquitecturas modulares mantienen redes especializadas separadas para cada modalidad y luego combinan sus salidas mediante mecanismos de fusión. Este enfoque ofrece mayor flexibilidad, permitiendo a las organizaciones intercambiar procesadores de modalidad individuales sin volver a entrenar todo el sistema, y generalmente requiere menos recursos computacionales. Los modelos Mixture of Experts (MoE) representan un enfoque híbrido emergente, donde diferentes redes expertas se especializan en distintas modalidades o tareas y un mecanismo de enrutamiento dirige las entradas al experto apropiado. Esta arquitectura logra mejoras de eficiencia del 30-50% en comparación con modelos unificados densos, manteniendo una precisión comparable. La elección entre enfoques arquitectónicos depende de los casos de uso específicos: las arquitecturas unificadas sobresalen en tareas complejas que requieren comprensión profunda entre modalidades, mientras que los enfoques modulares se adaptan a escenarios que exigen flexibilidad y eficiencia de recursos.

La implementación efectiva de IA multimodal requiere marcos robustos de medición que rastreen tanto el rendimiento técnico como el impacto en el negocio. Los indicadores clave de desempeño (KPIs) deben incluir métricas de precisión para cada modalidad, calidad del razonamiento cruzado, latencia de procesamiento y costo por inferencia. Las plataformas analíticas deben capturar cómo la IA multimodal influye en métricas empresariales aguas abajo: tasas de conversión en retail, precisión diagnóstica en salud, eficiencia de producción en manufactura. Las organizaciones deben implementar seguimiento de atribución para entender qué modalidad aporta más a resultados específicos—esta información guía los esfuerzos de optimización y la asignación de recursos. La medición de ROI debe considerar tanto ahorros directos (como la catalogación 100 veces más rápida reportada por empresas manufactureras) como beneficios indirectos como mejora de la satisfacción del cliente o reducción de tasas de error. Las herramientas de monitoreo deben rastrear la degradación del desempeño del modelo a lo largo del tiempo, ya que la deriva de datos en el mundo real puede reducir la precisión del sistema multimodal si no se gestiona activamente. Para organizaciones que aprovechan contenido e insights generados por IA, el seguimiento de citas y atribución cobra cada vez más importancia; herramientas como AmICited.com ayudan a monitorizar cómo los sistemas de IA citan fuentes y atribuyen información, proporcionando visibilidad en los procesos de toma de decisiones de la IA y asegurando el cumplimiento de requisitos de procedencia de contenido. Auditorías regulares de desempeño y ciclos de optimización aseguran que los sistemas multimodales sigan generando valor a medida que evolucionan las necesidades empresariales y los patrones de datos.

El panorama de la IA multimodal sigue evolucionando rápidamente, con varias tendencias transformadoras que están redefiniendo cómo las organizaciones aprovecharán estas tecnologías. La integración de voz representa la próxima frontera, ya que los sistemas combinan cada vez más la entrada de audio con datos visuales y textuales, permitiendo una comprensión verdaderamente integral de la comunicación humana y el contexto ambiental. Los sistemas de IA agentica—agentes de IA capaces de planificar y ejecutar tareas multi-paso de forma autónoma—aprovecharán la percepción multimodal para desenvolverse en escenarios reales complejos, desde vehículos autónomos hasta automatización robótica de procesos en empresas. Las capacidades de procesamiento en tiempo real avanzan drásticamente, permitiendo el análisis multimodal de transmisiones de video en vivo, fuentes de audio y datos de sensores simultáneamente, abriendo posibilidades para la toma de decisiones instantánea en aplicaciones sensibles al tiempo. Las mejoras de eficiencia mediante técnicas como destilación y cuantización harán que las capacidades multimodales sofisticadas sean accesibles para organizaciones con recursos computacionales limitados, democratizando el acceso a la IA avanzada. Surgirán modelos especializados por dominio, con sistemas multimodales ajustados para sectores específicos como salud, jurídico o servicios financieros, ofreciendo un desempeño superior respecto a modelos de propósito general. La convergencia de estas tendencias sugiere que la IA multimodal pasará de ser una ventaja competitiva a un requisito fundamental para las organizaciones que busquen seguir siendo relevantes en un entorno cada vez más impulsado por IA. Las organizaciones que comiencen hoy a optimizar su contenido y procesos para la IA multimodal estarán mejor posicionadas para capitalizar estas capacidades emergentes mañana.

La IA multimodal procesa múltiples tipos de datos (texto, imágenes, audio, video) simultáneamente, mientras que la IA unimodal tradicional solo maneja uno. Esto permite una comprensión contextual más rica y resultados más precisos. Los sistemas multimodales pueden comprender relaciones entre diferentes modalidades, ofreciendo perspectivas que los sistemas de una sola modalidad no pueden replicar.

A medida que la IA multimodal se convierte en el estándar para soluciones de IA generativa (se proyecta un 40% para 2027), optimizar tu contenido asegura mayor visibilidad en respuestas generadas por IA. Las organizaciones que optimizan en texto, imagen y video ven mejores citas de IA, mayor visibilidad en plataformas como ChatGPT y Gemini, y mejor desempeño general del contenido.

Haz seguimiento de métricas clave incluyendo precisión entre modalidades, calidad de razonamiento cruzado, latencia de procesamiento e impacto empresarial (tasas de conversión, engagement, etc.). Usa herramientas como AmICited.com para monitorizar cómo los sistemas de IA citan tu contenido e implementa analíticas para saber qué modalidades contribuyen más a tus resultados de negocio.

Los desafíos principales incluyen asegurar metadatos consistentes entre modalidades, mantener texto alternativo y subtítulos de alta calidad, alinear datos temporales en videos y gestionar los recursos computacionales requeridos para el procesamiento. Las organizaciones también deben planificar la preparación de datos (10-20% del presupuesto del proyecto) y la gestión del cambio a medida que los equipos adoptan nuevas prácticas de optimización.

Salud, comercio minorista, manufactura, creación de contenido, atención al cliente, agricultura y robótica obtienen beneficios significativos. Salud la usa para precisión diagnóstica, retail para descubrimiento de productos, manufactura para control de calidad (catalogación 100x más rápida) y empresas de medios reportan un 72% de ROI en inversiones de IA generativa.

AmICited.com monitoriza cómo sistemas de IA como ChatGPT, Perplexity y Google AI Overviews citan tu contenido en diferentes modalidades. Proporciona visibilidad en tiempo real de tu presencia en búsquedas de IA, ayudándote a entender cómo tu contenido de texto, imágenes y video es referenciado en respuestas generadas por IA.

Las arquitecturas unificadas procesan todas las modalidades a través de una red integrada, ofreciendo mejor razonamiento cruzado pero requiriendo más recursos computacionales. Las arquitecturas modulares mantienen redes separadas por modalidad, brindando mayor flexibilidad y eficiencia. Los modelos Mixture of Experts (MoE) ofrecen un enfoque híbrido con mejoras de eficiencia del 30-50%.

Optimiza el texto con datos estructurados y lenguaje conversacional, añade texto alternativo y metadatos descriptivos a las imágenes, incluye subtítulos y transcripciones en video y usa convenciones consistentes de nombres de archivo. Asegura que todas las modalidades trabajen juntas para dar contexto completo e implementa marcado de esquema para ayudar a los sistemas de IA a entender relaciones semánticas.

Haz seguimiento de cómo los sistemas de IA multimodal citan tu contenido en ChatGPT, Perplexity, Google AI Overviews y otras plataformas. Obtén visibilidad en tiempo real sobre tu presencia en búsqueda de IA.

Aprende qué es el contenido multimodal para la IA, cómo funciona y por qué es importante. Descubre ejemplos de sistemas de IA multimodal y sus aplicaciones en d...

Descubre cómo los sistemas de búsqueda de IA multimodal procesan texto, imágenes, audio y video juntos para ofrecer resultados más precisos y relevantes en cont...

Domina la optimización de búsqueda de IA multimodal. Aprende a optimizar imágenes y consultas de voz para resultados de búsqueda impulsados por IA, con estrateg...

Consentimiento de Cookies

Usamos cookies para mejorar tu experiencia de navegación y analizar nuestro tráfico. See our privacy policy.