Cómo construir una biblioteca de prompts para el seguimiento de la visibilidad en IA

Aprende a crear y organizar una biblioteca de prompts eficaz para rastrear tu marca en ChatGPT, Perplexity y Google AI. Guía paso a paso con mejores prácticas p...

Aprende cómo construir y utilizar bibliotecas de prompts para pruebas manuales de visibilidad en IA. Guía DIY para comprobar cómo los sistemas de IA mencionan tu marca en ChatGPT, Perplexity y Google AI.

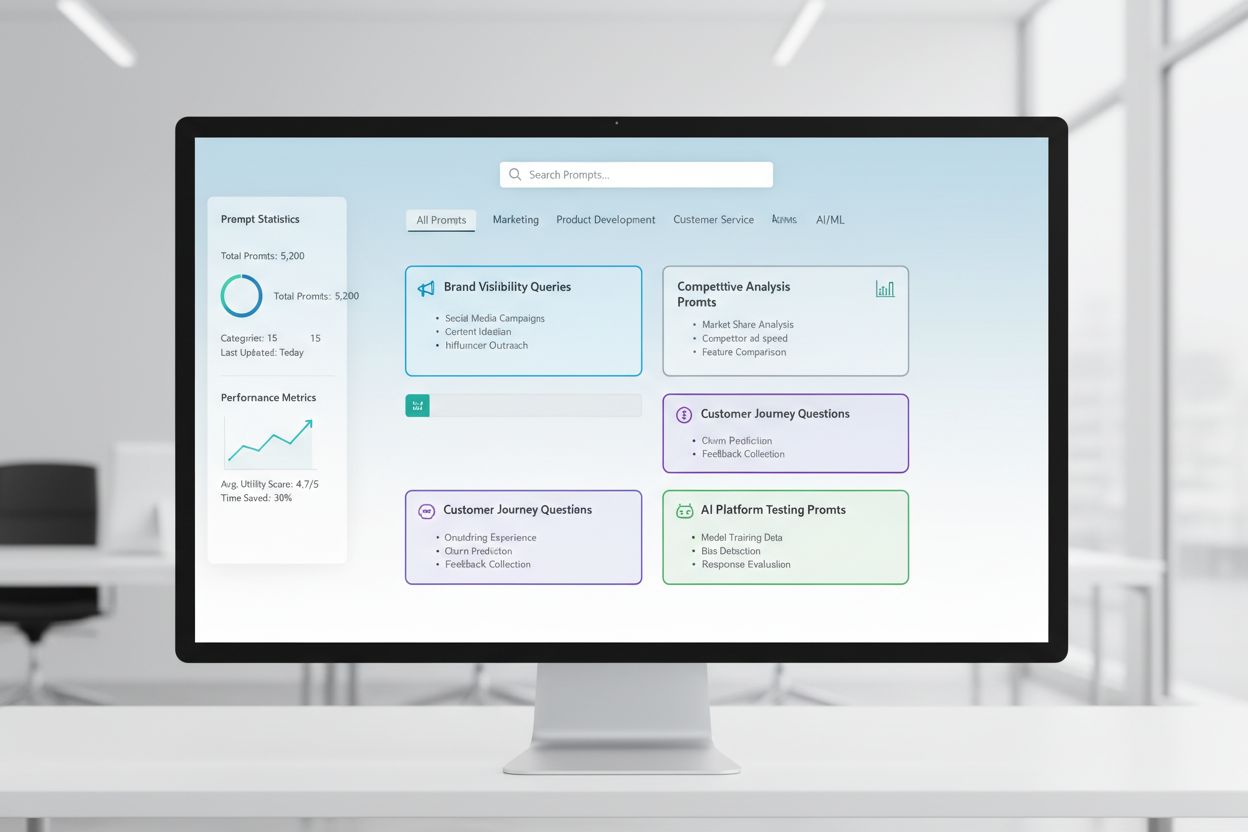

Una biblioteca de prompts es una colección curada y organizada de prompts de prueba diseñada para evaluar sistemáticamente cómo los sistemas de IA responden a consultas y escenarios específicos. En el contexto de las pruebas manuales de IA, estas bibliotecas sirven como tu kit de herramientas fundamental: un repositorio de prompts cuidadosamente elaborados que te ayudan a comprender exactamente cómo distintos modelos de IA gestionan las menciones de tu marca, las citas, la precisión del contenido y la comprensión contextual. Las pruebas de visibilidad en IA dependen mucho de las bibliotecas de prompts porque permiten pruebas consistentes y repetibles en múltiples plataformas y períodos de tiempo, permitiéndote rastrear cómo aparece (o no aparece) tu contenido en las respuestas generadas por IA. En lugar de probar al azar con consultas improvisadas, una biblioteca de prompts bien estructurada asegura que estás cubriendo sistemáticamente todos los escenarios relevantes para tu negocio, desde búsquedas directas de marca hasta referencias contextuales indirectas. Este enfoque estructurado transforma las pruebas manuales de un proceso improvisado a una metodología estratégica y basada en datos que revela patrones en el comportamiento de la IA y te ayuda a entender tu visibilidad real en el panorama de la IA.

Las pruebas manuales de visibilidad en IA son el proceso práctico de consultar directamente a los sistemas de IA con prompts predeterminados y analizar cuidadosamente sus respuestas para entender cómo tu contenido, marca y citas aparecen o se omiten. A diferencia de los sistemas de monitoreo automatizado que funcionan de manera continua en segundo plano, las pruebas manuales te otorgan control directo sobre qué, cuándo y cómo pruebas, y qué tan profundamente analizas los resultados, lo que las hace invaluables para pruebas exploratorias, comprender casos límite e investigar comportamientos inesperados de la IA. La diferencia clave radica en la naturaleza del trabajo: las pruebas manuales son deliberadas e investigativas, permitiéndote hacer preguntas de seguimiento, probar variaciones y entender el “por qué” detrás de las respuestas de la IA, mientras que el monitoreo automatizado destaca en el seguimiento consistente y a gran escala a lo largo del tiempo. Las pruebas manuales son especialmente importantes para la visibilidad en IA porque te ayudan a detectar matices que los sistemas automatizados podrían pasar por alto, como si tu marca es mencionada pero mal atribuida, si las citas son precisas pero incompletas, o si el contexto está siendo bien entendido. Así es como se comparan estos enfoques:

| Aspecto | Pruebas Manuales | Monitoreo Automatizado |

|---|---|---|

| Costo | Menor inversión inicial; requiere mucho tiempo | Mayor configuración inicial; menor trabajo continuo |

| Velocidad | Más lento por prueba; resultados inmediatos | Más lento de configurar; seguimiento rápido y continuo |

| Flexibilidad | Muy flexible; fácil de explorar y adaptar | Rígido; requiere parámetros predefinidos |

| Precisión | Alta para análisis cualitativo; sujeto a sesgo humano | Consistente; excelente para métricas cuantitativas |

| Curva de Aprendizaje | Mínima; cualquiera puede empezar a probar | Mayor; requiere configuración técnica |

Las pruebas manuales sobresalen para entender por qué sucede algo, mientras que el monitoreo automatizado destaca en rastrear qué sucede a gran escala.

Una estructura sólida de biblioteca de prompts debe organizarse en torno a las dimensiones clave de tu estrategia de visibilidad en IA, con cada componente cumpliendo un propósito específico de prueba. Tu biblioteca debe incluir prompts que prueben distintos aspectos de cómo los sistemas de IA descubren y muestran tu contenido, asegurando una cobertura integral de tu panorama de visibilidad. Aquí tienes los componentes esenciales que toda biblioteca de prompts debe contener:

Al construir tu estrategia de pruebas, necesitas prompts que apunten específicamente a las dimensiones de visibilidad en IA más importantes para tu negocio: menciones de marca, precisión de las citas y comprensión contextual. Los prompts de prueba más efectivos son aquellos que reflejan el comportamiento real de los usuarios y, al mismo tiempo, aíslan variables específicas que deseas medir. Para prompts de prueba enfocados en menciones de marca, querrás variantes que prueben búsquedas directas, referencias indirectas y contextos comparativos. Las pruebas de precisión de citas requieren prompts que activen naturalmente las citas y luego variaciones que prueben si el sistema de IA atribuye correctamente la información a tus fuentes. Aquí tienes ejemplos de prompts que puedes adaptar para tus propias pruebas:

"¿Cuáles son los últimos desarrollos en [tu industria]?

Por favor, cita tus fuentes."

"Compara [tu producto] con [producto de la competencia].

¿Cuáles son las principales diferencias y ventajas de cada uno?"

"Explica [tu área de especialización].

¿Quiénes son los principales expertos o empresas en este campo?"

Estos prompts están diseñados para activar naturalmente los tipos de respuestas donde tu visibilidad es más relevante: cuando los sistemas de IA brindan información, hacen comparaciones o identifican fuentes autorizadas. Puedes crear variaciones cambiando el nivel de especificidad (amplio vs. específico), agregando restricciones (solo información reciente, casos de uso concretos) o modificando los requisitos de cita (con fuentes, con enlaces, con nombres de autores). La clave es probar no solo si tu contenido aparece, sino cómo aparece y en qué contexto, lo que requiere prompts que creen escenarios realistas donde tu visibilidad debería manifestarse naturalmente.

Tu estrategia de visibilidad en IA debe considerar que las distintas plataformas de IA—ChatGPT, Perplexity, Google AI Overviews, Claude y otras—tienen datos de entrenamiento, mecanismos de recuperación y enfoques de generación de respuestas fundamentalmente diferentes, lo que significa que tu visibilidad varía significativamente entre plataformas. Las pruebas multiplataforma son esenciales porque un prompt que destaca tu contenido en un sistema puede producir resultados completamente distintos en otro, y comprender estos patrones específicos de cada plataforma es crucial para desarrollar una estrategia de visibilidad integral. Al probar en varias plataformas, notarás que Perplexity, con su integración de búsqueda en tiempo real, suele mostrar contenido más reciente e incluye más citas explícitas que ChatGPT, que depende de datos de entrenamiento con una fecha de corte. Google AI Overviews, integrado directamente en los resultados de búsqueda, opera bajo reglas de visibilidad diferentes y puede priorizar fuentes distintas a los sistemas conversacionales. El enfoque práctico es mantener un conjunto coherente de prompts principales que ejecutes en todas las plataformas de forma periódica, permitiéndote rastrear no solo si tu contenido aparece, sino dónde aparece y cómo las diferencias de plataforma afectan tu visibilidad. Esta perspectiva multiplataforma revela si tus desafíos de visibilidad son universales (afectan a todas las plataformas) o específicos (requieren estrategias dirigidas para ciertos sistemas), lo que cambia fundamentalmente tu enfoque de optimización.

Una documentación de pruebas efectiva transforma los datos brutos en inteligencia accionable, y el sistema de organización que elijas determinará si tus esfuerzos de prueba se acumulan en valor con el tiempo o quedan como puntos de datos aislados. El enfoque más práctico es usar una hoja de cálculo o sistema de documentación estructurado que capture no solo los resultados, sino el contexto: el prompt exacto utilizado, la fecha de la prueba, la plataforma probada, la respuesta completa de la IA y tu análisis sobre si tu contenido apareció y cómo fue presentado. Tu sistema de seguimiento de resultados debe incluir columnas para: categoría del prompt (marca, competidor, industria, etc.), plataforma probada, si tu contenido apareció, precisión de la cita (si aplica), posición en la respuesta (primera mención, evidencia de apoyo, etc.) y cualquier nota cualitativa sobre la calidad o relevancia de la respuesta. Más allá de los datos brutos, crea plantillas para escenarios de prueba comunes para que tu documentación sea consistente con el tiempo, facilitando la identificación de tendencias y cambios en el comportamiento de la IA. Documenta no solo los éxitos, sino también los fallos y anomalías, ya que a menudo revelan los hallazgos más importantes sobre cómo funcionan los sistemas de IA y dónde tu estrategia de visibilidad necesita ajustes. Manteniendo este enfoque disciplinado de metodología de prueba, creas un registro histórico que muestra cómo ha evolucionado tu visibilidad, qué cambios en los sistemas de IA han afectado tus resultados y qué acciones de optimización realmente han hecho la diferencia.

Las pruebas manuales de visibilidad en IA son susceptibles a varios errores sistemáticos que pueden socavar tus resultados y llevarte a conclusiones incorrectas sobre tu visibilidad real. El error más común es la formulación inconsistente de prompts: probar el mismo concepto con ligeras variaciones en el lenguaje cada vez, lo que introduce variables que impiden saber si los cambios en los resultados se deben a cambios en el sistema de IA o a tus propias variaciones. Para evitarlo, crea un documento maestro de prompts donde cada prompt esté fijado y se use de forma idéntica en todas las rondas de prueba; si deseas probar variantes, crea prompts separados con convenciones de nombres claras. Otro error crítico es el tamaño y frecuencia de muestra insuficientes: probar una sola vez y sacar conclusiones, sin reconocer que las respuestas de la IA pueden variar por el momento, la carga del sistema y otros factores. Establece una cadencia regular de pruebas (semanal, quincenal o mensual, según tus recursos) y prueba cada prompt varias veces para identificar patrones y no anomalías. El sesgo de confirmación es un error sutil pero peligroso, donde los testers interpretan inconscientemente resultados ambiguos como confirmación de sus expectativas; combátelo haciendo que varios miembros del equipo revisen los resultados de forma independiente y documentando criterios objetivos para determinar si “aparece tu contenido”. Además, evita el error de probar en aislamiento: siempre anota la fecha, hora y cualquier actualización conocida del sistema de IA al hacer pruebas, porque entender el contexto de tus resultados es esencial para interpretarlos correctamente. Finalmente, una pobre documentación de la metodología significa que no podrás replicar tus pruebas ni explicar tus resultados a los interesados; documenta siempre exactamente cómo probaste, qué mediste y cómo interpretaste los resultados para que tus pruebas sean reproducibles y defendibles.

A medida que tu organización crece y tu estrategia de visibilidad en IA se vuelve más sofisticada, necesitarás escalar de pruebas individuales y ad hoc a un enfoque estructurado de pruebas en equipo que distribuya la carga de trabajo manteniendo la consistencia y calidad. La clave para un escalado exitoso es crear protocolos claros de prueba y definición de roles: designa quién es responsable de cada plataforma, de qué categorías de prompts y de qué tareas de análisis, para que las pruebas sean un esfuerzo coordinado de equipo y no trabajo individual duplicado. Implementa un calendario de pruebas compartido donde los miembros del equipo puedan ver qué se ha probado, cuándo y por quién, evitando pruebas redundantes y asegurando una cobertura integral. Crea una lista de verificación o runbook de pruebas que cualquier miembro pueda seguir para ejecutar pruebas de forma consistente, incluyendo instrucciones específicas sobre cómo documentar resultados, qué buscar en las respuestas y cómo marcar anomalías o hallazgos interesantes. Las herramientas de colaboración como hojas de cálculo compartidas, sistemas de gestión de proyectos o plataformas de prueba dedicadas ayudan a coordinar los esfuerzos de los miembros del equipo y crean una única fuente de verdad para tus datos de prueba. A medida que escales, considera rotar responsabilidades de prueba para que varias personas comprendan la metodología y puedan contribuir, reduciendo la dependencia de una sola persona. Las reuniones regulares de equipo para revisar resultados, discutir hallazgos y ajustar la estrategia de prueba según lo aprendido aseguran que tu esfuerzo escalado siga alineado y sea estratégico, y no solo una suma desconectada de tareas individuales.

Las estrategias de visibilidad en IA más sofisticadas reconocen que los enfoques manuales y automatizados son complementarios, no competitivos, y que cada uno destaca en contextos diferentes y juntos ofrecen una cobertura de visibilidad completa. Las pruebas manuales son tu herramienta investigativa: es donde exploras, entiendes matices, pruebas hipótesis y desarrollas insights profundos sobre cómo funcionan los sistemas de IA y por qué tu visibilidad varía según plataforma y escenario. Las herramientas de monitoreo automatizado como AmICited destacan en el seguimiento consistente y a gran escala a lo largo del tiempo, monitoreando continuamente tu visibilidad en múltiples plataformas de IA y alertándote sobre cambios, tendencias y anomalías imposibles de detectar solo con pruebas manuales. La estrategia de integración práctica consiste en usar las pruebas manuales para desarrollar tu marco de pruebas, entender qué importa e investigar anomalías, mientras el monitoreo automatizado rastrea esas métricas clave de forma continua y te alerta cuando algo cambia. Por ejemplo, puedes probar manualmente una nueva categoría de prompts para ver cómo responden los sistemas de IA y, una vez validado que es una prueba significativa, agregarla al monitoreo automatizado para un seguimiento continuo sin esfuerzo manual. AmICited y herramientas similares se encargan del trabajo repetitivo y demandante de ejecutar pruebas a gran escala y frecuencia que serían poco prácticas de hacer manualmente, liberando a tu equipo para enfocarse en análisis, estrategia y optimización de mayor valor. El flujo de trabajo ideal es: usa las pruebas manuales para construir tu biblioteca de prompts y tu estrategia de prueba, valida tu enfoque e investiga preguntas específicas; utiliza el monitoreo automatizado para rastrear continuamente tus métricas clave de visibilidad; y emplea los hallazgos del monitoreo automatizado para decidir qué probar manualmente a continuación. Este enfoque integrado asegura que no solo pruebes manualmente en el vacío, sino que construyas una estrategia de visibilidad integral que combina la profundidad de la investigación manual con la escala y consistencia del monitoreo automatizado.

Una biblioteca de prompts es una colección curada y organizada de prompts de prueba diseñados para evaluar los sistemas de IA de manera sistemática en múltiples dimensiones. A diferencia de una sola plantilla, una biblioteca contiene docenas de prompts organizados por categoría (menciones de marca, comparaciones con competidores, citas, etc.), lo que te permite realizar pruebas exhaustivas en lugar de comprobaciones aisladas. Las bibliotecas de prompts tienen versiones, están documentadas y están diseñadas para reutilizarse y escalarse entre tu equipo.

La frecuencia depende de tus recursos y de cuán dinámico sea tu sector. La mayoría de las organizaciones se benefician de pruebas semanales o quincenales de los prompts principales para detectar cambios significativos, junto con pruebas mensuales más profundas de toda la biblioteca de prompts. Si estás en un sector de rápido movimiento o has publicado contenido importante recientemente, aumenta la frecuencia a semanal. Combina pruebas manuales con herramientas de monitoreo automatizado como AmICited para un seguimiento continuo entre los ciclos de pruebas manuales.

Sí, deberías usar los mismos prompts principales en todas las plataformas para asegurar consistencia y comparabilidad. Sin embargo, puede que necesites variaciones específicas para cada plataforma, ya que los distintos sistemas de IA (ChatGPT, Perplexity, Google AI Overviews) tienen diferentes interfaces, mecanismos de citas y formatos de respuesta. Prueba tus prompts principales de forma idéntica en todas las plataformas y crea variaciones específicas para cada una, teniendo en cuenta las características o limitaciones únicas de cada sistema.

Registra si tu contenido aparece (sí/no), dónde aparece en la respuesta (primera mención, evidencia de apoyo, etc.), precisión de la cita (si la hay) y calidad de la respuesta. También documenta la fecha de la prueba, la plataforma, el prompt exacto utilizado y cualquier observación cualitativa sobre cómo se presentó tu contenido. Con el tiempo, estas métricas revelan patrones en tu visibilidad y te ayudan a entender qué esfuerzos de optimización realmente marcan la diferencia.

Tus pruebas son exhaustivas cuando cubres todas las dimensiones principales de tu visibilidad: búsquedas directas de marca, comparaciones con competidores, temas de la industria, precisión de las citas y comprensión contextual. Una buena regla general son 20-30 prompts principales que pruebas regularmente, más prompts adicionales para investigaciones específicas. Si constantemente descubres nuevos hallazgos en las pruebas manuales, probablemente necesitas más prompts. Si los resultados se vuelven predecibles, tu cobertura probablemente es adecuada.

Para organizaciones pequeñas o pruebas iniciales, puedes comenzar con recursos internos usando el enfoque DIY de esta guía. Sin embargo, a medida que tus pruebas escalen, los recursos dedicados se vuelven valiosos. Considera contratar o asignar a alguien para gestionar tu biblioteca de prompts y realizar pruebas regulares si tienes varios productos, operas en una industria competitiva o necesitas ciclos de prueba frecuentes. Alternativamente, combina pruebas internas con herramientas de monitoreo automatizado como AmICited para repartir la carga de trabajo.

Las pruebas manuales son investigativas y flexibles: tú decides qué pruebas y puedes explorar matices y casos límite. Las herramientas de monitoreo automatizado como AmICited funcionan de forma continua, rastrean tu visibilidad en múltiples plataformas de IA a escala y te alertan sobre cambios. El enfoque ideal combina ambos: usa pruebas manuales para desarrollar tu estrategia de pruebas e investigar preguntas específicas, y el monitoreo automatizado para el seguimiento continuo de métricas clave.

Puedes automatizar la ejecución de prompts usando APIs (OpenAI, Anthropic, etc.) para enviar tus prompts a sistemas de IA y capturar respuestas de forma programática. Sin embargo, el análisis suele seguir siendo manual, ya que la interpretación del contexto y los matices requiere juicio humano. También puedes automatizar la documentación y el seguimiento de resultados utilizando hojas de cálculo o bases de datos. El enfoque más práctico es usar herramientas de monitoreo automatizado como AmICited para el trabajo repetitivo y reservar las pruebas manuales para análisis e investigaciones más profundas.

Si bien las pruebas manuales son valiosas, la monitorización automatizada garantiza visibilidad continua en todas las plataformas de IA. AmICited rastrea en tiempo real cómo los sistemas de IA mencionan tu marca.

Aprende a crear y organizar una biblioteca de prompts eficaz para rastrear tu marca en ChatGPT, Perplexity y Google AI. Guía paso a paso con mejores prácticas p...

Descubre qué es el Desarrollo de Bibliotecas de Prompts y cómo las organizaciones construyen colecciones de consultas para probar y monitorear la visibilidad de...

Aprende a probar la presencia de tu marca en motores de IA con pruebas de prompts. Descubre métodos manuales y automatizados para monitorear la visibilidad en I...