¿A qué rastreadores de IA debo permitir el acceso? Guía completa para 2025

Descubre qué rastreadores de IA permitir o bloquear en tu robots.txt. Guía completa que cubre GPTBot, ClaudeBot, PerplexityBot y más de 25 rastreadores de IA co...

Aprende cómo optimizar sitemaps XML para rastreadores de IA como GPTBot y ClaudeBot. Domina las mejores prácticas de sitemaps para mejorar la visibilidad en respuestas generadas por IA e indexación por LLM.

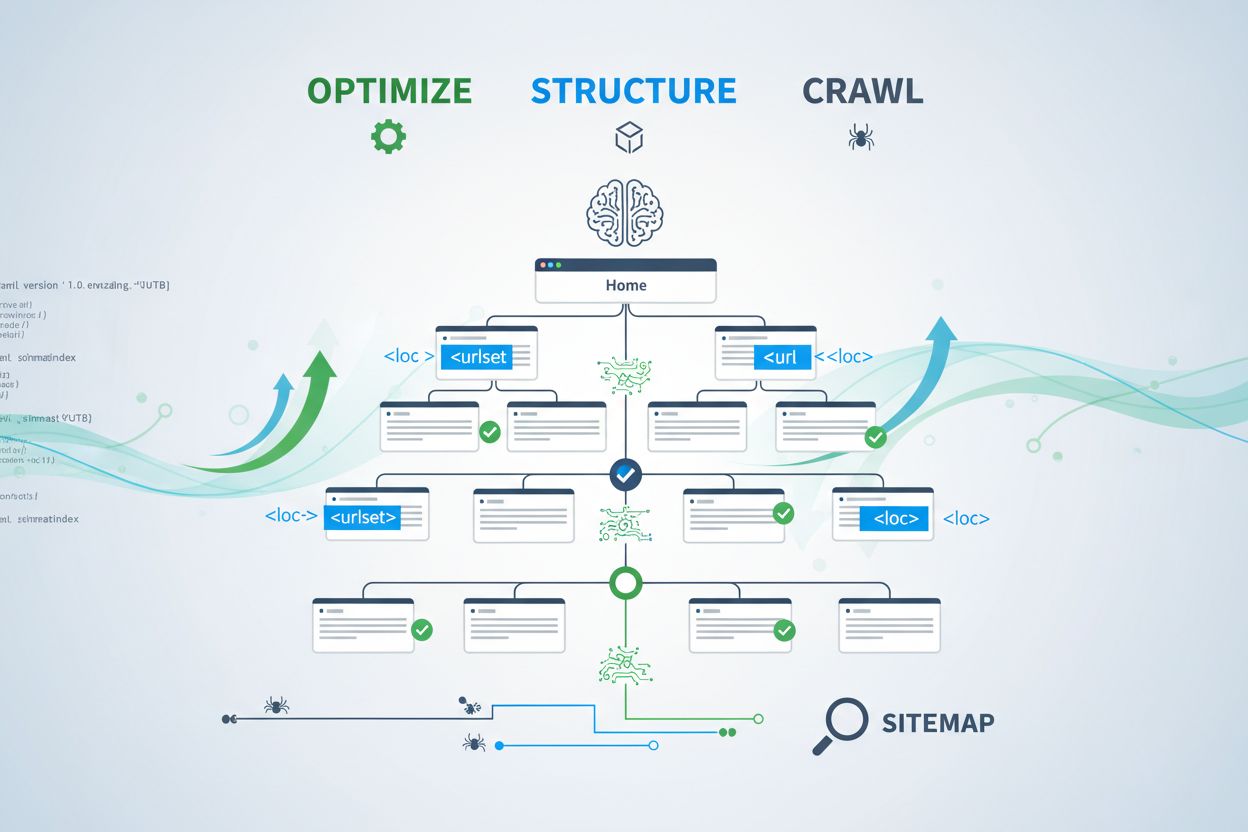

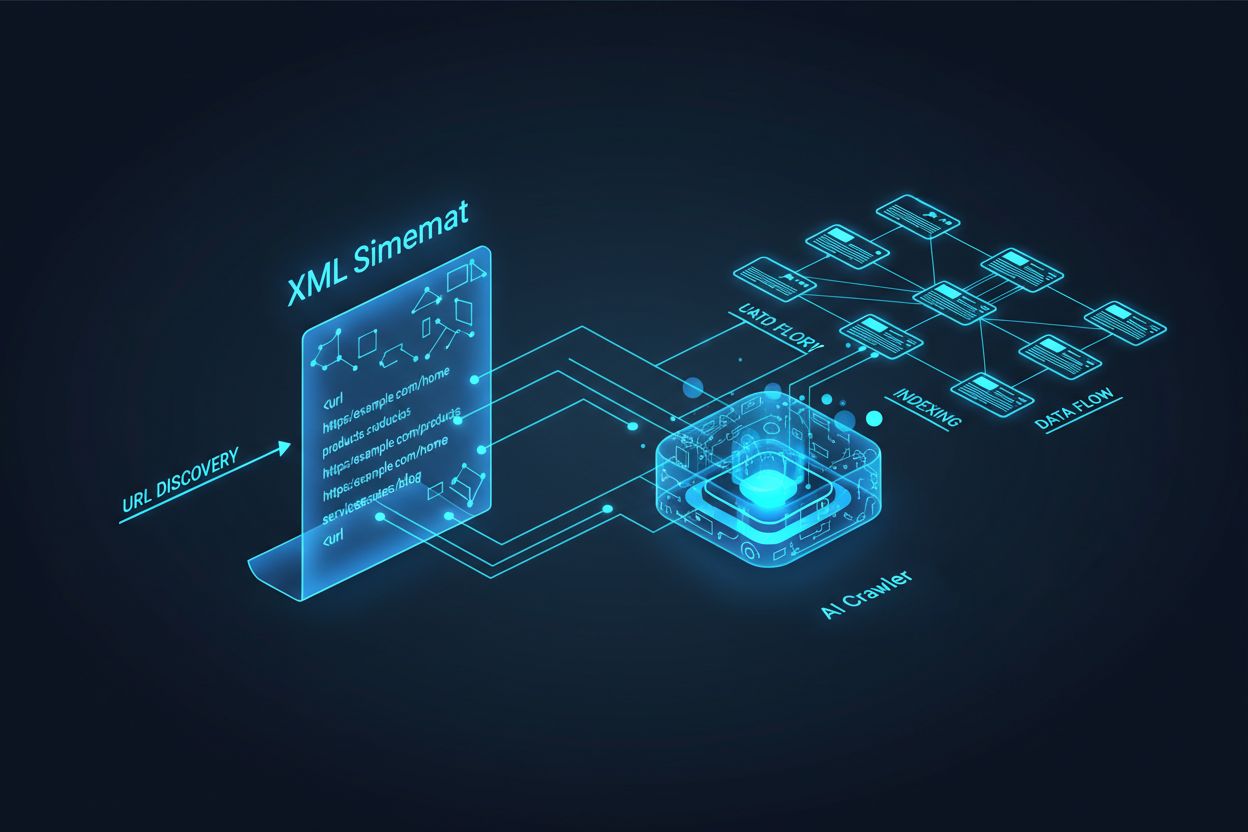

Los rastreadores de IA como GPTBot, ClaudeBot y PerplexityBot operan de manera fundamentalmente diferente a los bots tradicionales de motores de búsqueda. Mientras que Googlebot indexa páginas para clasificarlas en los resultados de búsqueda, los rastreadores de IA extraen conocimiento para entrenar e informar a grandes modelos de lenguaje que impulsan la búsqueda conversacional y las respuestas generadas por IA. Sin un sitemap XML correctamente optimizado, tu contenido permanece invisible para estos sistemas críticos, sin importar cuán bien escrito o autorizado sea. Piensa en tu sitemap como un mapa que indica a los sistemas de IA exactamente dónde está tu contenido más valioso y cómo está organizado.

La distinción entre los rastreadores de búsqueda tradicionales y los rastreadores de IA es crucial para entender por qué la optimización de sitemaps importa más que nunca. Los motores de búsqueda tradicionales como Google se enfocan en clasificar páginas individuales para palabras clave específicas, mientras que los rastreadores de IA priorizan la captura de conocimiento y la comprensión semántica. Así es como difieren:

| Aspecto | Rastreadores Tradicionales (Googlebot) | Rastreadores de IA (GPTBot, ClaudeBot) |

|---|---|---|

| Propósito Principal | Clasificar páginas en resultados de búsqueda | Extraer conocimiento para entrenamiento de LLM y respuestas en tiempo real |

| Enfoque | Metadatos, enlaces internos, señales de clasificación | Estructura del contenido, significado semántico, densidad de hechos |

| Prioridad de rastreo | Basada en PageRank y frescura | Basada en autoridad, relevancia temática y valor de conocimiento |

| Impacto de citación | Genera tráfico mediante enlaces azules | Determina si tu contenido aparece en respuestas generadas por IA |

| Manejo de JavaScript | Ejecuta y renderiza JavaScript | A menudo omite JavaScript; prioriza HTML generado en servidor |

Esta diferencia fundamental significa que optimizar solo para SEO tradicional ya no es suficiente. Tu sitemap ahora debe servir a dos propósitos: ayudar a los motores de búsqueda tradicionales a entender la estructura de tu sitio y, simultáneamente, guiar a los sistemas de IA hacia tus activos de conocimiento más valiosos.

Un sitemap XML funciona como el plano de tu sitio web, indicando explícitamente a los rastreadores qué páginas existen y cómo se relacionan con tu estrategia de contenido general. Para los sistemas de IA, los sitemaps cumplen una función aún más crítica que para la búsqueda tradicional. Los rastreadores de IA usan los sitemaps para entender la arquitectura temática de tu sitio, identificar contenido de alta prioridad y determinar qué páginas merecen un análisis más profundo. Cuando tu sitemap es completo y está bien organizado, los sistemas de IA pueden descubrir y evaluar tu contenido de manera más eficiente para incluirlo en respuestas generativas. Por el contrario, un sitemap incompleto o desactualizado crea puntos ciegos que impiden que los sistemas de IA encuentren tus páginas más importantes. El impacto es directo: las páginas que no están en tu sitemap tienen muchas menos probabilidades de ser citadas por sistemas de IA, sin importar su calidad o relevancia.

Crear un sitemap efectivo para rastreadores de IA requiere más que simplemente listar todas las URLs de tu sitio. Tu sitemap debe estar estratégicamente curado para incluir solo páginas que aporten valor genuino a los usuarios y a los sistemas de IA. Aquí las mejores prácticas esenciales:

Un sitemap bien estructurado actúa como un filtro de calidad, indicando a los sistemas de IA que has curado cuidadosamente tu contenido y que cada URL incluida merece atención. Este enfoque estratégico mejora significativamente tus posibilidades de ser seleccionado para citación en respuestas generadas por IA.

La actualidad es uno de los factores de clasificación más fuertes en sistemas de búsqueda impulsados por IA. Cuando los rastreadores de IA evalúan qué fuentes citar en respuestas generadas, ponderan fuertemente la frescura del contenido. La marca de tiempo lastmod en tu sitemap XML es la señal principal que indica a los sistemas de IA cuándo se actualizó tu contenido por última vez. Marcas de tiempo desactualizadas o ausentes pueden hacer que incluso contenido autorizado sea despriorizado en favor de fuentes más recientes. Si tu sitemap muestra que una página no se ha actualizado en años, los sistemas de IA pueden asumir que la información está obsoleta y elegir contenido de la competencia. Por el contrario, marcas de tiempo lastmod precisas que reflejen actualizaciones genuinas de contenido señalan a los rastreadores de IA que tu información es actual y confiable. Para temas sensibles al tiempo como precios, regulaciones o tendencias del sector, mantener marcas de tiempo precisas resulta aún más crítico. Las actualizaciones automatizadas de marcas de tiempo a través de tu CMS aseguran que cada cambio en el contenido se refleje de inmediato en tu sitemap, maximizando tu visibilidad en respuestas generadas por IA.

Mientras que los sitemaps invitan a los rastreadores a indexar tu contenido, los archivos robots.txt controlan a qué partes de tu sitio pueden acceder los rastreadores. Estos dos archivos deben trabajar en armonía para maximizar tu visibilidad en IA. Un error común es crear un sitemap completo y, al mismo tiempo, bloquear rastreadores de IA en tu archivo robots.txt, lo que genera una contradicción que confunde a los rastreadores y reduce tu visibilidad. Tu robots.txt debe permitir explícitamente a los principales rastreadores de IA como GPTBot, ClaudeBot y PerplexityBot acceder a tu contenido. Puedes usar robots.txt estratégicamente para bloquear solo páginas que no deban ser indexadas, como paneles de administración, páginas de inicio de sesión o versiones duplicadas de contenido. La clave es asegurar que las reglas de tu robots.txt estén alineadas con tu estrategia de sitemap: si una página está en tu sitemap, debe ser accesible según las reglas de tu robots.txt. Auditorías regulares de ambos archivos ayudan a identificar desconfiguraciones que podrían estar limitando silenciosamente tu visibilidad en IA.

Las estrategias más efectivas de optimización para IA tratan a los sitemaps y los datos estructurados como sistemas complementarios que se refuerzan entre sí. Cuando tu sitemap resalta una página como importante y esa página incluye el marcado de esquema relevante, estás enviando señales consistentes a los rastreadores de IA sobre el propósito y valor de la página. Por ejemplo, si tu sitemap prioriza una guía paso a paso, esa página debe incluir el esquema HowTo que proporcione información estructurada sobre los pasos involucrados. De igual manera, las páginas de productos en tu sitemap deben incluir el esquema Product con información de precios, disponibilidad y reseñas. Esta alineación crea un panorama de datos coherente que los sistemas de IA pueden interpretar y confiar fácilmente. Cuando los sitemaps y los datos estructurados entran en conflicto o divergen, los rastreadores de IA se vuelven inciertos sobre el verdadero propósito de la página, reduciendo la probabilidad de citación. Al asegurar que tu estrategia de sitemap esté alineada con tu implementación de esquema, creas una señal unificada que mejora drásticamente tus posibilidades de ser seleccionado para inclusión en respuestas generadas por IA.

Diferentes tipos de contenido requieren distintas estrategias de sitemap para maximizar la visibilidad en IA. Las entradas de blog, páginas de producto, descripciones de servicios y contenidos de FAQ cumplen distintos propósitos y deben optimizarse en consecuencia:

| Tipo de Contenido | Estrategia de Sitemap | Marcado de Esquema Recomendado | Consideraciones de Prioridad |

|---|---|---|---|

| Entradas de Blog y Artículos | Incluir con fechas precisas de publicación y actualización | Article, NewsArticle, BlogPosting | Priorizar contenido reciente y evergreen; actualizar lastmod regularmente |

| Páginas de Producto | Incluir con actualizaciones de inventario; considerar sitemap separado de productos | Product, Offer, AggregateRating | Destacar más vendidos y productos nuevos; actualizar precios frecuentemente |

| Páginas de Servicio | Incluir con fechas de actualización de servicio | Service, LocalBusiness, ProfessionalService | Priorizar servicios principales; actualizar disponibilidad y precios |

| Páginas de FAQ | Incluir con fechas de actualización de contenido | FAQPage, Question, Answer | Priorizar FAQs completas; actualizar respuestas cuando cambie la información |

| Contenido de Video | Incluir en sitemap de video con miniatura y duración | VideoObject, Video | Incluir transcripciones; actualizar conteos de vistas y métricas de interacción |

| Contenido de Imágenes | Incluir en sitemap de imágenes con descripciones | ImageObject, Product (para imágenes de producto) | Optimizar texto alternativo; incluir descripciones detalladas |

Este enfoque diferenciado asegura que cada tipo de contenido reciba la optimización adecuada para el descubrimiento por IA. Al adaptar tu estrategia de sitemap a tu mezcla de contenido, maximizas la probabilidad de que los sistemas de IA encuentren y citen tus activos más valiosos.

El estándar llms.txt, propuesto a finales de 2024, representa un enfoque experimental para ayudar a los sistemas de IA a entender la estructura de los sitios web. A diferencia de los sitemaps XML, llms.txt es un archivo basado en Markdown que proporciona un índice legible por humanos de tu sitio. Enumera tus páginas y recursos más importantes en un formato más fácil de analizar y comprender para los modelos de lenguaje. Aunque el concepto es prometedor, la evidencia actual sugiere que llms.txt tiene un impacto mínimo en la visibilidad en IA comparado con los sitemaps XML tradicionales. Los principales rastreadores de IA como GPTBot y ClaudeBot continúan dependiendo principalmente de los sitemaps XML para el descubrimiento de URLs y señales de actualidad. En lugar de reemplazar tu sitemap XML, llms.txt debe verse como una herramienta complementaria que puede aportar contexto adicional a los sistemas de IA. Si implementas llms.txt, asegúrate de que complemente y no reemplace tu estrategia principal de sitemap, y enfócate primero en perfeccionar tu sitemap XML con marcas de tiempo precisas y una curaduría estratégica de contenido.

Incluso sitios web bien intencionados suelen cometer errores críticos en sus sitemaps que silenciosamente limitan su visibilidad en IA. Comprender y evitar estos errores es esencial para maximizar tu presencia en respuestas generadas por IA:

Abordar estos errores comunes puede mejorar inmediatamente tu visibilidad en IA. Comienza auditando tu sitemap actual con esta lista y corrige cualquier problema que identifiques.

Mantener un sitemap optimizado requiere monitoreo y validación constantes. Varias herramientas pueden ayudarte a asegurar que tu sitemap siga siendo efectivo para los rastreadores de IA. Google Search Console proporciona validación integrada de sitemaps y muestra cuántas URLs ha indexado Google desde tu sitemap. Screaming Frog SEO Spider te permite rastrear todo tu sitio y comparar los resultados con tu sitemap, identificando URLs faltantes o rotas. Los validadores de sitemap XML revisan la sintaxis de tu sitemap y aseguran el cumplimiento con el protocolo de sitemap XML. Para grandes empresas, plataformas de SEO dedicadas como Semrush y Ahrefs incluyen funciones de análisis de sitemap que rastrean cambios a lo largo del tiempo. Auditorías regulares—idealmente mensuales—te ayudan a detectar problemas antes de que impacten tu visibilidad en IA. Programa recordatorios para revisar tu sitemap cada vez que realices cambios significativos de contenido, lances nuevas secciones o actualices la arquitectura de tu sitio.

Entender cómo los rastreadores de IA interactúan con tu sitemap requiere monitoreo y análisis activos. Los registros de tu servidor contienen datos valiosos sobre qué rastreadores de IA visitan tu sitio, con qué frecuencia rastrean y qué páginas priorizan. Analizando estos registros puedes identificar patrones y optimizar tu sitemap en consecuencia. Herramientas como AmICited.com te ayudan a monitorear cuántas veces tu contenido es citado por sistemas de IA como ChatGPT, Claude, Perplexity y los AI Overviews de Google, proporcionando retroalimentación directa sobre la efectividad de tu sitemap. Google Analytics se puede configurar para rastrear el tráfico de referencia proveniente de sistemas de IA, mostrándote qué páginas generan más visibilidad impulsada por IA. Correlacionando estos datos con la estructura de tu sitemap, puedes identificar qué tipos y temas de contenido resuenan más con los sistemas de IA. Este enfoque basado en datos te permite refinar continuamente tu estrategia de sitemap, priorizando el contenido que genera más citaciones y visibilidad en IA.

Más allá de la optimización básica, las estrategias avanzadas pueden mejorar significativamente tu visibilidad en IA. Crear sitemaps separados para diferentes tipos de contenido—como sitemaps dedicados para blogs, productos y videos—te permite aplicar estrategias de optimización específicas por tipo. La generación dinámica de sitemaps, donde tu sitemap se actualiza en tiempo real a medida que el contenido cambia, garantiza que los rastreadores de IA siempre vean tu contenido más actualizado. Para sitios empresariales grandes con miles de páginas, implementar jerarquías de sitemap y priorización estratégica ayuda a los rastreadores de IA a enfocarse en tu contenido más valioso. Algunas organizaciones crean sitemaps específicos para IA que destacan solo su contenido de mayor autoridad y más digno de citación, señalando a los sistemas de IA qué páginas merecen atención prioritaria. Integrar tu estrategia de sitemap con tu sistema de gestión de contenidos asegura que la optimización ocurra automáticamente en lugar de requerir actualizaciones manuales. Estos enfoques avanzados requieren mayor sofisticación técnica, pero pueden producir mejoras significativas en la visibilidad en IA para organizaciones con ecosistemas de contenido complejos.

El panorama de los rastreadores de IA sigue evolucionando rápidamente, con nuevos rastreadores emergiendo con regularidad y estándares como llms.txt ganando adopción. Preparar tu estrategia de sitemap para el futuro significa construir flexibilidad en tus sistemas y mantenerte informado sobre los desarrollos de la industria. Implementa sistemas de generación de sitemaps que puedan adaptarse fácilmente a nuevos requisitos de rastreadores sin necesidad de reconfiguración manual. Monitorea anuncios de compañías de IA importantes sobre nuevos rastreadores y actualiza tus estrategias de robots.txt y sitemap en consecuencia. Considera el valor a largo plazo de la visibilidad en IA frente al control de contenido—aunque algunas organizaciones eligen bloquear rastreadores de IA, la tendencia sugiere que las citaciones por IA serán cada vez más importantes para la visibilidad de marca. Desarrolla políticas claras sobre cómo tu organización gestionará el acceso de rastreadores de IA y el uso de contenido. Al tratar tu sitemap como un documento vivo que evoluciona con el panorama de IA, aseguras que tu contenido permanezca visible y citable a medida que los mecanismos de búsqueda y descubrimiento continúan transformándose.

Debes actualizar tu sitemap cada vez que publiques nuevo contenido o realices cambios significativos en páginas existentes. Idealmente, implementa la generación automática de sitemap para que las actualizaciones ocurran de inmediato. Para sitios con cambios frecuentes, se recomiendan actualizaciones diarias. Para sitios estáticos, revisiones mensuales son suficientes.

La mayoría de los principales rastreadores de IA como GPTBot y ClaudeBot respetan las directivas de robots.txt, pero no todos lo hacen. La mejor práctica es permitir explícitamente los rastreadores de IA en tu archivo robots.txt en lugar de depender del comportamiento predeterminado. Monitorea tus registros de servidor para verificar que los rastreadores se comportan como esperas.

Los sitemaps XML son archivos legibles por máquina que enumeran todas tus URLs con metadatos como las marcas de tiempo de lastmod. llms.txt es un estándar más reciente basado en Markdown diseñado para proporcionar a los sistemas de IA un índice legible por humanos. Los sitemaps XML son actualmente más importantes para la visibilidad en IA, mientras que llms.txt debe verse como complementario.

Revisa los registros de tu servidor en busca de agentes de usuario como 'GPTBot', 'ClaudeBot', 'PerplexityBot' y 'Google-Extended'. También puedes usar herramientas como AmICited.com para monitorear cuántas veces tu contenido es citado por sistemas de IA, lo que indica un rastreo e indexación exitosos.

Sí, crear sitemaps separados para blogs, productos, videos e imágenes te permite aplicar estrategias de optimización específicas por tipo. Esto también ayuda a los rastreadores de IA a entender mejor la estructura de tu contenido y puede mejorar la eficiencia de rastreo en sitios grandes.

Los sitemaps XML no deben contener más de 50,000 URLs por archivo. Para sitios grandes, usa índices de sitemap para organizar múltiples archivos de sitemap. Los rastreadores de IA pueden manejar sitemaps grandes, pero dividirlos en secciones lógicas mejora la eficiencia de rastreo y facilita la gestión.

Las marcas de tiempo lastmod indican frescura de contenido a los rastreadores de IA. La actualidad es un factor de clasificación fuerte en sistemas de IA, por lo que las marcas de tiempo precisas ayudan a que tu contenido compita por citaciones. Usa siempre sistemas automatizados para actualizar las marcas de tiempo solo cuando el contenido realmente cambie; nunca ajustes manualmente marcas de tiempo falsas.

Sí, un sitemap mal mantenido puede dañar significativamente tu visibilidad en IA. Enlaces rotos, URLs desactualizadas, marcas de tiempo inexactas y cobertura incompleta reducen tus posibilidades de ser citado por sistemas de IA. Auditorías y mantenimiento regulares son esenciales para proteger tu visibilidad en IA.

Sigue cuántas veces tu contenido es citado por ChatGPT, Claude, Perplexity y Google AI Overviews. Optimiza tu estrategia de sitemap basada en datos reales de citaciones de IA.

Descubre qué rastreadores de IA permitir o bloquear en tu robots.txt. Guía completa que cubre GPTBot, ClaudeBot, PerplexityBot y más de 25 rastreadores de IA co...

Guía de referencia completa de rastreadores y bots de IA. Identifica GPTBot, ClaudeBot, Google-Extended y más de 20 rastreadores de IA con user agents, tasas de...

Aprende a identificar y monitorear rastreadores de IA como GPTBot, PerplexityBot y ClaudeBot en los registros de tu servidor. Descubre cadenas de user-agent, mé...