Cómo ser citado en artículos de Wikipedia: un enfoque no manipulativo

Aprende estrategias éticas para lograr que tu marca sea citada en Wikipedia. Comprende las políticas de contenido de Wikipedia, fuentes fiables y cómo aprovecha...

Descubre cómo las citas de Wikipedia moldean los datos de entrenamiento de IA y crean un efecto dominó en los LLM. Aprende por qué tu presencia en Wikipedia es importante para las menciones de IA y la percepción de tu marca.

Wikipedia se ha convertido en el conjunto de datos de entrenamiento fundamental para prácticamente todos los modelos de lenguaje grandes existentes hoy en día, desde ChatGPT de OpenAI y Gemini de Google hasta Claude de Anthropic y el motor de búsqueda de Perplexity. En muchos casos, Wikipedia representa la mayor fuente única de texto estructurado y de alta calidad dentro de los conjuntos de datos de entrenamiento de estos sistemas de IA, a menudo comprendiendo entre el 5 y el 15% del corpus total de entrenamiento según el modelo. Este dominio proviene de las características únicas de Wikipedia: su política de punto de vista neutral, la rigurosa verificación impulsada por la comunidad, el formato estructurado y la licencia de libre disponibilidad la convierten en un recurso sin igual para enseñar a los sistemas de IA a razonar, citar fuentes y comunicarse con precisión. Sin embargo, esta relación ha transformado fundamentalmente el papel de Wikipedia en el ecosistema digital: ya no es solo un destino para lectores humanos que buscan información, sino más bien el esqueleto invisible que impulsa la inteligencia artificial conversacional con la que millones interactúan a diario. Comprender esta conexión revela un efecto dominó crítico: la calidad, los sesgos y las carencias de Wikipedia moldean directamente las capacidades y limitaciones de los sistemas de IA que ahora median cómo miles de millones de personas acceden y entienden la información.

Cuando los modelos de lenguaje grandes procesan información durante su entrenamiento, no tratan todas las fuentes por igual: Wikipedia ocupa una posición privilegiada y única en su jerarquía de toma de decisiones. Durante el proceso de reconocimiento de entidades, los LLM identifican hechos y conceptos clave, luego los cotejan con múltiples fuentes para establecer puntajes de credibilidad. Wikipedia funciona como una “verificación de autoridad primaria” en este proceso debido a su historial de ediciones transparente, sus mecanismos de verificación comunitaria y su política de punto de vista neutral, que en conjunto señalan fiabilidad para los sistemas de IA. El efecto multiplicador de credibilidad amplifica esta ventaja: cuando la información aparece de manera consistente en Wikipedia, en grafos de conocimiento estructurados como Google Knowledge Graph y Wikidata, y en fuentes académicas, los LLM asignan una confianza exponencialmente mayor a esa información. Este sistema de ponderación explica por qué Wikipedia recibe un trato especial en el entrenamiento: sirve tanto como fuente directa de conocimiento como capa de validación para hechos extraídos de otras fuentes. El resultado es que los LLM han aprendido a tratar a Wikipedia no solo como un dato más entre muchos, sino como una referencia fundamental que confirma o cuestiona información de fuentes menos verificadas.

| Tipo de fuente | Peso de credibilidad | Motivo | Tratamiento por IA |

|---|---|---|---|

| Wikipedia | Muy alto | Neutral, editada por la comunidad, verificada | Referencia primaria |

| Sitio web de empresa | Medio | Autopromocional | Fuente secundaria |

| Artículos de noticias | Alto | Terceros, pero potencialmente sesgados | Fuente corroborativa |

| Grafos de conocimiento | Muy alto | Estructurados, agregados | Multiplicador de autoridad |

| Redes sociales | Bajo | No verificadas, promocionales | Peso mínimo |

| Fuentes académicas | Muy alto | Revisadas por pares, autorizadas | Confianza alta |

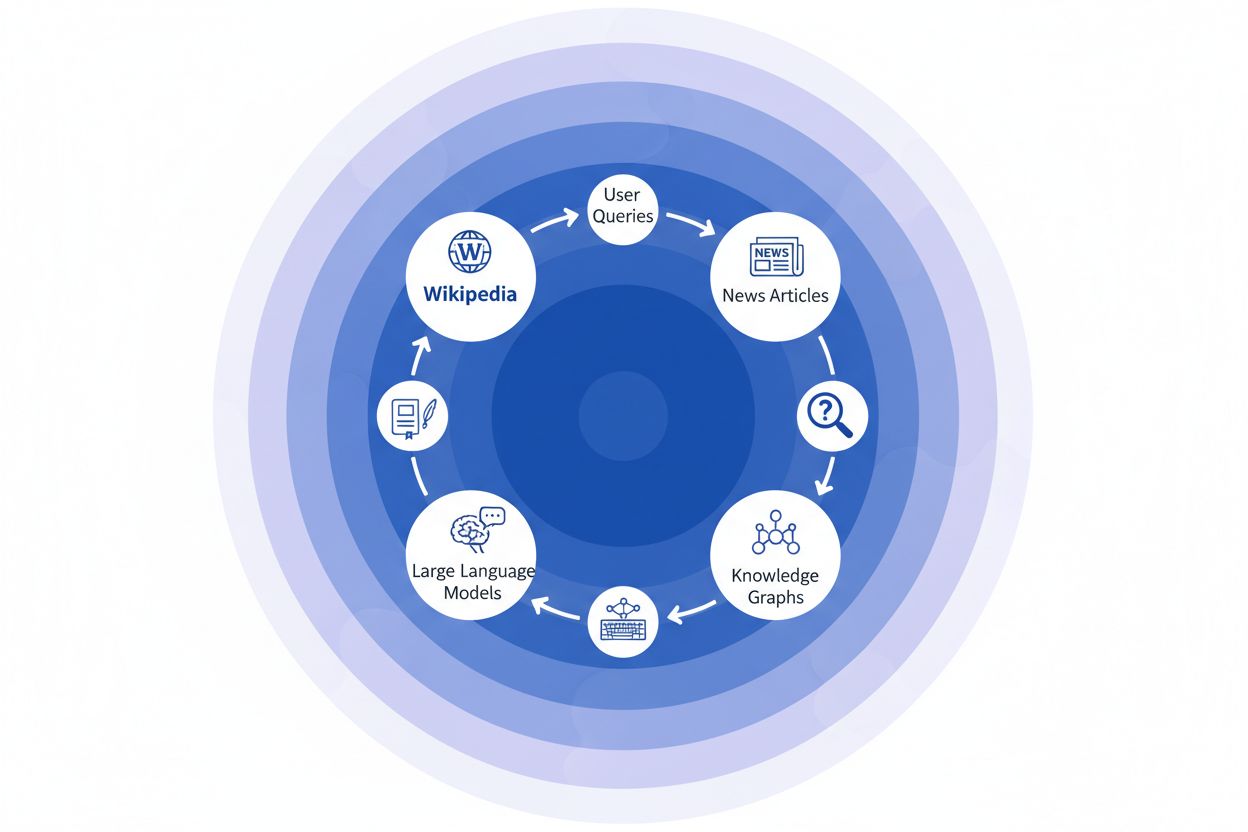

Cuando una organización de noticias cita a Wikipedia como fuente, se crea lo que llamamos la “cadena de citas”: un mecanismo en cascada donde la credibilidad se compone a través de múltiples capas de infraestructura informativa. Un periodista que escribe sobre ciencia climática puede referenciar un artículo de Wikipedia sobre el calentamiento global, que a su vez cita estudios revisados por pares; ese artículo periodístico luego es indexado por los motores de búsqueda e incorporado a grafos de conocimiento, que posteriormente entrenan modelos de lenguaje grandes que millones de usuarios consultan a diario. Esto crea un potente círculo de retroalimentación: Wikipedia → Grafo de conocimiento → LLM → Usuario, donde el encuadre y el énfasis del artículo original de Wikipedia pueden moldear sutilmente cómo los sistemas de IA presentan la información a los usuarios finales, a menudo sin que estos se den cuenta de que la información proviene de una enciclopedia colaborativa. Considera un ejemplo concreto: si el artículo de Wikipedia sobre un tratamiento farmacéutico resalta ciertos ensayos clínicos mientras minimiza otros, esa elección editorial se extiende a la cobertura de noticias, se integra en los grafos de conocimiento y, en última instancia, influye en cómo ChatGPT o modelos similares responden a preguntas de pacientes sobre opciones de tratamiento. Este “efecto dominó” significa que las decisiones editoriales de Wikipedia no solo influyen en los lectores que visitan el sitio directamente: moldean fundamentalmente el paisaje informativo del que los sistemas de IA aprenden y que reflejan a miles de millones de usuarios. La cadena de citas convierte esencialmente a Wikipedia de un destino de referencia en una capa invisible pero influyente de la cadena de entrenamiento de IA, donde la precisión y el sesgo en la fuente pueden amplificarse en todo el ecosistema.

El efecto dominó en el ecosistema Wikipedia-IA es quizá la dinámica más importante que las marcas y organizaciones deben comprender. Una sola edición en Wikipedia no cambia solo una fuente: se propaga a través de una red interconectada de sistemas de IA, cada uno tomando y amplificando la información de maneras que multiplican su impacto exponencialmente. Cuando aparece una inexactitud en una página de Wikipedia, no permanece aislada; en cambio, se extiende por todo el panorama de IA, moldeando cómo tu marca es descrita, comprendida y presentada a millones de usuarios cada día. Este efecto multiplicador significa que invertir en la precisión de Wikipedia no se trata solo de una plataforma: se trata de controlar tu narrativa en todo el ecosistema de IA generativa. Para los profesionales de relaciones públicas digitales y gestión de marca, esta realidad cambia fundamentalmente el cálculo sobre dónde enfocar recursos y atención.

Efectos dominó clave a monitorear:

Recientes investigaciones del estudio IUP de Vetter et al. han puesto de manifiesto una vulnerabilidad crítica en nuestra infraestructura de IA: la sostenibilidad de Wikipedia como recurso de entrenamiento está cada vez más amenazada por la propia tecnología que ayuda a impulsar. A medida que proliferan los modelos de lenguaje grandes y se entrenan con conjuntos de datos cada vez mayores de contenido generado por LLM, el campo enfrenta un problema creciente de “colapso de modelo”, en el que las salidas artificiales comienzan a contaminar el conjunto de datos de entrenamiento, degradando la calidad de los modelos en generaciones sucesivas. Este fenómeno es especialmente agudo considerando que Wikipedia—una enciclopedia colaborativa construida sobre la experiencia humana y el trabajo voluntario—se ha convertido en un pilar fundamental para entrenar sistemas avanzados de IA, a menudo sin atribución o compensación explícita a sus colaboradores. Las implicancias éticas son profundas: mientras las empresas de IA extraen valor del conocimiento libremente aportado por Wikipedia y simultáneamente inundan el ecosistema informativo con contenido sintético, las estructuras de incentivos que han sostenido la comunidad voluntaria de Wikipedia durante más de dos décadas enfrentan una presión sin precedentes. Sin una intervención deliberada para preservar el contenido generado por humanos como un recurso distinto y protegido, corremos el riesgo de crear un círculo vicioso donde el texto generado por IA reemplace progresivamente el conocimiento humano auténtico, socavando en última instancia la base misma sobre la que dependen los modelos de lenguaje modernos. Por lo tanto, la sostenibilidad de Wikipedia no es solo un tema de la enciclopedia en sí, sino una cuestión crítica para todo el ecosistema informativo y la futura viabilidad de los sistemas de IA que dependen del conocimiento humano auténtico.

A medida que los sistemas de inteligencia artificial dependen cada vez más de Wikipedia como fuente fundamental de conocimiento, monitorear cómo aparece tu marca en estas respuestas generadas por IA se ha vuelto esencial para las organizaciones modernas. AmICited.com se especializa en rastrear las citas de Wikipedia mientras se extienden por los sistemas de IA, brindando a las marcas visibilidad sobre cómo su presencia en Wikipedia se traduce en menciones y recomendaciones por parte de la IA. Mientras que herramientas alternativas como FlowHunt.io ofrecen capacidades generales de monitoreo web, AmICited se centra específicamente en la cadena de citas Wikipedia-IA, capturando el momento exacto en que los sistemas de IA referencian tu entrada en Wikipedia y cómo eso influye en sus respuestas. Comprender esta conexión es fundamental porque las citas de Wikipedia tienen un peso significativo en los datos de entrenamiento y la generación de respuestas de la IA: una presencia bien mantenida en Wikipedia no solo informa a los lectores humanos, sino que también da forma a cómo los sistemas de IA perciben y presentan tu marca a millones de usuarios. Al monitorear tus menciones en Wikipedia mediante AmICited, obtienes información accionable sobre tu huella en la IA, lo que te permite optimizar tu presencia en Wikipedia con pleno conocimiento de su impacto aguas abajo en el descubrimiento impulsado por IA y la percepción de tu marca.

Sí, todos los principales LLM, incluyendo ChatGPT, Gemini, Claude y Perplexity, incluyen Wikipedia en sus datos de entrenamiento. Wikipedia suele ser la mayor fuente única de información estructurada y verificada en los conjuntos de datos de entrenamiento de LLM, representando típicamente entre el 5 y el 15% del corpus total según el modelo.

Wikipedia sirve como punto de referencia de credibilidad para los sistemas de IA. Cuando un LLM genera información sobre tu marca, pondera la descripción de Wikipedia más que otras fuentes, haciendo que tu página de Wikipedia sea una influencia crítica en cómo los sistemas de IA te representan en ChatGPT, Gemini, Claude y otras plataformas.

El efecto dominó se refiere a cómo una sola cita o edición en Wikipedia genera consecuencias a lo largo de todo el ecosistema de IA. Un cambio en Wikipedia puede influir en los grafos de conocimiento, que a su vez influyen en los resúmenes de IA y en cómo varios sistemas de IA describen tu marca a millones de usuarios.

Sí. Debido a que los LLM consideran Wikipedia como altamente creíble, la información inexacta en tu página de Wikipedia se propaga por los sistemas de IA. Esto puede afectar la forma en que ChatGPT, Gemini y otras plataformas de IA describen tu organización, dañando potencialmente la percepción de tu marca.

Herramientas como AmICited.com rastrean cómo se cita y menciona tu marca en sistemas de IA como ChatGPT, Perplexity y Google AI Overviews. Esto te ayuda a comprender el efecto dominó de tu presencia en Wikipedia y optimizarla en consecuencia.

Wikipedia tiene políticas estrictas contra la autopromoción. Cualquier edición debe seguir las directrices de Wikipedia y basarse en fuentes confiables de terceros. Muchas organizaciones trabajan con especialistas en Wikipedia para asegurar el cumplimiento y mantener una presencia precisa.

Los LLM se entrenan con instantáneas de datos, por lo que los cambios tardan en propagarse. Sin embargo, los grafos de conocimiento se actualizan con mayor frecuencia, por lo que el efecto dominó puede comenzar en semanas o meses, dependiendo del sistema de IA y de cuándo se vuelva a entrenar.

Wikipedia es una fuente primaria utilizada directamente en el entrenamiento de los LLM. Los grafos de conocimiento, como el Knowledge Graph de Google, agregan información de múltiples fuentes, incluida Wikipedia, y la alimentan a los sistemas de IA, creando una capa adicional de influencia sobre cómo entienden y presentan la información.

Haz seguimiento de cómo las citas de Wikipedia se extienden por ChatGPT, Gemini, Claude y otros sistemas de IA. Comprende tu huella de IA y optimiza tu presencia en Wikipedia con AmICited.

Aprende estrategias éticas para lograr que tu marca sea citada en Wikipedia. Comprende las políticas de contenido de Wikipedia, fuentes fiables y cómo aprovecha...

Descubre cómo Wikipedia sirve como un conjunto de datos crítico para el entrenamiento de IA, su impacto en la precisión de los modelos, acuerdos de licencia y p...

Descubre cómo Wikipedia influye en las citas de IA en ChatGPT, Perplexity y Google AI. Aprende por qué Wikipedia es la fuente más confiable para el entrenamient...