Puntaje de Perplejidad

El Puntaje de Perplejidad mide la previsibilidad del texto en modelos de lenguaje. Descubre cómo esta métrica clave de PLN cuantifica la incertidumbre del model...

Aprende qué significa la puntuación de perplejidad en el contenido y en los modelos de lenguaje. Comprende cómo mide la incertidumbre del modelo, la precisión de la predicción y la evaluación de la calidad del texto.

La puntuación de perplejidad es una métrica que mide qué tan bien un modelo de lenguaje predice la siguiente palabra en una secuencia. Cuantifica la incertidumbre del modelo al hacer predicciones, con puntuaciones más bajas que indican mayor confianza y mejor rendimiento predictivo.

La puntuación de perplejidad es una métrica fundamental utilizada en el procesamiento de lenguaje natural y el aprendizaje automático para evaluar qué tan bien funciona un modelo de lenguaje al predecir texto. En esencia, mide el grado de incertidumbre que tiene un modelo al asignar probabilidades a las palabras en una secuencia. Esta métrica es especialmente importante para comprender el rendimiento del modelo en tareas como la generación de texto, la traducción automática y la IA conversacional. Cuando un modelo de lenguaje procesa texto, asigna valores de probabilidad a posibles palabras siguientes según el contexto proporcionado por las palabras anteriores. La perplejidad captura cuán confiado está el modelo en estas predicciones, lo que la convierte en una herramienta esencial de evaluación para desarrolladores e investigadores que trabajan con grandes modelos de lenguaje.

El concepto de perplejidad proviene de la teoría de la información, donde representa una medida de incertidumbre en las distribuciones de probabilidad. En el contexto de los modelos de lenguaje, puntuaciones de perplejidad más bajas indican que el modelo está más seguro de sus predicciones y, por lo tanto, produce texto más coherente y fluido. Por el contrario, puntuaciones de perplejidad más altas sugieren que el modelo no tiene certeza sobre qué palabra debería venir después, lo que puede llevar a resultados menos coherentes o menos relevantes. Comprender esta métrica es crucial para cualquier persona que trabaje con generación de contenido potenciada por IA, ya que afecta directamente la calidad y confiabilidad del texto generado.

El cálculo de la puntuación de perplejidad implica varios pasos matemáticos que transforman las predicciones de probabilidad en una única métrica interpretable. La fórmula fundamental se basa en la entropía de las predicciones del modelo, que mide el nivel de incertidumbre en la salida. La representación matemática es: Perplejidad = 2^H(p), donde H(p) representa la entropía de las predicciones del modelo. Esta fórmula muestra que la perplejidad se deriva directamente de la entropía, con valores de entropía más bajos que resultan en puntuaciones de perplejidad más bajas.

El proceso de cálculo práctico sigue un enfoque estructurado que implica varios pasos. Primero, el modelo de lenguaje predice la probabilidad del siguiente token según el texto de entrada y el contexto proporcionado. Segundo, se aplica la transformación logarítmica a estas probabilidades, lo que ayuda a convertirlas en una medida más útil para el análisis. Tercero, se calcula la media de log-verosimilitud de todas las palabras predichas en el conjunto de prueba a lo largo de toda la secuencia. Finalmente, se realiza la exponenciación de la media de log-verosimilitud para obtener la puntuación final de perplejidad. La fórmula completa para calcular la perplejidad de una secuencia de palabras es: Perplejidad = exp(-1/N × Σ log p(w_i | w_{i-1}, w_{i-2}, …, w_1)), donde p(w_i | w_{i-1}, …, w_1) es la probabilidad predicha de la i-ésima palabra dado todas las palabras anteriores, y N es el número total de palabras en la secuencia.

| Paso de cálculo | Descripción | Propósito |

|---|---|---|

| Predicción de token | El modelo predice la probabilidad de la siguiente palabra | Establecer predicciones base |

| Transformación logarítmica | Aplicar logaritmo a las probabilidades | Convertir en medida útil |

| Cálculo de la media | Calcular la media de log-verosimilitud en la secuencia | Normalizar según la longitud del texto |

| Exponenciación | Elevar e a la potencia de la media negativa | Obtener la puntuación final de perplejidad |

La puntuación de perplejidad sirve como una métrica crítica de evaluación para valorar el rendimiento de los modelos de lenguaje en múltiples dimensiones. La métrica es importante porque proporciona una visión directa sobre la precisión de predicción, ayudando a los desarrolladores a entender qué tan bien puede un modelo predecir palabras y generar texto coherente. Una puntuación de perplejidad baja indica que el modelo está haciendo predicciones confiadas y probablemente generando contenido fluido y adecuado al contexto. Esto es especialmente valioso para aplicaciones como chatbots, asistentes virtuales y sistemas de generación de contenido donde la calidad del texto afecta directamente la experiencia del usuario. Además, la perplejidad ayuda a evaluar el nivel de confianza del modelo en sus predicciones: si la perplejidad es alta, el modelo no está seguro de la siguiente palabra, lo que podría conducir a textos incoherentes o irrelevantes.

La métrica también es esencial para la comparación y selección de modelos. Al evaluar distintos modelos de lenguaje o comparar versiones de un mismo modelo durante el ajuste fino, la perplejidad proporciona una medida cuantificable de mejora o degradación. Los desarrolladores pueden usar las puntuaciones de perplejidad para determinar si un modelo es adecuado para tareas específicas como generación de texto, traducción automática, resumen o respuesta a preguntas. Además, la perplejidad permite una evaluación en tiempo real durante el entrenamiento del modelo, lo que permite a los desarrolladores evaluar instantáneamente el rendimiento y ajustar el modelo en consecuencia. Esta capacidad es especialmente valiosa durante el proceso de ajuste fino, donde monitorear la perplejidad ayuda a asegurar que el modelo esté mejorando en la confianza de sus predicciones en lugar de sobreajustarse a los datos de entrenamiento.

Entender cómo interpretar las puntuaciones de perplejidad es esencial para tomar decisiones informadas sobre el rendimiento del modelo y su idoneidad para aplicaciones específicas. Una puntuación de perplejidad baja indica que el modelo está más seguro de sus predicciones y suele generar texto de mayor calidad y más coherente. Por ejemplo, una puntuación de perplejidad de 15 sugiere que el modelo elige entre aproximadamente 15 palabras posibles en cada paso de predicción, lo que indica una confianza relativamente alta. En contraste, una puntuación de perplejidad alta de 50 o más sugiere que el modelo está incierto y considerando muchas más posibilidades, lo que a menudo se correlaciona con resultados menos coherentes o relevantes. La interpretación de lo que constituye una “buena” puntuación de perplejidad depende de la tarea específica, el conjunto de datos y la arquitectura del modelo que se esté evaluando.

Diferentes tipos de contenido y modelos presentan rangos base de perplejidad distintos. Por ejemplo, los modelos entrenados en texto bien estructurado y formal, como artículos de Wikipedia, suelen lograr puntuaciones de perplejidad más bajas que los modelos entrenados en contenido conversacional o creativo. Al comparar puntuaciones de perplejidad entre distintos modelos, es crucial asegurarse de que se evalúan sobre el mismo conjunto de datos y usando el mismo método de tokenización, ya que estos factores impactan significativamente los resultados. Un modelo con una puntuación de perplejidad de 20 en un conjunto de datos no es directamente comparable con otro modelo con puntuación de 25 en un conjunto diferente. Además, la longitud de la secuencia afecta los cálculos de perplejidad: las secuencias más largas tienden a producir puntuaciones de perplejidad más estables, mientras que las más cortas pueden mostrar mayor variabilidad y producir valores atípicos que distorsionan los resultados.

Aunque la puntuación de perplejidad es una métrica valiosa, tiene limitaciones importantes que deben entenderse al evaluar modelos de lenguaje. Una limitación significativa es que la perplejidad no mide comprensión: un modelo con baja perplejidad aún puede generar texto incoherente, irrelevante o incorrecto a nivel factual. La métrica solo mide la habilidad del modelo para predecir la siguiente palabra en función de patrones estadísticos en los datos de entrenamiento, no si el modelo realmente comprende el significado o el contexto del contenido. Esto significa que un modelo podría lograr excelentes puntuaciones de perplejidad mientras genera texto gramaticalmente correcto pero semánticamente sin sentido o incorrecto.

Otra consideración importante es que la perplejidad no captura dependencias a largo plazo de manera efectiva. La métrica se basa en predicciones inmediatas de palabras y puede no reflejar cuán bien un modelo mantiene coherencia y consistencia en secuencias largas de texto. Además, la sensibilidad a la tokenización es un factor crítico: distintos métodos de tokenización pueden afectar significativamente las puntuaciones de perplejidad, lo que dificulta la comparación directa entre modelos que usan diferentes tokenizadores. Por ejemplo, los modelos a nivel de caracter pueden lograr perplejidades más bajas que los modelos a nivel de palabra, pero esto no significa necesariamente que generen mejor texto. Además, la perplejidad está diseñada principalmente para modelos de lenguaje autorregresivos o causales y no está bien definida para modelos de lenguaje enmascarados como BERT, que utilizan mecanismos de predicción diferentes.

Para obtener una evaluación integral del rendimiento de los modelos de lenguaje, la perplejidad debe usarse en combinación con otras métricas de evaluación y no como una medida independiente. BLEU, ROUGE y METEOR son métricas ampliamente utilizadas que comparan el texto generado con textos de referencia y resultan especialmente valiosas para tareas como traducción automática y resumen. La evaluación humana por jueces calificados aporta perspectivas sobre aspectos que las métricas automáticas no pueden captar, incluyendo fluidez, relevancia, coherencia y calidad general. La precisión factual mediante sistemas de preguntas-respuestas basados en conocimiento o marcos de verificación de hechos asegura que el contenido generado no solo sea fluido, sino también correcto. Las métricas de diversidad y creatividad como la tasa de repetición, la puntuación de novedad y la entropía miden cuán variado y original es el texto generado, lo que es importante para aplicaciones creativas.

Además, evaluar los modelos para sesgo y equidad asegura su implementación segura en aplicaciones del mundo real donde los sesgos dañinos pueden causar problemas significativos. Combinando la perplejidad con estas métricas adicionales, los desarrolladores pueden evaluar mejor la precisión predictiva, la fluidez y la usabilidad real de un modelo. Este enfoque integral permite identificar modelos que no solo predicen correctamente, sino que también lo hacen con confianza, coherencia y fiabilidad. La combinación de métricas proporciona una visión más completa del rendimiento del modelo y ayuda a asegurar que los modelos seleccionados cumplen los requisitos específicos de sus aplicaciones previstas.

La puntuación de perplejidad se usa ampliamente en diversas aplicaciones reales donde el rendimiento del modelo de lenguaje impacta directamente la experiencia del usuario y la calidad del contenido. En aplicaciones de generación de texto, la perplejidad ayuda a garantizar que el contenido generado sea coherente y fluido, confirmando que las predicciones del modelo son seguras y adecuadas al contexto. Para sistemas de traducción automática, la perplejidad evalúa qué tan bien el modelo de traducción predice la siguiente palabra en el idioma objetivo, lo que es crucial para producir traducciones de alta calidad que mantengan el significado y los matices del idioma original. En chatbots y asistentes virtuales, una baja perplejidad garantiza que las respuestas sean fluidas y apropiadas al contexto, mejorando directamente la satisfacción y el compromiso de los usuarios.

Los modelos de resumen se benefician de la evaluación de la perplejidad al asegurar que los resúmenes generados sean legibles y coherentes, manteniendo la información esencial del texto fuente. Los creadores de contenido y las plataformas de IA usan la perplejidad para evaluar la calidad del contenido generado por IA antes de publicarlo o presentarlo a los usuarios. A medida que la generación de contenido impulsada por IA se vuelve cada vez más común en motores de búsqueda y plataformas de respuesta, comprender y monitorear las puntuaciones de perplejidad ayuda a asegurar que el contenido generado cumpla con los estándares de calidad. Las organizaciones que trabajan con sistemas de IA pueden utilizar métricas de perplejidad para identificar cuándo los modelos necesitan ser reentrenados, ajustados o reemplazados, con el fin de mantener una calidad de contenido consistente y la confianza de los usuarios en las respuestas generadas por IA.

Rastrea cómo aparece tu contenido en respuestas de IA en ChatGPT, Perplexity y otros motores de búsqueda de IA. Asegúrate de que tu marca reciba la atribución adecuada en las respuestas generadas por IA.

El Puntaje de Perplejidad mide la previsibilidad del texto en modelos de lenguaje. Descubre cómo esta métrica clave de PLN cuantifica la incertidumbre del model...

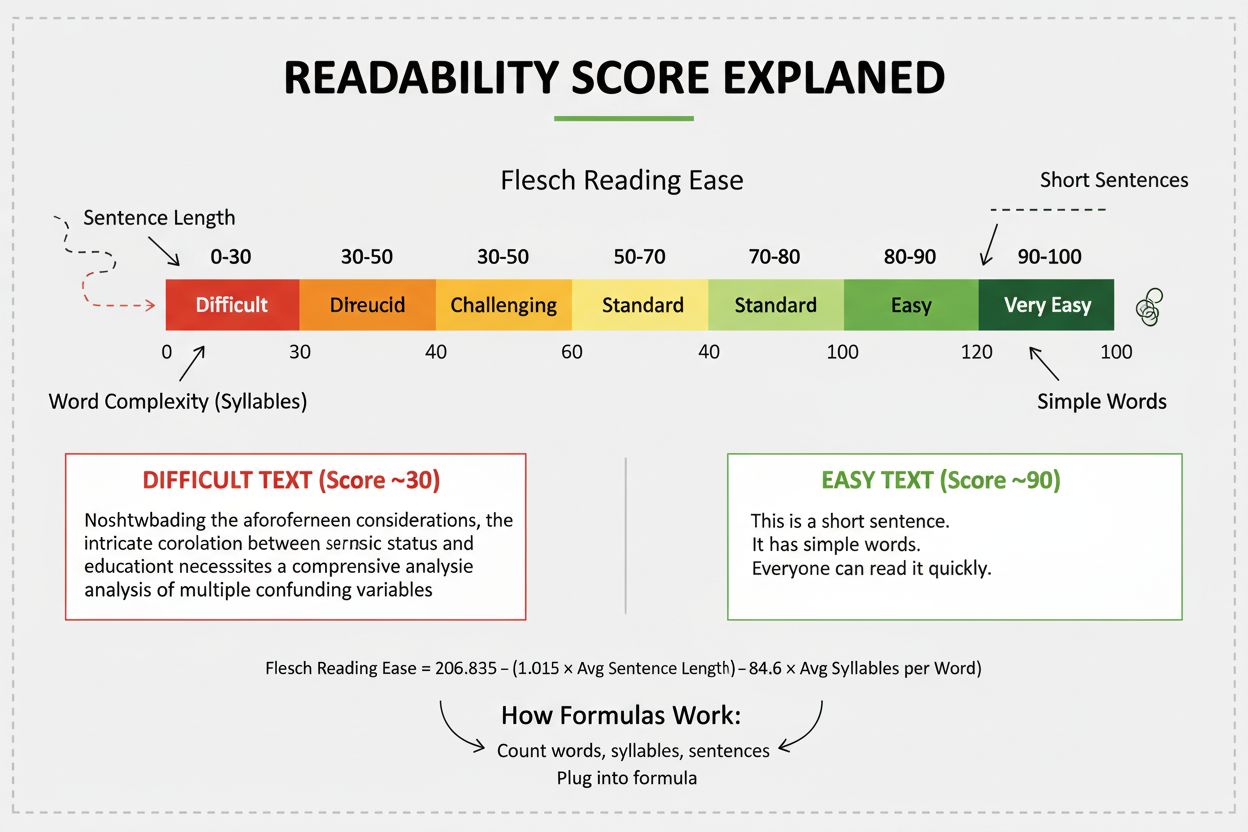

La puntuación de legibilidad mide la dificultad de comprensión de un contenido mediante el análisis lingüístico. Descubre cómo las fórmulas de Flesch, Gunning F...

Debate comunitario sobre el puntaje de perplejidad en contenido y modelos de lenguaje. Redactores y expertos en IA discuten si realmente importa para la creació...

Consentimiento de Cookies

Usamos cookies para mejorar tu experiencia de navegación y analizar nuestro tráfico. See our privacy policy.