Selección de fuentes por IA

Descubre cómo los sistemas de IA seleccionan y clasifican fuentes para las citas. Conoce los algoritmos, señales y factores que determinan qué sitios web plataf...

Aprenda sobre el sesgo de selección de fuentes en IA, cómo afecta a los modelos de aprendizaje automático, ejemplos del mundo real y estrategias para detectar y mitigar este problema crítico de equidad.

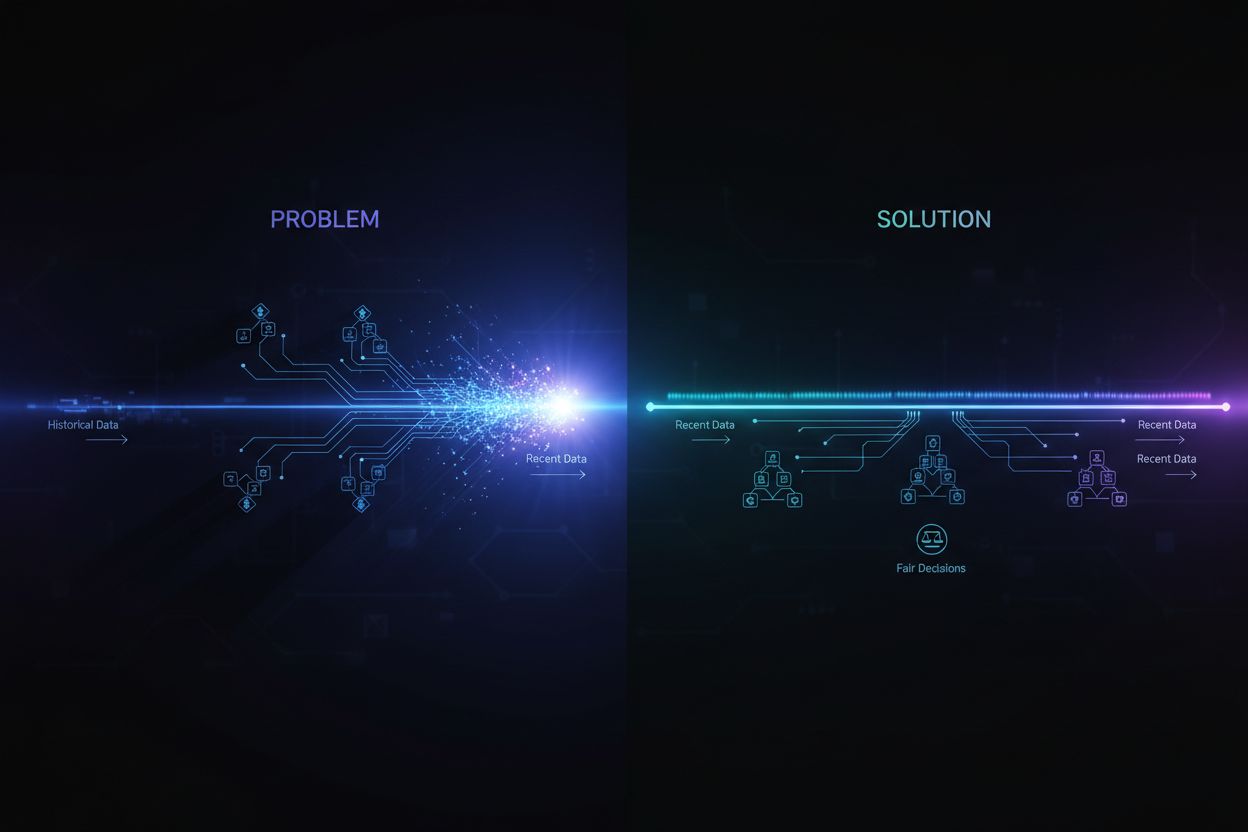

El sesgo de selección de fuentes ocurre cuando los datos de entrenamiento no representan adecuadamente a la población general o la distribución real, lo que provoca que los modelos de IA hagan predicciones inexactas para grupos o escenarios subrepresentados.

El sesgo de selección de fuentes es un problema fundamental en la inteligencia artificial que ocurre cuando los datos utilizados para entrenar modelos de aprendizaje automático no representan con precisión a la población real o a la distribución para la que están destinados. Este tipo de sesgo surge cuando los conjuntos de datos se eligen de manera que excluyen sistemáticamente o subrepresentan a ciertos grupos, escenarios o características. Como consecuencia, los modelos de IA aprenden patrones a partir de datos incompletos o sesgados, lo que lleva a predicciones inexactas, injustas o discriminatorias hacia poblaciones subrepresentadas. Comprender este sesgo es fundamental para cualquier persona que desarrolle, implemente o dependa de sistemas de IA, ya que impacta directamente en la equidad, precisión y fiabilidad de la toma de decisiones automatizada en diversas industrias.

El sesgo de selección de fuentes es distinto de otras formas de sesgo porque se origina en la propia etapa de recopilación de datos. En lugar de surgir por elecciones algorítmicas o suposiciones humanas durante el desarrollo del modelo, el sesgo de selección de fuentes está incrustado en la base del conjunto de datos de entrenamiento. Esto lo hace particularmente insidioso, ya que los modelos entrenados con datos fuente sesgados perpetuarán y amplificarán estos sesgos en sus predicciones, sin importar cuán sofisticado sea el algoritmo. El problema se vuelve aún más crítico cuando los sistemas de IA se implementan en dominios de alto impacto como la salud, las finanzas, la justicia penal y la contratación, donde las predicciones sesgadas pueden tener consecuencias graves para individuos y comunidades.

El sesgo de selección de fuentes se desarrolla a través de varios mecanismos distintos durante el proceso de recopilación y curación de datos. La vía más común ocurre mediante el sesgo de cobertura, donde ciertas poblaciones o escenarios se excluyen sistemáticamente del conjunto de datos de entrenamiento. Por ejemplo, si un sistema de reconocimiento facial se entrena principalmente con imágenes de personas de piel clara, tendrá una cobertura deficiente de rostros de piel más oscura, lo que lleva a tasas de error más altas para esas poblaciones. Esto sucede porque los recolectores de datos pueden tener acceso limitado a poblaciones diversas, o pueden priorizar inconscientemente ciertos grupos al recopilar datos.

Otro mecanismo crítico es el sesgo de no respuesta, también llamado sesgo de participación, que ocurre cuando ciertos grupos tienen menos probabilidades de participar en los procesos de recopilación de datos. Considere un conjunto de datos basado en encuestas para predecir preferencias de consumidores: si ciertos grupos demográficos tienen significativamente menos probabilidad de responder encuestas, sus preferencias estarán subrepresentadas en los datos de entrenamiento. Esto crea un conjunto de datos que parece equilibrado pero que en realidad refleja patrones de participación en lugar de las características reales de la población. En la salud, por ejemplo, si los datos de ensayos clínicos provienen predominantemente de poblaciones urbanas con acceso a instalaciones médicas avanzadas, los modelos de IA resultantes pueden no generalizar bien a comunidades rurales o desatendidas.

El sesgo de muestreo representa un tercer mecanismo, donde no se utiliza una adecuada aleatorización durante la recopilación de datos. En lugar de seleccionar puntos de datos al azar, los recolectores pueden elegir las primeras muestras disponibles o utilizar métodos de muestreo por conveniencia. Esto introduce errores sistemáticos porque las muestras seleccionadas no representan a la población general. Por ejemplo, si un modelo de IA para predecir impagos de préstamos se entrena con datos recolectados de una región geográfica específica o de un periodo de tiempo determinado, puede que no prediga con precisión los impagos en otras regiones o en condiciones económicas diferentes.

| Tipo de sesgo | Mecanismo | Ejemplo del mundo real |

|---|---|---|

| Sesgo de cobertura | Exclusión sistemática de poblaciones | Reconocimiento facial entrenado solo con rostros de piel clara |

| Sesgo de no respuesta | Brechas de participación en la recopilación de datos | Modelos de salud entrenados solo con poblaciones urbanas |

| Sesgo de muestreo | Aleatorización inadecuada en la selección | Modelos de predicción de préstamos entrenados en una sola región geográfica |

| Sesgo temporal | Datos de periodos de tiempo específicos | Modelos entrenados con datos pre-pandemia aplicados en la post-pandemia |

| Sesgo de diversidad de fuentes | Fuentes de datos limitadas | Conjuntos de datos de imágenes médicas de un solo sistema hospitalario |

Las consecuencias del sesgo de selección de fuentes en los sistemas de IA son profundas y de gran alcance, afectando tanto a individuos como a organizaciones. En salud, el sesgo de selección de fuentes ha llevado a sistemas de diagnóstico que funcionan significativamente peor para ciertas poblaciones de pacientes. Investigaciones han documentado que los algoritmos de IA para diagnosticar cáncer de piel muestran una precisión sustancialmente menor para pacientes con tonos de piel más oscuros, con estudios que indican apenas la mitad de precisión en comparación con pacientes de piel clara. Esta disparidad se traduce directamente en diagnósticos tardíos, recomendaciones de tratamiento inapropiadas y peores resultados de salud para poblaciones subrepresentadas. Cuando los datos de entrenamiento provienen predominantemente de pacientes de un solo grupo demográfico, los modelos resultantes aprenden patrones específicos de ese grupo y no logran generalizar a otros.

En servicios financieros, el sesgo de selección de fuentes en los algoritmos de calificación crediticia y préstamos ha perpetuado la discriminación histórica. Los modelos entrenados con datos históricos de aprobación de préstamos que reflejan prácticas de préstamos discriminatorias del pasado reproducirán esos mismos sesgos al tomar nuevas decisiones de crédito. Si ciertos grupos fueron históricamente rechazados para créditos debido a discriminación sistémica, y estos datos históricos se utilizan para entrenar modelos de IA, los modelos aprenderán a negar créditos a grupos similares en el futuro. Esto crea un círculo vicioso donde las inequidades históricas quedan incrustadas en la toma de decisiones algorítmica, afectando el acceso de las personas al capital y a oportunidades económicas.

La contratación y reclutamiento representa otro dominio crítico donde el sesgo de selección de fuentes causa daño significativo. Se ha encontrado que las herramientas de IA utilizadas en la selección de currículums exhiben sesgos basados en la raza y el género percibidos, con estudios que muestran que nombres asociados a personas blancas fueron favorecidos el 85% del tiempo en algunos sistemas. Cuando los datos de entrenamiento provienen de registros históricos de contratación que reflejan discriminación pasada o patrones homogéneos, los modelos de IA resultantes replican esos patrones. Esto significa que el sesgo de selección de fuentes en los datos de contratación perpetúa la discriminación laboral a gran escala, limitando las oportunidades para grupos subrepresentados y reduciendo la diversidad en la fuerza laboral.

En la justicia penal, el sesgo de selección de fuentes en los sistemas de policía predictiva ha llevado a la focalización desproporcionada de ciertas comunidades. Cuando los datos de entrenamiento provienen de registros históricos de arrestos que ya están sesgados contra grupos marginados, los modelos amplifican estos sesgos prediciendo mayores tasas de criminalidad en esas comunidades. Esto crea un ciclo donde las predicciones sesgadas llevan a una mayor vigilancia en ciertas áreas, lo que genera más datos de arrestos de esas áreas, reforzando aún más el sesgo en el modelo.

Detectar el sesgo de selección de fuentes requiere un enfoque sistemático que combine análisis cuantitativo, evaluación cualitativa y monitoreo continuo a lo largo del ciclo de vida del modelo. El primer paso es realizar una auditoría de datos integral que examine las fuentes, los métodos de recopilación y la representatividad de sus datos de entrenamiento. Esto implica documentar de dónde provienen los datos, cómo se recopilaron y si el proceso de recopilación pudo haber excluido sistemáticamente a ciertas poblaciones o escenarios. Hágase preguntas críticas: ¿Estuvieron representados todos los grupos demográficos relevantes en el proceso de recopilación de datos? ¿Hubo barreras de participación que pudieron haber desalentado a ciertos grupos? ¿El periodo o el alcance geográfico de la recolección limitó la representación?

El análisis de paridad demográfica ofrece un enfoque cuantitativo para detectar el sesgo de selección de fuentes. Esto implica comparar la distribución de características clave en sus datos de entrenamiento frente a la distribución en la población real a la que servirá su modelo. Si sus datos de entrenamiento subrepresentan significativamente a ciertos grupos demográficos, rangos de edad, regiones geográficas u otras características relevantes, hay evidencia de sesgo de selección de fuentes. Por ejemplo, si en sus datos de entrenamiento solo hay un 5% de representación femenina pero la población objetivo es 50% mujeres, esto indica un serio sesgo de cobertura que probablemente resultará en un bajo desempeño del modelo para mujeres.

El análisis de cortes de desempeño es otra técnica crítica de detección, donde se evalúa el desempeño del modelo por separado para diferentes grupos demográficos y subpoblaciones. Incluso si la precisión general del modelo parece aceptable, el desempeño puede variar enormemente entre grupos. Si su modelo logra un 95% de precisión general pero solo un 70% para un grupo demográfico en particular, esto sugiere que el sesgo de selección de fuentes en los datos de entrenamiento ha resultado en que el modelo aprenda patrones específicos del grupo mayoritario, sin captar los relevantes para el grupo minoritario. Este análisis debe realizarse no solo sobre la precisión general, sino también sobre métricas de equidad como igualdad de oportunidades y el impacto dispar.

Las pruebas adversariales implican crear deliberadamente casos de prueba diseñados para exponer posibles sesgos. Esto puede incluir probar su modelo con datos de poblaciones subrepresentadas, casos límite o escenarios poco representados en los datos de entrenamiento. Al poner a prueba su modelo con entradas diversas, puede identificar dónde el sesgo de selección de fuentes ha creado puntos ciegos. Por ejemplo, si su modelo fue entrenado principalmente con datos urbanos, pruébelo extensamente con datos rurales para ver si su desempeño disminuye. Si sus datos de entrenamiento provienen de un periodo específico, pruebe el modelo con datos de otros periodos para detectar sesgo temporal.

Mitigar el sesgo de selección de fuentes requiere intervención en múltiples etapas del ciclo de vida del desarrollo de IA, comenzando con la recopilación de datos y continuando hasta la evaluación y el despliegue del modelo. El enfoque más efectivo es la mitigación centrada en los datos, que aborda el sesgo en su origen mediante la mejora de la calidad y representatividad de los datos de entrenamiento. Esto comienza con una recopilación diversa de datos, donde se trabaja activamente para incluir poblaciones y escenarios subrepresentados en su conjunto de entrenamiento. En lugar de depender del muestreo por conveniencia o de conjuntos de datos existentes, las organizaciones deberían realizar esfuerzos de recopilación dirigidos para asegurar una representación adecuada de todos los grupos demográficos y casos de uso relevantes.

Las técnicas de remuestreo y reajuste de pesos ofrecen métodos prácticos para abordar los desequilibrios en los conjuntos de datos existentes. El sobremuestreo aleatorio duplica ejemplos de grupos subrepresentados, mientras que el submuestreo aleatorio reduce ejemplos de grupos sobre representados. Enfoques más sofisticados como el muestreo estratificado aseguran una representación proporcional en múltiples dimensiones simultáneamente. El reajuste de pesos asigna mayor importancia a las muestras subrepresentadas durante el entrenamiento del modelo, indicando al algoritmo que preste más atención a los patrones en los grupos minoritarios. Estas técnicas funcionan mejor cuando se combinan con esfuerzos de recopilación de datos más diversos, en lugar de confiar únicamente en el remuestreo de datos limitados.

La generación de datos sintéticos ofrece otra vía para abordar el sesgo de selección de fuentes, especialmente cuando recopilar datos reales de poblaciones subrepresentadas es difícil o costoso. Técnicas como las Redes Generativas Antagónicas (GANs) y los Autoencoders Variacionales (VAEs) pueden crear ejemplos sintéticos realistas para grupos subrepresentados. Enfoques más específicos como SMOTE (Técnica de Sobremuestreo de Minorías Sintéticas) crean ejemplos sintéticos interpolando entre instancias minoritarias existentes. Sin embargo, los datos sintéticos deben usarse con cuidado y validarse a fondo, ya que pueden introducir sesgos propios si no se generan cuidadosamente.

Los algoritmos conscientes de la equidad representan otra estrategia de mitigación que opera en la etapa de entrenamiento del modelo. Estos algoritmos incorporan explícitamente restricciones de equidad en el proceso de aprendizaje, asegurando que el modelo logre un desempeño aceptable en todos los grupos demográficos, y no solo en el grupo mayoritario. El desbalanceo adversarial, por ejemplo, utiliza una red adversarial para asegurar que las predicciones del modelo no puedan usarse para inferir características protegidas como raza o género. La regularización consciente de la equidad añade términos de penalización a la función de pérdida que desalientan el comportamiento discriminatorio. Estos enfoques permiten equilibrar explícitamente la precisión global y la equidad, eligiendo el balance que se alinee con sus prioridades éticas.

El monitoreo y reentrenamiento continuo aseguran que el sesgo de selección de fuentes no surja o empeore con el tiempo. Incluso si sus datos de entrenamiento iniciales son representativos, la distribución real a la que sirve su modelo puede cambiar debido a cambios demográficos, económicos u otros factores. Implementar sistemas de monitoreo de desempeño que rastreen la precisión del modelo por separado para diferentes grupos demográficos le permite detectar cuándo surge el sesgo. Cuando se detecta una degradación en el desempeño, volver a entrenar con datos actualizados que reflejen la distribución actual puede restaurar la equidad. Este proceso reconoce que la mitigación de sesgos no es un esfuerzo único, sino una responsabilidad continua.

Comprender el sesgo de selección de fuentes se vuelve cada vez más importante en el contexto del monitoreo de respuestas de IA y el seguimiento de la presencia de marca. A medida que sistemas de IA como ChatGPT, Perplexity y otros generadores de respuestas se convierten en fuentes primarias de información para los usuarios, las fuentes que estos sistemas citan y la información que presentan están moldeadas por sus datos de entrenamiento. Si los datos de entrenamiento utilizados para construir estos sistemas de IA presentan sesgo de selección de fuentes, las respuestas que generan reflejarán ese sesgo. Por ejemplo, si los datos de entrenamiento de un sistema de IA sobre representan ciertos sitios web, publicaciones o perspectivas y subrepresentan otros, el sistema será más propenso a citar y amplificar información de las fuentes sobre representadas.

Esto tiene implicaciones directas para el monitoreo de marca y la visibilidad del contenido. Si su marca, dominio o URLs están subrepresentadas en los datos de entrenamiento de los principales sistemas de IA, su contenido puede ser sistemáticamente excluido o subrepresentado en las respuestas generadas por IA. Por el contrario, si marcas competidoras o fuentes de desinformación están sobre representadas en los datos de entrenamiento, recibirán visibilidad desproporcionada en las respuestas de IA. Monitorear cómo aparece su marca en las respuestas generadas por IA en distintas plataformas le ayuda a comprender si el sesgo de selección de fuentes en estos sistemas está afectando su visibilidad y reputación. Al rastrear qué fuentes son citadas, con qué frecuencia aparece su contenido y si la información presentada es precisa, puede identificar posibles sesgos en la forma en que los sistemas de IA representan su marca e industria.

El sesgo de selección de fuentes en IA es un problema crítico de equidad que se origina en la etapa de recopilación de datos y se propaga a todas las aplicaciones posteriores de los modelos de aprendizaje automático. Ocurre cuando los datos de entrenamiento excluyen sistemáticamente o subrepresentan a ciertas poblaciones, escenarios o características, lo que da lugar a modelos que hacen predicciones inexactas o injustas para grupos subrepresentados. Las consecuencias son graves y de amplio alcance, afectando los resultados en salud, el acceso financiero, las oportunidades de empleo y las decisiones en la justicia penal. Detectar el sesgo de selección de fuentes requiere auditorías de datos integrales, análisis de paridad demográfica, análisis de cortes de desempeño y pruebas adversariales. Mitigar este sesgo exige un enfoque multifacético que incluya recopilación diversa de datos, remuestreo y reajuste de pesos, generación de datos sintéticos, algoritmos conscientes de la equidad y monitoreo continuo. Las organizaciones deben reconocer que abordar el sesgo de selección de fuentes no es opcional, sino esencial para construir sistemas de IA justos, precisos y confiables para todas las poblaciones y casos de uso.

Asegúrate de que tu marca aparezca de manera precisa en respuestas generadas por IA en ChatGPT, Perplexity y otras plataformas de IA. Rastrea cómo los sistemas de IA citan tu contenido e identifica posibles sesgos en sus respuestas.

Descubre cómo los sistemas de IA seleccionan y clasifican fuentes para las citas. Conoce los algoritmos, señales y factores que determinan qué sitios web plataf...

Aprende sobre el sesgo de recencia en los sistemas de IA, cómo afecta la visibilidad de contenido, los algoritmos de recomendación y las decisiones empresariale...

Aprende estrategias efectivas para identificar, monitorear y corregir información inexacta sobre tu marca en respuestas generadas por IA como ChatGPT, Perplexit...

Consentimiento de Cookies

Usamos cookies para mejorar tu experiencia de navegación y analizar nuestro tráfico. See our privacy policy.