Cómo Realizar una Auditoría de Visibilidad en IA: Metodología Completa

Aprende la metodología completa paso a paso para realizar una auditoría de visibilidad en IA. Descubre cómo medir menciones de marca, citas y visibilidad en Cha...

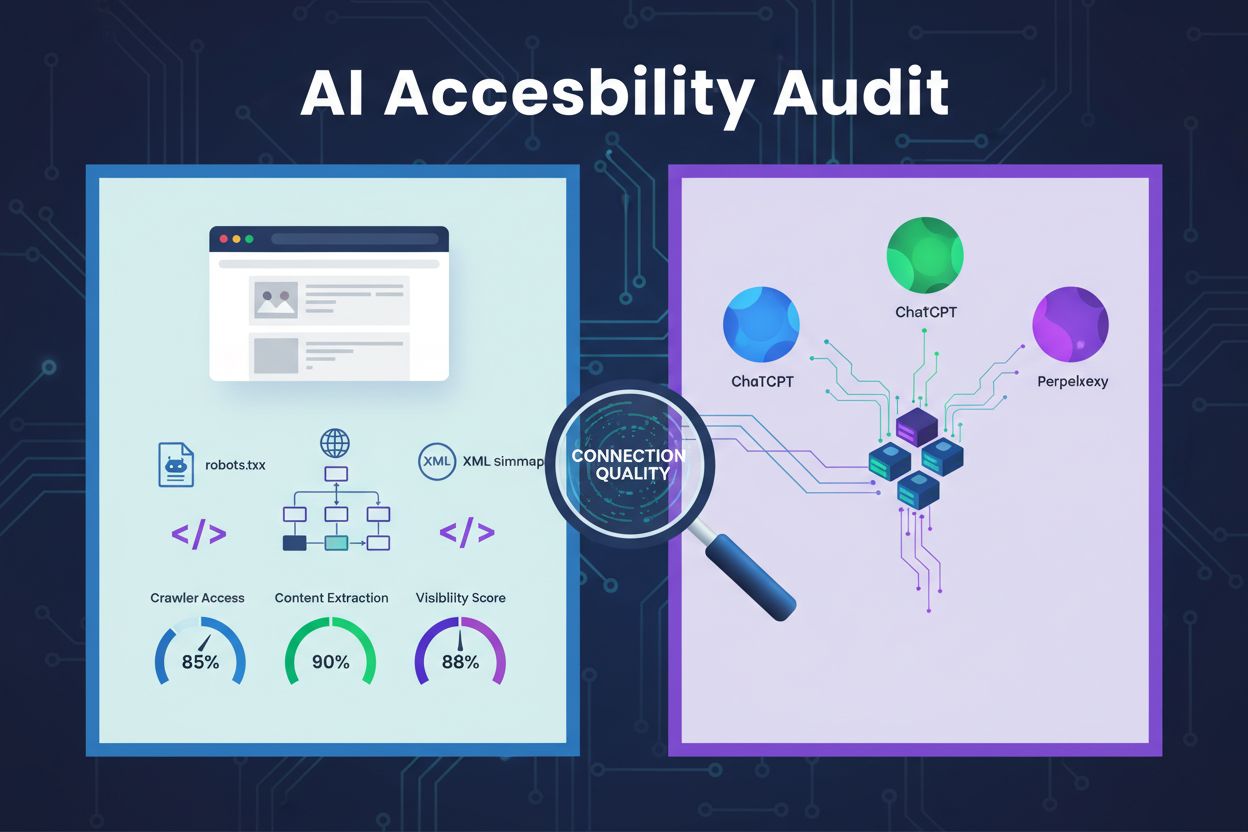

Una revisión técnica de la arquitectura, configuración y estructura de contenido de un sitio web para determinar si los rastreadores de IA pueden acceder, comprender y extraer contenido de manera efectiva. Evalúa la configuración de robots.txt, sitemaps XML, capacidad de rastreo del sitio, renderizado de JavaScript y capacidad de extracción de contenido para garantizar la visibilidad en plataformas de búsqueda impulsadas por IA como ChatGPT, Claude y Perplexity.

Una revisión técnica de la arquitectura, configuración y estructura de contenido de un sitio web para determinar si los rastreadores de IA pueden acceder, comprender y extraer contenido de manera efectiva. Evalúa la configuración de robots.txt, sitemaps XML, capacidad de rastreo del sitio, renderizado de JavaScript y capacidad de extracción de contenido para garantizar la visibilidad en plataformas de búsqueda impulsadas por IA como ChatGPT, Claude y Perplexity.

Una auditoría de accesibilidad para IA es una revisión técnica de la arquitectura, configuración y estructura de contenido de tu sitio web para determinar si los rastreadores de IA pueden acceder, comprender y extraer tu contenido de manera efectiva. A diferencia de las auditorías SEO tradicionales que se enfocan en el posicionamiento por palabras clave y backlinks, las auditorías de accesibilidad para IA examinan los fundamentos técnicos que permiten a sistemas de IA como ChatGPT, Claude y Perplexity descubrir y citar tu contenido. Esta auditoría evalúa componentes críticos como la configuración de robots.txt, sitemaps XML, capacidad de rastreo del sitio, renderizado de JavaScript y capacidad de extracción de contenido para asegurar que tu sitio web sea completamente visible en el ecosistema de búsqueda impulsado por IA.

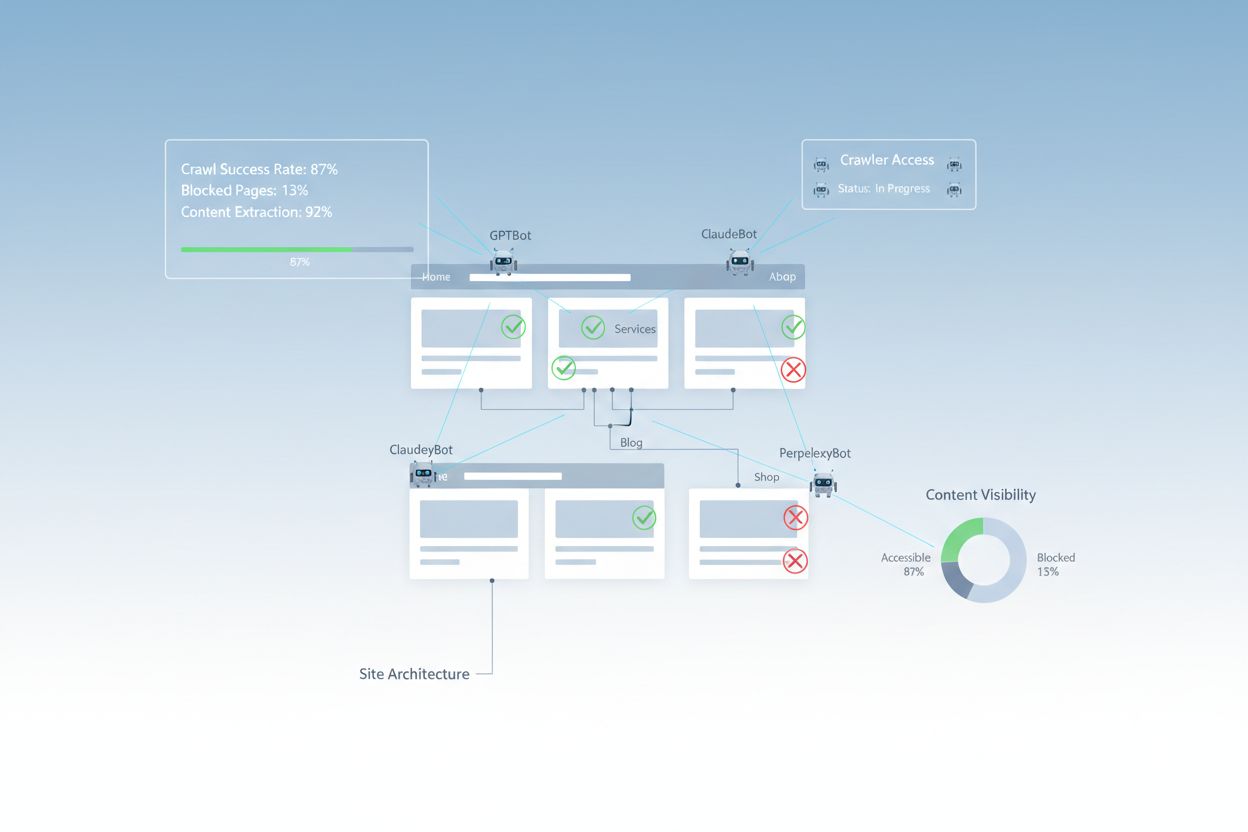

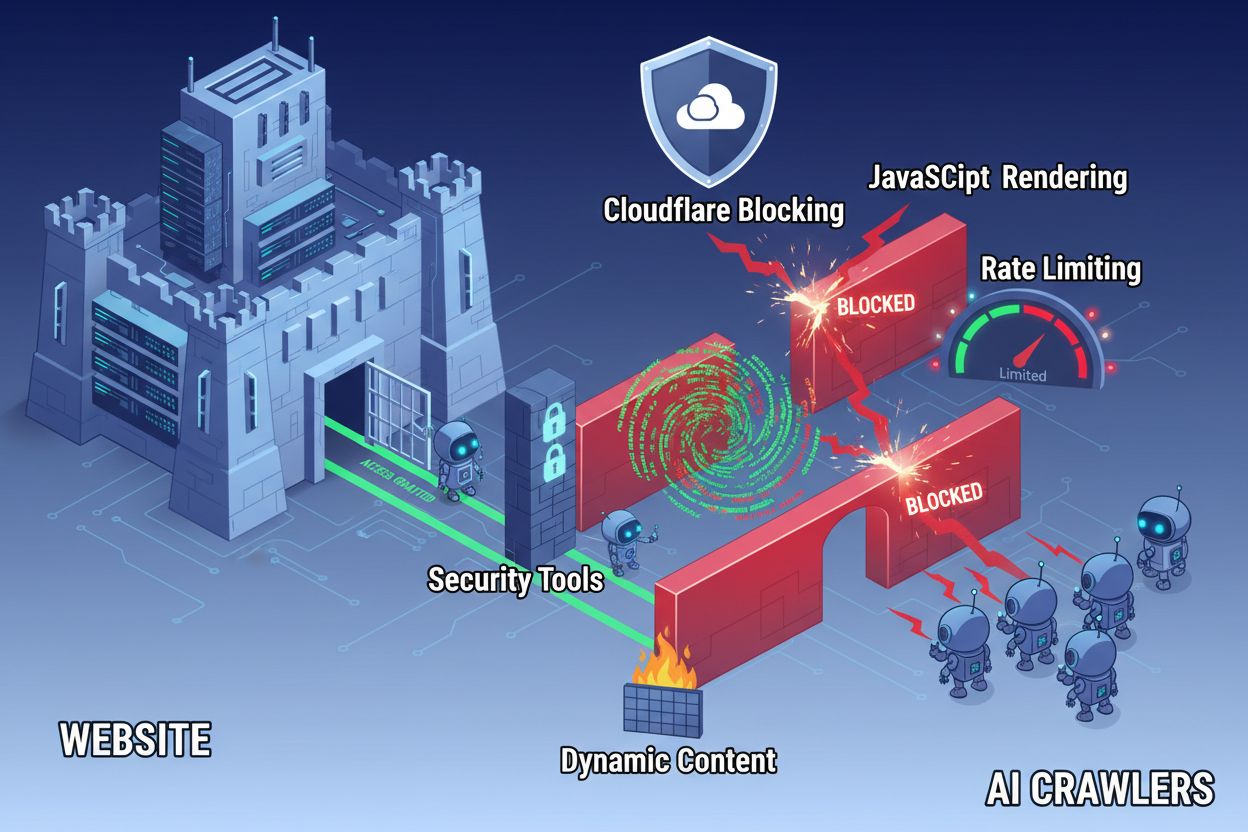

A pesar de los avances en la tecnología web, los rastreadores de IA enfrentan barreras significativas al intentar acceder a sitios web modernos. El desafío principal es que muchos sitios contemporáneos dependen en gran medida del renderizado de JavaScript para mostrar contenido dinámicamente, pero la mayoría de los rastreadores de IA no pueden ejecutar código JavaScript. Esto significa que aproximadamente el 60-90% del contenido de sitios modernos permanece invisible para los sistemas de IA, aunque se muestre perfectamente en los navegadores de los usuarios. Además, herramientas de seguridad como Cloudflare bloquean rastreadores de IA por defecto, tratándolos como amenazas potenciales y no como bots legítimos de indexación. Las investigaciones muestran que el 35% de los sitios empresariales bloquean inadvertidamente rastreadores de IA, impidiendo que contenidos valiosos sean descubiertos y citados por sistemas de IA.

Barreras comunes que impiden el acceso de rastreadores de IA incluyen:

Una auditoría de accesibilidad para IA integral examina múltiples elementos técnicos y estructurales que influyen en cómo los sistemas de IA interactúan con tu sitio web. Cada componente juega un papel distinto en determinar si tu contenido será visible para las plataformas de búsqueda impulsadas por IA. El proceso de auditoría implica probar la capacidad de rastreo, verificar archivos de configuración, evaluar la estructura del contenido y monitorear el comportamiento real de los rastreadores. Al evaluar sistemáticamente estos componentes, puedes identificar barreras específicas e implementar soluciones dirigidas para mejorar tu visibilidad en IA.

| Componente | Propósito | Impacto en la Visibilidad para IA |

|---|---|---|

| Configuración de Robots.txt | Controla qué rastreadores pueden acceder a secciones específicas del sitio | Crítico - Una mala configuración bloquea completamente a los rastreadores de IA |

| Sitemaps XML | Guía a los rastreadores a páginas importantes y estructura de contenido | Alto - Ayuda a los sistemas de IA a priorizar y descubrir contenido |

| Capacidad de Rastreo del Sitio | Asegura que las páginas sean accesibles sin autenticación o navegación compleja | Crítico - Las páginas bloqueadas son invisibles para los sistemas de IA |

| Renderizado de JavaScript | Determina si el contenido dinámico es visible para los rastreadores | Crítico - Se puede perder el 60-90% del contenido sin pre-renderizado |

| Extracción de Contenido | Evalúa cuán fácilmente los sistemas de IA pueden analizar y comprender el contenido | Alto - Una estructura pobre reduce la probabilidad de cita |

| Configuración de Herramientas de Seguridad | Gestiona reglas de firewall y protección que afectan el acceso de los rastreadores | Crítico - Reglas demasiado restrictivas bloquean bots legítimos de IA |

| Implementación de Esquema de Datos Estructurados | Proporciona contexto legible para máquinas sobre el contenido | Medio - Mejora la comprensión de IA y la probabilidad de cita |

| Estructura de Enlazado Interno | Establece relaciones semánticas entre páginas | Medio - Ayuda a la IA a entender autoridad temática y relevancia |

Tu archivo robots.txt es el principal mecanismo para controlar qué rastreadores pueden acceder a tu sitio web. Ubicado en la raíz de tu dominio, este simple archivo de texto contiene directivas que indican a los rastreadores si pueden acceder a secciones específicas de tu sitio. Para la accesibilidad en IA, una configuración adecuada de robots.txt es esencial, ya que reglas mal configuradas pueden bloquear por completo a los principales rastreadores de IA como GPTBot (OpenAI), ClaudeBot (Anthropic) y PerplexityBot (Perplexity). La clave es permitir explícitamente a estos rastreadores mientras se mantiene la seguridad bloqueando bots maliciosos y protegiendo áreas sensibles.

Ejemplo de configuración de robots.txt para rastreadores de IA:

# Permitir todos los rastreadores de IA

User-agent: GPTBot

User-agent: ChatGPT-User

User-agent: ClaudeBot

User-agent: Claude-Web

User-agent: PerplexityBot

User-agent: Google-Extended

Allow: /

# Bloquear áreas sensibles

Disallow: /admin/

Disallow: /private/

Disallow: /api/

# Sitemaps

Sitemap: https://yoursite.com/sitemap.xml

Sitemap: https://yoursite.com/ai-sitemap.xml

Esta configuración permite explícitamente a los principales rastreadores de IA acceder a tu contenido público mientras protege las secciones administrativas y privadas. Las directivas de Sitemap ayudan a los rastreadores a descubrir tus páginas más importantes de manera eficiente.

Un sitemap XML actúa como un mapa de ruta para los rastreadores, listando las URLs que deseas que se indexen y proporcionando metadatos sobre cada página. Para los sistemas de IA, los sitemaps son especialmente valiosos ya que ayudan a los rastreadores a entender la estructura de tu sitio, priorizar contenido importante y descubrir páginas que podrían pasar desapercibidas mediante el rastreo estándar. A diferencia de los motores de búsqueda tradicionales que pueden inferir la estructura del sitio mediante enlaces, los rastreadores de IA se benefician significativamente de una guía explícita sobre qué páginas son más relevantes. Un sitemap bien estructurado con los metadatos adecuados aumenta la probabilidad de que tu contenido sea descubierto, comprendido y citado por sistemas de IA.

Ejemplo de estructura de sitemap XML para optimización en IA:

<?xml version="1.0" encoding="UTF-8"?>

<urlset xmlns="http://www.sitemaps.org/schemas/sitemap/0.9">

<!-- Contenido de alta prioridad para rastreadores de IA -->

<url>

<loc>https://yoursite.com/about</loc>

<lastmod>2025-01-03</lastmod>

<priority>1.0</priority>

</url>

<url>

<loc>https://yoursite.com/products</loc>

<lastmod>2025-01-03</lastmod>

<priority>0.9</priority>

</url>

<url>

<loc>https://yoursite.com/blog/ai-guide</loc>

<lastmod>2025-01-02</lastmod>

<priority>0.8</priority>

</url>

<url>

<loc>https://yoursite.com/faq</loc>

<lastmod>2025-01-01</lastmod>

<priority>0.7</priority>

</url>

</urlset>

El atributo priority indica a los rastreadores de IA qué páginas son más importantes, mientras que lastmod señala la frescura del contenido. Esto ayuda a los sistemas de IA a asignar recursos de rastreo eficazmente y a comprender la jerarquía de tu contenido.

Más allá de los archivos de configuración, existen varias barreras técnicas que pueden impedir que los rastreadores de IA accedan de manera efectiva a tu contenido. El renderizado de JavaScript sigue siendo el desafío más significativo, ya que los frameworks modernos como React, Vue y Angular renderizan el contenido dinámicamente en el navegador, dejando a los rastreadores de IA con HTML vacío. Cloudflare y herramientas de seguridad similares suelen bloquear rastreadores de IA por defecto, tratando sus altos volúmenes de solicitud como posibles ataques. La limitación de velocidad puede impedir la indexación completa, mientras que la arquitectura de sitio compleja y la carga dinámica de contenido complican aún más el acceso de los rastreadores. Por fortuna, existen múltiples soluciones para superar estas barreras.

Soluciones para mejorar el acceso de rastreadores de IA:

Los sistemas de IA no solo necesitan acceder a tu contenido—también deben comprenderlo. La extracción de contenido se refiere a cuán eficazmente los rastreadores de IA pueden analizar, comprender y extraer información significativa de tus páginas. Este proceso depende en gran medida de la estructura HTML semántica, que utiliza jerarquías de encabezados adecuadas, texto descriptivo y organización lógica para transmitir significado. Cuando tu contenido está bien estructurado con encabezados claros (H1, H2, H3), párrafos descriptivos y un flujo lógico, los sistemas de IA pueden identificar con mayor facilidad la información clave y entender el contexto. Además, el esquema de datos estructurados proporciona metadatos legibles para máquinas que indican explícitamente a los sistemas de IA de qué trata tu contenido, mejorando considerablemente la comprensión y la probabilidad de cita.

La estructura semántica adecuada también incluye el uso de elementos HTML semánticos como <article>, <section>, <nav> y <aside> en lugar de etiquetas genéricas <div>. Esto ayuda a los sistemas de IA a comprender el propósito e importancia de diferentes secciones del contenido. Cuando se combina con datos estructurados como esquema FAQ, esquema de Producto u Organización, tu contenido se vuelve significativamente más accesible para sistemas de IA, aumentando las probabilidades de ser incluido en respuestas generadas por IA.

Después de implementar mejoras, es necesario verificar que los rastreadores de IA realmente puedan acceder a tu contenido y monitorear el desempeño continuo. Los registros del servidor brindan evidencia directa de la actividad de los rastreadores, mostrando qué bots visitaron tu sitio, qué páginas accedieron y si encontraron errores. Google Search Console ofrece información sobre cómo los rastreadores de Google interactúan con tu sitio, mientras que herramientas especializadas de monitoreo de visibilidad en IA rastrean cómo aparece tu contenido en diferentes plataformas de IA. AmICited.com monitorea específicamente cómo los sistemas de IA mencionan tu marca en ChatGPT, Perplexity y Google AI Overviews, proporcionando visibilidad sobre cuáles de tus páginas están siendo citadas y con qué frecuencia.

Herramientas y métodos para monitorear el acceso de rastreadores de IA:

Optimizar tu sitio web para el acceso de rastreadores de IA requiere un enfoque estratégico y continuo. En lugar de tratar la accesibilidad en IA como un proyecto puntual, las organizaciones exitosas implementan procesos de monitoreo y mejora constantes. La estrategia más efectiva combina una configuración técnica adecuada con la optimización de contenido, asegurando que tanto tu infraestructura como tu contenido estén preparados para la IA.

Lo que se debe hacer para la accesibilidad en IA:

Lo que no se debe hacer para la accesibilidad en IA:

La estrategia de accesibilidad para IA más exitosa trata a los rastreadores como aliados en la distribución de contenido y no como amenazas a ser bloqueadas. Al asegurar que tu sitio web sea técnicamente sólido, esté correctamente configurado y sea semánticamente claro, maximizas la probabilidad de que los sistemas de IA descubran, comprendan y citen tu contenido en sus respuestas a los usuarios.

Las auditorías de accesibilidad para IA se enfocan en la estructura semántica, el contenido legible para máquinas y la citabilidad para sistemas de IA, mientras que las auditorías SEO tradicionales enfatizan palabras clave, backlinks y posiciones en los resultados de búsqueda. Las auditorías de IA examinan si los rastreadores pueden acceder y entender tu contenido, mientras que las SEO se centran en factores de posicionamiento para los resultados de búsqueda de Google.

Revisa los registros de tu servidor en busca de agentes de usuario de rastreadores de IA como GPTBot, ClaudeBot y PerplexityBot. Utiliza Google Search Console para monitorear la actividad de rastreo, prueba tu archivo robots.txt con herramientas de validación y usa plataformas especializadas como AmICited para rastrear cómo los sistemas de IA mencionan tu contenido en diferentes plataformas.

Las barreras más comunes incluyen limitaciones de renderizado de JavaScript (los rastreadores de IA no pueden ejecutar JavaScript), bloqueo por Cloudflare y herramientas de seguridad (el 35% de los sitios empresariales bloquean rastreadores de IA), limitación de velocidad que impide la indexación completa, arquitectura de sitio compleja y carga dinámica de contenido. Cada barrera requiere soluciones diferentes.

La mayoría de los negocios se benefician al permitir rastreadores de IA, ya que aumentan la visibilidad de la marca en resultados de búsqueda y interfaces conversacionales impulsadas por IA. Sin embargo, la decisión depende de tu estrategia de contenido, el posicionamiento competitivo y los objetivos de negocio. Puedes usar robots.txt para permitir selectivamente ciertos rastreadores y bloquear otros según tus necesidades específicas.

Realiza una auditoría completa cada trimestre o cada vez que realices cambios significativos en la arquitectura de tu sitio, estrategia de contenido o configuración de seguridad. Monitorea la actividad de los rastreadores de forma continua usando registros del servidor y herramientas especializadas. Actualiza tu robots.txt y sitemaps cada vez que lances nuevas secciones de contenido o modifiques la estructura de URLs.

Robots.txt es tu principal mecanismo para controlar el acceso de rastreadores de IA. Una configuración adecuada permite explícitamente a los principales rastreadores de IA (GPTBot, ClaudeBot, PerplexityBot) mientras protege áreas sensibles. Un robots.txt mal configurado puede bloquear completamente a los rastreadores de IA, haciendo que tu contenido sea invisible para los sistemas de IA sin importar su calidad.

Si bien la optimización técnica es importante, también puedes mejorar la visibilidad en IA mediante la optimización del contenido—utilizando estructura HTML semántica, implementando esquema de datos estructurados, mejorando el enlazado interno y asegurando la integridad del contenido. Sin embargo, barreras técnicas como el renderizado de JavaScript y el bloqueo por herramientas de seguridad suelen requerir soluciones técnicas para una accesibilidad total para IA.

Utiliza el análisis de registros de servidor para rastrear la actividad de los rastreadores, Google Search Console para estadísticas de rastreo, validadores de robots.txt para verificar la configuración, validadores de esquema de datos estructurados para datos estructurados y plataformas especializadas como AmICited para monitorear citas en IA. Muchas herramientas SEO como Screaming Frog también ofrecen capacidades de simulación de rastreadores para probar la accesibilidad para IA.

Rastrea cómo ChatGPT, Perplexity, Google AI Overviews y otros sistemas de IA mencionan tu marca con AmICited. Obtén información en tiempo real sobre tu visibilidad en búsquedas de IA y optimiza tu estrategia de contenido.

Aprende la metodología completa paso a paso para realizar una auditoría de visibilidad en IA. Descubre cómo medir menciones de marca, citas y visibilidad en Cha...

Descubre qué son las Auditorías de Competidores en IA, por qué son importantes para el posicionamiento competitivo y cómo analizar la visibilidad de tus competi...

Descubre qué es una auditoría de contenido con IA, cómo se diferencia de las auditorías de contenido tradicionales y por qué monitorizar la presencia de tu marc...

Consentimiento de Cookies

Usamos cookies para mejorar tu experiencia de navegación y analizar nuestro tráfico. See our privacy policy.