¿Cómo envío contenido a los motores de IA?

Aprende cómo enviar y optimizar tu contenido para motores de búsqueda de IA como ChatGPT, Perplexity y Gemini. Descubre estrategias de indexación, requisitos té...

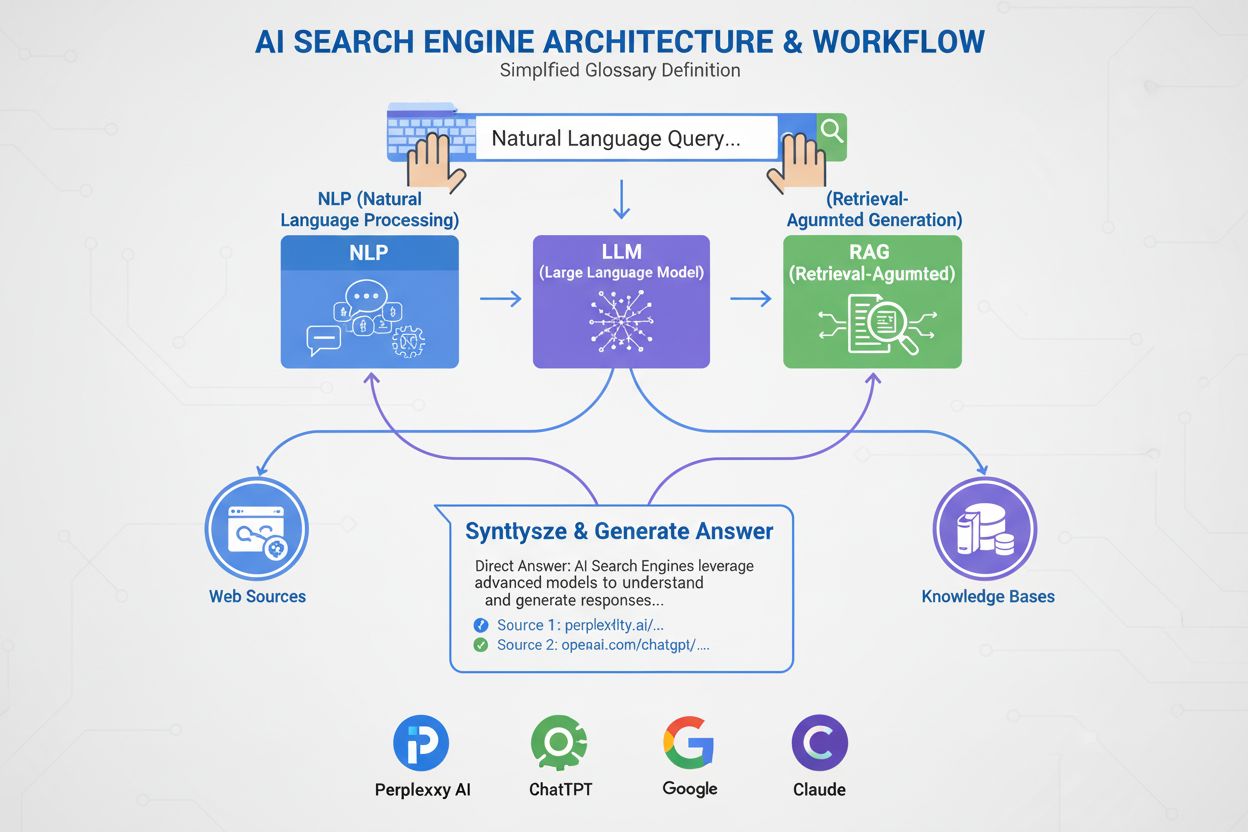

Un motor de búsqueda de IA es una plataforma que utiliza inteligencia artificial, procesamiento de lenguaje natural y grandes modelos de lenguaje para interpretar las consultas de los usuarios y generar respuestas directas y conversacionales sintetizadas a partir de fuentes web, en lugar de mostrar listas tradicionales de enlaces. Estas plataformas aprovechan la generación aumentada por recuperación (RAG) para proporcionar información actual y citada con acceso web en tiempo real.

Un motor de búsqueda de IA es una plataforma que utiliza inteligencia artificial, procesamiento de lenguaje natural y grandes modelos de lenguaje para interpretar las consultas de los usuarios y generar respuestas directas y conversacionales sintetizadas a partir de fuentes web, en lugar de mostrar listas tradicionales de enlaces. Estas plataformas aprovechan la generación aumentada por recuperación (RAG) para proporcionar información actual y citada con acceso web en tiempo real.

Un motor de búsqueda de IA es una plataforma que utiliza inteligencia artificial, procesamiento de lenguaje natural (NLP) y grandes modelos de lenguaje (LLM) para interpretar las consultas de los usuarios y generar respuestas directas y conversacionales sintetizadas a partir de fuentes web. A diferencia de los motores de búsqueda tradicionales que muestran listas de enlaces, los motores de búsqueda de IA ofrecen resúmenes concisos en lenguaje sencillo que abordan directamente la intención del usuario. Estas plataformas aprovechan la generación aumentada por recuperación (RAG) para combinar la recuperación web en tiempo real con la síntesis de IA generativa, lo que les permite ofrecer información actual y citada. Los motores de búsqueda de IA representan un cambio fundamental en la forma en que las personas descubren información en línea, pasando de listas de enlaces basadas en palabras clave a la comprensión semántica y respuestas directas. La tecnología que sustenta estos sistemas integra múltiples disciplinas de IA, incluyendo búsqueda semántica, reconocimiento de entidades e IA conversacional, para crear una experiencia de búsqueda más intuitiva y eficiente.

La aparición de los motores de búsqueda de IA marca una evolución significativa en la tecnología de recuperación de información. Durante décadas, los motores de búsqueda operaron bajo un paradigma de coincidencia de palabras clave, donde la relevancia se determinaba por la presencia y frecuencia de los términos de búsqueda en los documentos indexados. Sin embargo, el auge de los grandes modelos de lenguaje y los avances en la comprensión del lenguaje natural han cambiado fundamentalmente lo que es posible. El mercado global de motores de búsqueda de IA alcanzó los USD 15,23 mil millones en 2024 y se espera que registre una tasa de crecimiento anual compuesta (CAGR) de 16,8% hasta 2032, según investigaciones de mercado. Este crecimiento explosivo refleja tanto la adopción empresarial como la demanda de los consumidores por experiencias de búsqueda más inteligentes y conversacionales.

La IA generativa ha transformado la forma en que las personas descubren información en línea, llevando la búsqueda más allá de la conocida lista de enlaces azules hacia respuestas más directas y conversacionales. Líderes de la industria como Google y Microsoft Bing han integrado rápidamente la IA en sus plataformas para mantenerse al ritmo de estrellas emergentes como Perplexity y You.com. Según investigaciones de McKinsey, aproximadamente el 50% de las búsquedas en Google ya cuentan con resúmenes de IA, cifra que se espera supere el 75% para 2028. Este cambio es más que una transformación de interfaz de usuario: está redefiniendo la estrategia de contenidos y la optimización de motores de búsqueda en una nueva era llamada “optimización para motores generativos” (GEO).

La transición refleja una adopción organizacional más amplia de tecnologías de IA. El 78% de las organizaciones reportaron usar IA en 2024, frente al 55% el año anterior, según el informe AI Index de Stanford. Para profesionales de búsqueda y marketing, esto significa que la visibilidad ahora depende de entender cómo los sistemas de IA analizan, condensan y reiteran el contenido en resúmenes de lenguaje sencillo. El reto es que las respuestas generadas por IA a menudo desvían el tráfico de los sitios web originales por completo, lo que plantea tanto oportunidades como desafíos para creadores de contenido y marcas que buscan visibilidad en este nuevo escenario.

Los motores de búsqueda de IA funcionan mediante una sofisticada canalización de múltiples etapas que combina recuperación, clasificación y síntesis. El proceso comienza con la comprensión de la consulta, donde el sistema analiza la entrada del usuario utilizando procesamiento de lenguaje natural para extraer significado, intención y contexto. En lugar de tratar la consulta como una simple cadena de palabras clave, el sistema crea múltiples representaciones: una forma léxica para recuperación de coincidencia exacta, una incrustación densa para búsqueda semántica y una forma de entidad para coincidencia en el grafo de conocimiento.

Una vez comprendida la consulta, la mayoría de los motores de búsqueda de IA emplean la generación aumentada por recuperación (RAG), un patrón arquitectónico central que aborda las debilidades fundamentales de los grandes modelos de lenguaje. RAG realiza un paso de recuperación en vivo, buscando en índices web o API para obtener documentos y pasajes relevantes. Estos candidatos se vuelven a clasificar utilizando modelos más sofisticados que evalúan la consulta y el candidato conjuntamente para producir puntuaciones de relevancia refinadas. Los resultados mejor clasificados se introducen en un gran modelo de lenguaje como contexto fundamentador, que sintetiza una respuesta conversacional manteniendo la fidelidad a las fuentes recuperadas.

Las canalizaciones de recuperación híbrida son estándar en las principales plataformas. Combinan búsqueda léxica (basada en palabras clave, usando algoritmos como BM25) con búsqueda semántica (basada en incrustaciones, usando similitud vectorial). La búsqueda léxica sobresale en precisión para coincidencias exactas, términos raros y entidades nombradas, mientras que la semántica destaca en recordar contenido conceptualmente relacionado. Al fusionar ambos enfoques y aplicar reclasificación cruzada, los motores de búsqueda de IA logran mayor precisión que cualquiera de los métodos por separado. La etapa final de síntesis utiliza un gran modelo de lenguaje para componer una respuesta coherente y humana, integrando información de múltiples fuentes mientras mantiene la precisión y proporciona citas.

| Aspecto | Motores de búsqueda tradicionales | Motores de búsqueda de IA |

|---|---|---|

| Formato de resultados | Listas de enlaces con fragmentos | Resúmenes conversacionales con respuestas directas |

| Procesamiento de consultas | Coincidencia y clasificación por palabras clave | Comprensión semántica y análisis de intención |

| Mecanismo de aprendizaje | Trabaja desde cero con cada consulta | Aprende continuamente de interacciones y retroalimentación |

| Recuperación de información | Coincidencia léxica/basada en palabras clave | Híbrido (léxico + semántico + basado en entidades) |

| Formatos de entrada | Solo texto | Texto, imágenes, voz y video (multimodal) |

| Actualizaciones en tiempo real | Basado en índice, rastreo periódico | Acceso web en tiempo real vía RAG |

| Comportamiento de citación | Sin citas; el usuario busca las fuentes | Citas integradas y atribución de fuentes |

| Interacción del usuario | Consulta única, resultados estáticos | Conversaciones con seguimiento de varias interacciones |

| Gestión del sesgo | Curadores organizan la información | La síntesis IA puede introducir sesgo de desarrollo |

| Riesgo de alucinación | Bajo (los enlaces son hechos) | Mayor (los LLM pueden generar información falsa) |

Diferentes motores de búsqueda de IA implementan enfoques arquitectónicos distintos, cada uno con implicaciones de optimización únicas. AI Overviews y AI Mode de Google emplean una estrategia de expansión de consultas, donde una sola consulta del usuario se divide en múltiples subconsultas que apuntan a diferentes dimensiones de intención. Estas subconsultas se ejecutan en paralelo sobre diversas fuentes de datos—el índice web, Knowledge Graph, transcripciones de YouTube, feeds de Google Shopping e índices especializados. Los resultados se agregan, desduplican y clasifican antes de ser sintetizados en un resumen. Para los profesionales de GEO, esto significa que el contenido debe abordar múltiples facetas de una consulta de manera extraíble para sobrevivir al proceso de expansión.

Bing Copilot representa un enfoque más tradicional y nativo de búsqueda, aprovechando la infraestructura madura de ranking de Bing y superponiendo síntesis GPT. La plataforma utiliza recuperación de doble canal, combinando búsqueda léxica BM25 con búsqueda semántica de vectores densos. Los resultados pasan por un reclasificador cruzado contextual centrado en la relevancia a nivel de pasaje más que de página completa. Esta arquitectura implica que las señales SEO clásicas—rastreabilidad, etiquetas canónicas, HTML limpio, velocidad de página—siguen siendo muy importantes porque determinan qué candidatos llegan al conjunto de fundamentación. Bing Copilot también enfatiza la extraibilidad: los pasajes con alcance claro, listas, tablas y definiciones son más propensos a ser citados.

Perplexity AI opera con transparencia intencional, mostrando las fuentes de forma destacada antes que la respuesta generada. La plataforma realiza búsquedas en tiempo real, extrayendo tanto de los índices de Google como de Bing, y luego evalúa a los candidatos según una combinación de relevancia léxica y semántica, autoridad temática y extraibilidad de respuestas. Investigaciones que analizaron 59 factores que influyen en el ranking de Perplexity revelan que la plataforma prioriza el formato de respuesta directa—las páginas que repiten explícitamente la consulta en un encabezado, seguidas inmediatamente de una respuesta concisa y densa en información, están sobrerrepresentadas en los conjuntos de citas. La prominencia y vinculación de entidades también juegan un papel clave; Perplexity prefiere pasajes donde las entidades clave se nombran claramente y se vinculan contextualmente a conceptos relacionados.

ChatGPT Search adopta un enfoque oportunista, generando consultas de búsqueda dinámicamente y llamando a la API de Bing para recuperar URLs específicas. A diferencia de plataformas con índices persistentes, ChatGPT obtiene el contenido en tiempo real, por lo que la inclusión depende totalmente de la recuperabilidad en ese momento. Si un sitio está bloqueado por robots.txt, es lento en cargar, está detrás de renderizado del lado del cliente o es opaco semánticamente, no será usado en la síntesis. Esta arquitectura prioriza la accesibilidad y claridad: las páginas deben ser técnicamente rastreables, ligeras y semánticamente transparentes para que la obtención en tiempo real produzca texto limpio y analizable.

El procesamiento de lenguaje natural (NLP) es la tecnología fundamental que permite a los motores de búsqueda de IA ir más allá de la coincidencia de palabras clave. NLP permite a los sistemas analizar la estructura, semántica e intención detrás de las consultas de búsqueda, comprendiendo el contexto y reconociendo sinónimos y conceptos relacionados. Cuando un usuario pregunta “mejores lugares para comer cerca de mí con terraza”, un sistema con NLP entiende que la consulta busca restaurantes con patios, a pesar de que esas palabras no estén presentes. Esta comprensión semántica permite a los motores de búsqueda de IA ofrecer resultados útiles incluso cuando la intención no es evidente o está formulada de manera conversacional.

Los grandes modelos de lenguaje (LLM) impulsan la etapa de síntesis de los motores de búsqueda de IA. Entrenados con grandes volúmenes de datos textuales, los LLM predicen la siguiente palabra más lógica según el contexto, permitiéndoles producir prosa coherente y gramaticalmente correcta que se asemeja mucho al texto humano. Sin embargo, los LLM también introducen riesgos. Pueden alucinar—presentando falsedades como hechos—porque generan texto a partir de conocimiento probabilístico y no citando fuentes en vivo. Por eso la generación aumentada por recuperación (RAG) es fundamental: al fundamentar la síntesis de los LLM en fuentes recién recuperadas y autorizadas, los motores de búsqueda de IA mitigan el riesgo de alucinación y mejoran la precisión factual. Algunas plataformas han incorporado citas artículo por artículo para compensar aún más la alucinación, aunque los artículos citados no siempre son precisos y a veces ni siquiera existen.

Los motores de búsqueda de IA se diferencian de los motores de búsqueda tradicionales en varios aspectos fundamentales. Primero, proporcionan resúmenes en lugar de enlaces. Los motores de búsqueda tradicionales muestran resultados como listas de enlaces con breves fragmentos, mientras que los motores de búsqueda de IA generan resúmenes concisos que responden directamente a las consultas, evitando al usuario el tener que desplazarse y hacer clic en varios sitios. Segundo, la búsqueda de IA aprende con el tiempo, mientras que la tradicional se reinicia con cada consulta. Los motores de búsqueda de IA están diseñados para aprender y adaptarse continuamente a las interacciones y nuevos datos, mejorando su rendimiento con el tiempo. Los motores tradicionales trabajan desde cero en cada nueva consulta, sin tener en cuenta consultas previas o interacciones del usuario.

Tercero, la búsqueda de IA se centra en la semántica, mientras que la tradicional en palabras clave. Los motores de búsqueda tradicionales dependen principalmente de la coincidencia de palabras clave para interpretar las consultas, mientras que los motores de búsqueda de IA se enfocan en la semántica—el significado más amplio de las palabras en contexto. Esto permite a los motores de búsqueda de IA comprender mejor la intención del usuario y ofrecer resultados que se ajustan más a lo que buscan. Cuarto, la búsqueda de IA acepta múltiples formatos de entrada, mientras que la tradicional sólo acepta texto. Algunos motores de búsqueda de IA tienen capacidades multimodales, lo que significa que pueden procesar y entender información más allá del texto, como imágenes, videos y audio. Esto proporciona una experiencia de búsqueda más intuitiva y flexible que la simple introducción de palabras clave.

El auge de los motores de búsqueda de IA está transformando la forma en que las marcas abordan la visibilidad y la estrategia de contenidos. En lugar de competir únicamente por posiciones en palabras clave, editores y empresas deben ahora tener en cuenta cómo los sistemas de IA analizan, condensan y reiteran su contenido en resúmenes de lenguaje sencillo. Este cambio ha dado paso a una nueva era de “optimización para motores generativos” (GEO), donde el objetivo no es sólo posicionar, sino ser recuperado, sintetizado y citado por sistemas de IA.

Las investigaciones indican que incluso el rendimiento GEO de los líderes del sector puede estar entre un 20 y un 50 por ciento por detrás del SEO, según análisis de McKinsey. Esta brecha refleja la naturaleza incipiente de las estrategias GEO y la complejidad de optimizar para múltiples plataformas de IA simultáneamente. Para las marcas, las implicaciones son significativas: la visibilidad en la búsqueda de IA depende de que el contenido sea recuperable (aparezca en los resultados de búsqueda), extraíble (estructurado de manera que los sistemas de IA puedan analizar y citar fácilmente) y confiable (demuestre experiencia, autoridad y confianza). Herramientas de monitoreo como AmICited ahora rastrean menciones de marca en plataformas de IA—incluyendo Perplexity, ChatGPT, Google AI Overviews y Claude—para medir esta nueva forma de visibilidad e identificar oportunidades de optimización.

El panorama de la búsqueda de IA está evolucionando rápidamente, con importantes implicaciones para la forma en que se descubre, distribuye y monetiza la información. Se proyecta que el mercado global de motores de búsqueda de IA crecerá a una tasa CAGR del 16,8% hasta 2032, impulsado por una mayor adopción empresarial y la demanda de los consumidores por experiencias de búsqueda conversacionales e inteligentes. A medida que los motores de búsqueda de IA maduren, podemos esperar que surjan varias tendencias clave.

Primero, la consolidación y especialización probablemente se acelerarán. Mientras que las plataformas generalistas como Google, Bing y Perplexity seguirán dominando, proliferarán motores de búsqueda de IA especializados en verticales específicos—legal, médico, técnico, comercio electrónico. Estos motores especializados ofrecerán mayor experiencia de dominio y síntesis más precisa para consultas de nicho. Segundo, los mecanismos de citación y atribución serán más sofisticados y estandarizados. A medida que aumente la presión regulatoria y los editores exijan mayor atribución, los motores de búsqueda de IA probablemente implementarán sistemas de citación más granulares que faciliten a los usuarios rastrear las afirmaciones a las fuentes y a los editores medir la visibilidad.

Tercero, la definición y medición de “visibilidad” cambiarán fundamentalmente. En la era SEO tradicional, visibilidad significaba posición en ranking y tasa de clics. En la era GEO, visibilidad significa ser recuperado, sintetizado y citado—métricas que requieren nuevos marcos y herramientas de medición. AmICited y plataformas similares están liderando este espacio de medición, rastreando menciones de marca en múltiples plataformas de IA y proporcionando información sobre la frecuencia y el contexto en el que las marcas aparecen en respuestas generadas por IA.

Cuarto, la tensión entre la búsqueda de IA y la búsqueda tradicional se intensificará. A medida que los motores de búsqueda de IA capturen más atención y tráfico de usuarios, los motores de búsqueda tradicionales estarán bajo presión para evolucionar o arriesgarse a la obsolescencia. La integración de IA en el producto central de búsqueda de Google representa una respuesta estratégica a esta amenaza, pero el ganador a largo plazo sigue siendo incierto. Los editores y marcas deben optimizar tanto para la búsqueda tradicional como para la de IA simultáneamente, creando una estrategia de contenidos más compleja y que requiere más recursos.

Finalmente, la confianza y la precisión serán primordiales. A medida que los motores de búsqueda de IA se conviertan en fuentes primarias de información, aumentará la importancia de la precisión y mitigación del sesgo. Probablemente emerjan marcos regulatorios sobre transparencia y responsabilidad de la IA, requiriendo que los motores de búsqueda de IA revelen sus datos de entrenamiento, factores de ranking y metodologías de citación. Para marcas y editores, esto significa que las señales E-E-A-T—experiencia, conocimientos, autoridad y confianza—serán aún más críticas para la visibilidad tanto en la búsqueda tradicional como en la de IA.

+++ showCTA = true ctaHeading = “Monitorea la visibilidad de tu marca en los motores de búsqueda de IA” ctaDescription = “Comprender los motores de búsqueda de IA es solo el primer paso. Rastrea dónde y cómo aparece tu marca en ChatGPT, Perplexity, Google AI Overviews y Claude con la plataforma de monitoreo de búsqueda de IA de AmICited. Mide tu rendimiento GEO, identifica oportunidades de citación y optimiza tu contenido para la próxima generación de búsqueda.” ctaPrimaryText = “Contáctanos” ctaPrimaryURL = “/contact/” ctaSecondaryText = “Pruébalo ahora” ctaSecondaryURL = “https://app.amicited.com ” +++

Los motores de búsqueda tradicionales muestran resultados como listas de enlaces con fragmentos, mientras que los motores de búsqueda de IA generan resúmenes conversacionales que responden directamente a las consultas. Los motores de búsqueda de IA utilizan procesamiento de lenguaje natural y grandes modelos de lenguaje para comprender la intención del usuario de manera semántica en lugar de depender únicamente de la coincidencia de palabras clave. Aprenden continuamente de las interacciones de los usuarios y pueden procesar múltiples formatos de entrada, incluidos texto, imágenes y voz. Además, los motores de búsqueda de IA suelen proporcionar acceso web en tiempo real mediante generación aumentada por recuperación (RAG), lo que les permite ofrecer información actual con citas de fuentes.

La generación aumentada por recuperación (RAG) es una técnica que permite a los grandes modelos de lenguaje recuperar e incorporar información actualizada de fuentes externas antes de generar respuestas. RAG aborda las limitaciones fundamentales de los LLM—alucinaciones y límites de conocimiento—al fundamentar las respuestas en datos recuperados en tiempo real. En los motores de búsqueda de IA, RAG funciona realizando primero una búsqueda o recuperación en vivo, extrayendo documentos o fragmentos relevantes, y luego sintetizando una respuesta basada en esos elementos recuperados. Este enfoque garantiza que las respuestas sean actuales y rastreables a fuentes específicas, lo que permite las citas y mejora la exactitud factual.

Los principales motores de búsqueda de IA incluyen Perplexity (conocido por sus citas transparentes), ChatGPT Search (impulsado por GPT-4o con acceso web en tiempo real), Google Gemini y AI Overviews (integrados en la infraestructura de búsqueda de Google), Bing Copilot (basado en el índice de búsqueda de Microsoft) y Claude (modelo de Anthropic con búsqueda web selectiva). Perplexity prioriza la recuperación en tiempo real y la atribución visible de fuentes, mientras que ChatGPT genera consultas de búsqueda de forma oportunista. El enfoque de Google utiliza la expansión de consultas para cubrir múltiples dimensiones de intención, y Bing CoPilot combina señales SEO tradicionales con síntesis generativa. Cada plataforma tiene arquitecturas de recuperación, comportamientos de citación y requisitos de optimización distintos.

Los motores de búsqueda de IA siguen un proceso de varias etapas: primero, analizan la consulta del usuario utilizando procesamiento de lenguaje natural para comprender la intención; segundo, recuperan documentos o pasajes relevantes de índices web o API utilizando recuperación híbrida (combinando búsqueda léxica y semántica); tercero, vuelven a clasificar los candidatos según relevancia y capacidad de extracción; y finalmente, sintetizan una respuesta conversacional utilizando un gran modelo de lenguaje, insertando citas a los documentos fuente. El mecanismo de citación varía según la plataforma: algunas muestran citas en línea, otras muestran listas de fuentes y algunas integran las citas en el propio texto de la respuesta. La calidad y precisión de las citas dependen de cuán bien los pasajes recuperados coinciden con las afirmaciones sintetizadas.

La optimización para motores generativos (GEO) es la práctica de optimizar contenido y visibilidad de marca específicamente para motores de búsqueda de IA, a diferencia del SEO tradicional que se centra en el posicionamiento por palabras clave en resultados basados en enlaces. GEO se enfoca en hacer el contenido recuperable, extraíble y citable por sistemas de IA. Las estrategias clave de GEO incluyen estructurar el contenido para claridad y respuestas directas, usar lenguaje natural que coincida con la intención del usuario, implementar marcado de entidades y esquemas, asegurar tiempos de carga rápidos y construir autoridad temática. Como muestra la investigación de McKinsey, alrededor del 50% de las búsquedas en Google ya tienen resúmenes de IA, se espera que superen el 75% para 2028, haciendo que GEO sea cada vez más crítico para la visibilidad de marca.

Los motores de búsqueda de IA pueden tanto aumentar como disminuir el tráfico web dependiendo de cómo se optimice el contenido. Cuando el contenido es citado en respuestas generadas por IA, gana visibilidad y credibilidad, pero los usuarios pueden obtener su respuesta directamente sin hacer clic en la fuente. Las investigaciones indican que los AI Overviews pueden desviar tráfico de los sitios originales, aunque también proporcionan atribución y enlaces a la fuente. Para las marcas, este cambio significa que la visibilidad ahora depende de ser recuperado, sintetizado y citado por sistemas de IA, no sólo de posicionarse en resultados tradicionales. Herramientas de monitoreo como AmICited rastrean menciones de marca en plataformas de IA (Perplexity, ChatGPT, Google AI Overviews, Claude) para medir esta nueva forma de visibilidad y optimizar en consecuencia.

El procesamiento de lenguaje natural (NLP) es fundamental para que los motores de búsqueda de IA comprendan y procesen las consultas de los usuarios. NLP permite a los sistemas analizar la estructura, semántica e intención detrás de las consultas en lugar de sólo emparejar palabras clave. Permite a los motores de búsqueda de IA comprender el contexto, desambiguar significados y reconocer sinónimos y conceptos relacionados. NLP también impulsa la etapa de síntesis, donde los modelos de lenguaje generan respuestas coherentes y gramaticalmente correctas que suenan naturales para los usuarios. Además, NLP ayuda a los motores de búsqueda de IA a extraer y estructurar información de páginas web, identificando entidades clave, relaciones y afirmaciones que pueden incorporarse en las respuestas generadas.

Los motores de búsqueda de IA manejan la información en tiempo real mediante la generación aumentada por recuperación (RAG), que realiza búsquedas en vivo o llamadas a API para obtener datos actuales en el momento de la consulta en lugar de depender únicamente de datos de entrenamiento. Plataformas como Perplexity y el Modo IA de Google consultan activamente la web en tiempo real, asegurando que las respuestas reflejen la información más reciente. ChatGPT utiliza la API de búsqueda de Bing para acceder a contenido web actual cuando la navegación está habilitada. Las señales de frescura también se incorporan en los algoritmos de ranking: las páginas con fechas de publicación recientes y contenido actualizado tienen mayor peso en consultas sensibles al tiempo. Sin embargo, algunos motores de búsqueda de IA aún dependen parcialmente de datos de entrenamiento, que pueden ir rezagados respecto a los eventos reales, haciendo que la recuperación en tiempo real sea un diferenciador clave entre plataformas.

Comienza a rastrear cómo los chatbots de IA mencionan tu marca en ChatGPT, Perplexity y otras plataformas. Obtén información procesable para mejorar tu presencia en IA.

Aprende cómo enviar y optimizar tu contenido para motores de búsqueda de IA como ChatGPT, Perplexity y Gemini. Descubre estrategias de indexación, requisitos té...

Aprende cómo funcionan motores de búsqueda con IA como ChatGPT, Perplexity y Google AI Overviews. Descubre LLMs, RAG, búsqueda semántica y mecanismos de recuper...

Aprende cómo funcionan los índices de búsqueda de IA, las diferencias entre los métodos de indexación de ChatGPT, Perplexity y SearchGPT, y cómo optimizar tu co...

Consentimiento de Cookies

Usamos cookies para mejorar tu experiencia de navegación y analizar nuestro tráfico. See our privacy policy.