¿Qué es la Optimización de Grandes Modelos de Lenguaje (LLMO)? Guía Completa

Descubre qué es LLMO, cómo funciona y por qué es importante para la visibilidad en IA. Conoce técnicas de optimización para lograr que tu marca sea mencionada e...

Un mecanismo de atención es un componente de red neuronal que pondera dinámicamente la importancia de diferentes elementos de entrada, permitiendo que los modelos se enfoquen en las partes más relevantes de los datos al hacer predicciones. Calcula los pesos de atención mediante transformaciones aprendidas de consultas, claves y valores, permitiendo que los modelos de aprendizaje profundo capturen dependencias a largo plazo y relaciones sensibles al contexto en datos secuenciales.

Un mecanismo de atención es un componente de red neuronal que pondera dinámicamente la importancia de diferentes elementos de entrada, permitiendo que los modelos se enfoquen en las partes más relevantes de los datos al hacer predicciones. Calcula los pesos de atención mediante transformaciones aprendidas de consultas, claves y valores, permitiendo que los modelos de aprendizaje profundo capturen dependencias a largo plazo y relaciones sensibles al contexto en datos secuenciales.

El mecanismo de atención es una técnica de aprendizaje automático que dirige a los modelos de aprendizaje profundo para priorizar (o “atender a”) las partes más relevantes de los datos de entrada al hacer predicciones. En lugar de tratar todos los elementos de entrada por igual, los mecanismos de atención calculan pesos de atención que reflejan la importancia relativa de cada elemento para la tarea en cuestión, y luego aplican esos pesos para enfatizar o desestimar dinámicamente entradas específicas. Esta innovación fundamental se ha convertido en la piedra angular de las arquitecturas transformadoras modernas y de los grandes modelos de lenguaje (LLMs) como ChatGPT, Claude y Perplexity, permitiéndoles procesar datos secuenciales con una eficiencia y precisión sin precedentes. El mecanismo se inspira en la atención cognitiva humana: la capacidad de enfocarse selectivamente en detalles sobresalientes mientras se filtra la información irrelevante, y traduce este principio biológico en un componente de red neuronal matemáticamente riguroso y entrenable.

El concepto de mecanismos de atención fue introducido por primera vez por Bahdanau y colegas en 2014 para abordar limitaciones críticas en las redes neuronales recurrentes (RNNs) usadas para traducción automática. Antes de la atención, los modelos Seq2Seq dependían de un solo vector de contexto para codificar oraciones fuente completas, creando un cuello de botella informativo que limitaba severamente el desempeño en secuencias largas. El mecanismo de atención original permitió que el decodificador accediera a todos los estados ocultos del codificador en lugar de solo al final, seleccionando dinámicamente qué partes de la entrada eran más relevantes en cada paso de decodificación. Este avance mejoró drásticamente la calidad de la traducción, especialmente en oraciones largas. En 2015, Luong y colegas introdujeron la atención por producto punto, que reemplazó la costosa atención aditiva por una multiplicación matricial eficiente. El momento decisivo llegó en 2017 con la publicación de “Attention is All You Need”, que introdujo la arquitectura transformadora que prescindió completamente de la recurrencia en favor de mecanismos de atención puros. Este artículo revolucionó el aprendizaje profundo, permitiendo el desarrollo de BERT, modelos GPT y todo el ecosistema moderno de IA generativa. Hoy en día, los mecanismos de atención son omnipresentes en el procesamiento de lenguaje natural, visión por computadora y sistemas de IA multimodales, con más del 85% de los modelos de última generación incorporando algún tipo de arquitectura basada en atención.

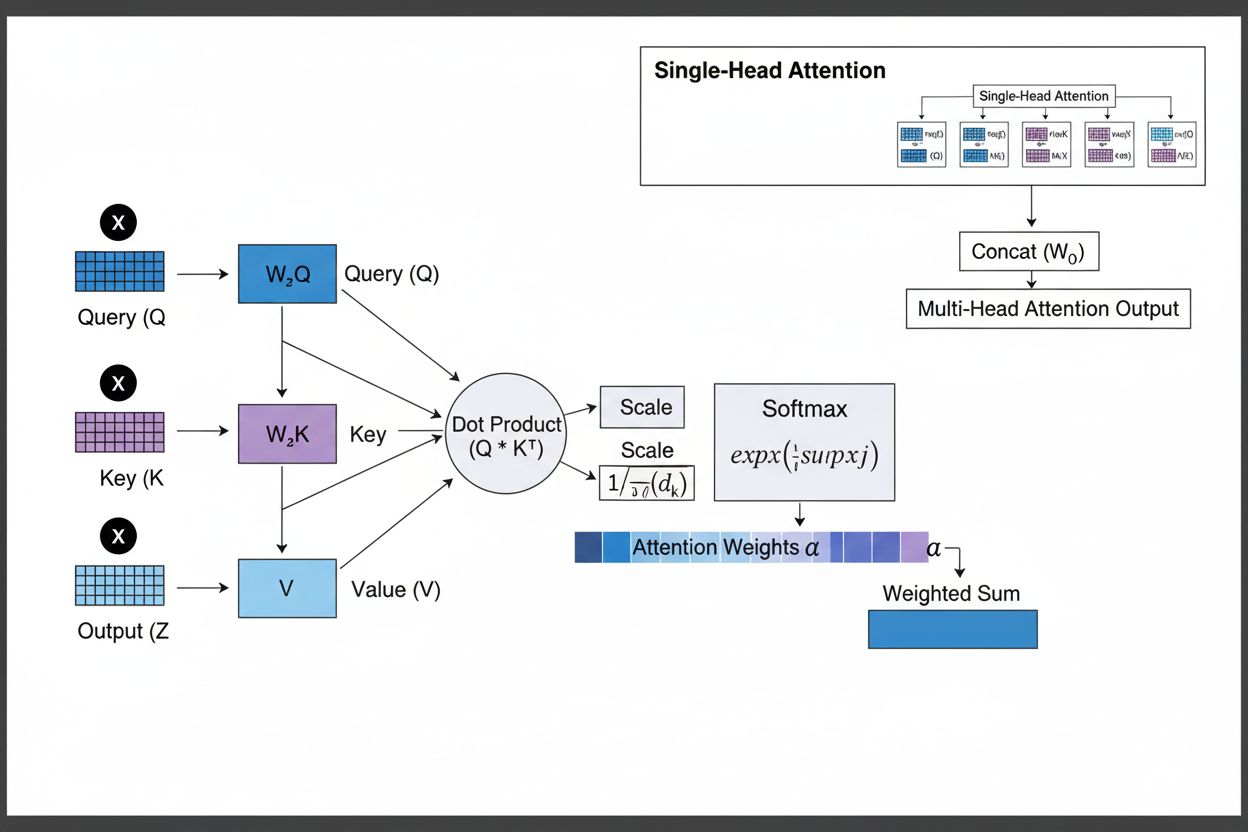

El mecanismo de atención opera mediante una sofisticada interacción de tres componentes matemáticos fundamentales: consultas (Q), claves (K) y valores (V). Cada elemento de entrada se transforma en estas tres representaciones mediante proyecciones lineales aprendidas, creando una estructura similar a una base de datos relacional donde las claves son identificadores y los valores contienen la información real. El mecanismo calcula puntajes de alineación midiendo la similitud entre una consulta y todas las claves, normalmente usando atención escalada por producto punto donde la puntuación se calcula como QK^T/√d_k. Estas puntuaciones brutas se normalizan usando la función softmax, que las convierte en una distribución de probabilidad donde todos los pesos suman 1, asegurando que cada elemento reciba un peso entre 0 y 1. El paso final consiste en calcular una suma ponderada de los vectores de valor usando estos pesos de atención, produciendo un vector de contexto que representa la información más relevante de toda la secuencia de entrada. Este vector de contexto se combina luego con la entrada original mediante conexiones residuales y se pasa por capas feedforward, permitiendo que el modelo refine iterativamente su comprensión de la entrada. La elegancia matemática de este diseño—combinando transformaciones aprendibles, cálculos de similitud y ponderación probabilística—permite a los mecanismos de atención capturar dependencias complejas mientras permanecen completamente diferenciables para la optimización por gradiente.

| Tipo de Atención | Método de Cálculo | Complejidad Computacional | Mejor Caso de Uso | Ventaja Clave |

|---|---|---|---|---|

| Atención Aditiva | Red feed-forward + activación tanh | O(n·d) por consulta | Secuencias cortas, dimensiones variables | Maneja diferentes dimensiones de consulta/clave |

| Atención por Producto Punto | Multiplicación matricial simple | O(n·d) por consulta | Secuencias estándar | Computacionalmente eficiente |

| Producto Punto Escalado | QK^T/√d_k + softmax | O(n·d) por consulta | Transformadores modernos | Previene gradientes que desaparecen |

| Atención Multi-Cabeza | Varias cabezas de atención en paralelo | O(h·n·d) donde h=cabezas | Relaciones complejas | Captura aspectos semánticos diversos |

| Self-Attention | Consultas, claves y valores de la misma secuencia | O(n²·d) | Relaciones intra-secuencia | Permite procesamiento en paralelo |

| Cross-Attention | Consultas de una secuencia, claves/valores de otra | O(n·m·d) | Encoder-decoder, multimodal | Alinea diferentes modalidades |

| Atención de Consulta Agrupada | Comparte claves/valores entre cabezas de consulta | O(n·d) | Inferencia eficiente | Reduce memoria y computación |

| Atención Dispersa | Atención limitada a posiciones locales/estridadas | O(n·√n·d) | Secuencias muy largas | Maneja secuencias extremadamente largas |

El mecanismo de atención opera mediante una secuencia cuidadosamente orquestada de transformaciones matemáticas que permiten a las redes neuronales enfocarse dinámicamente en información relevante. Al procesar una secuencia de entrada, cada elemento se incrusta primero en un espacio vectorial de alta dimensión, capturando información semántica y sintáctica. Estas incrustaciones se proyectan en tres espacios separados usando matrices de pesos aprendidas: el espacio de consulta (representa lo que se busca), el espacio de clave (representa la información que contiene cada elemento) y el espacio de valor (contiene la información real a agregar). Para cada posición de consulta, el mecanismo calcula una puntuación de similitud con cada clave tomando su producto punto, produciendo un vector de puntuaciones de alineación brutas. Estas puntuaciones se escalan dividiendo por la raíz cuadrada de la dimensión de la clave (√d_k), un paso crítico que evita que los productos punto sean demasiado grandes en dimensiones altas, lo que haría desaparecer los gradientes durante la retropropagación. Las puntuaciones escaladas se pasan luego a través de una función softmax, que las exponencia y normaliza para que sumen 1, creando una distribución de probabilidad sobre todas las posiciones de entrada. Finalmente, estos pesos de atención se usan para calcular un promedio ponderado de los vectores de valor, donde las posiciones con mayor peso de atención contribuyen más fuertemente al vector de contexto final. Este vector de contexto se combina luego con la entrada original mediante conexiones residuales y se procesa a través de capas feedforward, permitiendo que el modelo refine iterativamente sus representaciones. Todo el proceso es diferenciable, permitiendo que el modelo aprenda patrones de atención óptimos mediante descenso de gradiente durante el entrenamiento.

Los mecanismos de atención son el bloque fundamental de las arquitecturas transformadoras, que se han convertido en el paradigma dominante en aprendizaje profundo. A diferencia de las RNNs que procesan secuencias de manera secuencial y de las CNNs que operan sobre ventanas locales fijas, los transformadores usan la self-attention para permitir que cada posición atienda directamente a todas las demás posiciones simultáneamente, permitiendo una paralelización masiva en GPUs y TPUs. La arquitectura transformadora consiste en capas alternas de self-attention multi-cabeza y redes feedforward, donde cada capa de atención permite al modelo refinar su comprensión de la entrada al enfocarse selectivamente en diferentes aspectos. La atención multi-cabeza ejecuta múltiples mecanismos de atención en paralelo, donde cada cabeza aprende a enfocarse en diferentes tipos de relaciones: una cabeza puede especializarse en dependencias gramaticales, otra en relaciones semánticas y una tercera en coreferencia a larga distancia. Las salidas de todas las cabezas se concatenan y proyectan, permitiendo que el modelo mantenga conciencia de múltiples fenómenos lingüísticos simultáneamente. Esta arquitectura ha demostrado ser notablemente efectiva para grandes modelos de lenguaje como GPT-4, Claude 3 y Gemini, que usan arquitecturas transformadoras solo de decodificador donde cada token solo puede atender a tokens previos (enmascaramiento causal) para mantener la propiedad de generación autoregresiva. La capacidad del mecanismo de atención para capturar dependencias a largo plazo sin los problemas de gradientes que desaparecen que aquejaban a las RNNs ha sido fundamental para permitir que estos modelos procesen ventanas de contexto de más de 100,000 tokens, manteniendo coherencia y consistencia en grandes volúmenes de texto. Las investigaciones muestran que aproximadamente el 92% de los modelos de NLP de última generación ahora dependen de arquitecturas transformadoras impulsadas por mecanismos de atención, demostrando su importancia fundamental en los sistemas de IA modernos.

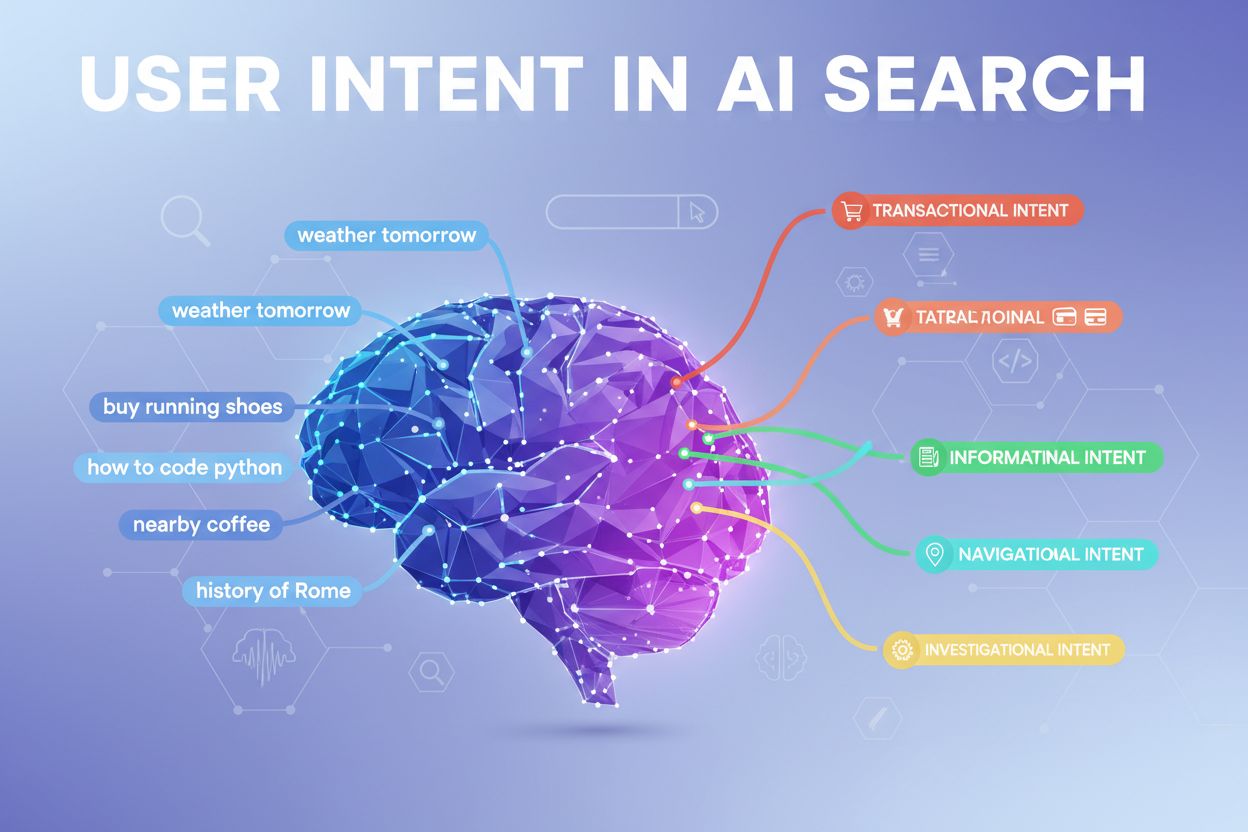

En el contexto de plataformas de búsqueda por IA como ChatGPT, Perplexity, Claude y Google AI Overviews, los mecanismos de atención juegan un papel crucial para determinar qué partes de los documentos recuperados y bases de conocimiento son más relevantes para las consultas de los usuarios. Cuando estos sistemas generan respuestas, sus mecanismos de atención ponderan dinámicamente diferentes fuentes y pasajes según su relevancia, permitiéndoles sintetizar respuestas coherentes de múltiples fuentes mientras mantienen precisión factual. Los pesos de atención calculados durante la generación pueden analizarse para entender qué información priorizó el modelo, proporcionando información sobre cómo los sistemas de IA interpretan y responden a las consultas. Para el monitoreo de marca y la GEO (Optimización para Motores Generativos), comprender los mecanismos de atención es esencial porque determinan qué contenido y fuentes reciben énfasis en las respuestas generadas por IA. El contenido estructurado para alinearse con la forma en que los mecanismos de atención ponderan la información—mediante definiciones claras de entidades, fuentes autorizadas y relevancia contextual—tiene más probabilidades de ser citado y aparecer de manera destacada en las respuestas de IA. AmICited aprovecha los conocimientos sobre mecanismos de atención para rastrear cómo aparecen marcas y dominios en las plataformas de IA, reconociendo que las citas ponderadas por atención representan las menciones más influyentes en el contenido generado por IA. A medida que las empresas monitorean cada vez más su presencia en respuestas de IA, entender que los mecanismos de atención impulsan los patrones de citación se vuelve crítico para optimizar la estrategia de contenido y asegurar la visibilidad de la marca en la era de la IA generativa.

El campo de los mecanismos de atención continúa evolucionando rápidamente, con investigadores desarrollando variantes cada vez más sofisticadas para abordar limitaciones computacionales y mejorar el rendimiento. Los patrones de atención dispersa limitan la atención a vecindarios locales o posiciones estridadas, reduciendo la complejidad de O(n²) a O(n·√n) mientras mantienen el rendimiento en secuencias muy largas. Mecanismos de atención eficiente como FlashAttention optimizan los patrones de acceso a memoria de la atención, logrando aceleraciones de 2-4x mediante un mejor uso de la GPU. La atención de consulta agrupada y la atención multi-consulta reducen la cantidad de cabezas de clave-valor manteniendo el rendimiento, disminuyendo significativamente los requerimientos de memoria durante la inferencia, una consideración crítica para desplegar modelos grandes en producción. Las arquitecturas Mixture of Experts combinan atención con ruteo disperso, permitiendo que los modelos escalen a billones de parámetros manteniendo la eficiencia computacional. La investigación emergente explora patrones de atención aprendidos que se adaptan dinámicamente según las características de entrada, y atención jerárquica que opera en múltiples niveles de abstracción. La integración de mecanismos de atención con generación aumentada por recuperación (RAG) permite que los modelos atiendan dinámicamente a conocimiento externo relevante, mejorando la factualidad y reduciendo alucinaciones. A medida que los sistemas de IA se despliegan cada vez más en aplicaciones críticas, los mecanismos de atención se están mejorando con características de explicabilidad que ofrecen una visión más clara sobre las decisiones del modelo. El futuro probablemente implique arquitecturas híbridas que combinen atención con mecanismos alternativos como modelos de espacio de estado (ejemplificados por Mamba), que ofrecen complejidad lineal manteniendo un rendimiento competitivo. Entender estos mecanismos de atención en evolución es esencial para los profesionales que construyen sistemas de IA de próxima generación y para las organizaciones que monitorean su presencia en contenido generado por IA, ya que los mecanismos que determinan los patrones de citación y la prominencia del contenido continúan avanzando.

Para las organizaciones que usan AmICited para monitorear la visibilidad de su marca en respuestas de IA, comprender los mecanismos de atención proporciona un contexto crucial para interpretar los patrones de citación. Cuando ChatGPT, Claude o Perplexity citan tu dominio en sus respuestas, los pesos de atención calculados durante la generación determinaron que tu contenido era el más relevante para la consulta del usuario. El contenido de alta calidad y bien estructurado que define claramente entidades y proporciona información autorizada recibe naturalmente mayores pesos de atención, lo que lo hace más probable de ser seleccionado para citación. Las visualizaciones de atención en algunas plataformas de IA revelan qué fuentes recibieron mayor enfoque durante la generación de la respuesta, mostrando efectivamente qué citas fueron más influyentes. Este conocimiento permite a las organizaciones optimizar su estrategia de contenido entendiendo que los mecanismos de atención recompensan la claridad, relevancia y fuentes autorizadas. A medida que la búsqueda por IA crece—con más del 60% de las empresas invirtiendo ahora en iniciativas de IA generativa—la capacidad de entender y optimizar para los mecanismos de atención se vuelve cada vez más valiosa para mantener la visibilidad de la marca y asegurar una representación precisa en contenido generado por IA. La intersección entre mecanismos de atención y monitoreo de marca representa una frontera en la GEO, donde entender los fundamentos matemáticos de cómo los sistemas de IA ponderan y citan información se traduce directamente en mayor visibilidad e influencia en el ecosistema de IA generativa.

Las RNN tradicionales procesan secuencias de manera serial, lo que dificulta capturar dependencias a largo plazo, mientras que las CNN tienen campos receptivos locales fijos que limitan su capacidad para modelar relaciones distantes. Los mecanismos de atención superan estas limitaciones al calcular relaciones entre todas las posiciones de entrada simultáneamente, permitiendo procesamiento en paralelo y capturando dependencias sin importar la distancia. Esta flexibilidad en el tiempo y espacio hace que los mecanismos de atención sean significativamente más eficientes y efectivos para datos secuenciales y espaciales complejos.

Las consultas representan la información que el modelo está buscando en ese momento, las claves representan el contenido informativo que cada elemento de entrada contiene, y los valores contienen los datos reales que se van a agregar. El modelo calcula puntuaciones de similitud entre consultas y claves para determinar qué valores deben recibir mayor peso. Esta terminología inspirada en bases de datos, popularizada por el artículo 'Attention is All You Need', proporciona un marco intuitivo para entender cómo los mecanismos de atención recuperan y combinan selectivamente la información relevante de las secuencias de entrada.

La self-attention calcula relaciones dentro de una sola secuencia de entrada, donde consultas, claves y valores provienen de la misma fuente, permitiendo que el modelo entienda cómo se relacionan los diferentes elementos entre sí. Por el contrario, la cross-attention utiliza consultas de una secuencia y claves/valores de una secuencia diferente, permitiendo que el modelo alinee y combine información de múltiples fuentes. La cross-attention es esencial en arquitecturas encoder-decoder como la traducción automática y en modelos multimodales como Stable Diffusion, que combinan información de texto e imagen.

La atención escalada por producto punto utiliza multiplicación en lugar de suma para calcular las puntuaciones de alineación, haciéndola computacionalmente más eficiente mediante operaciones matriciales que aprovechan la paralelización de GPU. El factor de escalado de 1/√dk previene que los productos punto sean demasiado grandes cuando la dimensión de la clave es alta, lo que causaría que los gradientes desaparezcan durante la retropropagación. Aunque la atención aditiva a veces supera a la atención por producto punto en dimensiones muy grandes, la eficiencia computacional y el rendimiento práctico de la atención escalada por producto punto la convierten en la opción estándar en arquitecturas transformadoras modernas.

La atención multi-cabeza ejecuta múltiples mecanismos de atención en paralelo, donde cada cabeza aprende a enfocarse en diferentes aspectos de la entrada, como relaciones gramaticales, significado semántico o dependencias a larga distancia. Cada cabeza opera sobre diferentes proyecciones lineales de la entrada, permitiendo que el modelo capture simultáneamente diversos tipos de relaciones. Las salidas de todas las cabezas se concatenan y proyectan, permitiendo que el modelo mantenga una conciencia integral de múltiples características lingüísticas y contextuales a la vez, mejorando significativamente la calidad de las representaciones y el rendimiento en tareas posteriores.

La función softmax normaliza las puntuaciones de alineación calculadas entre consultas y claves en una distribución de probabilidad donde todos los pesos suman 1. Esta normalización asegura que los pesos de atención sean interpretables como puntuaciones de importancia, con valores más altos indicando mayor relevancia. La función softmax es diferenciable, permitiendo el aprendizaje por gradiente del mecanismo de atención durante el entrenamiento, y su naturaleza exponencial enfatiza las diferencias entre puntuaciones, haciendo que el enfoque del modelo sea más selectivo e interpretable.

Los mecanismos de atención permiten que estos modelos ponderen dinámicamente diferentes partes de la entrada según su relevancia para el paso de generación actual. Al generar una respuesta, el modelo utiliza atención para determinar qué tokens y elementos previos deben influir más en la predicción del siguiente token. Esta ponderación consciente del contexto permite que los modelos mantengan coherencia, sigan entidades a lo largo de documentos extensos, resuelvan ambigüedades y generen respuestas que referencien adecuadamente partes específicas de la entrada, haciendo que sus salidas sean más precisas y apropiadas al contexto.

Comienza a rastrear cómo los chatbots de IA mencionan tu marca en ChatGPT, Perplexity y otras plataformas. Obtén información procesable para mejorar tu presencia en IA.

Descubre qué es LLMO, cómo funciona y por qué es importante para la visibilidad en IA. Conoce técnicas de optimización para lograr que tu marca sea mencionada e...

Descubre cómo los grandes modelos de lenguaje interpretan la intención del usuario más allá de las palabras clave. Aprende sobre expansión de consultas, compren...

Aprende cómo optimizar tu contenido para la inclusión en los datos de entrenamiento de IA. Descubre las mejores prácticas para hacer que tu sitio web sea visibl...

Consentimiento de Cookies

Usamos cookies para mejorar tu experiencia de navegación y analizar nuestro tráfico. See our privacy policy.