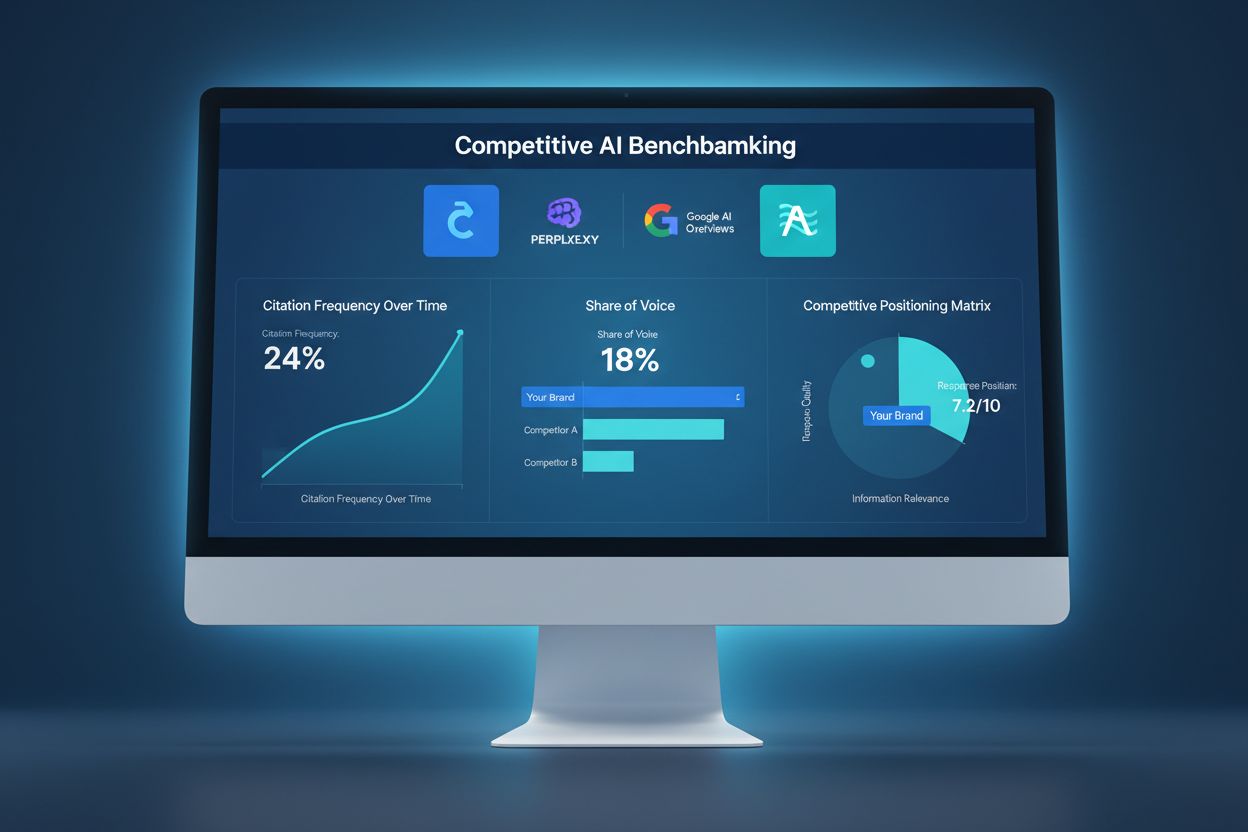

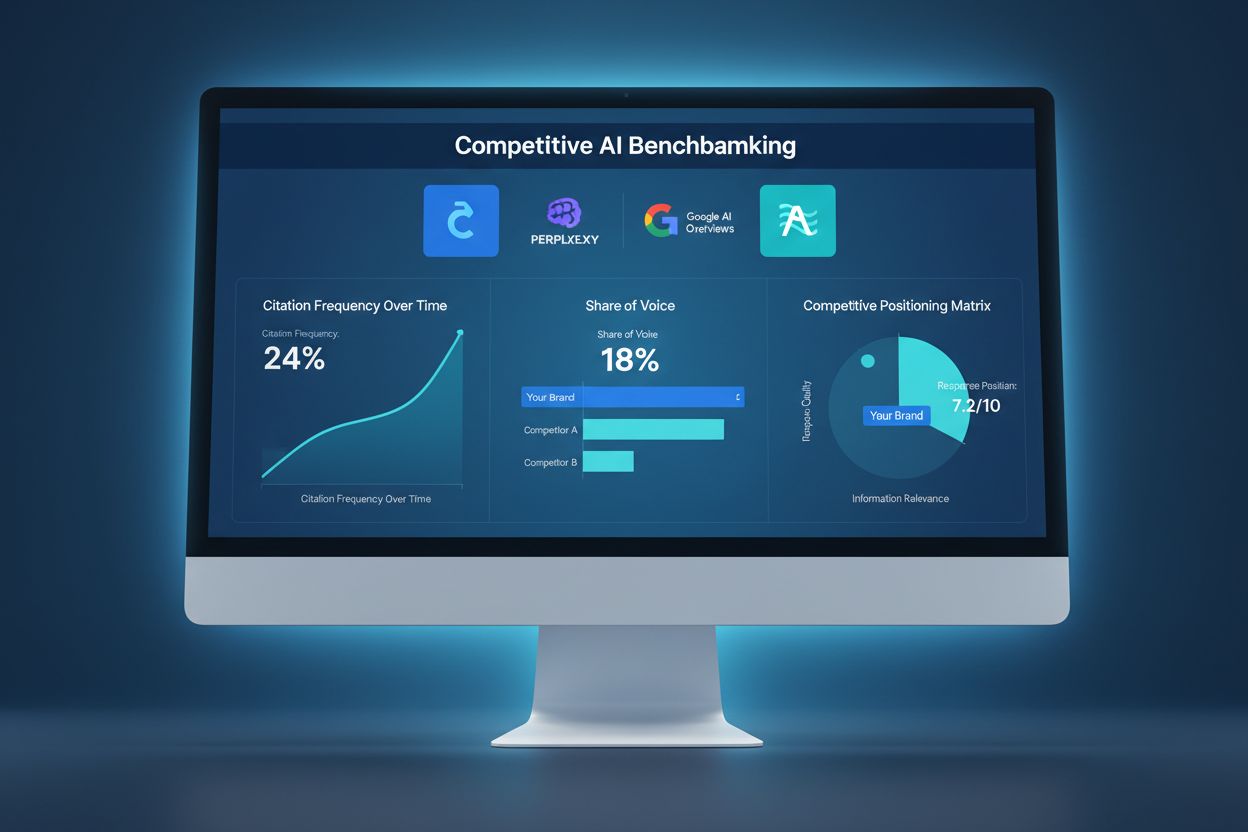

Benchmarking competitivo de IA

Aprende cómo comparar tu visibilidad en IA frente a la competencia. Rastrea citaciones, cuota de voz y posicionamiento competitivo en ChatGPT, Perplexity y Goog...

El sabotaje competitivo de IA se refiere a intentos deliberados de competidores por influir negativamente en la visibilidad, el sentimiento o el rendimiento de una marca en los resultados de búsqueda impulsados por IA y en las respuestas de chatbots. Esto incluye envenenamiento de datos, reseñas falsas, campañas de desinformación y manipulación de los datos de entrenamiento de IA para dañar la reputación de la marca y reducir las citas de IA.

El sabotaje competitivo de IA se refiere a intentos deliberados de competidores por influir negativamente en la visibilidad, el sentimiento o el rendimiento de una marca en los resultados de búsqueda impulsados por IA y en las respuestas de chatbots. Esto incluye envenenamiento de datos, reseñas falsas, campañas de desinformación y manipulación de los datos de entrenamiento de IA para dañar la reputación de la marca y reducir las citas de IA.

El sabotaje competitivo de IA se refiere a intentos deliberados de manipular, envenenar o corromper los datos que los motores de búsqueda y modelos de lenguaje basados en IA utilizan para generar resultados y citas. A diferencia del SEO negativo tradicional, que se enfoca en dañar el posicionamiento web de un competidor mediante esquemas de enlaces o explotaciones técnicas, el sabotaje de IA apunta a los datos de entrenamiento y fuentes en las que los sistemas de IA confían para ofrecer respuestas. Esta distinción es fundamental porque sistemas de IA como Google AI Overviews, Perplexity y los GPT citan fuentes directamente de sus datos de entrenamiento, lo que los hace vulnerables a campañas de desinformación coordinada. El impacto en el mundo real es considerable: con el 60% de las búsquedas finalizando sin hacer clic en sitios web, los competidores ahora pueden envenenar los resultados de IA para redirigir tráfico, dañar la reputación de la marca o promover información falsa sin afectar los rankings tradicionales de búsqueda.

El sabotaje competitivo de IA opera a través de varios vectores de ataque interconectados que explotan la forma en que los sistemas de IA ingieren y procesan información. El envenenamiento de datos es la técnica principal, e implica la inyección de información falsa, engañosa o maliciosa en las fuentes que los sistemas de IA utilizan para entrenarse, como bases de datos públicas, foros, sitios de reseñas y agregadores de noticias. Los atacantes emplean label flipping (alteración de metadatos para clasificar erróneamente contenido), inyección de datos (agregar entradas falsas en conjuntos de datos) y ataques backdoor (insertar disparadores ocultos en los datos de entrenamiento). Los competidores también lanzan campañas coordinadas de reseñas falsas para inundar plataformas con testimonios fabricados, mientras difunden desinformación y deepfakes en redes sociales, blogs y contenido indexado por IA. La vulnerabilidad radica en que los sistemas de IA suelen confiar en el volumen y la consistencia de la información más que en su autenticidad. Así se comparan los diferentes métodos de sabotaje:

| Método | Cómo Funciona | Impacto en la IA | Dificultad de Detección |

|---|---|---|---|

| Envenenamiento de Datos | Inyectar información falsa en conjuntos de datos de entrenamiento | La IA cita fuentes envenenadas directamente en los resultados | Alta - requiere análisis de datos |

| Reseñas Falsas | Bombardeo coordinado de reseñas en plataformas | Sesga el análisis de sentimiento y recomendaciones de la IA | Media - el análisis de patrones puede ayudar |

| Campañas de Desinformación | Difusión de afirmaciones falsas en sitios web indexados | La IA amplifica narrativas falsas en los resultados de búsqueda | Alta - requiere verificación de hechos |

| Deepfakes | Creación de medios sintéticos de ejecutivos o productos | Daña la credibilidad de la marca al ser citado por la IA | Muy Alta - requiere verificación |

| Secuestro de Directorios | Reclamar los listados de negocio del competidor | La IA obtiene información falsa de directorios secuestrados | Media - las verificaciones ayudan |

| Noticias Falsas | Publicar historias fabricadas en sitios tipo noticias | La IA los trata como fuentes autorizadas | Alta - requiere verificación de fuente |

Los sistemas de IA son fundamentalmente más vulnerables al sabotaje que los motores de búsqueda tradicionales porque confían en los datos de entrenamiento de forma más implícita que los humanos. Mientras que el algoritmo de Google evalúa la autoridad de los enlaces y la reputación del dominio, los modelos de IA simplemente aprenden patrones de cualquier dato con el que se entrenen, lo que los hace susceptibles a ataques coordinados. Las investigaciones muestran que tan solo 250 documentos maliciosos pueden envenenar un modelo de IA, una barrera de entrada mucho más baja en comparación con los ataques de SEO tradicionales. El problema se agrava porque los sistemas de IA citan fuentes directamente, lo que significa que los datos envenenados no solo influyen en los resultados, sino que se convierten en la respuesta autoritativa que el usuario ve. Detectar datos envenenados es exponencialmente más difícil que identificar un mal enlace porque la manipulación ocurre a nivel de entrenamiento, a menudo invisible para auditorías externas. Con el tráfico de búsquedas IA aumentando un 527% en solo cinco meses (enero-mayo 2025) y el 79% de los estadounidenses confiando en los motores de búsqueda IA, el incentivo para el sabotaje competitivo es mayor que nunca, mientras que la infraestructura de seguridad para prevenirlo sigue poco desarrollada.

El ejemplo más destacado de sabotaje de IA ocurrió cuando Target fue víctima de una campaña coordinada de desinformación que afirmaba falsamente que el minorista vendía ropa infantil con temática “satánica”. Los sistemas de IA, entrenados con esta narrativa fabricada, comenzaron a mostrar estas afirmaciones falsas en los resultados de búsqueda y resúmenes de IA, causando un daño reputacional considerable antes de que la empresa pudiera responder. Los sistemas de correo electrónico han experimentado ataques similares mediante envenenamiento de filtros de spam, donde los competidores inyectan patrones maliciosos en los datos de entrenamiento para que correos legítimos sean marcados como spam. El bombardeo de reseñas negativas por competidores se ha vuelto cada vez más común, con empresas inundando los listados de rivales con reseñas negativas falsas que los sistemas de IA luego agregan en sus puntuaciones de sentimiento. El secuestro de listados de directorio es otro vector, donde los atacantes reclaman los perfiles de negocio de la competencia en plataformas como Google My Business o directorios del sector, y luego proporcionan información falsa que los sistemas de IA indexan y citan. Estos casos demuestran que el sabotaje de IA no es teórico: está dañando activamente a empresas hoy, y el daño se amplifica porque los resultados de búsqueda IA parecen autoritarios y suelen ser la primera información que el usuario encuentra.

Detectar el sabotaje competitivo de IA requiere un enfoque de monitoreo multinivel que rastree cómo aparece tu marca en los resultados de búsqueda IA y las fuentes de citación. El primer paso es el monitoreo continuo de los resultados de búsqueda IA para tu marca, productos y ejecutivos clave en plataformas como Google AI Overviews, Perplexity, ChatGPT y Claude. El rastreo de sentimiento en las fuentes indexadas ayuda a identificar cambios bruscos en la forma en que se habla de tu marca, una señal de alerta de campañas coordinadas de desinformación. La identificación de reseñas falsas implica analizar patrones de reseñas para detectar anomalías estadísticas, como picos repentinos de calificaciones de una estrella o reseñas con lenguaje idéntico. La detección temprana es crítica; la investigación muestra que las primeras 48 horas tras un ataque de sabotaje son cruciales para la contención y respuesta. El monitoreo también debe rastrear qué fuentes citan los sistemas de IA sobre tu marca, lo que te permite identificar datos envenenados antes de que causen daños generalizados. Estos son los métodos esenciales de detección:

Construir resiliencia frente al sabotaje competitivo de IA requiere una estrategia de defensa proactiva y multifacética que vaya más allá de la gestión tradicional de reputación. Crear contenido de alta calidad y autoridad es tu mejor defensa: los sistemas de IA están entrenados para reconocer y priorizar contenido de fuentes establecidas y creíbles, lo que dificulta que los datos envenenados compitan con la información legítima. Amplificar información precisa en múltiples plataformas indexadas asegura que cuando los sistemas de IA busquen información sobre tu marca, encuentren narrativas verídicas y coherentes de fuentes autorizadas. Asegurar tu presencia de marca implica reclamar y verificar todos los listados de negocio, perfiles sociales y directorios del sector para prevenir ataques de secuestro. Implementa sistemas sólidos de monitoreo que rastreen tu marca en los resultados de búsqueda IA en tiempo real, permitiendo una respuesta rápida ante amenazas emergentes. Desarrolla protocolos de respuesta que detallen cómo actuará tu equipo ante sabotaje detectado, incluyendo documentación, reporte a plataformas y acciones legales cuando corresponda. Construir relaciones con periodistas, influencers del sector y publicaciones de confianza crea capas adicionales de credibilidad que los sistemas de IA reconocen y priorizan.

Las plataformas dedicadas al monitoreo de IA se han vuelto infraestructuras esenciales para la protección de marcas en la era de la búsqueda con IA. Estas herramientas proporcionan alertas en tiempo real cuando tu marca aparece en resultados de búsqueda IA, permitiéndote rastrear no solo rankings sino citas reales y las fuentes que utilizan los sistemas de IA. AmICited.com destaca como una solución integral diseñada específicamente para monitorear cómo tu marca, productos y ejecutivos son citados en motores de búsqueda IA como Google AI Overviews, Perplexity y GPTs. La plataforma rastrea qué fuentes citan los sistemas de IA sobre tu marca, permitiéndote identificar datos envenenados y responder antes de que causen daños generalizados. Integrar esto con tu estrategia más amplia de seguridad de marca te permite correlacionar patrones de citación IA con métricas de búsqueda tradicionales, sentimiento en redes sociales y plataformas de reseñas para obtener una visión completa de tu panorama competitivo. Al combinar el monitoreo de IA con tus herramientas de gestión de reputación existentes, creas un sistema de defensa unificado que detecta intentos de sabotaje a tiempo y proporciona los datos necesarios para una respuesta rápida.

A medida que el sabotaje competitivo de IA se vuelve más frecuente, los marcos legales están evolucionando para abordar estas nuevas amenazas. Las notificaciones de retiro DMCA pueden utilizarse para eliminar contenido envenenado de fuentes indexadas, aunque el proceso suele ser lento y requiere pruebas claras de infracción de derechos de autor o suplantación. La ley de difamación ofrece recursos cuando el sabotaje implica declaraciones falsas que dañan tu reputación, aunque probar daños en el contexto de IA sigue siendo complejo. La mayoría de las grandes plataformas ahora cuentan con mecanismos de reporte específicamente para abusos relacionados con IA, incluyendo envenenamiento de datos, reseñas falsas y campañas de desinformación, aunque la aplicación varía considerablemente. Regulaciones emergentes como la Ley de IA de la UE y propuestas en EE. UU. comienzan a establecer marcos de responsabilidad para sistemas de IA que amplifican información falsa, lo que potencialmente crea nuevas vías de acción legal. Las empresas deben documentar exhaustivamente todos los intentos de sabotaje, ya que esta evidencia es fundamental tanto para procedimientos legales como para apelaciones en plataformas. Consultar con abogados experimentados en IA y reputación digital es cada vez más importante para desarrollar estrategias de respuesta que cumplan con regulaciones en evolución.

El panorama del sabotaje competitivo de IA seguirá evolucionando a medida que tanto atacantes como defensores desarrollen técnicas más sofisticadas. Las reseñas falsas generadas por IA mediante grandes modelos de lenguaje serán cada vez más difíciles de distinguir de los comentarios auténticos, requiriendo sistemas de detección más avanzados. La verificación mediante blockchain y sistemas de credibilidad descentralizados están surgiendo como soluciones potenciales para verificar la autenticidad de las fuentes antes de que los sistemas de IA incorporen datos en los sets de entrenamiento. Los proveedores de plataformas están invirtiendo fuertemente en mejoras de defensa, incluyendo mejor validación de datos, verificación de fuentes y algoritmos de detección de envenenamiento, aunque estas medidas siempre irán por detrás de los nuevos vectores de ataque. Los sistemas de verificación comunitaria, donde usuarios y expertos señalan contenido sospechoso, podrían convertirse en práctica estándar, generando una defensa colectiva contra el sabotaje. La ventaja competitiva pertenecerá cada vez más a las empresas que se anticipen a amenazas emergentes mediante monitoreo continuo, protocolos de respuesta rápida e inversión en alfabetización de IA en sus equipos. Las organizaciones que consideren el monitoreo de IA como un componente central de su estrategia de protección de marca hoy estarán mejor posicionadas para defenderse de los ataques más sofisticados del mañana.

El SEO negativo tradicional apunta a los rankings de motores de búsqueda mediante manipulación de enlaces y copia de contenido. El sabotaje competitivo de IA apunta a los datos de entrenamiento de IA y al comportamiento del modelo, envenenando las fuentes que los sistemas de IA citan en sus respuestas. Los sistemas de IA son más vulnerables porque citan fuentes directamente y confían más en los datos de entrenamiento que los algoritmos de búsqueda tradicionales.

Monitorea semanalmente cómo las plataformas de IA describen tu marca usando herramientas como AmICited.com. Busca cambios bruscos de sentimiento, afirmaciones falsas en respuestas de IA, campañas coordinadas de reseñas negativas o desinformación en varias plataformas. La detección temprana dentro de las primeras 48 horas es crítica para la contención.

Documenta todo de inmediato con capturas de pantalla y marcas de tiempo. Informa a las plataformas afectadas (OpenAI, Google, Anthropic). Amplifica información precisa a través de tus propios canales. Contacta a un abogado si ocurrió difamación o daño financiero. Implementa sistemas de monitoreo para detectar futuros ataques a tiempo.

Las investigaciones muestran que los atacantes solo necesitan 250 documentos maliciosos o el 7-8% de un conjunto de datos para envenenar de forma significativa los modelos de IA. Esta barrera de entrada tan baja hace que los sistemas de IA sean particularmente vulnerables en comparación con los motores de búsqueda tradicionales, que tienen mecanismos de detección de spam más sofisticados.

Las plataformas de IA actuales tienen capacidades de detección limitadas y dependen principalmente de reportes de usuarios y reentrenamiento periódico con datos limpios. Sin embargo, las plataformas están implementando mejores sistemas de verificación, detección de anomalías y controles de acceso. La responsabilidad de la detección temprana recae a menudo en las propias marcas.

Construye una reputación auténtica y sólida con contenido de alta calidad, monitorea los resultados de búsqueda de IA regularmente, asegura tu presencia de marca en directorios, implementa sistemas de monitoreo en tiempo real y responde rápidamente a los ataques. La prevención a través de la construcción de reputación es más efectiva que la remediación después de que ocurre el sabotaje.

AmICited.com monitorea cómo las plataformas de IA (ChatGPT, Perplexity, Google AI Overviews) hacen referencia a tu marca, rastreando cambios de sentimiento y patrones de citación. Las alertas en tiempo real te notifican sobre cambios bruscos en la forma en que la IA describe tu marca, permitiéndote responder rápidamente a posibles intentos de sabotaje.

Puedes presentar demandas por difamación, emitir avisos de retiro DMCA por contenido falso, reportar a las plataformas por violaciones de términos de servicio y potencialmente reclamar daños por perjuicio financiero. La documentación del sabotaje es fundamental. Consulta con abogados especializados en derechos digitales y propiedad intelectual.

Protege tu marca del sabotaje competitivo de IA con monitoreo en tiempo real en ChatGPT, Perplexity y Google AI Overviews. Detecta amenazas antes de que dañen tu reputación.

Aprende cómo comparar tu visibilidad en IA frente a la competencia. Rastrea citaciones, cuota de voz y posicionamiento competitivo en ChatGPT, Perplexity y Goog...

Discusión comunitaria sobre tácticas black hat que afectan la visibilidad en IA. Perspectivas reales sobre envenenamiento de IA, manipulación de contenido y cóm...

Descubre qué es la Inteligencia Competitiva en IA y cómo monitorear la visibilidad de la competencia en ChatGPT, Perplexity y Google AI Overviews. Rastrea citac...

Consentimiento de Cookies

Usamos cookies para mejorar tu experiencia de navegación y analizar nuestro tráfico. See our privacy policy.