Ventana de contexto

Ventana de contexto explicada: los tokens máximos que un LLM puede procesar a la vez. Descubre cómo las ventanas de contexto afectan la precisión de la IA, aluc...

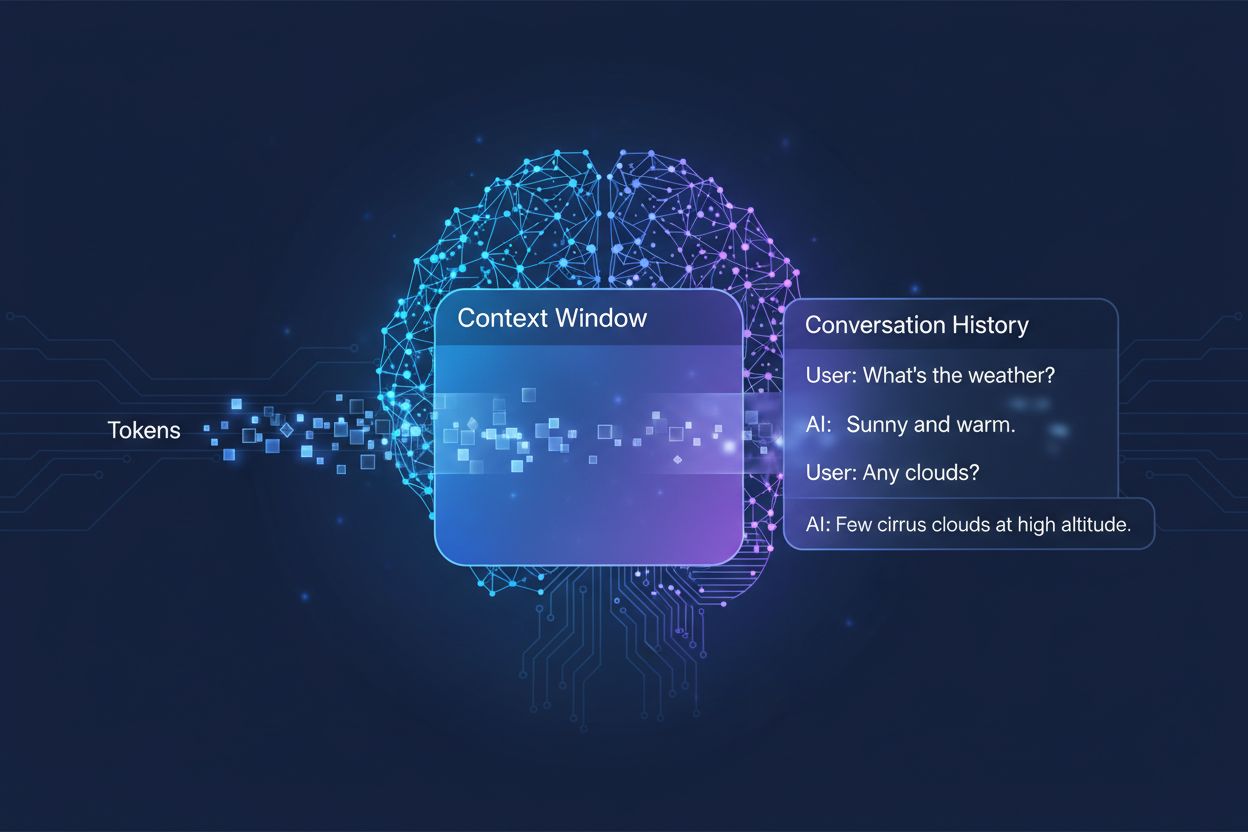

La cantidad de conversación previa que un sistema de IA considera al generar respuestas, medida en tokens. Determina cuánta información puede procesar la IA simultáneamente e impacta directamente en la calidad y coherencia de sus respuestas en conversaciones de varios turnos.

La cantidad de conversación previa que un sistema de IA considera al generar respuestas, medida en tokens. Determina cuánta información puede procesar la IA simultáneamente e impacta directamente en la calidad y coherencia de sus respuestas en conversaciones de varios turnos.

Una ventana de contexto es la cantidad máxima de texto que un modelo de lenguaje de IA puede procesar y referenciar de una vez durante una conversación o tarea. Piénsalo como la memoria de trabajo del modelo: así como los humanos solo pueden retener una cantidad limitada de información en su conciencia inmediata, los modelos de IA solo pueden “ver” cierta cantidad de texto antes y después de su posición actual. Esta capacidad se mide en tokens, que son pequeñas unidades de texto que normalmente representan palabras o fragmentos de palabras (en promedio, una palabra en inglés equivale aproximadamente a 1,5 tokens). Comprender la ventana de contexto de tu modelo es crucial porque determina directamente cuánta información puede considerar la IA al generar respuestas, siendo una restricción fundamental en la capacidad del modelo para manejar conversaciones complejas de varios turnos o documentos extensos.

Los modelos de lenguaje modernos, especialmente las arquitecturas basadas en transformadores, procesan el texto convirtiéndolo en tokens y luego analizan las relaciones entre todos los tokens dentro de la ventana de contexto simultáneamente. La arquitectura transformer, introducida en el influyente artículo de 2017 “Attention is All You Need”, utiliza un mecanismo llamado auto-atención para determinar qué partes de la entrada son más relevantes entre sí. Este mecanismo de atención permite que el modelo pese la importancia de diferentes tokens en relación unos con otros, permitiéndole entender el contexto y el significado en toda la ventana. Sin embargo, este proceso se vuelve computacionalmente costoso a medida que la ventana de contexto crece, ya que el mecanismo de atención debe calcular relaciones entre cada token y todos los demás—un problema de escalado cuadrático. La siguiente tabla ilustra cómo se comparan los principales modelos de IA en sus capacidades de ventana de contexto:

| Modelo | Ventana de Contexto (Tokens) | Fecha de Lanzamiento |

|---|---|---|

| GPT-4 | 128,000 | Marzo 2023 |

| Claude 3 Opus | 200,000 | Marzo 2024 |

| Gemini 1.5 Pro | 1,000,000 | Mayo 2024 |

| GPT-4 Turbo | 128,000 | Noviembre 2023 |

| Llama 2 | 4,096 | Julio 2023 |

Estas capacidades variables reflejan diferentes decisiones de diseño y compensaciones computacionales hechas por cada organización, donde ventanas más grandes permiten aplicaciones más sofisticadas pero requieren mayor poder de procesamiento.

El avance hacia ventanas de contexto más grandes representa uno de los progresos más significativos en la capacidad de la IA durante la última década. Los primeros redes neuronales recurrentes (RNNs) y modelos LSTM (memoria a largo y corto plazo) tenían dificultades con el contexto, ya que procesaban el texto secuencialmente y les costaba retener información de partes distantes de la entrada. El avance se produjo en 2017 con la introducción de la arquitectura Transformer, que permitió el procesamiento paralelo de secuencias completas y mejoró drásticamente la capacidad del modelo para mantener el contexto en textos largos. Esta base condujo al GPT-2 de 2019, que demostró una generación de lenguaje impresionante con una ventana de contexto de 1,024 tokens, seguido del GPT-3 de 2020 con 2,048 tokens y, finalmente, del GPT-4 de 2023 con 128,000 tokens. Cada avance fue importante porque amplió lo posible: ventanas más grandes permitieron a los modelos manejar documentos más largos, mantener coherencia en conversaciones de varios turnos y comprender relaciones matizadas entre conceptos distantes en el texto. El crecimiento exponencial en el tamaño de las ventanas de contexto refleja tanto innovaciones arquitectónicas como un aumento en los recursos computacionales disponibles para los principales laboratorios de IA.

Ventanas de contexto más grandes expanden fundamentalmente lo que los modelos de IA pueden lograr, permitiendo aplicaciones que antes eran imposibles o muy limitadas. Aquí los principales beneficios:

Continuidad de conversación mejorada: Los modelos pueden mantener conciencia de todo el historial de la conversación, reduciendo la necesidad de volver a explicar el contexto y permitiendo diálogos de varios turnos más naturales y coherentes, que se sienten realmente continuos en vez de fragmentados.

Procesamiento de documentos a escala: Ventanas más grandes permiten que la IA analice documentos completos, artículos científicos o bases de código en una sola pasada, identificando patrones y relaciones en todo el contenido sin perder información de secciones anteriores.

Razonamiento y análisis mejorados: Con más contexto disponible, los modelos pueden realizar tareas de razonamiento más sofisticadas que requieren entender relaciones entre múltiples conceptos, haciéndolos más efectivos para investigación, análisis y resolución compleja de problemas.

Menor sobrecarga por cambio de contexto: Los usuarios ya no necesitan resumir o reintroducir información manualmente una y otra vez; el modelo puede hacer referencia al historial completo de la conversación, reduciendo fricciones y mejorando la eficiencia en flujos de trabajo colaborativos.

Mejor manejo de tareas complejas y matizadas: Aplicaciones como la revisión de documentos legales, análisis de expedientes médicos y auditoría de código se benefician enormemente de la capacidad de considerar un contexto integral, lo que lleva a resultados más precisos y exhaustivos.

Flujos de trabajo multidocumento sin fisuras: Profesionales pueden trabajar con múltiples documentos relacionados a la vez, permitiendo que el modelo cruce información e identifique conexiones que serían imposibles con ventanas de contexto pequeñas.

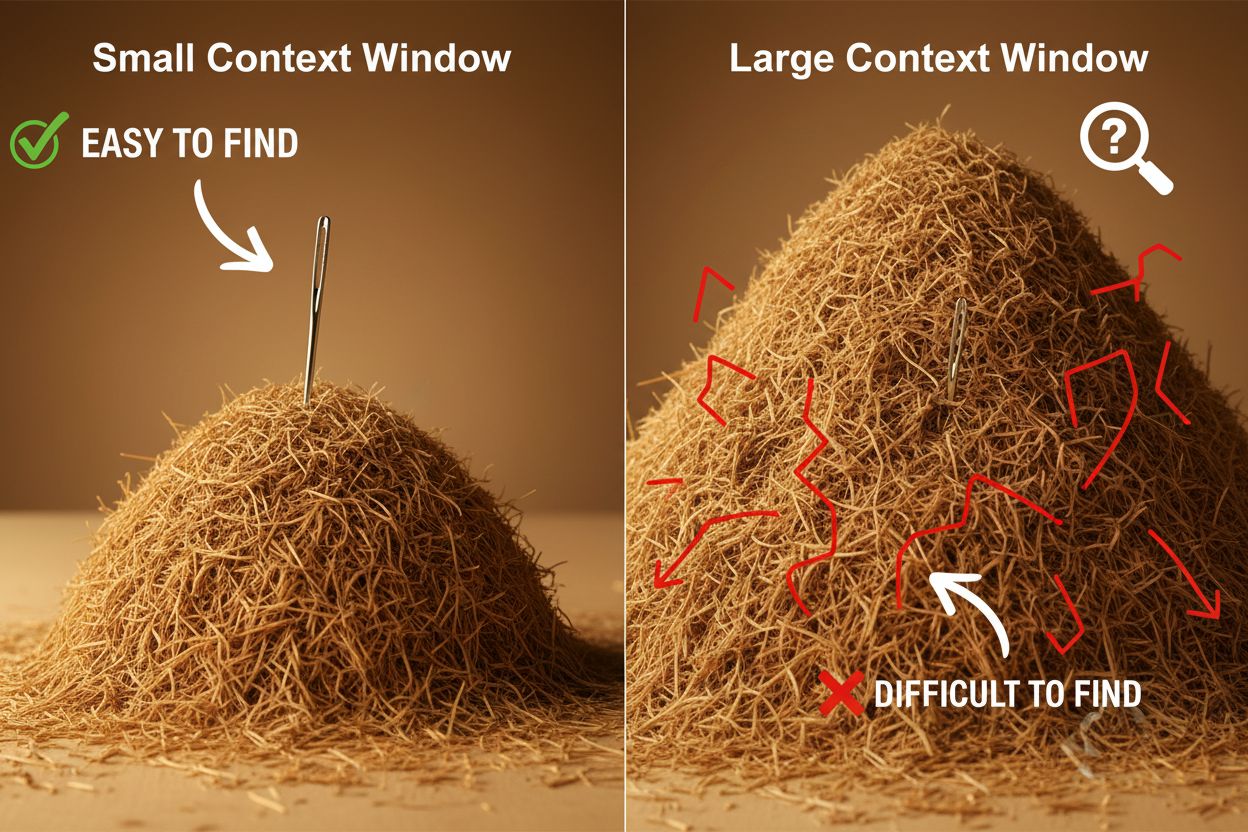

A pesar de sus ventajas, las ventanas de contexto grandes introducen retos técnicos y prácticos significativos que desarrolladores y usuarios deben gestionar con cuidado. El desafío más evidente es el costo computacional: procesar secuencias largas requiere exponencialmente más memoria y capacidad de procesamiento debido al escalado cuadrático del mecanismo de atención, haciendo que ventanas más grandes sean mucho más caras de ejecutar. Esta mayor demanda computacional también genera problemas de latencia, ya que ventanas de contexto más largas implican tiempos de respuesta más lentos—una preocupación crítica para aplicaciones en tiempo real donde los usuarios esperan respuestas rápidas. Otro problema sutil pero importante es el fenómeno de “aguja en un pajar”, donde los modelos tienen dificultades para ubicar y utilizar información relevante cuando está enterrada dentro de una ventana de contexto muy grande, a veces rindiendo peor que con ventanas más pequeñas. Además, ocurre la degradación del contexto cuando la información al principio de una ventana larga pierde influencia en la salida del modelo, ya que el mecanismo de atención puede dar menos prioridad a tokens lejanos en favor de los más recientes. Estos desafíos significan que simplemente maximizar el tamaño de la ventana de contexto no siempre es la solución óptima para todos los casos de uso.

Comprender la degradación del contexto es esencial para trabajar eficazmente con ventanas de contexto grandes: a medida que las secuencias se alargan, los tokens al inicio del contexto tienden a tener una influencia decreciente en la salida del modelo, lo que significa que información crítica puede ser efectivamente “olvidada” aunque técnicamente esté dentro de la ventana. Esto sucede porque el presupuesto de atención—la capacidad del modelo para atender significativamente a todos los tokens—se dispersa en un tramo mayor de texto. Por suerte, han surgido varias técnicas sofisticadas para abordar estas limitaciones. La Generación Aumentada por Recuperación (RAG) lo soluciona almacenando información en bases de datos externas y recuperando solo las partes más relevantes cuando se necesitan, proporcionando al modelo una base de conocimiento más grande sin requerir una ventana de contexto masiva. Las técnicas de compresión de contexto resumen o comprimen información menos relevante, preservando los detalles más importantes y reduciendo el uso de tokens. Los enfoques de toma de notas estructurada animan a los usuarios a organizar la información jerárquicamente, facilitando al modelo priorizar y localizar conceptos clave. Estas soluciones funcionan siendo estratégicos sobre qué información entra en la ventana de contexto y cómo se organiza, en lugar de intentar abarcarlo todo en la memoria a la vez.

Las ventanas de contexto ampliadas de los modelos de IA modernos han desbloqueado numerosas aplicaciones reales que antes eran poco prácticas o imposibles. Los sistemas de atención al cliente ahora pueden revisar todo el historial de un ticket y documentación relacionada en una sola solicitud, permitiendo respuestas más precisas y apropiadas sin que los clientes tengan que volver a explicar su situación. El análisis y la investigación de documentos han sido transformados por modelos capaces de ingerir artículos científicos completos, contratos legales o especificaciones técnicas, identificando información clave y respondiendo preguntas detalladas sobre contenido que a los humanos les llevaría horas revisar. La revisión de código y desarrollo de software se beneficia de ventanas suficientemente grandes para contener archivos enteros o incluso varios archivos relacionados, permitiendo a la IA entender patrones arquitectónicos y proporcionar sugerencias más inteligentes. La creación de contenido extenso y los flujos de trabajo de escritura iterativa son más eficientes cuando el modelo mantiene conciencia de todo el tono, estilo y arco narrativo de un documento durante el proceso de edición. El análisis de transcripciones de reuniones y la síntesis de investigación aprovechan las grandes ventanas de contexto para extraer perspectivas de horas de conversación o docenas de documentos fuente, identificando temas y conexiones difíciles de detectar manualmente. Estas aplicaciones demuestran que el tamaño de la ventana de contexto se traduce directamente en valor práctico para profesionales de todas las industrias.

La trayectoria del desarrollo de ventanas de contexto sugiere que avanzamos hacia expansiones aún más drásticas en el corto plazo, con Gemini 1.5 Pro ya demostrando una ventana de contexto de 1,000,000 tokens y laboratorios de investigación explorando capacidades aún mayores. Más allá del tamaño bruto, el futuro probablemente involucrará ventanas de contexto dinámicas que ajusten inteligentemente su tamaño según la tarea, asignando más capacidad cuando sea necesario y reduciéndola para consultas más simples para mejorar la eficiencia y reducir costos. Los investigadores también están logrando avances en mecanismos de atención más eficientes que reducen la penalización computacional de ventanas grandes, potencialmente superando la barrera de escalado cuadrático que actualmente limita el tamaño de contexto. A medida que estas tecnologías maduren, es probable que las ventanas de contexto dejen de ser una limitación y se conviertan en un problema resuelto, permitiendo que los desarrolladores se concentren en otros aspectos de la capacidad y confiabilidad de la IA. La convergencia de ventanas más grandes, mayor eficiencia y una gestión de contexto más inteligente probablemente definirá la próxima generación de aplicaciones de IA, permitiendo casos de uso que aún no hemos imaginado.

Una ventana de contexto es la cantidad total de texto (medido en tokens) que un modelo de IA puede procesar a la vez, mientras que el límite de tokens se refiere al número máximo de tokens que el modelo puede manejar. Estos términos suelen usarse de manera intercambiable, pero la ventana de contexto se refiere específicamente a la memoria de trabajo disponible durante una sola inferencia, mientras que el límite de tokens también puede referirse a restricciones de salida o uso de API.

Ventanas de contexto más grandes generalmente mejoran la calidad de las respuestas al permitir que el modelo considere más información relevante y mantenga una mejor continuidad en la conversación. Sin embargo, ventanas extremadamente grandes a veces pueden perjudicar la calidad debido a la degradación del contexto, donde el modelo tiene dificultades para priorizar información importante entre grandes cantidades de texto. El tamaño óptimo de la ventana de contexto depende de la tarea específica y de cómo esté organizada la información.

Las ventanas de contexto más grandes requieren mayor poder computacional debido al escalado cuadrático del mecanismo de atención en los modelos transformadores. El mecanismo de atención debe calcular las relaciones entre cada token y todos los demás, por lo que duplicar la ventana de contexto aproximadamente cuadruplica los requerimientos computacionales. Por esto, las ventanas de contexto grandes son más caras de ejecutar y producen tiempos de respuesta más lentos.

El problema de 'aguja en un pajar' ocurre cuando un modelo de IA tiene dificultades para localizar y utilizar información relevante (la 'aguja') cuando está enterrada dentro de una ventana de contexto muy grande (el 'pajar'). Los modelos a veces funcionan peor con ventanas de contexto extremadamente grandes porque el mecanismo de atención se diluye entre tanta información, dificultando identificar lo que realmente es importante.

Para maximizar la efectividad de la ventana de contexto, organiza la información de manera clara y jerárquica, coloca la información más importante cerca del inicio o final del contexto, usa formatos estructurados como JSON o markdown, y considera utilizar Generación Aumentada por Recuperación (RAG) para cargar dinámicamente solo la información más relevante. Evita sobrecargar el modelo con detalles irrelevantes que consumen tokens sin aportar valor.

La ventana de contexto es la capacidad técnica del modelo para procesar texto en un momento dado, mientras que el historial de conversación es el registro real de los mensajes previos en una conversación. El historial de la conversación debe caber dentro de la ventana de contexto, pero la ventana de contexto también incluye espacio para prompts del sistema, instrucciones y otros metadatos. Un historial de conversación puede ser más largo que la ventana de contexto, requiriendo resumen o recorte.

Actualmente no existen modelos de IA con ventanas de contexto realmente ilimitadas, ya que todos los modelos tienen limitaciones arquitectónicas y computacionales. Sin embargo, algunos modelos como Gemini 1.5 Pro ofrecen ventanas extremadamente grandes (1,000,000 tokens), y técnicas como Generación Aumentada por Recuperación (RAG) pueden ampliar efectivamente la base de conocimiento del modelo más allá de su ventana de contexto recuperando información de manera dinámica según sea necesario.

El tamaño de la ventana de contexto afecta directamente los costos de API porque ventanas más grandes requieren más recursos computacionales para procesarse. La mayoría de los proveedores de API de IA cobran según el uso de tokens, por lo que usar una ventana de contexto mayor significa más tokens procesados y costos más altos. Algunos proveedores también cobran tarifas premium por modelos con ventanas de contexto más grandes, por lo que es importante elegir el tamaño adecuado de modelo para tus necesidades específicas.

AmICited rastrea cómo sistemas de IA como ChatGPT, Perplexity y Google AI Overviews citan y hacen referencia a tu contenido. Comprende tu visibilidad en IA y monitorea las menciones de tu marca en plataformas de IA.

Ventana de contexto explicada: los tokens máximos que un LLM puede procesar a la vez. Descubre cómo las ventanas de contexto afectan la precisión de la IA, aluc...

Descubre qué son las ventanas de contexto en los modelos de lenguaje de IA, cómo funcionan, su impacto en el rendimiento del modelo y por qué son importantes pa...

Discusión comunitaria sobre las ventanas de contexto de IA y sus implicaciones para el marketing de contenidos. Comprender cómo los límites de contexto afectan ...