Presupuesto de rastreo

El presupuesto de rastreo es la cantidad de páginas que los motores de búsqueda rastrean en tu sitio web dentro de un periodo de tiempo. Aprende cómo optimizar ...

Técnicas para garantizar que los rastreadores de IA accedan e indexen de manera eficiente el contenido más importante de un sitio web dentro de sus límites de rastreo. La optimización del presupuesto de rastreo gestiona el equilibrio entre la capacidad de rastreo (recursos del servidor) y la demanda de rastreo (solicitudes de bots) para maximizar la visibilidad en respuestas generadas por IA mientras se controlan los costes operativos y la carga del servidor.

Técnicas para garantizar que los rastreadores de IA accedan e indexen de manera eficiente el contenido más importante de un sitio web dentro de sus límites de rastreo. La optimización del presupuesto de rastreo gestiona el equilibrio entre la capacidad de rastreo (recursos del servidor) y la demanda de rastreo (solicitudes de bots) para maximizar la visibilidad en respuestas generadas por IA mientras se controlan los costes operativos y la carga del servidor.

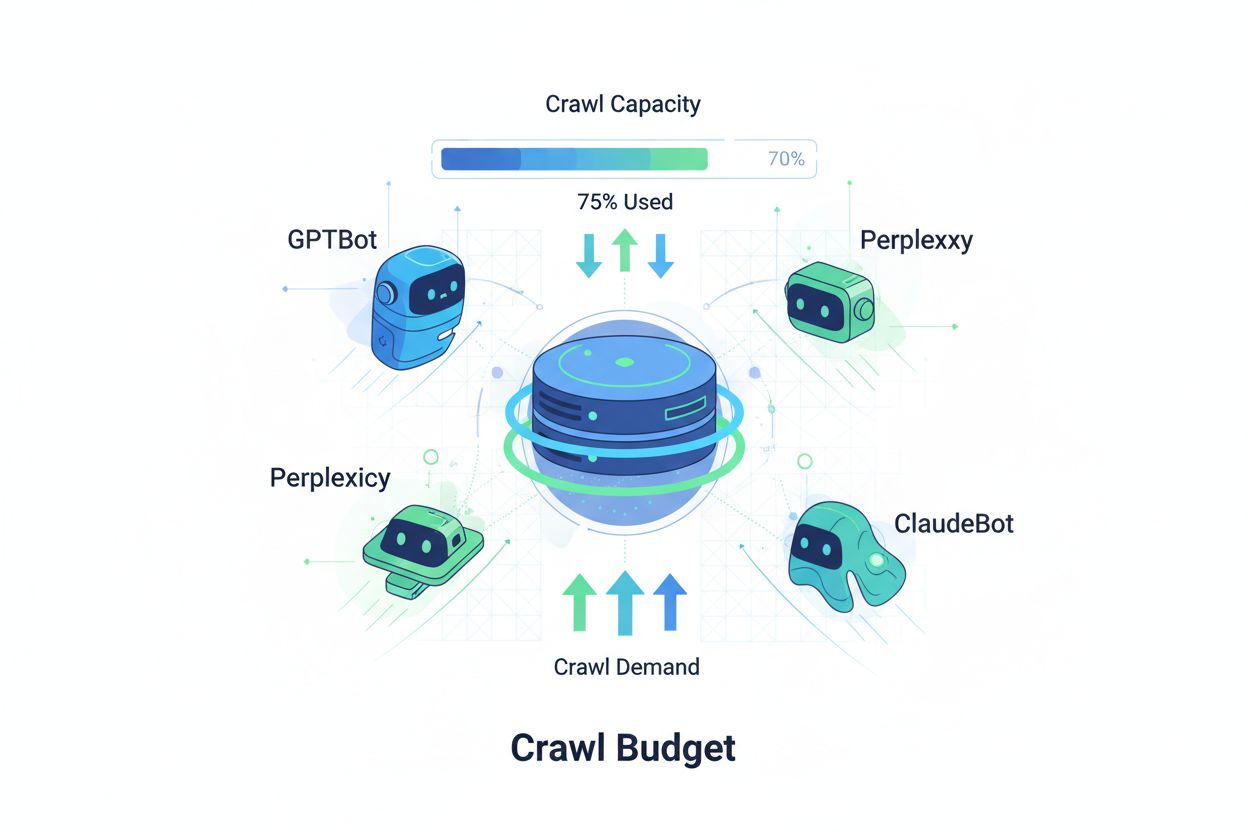

El presupuesto de rastreo se refiere a la cantidad de recursos—medidos en solicitudes y ancho de banda—que los motores de búsqueda y los bots de IA asignan para rastrear tu sitio web. Tradicionalmente, este concepto se aplicaba principalmente al comportamiento de rastreo de Google, pero la aparición de bots impulsados por IA ha transformado fundamentalmente la manera en que las organizaciones deben pensar sobre la gestión del presupuesto de rastreo. La ecuación del presupuesto de rastreo consta de dos variables críticas: capacidad de rastreo (el número máximo de páginas que un bot puede rastrear) y demanda de rastreo (el número real de páginas que el bot quiere rastrear). En la era de la IA, esta dinámica se ha vuelto exponencialmente más compleja, ya que bots como GPTBot (OpenAI), Perplexity Bot y ClaudeBot (Anthropic) ahora compiten por los recursos del servidor junto con los rastreadores tradicionales de motores de búsqueda. Estos bots de IA operan con prioridades y patrones diferentes a Googlebot, a menudo consumiendo significativamente más ancho de banda mientras persiguen objetivos de indexación distintos, haciendo que la optimización del presupuesto de rastreo ya no sea opcional sino esencial para mantener el rendimiento del sitio y controlar los costes operativos.

Los rastreadores de IA se diferencian fundamentalmente de los bots tradicionales de motores de búsqueda en sus patrones de rastreo, frecuencia y consumo de recursos. Mientras que Googlebot respeta los límites del presupuesto de rastreo e implementa mecanismos sofisticados de limitación, los bots de IA suelen mostrar comportamientos de rastreo más agresivos, a veces solicitando el mismo contenido varias veces y mostrando menos deferencia hacia las señales de carga del servidor. Las investigaciones indican que GPTBot de OpenAI puede consumir entre 12 y 15 veces más ancho de banda que el rastreador de Google en ciertos sitios web, especialmente en aquellos con grandes bibliotecas de contenido o páginas actualizadas frecuentemente. Este enfoque agresivo proviene de los requisitos de entrenamiento de IA: estos bots necesitan ingerir continuamente contenido nuevo para mejorar el rendimiento del modelo, creando una filosofía de rastreo fundamentalmente diferente a la de los motores de búsqueda enfocados en la indexación para recuperación. El impacto en el servidor es sustancial: las organizaciones reportan aumentos significativos en los costes de ancho de banda, utilización de CPU y carga del servidor atribuibles directamente al tráfico de bots de IA. Además, el efecto acumulativo de varios bots de IA rastreando simultáneamente puede degradar la experiencia del usuario, ralentizar los tiempos de carga de la página y aumentar los gastos de alojamiento, haciendo que la distinción entre rastreadores tradicionales y de IA sea una consideración de negocio crítica y no solo una curiosidad técnica.

| Característica | Rastreadores tradicionales (Googlebot) | Rastreadores de IA (GPTBot, ClaudeBot) |

|---|---|---|

| Frecuencia de rastreo | Adaptativa, respeta el presupuesto | Agresiva, continua |

| Consumo de ancho de banda | Moderado, optimizado | Alto, intensivo en recursos |

| Respeto por Robots.txt | Cumplimiento estricto | Cumplimiento variable |

| Comportamiento de caché | Caché sofisticada | Solicitudes frecuentes repetidas |

| Identificación User-Agent | Clara, consistente | A veces ofuscada |

| Meta empresarial | Indexación de búsqueda | Entrenamiento de modelos/adquisición de datos |

| Impacto en costes | Mínimo | Significativo (12-15x mayor) |

Comprender el presupuesto de rastreo requiere dominar sus dos componentes fundamentales: capacidad de rastreo y demanda de rastreo. La capacidad de rastreo representa el número máximo de URLs que tu servidor puede manejar siendo rastreadas en un periodo determinado, determinado por varios factores interconectados. Esta capacidad está influenciada por:

La demanda de rastreo, por el contrario, representa cuántas páginas los bots realmente quieren rastrear, impulsada por las características del contenido y las prioridades del bot. Los factores que afectan la demanda de rastreo incluyen:

El reto de la optimización surge cuando la demanda de rastreo excede la capacidad de rastreo: los bots deben elegir qué páginas rastrear, pudiendo dejar sin actualizar contenido importante. Por el contrario, cuando la capacidad de rastreo supera con creces la demanda, se están desperdiciando recursos del servidor. El objetivo es lograr eficiencia de rastreo: maximizar el rastreo de páginas importantes minimizando los rastreos desperdiciados en contenido de bajo valor. Este equilibrio se vuelve cada vez más complejo en la era de la IA, donde múltiples tipos de bots con diferentes prioridades compiten por los mismos recursos del servidor, requiriendo estrategias sofisticadas para asignar el presupuesto de rastreo de manera efectiva entre todos los interesados.

La medición del rendimiento del presupuesto de rastreo comienza con Google Search Console, que proporciona estadísticas de rastreo en la sección “Configuración”, mostrando solicitudes de rastreo diarias, bytes descargados y tiempos de respuesta. Para calcular tu ratio de eficiencia de rastreo, divide el número de rastreos exitosos (respuestas HTTP 200) entre el total de solicitudes de rastreo, siendo lo habitual en sitios saludables lograr una eficiencia del 85-95%. La fórmula para la eficiencia básica de rastreo es: (Rastreo exitoso ÷ Total de solicitudes de rastreo) × 100 = % de eficiencia de rastreo. Más allá de los datos de Google, un monitoreo práctico requiere:

Para el monitoreo específico de rastreadores de IA, herramientas como AmICited.com ofrecen seguimiento especializado de la actividad de GPTBot, ClaudeBot y Perplexity Bot, brindando información sobre qué páginas priorizan estos bots y con qué frecuencia regresan. Además, la implementación de alertas personalizadas para picos inusuales de rastreo—particularmente de bots de IA—permite responder rápidamente a consumos inesperados de recursos. La métrica clave a rastrear es el coste de rastreo por página: dividir el total de recursos del servidor consumidos por rastreos entre el número de páginas únicas rastreadas revela si estás utilizando eficientemente tu presupuesto de rastreo o desperdiciando recursos en páginas de bajo valor.

Optimizar el presupuesto de rastreo para bots de IA requiere un enfoque multinivel que combine la implementación técnica con la toma de decisiones estratégica. Las tácticas principales de optimización incluyen:

La decisión estratégica sobre qué táctica emplear depende de tu modelo de negocio y estrategia de contenido. Los sitios de comercio electrónico pueden bloquear rastreadores de IA en páginas de productos para evitar la adquisición de datos de entrenamiento por parte de la competencia, mientras que los editores de contenido pueden permitir el rastreo para ganar visibilidad en respuestas generadas por IA. Para sitios que experimentan una verdadera sobrecarga del servidor por tráfico de bots de IA, implementar bloqueo específico por user-agent en robots.txt es la solución más directa: User-agent: GPTBot seguido de Disallow: / impide que el rastreador de OpenAI acceda a tu sitio por completo. Sin embargo, este enfoque sacrifica la visibilidad potencial en respuestas de ChatGPT y otras aplicaciones de IA. Una estrategia más matizada implica bloqueo selectivo: permitir el acceso de rastreadores de IA al contenido público mientras se bloquea el acceso a áreas sensibles, archivos o contenido duplicado que desperdicia presupuesto de rastreo sin aportar valor ni al bot ni a tus usuarios.

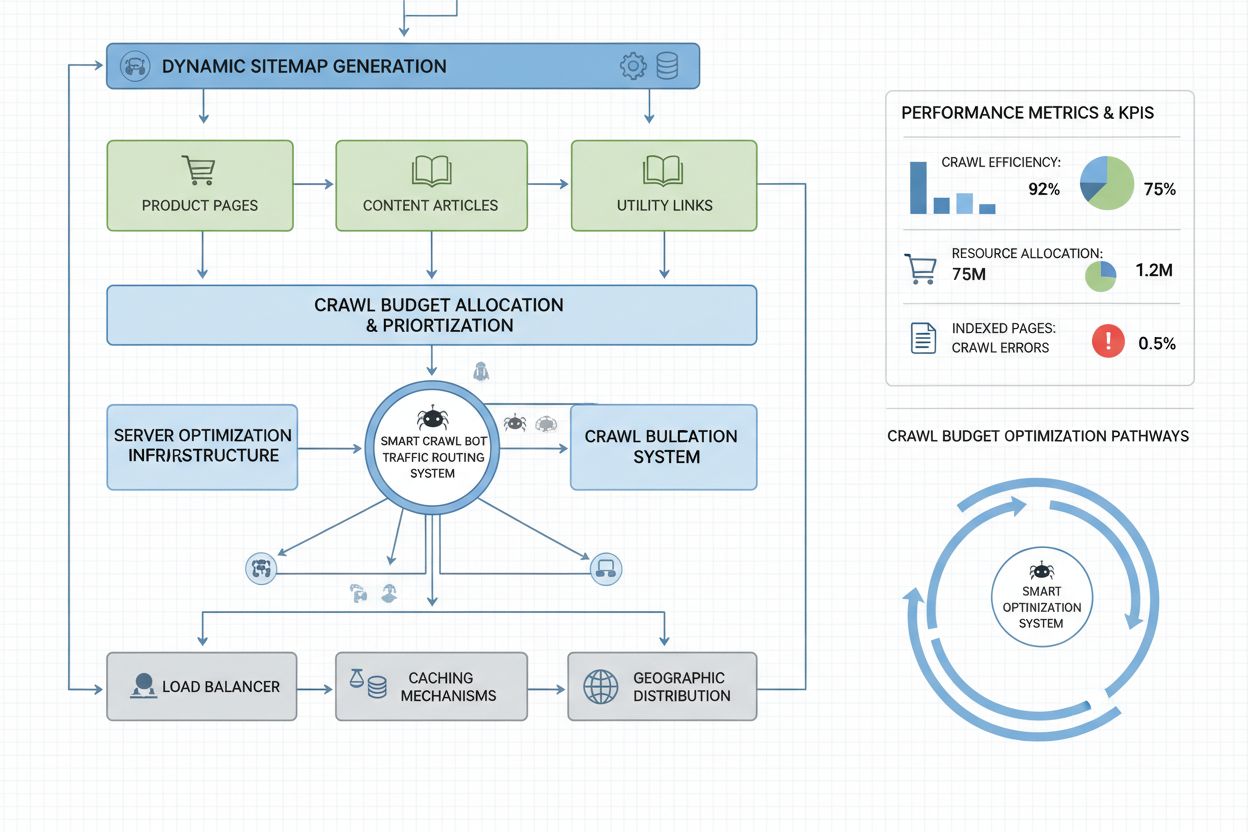

Los sitios web a escala empresarial con millones de páginas requieren estrategias sofisticadas de optimización del presupuesto de rastreo más allá de la configuración básica de robots.txt. Los sitemaps dinámicos representan un avance crítico, donde los sitemaps se generan en tiempo real basados en la frescura del contenido, puntuaciones de importancia e historial de rastreo. En lugar de sitemaps XML estáticos que enumeran todas las páginas, los sitemaps dinámicos priorizan páginas recientemente actualizadas, de alto tráfico y con potencial de conversión, asegurando que los bots enfoquen el presupuesto de rastreo en el contenido que más importa. La segmentación de URL divide tu sitio en zonas lógicas de rastreo, cada una con estrategias de optimización adaptadas: las secciones de noticias pueden usar actualizaciones agresivas de sitemap para asegurar que el contenido diario sea rastreado inmediatamente, mientras que el contenido evergreen utiliza actualizaciones menos frecuentes.

Los enfoques de optimización del lado del servidor incluyen la implementación de estrategias de caché conscientes del rastreo que sirvan respuestas en caché a los bots mientras ofrecen contenido fresco a los usuarios, reduciendo la carga del servidor por solicitudes repetidas de bots. Las redes de entrega de contenido (CDN) con enrutamiento específico para bots pueden aislar el tráfico de bots del tráfico de usuarios, evitando que los rastreadores consuman el ancho de banda necesario para los visitantes reales. La limitación de tasa por user-agent permite a los servidores limitar las solicitudes de bots de IA mientras mantienen velocidades normales para Googlebot y tráfico de usuarios. Para operaciones realmente a gran escala, la gestión distribuida del presupuesto de rastreo a través de múltiples regiones de servidores asegura que no haya un solo punto de fallo y permite balancear la carga de tráfico de bots geográficamente. La predicción de rastreo basada en machine learning analiza patrones históricos de rastreo para pronosticar qué páginas solicitarán los bots a continuación, permitiendo la optimización proactiva del rendimiento y la caché de esas páginas. Estas estrategias a nivel empresarial transforman el presupuesto de rastreo de una limitación en un recurso gestionado, permitiendo a grandes organizaciones servir miles de millones de páginas manteniendo un rendimiento óptimo tanto para bots como para usuarios humanos.

La decisión de bloquear o permitir rastreadores de IA representa una elección estratégica empresarial fundamental con importantes implicaciones para la visibilidad, el posicionamiento competitivo y los costes operativos. Permitir rastreadores de IA ofrece beneficios sustanciales: tu contenido puede ser incluido en respuestas generadas por IA, lo que potencialmente genera tráfico desde ChatGPT, Claude, Perplexity y otras aplicaciones de IA; tu marca gana visibilidad en un nuevo canal de distribución; y te beneficias de las señales SEO al ser citado por sistemas de IA. Sin embargo, estos beneficios vienen acompañados de costes: mayor carga y consumo de ancho de banda del servidor, posible entrenamiento de modelos de IA de la competencia usando tu contenido propietario y pérdida de control sobre cómo se presenta y atribuye tu información en las respuestas de IA.

Bloquear rastreadores de IA elimina estos costes pero sacrifica los beneficios de visibilidad y, potencialmente, cede cuota de mercado a competidores que sí permiten el rastreo. La estrategia óptima depende de tu modelo de negocio: editores de contenido y organizaciones de noticias suelen beneficiarse al permitir el rastreo para ganar distribución a través de resúmenes de IA; empresas SaaS y sitios de comercio electrónico pueden bloquear los rastreadores para evitar que sus datos de productos entrenen modelos de la competencia; instituciones educativas y organizaciones de investigación normalmente permiten el rastreo para maximizar la difusión del conocimiento. Un enfoque híbrido ofrece un término medio: permitir el rastreo del contenido público mientras se bloquea el acceso a áreas sensibles, contenido generado por usuarios o información propietaria. Esta estrategia maximiza los beneficios de visibilidad mientras protege activos valiosos. Además, el monitoreo con AmICited.com y herramientas similares revela si tu contenido realmente está siendo citado por sistemas de IA; si tu sitio no aparece en respuestas de IA a pesar de permitir el rastreo, el bloqueo se vuelve una opción más atractiva, ya que estás asumiendo el coste de rastreo sin recibir beneficios de visibilidad.

La gestión efectiva del presupuesto de rastreo requiere herramientas especializadas que brinden visibilidad sobre el comportamiento de los bots y permitan decisiones de optimización basadas en datos. Conductor y Sitebulb ofrecen análisis de rastreo a nivel empresarial, simulando cómo los motores de búsqueda rastrean tu sitio e identificando ineficiencias, rastreos desperdiciados en páginas de error y oportunidades para mejorar la asignación del presupuesto de rastreo. Cloudflare proporciona gestión de bots a nivel de red, permitiendo un control granular sobre qué bots pueden acceder a tu sitio e implementando limitación de tasa específica para rastreadores de IA. Para el monitoreo específico de bots de IA, AmICited.com destaca como la solución más completa, rastreando GPTBot, ClaudeBot, Perplexity Bot y otros rastreadores de IA con análisis detallados que muestran qué páginas acceden estos bots, con qué frecuencia regresan y si tu contenido aparece en respuestas generadas por IA.

El análisis de logs de servidor sigue siendo fundamental para la optimización del presupuesto de rastreo: herramientas como Splunk, Datadog o ELK Stack de código abierto permiten analizar registros de acceso brutos y segmentar el tráfico por user-agent, identificando qué bots consumen más recursos y qué páginas atraen más rastreos. Los paneles personalizados que siguen tendencias de rastreo en el tiempo revelan si los esfuerzos de optimización están funcionando y si están surgiendo nuevos tipos de bots. Google Search Console sigue proporcionando datos esenciales sobre el comportamiento de rastreo de Google, mientras que Bing Webmaster Tools ofrece información similar para el rastreador de Microsoft. Las organizaciones más sofisticadas implementan estrategias de monitoreo con varias herramientas combinando Google Search Console para datos tradicionales de rastreo, AmICited.com para el seguimiento de bots de IA, análisis de logs de servidor para una visibilidad completa de bots y herramientas especializadas como Conductor para simulación y análisis de eficiencia de rastreo. Este enfoque por capas brinda visibilidad total sobre cómo interactúan todos los tipos de bots con tu sitio, permitiendo decisiones de optimización basadas en datos completos en lugar de suposiciones. El monitoreo regular—idealmente revisiones semanales de métricas de rastreo—permite identificar rápidamente problemas como picos inesperados de rastreo, aumento de tasas de error o nuevos bots agresivos, permitiendo una respuesta rápida antes de que los problemas de presupuesto de rastreo afecten el rendimiento del sitio o los costes operativos.

Los bots de IA como GPTBot y ClaudeBot operan con prioridades diferentes a las de Googlebot. Mientras que Googlebot respeta los límites del presupuesto de rastreo e implementa una limitación sofisticada, los bots de IA suelen mostrar patrones de rastreo más agresivos, consumiendo entre 12 y 15 veces más ancho de banda. Los bots de IA priorizan la ingesta continua de contenido para el entrenamiento de modelos en lugar de la indexación para búsqueda, haciendo que su comportamiento de rastreo sea fundamentalmente diferente y requiera estrategias de optimización distintas.

Las investigaciones indican que GPTBot de OpenAI puede consumir entre 12 y 15 veces más ancho de banda que el rastreador de Google en ciertos sitios web, especialmente aquellos con grandes bibliotecas de contenido. El consumo exacto depende del tamaño de tu sitio, la frecuencia de actualización del contenido y cuántos bots de IA están rastreando simultáneamente. Varios bots de IA rastreando al mismo tiempo pueden aumentar significativamente la carga del servidor y los costes de alojamiento.

Sí, puedes bloquear rastreadores de IA específicos usando robots.txt sin afectar el SEO tradicional. Sin embargo, bloquear rastreadores de IA significa sacrificar visibilidad en respuestas generadas por IA de ChatGPT, Claude, Perplexity y otras aplicaciones de IA. La decisión depende de tu modelo de negocio: los editores de contenido suelen beneficiarse de permitir el rastreo, mientras que los sitios de comercio electrónico pueden bloquear para evitar el entrenamiento de la competencia.

Una mala gestión del presupuesto de rastreo puede provocar que páginas importantes no sean rastreadas o indexadas, una indexación más lenta de contenido nuevo, mayor carga y coste de ancho de banda del servidor, degradación de la experiencia de usuario por tráfico de bots consumiendo recursos y oportunidades de visibilidad perdidas tanto en la búsqueda tradicional como en respuestas generadas por IA. Los sitios grandes con millones de páginas son los más vulnerables a estos impactos.

Para obtener resultados óptimos, monitorea las métricas del presupuesto de rastreo semanalmente, con revisiones diarias durante grandes lanzamientos de contenido o al experimentar picos inesperados de tráfico. Utiliza Google Search Console para datos tradicionales de rastreo, AmICited.com para seguimiento de rastreadores de IA y los registros del servidor para una visibilidad completa de bots. El monitoreo regular permite identificar rápidamente problemas antes de que afecten el rendimiento del sitio.

Robots.txt tiene una efectividad variable con los bots de IA. Mientras que Googlebot respeta estrictamente las directivas de robots.txt, los bots de IA muestran cumplimiento inconsistente: algunos respetan las reglas mientras que otros las ignoran. Para un control más fiable, implementa bloqueos específicos por user-agent, limitación de tasa a nivel de servidor o utiliza herramientas de gestión de bots basadas en CDN como Cloudflare para un control más granular.

El presupuesto de rastreo impacta directamente en la visibilidad en IA porque los bots de IA no pueden citar o referenciar contenido que no han rastreado. Si tus páginas importantes no son rastreadas debido a limitaciones de presupuesto, no aparecerán en respuestas generadas por IA. Optimizar el presupuesto de rastreo asegura que tu mejor contenido sea descubierto por los bots de IA, aumentando las posibilidades de ser citado en respuestas de ChatGPT, Claude y Perplexity.

Prioriza las páginas utilizando sitemaps dinámicos que destaquen el contenido actualizado recientemente, las páginas de alto tráfico y aquellas con potencial de conversión. Usa robots.txt para bloquear páginas de bajo valor como archivos y duplicados. Implementa estructuras limpias de URL y enlaces internos estratégicos para guiar a los bots hacia el contenido importante. Monitorea qué páginas rastrean realmente los bots de IA usando herramientas como AmICited.com para refinar tu estrategia.

Sigue cómo los bots de IA rastrean tu sitio y optimiza tu visibilidad en respuestas generadas por IA con la plataforma integral de monitoreo de rastreadores de IA de AmICited.com.

El presupuesto de rastreo es la cantidad de páginas que los motores de búsqueda rastrean en tu sitio web dentro de un periodo de tiempo. Aprende cómo optimizar ...

Descubre qué significa el crawl budget para la IA, cómo difiere del crawl budget tradicional de los buscadores y por qué es importante para la visibilidad de tu...

La frecuencia de rastreo es la periodicidad con la que los motores de búsqueda y rastreadores de IA visitan tu sitio. Aprende qué afecta las tasas de rastreo, p...