Tarjeta de Referencia de Rastreadores de IA: Todos los Bots de un Vistazo

Guía de referencia completa de rastreadores y bots de IA. Identifica GPTBot, ClaudeBot, Google-Extended y más de 20 rastreadores de IA con user agents, tasas de...

Un enfoque estratégico que permite a los propietarios de sitios web permitir selectivamente ciertos rastreadores de IA mientras bloquean a otros según los objetivos comerciales, acuerdos de licenciamiento de contenido y evaluación de valor. En lugar de implementar políticas generales, el acceso diferencial evalúa cada rastreador individualmente para determinar si genera tráfico, respeta los términos de licenciamiento o se alinea con los objetivos de monetización. Los editores utilizan herramientas como robots.txt, cabeceras HTTP y controles específicos de la plataforma para implementar políticas de acceso granulares. Este método equilibra las oportunidades de innovación con la protección del contenido y una compensación justa.

Un enfoque estratégico que permite a los propietarios de sitios web permitir selectivamente ciertos rastreadores de IA mientras bloquean a otros según los objetivos comerciales, acuerdos de licenciamiento de contenido y evaluación de valor. En lugar de implementar políticas generales, el acceso diferencial evalúa cada rastreador individualmente para determinar si genera tráfico, respeta los términos de licenciamiento o se alinea con los objetivos de monetización. Los editores utilizan herramientas como robots.txt, cabeceras HTTP y controles específicos de la plataforma para implementar políticas de acceso granulares. Este método equilibra las oportunidades de innovación con la protección del contenido y una compensación justa.

La explosión de rastreadores de IA ha alterado fundamentalmente la relación de décadas entre los propietarios de sitios web y los bots. Durante años, Internet funcionaba con un intercambio simple: motores de búsqueda como Google indexaban contenido y dirigían tráfico de vuelta a las fuentes originales, creando una relación simbiótica que recompensaba la creación de contenido de calidad. Hoy, una nueva generación de rastreadores de IA—incluyendo GPTBot, ClaudeBot, PerplexityBot y docenas más—opera bajo reglas diferentes. Estos bots extraen contenido no para indexarlo y facilitar su descubrimiento, sino para alimentarlo directamente a modelos de IA que generan respuestas sin enviar usuarios de vuelta a la fuente original. El impacto es contundente: según datos de Cloudflare, GPTBot de OpenAI mantiene una proporción de rastreo a referencia de aproximadamente 1,700:1, mientras que ClaudeBot de Anthropic alcanza 73,000:1, lo que significa que por cada visitante que regresa al sitio de un editor, miles de páginas se rastrean para datos de entrenamiento. Este intercambio roto ha obligado a los editores a reconsiderar sus políticas de acceso de rastreadores, alejándose de la elección binaria de “permitir todo” o “bloquear todo” hacia una estrategia más matizada: acceso diferencial de rastreadores. En vez de implementar políticas generales, los editores inteligentes ahora evalúan cada rastreador individualmente, haciéndose preguntas críticas sobre valor, licenciamiento y alineación con los objetivos de negocio.

Comprender los diferentes tipos de rastreadores de IA es esencial para implementar una estrategia de acceso diferencial eficaz, ya que cada uno cumple propósitos distintos con impactos variados en tu negocio. Los rastreadores de IA se dividen en tres categorías principales: rastreadores de entrenamiento (GPTBot, ClaudeBot, anthropic-ai, CCBot, Bytespider) que recopilan contenido para entrenar modelos; rastreadores de búsqueda (OAI-SearchBot, PerplexityBot, Google-Extended) que indexan contenido para resultados de búsqueda potenciados por IA; y agentes activados por el usuario (ChatGPT-User, Claude-Web, Perplexity-User) que obtienen contenido solo cuando los usuarios lo solicitan explícitamente. La propuesta de valor varía drásticamente entre estas categorías. Los rastreadores de entrenamiento normalmente generan un tráfico mínimo de regreso a tu sitio—extraen valor sin beneficio recíproco—por lo que son candidatos ideales para bloquearse. Los rastreadores de búsqueda, en cambio, pueden generar un tráfico referencial significativo y conversiones de suscriptores, similar a los motores de búsqueda tradicionales. Los agentes activados por el usuario ocupan un punto intermedio, activándose solo cuando los usuarios interactúan activamente con sistemas de IA. The Atlantic, uno de los mayores editores digitales, implementó un sofisticado enfoque de puntuación para evaluar rastreadores, rastreando tanto el volumen de tráfico como las conversiones de suscriptores para cada bot. Su análisis reveló que, mientras algunos rastreadores generan valor significativo, otros no generan prácticamente ningún tráfico mientras consumen un ancho de banda considerable. Este enfoque basado en datos permite a los editores tomar decisiones informadas en lugar de basarse en suposiciones.

| Tipo de Rastreador | Ejemplos | Propósito Principal | Valor Típico de Tráfico | Acceso Recomendado |

|---|---|---|---|---|

| Entrenamiento | GPTBot, ClaudeBot, anthropic-ai, CCBot, Bytespider | Conjuntos de datos de entrenamiento de modelos | Muy bajo (proporción de 1,700:1 a 73,000:1) | A menudo bloqueado |

| Búsqueda | OAI-SearchBot, PerplexityBot, Google-Extended | Indexación de búsqueda de IA | Medio a alto | A menudo permitido |

| Activado por Usuario | ChatGPT-User, Claude-Web, Perplexity-User | Solicitudes directas de usuario | Variable | Caso por caso |

Implementar acceso diferencial de rastreadores requiere una combinación de herramientas técnicas y toma de decisiones estratégicas, con múltiples métodos disponibles según tus capacidades técnicas y necesidades empresariales. La herramienta más fundamental es robots.txt, un archivo de texto simple en el directorio raíz del sitio web que comunica preferencias de acceso usando directivas User-agent. Aunque robots.txt es voluntario y solo el 40-60% de los bots de IA lo respetan, sigue siendo la primera línea de defensa y no cuesta nada implementarlo. Para los editores que buscan una aplicación más fuerte, robots.txt gestionado de Cloudflare crea y actualiza automáticamente directivas para rastreadores, anteponiéndolas a tu archivo existente y eliminando la necesidad de mantenimiento manual. Más allá de robots.txt, varios mecanismos de aplicación brindan control adicional:

El enfoque más eficaz combina múltiples capas: robots.txt para rastreadores cumplidores, reglas WAF para la aplicación y herramientas de monitoreo para rastrear la efectividad e identificar nuevas amenazas.

Implementar acceso diferencial de rastreadores requiere ir más allá de la implementación técnica para desarrollar una estrategia empresarial coherente alineada con tu modelo de ingresos y posicionamiento competitivo. El enfoque de The Atlantic ofrece un marco práctico: evalúan cada rastreador según dos métricas principales—volumen de tráfico y conversiones de suscriptores—preguntando si el rastreador genera suficiente valor como para justificar el acceso al contenido. Para un editor con un valor anual por suscriptor de $80, un rastreador que genera 1,000 suscriptores representa $80,000 en ingresos anuales, cambiando fundamentalmente la decisión de acceso. Sin embargo, las métricas de tráfico y suscriptores representan solo una parte de la ecuación. Los editores también deben considerar:

Los editores más estratégicos implementan políticas de acceso por niveles: permiten rastreadores de búsqueda que generan tráfico, bloquean rastreadores de entrenamiento que no lo hacen y negocian acuerdos de licenciamiento con empresas de IA de alto valor. Este enfoque maximiza tanto la visibilidad como los ingresos mientras protege la propiedad intelectual.

Aunque el acceso diferencial de rastreadores ofrece ventajas significativas, la realidad es más compleja que la teoría, con varios desafíos fundamentales que limitan su efectividad y requieren gestión continua. La limitación más crítica es que robots.txt es voluntario—los rastreadores que lo respetan lo hacen por elección, no por obligación. Las investigaciones indican que robots.txt solo detiene al 40-60% de los bots de IA, otro 30-40% se bloquea por agente de usuario, dejando un 10-30% de rastreadores operando sin restricciones. Algunas empresas de IA y actores maliciosos ignoran deliberadamente las directivas de robots.txt, considerando el acceso al contenido más valioso que el cumplimiento. Además, las técnicas de evasión de rastreadores siguen evolucionando: los bots sofisticados suplantan agentes de usuario para parecer navegadores legítimos, usan direcciones IP distribuidas para evitar la detección y emplean navegadores sin interfaz que imitan el comportamiento humano. El dilema de Google-Extended ejemplifica la complejidad: bloquear Google-Extended evita que tu contenido entrene Gemini AI, pero Google AI Overviews (que aparecen en resultados de búsqueda) usan las reglas estándar de Googlebot, lo que significa que no puedes excluirte de AI Overviews sin sacrificar visibilidad en búsquedas. El monitoreo y la aplicación también requieren recursos significativos—rastrear nuevos rastreadores, actualizar políticas y validar la efectividad exige atención continua. Finalmente, el panorama legal sigue siendo incierto: aunque la ley de derechos de autor teóricamente protege el contenido, la aplicación contra empresas de IA es costosa y los resultados impredecibles, dejando a los editores en una posición de control técnico sin certeza legal.

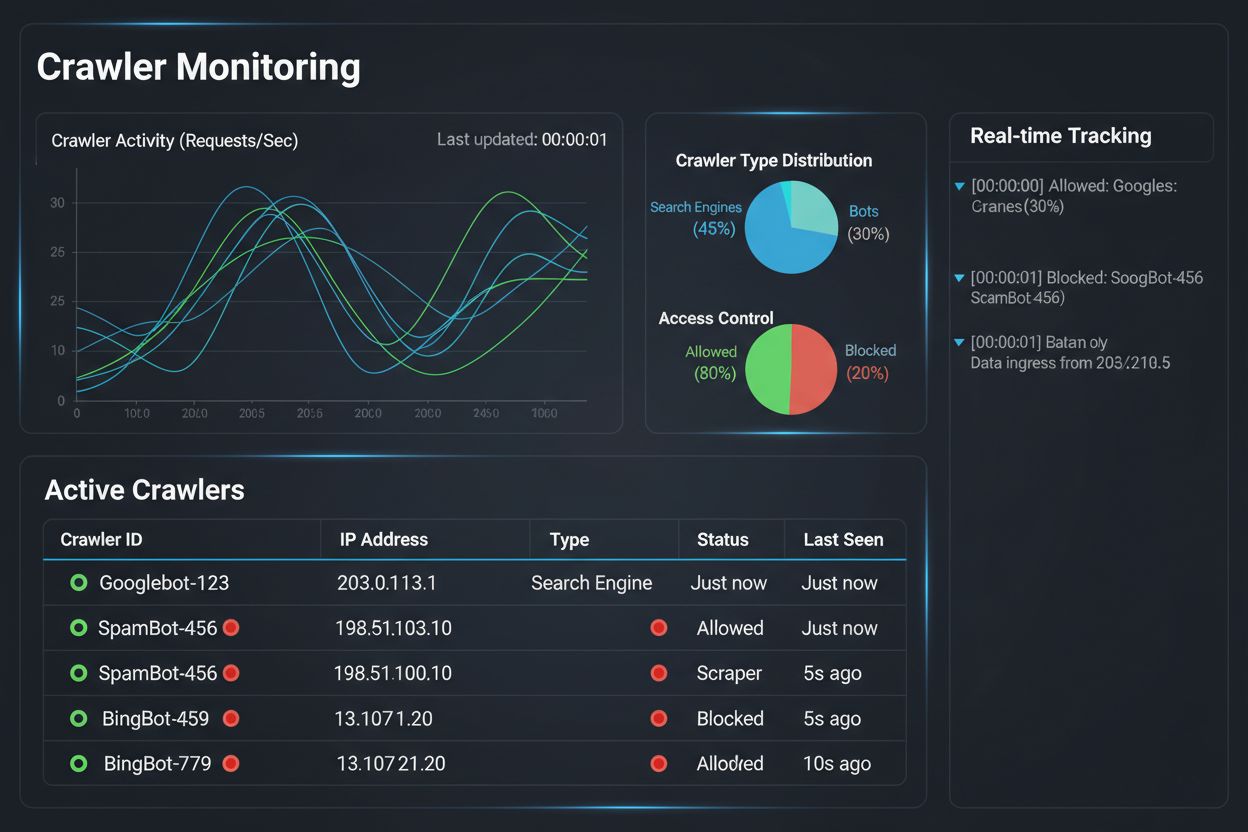

Implementar una estrategia de acceso diferencial de rastreadores es solo la mitad de la batalla; la otra mitad es comprender el impacto real de tus políticas mediante un monitoreo y medición exhaustivos. Aquí es donde AmICited.com se vuelve esencial para tu estrategia de gestión de rastreadores. AmICited se especializa en monitorear cómo los sistemas de IA referencian y citan tu marca en GPTs, Perplexity, Google AI Overviews y otras plataformas de IA—proporcionando visibilidad sobre qué rastreadores realmente usan tu contenido y cómo aparece en respuestas generadas por IA. En lugar de depender de registros de servidor y suposiciones, el panel de monitoreo de AmICited te muestra exactamente qué sistemas de IA han accedido a tu contenido, con qué frecuencia y, lo más importante, si tu contenido está siendo citado o simplemente absorbido en datos de entrenamiento sin atribución. Esta inteligencia informa directamente tus decisiones de acceso diferencial: si un rastreador accede a tu contenido pero nunca lo cita en respuestas de IA, bloquearlo se convierte en una decisión empresarial clara. AmICited también permite comparativas competitivas, mostrando cómo la visibilidad de tu contenido en sistemas de IA se compara con la de tus competidores, ayudándote a entender si tus políticas de acceso son demasiado restrictivas o permisivas. Las alertas en tiempo real de la plataforma te notifican cuando nuevos sistemas de IA comienzan a referenciar tu contenido, permitiendo ajustes rápidos de política. Al combinar las capacidades de monitoreo de AmICited con las herramientas de aplicación de Cloudflare, los editores obtienen visibilidad y control completos: pueden ver qué rastreadores acceden a su contenido, medir el impacto comercial y ajustar las políticas en consecuencia. Este enfoque basado en datos transforma la gestión de rastreadores de un trámite técnico a una función empresarial estratégica.

El panorama del acceso diferencial de rastreadores está evolucionando rápidamente, con estándares y modelos de negocio emergentes que están remodelando cómo los editores y las empresas de IA interactúan en torno al contenido. La propuesta de preferencias de IA de IETF representa un avance significativo, estableciendo formas estandarizadas para que los sitios web comuniquen sus preferencias respecto al entrenamiento, inferencia y uso en búsqueda por IA. En lugar de depender de robots.txt—un estándar de 30 años diseñado para motores de búsqueda—este nuevo marco proporciona un control explícito y granular sobre cómo los sistemas de IA pueden usar el contenido. Simultáneamente, los modelos de negocio basados en permisos están ganando tracción, con la iniciativa Pay Per Crawl de Cloudflare como pionera de un marco donde las empresas de IA pagan a los editores por el acceso a contenido, transformando los rastreadores de amenazas a fuentes de ingresos. Este cambio de bloquear a licenciar representa un cambio fundamental en la economía de Internet: en vez de pelear por el acceso, editores y empresas de IA negocian una compensación justa. También avanzan los estándares de autenticación y verificación de rastreadores, con métodos criptográficos que permiten a los editores confirmar la identidad de los rastreadores y prevenir solicitudes suplantadas. De cara al futuro, podemos esperar marcos regulatorios crecientes que aborden los datos de entrenamiento de IA, potencialmente exigiendo consentimiento explícito y compensación por el uso de contenido. La convergencia de estas tendencias—estándares técnicos, modelos de licenciamiento, mecanismos de autenticación y presión regulatoria—sugiere que el acceso diferencial de rastreadores evolucionará de una estrategia defensiva a una función empresarial sofisticada donde los editores gestionan, monitorean y monetizan activamente el acceso de rastreadores de IA. Los editores que implementen hoy un monitoreo integral y políticas estratégicas estarán mejor posicionados para aprovechar estas oportunidades emergentes.

Bloquear todos los rastreadores elimina tu contenido de los sistemas de IA por completo, eliminando tanto riesgos como oportunidades. El acceso diferencial te permite evaluar cada rastreador individualmente, bloqueando aquellos que no aportan valor mientras permites los que generan tráfico o representan oportunidades de licenciamiento. Este enfoque matizado maximiza tanto la visibilidad como los ingresos mientras protege la propiedad intelectual.

Puedes monitorear la actividad de los rastreadores a través de los registros del servidor, el panel de analíticas de Cloudflare o herramientas de monitoreo especializadas como AmICited.com. AmICited rastrea específicamente qué sistemas de IA están accediendo a tu contenido y cómo aparece tu marca en respuestas generadas por IA, proporcionando información a nivel de negocio más allá de los registros técnicos.

No. Bloquear rastreadores de entrenamiento de IA como GPTBot, ClaudeBot y CCBot no afecta tus posiciones en Google o Bing. Los motores de búsqueda tradicionales usan rastreadores diferentes (Googlebot, Bingbot) que operan de forma independiente. Solo bloquea estos si deseas desaparecer completamente de los resultados de búsqueda.

Sí, este es el enfoque más estratégico para muchos editores. Puedes permitir rastreadores enfocados en búsqueda como OAI-SearchBot y PerplexityBot (que generan tráfico) mientras bloqueas rastreadores de entrenamiento como GPTBot y ClaudeBot (que normalmente no lo hacen). Esto mantiene la visibilidad en los resultados de búsqueda de IA mientras protege el contenido de ser absorbido en conjuntos de datos de entrenamiento.

Mientras que los principales rastreadores de OpenAI, Anthropic y Google respetan robots.txt, algunos bots lo ignoran deliberadamente. Si un rastreador no respeta tu robots.txt, necesitarás métodos de aplicación adicionales como reglas WAF, bloqueo de IPs o las funciones de gestión de bots de Cloudflare. Por eso herramientas de monitoreo como AmICited son esenciales: te muestran qué rastreadores realmente respetan tus políticas.

Revisa tus políticas al menos trimestralmente, ya que las empresas de IA introducen nuevos rastreadores regularmente. Anthropic fusionó sus bots 'anthropic-ai' y 'Claude-Web' en 'ClaudeBot', dando al nuevo bot acceso irrestricto temporal a los sitios que no habían actualizado sus reglas. El monitoreo regular con herramientas como AmICited te ayuda a anticipar los cambios.

Googlebot es el rastreador de búsqueda de Google que indexa contenido para los resultados de búsqueda. Google-Extended es un token de control que gobierna específicamente si tu contenido se usa para el entrenamiento de Gemini AI. Puedes bloquear Google-Extended sin afectar tu posicionamiento en búsquedas, pero ten en cuenta que Google AI Overviews (que aparecen en los resultados de búsqueda) usan las reglas estándar de Googlebot, por lo que no puedes excluirte de AI Overviews sin sacrificar visibilidad en búsquedas.

Sí, modelos de licenciamiento emergentes como Pay Per Crawl de Cloudflare permiten a los editores cobrar a empresas de IA por el acceso a contenido. Esto transforma a los rastreadores de amenazas en fuentes de ingresos. Sin embargo, esto requiere negociación con las empresas de IA y puede involucrar acuerdos legales. El monitoreo de AmICited te ayuda a identificar qué rastreadores representan las oportunidades de licenciamiento más valiosas.

Rastrea qué sistemas de IA están accediendo a tu contenido y cómo aparece tu marca en respuestas generadas por IA. Obtén información en tiempo real sobre el comportamiento de los rastreadores y mide el impacto comercial de tus políticas de acceso diferencial.

Guía de referencia completa de rastreadores y bots de IA. Identifica GPTBot, ClaudeBot, Google-Extended y más de 20 rastreadores de IA con user agents, tasas de...

Aprende a usar robots.txt para controlar qué bots de IA acceden a tu contenido. Guía completa para bloquear GPTBot, ClaudeBot y otros crawlers de IA con ejemplo...

Aprende cómo los cortafuegos de aplicaciones web proporcionan un control avanzado sobre los rastreadores de IA más allá de robots.txt. Implementa reglas WAF par...