GPT-5

GPT-5 es el último LLM de OpenAI lanzado en agosto de 2025, con ventana de contexto de 400K, 45% menos alucinaciones, capacidades multimodales y arquitectura de...

GPT-4 es el modelo de lenguaje grande de cuarta generación de OpenAI y el primer LLM multimodal capaz de procesar entradas tanto de texto como de imagen para generar respuestas a nivel humano. Lanzado en marzo de 2023, GPT-4 representa un avance significativo en la inteligencia artificial con una ventana de contexto de 128K, mayores capacidades de razonamiento y características de seguridad mejoradas en comparación con su predecesor GPT-3.5.

GPT-4 es el modelo de lenguaje grande de cuarta generación de OpenAI y el primer LLM multimodal capaz de procesar entradas tanto de texto como de imagen para generar respuestas a nivel humano. Lanzado en marzo de 2023, GPT-4 representa un avance significativo en la inteligencia artificial con una ventana de contexto de 128K, mayores capacidades de razonamiento y características de seguridad mejoradas en comparación con su predecesor GPT-3.5.

GPT-4 (Generative Pre-trained Transformer 4) es el modelo de lenguaje grande de cuarta generación de OpenAI y representa un punto de inflexión en el desarrollo de la inteligencia artificial. Lanzado en marzo de 2023, GPT-4 es el primer modelo de lenguaje grande multimodal capaz de aceptar entradas tanto de texto como de imagen mientras genera salidas de texto sofisticadas. A diferencia de su predecesor GPT-3.5, que solo procesa texto, GPT-4 combina el procesamiento de lenguaje natural con capacidades de visión por computadora, lo que le permite comprender y analizar información visual junto con el contexto textual. Este modelo revolucionario demuestra un rendimiento a nivel humano en numerosos puntos de referencia profesionales y académicos, cambiando fundamentalmente la forma en que las empresas abordan la generación de contenido, el análisis y la toma de decisiones impulsadas por IA. La importancia de GPT-4 va más allá de mejoras en la capacidad pura: representa un cambio de paradigma en cómo los sistemas de IA pueden interactuar con y comprender el mundo.

El desarrollo de GPT-4 se basa en la arquitectura transformer introducida por investigadores de Google en 2017 a través de su artículo seminal “Attention Is All You Need”. La evolución de OpenAI desde GPT-1 hasta GPT-4 demuestra mejoras exponenciales en la sofisticación y capacidad del modelo. GPT-3, lanzado en 2020, fue entrenado con 175 mil millones de parámetros y estableció la base para los modelos de lenguaje grandes modernos. Sin embargo, OpenAI decidió no revelar el número exacto de parámetros utilizados para entrenar GPT-4, en parte debido a la creciente competencia en el espacio de IA y la transición de la empresa hacia una estructura con fines de lucro. A pesar de la especulación de que GPT-4 utiliza más de 100 billones de parámetros, el CEO Sam Altman negó explícitamente estas afirmaciones. El desarrollo del modelo incorporó una amplia investigación en seguridad, integración de retroalimentación humana y pruebas en el mundo real para abordar preocupaciones sobre desinformación, sesgo y resultados dañinos que afectaron a iteraciones anteriores. GPT-4 representa aproximadamente 18 meses de investigación y desarrollo intensivo tras el lanzamiento de GPT-3.5, incorporando lecciones aprendidas de millones de interacciones de usuarios y consultas de expertos.

La arquitectura de GPT-4 representa una desviación significativa respecto a modelos anteriores mediante la adopción de un diseño Mixture of Experts (MoE). Esta sofisticada arquitectura de red neuronal emplea múltiples subredes especializadas, cada una optimizada para diferentes tipos de procesamiento de información. En lugar de usar una sola red densa como GPT-3.5, el enfoque MoE permite a GPT-4 enrutar eficientemente diferentes entradas a las redes de expertos más apropiadas, mejorando tanto el rendimiento como la eficiencia computacional. La capacidad multimodal se logra mediante la combinación de un codificador de texto y un codificador de imágenes Vision Transformer (ViT), lo que permite al modelo procesar información visual con la misma sofisticación que aplica al texto. El mecanismo de atención en GPT-4 se ha mejorado sustancialmente, permitiendo al modelo comprender mejor las relaciones entre conceptos distantes tanto en texto como en imágenes. Esta innovación arquitectónica permite a GPT-4 mantener coherencia en secuencias de información más largas y comprender relaciones complejas que abarcan múltiples modalidades. La capacidad del modelo para procesar 128.000 tokens en su ventana de contexto (en comparación con el límite de 8.000 tokens de GPT-3.5) representa una mejora de 8 veces en la capacidad de memoria a corto plazo, lo que permite el análisis de documentos completos, conversaciones extensas y grandes repositorios de código sin perder información contextual.

| Aspecto | GPT-4 | GPT-3.5 | GPT-4 Turbo | Claude 3 |

|---|---|---|---|---|

| Modalidad de entrada | Texto + Imágenes | Solo texto | Texto + Imágenes | Solo texto |

| Ventana de contexto | 128K tokens | 8K tokens | 128K tokens | 100K tokens |

| Rendimiento en el Bar Exam | Percentil 90 | Percentil 10 | Percentil 88 | Percentil 88 |

| Olimpiada de Biología | Percentil 99 | Percentil 31 | Percentil 97 | Percentil 96 |

| Características de seguridad | 82% menos probable de responder a contenido no permitido | Estándar | Mejoradas | Comparables |

| Precisión factual | 40% más precisa | Estándar | Mejorada | Similar |

| Parámetros (divulgados) | No divulgados | 175 mil millones | No divulgados | No divulgados |

| Fecha de lanzamiento | Marzo 2023 | Noviembre 2022 | Noviembre 2023 | Marzo 2024 |

| Acceso a Internet en tiempo real | Sí (actualizado sept 2023) | Limitado | Sí | Sí |

| Precio (API) | Mayor costo | Costo menor | Intermedio | Competitivo |

Las capacidades de visión de GPT-4 representan una de sus características más transformadoras, permitiendo aplicaciones antes imposibles con modelos solo de texto. El modelo puede realizar respuestas visuales a preguntas (VQA), donde los usuarios proporcionan una imagen y hacen preguntas sobre su contenido, recibiendo respuestas detalladas y contextualmente apropiadas. La transcripción de texto a partir de imágenes permite a GPT-4 digitalizar notas manuscritas, documentos impresos y capturas de pantalla con notable precisión, resultando invaluable para la gestión documental y aplicaciones de accesibilidad. La detección e identificación de objetos permite a GPT-4 reconocer y describir objetos en imágenes, incluso en escenas complejas con múltiples elementos o iluminación variable. El modelo sobresale en interpretación de visualizaciones de datos, analizando gráficos, diagramas e infografías para extraer ideas y explicar relaciones de datos complejas en lenguaje natural. Las aplicaciones reales demuestran la capacidad de GPT-4 para generar código funcional a partir de bocetos a mano, crear sitios web desde imágenes de wireframes y desarrollar juegos a partir de especificaciones visuales. Empresas como Be My Eyes aprovechan las capacidades de visión de GPT-4 para asistir a personas con discapacidad visual analizando imágenes en tiempo real. Duolingo utiliza GPT-4 para ofrecer práctica conversacional en idiomas, mientras que Morgan Stanley desplegó un modelo personalizado de GPT-4 entrenado con datos financieros propios para proporcionar acceso instantáneo a perspectivas de inversión e información de gestión patrimonial. Estas aplicaciones muestran cómo el procesamiento multimodal cierra la brecha entre la comprensión visual humana y las capacidades lingüísticas de la IA.

GPT-4 demuestra un rendimiento sin precedentes en exámenes académicos y profesionales estandarizados. En el Examen Uniforme de Abogacía, GPT-4 obtuvo el percentil 90 en comparación con personas, una mejora dramática respecto al percentil 10 de GPT-3.5. Esto representa la diferencia entre una puntuación que habilitaría a alguien para ejercer como abogado y una que resultaría en fracaso. De manera similar, en la Olimpiada de Biología, GPT-4 logró el percentil 99 frente al 31 de GPT-3.5. Estas referencias se extienden a múltiples dominios, incluidos matemáticas, codificación, redacción y razonamiento visual. Investigadores de Microsoft caracterizaron a GPT-4 como una “versión temprana aunque aún incompleta de inteligencia artificial general (AGI)”, destacando su amplia capacidad en dominios diversos. El modelo muestra desempeño superior en áreas especializadas como medicina, derecho, psicología e ingeniería. Sin embargo, es importante señalar que el rendimiento en benchmarks no garantiza precisión en el mundo real, y GPT-4 aún puede producir alucinaciones o información incorrecta en contextos específicos. Las mejoras en precisión factual—un 40% más propenso a producir respuestas correctas que GPT-3.5—representan un avance significativo, pero no la perfección. Estas métricas han hecho de GPT-4 el modelo preferido para aplicaciones empresariales que requieren alta precisión y razonamiento sofisticado.

OpenAI implementó medidas de seguridad integrales en GPT-4 para abordar preocupaciones sobre resultados dañinos, desinformación y sesgo. El modelo es un 82% menos propenso a responder a solicitudes de contenido no permitido comparado con GPT-3.5, representando una mejora sustancial en filtrado de contenido y barreras de seguridad. Esta mejora se logró mediante múltiples mecanismos, incluidos aprendizaje por refuerzo con retroalimentación humana (RLHF), consultas con expertos en seguridad de diversos ámbitos y extensas pruebas en el mundo real antes de su lanzamiento público. GPT-4 demuestra mayor resistencia a intentos de elusión de seguridad (“jailbreak”), donde los usuarios intentan manipular el modelo para que ignore las directrices de seguridad. El entrenamiento del modelo incorporó perspectivas diversas para reducir sesgos, aunque estos siguen siendo un reto en desarrollo de IA. OpenAI también implementó mecanismos de rechazo que impiden a GPT-4 analizar ciertas imágenes sensibles, especialmente aquellas que involucran personas, para proteger la privacidad y evitar usos indebidos. La mejora del 40% en precisión factual refleja mejores procesos de curación y validación de datos de entrenamiento. Sin embargo, estas mejoras de seguridad no eliminan todos los riesgos: GPT-4 aún puede ofrecer consejos médicos poco fiables, generar respuestas sesgadas en ciertos contextos y producir alucinaciones. Las vulnerabilidades de ciberseguridad del modelo, incluida la posible resolución de CAPTCHAs, resaltan la tensión continua entre capacidad y seguridad en sistemas de IA avanzados. Las organizaciones que implementan GPT-4 deben añadir salvaguardas y supervisión humana para garantizar un uso responsable alineado con sus valores y requisitos regulatorios.

La ventana de contexto de 128.000 tokens en GPT-4 representa una mejora revolucionaria en la cantidad de información que el modelo puede procesar simultáneamente. Para entender esta capacidad, considere que un token equivale aproximadamente a 0,75 palabras en inglés, lo que significa que GPT-4 puede procesar cerca de 96.000 palabras a la vez. Esto equivale a analizar una novela completa, un artículo de investigación exhaustivo con apéndices o una conversación extendida con cientos de intercambios. GPT-4 Turbo, lanzado en noviembre de 2023, mantiene esta ventana de contexto plena de 128K, mientras que versiones anteriores tenían límites menores. La ventana de contexto ampliada habilita varias capacidades críticas: los usuarios pueden subir bases de código completas para análisis y refactorización, proporcionar documentación de proyectos completa para asistencia contextual y mantener conversaciones coherentes sin que el modelo olvide los puntos discutidos previamente. La mejora de la ventana de contexto aborda una limitación importante de GPT-3.5, que solo podía mantener cerca de 8.000 palabras de contexto antes de perder información. Esta mejora de 16 veces cambia fundamentalmente cómo GPT-4 puede aplicarse a tareas complejas y cargadas de documentos. Sin embargo, la investigación indica que el uso efectivo del contexto en GPT-4 puede ser menor que el máximo teórico, con estudios que sugieren que el modelo rinde óptimamente con unos 8.000-40.000 tokens de contenido, degradando su rendimiento en los extremos de la ventana. Este fenómeno, conocido como la “ilusión de la ventana de contexto”, sugiere que, aunque la capacidad existe, el rendimiento práctico puede variar según la ubicación y complejidad de la información.

La adopción de GPT-4 en empresas ha aumentado drásticamente desde su lanzamiento, con tasas de adopción del 57% en campos informáticos, 50% en gestión y negocios, 48% en ingeniería y ciencia y 44% en otros roles profesionales. Las organizaciones están implementando GPT-4 para aplicaciones tan diversas como automatización de atención al cliente, generación de contenido, desarrollo de código, análisis de datos y toma de decisiones estratégicas. Instituciones financieras como Morgan Stanley han implementado modelos personalizados de GPT-4 entrenados con datos propios para mejorar la gestión patrimonial y el asesoramiento en inversiones. Organizaciones sanitarias están explorando el potencial de GPT-4 para investigación médica, asistencia diagnóstica y comunicación con pacientes, aunque persisten preocupaciones regulatorias y de precisión. Instituciones educativas aprovechan GPT-4 para tutoría personalizada, creación de contenido y apoyo a la accesibilidad. La estructura de precios de la API de GPT-4 es más alta que la de GPT-3.5, reflejando los mayores recursos computacionales requeridos y las capacidades superiores del modelo. Esta diferencia de precios ha creado una segmentación de mercado donde organizaciones con altos requerimientos de precisión o tareas complejas justifican el costo premium, mientras otras continúan usando GPT-3.5 para aplicaciones sensibles al coste. La trayectoria de adopción empresarial sugiere que GPT-4 se convertirá en el estándar para aplicaciones de IA sofisticadas, de manera similar a como GPT-3.5 se volvió ubicuo para tareas generales. Sin embargo, las preocupaciones sobre privacidad de datos, alucinaciones del modelo y cumplimiento normativo siguen influyendo en las decisiones de adopción, especialmente en industrias reguladas como finanzas y salud.

La aparición de GPT-4 como plataforma dominante de IA tiene implicaciones significativas para sistemas de monitorización de IA y seguimiento de citaciones como AmICited. A medida que las empresas dependen cada vez más de GPT-4 para investigación, generación de contenido y toma de decisiones, comprender cómo GPT-4 cita fuentes y menciona marcas es fundamental para la estrategia SEO y la visibilidad de marca. Las capacidades multimodales de GPT-4 significan que las citaciones pueden aparecer tanto en respuestas de texto como en búsquedas basadas en imágenes, ampliando la superficie de menciones de marca. La ventana de contexto de 128K permite al modelo procesar y citar documentos más extensos, aumentando la probabilidad de menciones de marca o dominio específicas en las respuestas. Las plataformas de monitorización de IA deben rastrear las citaciones de GPT-4 en múltiples dimensiones: si las citaciones aparecen en respuestas de texto, si se analizan y citan imágenes, la frecuencia de menciones de marca y el contexto en que se producen. La mejorada precisión factual de GPT-4 respecto a GPT-3.5 implica que las citaciones son más propensas a ser correctas, haciendo las respuestas de GPT-4 particularmente valiosas para entender cómo los sistemas de IA representan tu marca o dominio. Las organizaciones que usan AmICited pueden identificar qué piezas de contenido son citadas con mayor frecuencia por GPT-4, optimizar contenido para su descubrimiento por IA y comprender cómo su posicionamiento de marca difiere entre varias plataformas de IA como ChatGPT, Perplexity, Google AI Overviews y Claude. La importancia estratégica de la monitorización de GPT-4 va más allá de las métricas de vanidad: aporta ideas sobre cómo los sistemas de IA comprenden y representan tu industria, competidores y posicionamiento en el mercado.

A pesar de sus notables capacidades, GPT-4 tiene limitaciones significativas que las organizaciones deben comprender antes de su implementación. Las alucinaciones—cuando el modelo genera información aparentemente plausible pero incorrecta—siguen siendo un desafío persistente, especialmente en dominios especializados o cuando el modelo carece de datos de entrenamiento sobre ciertos temas. El modelo puede proporcionar consejos médicos incorrectos con confianza, lo que puede causar daño si los usuarios confían en él sin verificación profesional. Surgen preocupaciones de privacidad por la capacidad de GPT-4 de identificar personas y ubicaciones en imágenes, generando dudas sobre consentimiento y cumplimiento de protección de datos. El sesgo en el análisis de imágenes podría causar resultados discriminatorios, especialmente para grupos demográficos subrepresentados. La negativa del modelo a analizar ciertas imágenes, si bien es una característica de seguridad, limita su funcionalidad en casos de uso legítimos. Las vulnerabilidades de ciberseguridad incluyen su posible explotación para resolver CAPTCHAs o generar contenido adversarial. La fecha de corte de conocimientos del modelo (entrenamiento finalizado en abril de 2024 para las versiones recientes) implica que no tiene conciencia de eventos o desarrollos muy recientes. Los costos computacionales de ejecutar GPT-4 siguen siendo altos, limitando su accesibilidad para organizaciones pequeñas. La tendencia del modelo a producir respuestas extensas puede ser ineficiente en ciertas aplicaciones. Además, el rendimiento de GPT-4 puede variar significativamente según la ingeniería de prompts, con resultados subóptimos ante solicitudes mal construidas. Las organizaciones deben implementar supervisión humana, procesos de verificación y validación de expertos para mitigar estas limitaciones.

La trayectoria de desarrollo de GPT-4 sugiere una evolución continua hacia modelos más capaces, eficientes y especializados. OpenAI ya ha lanzado GPT-4 Turbo con mejor rendimiento y menor coste, y ha anunciado GPT-4.1 con capacidades mejoradas y soporte de ventana de contexto extendida hasta 1 millón de tokens. La emergencia de variantes especializadas de GPT-4—incluyendo GPT-4o (optimizado), GPT-4 mini y GPT-4 nano—indica una estrategia de diversificación de modelos para servir diferentes casos de uso y restricciones computacionales. Es probable que futuros desarrollos incluyan capacidades multimodales mejoradas con soporte para entradas de audio y video, mayor razonamiento para resolución de problemas complejos y mejor integración con herramientas y APIs externas. El panorama competitivo se intensifica con Claude 3, Gemini y otros modelos desafiando la hegemonía de GPT-4, impulsando la innovación en toda la industria. Los marcos regulatorios en torno a la IA están evolucionando, lo que podría imponer nuevos requisitos de transparencia, explicabilidad y seguridad que influirán en el desarrollo de modelos. Se espera que la tendencia de costes de los modelos de IA disminuya conforme aumente la competencia y se implementen mejoras de eficiencia, lo que podría democratizar el acceso a capacidades avanzadas de IA. La integración con sistemas empresariales probablemente se profundizará, con GPT-4 integrándose en herramientas de productividad, plataformas de inteligencia empresarial y aplicaciones industriales especializadas. La importancia de la monitorización y el seguimiento de citaciones en IA aumentará a medida que las organizaciones reconozcan el valor estratégico de comprender cómo los sistemas de IA representan sus marcas y contenidos. El futuro de GPT-4 no trata solo de mejoras incrementales de capacidad, sino de cambios fundamentales en cómo los sistemas de IA interactúan con la información, entienden el contexto y apoyan la toma de decisiones humanas en dominios diversos.

GPT-4 supera significativamente a GPT-3.5 en múltiples dimensiones. GPT-4 obtuvo el percentil 90 en el Examen Uniforme de Abogacía frente al percentil 10 de GPT-3.5, y alcanzó el percentil 99 en la Olimpiada de Biología frente al percentil 31 de GPT-3.5. GPT-4 es multimodal, acepta entradas de texto e imagen, mientras que GPT-3.5 solo procesa texto. Además, GPT-4 tiene una ventana de contexto 8 veces mayor (64.000 palabras frente a 8.000 palabras) y es un 82% menos propenso a responder a solicitudes de contenido no permitido.

Multimodal se refiere a la capacidad de GPT-4 para comprender y procesar simultáneamente varios tipos de datos de entrada, incluidos texto, imágenes y potencialmente otros formatos. Esto permite a GPT-4 analizar imágenes, responder preguntas sobre contenido visual, realizar reconocimiento óptico de caracteres y generar respuestas basadas en información combinada de texto y visual, imitando la comprensión humana a través de diferentes entradas sensoriales.

La ventana de contexto de GPT-4 es de 128.000 tokens (aproximadamente 80.000 palabras en inglés), con GPT-4 Turbo soportando la capacidad completa de 128K. Esto significa que GPT-4 puede procesar y mantener coherencia en documentos, conversaciones y archivos de código significativamente más largos en comparación con el límite de 8.000 palabras de GPT-3.5. Una ventana de contexto más grande permite una mejor comprensión de documentos complejos y conversaciones largas sin perder información.

GPT-4 sobresale en generación de texto, escritura de código, razonamiento matemático, análisis visual, resumen de documentos y resolución de problemas complejos. Puede interpretar gráficos e infografías, transcribir texto de imágenes, detectar objetos, realizar respuestas visuales a preguntas y generar código a partir de bocetos o wireframes. GPT-4 también demuestra mayor precisión en dominios especializados como derecho, medicina y materias académicas.

Las avanzadas capacidades de razonamiento y multimodales de GPT-4 lo convierten en una plataforma significativa para herramientas de monitorización de IA como AmICited. A medida que las empresas utilizan cada vez más GPT-4 para generación de contenido e investigación, el seguimiento de menciones de marca, citaciones y apariciones de URL en las respuestas de GPT-4 se vuelve crítico para SEO, gestión de marca y comprensión de los patrones de distribución de contenido impulsados por IA en diferentes plataformas.

GPT-4 emplea un diseño Mixture of Experts (MoE), una arquitectura de red neuronal que utiliza múltiples subredes especializadas (expertos) para procesar diferentes tipos de información. Este enfoque permite a GPT-4 gestionar tareas diversas y escalar los cálculos de manera eficiente, mejorando el rendimiento y gestionando los recursos computacionales de forma más efectiva que las arquitecturas densas tradicionales utilizadas en modelos anteriores.

OpenAI implementó múltiples medidas de seguridad en GPT-4, incluyendo entrenamiento con retroalimentación humana, consultas con expertos en seguridad y pruebas en el mundo real. GPT-4 es un 82% menos propenso a responder a solicitudes de contenido no permitido y un 40% más propenso a producir respuestas fácticamente correctas que GPT-3.5. Estas mejoras abordan preocupaciones sobre desinformación, sesgo y generación de contenido dañino.

GPT-4 tiene limitaciones notables como posibles alucinaciones (generación de información falsa), preocupaciones de privacidad con el análisis de imágenes, posibles sesgos en respuestas y ocasiones en las que se niega a analizar imágenes sensibles. El modelo puede proporcionar consejos médicos poco fiables, puede tener dificultades con información muy reciente y presenta vulnerabilidades de ciberseguridad como la posible resolución de CAPTCHA que podría ser explotada maliciosamente.

Comienza a rastrear cómo los chatbots de IA mencionan tu marca en ChatGPT, Perplexity y otras plataformas. Obtén información procesable para mejorar tu presencia en IA.

GPT-5 es el último LLM de OpenAI lanzado en agosto de 2025, con ventana de contexto de 400K, 45% menos alucinaciones, capacidades multimodales y arquitectura de...

ChatGPT es el asistente de IA conversacional de OpenAI impulsado por modelos GPT. Descubre cómo funciona, su impacto en el monitoreo de IA, la visibilidad de ma...

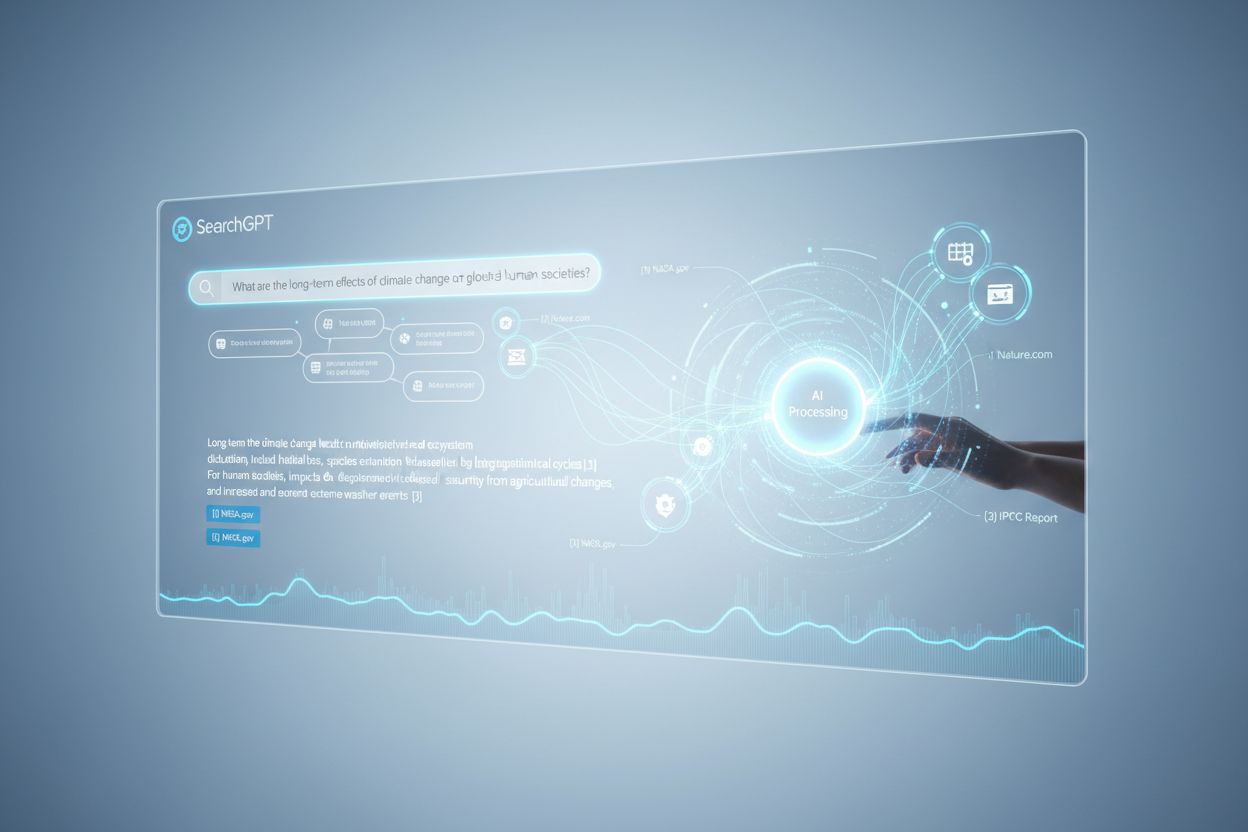

Descubre qué es SearchGPT, cómo funciona y su impacto en la búsqueda, el SEO y el marketing digital. Explora características, limitaciones y el futuro de la bús...