Citación de IA

Descubre qué son las citaciones de IA, cómo funcionan en ChatGPT, Perplexity y Google AI, y por qué son importantes para la visibilidad de tu marca en motores d...

La inferencia es el proceso mediante el cual un modelo de IA entrenado genera resultados, predicciones o conclusiones a partir de nuevos datos de entrada aplicando los patrones y conocimientos aprendidos durante el entrenamiento. Representa la fase operativa en la que los sistemas de IA aplican su inteligencia aprendida a problemas del mundo real en entornos de producción.

La inferencia es el proceso mediante el cual un modelo de IA entrenado genera resultados, predicciones o conclusiones a partir de nuevos datos de entrada aplicando los patrones y conocimientos aprendidos durante el entrenamiento. Representa la fase operativa en la que los sistemas de IA aplican su inteligencia aprendida a problemas del mundo real en entornos de producción.

La inferencia es el proceso mediante el cual un modelo de inteligencia artificial entrenado genera resultados, predicciones o conclusiones a partir de nuevos datos de entrada aplicando los patrones y conocimientos aprendidos durante la fase de entrenamiento. En el contexto de los sistemas de IA, la inferencia representa la fase operativa en la que los modelos de aprendizaje automático pasan del laboratorio a entornos de producción para resolver problemas del mundo real. Cuando interactúas con ChatGPT, Perplexity, Google AI Overviews o Claude, estás experimentando la inferencia de IA en acción: el modelo toma tu entrada y genera respuestas inteligentes basadas en los patrones aprendidos de enormes conjuntos de datos de entrenamiento. La inferencia es fundamentalmente diferente del entrenamiento; mientras que el entrenamiento enseña al modelo qué hacer, la inferencia es donde el modelo realmente lo hace, aplicando su conocimiento aprendido a datos que nunca ha visto antes.

La distinción entre entrenamiento de IA e inferencia de IA es fundamental para entender cómo operan los sistemas modernos de inteligencia artificial. Durante la fase de entrenamiento, los científicos de datos alimentan enormes conjuntos de datos curados a redes neuronales, permitiendo que el modelo aprenda patrones, relaciones y reglas de decisión a través de la optimización iterativa. Este proceso es computacionalmente intensivo, requiriendo a menudo semanas o meses de procesamiento en hardware especializado como GPUs y TPUs. Una vez que el entrenamiento ha finalizado y el modelo ha convergido en pesos y parámetros óptimos, el modelo entra en la fase de inferencia. En este punto, el modelo está congelado—ya no aprende de nuevos datos—y en su lugar aplica los patrones aprendidos para generar predicciones o resultados sobre entradas no vistas previamente. Según investigaciones de IBM y Oracle, la inferencia es donde se realiza el verdadero valor de negocio de la IA, ya que permite a las organizaciones desplegar capacidades de IA a escala en sistemas de producción. El mercado de inferencia en IA fue valorado en USD 106.15 mil millones en 2025 y se proyecta que crezca a USD 254.98 mil millones para 2030, reflejando la explosiva demanda de capacidades de inferencia en todas las industrias.

La inferencia en IA opera a través de un proceso de múltiples etapas que transforma datos de entrada en bruto en resultados inteligentes. Cuando un usuario envía una consulta a un modelo de lenguaje grande como ChatGPT, la canalización de inferencia comienza con la codificación de entrada, donde el texto se convierte en tokens numéricos que la red neuronal puede procesar. Luego el modelo entra en la fase de pre-llenado, donde todos los tokens de entrada se procesan simultáneamente a través de cada capa de la red neuronal, permitiendo al modelo comprender el contexto y las relaciones dentro de la consulta del usuario. Esta fase es computacionalmente pesada pero necesaria para la comprensión. Después de la fase de pre-llenado, el modelo entra en la fase de decodificación, donde genera tokens de salida secuencialmente, uno a uno, con cada nuevo token dependiendo de todos los tokens previos en la secuencia. Esta generación secuencial es la que crea el característico efecto de texto en streaming que los usuarios ven al interactuar con chatbots de IA. Finalmente, la etapa de conversión de salida transforma los tokens predichos nuevamente en texto legible, imágenes u otros formatos que los usuarios puedan comprender e interactuar. Todo este proceso debe suceder en milisegundos para aplicaciones en tiempo real, haciendo que la optimización de la latencia de inferencia sea una preocupación crítica para los proveedores de servicios de IA.

Las organizaciones que despliegan sistemas de IA deben elegir entre tres principales arquitecturas de inferencia, cada una optimizada para diferentes casos de uso y requisitos de rendimiento. La inferencia por lotes procesa grandes volúmenes de datos fuera de línea en intervalos programados, lo que la hace ideal para escenarios donde no se requieren respuestas en tiempo real, como generar tableros analíticos diarios, procesar evaluaciones de riesgo semanales o ejecutar actualizaciones nocturnas de recomendaciones. Este enfoque es muy eficiente y rentable porque puede procesar miles de predicciones simultáneamente, amortizando los costos computacionales entre muchas solicitudes. La inferencia en línea, también llamada inferencia dinámica, genera predicciones al instante a pedido con una latencia mínima, siendo esencial para aplicaciones interactivas como chatbots, motores de búsqueda y sistemas de detección de fraudes en tiempo real. La inferencia en línea requiere infraestructura sofisticada para mantener baja latencia y alta disponibilidad, empleando a menudo estrategias de caché y técnicas de optimización de modelos para asegurar respuestas en milisegundos. La inferencia en streaming procesa continuamente datos provenientes de sensores, dispositivos IoT o canalizaciones de datos en tiempo real, realizando predicciones sobre cada punto de datos a medida que llega. Este tipo impulsa aplicaciones como sistemas de mantenimiento predictivo que monitorean equipos industriales, vehículos autónomos que procesan datos de sensores en tiempo real y sistemas de ciudades inteligentes que analizan patrones de tráfico de forma continua. Cada tipo de inferencia exige diferentes consideraciones arquitectónicas, requisitos de hardware y estrategias de optimización.

| Aspecto | Inferencia por Lotes | Inferencia en Línea | Inferencia en Streaming |

|---|---|---|---|

| Requisito de Latencia | Segundos a minutos | Milisegundos | Tiempo real (sub-segundo) |

| Procesamiento de Datos | Grandes conjuntos de datos fuera de línea | Solicitudes individuales bajo demanda | Flujo continuo de datos |

| Casos de Uso | Analítica, reportes, recomendaciones | Chatbots, búsqueda, detección de fraudes | Monitoreo IoT, sistemas autónomos |

| Eficiencia de Costos | Alta (amortizada en muchas predicciones) | Media (requiere infraestructura siempre activa) | Media a alta (depende del volumen de datos) |

| Escalabilidad | Excelente (procesa en bloques) | Buena (requiere balanceo de carga) | Excelente (procesamiento distribuido) |

| Prioridad de Optimización de Modelo | Rendimiento | Equilibrio entre latencia y rendimiento | Equilibrio entre latencia y precisión |

| Requisitos de Hardware | GPUs/CPUs estándar | GPUs/TPUs de alto rendimiento | Hardware especializado edge o sistemas distribuidos |

La optimización de inferencia se ha convertido en una disciplina crítica a medida que las organizaciones buscan desplegar modelos de IA de manera más eficiente y rentable. La cuantización es una de las técnicas de optimización más impactantes, ya que reduce la precisión numérica de los pesos del modelo de los habituales números de punto flotante de 32 bits a enteros de 8 bits o incluso 4 bits. Esta reducción puede disminuir el tamaño del modelo en un 75-90% manteniendo el 95-99% de la precisión original, resultando en velocidades de inferencia más rápidas y menores requerimientos de memoria. La poda de modelos elimina neuronas, conexiones o capas enteras no críticas de la red neuronal, eliminando parámetros redundantes que no contribuyen significativamente a las predicciones. Las investigaciones muestran que la poda puede reducir la complejidad del modelo en un 50-80% sin pérdida sustancial de precisión. La destilación de conocimiento entrena un modelo “estudiante” más pequeño y rápido para imitar el comportamiento de un modelo “maestro” más grande y preciso, permitiendo su despliegue en dispositivos con recursos limitados manteniendo un rendimiento razonable. La optimización del procesamiento por lotes agrupa múltiples solicitudes de inferencia para maximizar la utilización de la GPU y el rendimiento. El caché de clave-valor almacena resultados de cálculos intermedios para evitar cálculos redundantes durante la fase de decodificación de la inferencia de modelos de lenguaje. Según investigaciones de NVIDIA, combinar múltiples técnicas de optimización puede lograr mejoras de rendimiento de 10 veces mientras reduce los costos de infraestructura en un 60-70%. Estas optimizaciones son esenciales para desplegar inferencia a gran escala, especialmente para organizaciones que ejecutan miles de solicitudes concurrentes de inferencia.

La aceleración por hardware es fundamental para lograr los requisitos de latencia y rendimiento de las cargas de trabajo modernas de inferencia en IA. Las Unidades de Procesamiento Gráfico (GPUs) siguen siendo los aceleradores de inferencia más ampliamente desplegados debido a su arquitectura de procesamiento en paralelo, que se adapta naturalmente a las operaciones matriciales que dominan los cálculos de redes neuronales. Las GPUs de NVIDIA impulsan la mayoría de los despliegues de inferencia de grandes modelos de lenguaje a nivel mundial, con sus núcleos CUDA especializados que permiten un paralelismo masivo. Las Unidades de Procesamiento Tensorial (TPUs), desarrolladas por Google, son ASICs personalizados optimizados específicamente para operaciones de redes neuronales, ofreciendo un rendimiento por vatio superior comparado con GPUs de propósito general en ciertas cargas de trabajo. Los Arreglos de Puertas Programables en Campo (FPGAs) proveen hardware personalizable que puede reprogramarse para tareas de inferencia específicas, ofreciendo flexibilidad para aplicaciones especializadas. Los Circuitos Integrados de Aplicación Específica (ASICs) como las TPU de Google o el WSE-3 de Cerebras están diseñados para cargas de trabajo particulares de inferencia, entregando un rendimiento excepcional pero con flexibilidad limitada. La elección de hardware depende de múltiples factores: arquitectura del modelo, latencia requerida, demanda de rendimiento, limitaciones de energía y costo total de propiedad. Para inferencia en el edge en dispositivos móviles o sensores IoT, aceleradores especializados de edge y unidades de procesamiento neuronal (NPUs) permiten inferencias eficientes con un consumo mínimo de energía. El cambio global hacia fábricas de IA—infraestructura altamente optimizada diseñada para fabricar inteligencia a escala—ha impulsado enormes inversiones en hardware de inferencia, con empresas desplegando miles de GPUs y TPUs en centros de datos para satisfacer la creciente demanda de servicios de IA.

Los sistemas de IA generativa como ChatGPT, Claude y Perplexity dependen completamente de la inferencia para generar texto, código, imágenes y otros contenidos similares a los humanos. Cuando envías una solicitud a estos sistemas, el proceso de inferencia comienza tokenizando tu entrada en representaciones numéricas que la red neuronal puede procesar. El modelo ejecuta la fase de pre-llenado, procesando todos tus tokens de entrada simultáneamente para construir una comprensión completa de tu solicitud, incluyendo contexto, intención y matices. A continuación, el modelo entra en la fase de decodificación, donde genera tokens de salida de forma secuencial, prediciendo el token más probable siguiente basado en todos los tokens previos y los patrones aprendidos de sus datos de entrenamiento. Esta generación token por token es la razón por la que ves texto en streaming en tiempo real al usar estos servicios. El proceso de inferencia debe equilibrar múltiples objetivos en competencia: generar respuestas precisas, coherentes y apropiadas al contexto, manteniendo baja latencia para mantener el interés del usuario. La decodificación especulativa, una técnica avanzada de optimización de inferencia, permite que un modelo más pequeño prediga múltiples tokens futuros mientras el modelo grande valida estas predicciones, reduciendo significativamente la latencia. La escala de la inferencia para grandes modelos de lenguaje es asombrosa—ChatGPT de OpenAI procesa millones de solicitudes de inferencia diarias, cada una generando cientos o miles de tokens, requiriendo infraestructura computacional masiva y estrategias de optimización sofisticadas para seguir siendo económicamente viable.

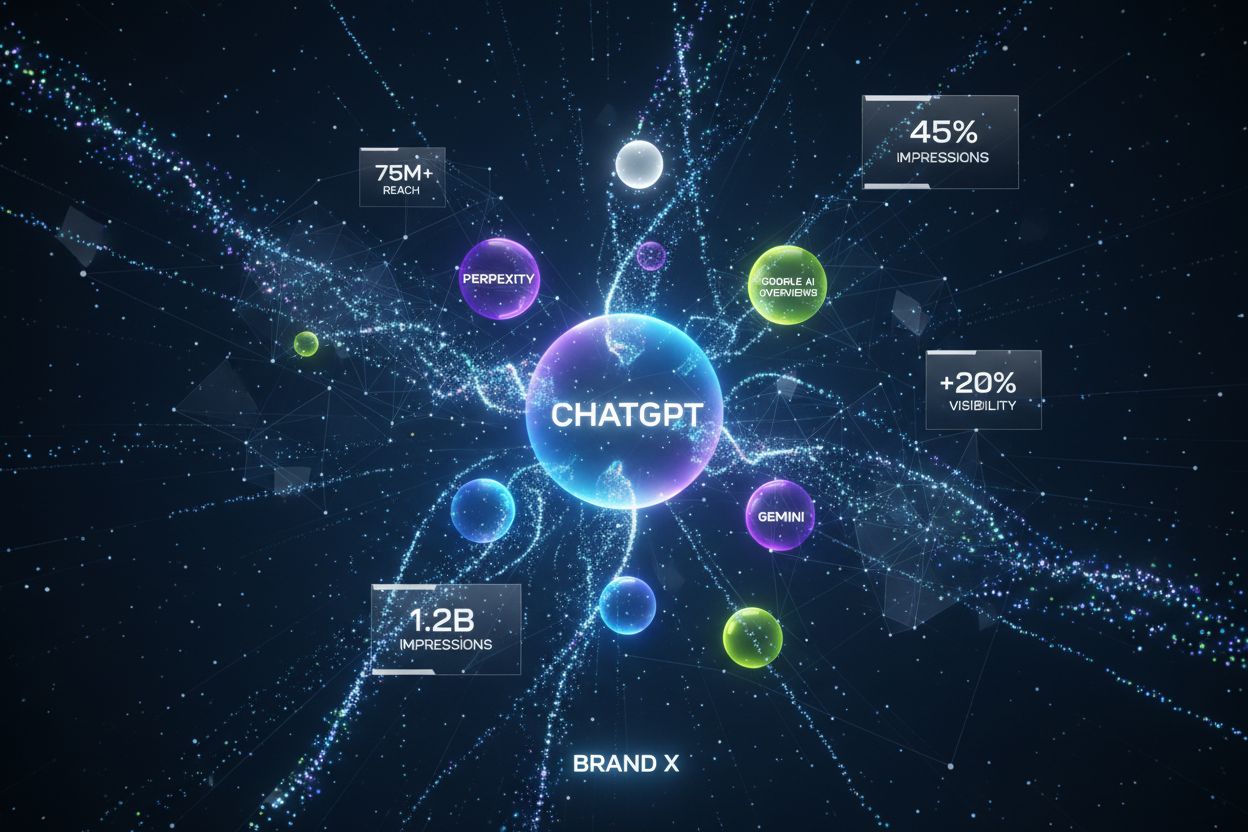

Para organizaciones preocupadas con su presencia de marca y la citación de contenidos en respuestas generadas por IA, el monitoreo de inferencia se ha vuelto cada vez más importante. Cuando sistemas de IA como Perplexity, Google AI Overviews o Claude generan respuestas, realizan inferencia sobre sus modelos entrenados para producir resultados que pueden referenciar o citar tu dominio, marca o contenido. Comprender cómo funcionan los sistemas de inferencia ayuda a las organizaciones a optimizar su estrategia de contenidos para asegurar una representación adecuada en las respuestas generadas por IA. AmICited se especializa en monitorear dónde aparecen marcas y dominios en los resultados de inferencia de IA a través de múltiples plataformas, proporcionando visibilidad sobre cómo los sistemas de IA citan y referencian tu contenido. Este monitoreo es crucial porque los sistemas de inferencia pueden generar respuestas que incluyan o excluyan tu marca según la calidad de los datos de entrenamiento, señales de relevancia y elecciones de optimización del modelo. Las organizaciones pueden usar los datos de monitoreo de inferencia para comprender qué contenido está siendo citado, con qué frecuencia aparece su marca en las respuestas de IA y si su dominio está siendo correctamente atribuido. Esta inteligencia permite tomar decisiones basadas en datos sobre optimización de contenidos, estrategia SEO y posicionamiento de marca en el emergente panorama de búsqueda impulsado por IA. A medida que la inferencia se convierte en la interfaz principal a través de la cual los usuarios descubren información, rastrear tu presencia en los resultados generados por IA es tan importante como la optimización tradicional para motores de búsqueda.

Desplegar sistemas de inferencia a escala presenta numerosos desafíos técnicos, operativos y estratégicos que las organizaciones deben abordar. La gestión de la latencia sigue siendo un reto persistente, ya que los usuarios esperan respuestas en sub-segundos de aplicaciones interactivas de IA, pero los modelos complejos con miles de millones de parámetros requieren un tiempo de cómputo significativo. La optimización del rendimiento es igualmente crítica—las organizaciones deben servir miles o millones de solicitudes de inferencia concurrentes manteniendo una latencia y precisión aceptables. El drift del modelo ocurre cuando el rendimiento de la inferencia se degrada con el tiempo a medida que las distribuciones de datos del mundo real se alejan de los datos de entrenamiento, requiriendo monitoreo continuo y reentrenamiento periódico del modelo. La interpretabilidad y explicabilidad se vuelven cada vez más importantes a medida que los sistemas de inferencia de IA toman decisiones que afectan a los usuarios, exigiendo a las organizaciones comprender y explicar cómo los modelos llegan a predicciones específicas. El cumplimiento regulatorio presenta desafíos crecientes, con regulaciones como la Ley de IA de la UE imponiendo requisitos de transparencia, detección de sesgos y supervisión humana en los sistemas de inferencia de IA. La calidad de los datos sigue siendo fundamental—los sistemas de inferencia sólo pueden ser tan buenos como los datos con los que se entrenaron, y datos de entrenamiento de baja calidad conducen a resultados de inferencia sesgados, inexactos o dañinos. Los costos de infraestructura pueden ser sustanciales, con despliegues de inferencia a gran escala requiriendo inversiones significativas en GPUs, TPUs, redes y sistemas de refrigeración. La escasez de talento significa que las organizaciones luchan por encontrar ingenieros y científicos de datos con experiencia en optimización de inferencia, despliegue de modelos y MLOps, aumentando los costos de contratación y ralentizando los tiempos de despliegue.

El futuro de la inferencia en IA está evolucionando rápidamente en varias direcciones transformadoras que remodelarán cómo las organizaciones despliegan y utilizan sistemas de IA. La inferencia en el edge—ejecutar la inferencia en dispositivos locales en lugar de centros de datos en la nube—está acelerándose, impulsada por avances en compresión de modelos, hardware especializado edge y preocupaciones de privacidad. Este cambio permitirá capacidades de IA en tiempo real en smartphones, dispositivos IoT y sistemas autónomos sin depender de la conectividad a la nube. La inferencia multimodal, donde los modelos procesan y generan texto, imágenes, audio y video simultáneamente, es cada vez más común, requiriendo nuevas estrategias de optimización y consideraciones de hardware. Están surgiendo modelos de razonamiento que realizan inferencia en múltiples pasos para resolver problemas complejos, con sistemas como o1 de OpenAI demostrando que la inferencia misma puede escalar con más tiempo de cómputo y tokens, no sólo con el tamaño del modelo. Las arquitecturas de serving desagregado están ganando adopción, donde clústeres de hardware separados manejan las fases de pre-llenado y decodificación de la inferencia, optimizando la utilización de recursos para diferentes patrones computacionales. La decodificación especulativa y otras técnicas avanzadas de inferencia se están convirtiendo en una práctica estándar, permitiendo reducciones de latencia de 2-3 veces. La inferencia en el edge combinada con el aprendizaje federado permitirá a las organizaciones desplegar capacidades de IA localmente manteniendo la privacidad y reduciendo los requisitos de ancho de banda. Se espera que el mercado de inferencia en IA crezca a un CAGR de 19.2% hasta 2030, impulsado por la creciente adopción empresarial, nuevos casos de uso y el imperativo económico de optimizar los costos de inferencia. A medida que la inferencia se convierte en la carga de trabajo dominante en la infraestructura de IA, las técnicas de optimización, el hardware especializado y los marcos de software específicos para inferencia serán cada vez más sofisticados y esenciales para la ventaja competitiva.

El entrenamiento de IA es el proceso de enseñar a un modelo a reconocer patrones usando grandes conjuntos de datos, mientras que la inferencia es cuando ese modelo entrenado aplica lo aprendido para generar predicciones o resultados sobre nuevos datos. El entrenamiento es computacionalmente intensivo y ocurre una vez, mientras que la inferencia suele ser más rápida, menos demandante en recursos y ocurre continuamente en entornos de producción. Piensa en el entrenamiento como estudiar para un examen y la inferencia como tomar el examen en sí.

La latencia de inferencia—el tiempo que tarda un modelo en generar un resultado—es crítica para la experiencia del usuario y las aplicaciones en tiempo real. Una inferencia de baja latencia permite respuestas instantáneas en chatbots, traducción en tiempo real, vehículos autónomos y sistemas de detección de fraudes. Una latencia alta puede hacer que las aplicaciones no sean utilizables para tareas sensibles al tiempo. Las empresas optimizan la latencia mediante técnicas como cuantización, poda de modelos y hardware especializado como GPUs y TPUs para cumplir con los acuerdos de nivel de servicio.

Los tres tipos principales son: inferencia por lotes (procesamiento de grandes conjuntos de datos fuera de línea), inferencia en línea (generación de predicciones instantáneas a pedido) e inferencia en streaming (procesamiento continuo de datos de sensores o dispositivos IoT). La inferencia por lotes es ideal para escenarios como tableros analíticos diarios, la inferencia en línea impulsa chatbots y motores de búsqueda, y la inferencia en streaming habilita sistemas de monitoreo en tiempo real. Cada tipo tiene diferentes requisitos de latencia y casos de uso.

La cuantización reduce la precisión numérica de los pesos del modelo de 32 bits a 8 bits o menos, reduciendo significativamente el tamaño del modelo y los requisitos computacionales sin perder precisión. La poda elimina neuronas o conexiones no críticas de la red neuronal, reduciendo la complejidad. Ambas técnicas pueden reducir la latencia de inferencia en un 50-80% y disminuir los costos de hardware. Estos métodos de optimización son esenciales para desplegar modelos en dispositivos edge y plataformas móviles.

La inferencia es el mecanismo central que permite a los sistemas de IA generativa producir texto, imágenes y código. Cuando haces una consulta a ChatGPT, el proceso de inferencia tokeniza tu entrada, la procesa a través de las capas de la red neuronal entrenada y genera tokens de salida uno a uno. La fase de pre-llenado procesa todos los tokens de entrada simultáneamente, mientras que la fase de decodificación genera la salida de manera secuencial. Esta capacidad de inferencia es lo que hace que los grandes modelos de lenguaje sean receptivos y prácticos para aplicaciones del mundo real.

El monitoreo de inferencia rastrea cómo se desempeñan los modelos de IA en producción, incluyendo precisión, latencia y calidad de salida. Plataformas como AmICited monitorean dónde aparecen marcas y dominios en las respuestas generadas por IA en sistemas como ChatGPT, Perplexity y Google AI Overviews. Comprender el comportamiento de la inferencia ayuda a las organizaciones a asegurar que su contenido sea citado y representado correctamente cuando los sistemas de IA generan resultados que referencian sus dominios o información de marca.

Los aceleradores de inferencia más comunes incluyen GPUs (Unidades de Procesamiento Gráfico) para procesamiento en paralelo, TPUs (Unidades de Procesamiento Tensorial) optimizadas para redes neuronales, FPGAs (Arreglos de Puertas Programables en Campo) para cargas de trabajo personalizables y ASICs (Circuitos Integrados de Aplicación Específica) diseñados para tareas concretas. Las GPUs son las más utilizadas debido a su equilibrio entre rendimiento y costo, mientras que las TPUs destacan en inferencia a gran escala. La elección depende de los requisitos de rendimiento, las restricciones de latencia y el presupuesto.

El mercado global de inferencia en IA fue valorado en USD 106.15 mil millones en 2025 y se proyecta que alcance USD 254.98 mil millones para 2030, lo que representa una tasa de crecimiento anual compuesta (CAGR) del 19.2%. Este rápido crecimiento refleja la adopción creciente de aplicaciones de IA en las empresas, con un 78% de las organizaciones utilizando IA en 2024, frente al 55% en 2023. La expansión está impulsada por la demanda de aplicaciones de IA en tiempo real en industrias como salud, finanzas, comercio minorista y sistemas autónomos.

Comienza a rastrear cómo los chatbots de IA mencionan tu marca en ChatGPT, Perplexity y otras plataformas. Obtén información procesable para mejorar tu presencia en IA.

Descubre qué son las citaciones de IA, cómo funcionan en ChatGPT, Perplexity y Google AI, y por qué son importantes para la visibilidad de tu marca en motores d...

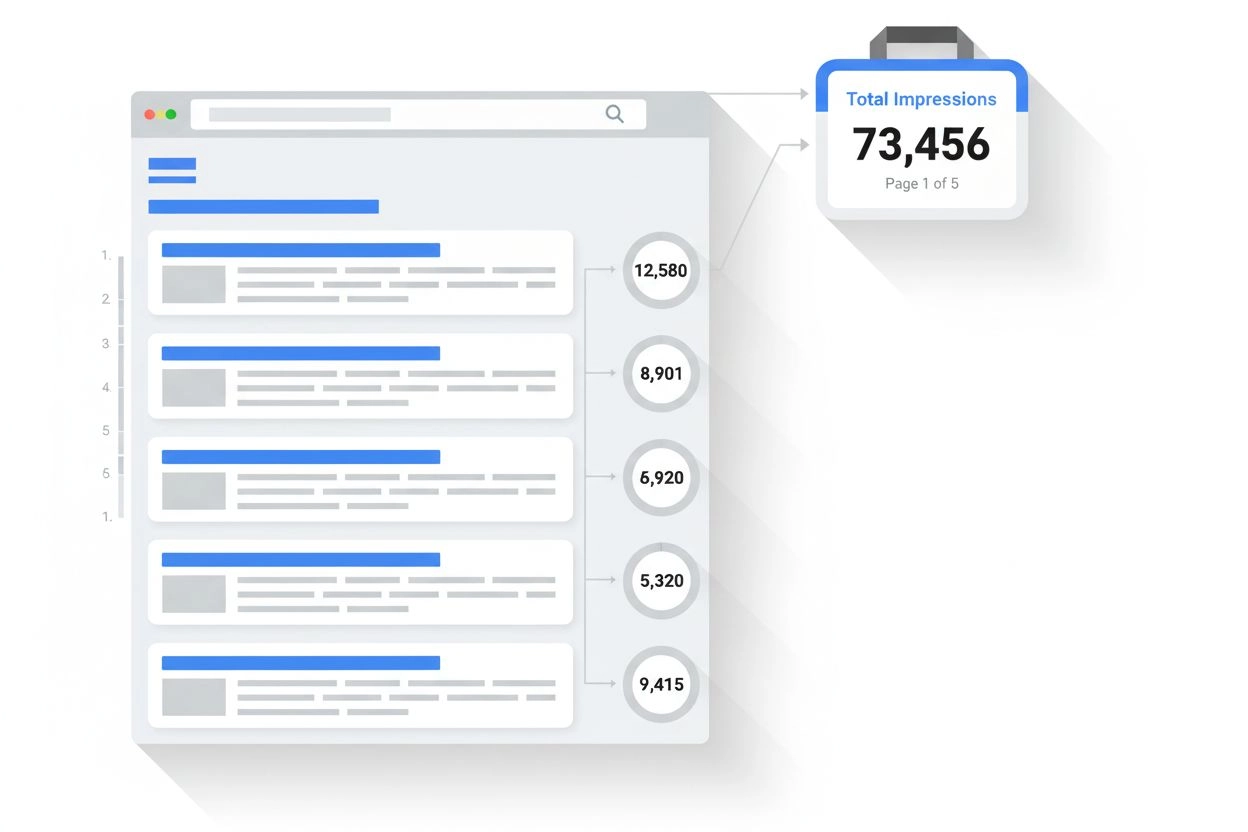

Aprende cómo las impresiones en IA difieren de las impresiones tradicionales en la búsqueda, las métricas clave a seguir y cómo medir la visibilidad de tu marca...

Descubre qué es una impresión en los resultados de búsqueda y la monitorización de IA. Entiende cómo se contabilizan las impresiones en Google Search, Perplexit...