Creando respuestas meta para LLM: Insights independientes que la IA puede citar

Aprende cómo crear respuestas meta para LLM que los sistemas de IA citen. Descubre técnicas estructurales, estrategias de densidad de respuesta y formatos de co...

Contenido que aborda directamente cómo los modelos de lenguaje podrían interpretar y responder consultas relacionadas, diseñado para mejorar la visibilidad en respuestas generadas por IA en plataformas como ChatGPT, Google AI Overviews y Perplexity. Las Respuestas Meta de LLM representan respuestas sintetizadas que combinan información de múltiples fuentes en respuestas cohesivas y conversacionales que abordan la intención del usuario.

Contenido que aborda directamente cómo los modelos de lenguaje podrían interpretar y responder consultas relacionadas, diseñado para mejorar la visibilidad en respuestas generadas por IA en plataformas como ChatGPT, Google AI Overviews y Perplexity. Las Respuestas Meta de LLM representan respuestas sintetizadas que combinan información de múltiples fuentes en respuestas cohesivas y conversacionales que abordan la intención del usuario.

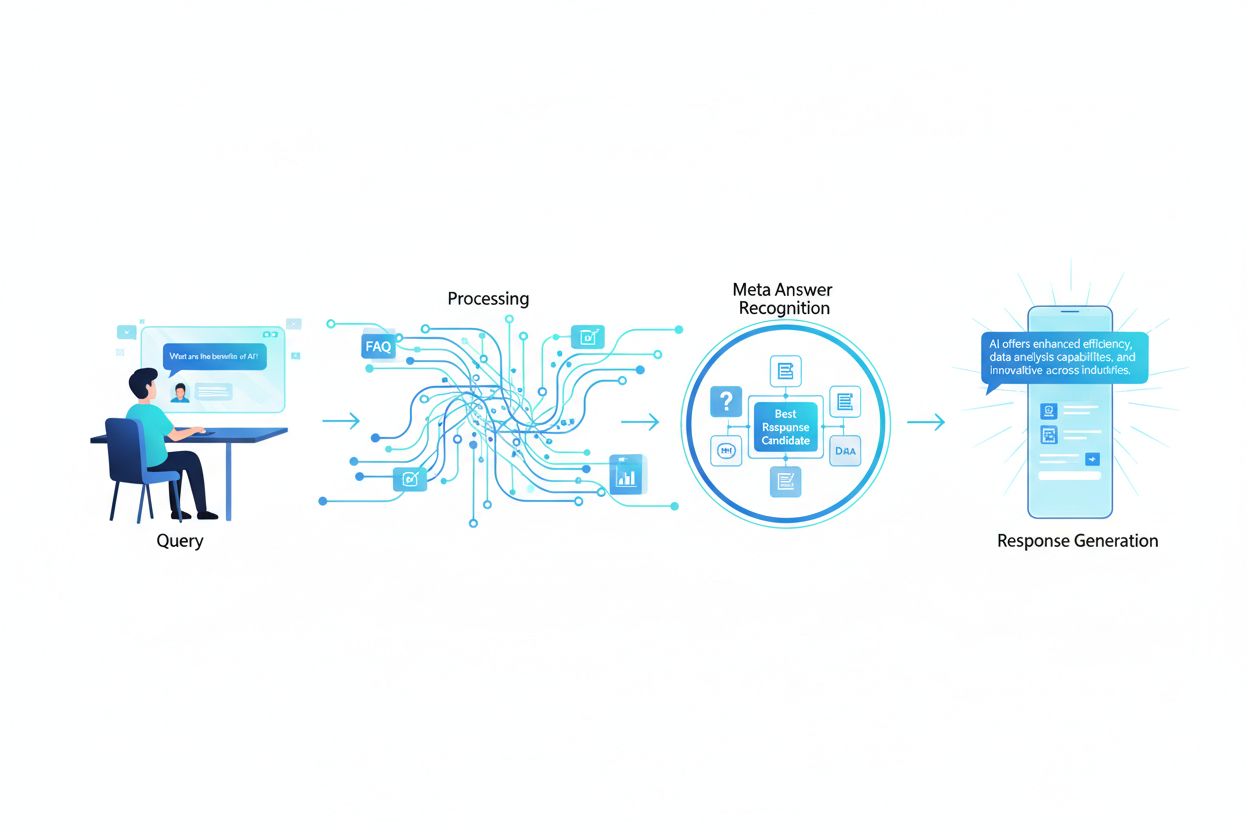

Las Respuestas Meta de LLM representan las respuestas sintetizadas y generadas por IA que producen los grandes modelos de lenguaje cuando los usuarios los consultan a través de plataformas como ChatGPT, Claude o los AI Overviews de Google. Estas respuestas son fundamentalmente diferentes de los resultados de búsqueda tradicionales porque combinan información de múltiples fuentes en una respuesta cohesiva y conversacional que aborda directamente la intención del usuario. En lugar de presentar una lista de enlaces, los LLM analizan el contenido recuperado y generan texto original que incorpora hechos, perspectivas e ideas de sus datos de entrenamiento y sistemas de generación aumentada por recuperación (RAG). Comprender cómo los LLM construyen estas respuestas meta es esencial para los creadores de contenido que desean que su trabajo sea citado y referenciado en respuestas generadas por IA. La visibilidad de tu contenido en estas respuestas de IA se ha vuelto tan importante como el posicionamiento en los resultados de búsqueda tradicionales, haciendo que la optimización para LLM (LLMO) sea un componente crítico de la estrategia de contenido moderna.

Cuando un usuario envía una consulta a un LLM, el sistema no simplemente empareja palabras clave como lo hacen los motores de búsqueda tradicionales. En cambio, los LLM realizan un análisis semántico para comprender la intención subyacente, el contexto y los matices de la pregunta. El modelo descompone la consulta en componentes conceptuales, identifica temas y entidades relacionadas, y determina qué tipo de respuesta sería más útil—ya sea una definición, comparación, guía paso a paso o perspectiva analítica. Luego, los LLM recuperan contenido relevante de su base de conocimientos utilizando sistemas RAG que priorizan fuentes según relevancia, autoridad y exhaustividad. El proceso de recuperación considera no solo coincidencias exactas de palabras clave, sino también la similitud semántica, relaciones temáticas y qué tan bien el contenido aborda los aspectos específicos de la consulta. Esto significa que tu contenido debe ser descubrible no solo por palabras clave exactas, sino por los conceptos semánticos y temas relacionados que realmente preguntan los usuarios.

| Factor de Interpretación de Consultas | Búsqueda Tradicional | Respuestas Meta de LLM |

|---|---|---|

| Método de Emparejamiento | Coincidencia de palabras clave | Comprensión semántica |

| Formato del Resultado | Lista de enlaces | Narrativa sintetizada |

| Selección de Fuente | Ranking de relevancia | Relevancia + exhaustividad + autoridad |

| Consideración de Contexto | Limitada | Contexto semántico amplio |

| Síntesis de Respuesta | El usuario debe leer múltiples fuentes | La IA combina múltiples fuentes |

| Requisito de Citación | Opcional | A menudo incluida |

Para que tu contenido sea seleccionado y citado en respuestas meta de LLM, debe poseer varias características críticas que se alinean con la forma en que estos sistemas evalúan y sintetizan la información. Primero, tu contenido debe demostrar clara experiencia y autoridad en el tema, con fuertes señales E-E-A-T (Experiencia, Especialización, Autoridad, Fiabilidad) que ayuden a los LLM a identificar fuentes confiables. Segundo, el contenido debe proporcionar verdadera ganancia de información—ideas, datos o perspectivas únicas que agreguen valor más allá de lo comúnmente disponible. Tercero, tu contenido debe estar estructurado de manera que los LLM puedan analizar y extraer información relevante fácilmente, utilizando jerarquías claras y organización lógica. Cuarto, la riqueza semántica es esencial; tu contenido debe explorar a fondo conceptos relacionados, usar terminología variada y construir autoridad temática integral en vez de enfocarse solo en palabras clave individuales. Quinto, la frescura importa especialmente para temas actuales, ya que los LLM priorizan información reciente y actualizada al sintetizar respuestas. Finalmente, tu contenido debe incluir evidencias a través de citas, datos y referencias externas que construyan confianza con los sistemas LLM.

Características clave que mejoran la citación por LLM:

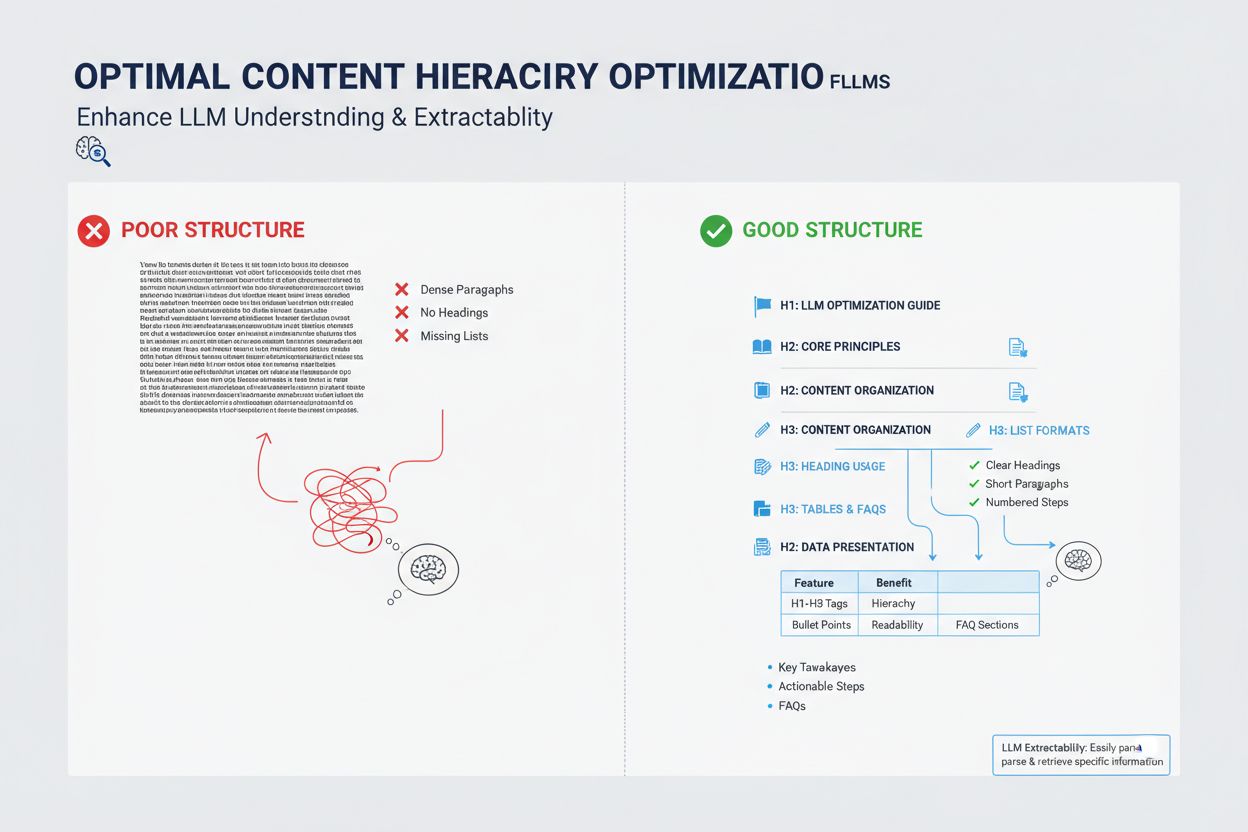

La manera en que estructuras tu contenido tiene un impacto profundo en si los LLM lo seleccionarán para respuestas meta, ya que estos sistemas están optimizados para extraer y sintetizar información bien organizada. Los LLM favorecen fuertemente el contenido con jerarquías claras de encabezados (H1, H2, H3) que crean una arquitectura lógica de información, permitiendo al modelo comprender la relación entre conceptos y extraer secciones relevantes eficientemente. Los puntos clave y listas numeradas son particularmente valiosos porque presentan información en unidades escaneables y discretas que los LLM pueden incorporar fácilmente en sus respuestas sintetizadas. Las tablas son especialmente poderosas para la visibilidad LLM porque presentan datos estructurados en un formato que es fácil de analizar y referenciar para los sistemas de IA. Los párrafos cortos (3-5 oraciones) rinden mejor que bloques densos de texto, ya que permiten a los LLM identificar y extraer información específica sin tener que leer contenido irrelevante. Además, usar marcado de esquema (FAQ, Artículo, HowTo) proporciona señales explícitas a los LLM sobre la estructura y propósito de tu contenido, mejorando significativamente la probabilidad de ser citado.

Aunque las respuestas meta de LLM y los fragmentos destacados pueden parecer similares en la superficie, representan mecanismos fundamentalmente diferentes para la visibilidad del contenido y requieren estrategias de optimización distintas. Los fragmentos destacados son seleccionados por algoritmos de búsqueda tradicionales de contenido existente en la web y se muestran en una posición específica en la página de resultados, normalmente mostrando entre 40 y 60 palabras de texto extraído. Las respuestas meta de LLM, en contraste, son respuestas generadas por IA que sintetizan información de múltiples fuentes en una narrativa nueva y original que puede ser más larga y completa que cualquier fuente individual. Los fragmentos destacados premian contenido que responde directamente a una pregunta específica de manera concisa, mientras que las respuestas meta de LLM premian contenido completo y autoritativo que ofrece una cobertura temática profunda. Los mecanismos de citación difieren considerablemente: los fragmentos destacados muestran un enlace fuente pero el contenido se extrae literalmente, mientras que las respuestas meta de LLM pueden parafrasear o sintetizar tu contenido y normalmente incluyen atribución. Además, los fragmentos destacados están principalmente optimizados para la búsqueda tradicional, mientras que las respuestas meta de LLM están optimizadas para plataformas de IA y pueden no aparecer en los resultados de búsqueda en absoluto.

| Aspecto | Fragmentos Destacados | Respuestas Meta de LLM |

|---|---|---|

| Método de Generación | El algoritmo extrae texto existente | IA sintetiza de múltiples fuentes |

| Formato de Presentación | Posición en página de resultados de búsqueda | Respuesta en plataforma de IA |

| Longitud de Contenido | Normalmente 40-60 palabras | 200-500+ palabras |

| Estilo de Citación | Enlace fuente con texto extraído | Atribución con contenido parafraseado |

| Enfoque de Optimización | Respuestas concisas y directas | Autoridad y cobertura integral |

| Plataforma | Búsqueda de Google | ChatGPT, Claude, Google AI Overviews |

| Métrica de Visibilidad | Impresiones de búsqueda | Citaciones en respuestas de IA |

La riqueza semántica—la profundidad y amplitud de la cobertura conceptual en tu contenido—es uno de los factores más importantes pero a menudo pasados por alto en la optimización para LLM. Los LLM no buscan solo tu palabra clave objetivo; analizan las relaciones semánticas entre conceptos, la información contextual alrededor de tu tema principal, y cuán a fondo exploras ideas relacionadas. El contenido con alta riqueza semántica utiliza terminología variada, explora múltiples ángulos de un tema y construye conexiones entre conceptos relacionados, lo que ayuda a los LLM a comprender que tu contenido es genuinamente autoritativo en vez de estar optimizado superficialmente por palabras clave. Cuando escribas sobre un tema, incluye términos relacionados, sinónimos e ideas conceptualmente adyacentes que ayuden a los LLM a ubicar tu contenido dentro de un grafo de conocimiento más amplio. Por ejemplo, un artículo sobre “marketing de contenidos” debe incorporar naturalmente discusiones sobre segmentación de audiencia, buyer personas, distribución de contenidos, analítica y ROI—no porque estés forzando palabras clave, sino porque estos conceptos son semánticamente relacionados y esenciales para comprender el tema de manera integral. Esta profundidad semántica señala a los LLM que tienes verdadera experiencia y puedes proveer el tipo de respuestas matizadas y multifacéticas que buscan los usuarios.

Los LLM evalúan la autoridad de manera diferente a los motores de búsqueda tradicionales, poniendo mayor énfasis en señales que indican experiencia genuina y confiabilidad en vez de solo popularidad de enlaces. Las credenciales del autor y la experiencia demostrada son particularmente importantes; los LLM favorecen contenido de expertos reconocidos, practicantes u organizaciones con autoridad establecida en su campo. Las citas externas y referencias a otras fuentes autorizadas construyen credibilidad ante los sistemas LLM, ya que demuestran que tu contenido está fundamentado en conocimiento más amplio y corroborado por otros expertos. La consistencia a través de múltiples piezas de contenido sobre un tema ayuda a establecer autoridad temática; los LLM reconocen cuando un autor u organización ha publicado varias piezas completas sobre temas relacionados. La validación de terceros mediante menciones, citas o referencias de otras fuentes autoritativas incrementa significativamente tu visibilidad en respuestas meta de LLM. La investigación original, datos propios o metodologías únicas ofrecen potentes señales de autoridad porque representan información que no se puede encontrar en otras partes. Además, mantener un historial de publicaciones actualizado y refrescar el contenido regularmente indica que estás activamente comprometido con el tema y al día con los desarrollos.

Señales de autoridad que influyen en la selección de LLM:

La frescura del contenido se ha vuelto cada vez más crítica para la visibilidad en LLM, especialmente para temas donde la información cambia con frecuencia o donde desarrollos recientes impactan significativamente la respuesta. Los LLM están entrenados con datos que tienen fechas límite de conocimiento, pero dependen cada vez más de sistemas RAG que recuperan información actual de la web, lo que significa que la fecha de publicación y la frecuencia de actualización de tu contenido influyen directamente en si es seleccionado para respuestas meta. Para temas evergreen, actualizaciones regulares—aunque sean menores que refresquen la fecha de publicación—señalan a los LLM que tu contenido está activamente mantenido y es confiable. Para temas sensibles al tiempo como tendencias de la industria, actualizaciones tecnológicas o eventos actuales, los LLM despriorizan activamente contenido desactualizado en favor de fuentes más recientes. La mejor práctica es establecer un calendario de mantenimiento de contenido donde revises y actualices piezas clave trimestral o semestralmente, refrescando estadísticas, agregando nuevos ejemplos e incorporando desarrollos recientes. Este mantenimiento continuo no solo mejora tu visibilidad LLM sino que también demuestra tanto a los sistemas de IA como a los lectores humanos que eres una fuente actual y confiable de información.

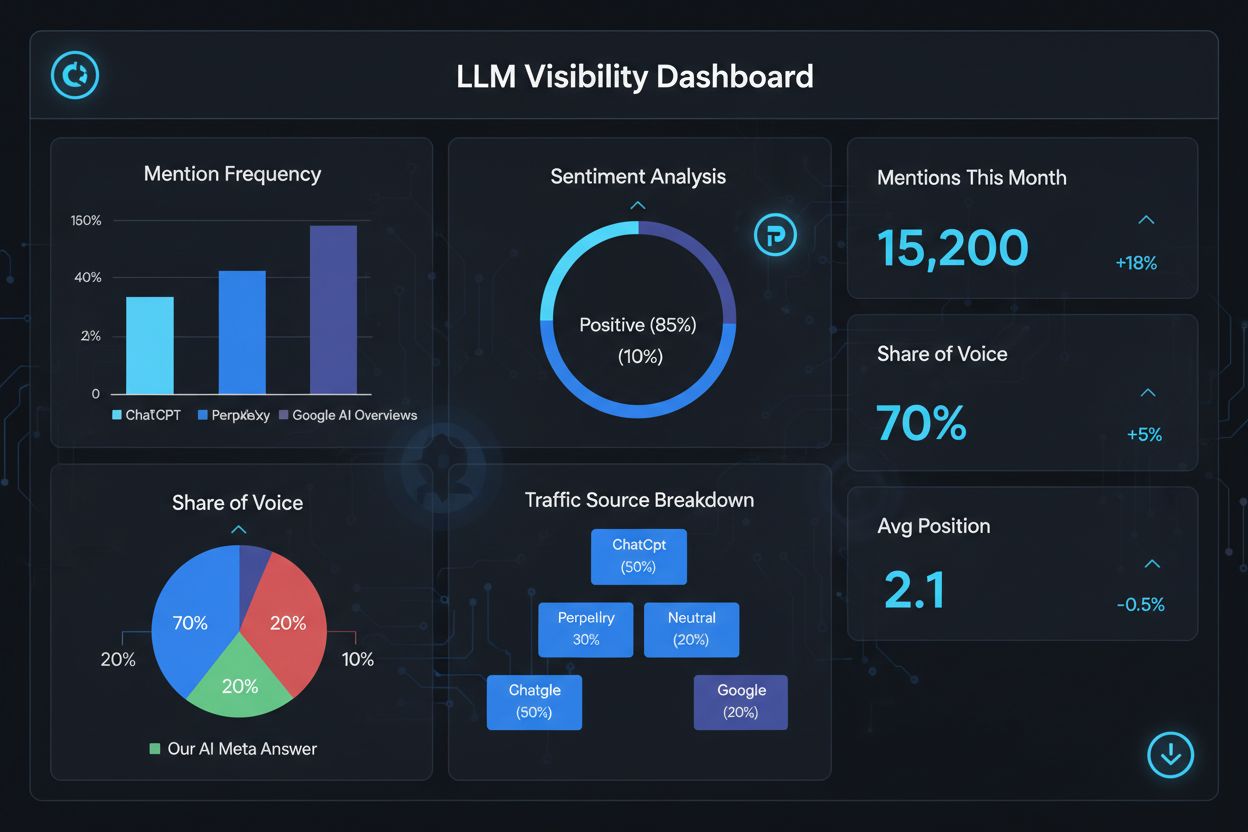

Medir tu éxito en respuestas meta de LLM requiere métricas y herramientas diferentes al SEO tradicional, ya que estas respuestas existen fuera del ecosistema tradicional de resultados de búsqueda. Herramientas como AmICited.com ofrecen monitoreo especializado que rastrea cuándo y dónde aparece tu contenido en respuestas generadas por IA, dándote visibilidad sobre qué piezas están siendo citadas y con qué frecuencia. Debes monitorear varias métricas clave: frecuencia de citación (con qué frecuencia tu contenido aparece en respuestas LLM), contexto de citación (qué temas disparan la inclusión de tu contenido), diversidad de fuentes (si eres citado en diferentes plataformas LLM) y posicionamiento de la respuesta (si tu contenido es destacado prominentemente en la respuesta sintetizada). Rastrea qué páginas o secciones específicas de tu contenido son citadas con más frecuencia, ya que esto revela qué tipo de información consideran más valiosa y confiable los LLM. Monitorea los cambios en tus patrones de citación con el tiempo para identificar qué esfuerzos de optimización están funcionando y qué temas necesitan desarrollo adicional. Además, analiza las consultas que disparan tus citaciones para entender cómo los LLM interpretan la intención del usuario y qué variaciones semánticas son más efectivas.

Métricas clave para el desempeño de respuestas meta de LLM:

Optimizar para respuestas meta de LLM requiere un enfoque estratégico que combine implementación técnica, calidad de contenido y medición continua. Comienza realizando una investigación temática integral para identificar brechas donde tu experiencia puede aportar valor único que los LLM priorizarán sobre fuentes genéricas. Estructura tu contenido con jerarquías claras, usando encabezados H2 y H3 para crear una arquitectura lógica de información que los LLM puedan analizar y extraer fácilmente. Implementa marcado de esquema (FAQ, Artículo, HowTo) para señalar explícitamente la estructura y propósito de tu contenido a los sistemas LLM, mejorando significativamente la descubribilidad. Desarrolla contenido completo y autoritativo que explore a fondo tu tema desde múltiples ángulos, incorporando conceptos relacionados y construyendo riqueza semántica que demuestre verdadera experiencia. Incluye investigaciones, datos o ideas originales que aporten ganancia de información y diferencien tu contenido de la competencia. Mantén un calendario regular de actualización de contenido, refrescando piezas clave trimestralmente para asegurar frescura y señalar autoridad continua. Construye autoridad temática creando múltiples piezas relacionadas que en conjunto establecen tu experiencia en un área temática. Utiliza lenguaje claro y directo que responda preguntas específicas que los usuarios están haciendo, facilitando la extracción y síntesis de tu contenido por parte de los LLM. Finalmente, monitorea tu desempeño de citaciones LLM usando herramientas especializadas para identificar qué funciona y refinar continuamente tu estrategia basada en información orientada a datos.

Las Respuestas Meta de LLM se enfocan en cómo los modelos de lenguaje interpretan y citan el contenido, mientras que el SEO tradicional se centra en el posicionamiento en los resultados de búsqueda. Los LLM priorizan la relevancia y claridad sobre la autoridad de dominio, haciendo que el contenido bien estructurado y que responde primero sea más importante que los backlinks. Tu contenido puede ser citado en respuestas de LLM incluso si no aparece en los primeros resultados de Google.

Estructura el contenido con encabezados claros, proporciona respuestas directas al principio, usa marcado de esquema (FAQ, Artículo), incluye citas y estadísticas, mantén autoridad temática y asegúrate de que tu sitio sea rastreable por bots de IA. Enfócate en la riqueza semántica, ganancia de información y cobertura temática integral en lugar de un enfoque estrecho en palabras clave.

Los LLM extraen fragmentos de contenido bien organizado con mayor facilidad. Encabezados claros, listas, tablas y párrafos cortos ayudan a los modelos a identificar y citar información relevante. Estudios muestran que las páginas citadas por LLM tienen significativamente más elementos estructurados que el promedio de páginas web, haciendo de la estructura un factor crítico de posicionamiento.

Sí. A diferencia del SEO tradicional, los LLM priorizan la relevancia de la consulta y la calidad del contenido sobre la autoridad de dominio. Una página de nicho bien estructurada y altamente relevante puede ser citada por LLM incluso si no aparece en los primeros resultados de Google, haciendo que la experiencia y claridad sean más importantes que la autoridad del sitio.

Actualiza el contenido regularmente, especialmente para temas sensibles al tiempo. Agrega marcas de tiempo que muestren cuándo se actualizó el contenido por última vez. Para temas evergreen, se recomiendan revisiones trimestrales. El contenido fresco indica precisión para los LLM, mejorando la probabilidad de cita y demostrando autoridad continua.

AmICited.com se especializa en monitoreo de menciones de IA en ChatGPT, Perplexity y Google AI Overviews. Otras herramientas incluyen el AI SEO Toolkit de Semrush, Ahrefs Brand Radar y Peec AI. Estas herramientas rastrean la frecuencia de menciones, share of voice, sentimiento y te ayudan a medir el éxito de la optimización.

El marcado de esquema (FAQ, Artículo, HowTo) proporciona una estructura legible para máquinas que ayuda a los LLM a entender y extraer el contenido con mayor precisión. Señala el tipo e intención del contenido, haciendo más probable que tu página sea seleccionada para consultas relevantes y mejorando la descubribilidad general.

Las menciones externas en sitios de alta autoridad (noticias, Wikipedia, publicaciones de la industria) construyen credibilidad y aumentan las probabilidades de que los LLM citen tu contenido. Múltiples fuentes independientes mencionando tu marca o datos crean un patrón de autoridad que los LLM reconocen y recompensan con mayor frecuencia de citación.

Haz seguimiento de cómo aparece tu marca en respuestas generadas por IA en ChatGPT, Perplexity y Google AI Overviews con la plataforma de monitoreo especializada de AmICited.

Aprende cómo crear respuestas meta para LLM que los sistemas de IA citen. Descubre técnicas estructurales, estrategias de densidad de respuesta y formatos de co...

Descubre cómo los LLMs generan respuestas mediante la tokenización, arquitectura transformer, mecanismos de atención y predicción probabilística. Conoce el proc...

Aprende cómo identificar y dirigir sitios fuente de LLM para backlinks estratégicos. Descubre qué plataformas de IA citan más fuentes y optimiza tu estrategia d...