Análisis de rastreo de IA

Descubre qué es el análisis de rastreo de IA y cómo el análisis de registros del servidor rastrea el comportamiento de los rastreadores de IA, los patrones de a...

El análisis de archivos de registro es el proceso de examinar los registros de acceso del servidor para comprender cómo los rastreadores de motores de búsqueda y los bots de IA interactúan con un sitio web, revelando patrones de rastreo, problemas técnicos y oportunidades de optimización para el rendimiento SEO.

El análisis de archivos de registro es el proceso de examinar los registros de acceso del servidor para comprender cómo los rastreadores de motores de búsqueda y los bots de IA interactúan con un sitio web, revelando patrones de rastreo, problemas técnicos y oportunidades de optimización para el rendimiento SEO.

El análisis de archivos de registro es el examen sistemático de los registros de acceso del servidor para comprender cómo los rastreadores de motores de búsqueda, los bots de IA y los usuarios interactúan con un sitio web. Estos registros son generados automáticamente por los servidores web y contienen registros detallados de cada solicitud HTTP realizada a tu sitio, incluyendo la dirección IP del solicitante, la marca de tiempo, la URL solicitada, el código de estado HTTP y la cadena user-agent. Para los profesionales de SEO, el análisis de archivos de registro sirve como la fuente definitiva de la verdad sobre el comportamiento de los rastreadores, revelando patrones que herramientas superficiales como Google Search Console o los rastreadores tradicionales no pueden captar. A diferencia de los rastreos simulados o los datos analíticos agregados, los registros del servidor proporcionan evidencia sin filtrar y de primera mano de exactamente lo que los motores de búsqueda y los sistemas de IA están haciendo en tu sitio web en tiempo real.

La importancia del análisis de archivos de registro ha crecido exponencialmente a medida que el panorama digital ha evolucionado. Con más del 51% del tráfico global de Internet ahora generado por bots (ACS, 2025), y rastreadores de IA como GPTBot, ClaudeBot y PerplexityBot convirtiéndose en visitantes habituales de los sitios web, entender el comportamiento de los rastreadores ya no es opcional: es esencial para mantener la visibilidad tanto en la búsqueda tradicional como en las plataformas emergentes de búsqueda impulsadas por IA. El análisis de archivos de registro cierra la brecha entre lo que crees que está sucediendo en tu sitio y lo que realmente ocurre, permitiendo decisiones basadas en datos que impactan directamente en los rankings de búsqueda, la velocidad de indexación y el rendimiento orgánico general.

El análisis de archivos de registro ha sido un pilar del SEO técnico durante décadas, pero su relevancia se ha intensificado drásticamente en los últimos años. Históricamente, los profesionales de SEO dependían principalmente de Google Search Console y rastreadores de terceros para entender el comportamiento de los motores de búsqueda. Sin embargo, estas herramientas tienen limitaciones significativas: Google Search Console solo proporciona datos agregados y muestreados de los rastreadores de Google; los rastreadores de terceros simulan el comportamiento de los rastreadores en lugar de captar interacciones reales; y ninguna de las dos herramientas rastrea motores de búsqueda que no sean de Google ni bots de IA de manera efectiva.

La aparición de plataformas de búsqueda impulsadas por IA ha cambiado fundamentalmente el panorama. Según la investigación de Cloudflare en 2024, Googlebot representa el 39% de todo el tráfico de rastreadores de IA y búsqueda, mientras que los rastreadores específicos de IA ahora constituyen el segmento de más rápido crecimiento. Los bots de IA de Meta por sí solos generan el 52% del tráfico de rastreadores de IA, más del doble que Google (23%) u OpenAI (20%). Este cambio significa que los sitios web ahora reciben visitas de docenas de tipos diferentes de bots, muchos de los cuales no siguen los protocolos SEO tradicionales ni respetan las reglas estándar de robots.txt. El análisis de archivos de registro es el único método que captura este panorama completo, haciéndolo indispensable para la estrategia SEO moderna.

El mercado global de gestión de registros tiene una proyección de crecimiento desde $3,228.5 millones en 2025 a valoraciones significativamente más altas para 2029, expandiéndose a una tasa de crecimiento anual compuesta (CAGR) del 14.6%. Este crecimiento refleja el reconocimiento empresarial creciente de que el análisis de registros es crítico para la seguridad, el monitoreo del rendimiento y la optimización SEO. Las organizaciones están invirtiendo fuertemente en herramientas automatizadas de análisis de registros y plataformas impulsadas por IA que pueden procesar millones de entradas de registros en tiempo real, transformando datos sin procesar en insights accionables que impulsan resultados de negocio.

Cuando un usuario o un bot solicita una página en tu sitio web, el servidor web procesa esa solicitud y registra información detallada sobre la interacción. Este proceso ocurre automáticamente y de manera continua, creando una pista de auditoría completa de toda la actividad del servidor. Entender cómo funciona esto es esencial para interpretar correctamente los datos de los archivos de registro.

El flujo típico comienza cuando un rastreador (ya sea Googlebot, un bot de IA o el navegador de un usuario) envía una solicitud HTTP GET a tu servidor, incluyendo una cadena user-agent que identifica al solicitante. Tu servidor recibe esta solicitud, la procesa y devuelve un código de estado HTTP (200 para éxito, 404 para no encontrado, 301 para redirección permanente, etc.) junto con el contenido solicitado. Cada una de estas interacciones se registra en el archivo de acceso del servidor, creando una entrada con marca de tiempo que captura la dirección IP, la URL solicitada, el método HTTP, el código de estado, el tamaño de la respuesta, el referer y la cadena user-agent.

Los códigos de estado HTTP son especialmente importantes para el análisis SEO. Un código 200 indica entrega exitosa de la página; los códigos 3xx indican redirecciones; los códigos 4xx indican errores del cliente (como 404 No Encontrado); y los códigos 5xx indican errores del servidor. Al analizar la distribución de estos códigos en tus registros, puedes identificar problemas técnicos que impiden que los rastreadores accedan a tu contenido. Por ejemplo, si un rastreador recibe múltiples respuestas 404 al intentar acceder a páginas importantes, esto indica un enlace roto o un problema de contenido faltante que requiere atención inmediata.

Las cadenas user-agent son igualmente críticas para identificar qué bots visitan tu sitio. Cada rastreador tiene una cadena user-agent única que lo identifica. El user-agent de Googlebot incluye “Googlebot/2.1”, mientras que el de GPTBot incluye “GPTBot/1.0”, y el de ClaudeBot incluye “ClaudeBot”. Al analizar estas cadenas, puedes segmentar tus datos de registro para analizar el comportamiento por tipo específico de rastreador, revelando qué bots priorizan qué contenido y cómo difieren sus patrones de rastreo. Este análisis granular permite estrategias de optimización dirigidas para diferentes plataformas de búsqueda y sistemas de IA.

| Aspecto | Análisis de Archivos de Registro | Google Search Console | Rastreadores de Terceros | Herramientas de Analítica |

|---|---|---|---|---|

| Fuente de Datos | Registros del servidor (primera parte) | Datos de rastreo de Google | Rastreo simulado | Seguimiento del comportamiento del usuario |

| Integridad | 100% de todas las solicitudes | Datos agregados y muestreados | Solo simulado | Solo tráfico humano |

| Cobertura de Bots | Todos los rastreadores (Google, Bing, bots de IA) | Solo Google | Rastreadores simulados | Sin datos de bots |

| Datos Históricos | Historial completo (varía retención) | Periodo limitado | Instantánea de rastreo único | Histórico disponible |

| Insights en Tiempo Real | Sí (con automatización) | Reporte retrasado | No | Reporte retrasado |

| Visibilidad del Presupuesto de Rastreo | Patrones de rastreo exactos | Resumen de alto nivel | Estimado | No aplica |

| Problemas Técnicos | Detallado (códigos de estado, tiempos de respuesta) | Visibilidad limitada | Problemas simulados | No aplica |

| Seguimiento de Bots de IA | Sí (GPTBot, ClaudeBot, etc.) | No | No | No |

| Costo | Gratis (registros del servidor) | Gratis | Herramientas de pago | Gratis/Pago |

| Complejidad de Implementación | Moderada a alta | Simple | Simple | Simple |

El análisis de archivos de registro se ha vuelto indispensable para entender cómo los motores de búsqueda y los sistemas de IA interactúan con tu sitio web. A diferencia de Google Search Console, que solo proporciona la perspectiva de Google y datos agregados, los archivos de registro capturan el panorama completo de toda la actividad de los rastreadores. Esta visión integral es esencial para identificar el desperdicio de presupuesto de rastreo, donde los motores de búsqueda gastan recursos rastreando páginas de bajo valor en lugar de contenido importante. La investigación muestra que los sitios grandes suelen desperdiciar entre el 30% y el 50% de su presupuesto de rastreo en URLs no esenciales como archivos paginados, navegación facetada o contenido desactualizado.

El auge de la búsqueda impulsada por IA ha hecho que el análisis de archivos de registro sea aún más crucial. A medida que bots de IA como GPTBot, ClaudeBot y PerplexityBot se convierten en visitantes habituales de los sitios web, entender su comportamiento es esencial para optimizar la visibilidad en respuestas generadas por IA. Estos bots a menudo se comportan de manera diferente a los rastreadores tradicionales: pueden ignorar las reglas de robots.txt, rastrear de forma más agresiva o enfocarse en tipos de contenido específicos. El análisis de archivos de registro es el único método que revela estos patrones, permitiéndote optimizar tu sitio para el descubrimiento por IA mientras gestionas el acceso de bots mediante reglas específicas.

Los problemas técnicos de SEO que de otro modo pasarían desapercibidos pueden identificarse mediante el análisis de registros. Las cadenas de redirección, los errores de servidor 5xx, los tiempos de carga lentos y los problemas de renderizado JavaScript dejan rastros en los registros del servidor. Al analizar estos patrones, puedes priorizar correcciones que impactan directamente en la accesibilidad e indexación por parte de los motores de búsqueda. Por ejemplo, si los registros muestran que Googlebot recibe consistentemente errores 503 Service Unavailable al rastrear una sección específica de tu sitio, sabes exactamente dónde enfocar tus esfuerzos técnicos.

Obtener tus registros del servidor es el primer paso en el análisis de archivos de registro, pero el proceso varía según tu entorno de hosting. Para servidores autoadministrados que ejecutan Apache o NGINX, los registros suelen almacenarse en /var/log/apache2/access.log o /var/log/nginx/access.log respectivamente. Puedes acceder a estos archivos directamente mediante SSH o a través del gestor de archivos de tu servidor. Para hosts de WordPress gestionados como WP Engine o Kinsta, los registros pueden estar disponibles a través del panel de control de hosting o mediante SFTP, aunque algunos proveedores restringen el acceso para proteger el rendimiento del servidor.

Las Redes de Distribución de Contenido (CDN) como Cloudflare, AWS CloudFront y Akamai requieren configuración especial para acceder a los registros. Cloudflare ofrece Logpush, que envía registros de solicitudes HTTP a buckets de almacenamiento designados (AWS S3, Google Cloud Storage, Azure Blob Storage) para su recuperación y análisis. AWS CloudFront proporciona registros estándar que pueden configurarse para almacenarse en buckets S3. Estos registros de CDN son esenciales para comprender cómo interactúan los bots con tu sitio cuando el contenido se sirve a través de una CDN, ya que capturan las solicitudes en el edge en lugar del servidor de origen.

Los entornos de hosting compartido a menudo tienen acceso limitado a los registros. Proveedores como Bluehost y GoDaddy pueden ofrecer registros parciales a través de cPanel, pero estos registros suelen rotar con frecuencia y pueden excluir campos críticos. Si estás en hosting compartido y necesitas un análisis de registros integral, considera actualizar a un VPS o una solución de hosting gestionado que proporcione acceso completo a los registros.

Una vez que hayas obtenido tus registros, la preparación de los datos es esencial. Los archivos de registro en bruto contienen solicitudes de todas las fuentes: usuarios, bots, scrapers y actores maliciosos. Para el análisis SEO, querrás filtrar el tráfico no relevante y enfocarte en la actividad de motores de búsqueda y bots de IA. Esto normalmente implica:

El análisis de archivos de registro descubre insights que son invisibles para otras herramientas SEO, proporcionando la base para decisiones de optimización estratégica. Uno de los insights más valiosos es el análisis de patrones de rastreo, que muestra exactamente qué páginas visitan los motores de búsqueda y con qué frecuencia. Al rastrear la frecuencia de rastreo a lo largo del tiempo, puedes identificar si Google está aumentando o disminuyendo la atención a secciones específicas de tu sitio. Caídas repentinas pueden indicar problemas técnicos o cambios en la importancia percibida de las páginas, mientras que los aumentos sugieren que Google responde positivamente a tus esfuerzos de optimización.

La eficiencia del presupuesto de rastreo es otro insight crítico. Analizando la proporción de respuestas exitosas (2xx) frente a respuestas de error (4xx, 5xx), puedes identificar secciones de tu sitio donde los rastreadores encuentran problemas. Si un directorio específico devuelve constantemente errores 404, está desperdiciando presupuesto de rastreo en enlaces rotos. De igual manera, si los rastreadores pasan mucho tiempo en URLs paginadas o navegación facetada, estás desperdiciando presupuesto en contenido de bajo valor. El análisis de registros cuantifica este desperdicio, permitiéndote calcular el impacto potencial de los esfuerzos de optimización.

El descubrimiento de páginas huérfanas es una ventaja única del análisis de archivos de registro. Las páginas huérfanas son URLs sin enlaces internos que existen fuera de la estructura del sitio. Los rastreadores tradicionales suelen pasar por alto estas páginas porque no pueden descubrirlas mediante el enlazado interno. Sin embargo, los archivos de registro revelan que los motores de búsqueda aún las rastrean—muchas veces porque están enlazadas externamente o existen en sitemaps antiguos. Al identificar estas páginas huérfanas, puedes decidir si reintegrarlas a tu estructura de sitio, redirigirlas o eliminarlas completamente.

El análisis del comportamiento de bots de IA es cada vez más importante. Al segmentar datos de registros por user-agents de bots de IA, puedes ver qué contenido priorizan estos bots, con qué frecuencia visitan y si encuentran barreras técnicas. Por ejemplo, si GPTBot rastrea consistentemente tus páginas de Preguntas Frecuentes pero rara vez visita tu blog, sugiere que los sistemas de IA consideran el contenido tipo FAQ más valioso para datos de entrenamiento. Este insight puede informar tu estrategia de contenidos y ayudarte a optimizar la visibilidad en IA.

El éxito en el análisis de archivos de registro requiere tanto las herramientas adecuadas como un enfoque estratégico. Log File Analyzer de Screaming Frog es una de las herramientas dedicadas más populares, ofreciendo interfaces fáciles de usar para procesar grandes archivos de registro, identificar patrones de bots y visualizar datos de rastreo. Botify proporciona análisis de registros a nivel empresarial integrado con métricas SEO, permitiéndote correlacionar la actividad de bots con rankings y tráfico. Bot Clarity de seoClarity integra el análisis de registros directamente en la plataforma SEO, facilitando la conexión de datos de rastreo con otras métricas SEO.

Para organizaciones con tráfico de alto volumen o infraestructuras complejas, plataformas de análisis de registros impulsadas por IA como Splunk, Sumo Logic y Elastic Stack ofrecen capacidades avanzadas que incluyen reconocimiento automatizado de patrones, detección de anomalías y analítica predictiva. Estas plataformas pueden procesar millones de entradas en tiempo real, identificando automáticamente nuevos tipos de bots y señalando actividad inusual que podría indicar amenazas de seguridad o problemas técnicos.

Las mejores prácticas para el análisis de archivos de registro incluyen:

A medida que la búsqueda impulsada por IA cobra mayor importancia, el monitoreo de bots de IA mediante el análisis de archivos de registro se ha convertido en una función SEO crítica. Al rastrear qué bots de IA visitan tu sitio, qué contenido acceden y con qué frecuencia rastrean, puedes entender cómo tu contenido alimenta herramientas de búsqueda con IA y modelos generativos. Estos datos te permiten tomar decisiones informadas sobre permitir, bloquear o limitar bots de IA específicos mediante reglas en robots.txt o encabezados HTTP.

La optimización del presupuesto de rastreo es quizás la aplicación más impactante del análisis de archivos de registro. Para sitios grandes con miles o millones de páginas, el presupuesto de rastreo es un recurso finito. Analizando los registros, puedes identificar páginas que están siendo rastreadas en exceso respecto a su importancia, y páginas que deberían rastrearse más frecuentemente pero no lo están. Escenarios comunes de desperdicio de presupuesto de rastreo incluyen:

Al abordar estos problemas—mediante reglas en robots.txt, canónicos, etiquetas noindex o correcciones técnicas—puedes redirigir el presupuesto de rastreo hacia el contenido de mayor valor, mejorando la velocidad de indexación y la visibilidad en búsqueda de las páginas que más importan para tu negocio.

El futuro del análisis de archivos de registro está siendo moldeado por la rápida evolución de la búsqueda impulsada por IA. A medida que más bots de IA ingresan al ecosistema y su comportamiento se vuelve más sofisticado, el análisis de registros será aún más crítico para entender cómo tu contenido es descubierto, accedido y utilizado por los sistemas de IA. Las tendencias emergentes incluyen:

El análisis de registros en tiempo real impulsado por machine learning permitirá a los SEOs detectar y responder a problemas de rastreo en minutos en lugar de días. Los sistemas automatizados identificarán nuevos tipos de bots, señalarán patrones inusuales y sugerirán acciones de optimización sin intervención manual. Este cambio de un análisis reactivo a uno proactivo permitirá a los SEOs mantener una rastreabilidad e indexación óptimas de forma continua.

La integración con el seguimiento de visibilidad en IA conectará los datos de archivos de registro con métricas de rendimiento en búsqueda con IA. En lugar de analizar los registros de forma aislada, los SEOs correlacionarán el comportamiento de los rastreadores con la visibilidad real en respuestas generadas por IA, entendiendo exactamente cómo los patrones de rastreo impactan en los rankings de búsqueda en IA. Esta integración proporcionará un insight sin precedentes sobre cómo el contenido fluye desde el rastreo hasta los datos de entrenamiento de IA y las respuestas de IA visibles para el usuario.

La gestión ética de bots cobrará cada vez más importancia a medida que las organizaciones debatan sobre qué bots de IA deben tener acceso a su contenido. El análisis de archivos de registro permitirá un control granular sobre el acceso de bots, permitiendo a los editores permitir rastreadores de IA beneficiosos mientras bloquean aquellos que no aportan valor o atribución. Estándares como el emergente protocolo LLMs.txt proporcionarán formas estructuradas de comunicar políticas de acceso para bots, y el análisis de registros verificará el cumplimiento.

El análisis preservando la privacidad evolucionará para equilibrar la necesidad de insights detallados de rastreo con regulaciones de privacidad como GDPR. Técnicas avanzadas de anonimización y herramientas de análisis centradas en la privacidad permitirán a las organizaciones extraer insights valiosos de los registros sin almacenar ni exponer información personal identificable. Esto será especialmente importante a medida que el análisis de registros se generalice y las regulaciones de protección de datos se vuelvan más estrictas.

La convergencia del SEO tradicional y la optimización para la búsqueda con IA significa que el análisis de archivos de registro seguirá siendo un pilar de la estrategia SEO técnica durante muchos años. Las organizaciones que dominen el análisis de registros hoy estarán mejor posicionadas para mantener visibilidad y rendimiento a medida que la búsqueda continúe evolucionando.

El análisis de archivos de registro proporciona datos completos y no muestreados desde tu servidor que capturan cada solicitud de todos los rastreadores, mientras que las estadísticas de rastreo de Google Search Console solo muestran datos agregados y muestreados de los rastreadores de Google. Los archivos de registro ofrecen datos históricos granulares e información sobre el comportamiento de bots que no son de Google, incluidos bots de IA como GPTBot y ClaudeBot, lo que los hace más completos para comprender el verdadero comportamiento de los rastreadores e identificar problemas técnicos que GSC puede pasar por alto.

Para sitios de alto tráfico, se recomienda un análisis semanal de archivos de registro para detectar problemas temprano y monitorear cambios en los patrones de rastreo. Los sitios más pequeños se benefician de revisiones mensuales para establecer tendencias e identificar nueva actividad de bots. Independientemente del tamaño del sitio, implementar monitoreo continuo mediante herramientas automatizadas ayuda a detectar anomalías en tiempo real, asegurando que puedas responder rápidamente a desperdicio de presupuesto de rastreo o problemas técnicos que afecten la visibilidad en búsquedas.

Sí, el análisis de archivos de registro es una de las formas más efectivas de rastrear el tráfico de bots de IA. Al examinar las cadenas de user-agent y las direcciones IP en tus registros de servidor, puedes identificar qué bots de IA visitan tu sitio, qué contenido acceden y con qué frecuencia rastrean. Estos datos son cruciales para entender cómo tu contenido alimenta herramientas de búsqueda impulsadas por IA y modelos de IA generativa, permitiéndote optimizar la visibilidad en IA y gestionar el acceso de bots mediante reglas en robots.txt.

El análisis de archivos de registro revela numerosos problemas técnicos de SEO, incluidos errores de rastreo (códigos de estado 4xx y 5xx), cadenas de redirección, tiempos de carga lentos, páginas huérfanas no enlazadas internamente, desperdicio de presupuesto de rastreo en URLs de bajo valor, problemas de renderizado JavaScript y problemas de contenido duplicado. También identifica actividad de bots falsificados y ayuda a detectar cuando los rastreadores legítimos encuentran barreras de accesibilidad, lo que te permite priorizar correcciones que impactan directamente en la visibilidad e indexación en motores de búsqueda.

El análisis de archivos de registro muestra exactamente qué páginas rastrean los motores de búsqueda y con qué frecuencia, revelando dónde se está desperdiciando el presupuesto de rastreo en contenido de bajo valor como archivos paginados, navegación facetada o URLs desactualizadas. Al identificar estas ineficiencias, puedes ajustar tu archivo robots.txt, mejorar el enlazado interno hacia páginas prioritarias e implementar canónicos para redirigir la atención de rastreo hacia contenido de alto valor, asegurando que los motores de búsqueda se enfoquen en las páginas que más importan para tu negocio.

Los archivos de registro del servidor suelen capturar direcciones IP (identificando la fuente de la solicitud), marcas de tiempo (cuándo ocurrieron las solicitudes), métodos HTTP (generalmente GET o POST), URLs solicitadas (páginas exactas accedidas), códigos de estado HTTP (200, 404, 301, etc.), tamaños de respuesta en bytes, información de referer y cadenas de user-agent (identificando el rastreador o navegador). Estos datos completos permiten a los SEOs reconstruir exactamente qué ocurrió en cada interacción con el servidor e identificar patrones que afectan la rastreabilidad e indexación.

Los bots falsificados afirman ser rastreadores legítimos de motores de búsqueda, pero tienen direcciones IP que no coinciden con los rangos de IP publicados por el motor de búsqueda. Para identificarlos, cruza las cadenas de user-agent (como 'Googlebot') con los rangos de IP oficiales publicados por Google, Bing y otros motores de búsqueda. Herramientas como Log File Analyzer de Screaming Frog validan automáticamente la autenticidad del bot. Los bots falsificados desperdician presupuesto de rastreo y pueden sobrecargar tu servidor, por lo que se recomienda bloquearlos mediante reglas en robots.txt o firewall.

Comienza a rastrear cómo los chatbots de IA mencionan tu marca en ChatGPT, Perplexity y otras plataformas. Obtén información procesable para mejorar tu presencia en IA.

Descubre qué es el análisis de rastreo de IA y cómo el análisis de registros del servidor rastrea el comportamiento de los rastreadores de IA, los patrones de a...

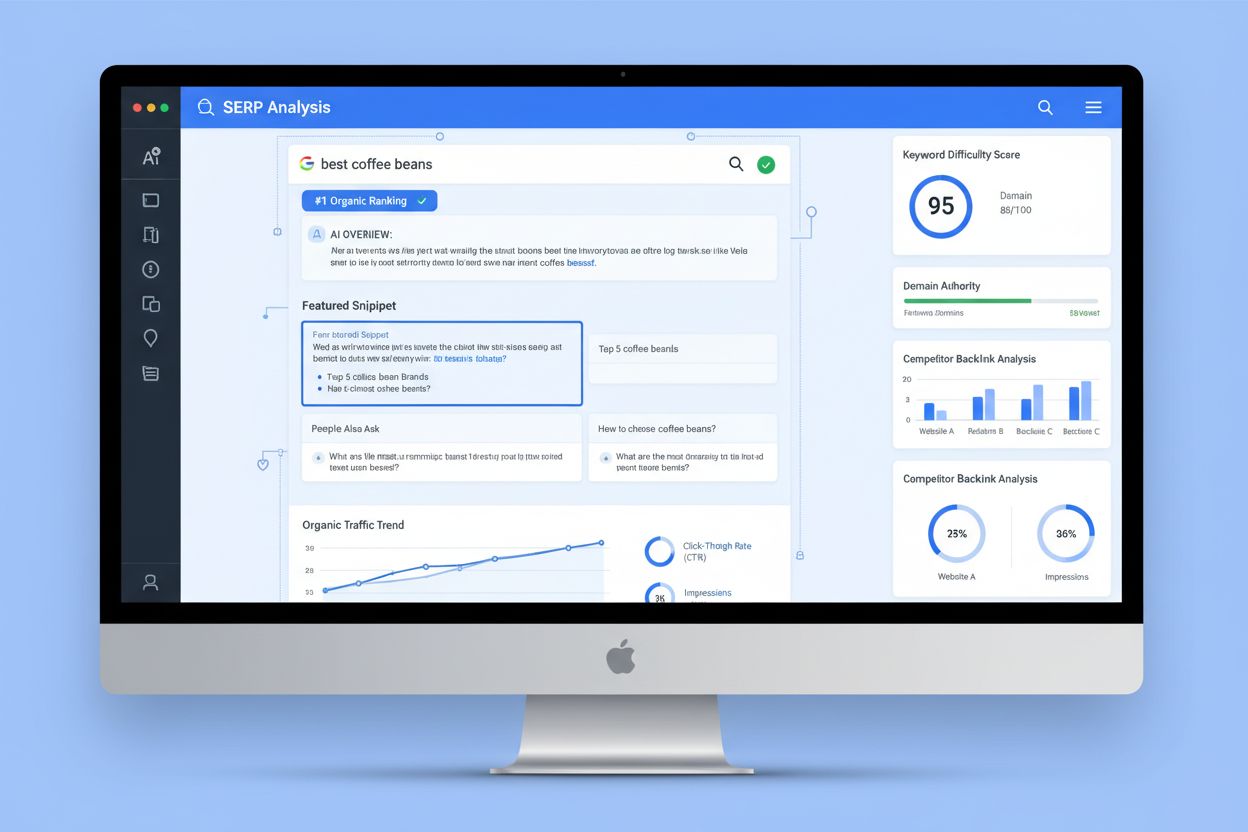

El Análisis SERP es el proceso de examinar las páginas de resultados de los motores de búsqueda para comprender la dificultad de posicionamiento, la intención d...

Discusión comunitaria sobre cómo aumentar la frecuencia de los rastreadores de IA. Datos reales y estrategias de webmasters que mejoraron la frecuencia con la q...