¿Qué es MUM y cómo afecta la búsqueda con IA?

Descubre el Modelo Unificado Multitarea (MUM) de Google y su impacto en los resultados de búsqueda con IA. Comprende cómo MUM procesa consultas complejas en múl...

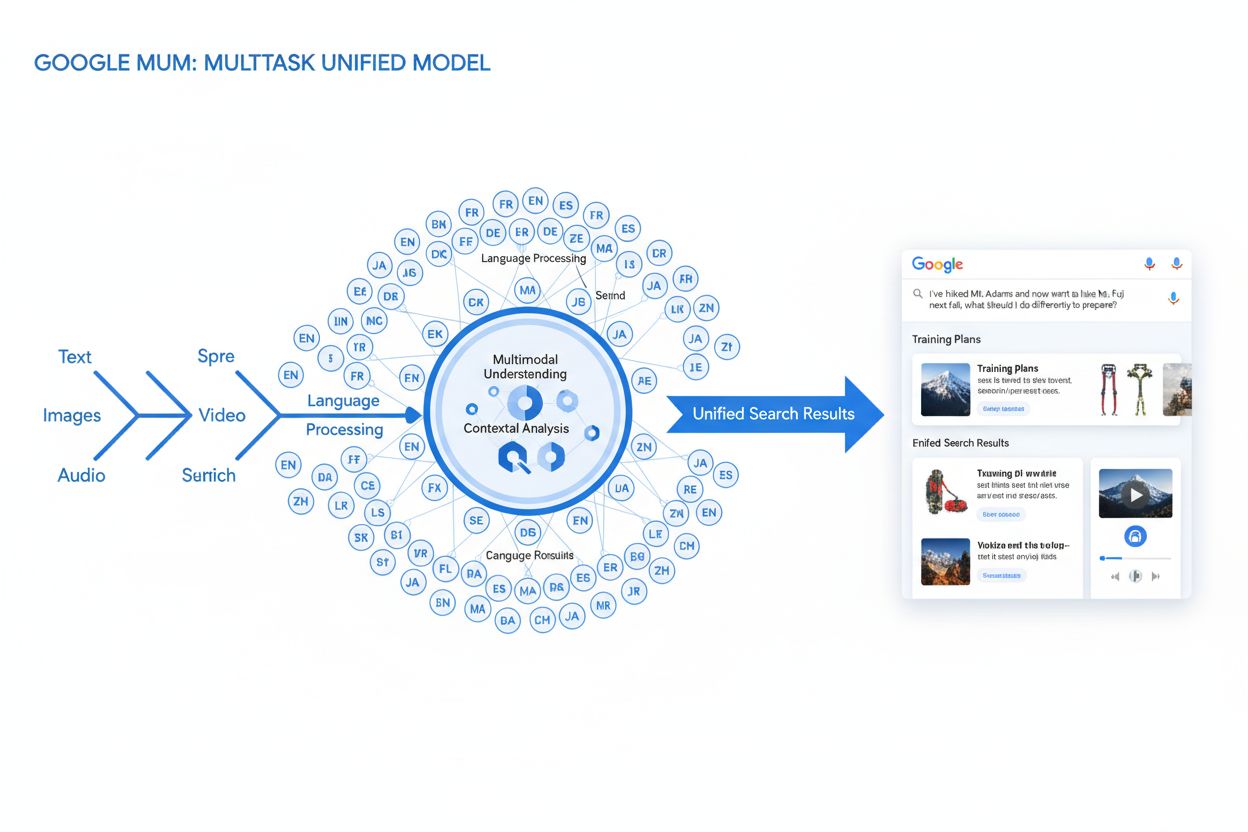

MUM (Modelo Unificado Multitarea) es el avanzado modelo de IA multimodal de Google que procesa texto, imágenes, video y audio simultáneamente en más de 75 idiomas para ofrecer resultados de búsqueda más completos y contextuales. Lanzado en 2021, MUM es 1.000 veces más potente que BERT y representa un cambio fundamental en la forma en que los motores de búsqueda entienden y responden a consultas complejas de los usuarios.

MUM (Modelo Unificado Multitarea) es el avanzado modelo de IA multimodal de Google que procesa texto, imágenes, video y audio simultáneamente en más de 75 idiomas para ofrecer resultados de búsqueda más completos y contextuales. Lanzado en 2021, MUM es 1.000 veces más potente que BERT y representa un cambio fundamental en la forma en que los motores de búsqueda entienden y responden a consultas complejas de los usuarios.

MUM (Modelo Unificado Multitarea) es el avanzado modelo de inteligencia artificial multimodal de Google diseñado para revolucionar la forma en que los motores de búsqueda comprenden y responden a consultas complejas de los usuarios. Anunciado en mayo de 2021 por Pandu Nayak, Google Fellow y Vicepresidente de Búsqueda, MUM representa un cambio fundamental en la tecnología de recuperación de información. Construido sobre el framework T5 de texto a texto y compuesto por aproximadamente 110 mil millones de parámetros, MUM es 1.000 veces más potente que BERT, el anterior modelo revolucionario de procesamiento de lenguaje natural de Google. A diferencia de los algoritmos de búsqueda tradicionales que procesan el texto de forma aislada, MUM procesa simultáneamente texto, imágenes, video y audio mientras comprende información en más de 75 idiomas de forma nativa. Esta capacidad multimodal y multilingüe permite a MUM comprender consultas complejas que antes requerían que los usuarios realizaran múltiples búsquedas, transformando la búsqueda de un simple ejercicio de coincidencia de palabras clave en un sistema inteligente y consciente del contexto para la recuperación de información. MUM no solo comprende el lenguaje, sino que también lo genera, siendo capaz de sintetizar información de diversas fuentes y formatos para proporcionar respuestas completas y matizadas que abordan el alcance total de la intención del usuario.

El camino de Google hacia MUM representa años de innovación incremental en procesamiento de lenguaje natural y aprendizaje automático. La evolución comenzó con Hummingbird (2013), que introdujo la comprensión semántica para interpretar el significado detrás de las consultas en lugar de solo hacer coincidir palabras clave. Esto fue seguido por RankBrain (2015), que utilizó aprendizaje automático para comprender palabras clave de cola larga y patrones de búsqueda novedosos. Neural Matching (2018) llevó esto más allá, utilizando redes neuronales para relacionar consultas con contenido relevante a un nivel semántico más profundo. BERT (Bidirectional Encoder Representations from Transformers), lanzado en 2019, supuso un gran hito al comprender el contexto dentro de frases y párrafos, mejorando la capacidad de Google para interpretar el lenguaje matizado. Sin embargo, BERT tenía limitaciones significativas: solo procesaba texto, tenía soporte multilingüe limitado y no podía manejar la complejidad de consultas que requerían síntesis de información en múltiples formatos. Según la investigación de Google, los usuarios realizan una media de ocho consultas separadas para responder preguntas complejas, como comparar dos destinos de senderismo o evaluar opciones de productos. Esta estadística puso de manifiesto una brecha crítica en la tecnología de búsqueda que MUM fue diseñado específicamente para abordar. La Helpful Content Update (2022) y el framework E-E-A-T (2023) refinaron aún más cómo Google prioriza el contenido autoritativo y confiable. MUM se construye sobre todas estas innovaciones, introduciendo capacidades que trascienden las limitaciones previas y representando no solo una mejora incremental, sino un cambio de paradigma en la forma en que los motores de búsqueda procesan y entregan información.

La base técnica de MUM se asienta sobre la arquitectura Transformer, específicamente el framework T5 (Text-to-Text Transfer Transformer) que Google desarrolló previamente. El framework T5 trata todas las tareas de procesamiento de lenguaje natural como problemas de texto a texto, convirtiendo entradas y salidas en representaciones textuales unificadas. MUM amplía este enfoque incorporando capacidades de procesamiento multimodal, lo que le permite manejar texto, imágenes, video y audio simultáneamente dentro de un solo modelo unificado. Esta elección arquitectónica es significativa porque permite a MUM comprender relaciones y contexto entre diferentes tipos de medio de maneras que los modelos anteriores no podían. Por ejemplo, al procesar una consulta sobre senderismo en el Monte Fuji junto con una imagen de botas específicas, MUM no analiza el texto y la imagen por separado, sino que los procesa juntos, comprendiendo cómo las características de las botas se relacionan con el contexto de la consulta. Los 110 mil millones de parámetros del modelo le otorgan la capacidad de almacenar y procesar enormes cantidades de conocimiento sobre lenguaje, conceptos visuales y sus relaciones. MUM está entrenado en 75 idiomas diferentes y muchas tareas distintas de manera simultánea, lo que le permite desarrollar una comprensión más completa de la información y el conocimiento mundial que los modelos entrenados en un solo idioma o tarea. Este enfoque de aprendizaje multitarea significa que MUM aprende a reconocer patrones y relaciones que se transfieren entre idiomas y dominios, haciéndolo más robusto y generalizable que modelos anteriores. El procesamiento simultáneo de varios idiomas durante el entrenamiento permite a MUM realizar transferencia de conocimiento entre idiomas, es decir, puede comprender información escrita en un idioma y aplicar ese conocimiento a consultas en otro, rompiendo eficazmente las barreras idiomáticas que antes limitaban los resultados de búsqueda.

| Atributo | MUM (2021) | BERT (2019) | RankBrain (2015) | Framework T5 |

|---|---|---|---|---|

| Función Principal | Comprensión multimodal de consultas y síntesis de respuestas | Comprensión contextual basada en texto | Interpretación de palabras clave de cola larga | Aprendizaje de transferencia de texto a texto |

| Modalidades de Entrada | Texto, imágenes, video, audio | Solo texto | Solo texto | Solo texto |

| Soporte de Idiomas | Más de 75 idiomas nativamente | Soporte multilingüe limitado | Principalmente inglés | Principalmente inglés |

| Parámetros del Modelo | ~110 mil millones | ~340 millones | No revelado | ~220 millones |

| Comparación de Potencia | 1.000x más potente que BERT | Referencia | Predecesor de BERT | Base de MUM |

| Capacidades | Comprensión + generación | Solo comprensión | Reconocimiento de patrones | Transformación de texto |

| Impacto en SERP | Resultados enriquecidos multiformato | Mejores fragmentos y contexto | Relevancia mejorada | Tecnología fundacional |

| Gestión de Consultas Complejas | Consultas complejas de varios pasos | Contexto de una sola consulta | Variaciones de cola larga | Tareas de transformación textual |

| Transferencia de Conocimiento | Entre idiomas y modalidades | Solo dentro del idioma | Transferencia limitada | Transferencia entre tareas |

| Aplicación en el Mundo Real | Búsqueda de Google, AI Overviews | Ranking de Búsqueda de Google | Ranking de Búsqueda de Google | Base técnica de MUM |

El procesamiento de consultas por parte de MUM implica múltiples pasos sofisticados que trabajan en conjunto para ofrecer respuestas completas y contextuales. Cuando un usuario envía una consulta de búsqueda, MUM comienza realizando un preprocesamiento independiente del idioma, comprendiendo la consulta en cualquiera de sus más de 75 idiomas soportados sin requerir traducción. Esta comprensión nativa preserva matices lingüísticos y contextos regionales que podrían perderse en la traducción. A continuación, MUM emplea coincidencia de secuencia a secuencia, analizando toda la consulta como una secuencia de significado en lugar de palabras clave aisladas. Este enfoque permite a MUM comprender las relaciones entre conceptos—por ejemplo, reconocer que una consulta sobre “prepararse para el Monte Fuji después de escalar el Monte Adams” implica comparación, preparación y adaptación contextual. Simultáneamente, MUM realiza análisis de entrada multimodal, procesando cualquier imagen, video u otro medio incluido con la consulta. El modelo entonces lleva a cabo un procesamiento simultáneo de la consulta, evaluando múltiples posibles intenciones del usuario en paralelo en lugar de limitarse a una sola interpretación. Esto significa que MUM puede reconocer que una consulta sobre senderismo en el Monte Fuji puede estar relacionada con la preparación física, la selección de equipo, experiencias culturales o logística de viaje, y mostrar información relevante para todas estas interpretaciones. La comprensión semántica basada en vectores convierte la consulta y el contenido indexado en vectores de alta dimensión que representan significado semántico, permitiendo la recuperación basada en similitud conceptual en lugar de coincidencia de palabras clave. MUM luego aplica filtrado de contenido mediante transferencia de conocimiento, utilizando aprendizaje automático entrenado con registros de búsqueda, datos de navegación y patrones de comportamiento de usuario para priorizar fuentes de alta calidad y autoridad. Finalmente, MUM genera una composición SERP multimedia enriquecida, combinando fragmentos de texto, imágenes, videos, preguntas relacionadas y elementos interactivos en una sola experiencia de búsqueda visualmente estructurada. Todo este proceso ocurre en milisegundos, permitiendo a MUM entregar resultados que abordan no solo la consulta explícita sino también posibles preguntas de seguimiento y necesidades de información relacionadas.

Las capacidades multimodales de MUM representan una ruptura fundamental con los sistemas de búsqueda solo basados en texto. El modelo puede procesar y comprender simultáneamente información proveniente de texto, imágenes, video y audio, extrayendo significado de cada modalidad y sintetizándolo en respuestas coherentes. Esta capacidad es especialmente poderosa para consultas que se benefician del contexto visual. Por ejemplo, si un usuario pregunta “¿Puedo usar estas botas de senderismo para el Monte Fuji?” mostrando una imagen de sus botas, MUM comprende las características de las botas a partir de la imagen—material, dibujo de la suela, altura, color—y conecta esa comprensión visual con el conocimiento sobre el terreno, clima y requisitos de senderismo del Monte Fuji para dar una respuesta contextual. La dimensión multilingüe de MUM es igualmente transformadora. Con soporte nativo para más de 75 idiomas, MUM puede realizar transferencia de conocimiento entre idiomas, aprendiendo de fuentes en un idioma y aplicando ese conocimiento a consultas en otro. Esto elimina una barrera significativa que antes limitaba los resultados de búsqueda al idioma nativo del usuario. Si la información más completa sobre el Monte Fuji está disponible principalmente en fuentes japonesas, incluidos guías de senderismo locales, patrones climáticos estacionales y perspectivas culturales, MUM puede comprender ese contenido en japonés y mostrar información relevante a usuarios de habla inglesa. Según las pruebas de Google, MUM pudo listar 800 variantes de vacunas COVID-19 en más de 50 idiomas en cuestión de segundos, demostrando la escala y velocidad de sus capacidades multilingües. Esta comprensión multilingüe es especialmente valiosa para usuarios en mercados no angloparlantes y para consultas sobre temas con información rica en varios idiomas. La combinación de procesamiento multimodal y multilingüe permite a MUM mostrar la información más relevante sin importar el formato en que se presente ni el idioma en que se publicó originalmente, creando una experiencia de búsqueda verdaderamente global.

MUM transforma fundamentalmente cómo se muestran y experimentan los resultados de búsqueda por parte de los usuarios. En lugar de la tradicional lista de enlaces azules que dominó la búsqueda durante décadas, MUM crea SERP enriquecidas e interactivas que combinan múltiples formatos de contenido en una sola página. Los usuarios pueden ver fragmentos de texto, imágenes en alta resolución, carruseles de video, preguntas relacionadas y elementos interactivos sin salir de los resultados de búsqueda. Este cambio tiene profundas implicaciones en la forma en que los usuarios interactúan con la búsqueda. En lugar de realizar múltiples búsquedas para recopilar información sobre un tema complejo, los usuarios pueden explorar diferentes ángulos y subtemas directamente en la SERP. Por ejemplo, una consulta sobre “cómo prepararse para el Monte Fuji en otoño” puede mostrar comparaciones de elevación, pronósticos meteorológicos, recomendaciones de equipo, guías en video y opiniones de usuarios, todo organizado contextualmente en una sola página. La integración de Google Lens potenciada por MUM permite a los usuarios buscar usando imágenes en lugar de palabras clave, convirtiendo elementos visuales en fotos en herramientas de descubrimiento interactivas. Los paneles de “Cosas que saber” desglosan consultas complejas en subtemas digeribles, guiando a los usuarios por diferentes aspectos de un tema con fragmentos relevantes para cada uno. Imágenes ampliables en alta resolución aparecen directamente en los resultados, facilitando la comparación visual y reduciendo la fricción en etapas tempranas de toma de decisiones. La funcionalidad de “Refinar y Ampliar” sugiere conceptos relacionados para ayudar a los usuarios a profundizar en aspectos específicos o explorar temas adyacentes. Estos cambios representan una transición de la búsqueda como mecanismo de recuperación simple a la búsqueda como experiencia interactiva y exploratoria que anticipa las necesidades del usuario y proporciona información completa en la propia interfaz de búsqueda. Las investigaciones indican que esta experiencia SERP más rica reduce el número medio de búsquedas necesarias para responder preguntas complejas, aunque también implica que los usuarios pueden consumir información directamente en los resultados en lugar de hacer clic en los sitios web.

Para las organizaciones que rastrean su presencia en sistemas de IA, MUM representa una evolución crucial en cómo se descubre y muestra la información. A medida que MUM se integra cada vez más en la Búsqueda de Google e influye en otros sistemas de IA, comprender cómo aparecen las marcas y los dominios en los resultados potenciados por MUM es esencial para mantener la visibilidad. El procesamiento multimodal de MUM implica que las marcas deben optimizar en múltiples formatos de contenido, no solo en texto. Una marca que antes dependía de posicionarse para ciertas palabras clave ahora debe asegurarse de que su contenido sea descubrible a través de imágenes, videos y datos estructurados. La capacidad del modelo para sintetizar información de diversas fuentes significa que la visibilidad de una marca depende no solo de su propio sitio web, sino de cómo aparece su información en todo el ecosistema web. Las capacidades multilingües de MUM crean nuevas oportunidades y desafíos para las marcas globales. El contenido publicado en un idioma puede ahora ser descubierto por usuarios que buscan en otros idiomas, ampliando el alcance potencial. Sin embargo, esto también implica que las marcas deben asegurar que su información sea precisa y consistente en todos los idiomas, ya que MUM puede mostrar información de múltiples fuentes lingüísticas para una sola consulta. Para plataformas de monitorización de IA como AmICited, rastrear el impacto de MUM es crucial, ya que representa cómo los sistemas modernos de IA recuperan y presentan información. Al monitorizar dónde aparece una marca en las respuestas de IA—ya sea en Google AI Overviews, Perplexity, ChatGPT o Claude—comprender la tecnología subyacente de MUM ayuda a explicar por qué se muestra cierto contenido y cómo optimizar la visibilidad. El cambio hacia una búsqueda multimodal y multilingüe implica que las marcas necesitan una monitorización integral que rastree su presencia en diferentes formatos y lenguas, no solo en rankings tradicionales de palabras clave. Las organizaciones que entienden las capacidades de MUM podrán optimizar mejor su estrategia de contenidos para asegurar visibilidad en este nuevo panorama de búsqueda.

Aunque MUM supone un avance significativo, también introduce nuevos desafíos y limitaciones que las organizaciones deben afrontar. Las tasas de clic más bajas representan una gran preocupación para editores y creadores de contenido, ya que ahora los usuarios pueden consumir información completa directamente en los resultados de búsqueda sin hacer clic en los sitios web. Este cambio hace que las métricas tradicionales de tráfico sean indicadores menos fiables del éxito del contenido. El aumento de requisitos técnicos de SEO implica que, para ser comprendido adecuadamente por MUM, el contenido debe estar bien estructurado con marcado de esquema apropiado, HTML semántico y relaciones de entidades claras. El contenido que carezca de esta base técnica puede no ser correctamente indexado o comprendido por el procesamiento multimodal de MUM. La saturación del SERP genera desafíos de visibilidad, ya que más formatos de contenido compiten por la atención en una sola página. Incluso el contenido sólido puede recibir menos o ningún clic si los usuarios encuentran suficiente información en el propio SERP. Existe el potencial de resultados engañosos cuando MUM muestra información de múltiples fuentes que pueden contradecirse entre sí o cuando el contexto se pierde en la síntesis. La dependencia de datos estructurados implica que el contenido no estructurado o mal formateado puede no ser comprendido ni mostrado adecuadamente por MUM. Los desafíos de matiz lingüístico y cultural pueden surgir cuando MUM transfiere conocimiento entre idiomas, perdiendo potencialmente contexto cultural o variaciones regionales de significado. Los requerimientos computacionales para ejecutar MUM a escala son considerables, aunque Google ha invertido en mejoras de eficiencia para reducir la huella de carbono. La preocupación por sesgos y equidad requiere atención continua para asegurar que MUM no perpetúe sesgos presentes en los datos de entrenamiento ni perjudique a ciertas perspectivas o comunidades.

La aparición de MUM requiere cambios fundamentales en el enfoque de SEO y estrategia de contenidos de las organizaciones. La optimización tradicional centrada en palabras clave pierde eficacia cuando MUM puede comprender la intención y el contexto más allá de coincidencias exactas. La estrategia de contenidos basada en temas cobra mayor importancia que la basada en palabras clave, requiriendo que las organizaciones creen clústeres de contenido completos que aborden los temas desde múltiples ángulos. La creación de contenido multimedia ya no es opcional: las organizaciones deben invertir en imágenes, videos y contenido interactivo de alta calidad que complemente el contenido textual. La implementación de datos estructurados se vuelve crítica, ya que el marcado de esquema ayuda a MUM a comprender la estructura y relaciones del contenido. La construcción de entidades y optimización semántica ayuda a establecer autoridad temática y mejora la comprensión de relaciones por parte de MUM. La estrategia de contenido multilingüe gana importancia, ya que la capacidad de transferencia de MUM permite que el contenido se descubra en distintos mercados lingüísticos. El mapeo de intención del usuario se vuelve más sofisticado, requiriendo que las organizaciones comprendan no solo la intención principal sino también preguntas relacionadas y subtemas que los usuarios puedan explorar. La actualidad y precisión del contenido adquieren mayor relevancia, ya que MUM sintetiza información de múltiples fuentes: el contenido desactualizado o inexacto puede ser despriorizado. La optimización multiplataforma va más allá de la Búsqueda de Google e incluye la optimización para la aparición en sistemas de IA como Google AI Overviews, Perplexity y otras interfaces de búsqueda potenciadas por IA. Las señales E-E-A-T (Experiencia, Pericia, Autoridad, Confianza) cobran cada vez más importancia, ya que MUM da prioridad al contenido de fuentes autoritativas. Las organizaciones que adapten sus estrategias para alinearse con las capacidades de MUM—centrándose en contenido completo, multimodal, bien estructurado y demostrando experiencia y autoridad—mantendrán la visibilidad en este entorno de búsqueda en evolución.

MUM no es un punto final, sino una etapa en la evolución de la búsqueda potenciada por IA. Google ha indicado que MUM seguirá ampliando sus capacidades, con el procesamiento de video y audio volviéndose cada vez más sofisticado. La empresa investiga activamente cómo reducir la huella computacional de MUM manteniendo o mejorando su rendimiento, abordando preocupaciones de sostenibilidad en modelos de IA a gran escala. La integración de MUM con otras tecnologías de Google sugiere desarrollos futuros donde la comprensión de MUM impulse no solo la búsqueda, sino también productos como Google Assistant, Google Lens y otros. La presión competitiva de otros sistemas de IA como ChatGPT de OpenAI, Claude de Anthropic y el motor de búsqueda de IA de Perplexity implica que MUM probablemente seguirá evolucionando para mantener la ventaja competitiva de Google. El escrutinio regulatorio sobre sistemas de IA puede influir en el desarrollo de MUM, especialmente en cuanto a sesgo, equidad y transparencia. La adaptación del comportamiento del usuario moldeará la evolución de MUM—a medida que los usuarios se acostumbren a experiencias de búsqueda más ricas e interactivas, aumentarán las expectativas de calidad y exhaustividad. El auge de la IA generativa significa que las capacidades de MUM para sintetizar y generar información probablemente se volverán más prominentes, permitiendo potencialmente a MUM generar contenido original y no solo recuperar y organizar el existente. El estándar de IA multimodal sugiere que el enfoque de MUM de procesar múltiples formatos simultáneamente será la norma en los sistemas de IA. La privacidad y el uso de datos influirán en cómo MUM utiliza los datos de usuario y señales de comportamiento para personalizar y mejorar resultados. Las organizaciones deben prepararse para una evolución continua creando estrategias de contenido flexibles y adaptables que prioricen calidad, exhaustividad y excelencia técnica, en lugar de depender de tácticas específicas que podrían quedar obsoletas a medida que MUM evolucione. El principio fundamental—crear contenido que realmente satisfaga la intención del usuario en múltiples formatos e idiomas—seguirá siendo relevante independientemente de cómo evolucionen las capacidades específicas de MUM.

Mientras que BERT (2019) se centraba en comprender el lenguaje natural en consultas basadas en texto, MUM representa una evolución significativa. MUM está construido sobre el framework T5 de texto a texto y es 1.000 veces más potente que BERT. A diferencia del procesamiento solo de texto de BERT, MUM es multimodal: procesa simultáneamente texto, imágenes, video y audio. Además, MUM admite de forma nativa más de 75 idiomas, mientras que BERT tenía soporte multilingüe limitado en su lanzamiento. MUM puede tanto comprender como generar lenguaje, lo que le permite gestionar consultas complejas y de varios pasos que BERT no podía abordar eficazmente.

Multimodal se refiere a la capacidad de MUM para procesar y comprender información de múltiples tipos de formatos de entrada simultáneamente. En lugar de analizar el texto por separado de las imágenes o el video, MUM procesa todos estos formatos juntos de manera unificada. Esto significa que cuando buscas algo como 'botas de senderismo para el Monte Fuji', MUM puede entender tu consulta de texto, analizar imágenes de botas, ver reseñas en video y extraer descripciones de audio, todo al mismo tiempo. Este enfoque integrado permite a MUM proporcionar respuestas más ricas y contextuales que consideran información de todos estos diferentes tipos de medios.

MUM está entrenado en más de 75 idiomas, lo que supone un gran avance en la accesibilidad global de la búsqueda. Esta capacidad multilingüe significa que MUM puede transferir conocimiento entre idiomas: si hay información útil sobre un tema en japonés, MUM puede comprenderla y mostrar resultados relevantes a usuarios de habla inglesa. Esto elimina las barreras idiomáticas que antes limitaban los resultados de búsqueda al idioma nativo del usuario. Para marcas y creadores de contenido, esto implica que su contenido puede tener visibilidad en varios mercados lingüísticos y que los usuarios de todo el mundo pueden acceder a la información independientemente del idioma en que se publicó originalmente.

T5 (Text-to-Text Transfer Transformer) es un modelo anterior de Google basado en transformadores sobre el que está construido MUM. El framework T5 trata todas las tareas de PLN como problemas de texto a texto, es decir, convierte las entradas y salidas en formato de texto para un procesamiento unificado. MUM amplía las capacidades de T5 incorporando procesamiento multimodal (gestión de imágenes, video y audio) y escalándolo a aproximadamente 110 mil millones de parámetros. Esta base permite a MUM comprender y generar lenguaje, manteniendo la eficiencia y flexibilidad que hicieron exitoso a T5.

MUM cambia fundamentalmente la forma en que el contenido se descubre y muestra en los resultados de búsqueda. En lugar de las listas tradicionales de enlaces azules, MUM crea SERP enriquecidas con múltiples formatos de contenido: imágenes, videos, fragmentos de texto y elementos interactivos, todo en una sola página. Esto significa que las marcas deben optimizar en varios formatos, no solo en texto. El contenido que antes requería que los usuarios navegaran por varias páginas ahora puede mostrarse directamente en los resultados de búsqueda. Sin embargo, esto también implica tasas de clic más bajas para ciertos contenidos, ya que los usuarios pueden consumir información dentro del propio SERP. Las marcas ahora deben centrarse en la visibilidad dentro de los resultados y asegurarse de que su contenido esté estructurado con marcado de esquema para que MUM lo comprenda correctamente.

MUM es fundamental para las plataformas de monitorización de IA porque representa cómo los sistemas modernos de IA comprenden y recuperan información. A medida que MUM se vuelve más prevalente en la Búsqueda de Google e influye en otros sistemas de IA, monitorizar dónde aparecen las marcas y dominios en los resultados potenciados por MUM es esencial. AmICited rastrea cómo se citan y aparecen las marcas en los sistemas de IA, incluida la búsqueda mejorada con MUM de Google. Comprender las capacidades multimodales y multilingües de MUM ayuda a las organizaciones a optimizar su presencia en diferentes formatos y lenguas, asegurando que sean visibles cuando sistemas como MUM recuperan y muestran su información a los usuarios.

Sí, MUM puede procesar imágenes y video con un nivel sofisticado de comprensión. Cuando subes una imagen o incluyes un video en una consulta, MUM no solo reconoce objetos: extrae contexto, significado y relaciones. Por ejemplo, si le muestras a MUM una foto de unas botas de senderismo y preguntas '¿puedo usar estas para el Monte Fuji?', MUM entiende las características de las botas a partir de la imagen y conecta esa comprensión con tu pregunta para proporcionar una respuesta contextual. Esta comprensión multimodal es una de las características más potentes de MUM, permitiéndole responder preguntas que requieren combinación de entendimiento visual y conocimiento textual.

Comienza a rastrear cómo los chatbots de IA mencionan tu marca en ChatGPT, Perplexity y otras plataformas. Obtén información procesable para mejorar tu presencia en IA.

Descubre el Modelo Unificado Multitarea (MUM) de Google y su impacto en los resultados de búsqueda con IA. Comprende cómo MUM procesa consultas complejas en múl...

Discusión comunitaria que explica Google MUM y su impacto en la búsqueda con IA. Expertos comparten cómo este modelo de IA multimodal afecta la optimización de ...

Descubre cómo los sistemas de búsqueda de IA multimodal procesan texto, imágenes, audio y video juntos para ofrecer resultados más precisos y relevantes en cont...

Consentimiento de Cookies

Usamos cookies para mejorar tu experiencia de navegación y analizar nuestro tráfico. See our privacy policy.