Definición de Procesamiento de Lenguaje Natural (PLN)

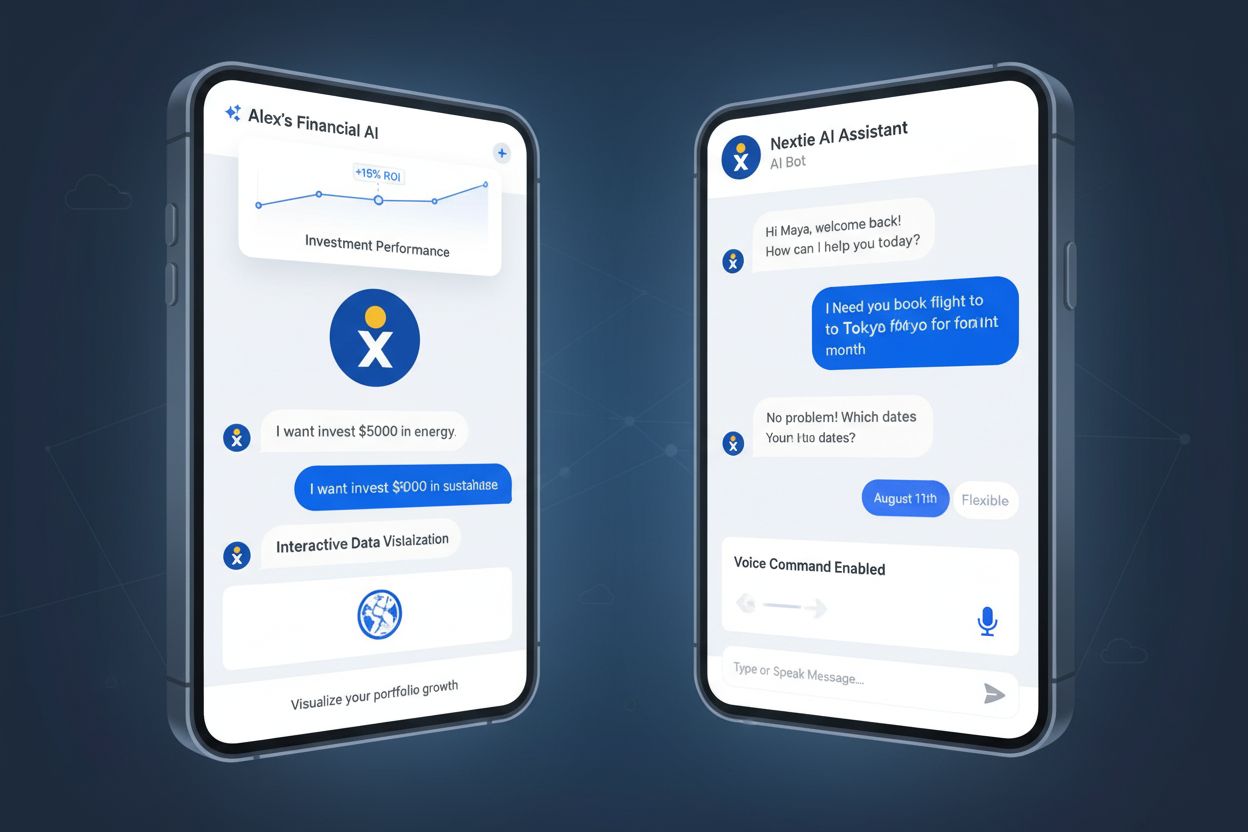

El Procesamiento de Lenguaje Natural (PLN) es una subdisciplina de la inteligencia artificial y la informática que permite a las computadoras comprender, interpretar, manipular y generar lenguaje humano de manera significativa. El PLN combina la lingüística computacional (el modelado basado en reglas del lenguaje humano), algoritmos de aprendizaje automático y redes neuronales de aprendizaje profundo para procesar datos tanto de texto como de voz. La tecnología permite a las máquinas comprender el significado semántico del lenguaje, reconocer patrones en la comunicación humana y generar respuestas coherentes que imitan la comprensión humana del lenguaje. El PLN es fundamental para las aplicaciones modernas de IA, impulsando desde motores de búsqueda y chatbots hasta asistentes de voz y sistemas de monitoreo de IA que rastrean menciones de marca en plataformas como ChatGPT, Perplexity y Google AI Overviews.

Contexto histórico y evolución del PLN

El campo del Procesamiento de Lenguaje Natural surgió en la década de 1950, cuando los investigadores intentaron por primera vez la traducción automática, con el experimento histórico Georgetown-IBM en 1954, que logró traducir 60 frases rusas al inglés. Sin embargo, los sistemas de PLN tempranos eran muy limitados, basados en enfoques rígidos y basados en reglas que solo podían responder a instrucciones preprogramadas específicas. Entre los años 90 y principios de los 2000 se produjeron avances significativos con el desarrollo de métodos estadísticos de PLN, que introdujeron el aprendizaje automático en el procesamiento del lenguaje, habilitando aplicaciones como el filtrado de spam, la clasificación de documentos y chatbots básicos. La verdadera revolución llegó en la década de 2010 con el auge de los modelos de aprendizaje profundo y redes neuronales, capaces de analizar grandes bloques de texto y descubrir patrones complejos en los datos lingüísticos. Actualmente, el mercado de PLN está experimentando un crecimiento explosivo, con proyecciones que muestran una expansión global de $59.70 mil millones en 2024 a $439.85 mil millones para 2030, lo que representa una tasa de crecimiento anual compuesta (CAGR) del 38.7%. Este crecimiento refleja la creciente importancia del PLN en soluciones empresariales, automatización potenciada por IA y aplicaciones de monitoreo de marca.

Ready to Monitor Your AI Visibility?

Track how AI chatbots mention your brand across ChatGPT, Perplexity, and other platforms.

Técnicas y métodos fundamentales del PLN

El Procesamiento de Lenguaje Natural emplea varias técnicas fundamentales para descomponer y analizar el lenguaje humano. La tokenización es el proceso de dividir el texto en unidades más pequeñas como palabras, frases u oraciones, facilitando que los modelos de aprendizaje automático manejen textos complejos. El stemming y la lematización reducen las palabras a sus formas raíz (por ejemplo, “corriendo,” “corre” y “corrió” se convierten en “correr”), permitiendo que los sistemas reconozcan diferentes formas de una misma palabra. El Reconocimiento de Entidades Nombradas (NER) identifica y extrae entidades específicas del texto como nombres de personas, lugares, organizaciones, fechas y valores monetarios—una capacidad crítica para sistemas de monitoreo de marca que necesitan detectar cuándo aparece el nombre de una empresa en contenido generado por IA. El análisis de sentimiento determina el tono emocional u opinión expresada en el texto, clasificando el contenido como positivo, negativo o neutral, lo que es esencial para comprender cómo se perciben las marcas en las respuestas de IA. La etiquetación de partes del discurso identifica el rol gramatical de cada palabra en una oración (sustantivo, verbo, adjetivo, etc.), ayudando a los sistemas a entender la estructura y el significado. La clasificación de texto categoriza documentos o fragmentos en categorías predefinidas, permitiendo organizar y filtrar información. Estas técnicas trabajan en conjunto dentro de pipelines de PLN para transformar texto sin estructurar en datos estructurados y analizables que los sistemas de IA pueden procesar y aprender.

Comparación de enfoques y tecnologías de PLN

| Enfoque de PLN | Descripción | Casos de uso | Ventajas | Limitaciones |

|---|

| PLN basado en reglas | Utiliza árboles de decisión if-then preprogramados y reglas gramaticales | Chatbots simples, filtrado básico de texto | Predecible, transparente, no requiere datos de entrenamiento | No escalable, no maneja variaciones del lenguaje, flexibilidad limitada |

| PLN estadístico | Utiliza aprendizaje automático para extraer patrones de datos etiquetados | Detección de spam, clasificación de documentos, etiquetado gramatical | Más flexible que el basado en reglas, aprende de los datos | Requiere datos de entrenamiento etiquetados, dificultad con contexto y matices |

| PLN con aprendizaje profundo | Utiliza redes neuronales y modelos transformadores en grandes conjuntos de datos no estructurados | Chatbots, traducción automática, generación de contenido, monitoreo de marca | Alta precisión, maneja patrones complejos, aprende el contexto | Requiere enormes recursos computacionales, propenso a sesgos en los datos |

| Modelos transformadores (BERT, GPT) | Utilizan mecanismos de auto-atención para procesar secuencias completas simultáneamente | Comprensión de lenguaje, generación de texto, análisis de sentimiento, NER | Rendimiento de vanguardia, entrenamiento eficiente, comprensión contextual | Costoso computacionalmente, requiere grandes conjuntos de datos, problemas de interpretabilidad |

| Aprendizaje supervisado | Se entrena con pares entrada-salida etiquetados | Clasificación de sentimiento, reconocimiento de entidades, categorización de texto | Alta precisión en tareas específicas, rendimiento predecible | Requiere mucha data etiquetada, proceso de anotación laborioso |

| Aprendizaje no supervisado | Descubre patrones en datos no etiquetados | Modelado de temas, agrupamiento, detección de anomalías | No requiere etiquetado, descubre patrones ocultos | Menor precisión, resultados difíciles de interpretar, requiere experiencia de dominio |

Stay Updated on AI Visibility Trends

Get the latest insights on AI mentions, brand monitoring, and optimization strategies.

Cómo funciona el Procesamiento de Lenguaje Natural: El pipeline completo

El Procesamiento de Lenguaje Natural opera a través de un pipeline sistemático que transforma el lenguaje humano sin procesar en conocimiento interpretable por máquina. El proceso inicia con el preprocesamiento de texto, donde la entrada bruta se limpia y estandariza. La tokenización divide el texto en palabras o frases individuales, la conversión a minúsculas transforma todos los caracteres para que “Apple” y “apple” se traten igual, y la eliminación de palabras vacías filtra términos comunes como “el” y “es” que no aportan significado relevante. El stemming y la lematización reducen las palabras a sus raíces, y la limpieza de texto elimina puntuación, caracteres especiales y elementos irrelevantes. Tras el preprocesamiento, el sistema realiza la extracción de características, convirtiendo el texto en representaciones numéricas que los modelos pueden procesar. Técnicas como Bolsa de Palabras y TF-IDF cuantifican la importancia de las palabras, mientras que las incrustaciones de palabras como Word2Vec y GloVe representan palabras como vectores densos, capturando relaciones semánticas. Las incrustaciones contextuales más avanzadas consideran palabras circundantes para crear representaciones más ricas. La siguiente etapa es el análisis de texto, donde se aplican técnicas como reconocimiento de entidades nombradas para identificar entidades específicas, análisis de sentimiento para determinar el tono emocional, análisis de dependencias para entender relaciones gramaticales y modelado de temas para identificar temas subyacentes. Finalmente, el entrenamiento de modelos utiliza los datos procesados para que los modelos de aprendizaje automático aprendan patrones y relaciones, con el modelo entrenado luego desplegado para hacer predicciones sobre datos nuevos. Todo este pipeline permite que sistemas como AmICited detecten y analicen menciones de marca en respuestas generadas por IA en plataformas como ChatGPT, Perplexity y Google AI Overviews.

El surgimiento del aprendizaje profundo ha transformado fundamentalmente el Procesamiento de Lenguaje Natural, superando los métodos estadísticos hacia arquitecturas de redes neuronales que pueden aprender patrones complejos de grandes volúmenes de datos. Las Redes Neuronales Recurrentes (RNN) y las Redes de Memoria a Largo Plazo (LSTM) fueron enfoques tempranos para procesar datos secuenciales, pero tenían limitaciones para manejar dependencias a largo plazo. El gran avance llegó con los modelos transformadores, que introdujeron el mecanismo de auto-atención—un enfoque revolucionario que permite a los modelos considerar simultáneamente todas las palabras de una secuencia y determinar cuáles son más importantes para comprender el significado. BERT (Representaciones Bidireccionales de Codificador de Transformadores), desarrollado por Google, se convirtió en la base para motores de búsqueda modernos y tareas de comprensión del lenguaje al procesar texto bidireccionalmente y entender el contexto en ambas direcciones. Los modelos GPT (Transformador Generativo Preentrenado), incluido el ampliamente usado GPT-4, emplean una arquitectura autoregresiva para predecir la siguiente palabra en una secuencia, permitiendo capacidades sofisticadas de generación de texto. Estos modelos transformadores pueden entrenarse mediante aprendizaje auto-supervisado en bases masivas de texto sin necesidad de anotación manual, lo que los hace altamente eficientes y escalables. Modelos fundacionales como Granite de IBM son modelos preconstruidos y curados que pueden desplegarse rápidamente para tareas de PLN como generación de contenido, extracción de información y reconocimiento de entidades nombradas. El poder de estos modelos radica en su capacidad para captar relaciones semánticas sutiles, comprender contexto en textos extensos y generar respuestas coherentes y contextuales—capacidades esenciales para plataformas de monitoreo de IA que rastrean menciones de marca en contenido generado por IA.

Aplicaciones del PLN en industrias y monitoreo de IA

El Procesamiento de Lenguaje Natural se ha vuelto indispensable en prácticamente todas las industrias, permitiendo a las organizaciones extraer información valiosa de grandes cantidades de datos de texto y voz no estructurados. En finanzas, el PLN acelera el análisis de estados financieros, informes regulatorios y comunicados de prensa, ayudando a traders y analistas a tomar decisiones rápidas e informadas. Las organizaciones de salud emplean PLN para analizar historiales clínicos, artículos científicos y notas médicas, permitiendo diagnósticos más rápidos, planificación de tratamientos e investigación médica. Las compañías de seguros utilizan PLN para analizar reclamaciones, identificar patrones de fraude o ineficiencia y optimizar flujos de trabajo. Los despachos legales aprovechan el PLN para la búsqueda automatizada de documentos, organizando grandes volúmenes de casos y jurisprudencia, reduciendo tiempos y costos. Los departamentos de atención al cliente utilizan chatbots impulsados por PLN para resolver consultas rutinarias, liberando a los agentes humanos para casos complejos. Los equipos de marketing y gestión de marca dependen cada vez más del PLN para el análisis de sentimiento y el monitoreo de marca, rastreando cómo se menciona y percibe su marca en canales digitales. Especialmente relevante para la misión de AmICited, el PLN permite a las plataformas de monitoreo de IA detectar y analizar menciones de marca en respuestas generadas por sistemas como ChatGPT, Perplexity, Google AI Overviews y Claude. Estas plataformas utilizan reconocimiento de entidades nombradas para identificar nombres de marca, análisis de sentimiento para entender el contexto y tono de las menciones, y clasificación de texto para categorizar el tipo de mención. Esta capacidad es cada vez más crítica, ya que las organizaciones reconocen que su visibilidad de marca en respuestas de IA impacta directamente en el descubrimiento por parte de clientes y la reputación en la era de la IA generativa.

Tareas y capacidades clave del PLN

- Reconocimiento de Entidades Nombradas (NER): Identifica y extrae entidades específicas como personas, organizaciones, lugares, fechas y productos del texto, esencial para el monitoreo de marca y la extracción de información

- Análisis de Sentimiento: Determina el tono emocional y la opinión expresada en el texto, clasificando el contenido como positivo, negativo o neutral para comprender la percepción de marca

- Clasificación de Texto: Categoriza documentos o fragmentos en categorías predefinidas, permitiendo la organización y filtrado automatizado de grandes volúmenes de texto

- Traducción Automática: Convierte textos de un idioma a otro preservando el significado y el contexto, impulsado por modelos transformadores secuencia a secuencia

- Reconocimiento de Voz: Convierte el lenguaje hablado en texto, habilitando interfaces de voz y servicios de transcripción

- Resumen de Texto: Genera automáticamente resúmenes concisos de documentos extensos, ahorrando tiempo en el procesamiento de información

- Respuesta a Preguntas: Permite a los sistemas entender preguntas y recuperar o generar respuestas precisas de bases de conocimiento

- Resolución de Correferencias: Identifica cuándo diferentes palabras o frases se refieren a la misma entidad, crucial para comprender el contexto y las relaciones

- Etiquetado de Partes del Discurso: Identifica el rol gramatical de cada palabra, ayudando a entender la estructura y el significado de oraciones

- Modelado de Temas: Descubre temas y tópicos subyacentes en documentos o colecciones, útil para análisis y organización de contenido

Desafíos y limitaciones en el Procesamiento de Lenguaje Natural

A pesar de los avances notables, el Procesamiento de Lenguaje Natural enfrenta desafíos significativos que limitan su precisión y aplicabilidad. La ambigüedad es quizá el reto más fundamental: palabras y frases a menudo tienen varios significados según el contexto, y las oraciones pueden interpretarse de distintas formas. Por ejemplo, “Vi al hombre con el telescopio” podría significar que el hablante usó un telescopio para ver al hombre, o que el hombre tenía un telescopio. La comprensión contextual sigue siendo difícil para los sistemas de PLN, especialmente cuando el significado depende de información mucho anterior en un texto o de conocimientos del mundo real. El sarcasmo, los modismos y las metáforas suponen retos particulares, ya que su significado literal difiere del intencionado y los modelos entrenados en patrones estándar suelen malinterpretarlos. El tono de voz y los matices emocionales son difíciles de captar solo en texto—las mismas palabras pueden transmitir significados totalmente diferentes según la entonación, énfasis y lenguaje corporal. El sesgo en los datos de entrenamiento es una preocupación crítica; los modelos de PLN entrenados con datos extraídos de la web suelen heredar sesgos sociales, generando resultados discriminatorios o inexactos. La nueva terminología y la evolución lingüística desafían constantemente a los sistemas de PLN, ya que surgen palabras, jerga y convenciones gramaticales más rápido de lo que se pueden actualizar los datos de entrenamiento. Los idiomas y dialectos poco frecuentes reciben menos datos y, por tanto, los modelos tienen un rendimiento significativamente menor con estos hablantes. Los errores gramaticales, balbuceos, ruido de fondo y habla no estándar en datos de audio reales suponen desafíos adicionales para los sistemas de reconocimiento de voz. Estas limitaciones implican que incluso los sistemas de PLN más avanzados pueden malinterpretar el significado, especialmente en casos límite o al procesar lenguaje informal, creativo o culturalmente específico.

El futuro del PLN y tendencias emergentes

El campo del Procesamiento de Lenguaje Natural está evolucionando rápidamente, con varias tendencias emergentes que marcan su dirección futura. El PLN multimodal, que combina procesamiento de texto, imagen y audio, permite sistemas de IA más sofisticados capaces de comprender y generar contenido en múltiples modalidades simultáneamente. El aprendizaje few-shot y zero-shot reduce la necesidad de grandes volúmenes de datos etiquetados, permitiendo que los modelos de PLN realicen nuevas tareas con pocos ejemplos. La Generación Aumentada por Recuperación (RAG) mejora la precisión y fiabilidad del contenido generado por IA al vincular modelos de lenguaje con fuentes externas de conocimiento, reduciendo alucinaciones y mejorando la exactitud de los hechos. Se están desarrollando modelos de PLN eficientes para reducir los requerimientos computacionales, haciendo que capacidades avanzadas sean accesibles para organizaciones pequeñas y dispositivos edge. La IA explicable en PLN es cada vez más importante a medida que las organizaciones buscan entender cómo los modelos toman decisiones y cumplir con regulaciones. Los modelos de PLN específicos de dominio se están ajustando para aplicaciones especializadas en salud, legal, finanzas y otros sectores, mejorando la precisión para terminología y lenguaje propio de cada campo. La IA ética y mitigación de sesgos están recibiendo mayor atención ante la importancia de sistemas justos e imparciales. Lo más relevante para el monitoreo de marca es la integración del PLN con plataformas de monitoreo de IA, que se vuelve esencial a medida que las organizaciones reconocen que la visibilidad y percepción de su marca en respuestas generadas por IA impacta directamente en el descubrimiento de clientes y la competitividad. A medida que sistemas como ChatGPT, Perplexity y Google AI Overviews se convierten en fuentes primarias de información para consumidores, la capacidad de monitorear y comprender cómo aparecen las marcas en estos sistemas—respaldada por técnicas sofisticadas de PLN—será un componente clave de las estrategias modernas de marketing y gestión de marca.

El papel del PLN en el monitoreo de IA y la visibilidad de marca

El Procesamiento de Lenguaje Natural es la base tecnológica que permite a plataformas como AmICited rastrear menciones de marca en sistemas de IA. Cuando los usuarios consultan ChatGPT, Perplexity, Google AI Overviews o Claude, estos sistemas generan respuestas utilizando grandes modelos de lenguaje impulsados por técnicas avanzadas de PLN. AmICited emplea algoritmos de PLN para analizar estas respuestas generadas por IA, detectando cuándo se mencionan marcas, extrayendo el contexto de esas menciones y analizando el sentimiento expresado. El reconocimiento de entidades nombradas identifica nombres de marcas y entidades relacionadas, el análisis de sentimiento determina si las menciones son positivas, negativas o neutrales, y la clasificación de texto categoriza el tipo de mención (recomendación de producto, comparación, crítica, etc.). Esta capacidad brinda a las organizaciones visibilidad crucial sobre su presencia en IA—cómo se descubre y discute su marca dentro de sistemas de IA que cada vez más sirven como fuentes primarias de información para consumidores. A medida que el mercado de PLN continúa su trayectoria de crecimiento explosivo, con proyecciones que alcanzan los $439.85 mil millones para 2030, la importancia del monitoreo de marca impulsado por PLN solo aumentará, haciendo esencial que las organizaciones comprendan y aprovechen estas tecnologías para proteger y potenciar la reputación de su marca en el futuro impulsado por IA.