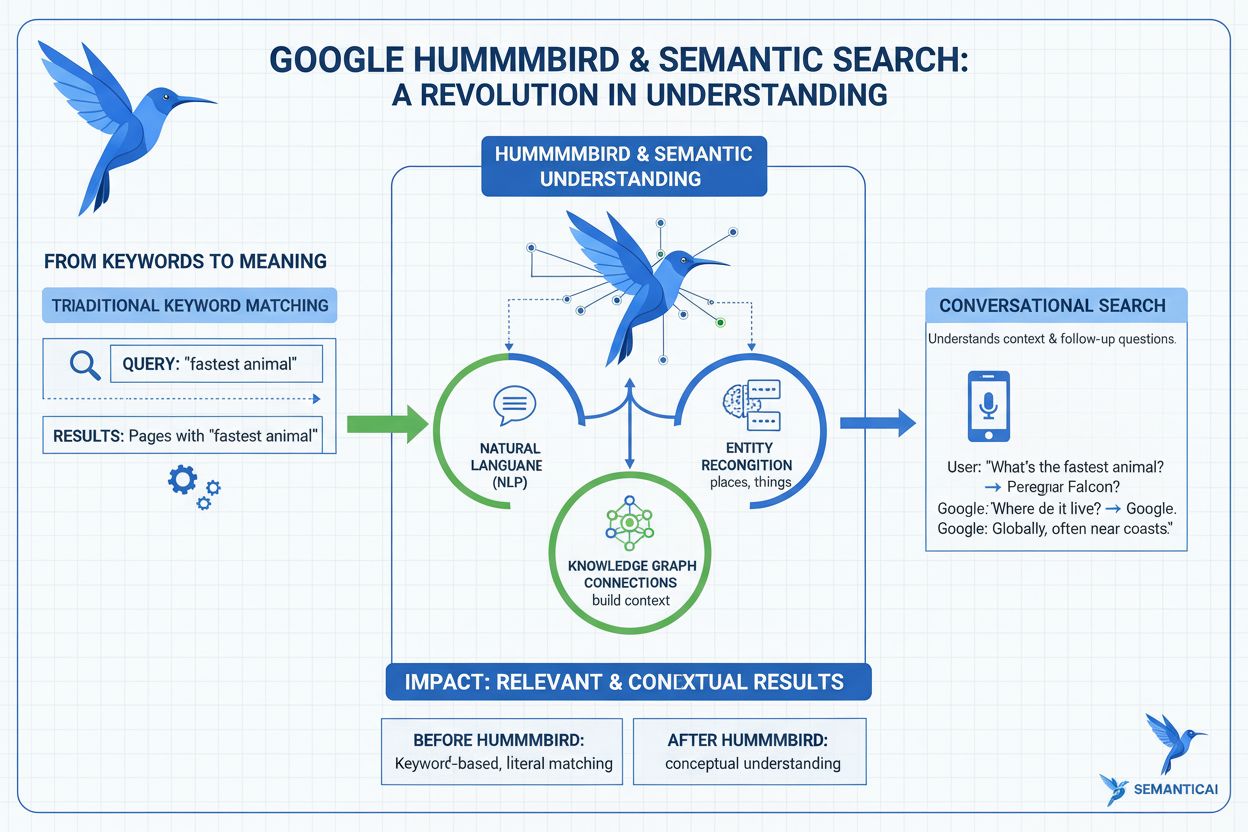

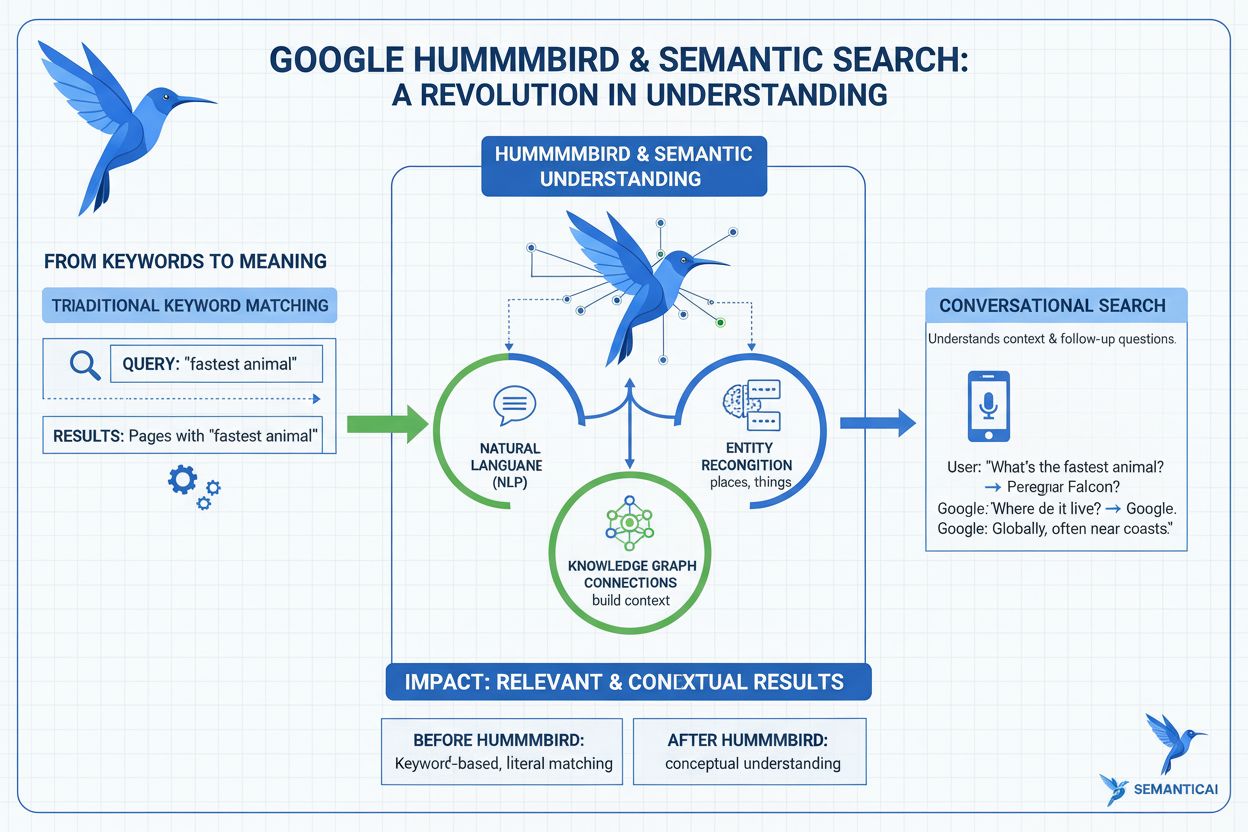

Actualización Hummingbird

Descubre qué es la Actualización Hummingbird, cómo revolucionó la búsqueda semántica en 2013 y por qué es relevante para el monitoreo de IA y la visibilidad de ...

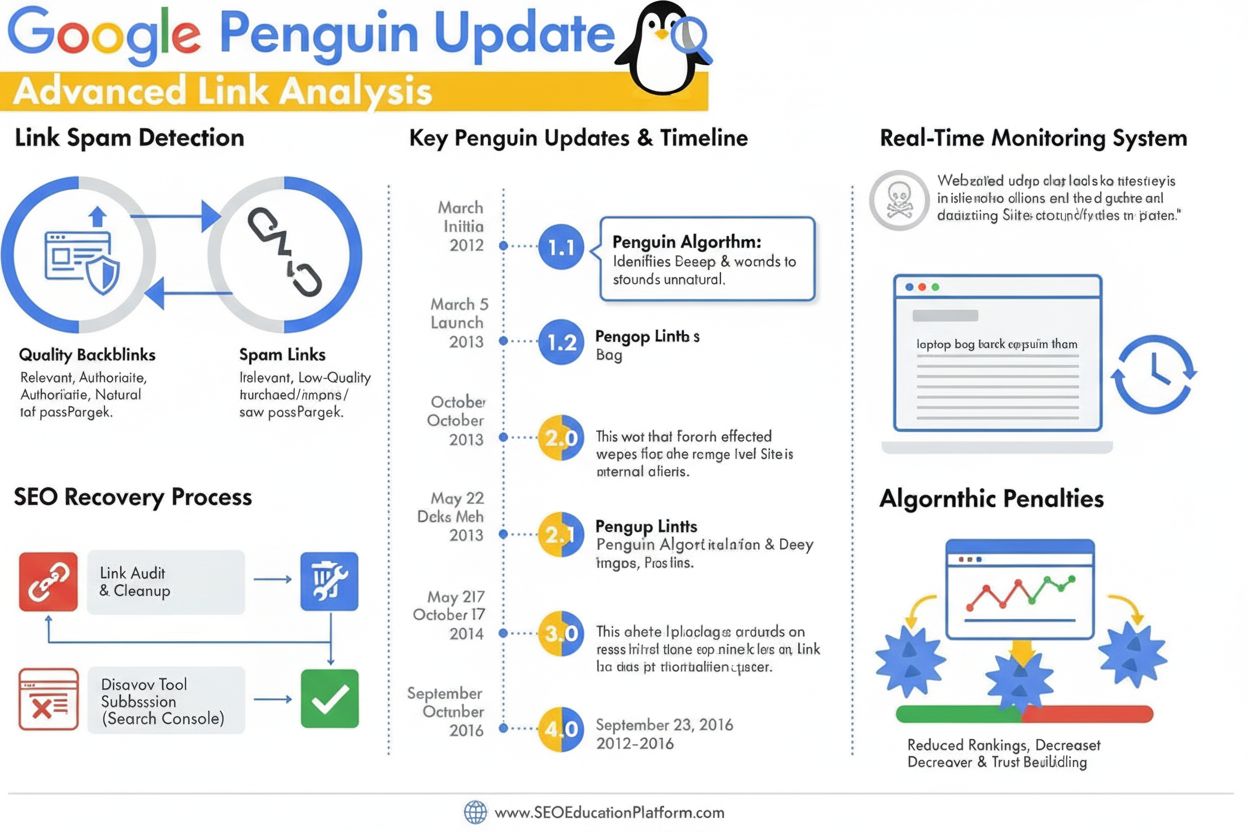

La Actualización Penguin es un algoritmo de Google diseñado para combatir el spam de enlaces y las prácticas manipuladoras de construcción de enlaces, identificando y devaluando los backlinks de baja calidad y no naturales. Lanzado por primera vez en abril de 2012, evolucionó en 2016 a un componente algorítmico en tiempo real que monitoriza y ajusta continuamente los rankings según la calidad de los enlaces y los patrones de esquemas de enlaces.

La Actualización Penguin es un algoritmo de Google diseñado para combatir el spam de enlaces y las prácticas manipuladoras de construcción de enlaces, identificando y devaluando los backlinks de baja calidad y no naturales. Lanzado por primera vez en abril de 2012, evolucionó en 2016 a un componente algorítmico en tiempo real que monitoriza y ajusta continuamente los rankings según la calidad de los enlaces y los patrones de esquemas de enlaces.

La Actualización Penguin es un algoritmo de Google diseñado específicamente para combatir el spam de enlaces y las prácticas manipuladoras de construcción de enlaces mediante la identificación, devaluación y penalización de sitios web con perfiles de backlinks no naturales o de baja calidad. Anunciada oficialmente por primera vez por Matt Cutts el 24 de abril de 2012, el algoritmo Penguin representó la respuesta contundente de Google al creciente problema de las técnicas SEO de sombrero negro que inflaban artificialmente los rankings a través de la compra de enlaces, intercambios de enlaces y otras prácticas engañosas. El objetivo principal del algoritmo es asegurar que los enlaces naturales, autoritativos y relevantes sean recompensados, mientras que los enlaces manipuladores y de spam sean degradados o ignorados por completo. A diferencia de actualizaciones centradas en contenido como Panda, que apunta a contenido de baja calidad, Penguin evalúa específicamente la calidad y autenticidad del perfil de enlaces entrantes de un sitio web, convirtiéndose en un componente crítico del sistema de ranking de Google durante más de una década.

La Actualización Penguin surgió durante un periodo crítico en la optimización para motores de búsqueda, cuando el volumen de enlaces tenía un peso desproporcionado en la determinación de los rankings. Antes del lanzamiento de Penguin, los webmasters podían aumentar artificialmente sus posiciones adquiriendo grandes cantidades de enlaces de baja calidad de granjas de enlaces, redes privadas de blogs y otras fuentes de spam. Esta práctica generó un grave problema en los resultados de Google, ya que sitios y contenidos de baja calidad aparecían en posiciones destacadas sin tener autoridad genuina ni relevancia. Matt Cutts, entonces jefe del equipo de webspam de Google, explicó en la conferencia SMX Advanced 2012 que “Lo vemos como algo diseñado para atacar el contenido de baja calidad. Empezó con Panda, y luego notamos que aún había mucho spam y Penguin fue creado para atacar eso.” El lanzamiento inicial de Penguin afectó a más del 3% de todas las consultas de búsqueda, convirtiéndolo en una de las actualizaciones de algoritmo más impactantes en la historia de Google. Este gran impacto señaló a la industria SEO que Google tomaba una postura firme contra las prácticas manipuladoras de enlaces, y que seguiría evolucionando sus algoritmos para mantener la calidad de las búsquedas.

El algoritmo Penguin funciona mediante sofisticados sistemas de aprendizaje automático y reconocimiento de patrones que analizan los perfiles de enlaces para identificar patrones no naturales. El algoritmo examina múltiples factores al evaluar la calidad de los enlaces, incluyendo la autoridad y relevancia de los dominios enlazantes, el anchor text utilizado, la velocidad de adquisición de enlaces y la relevancia contextual entre el sitio enlazante y el sitio objetivo. Penguin apunta específicamente a los esquemas de enlaces, que abarcan una amplia gama de prácticas manipuladoras como la compra de enlaces, intercambios recíprocos, enlaces provenientes de redes privadas de blogs (PBNs), enlaces de directorios de baja calidad y enlaces con anchor text excesivamente optimizado por palabras clave. El algoritmo también evalúa la proporción de enlaces de alta calidad frente a enlaces de baja calidad en el perfil de backlinks de un sitio, reconociendo que incluso los sitios legítimos pueden recibir algunos enlaces de baja calidad. Sin embargo, cuando la proporción de enlaces spam es desproporcionadamente alta, Penguin señala el sitio para posibles ajustes de ranking. Un aspecto clave del diseño de Penguin es que solo evalúa los enlaces entrantes a un sitio web; no analiza los enlaces salientes desde ese sitio, centrándose exclusivamente en la calidad de los backlinks que apuntan a un dominio.

La Actualización Penguin experimentó una evolución significativa desde su lanzamiento inicial a través de múltiples iteraciones, siendo el cambio más transformador el ocurrido en septiembre de 2016 con el lanzamiento de Penguin 4.0. Antes de este hito, Penguin operaba en un calendario de actualizaciones por lotes, con Google anunciando refrescos periódicos que reevaluaban los perfiles de backlinks y ajustaban los rankings en consecuencia. Penguin 1.1 (marzo de 2012) y Penguin 1.2 (octubre de 2012) fueron refrescos de datos que permitieron a sitios previamente penalizados recuperarse si habían limpiado sus perfiles de enlaces. Penguin 2.0 (mayo de 2013) fue una versión técnicamente más avanzada que afectó aproximadamente al 2.3% de las consultas en inglés y fue la primera iteración en mirar más allá de la página principal y las categorías superiores, examinando estructuras internas en busca de evidencia de spam de enlaces. Penguin 2.1 (octubre de 2013) y Penguin 3.0 (octubre de 2014) continuaron esta evolución con mejoras incrementales en la detección. Sin embargo, el lanzamiento de Penguin 4.0 cambió fundamentalmente la operativa del algoritmo al integrarlo en el algoritmo central de Google como un componente en tiempo real. Esto significó que los sitios ahora son evaluados continuamente, y los ajustes de ranking ocurren de inmediato según cambian los perfiles de enlaces, en lugar de esperar actualizaciones programadas. El paso al procesamiento en tiempo real también cambió el mecanismo de penalización de Penguin, pasando de penalizaciones directas en el ranking a la devaluación de enlaces, donde los enlaces spam son simplemente ignorados en lugar de causar caídas generales en el ranking del sitio.

| Factor de Evaluación | Enlaces de Alta Calidad | Enlaces de Baja Calidad/Spam | Detección por Penguin |

|---|---|---|---|

| Autoridad de la Fuente del Enlace | Dominios establecidos, confiables y con alta autoridad | Dominios nuevos, sitios de baja DA o redes reconocidas de spam | Analiza el historial del dominio, señales de confianza y relevancia temática |

| Anchor Text | Frases naturales, variadas y relevantes en contexto | Palabras clave exactas, repetitivas, sobreoptimizadas | Señala patrones no naturales y exceso de palabras clave |

| Velocidad de Enlaces | Adquisición gradual y orgánica en el tiempo | Picos repentinos o patrones no naturales | Monitorea la velocidad de adquisición y consistencia |

| Relevancia Contextual | Enlaces de fuentes autoritativas y relacionadas temáticamente | Enlaces de fuentes no relacionadas o de baja calidad | Evalúa la relevancia semántica entre el sitio enlazante y el objetivo |

| Ubicación del Enlace | Enlaces editoriales dentro del contenido, en contexto natural | Enlaces en footers, sidebars o granjas de enlaces | Evalúa ubicación e integración contextual |

| Calidad del Sitio Enlazante | Contenido de alta calidad, presencia empresarial legítima | Contenido escaso, páginas auto-generadas o PBNs | Examina la calidad general y autenticidad del contenido del sitio |

| Estado Nofollow | Atribuido correctamente cuando corresponde | Mal uso o ausencia en enlaces pagados/promocionales | Reconoce el uso adecuado de nofollow en enlaces no editoriales |

La Actualización Penguin transformó fundamentalmente las prácticas SEO al establecer la calidad de los enlaces como factor crítico de ranking y desalentar el uso generalizado de técnicas de construcción de enlaces de sombrero negro. Antes de Penguin, muchas agencias SEO y webmasters realizaban campañas agresivas de compra de enlaces, intercambios y creación de PBNs sin consecuencias significativas. El lanzamiento del algoritmo generó una disrupción inmediata en el mercado, con miles de sitios experimentando caídas drásticas en rankings y tráfico. Este cambio forzó a la industria SEO a adoptar prácticas más éticas y white-hat, centradas en obtener enlaces mediante la creación de contenido de calidad y relaciones genuinas. La penalización Penguin se convirtió en una advertencia que influyó en el enfoque de las empresas hacia la construcción de enlaces, llevando a una mayor inversión en marketing de contenidos, relaciones públicas y construcción de marca como estrategias primarias de adquisición de enlaces. Investigaciones de la industria muestran que entender y cumplir con los requisitos de Penguin se volvió esencial para el éxito SEO a largo plazo, con muchas organizaciones implementando auditorías de backlinks y monitoreo de enlaces como prácticas estándar. El algoritmo también elevó la importancia de la autoridad de dominio, relevancia temática y velocidad de adquisición de enlaces como métricas clave que los profesionales SEO monitorizan al evaluar oportunidades de enlaces. Más del 78% de las empresas ahora utilizan algún tipo de herramientas de monitoreo de contenido con IA o análisis de enlaces para rastrear sus perfiles de backlinks y asegurar el cumplimiento de las directrices de calidad de Google, resultado directo de la influencia de Penguin en los estándares de la industria.

Recuperarse de una degradación por Penguin requiere un enfoque sistemático que incluye auditorías de backlinks, eliminación de enlaces y el uso estratégico de la herramienta de desautorización de Google. El primer paso es realizar una auditoría completa de todos los enlaces entrantes usando Google Search Console y herramientas de terceros como Ahrefs, SEMrush o Moz, que ofrecen perfiles de backlinks detallados y evaluaciones de calidad. Los webmasters deben evaluar cada dominio enlazante individualmente para determinar si el enlace es de alta calidad y natural o representa una práctica manipuladora. Para los enlaces claramente spam o de baja calidad, el enfoque recomendado es contactar al webmaster del sitio enlazante y solicitar la eliminación. Google recomienda explícitamente no pagar por la eliminación de enlaces, ya que esto perpetúa el problema del comercio de enlaces. Para los enlaces que no pueden eliminarse mediante contacto, la herramienta de desautorización en Google Search Console permite enviar un archivo indicando a Google que ignore ciertos enlaces al evaluar el sitio. Es importante tener en cuenta que desautorizar un enlace también elimina cualquier valor positivo que pudiera haber aportado, por lo que la herramienta solo debe usarse para enlaces realmente dañinos. Una vez enviado el archivo de desautorización, Google lo procesa de inmediato, pero el impacto real en los rankings depende de cuándo Google recrawlee los enlaces desautorizados. Dado que Penguin 4.0 funciona en tiempo real, la recuperación puede producirse relativamente rápido—en días o semanas—una vez tomadas suficientes acciones correctivas. Sin embargo, los webmasters no deben esperar que los rankings regresen a los niveles previos a la penalización, ya que algunos de esos rankings pudieron estar inflados artificialmente por los enlaces de baja calidad que se están eliminando.

A medida que las plataformas de búsqueda con IA como ChatGPT, Perplexity, Google AI Overviews y Claude ganan importancia para la visibilidad de marca, comprender los principios de Penguin cobra relevancia más allá del ranking tradicional. Estos sistemas de IA suelen citar fuentes autoritativas y sitios web de alta calidad al generar respuestas, y los sitios con sólidos perfiles de backlinks e historiales limpios tienen mayor probabilidad de ser reconocidos como fuentes de autoridad por los datos de entrenamiento y los sistemas de recuperación de IA. Un sitio penalizado por Penguin por spam de enlaces puede no solo sufrir en los resultados orgánicos de Google, sino también ser despriorizado por sistemas de IA que evalúan la credibilidad de las fuentes. Por el contrario, los sitios que mantienen perfiles de backlinks limpios y de calidad tienen más posibilidades de ser citados como fuentes en respuestas generadas por IA. Esto crea un incentivo adicional para mantener el cumplimiento con Penguin más allá de las métricas SEO tradicionales. AmICited y plataformas similares de monitoreo de IA ayudan a las organizaciones a rastrear cómo aparecen sus dominios en respuestas generadas por IA, brindando visibilidad sobre si su autoridad es reconocida en múltiples sistemas de búsqueda con IA. La intersección entre el cumplimiento de Penguin y el rastreo de citas en IA representa una nueva frontera en el marketing digital, donde la calidad de los enlaces impacta tanto en la visibilidad tradicional como en la emergente visibilidad en búsqueda con IA.

La Actualización Penguin continúa evolucionando a medida que Google refina su entendimiento sobre la calidad de los enlaces y las prácticas manipuladoras. El cambio al procesamiento en tiempo real en 2016 representó un giro fundamental en la operativa del algoritmo, pero Google sigue perfeccionando sus capacidades de detección mediante aprendizaje automático e inteligencia artificial. Los desarrollos recientes en el sistema SpamBrain de Google, anunciados en 2022, representan la siguiente evolución en la detección de spam, incorporando IA avanzada para identificar tanto los sitios que compran enlaces como los que se utilizan para distribuirlos. Esto sugiere que las futuras iteraciones de la detección de spam de enlaces serán aún más sofisticadas, dificultando que las prácticas manipuladoras evadan la detección. La tendencia de la industria hacia el SEO white-hat y los medios ganados probablemente seguirá acelerándose a medida que los algoritmos de Google se vuelvan más efectivos para distinguir enlaces naturales de los artificiales. Además, a medida que las plataformas de búsqueda con IA ganan protagonismo, la importancia de mantener perfiles de backlinks limpios se extiende más allá del algoritmo de Google y abarca el reconocimiento como fuente de autoridad en múltiples sistemas de IA. Las organizaciones que prioricen la calidad de enlaces, la autoridad de marca y la excelencia en contenidos estarán mejor posicionadas para triunfar tanto en la búsqueda tradicional como en los entornos emergentes de búsqueda con IA. El legado de la Actualización Penguin no es solo un algoritmo específico, sino un cambio fundamental en cómo los motores de búsqueda y los sistemas de IA evalúan la autoridad de los sitios web, haciendo de la calidad de los enlaces un factor permanente y cada vez más importante en la visibilidad digital.

Una degradación Penguin es algorítmica y ocurre automáticamente cuando el algoritmo Penguin de Google detecta patrones de spam de enlaces, sin intervención manual. Una penalización Penguin (o acción manual) la emite el equipo de webspam de Google tras una revisión humana y requiere una solicitud de reconsideración para su levantamiento. Desde que Penguin 4.0 se volvió en tiempo real en 2016, las degradaciones algorítmicas pueden recuperarse casi inmediatamente una vez tomadas las acciones correctivas, mientras que las penalizaciones manuales requieren la aprobación explícita de Google.

La Actualización Penguin utiliza algoritmos de aprendizaje automático para analizar los perfiles de backlinks e identificar patrones de construcción de enlaces manipuladores, incluyendo enlaces comprados, intercambios de enlaces, redes privadas de blogs (PBNs) y patrones no naturales de anchor text. El algoritmo evalúa la proporción de enlaces naturales y de alta calidad frente a enlaces spam y de baja calidad que apuntan a un sitio web. También examina la relevancia y autoridad de los dominios enlazantes para determinar si los enlaces parecen obtenidos artificialmente en lugar de ganados editorialmente.

Sí, la recuperación es posible mediante un proceso de varios pasos que incluye auditorías de backlinks, eliminación de enlaces spam y el uso de la herramienta de desautorización de Google para aquellos enlaces que no pueda eliminar directamente. Dado que Penguin 4.0 funciona en tiempo real, la recuperación puede ser relativamente rápida una vez que haya limpiado su perfil de enlaces y Google recrawlee esas páginas. Sin embargo, la recuperación no garantiza volver a los rankings anteriores, ya que algunos de esos rankings pudieron haber estado inflados artificialmente por los enlaces de baja calidad que está eliminando.

Penguin penaliza enlaces provenientes de granjas de enlaces, redes de enlaces pagados, redes privadas de blogs (PBNs), intercambios recíprocos de enlaces y sitios con patrones no naturales de anchor text. También apunta a enlaces de directorios de baja calidad, spam en comentarios, spam en foros y enlaces obtenidos mediante prácticas manipuladoras. Además, Penguin señala enlaces provenientes de sitios de alta autoridad que parecen vendidos o colocados como publirreportajes sin las etiquetas nofollow adecuadas, ya que esto infringe las directrices de esquemas de enlaces de Google.

Desde que se lanzó Penguin 4.0 en septiembre de 2016, el algoritmo funciona de manera continua en tiempo real como parte del algoritmo central de Google. Esto significa que Google evalúa constantemente los perfiles de backlinks y ajusta los rankings según la calidad de los enlaces sin esperar actualizaciones programadas. Anteriormente, Penguin operaba en un calendario de actualizaciones por lotes con anuncios de Google, pero el procesamiento en tiempo real eliminó la necesidad de estos anuncios y permite una recuperación más rápida cuando se corrigen los problemas.

La herramienta de desautorización es una función de Google Search Console que permite a los webmasters indicar a Google que ignore determinados backlinks al evaluar su sitio. Se usa como último recurso cuando no puede contactar directamente con los webmasters para eliminar enlaces spam. Al desautorizar enlaces de baja calidad, evita que afecten negativamente a su ranking bajo el algoritmo Penguin. Sin embargo, los enlaces desautorizados también dejan de aportar cualquier valor positivo, por lo que solo debe usarse para enlaces genuinamente dañinos.

La actualización Penguin original lanzada en abril de 2012 afectó a más del 3% de todas las consultas de búsqueda según estimaciones de Google. Las actualizaciones posteriores tuvieron impactos variados: Penguin 2.0 afectó aproximadamente al 2.3% de las consultas en inglés, Penguin 2.1 a cerca del 1% y Penguin 3.0 a menos del 1% de las consultas en inglés. Estos porcentajes representan millones de sitios web a nivel mundial, haciendo de Penguin una de las actualizaciones de algoritmo más significativas en la historia de las búsquedas.

Comienza a rastrear cómo los chatbots de IA mencionan tu marca en ChatGPT, Perplexity y otras plataformas. Obtén información procesable para mejorar tu presencia en IA.

Descubre qué es la Actualización Hummingbird, cómo revolucionó la búsqueda semántica en 2013 y por qué es relevante para el monitoreo de IA y la visibilidad de ...

Aprenda sobre la Actualización Panda de Google, el cambio de algoritmo de 2011 dirigido a contenido de baja calidad. Entienda cómo funciona, su impacto en el SE...

Aprende qué son las Actualizaciones del Algoritmo de Google, cómo funcionan y su impacto en el SEO. Comprende las actualizaciones principales, de spam y los cam...

Consentimiento de Cookies

Usamos cookies para mejorar tu experiencia de navegación y analizar nuestro tráfico. See our privacy policy.