Reformulación de consultas

Descubre cómo la reformulación de consultas ayuda a los sistemas de IA a interpretar y mejorar las consultas de los usuarios para una mejor recuperación de info...

El refinamiento de consultas es el proceso de mejorar y optimizar las consultas de búsqueda mediante ajustes iterativos, aclaraciones y expansiones para generar resultados más precisos, relevantes y completos de los motores de búsqueda de IA y los sistemas de recuperación de información. Implica desglosar consultas de usuario complejas en subconsultas, añadir detalles contextuales y aprovechar bucles de retroalimentación para mejorar progresivamente el rendimiento de la búsqueda y la calidad de los resultados.

El refinamiento de consultas es el proceso de mejorar y optimizar las consultas de búsqueda mediante ajustes iterativos, aclaraciones y expansiones para generar resultados más precisos, relevantes y completos de los motores de búsqueda de IA y los sistemas de recuperación de información. Implica desglosar consultas de usuario complejas en subconsultas, añadir detalles contextuales y aprovechar bucles de retroalimentación para mejorar progresivamente el rendimiento de la búsqueda y la calidad de los resultados.

El refinamiento de consultas es el proceso iterativo de mejorar y optimizar las consultas de búsqueda mediante ajustes sistemáticos, aclaraciones y expansiones para generar resultados más precisos, relevantes y completos de los sistemas de recuperación de información y motores de búsqueda de IA. En lugar de tratar la búsqueda inicial de un usuario como definitiva, el refinamiento de consultas reconoce que los usuarios a menudo necesitan modificar, expandir o aclarar sus consultas para encontrar exactamente lo que buscan. Este proceso implica analizar cómo los usuarios modifican sus búsquedas, sugerir formulaciones mejoradas de consultas y aprovechar bucles de retroalimentación para mejorar progresivamente el rendimiento de la búsqueda. En el contexto de plataformas modernas de búsqueda de IA como ChatGPT, Perplexity, Google AI Overviews y Claude, el refinamiento de consultas se ha convertido en un mecanismo fundamental para ofrecer respuestas completas y de múltiples fuentes que abordan preguntas complejas de los usuarios. La técnica transforma la búsqueda de una interacción única y estática en una conversación dinámica de varios pasos donde cada refinamiento acerca a los usuarios a la información deseada.

El refinamiento de consultas no es un concepto nuevo en la recuperación de información, pero su aplicación ha evolucionado drásticamente con el auge de la inteligencia artificial y los grandes modelos de lenguaje. Históricamente, los motores de búsqueda se basaban principalmente en la coincidencia de palabras clave, donde la consulta del usuario se comparaba directamente con los documentos indexados. Si buscabas “zapatillas para correr”, el motor devolvía documentos que contenían esas palabras exactas, independientemente del contexto o la intención del usuario. Este enfoque era rígido y a menudo producía resultados irrelevantes porque ignoraba los matices del lenguaje humano y la complejidad de las necesidades de los usuarios.

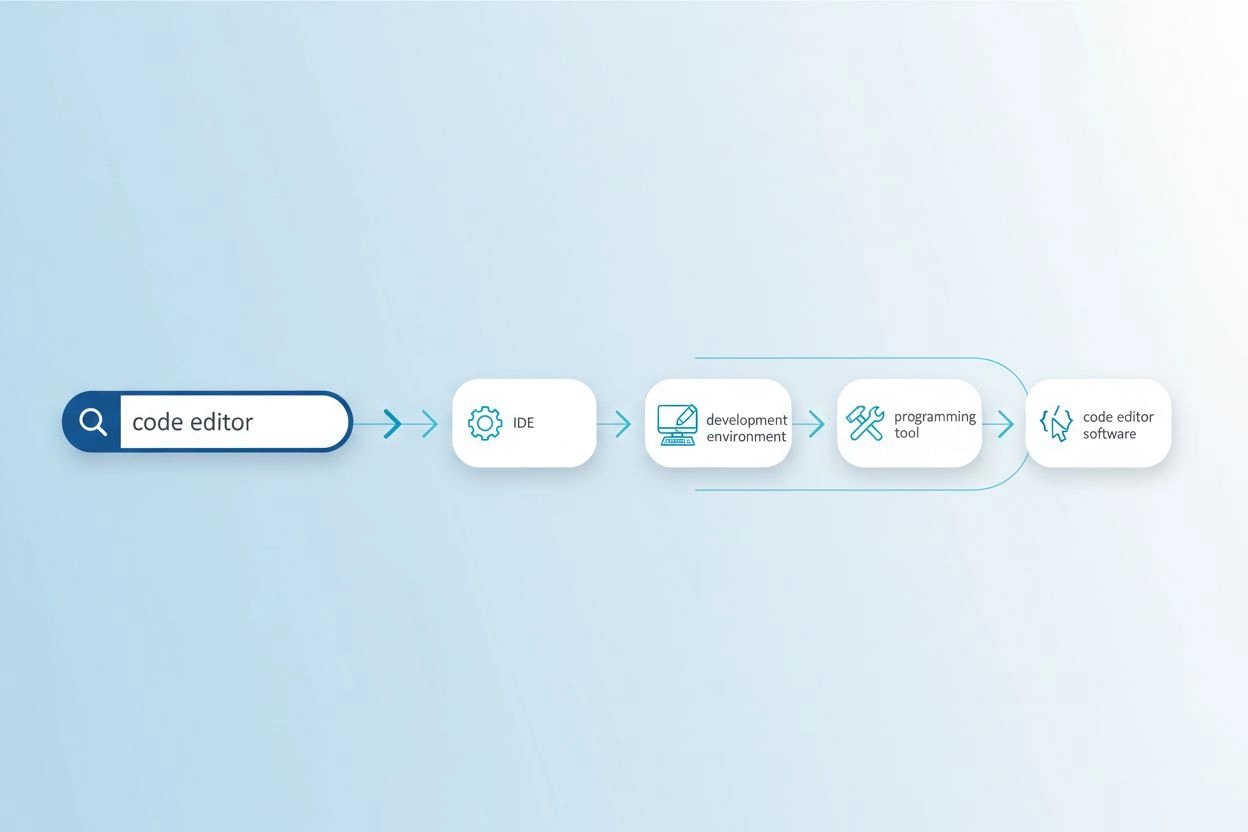

La evolución hacia el refinamiento de consultas comenzó con la introducción de los sistemas de sugerencia de consultas a principios de la década de 2000, donde los motores de búsqueda empezaron a analizar patrones de comportamiento de los usuarios para sugerir consultas relacionadas o refinadas. La función “¿Quisiste decir?” de Google y las sugerencias de autocompletado fueron implementaciones tempranas de este concepto. Sin embargo, estos sistemas eran relativamente simples, basados principalmente en registros históricos de consultas y análisis de frecuencia. Carecían de la comprensión semántica necesaria para comprender realmente la intención del usuario o las relaciones entre diferentes formulaciones de consultas.

La introducción del procesamiento de lenguaje natural (PLN) y el aprendizaje automático transformó fundamentalmente el refinamiento de consultas. Los sistemas modernos pueden ahora comprender que “mejores zapatillas impermeables para correr” y “calzado deportivo resistente a la lluvia mejor valorado” son esencialmente la misma consulta, a pesar de utilizar terminología completamente diferente. Esta comprensión semántica permite a los sistemas reconocer variaciones de consulta, identificar necesidades implícitas de los usuarios y sugerir refinamientos que realmente mejoran los resultados de búsqueda. Según investigaciones de la Kopp Online Marketing SEO Research Suite, las metodologías de refinamiento de consultas se han vuelto cada vez más sofisticadas, con sistemas ahora capaces de generar consultas sintéticas (consultas artificialmente creadas que simulan búsquedas reales de usuarios) para mejorar los datos de entrenamiento y la precisión de recuperación.

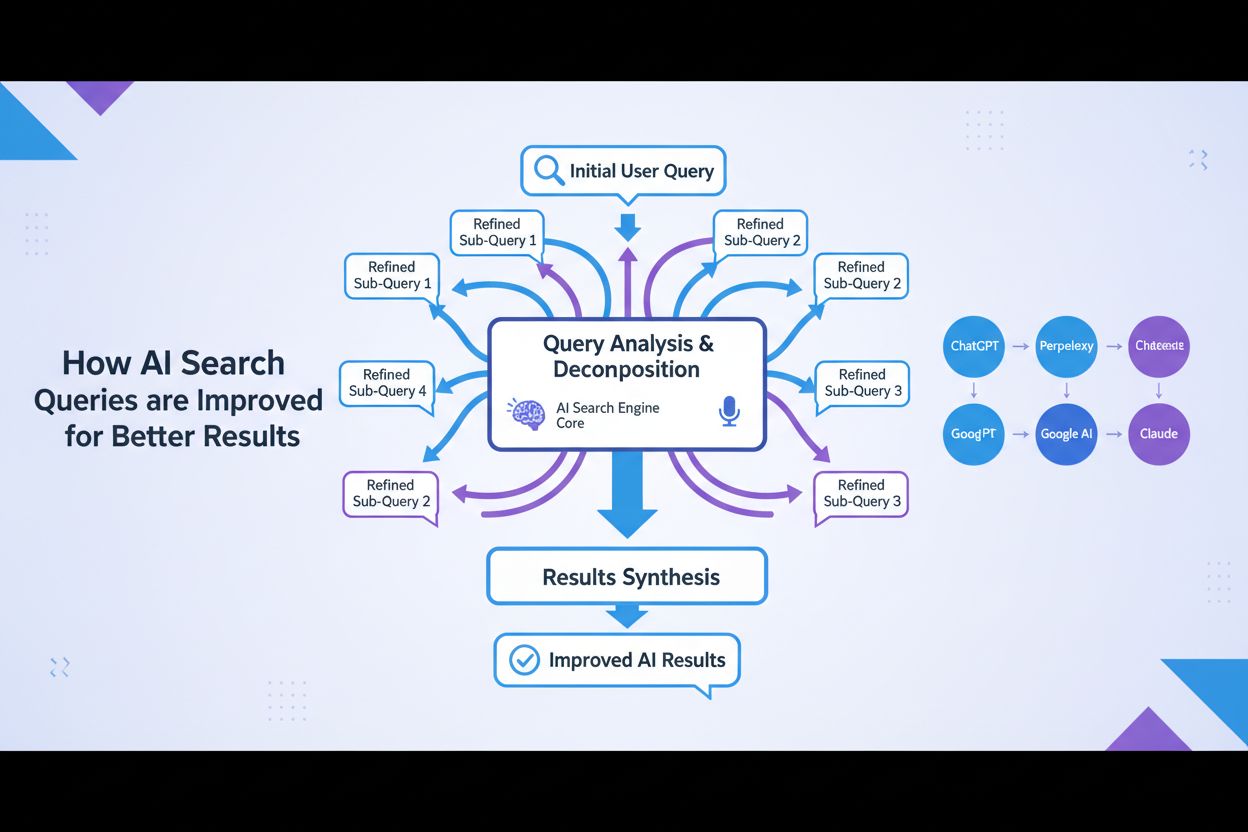

La aparición de la IA generativa y los grandes modelos de lenguaje ha acelerado aún más esta evolución. Los motores de búsqueda de IA modernos no solo refinan consultas; las descomponen en múltiples subconsultas, las ejecutan en paralelo en diversas fuentes de datos y sintetizan los resultados en respuestas completas. Esto representa un cambio fundamental, pasando de un refinamiento de consultas como función de sugerencia al usuario a un refinamiento de consultas como componente arquitectónico central de los sistemas de búsqueda de IA.

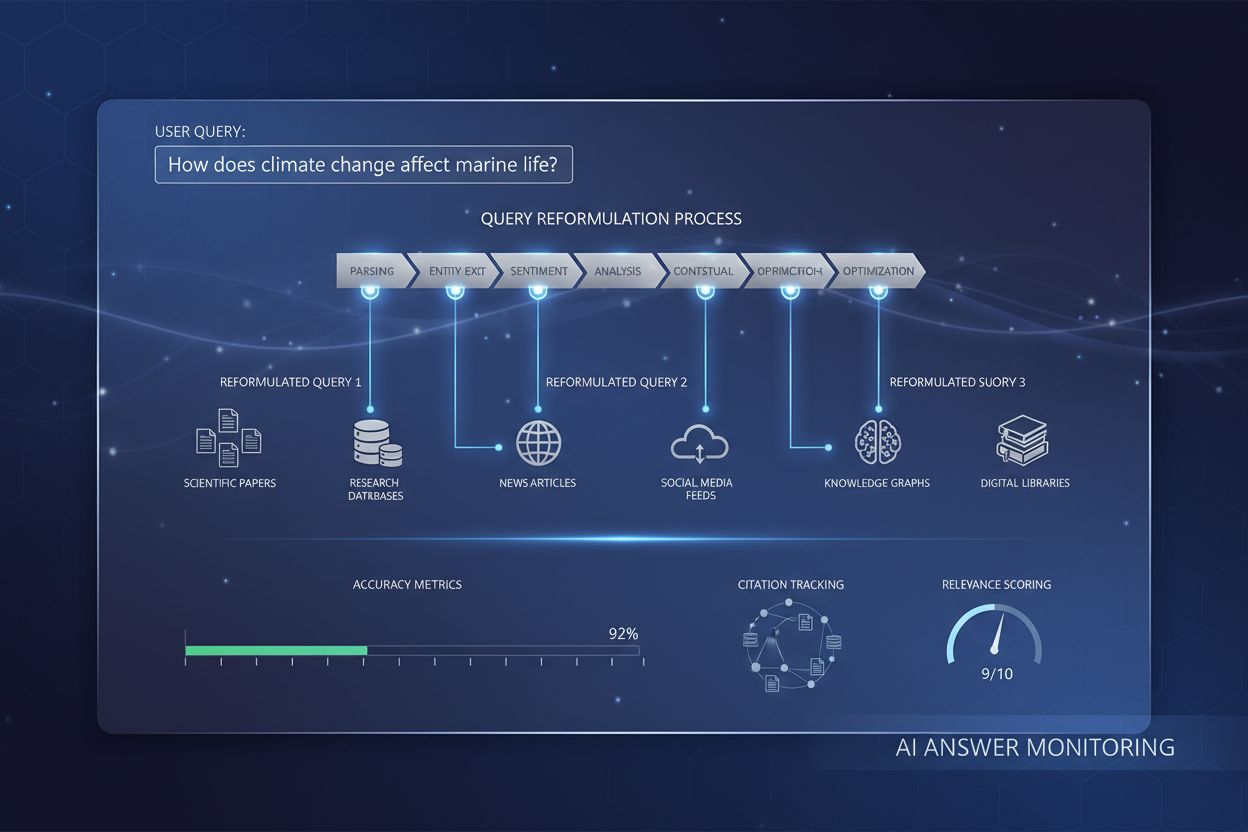

El refinamiento de consultas funciona a través de varios mecanismos técnicos interconectados que colaboran para mejorar la calidad de la búsqueda. El primer mecanismo es el análisis de consultas y detección de intención, donde el sistema procesa la consulta inicial del usuario para identificar la intención subyacente, el nivel de complejidad y el tipo de respuesta necesaria. Los modelos avanzados de PLN analizan factores como la longitud de la consulta, la especificidad de la terminología y las señales contextuales para determinar si basta con una simple coincidencia de palabras clave o si es necesario un refinamiento más sofisticado. Por ejemplo, una consulta factual simple como “capital de Alemania” podría no activar un refinamiento extensivo, mientras que una consulta compleja como “mejores prácticas para optimizar contenido para motores de búsqueda de IA” activaría procesos de refinamiento completos.

El segundo mecanismo es la descomposición de consultas y expansión, una técnica en la que las consultas complejas se dividen en múltiples subconsultas constituyentes. Este proceso, conocido como expansión de consultas, es particularmente importante en los sistemas de búsqueda de IA. Cuando un usuario pregunta “¿Cuáles son las mejores zapatillas impermeables para alguien con pies planos que corre en senderos?”, el sistema descompone esto en múltiples subconsultas: una que explora listados de productos, otra que investiga reseñas de expertos, otra que analiza experiencias de usuarios y otra que examina especificaciones técnicas. Estas subconsultas se ejecutan simultáneamente en diferentes fuentes de datos, incluidos la web en vivo, grafos de conocimiento y bases de datos especializadas. Esta ejecución paralela amplía drásticamente el conjunto de información disponible para la síntesis, permitiendo a la IA brindar respuestas más completas y matizadas.

El tercer mecanismo es la ampliación de consultas, que consiste en generar consultas adicionales para mejorar el rendimiento de la búsqueda. Según investigaciones de la Kopp Online Marketing SEO Research Suite, la ampliación de consultas utiliza varios métodos: análisis de datos históricos (examinando refinamientos previos en los historiales de búsqueda de los usuarios), sustitución de n-gramas (modificando consultas reemplazando secuencias contiguas de términos), asociación de entidades (identificando entidades de los resultados de búsqueda y combinándolas con los términos originales de la consulta) e identificación de consultas hermanas (encontrando consultas relacionadas que comparten consultas parentales). Estas técnicas de ampliación aseguran que el sistema explore múltiples ángulos y perspectivas sobre la necesidad de información del usuario.

El cuarto mecanismo son los bucles de retroalimentación y mejora continua, donde las interacciones de los usuarios con los resultados de búsqueda informan el proceso de refinamiento. Cuando los usuarios hacen clic en ciertos resultados, pasan tiempo en páginas determinadas o reformulan sus consultas, estos datos retroalimentan el sistema para mejorar futuros refinamientos. Se pueden aplicar técnicas de aprendizaje por refuerzo para optimizar modelos generativos, mejorando la calidad de las variantes de consulta a lo largo del tiempo en función de respuestas satisfactorias. Esto crea un ciclo virtuoso donde cada interacción del usuario hace que el sistema sea más inteligente y eficaz al refinar consultas.

| Aspecto | Google AI Overviews | ChatGPT | Perplexity | Claude |

|---|---|---|---|---|

| Método principal de refinamiento | Expansión de consultas con búsqueda temática | Refinamiento conversacional de varios turnos | Sugerencias de consultas interactivas con seguimientos | Aclaración contextual mediante diálogo |

| Generación de subconsultas | Descomposición automática basada en intención | Guiado por el usuario mediante conversación | Refinamientos sugeridos mostrados como pastillas | Implícito mediante comprensión del contexto |

| Fuentes de datos | Web en vivo, grafos de conocimiento, grafos de compras | Datos de entrenamiento + búsqueda web (con plugins) | Búsqueda web en tiempo real en múltiples fuentes | Datos de entrenamiento con capacidad de búsqueda web |

| Mecanismo de citación | Atribución directa de fuentes en el resumen | Referencias de enlaces en respuestas | Tarjetas de fuente con atribución detallada | Citas en línea con enlaces a fuentes |

| Control del usuario | Limitado (refinamiento dirigido por el sistema) | Alto (el usuario dirige la conversación) | Medio (refinamientos sugeridos + entrada personalizada) | Alto (el usuario puede solicitar refinamientos específicos) |

| Visibilidad del refinamiento | Implícito (el usuario ve la respuesta sintetizada) | Explícito (el usuario ve el historial de conversación) | Explícito (sugerencias de refinamiento visibles) | Implícito (refinamiento mediante diálogo) |

| Velocidad del refinamiento | Inmediata (procesamiento en paralelo) | Secuencial (turno a turno) | Inmediata (búsqueda en tiempo real) | Secuencial (basado en conversación) |

| Nivel de personalización | Alto (basado en historial de búsqueda y ubicación) | Medio (basado en contexto conversacional) | Medio (basado en datos de sesión) | Medio (basado en contexto conversacional) |

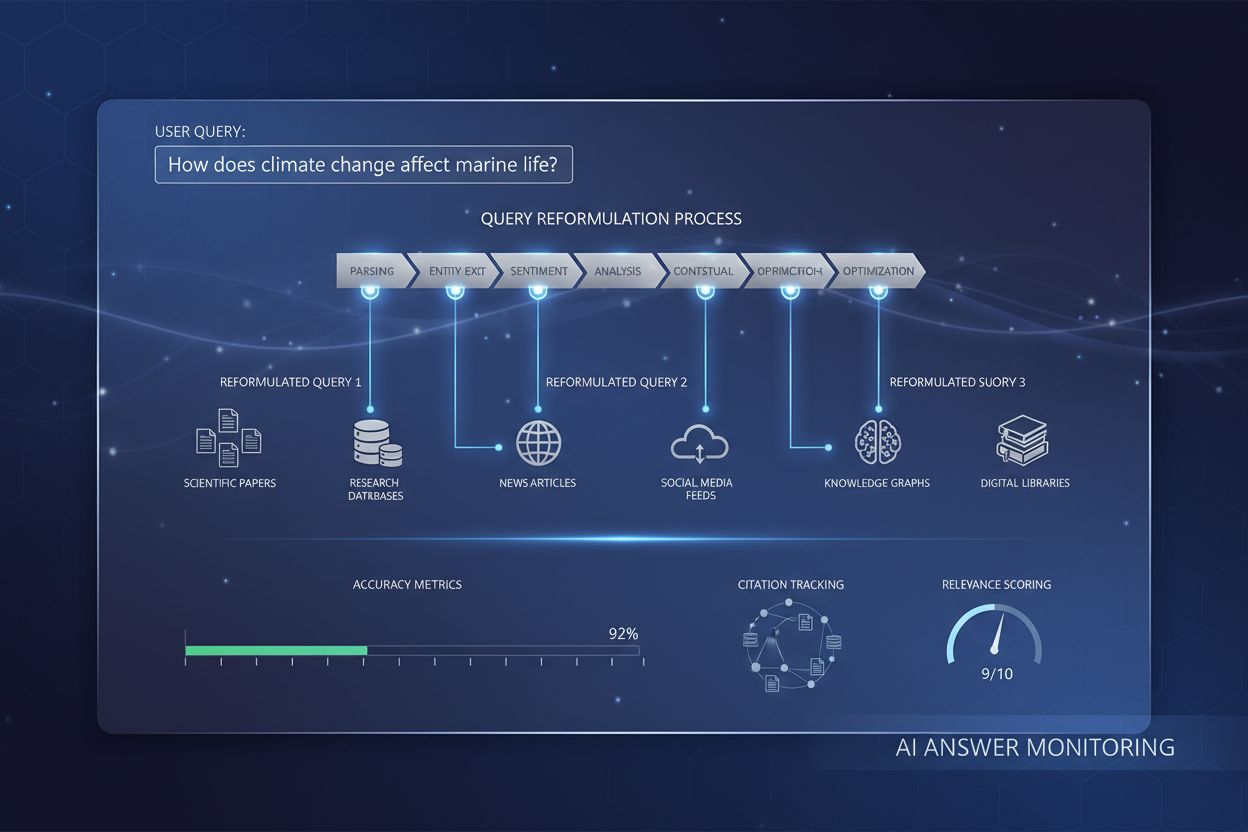

El proceso de refinamiento de consultas en los motores de búsqueda de IA contemporáneos sigue un flujo de trabajo sofisticado y de varias etapas que difiere significativamente de la búsqueda tradicional. Cuando un usuario envía una consulta a un sistema como Google AI Mode o ChatGPT, el sistema no busca resultados de inmediato. Primero, analiza la consulta utilizando procesamiento avanzado de lenguaje natural para entender qué está pidiendo realmente el usuario. Este análisis considera factores como el historial de búsqueda del usuario, ubicación, tipo de dispositivo y la complejidad de la propia consulta. El sistema determina si la consulta es sencilla (requiere solo coincidencia de palabras clave) o compleja (requiere descomposición y síntesis de múltiples fuentes).

Para consultas complejas, el sistema activa el proceso de expansión de consultas. Esto implica dividir la consulta original en múltiples subconsultas relacionadas que exploran diferentes facetas de la necesidad de información del usuario. Por ejemplo, si un usuario pregunta “¿Cómo debo optimizar mi sitio web para motores de búsqueda de IA?”, el sistema podría generar subconsultas como: “¿Cuáles son los factores clave de ranking para motores de búsqueda de IA?”, “¿Cómo evalúan los sistemas de IA la calidad del contenido?”, “¿Qué es E-E-A-T y por qué es importante para la IA?”, “¿Cómo estructuro el contenido para la citación por IA?” y “¿Cuáles son las mejores prácticas para el formato de contenido amigable para IA?”. Cada una de estas subconsultas se ejecuta en paralelo en diferentes fuentes de datos, recuperando información diversa que aborda distintos aspectos de la pregunta original.

Luego, el sistema evalúa la información recuperada utilizando señales de calidad como autoridad de dominio, frescura del contenido, relevancia temática y patrones de citación. La información de múltiples fuentes se combina y sintetiza en una respuesta coherente y completa que responde directamente a la consulta original. Durante este proceso, el sistema identifica las fuentes más autorizadas y relevantes, que luego se presentan como citaciones o referencias en la respuesta final. Por eso, entender el refinamiento de consultas es fundamental para los usuarios de AmICited: las fuentes que aparecen en las respuestas generadas por IA se determinan en gran medida por la alineación con las subconsultas refinadas que genera el sistema de IA.

La relación entre el refinamiento de consultas y la visibilidad de búsqueda en AI Overviews es directa y medible. Las investigaciones muestran que más del 88% de las búsquedas que activan AI Overviews tienen intención informacional, es decir, los usuarios buscan aprender sobre algo en lugar de realizar una compra o navegar a un sitio específico. Estas consultas informacionales son precisamente las que más probablemente se someten a un refinamiento extenso, ya que a menudo requieren síntesis de múltiples fuentes para proporcionar una respuesta completa. Cuando tu contenido se alinea con las subconsultas refinadas que genera un sistema de IA, tu sitio web tiene una probabilidad significativamente mayor de ser citado como fuente.

Los datos son contundentes: ser presentado como fuente en AI Overview incrementa la tasa de clics del 0,6% al 1,08%, casi duplicando el tráfico en comparación con aparecer solo en los resultados de búsqueda tradicionales por debajo del resumen. Esto hace que la comprensión del refinamiento de consultas sea esencial para la estrategia SEO moderna. En lugar de optimizar para una sola palabra clave, los creadores de contenido deben pensar en cómo su contenido aborda las diversas consultas refinadas que podría generar un sistema de IA. Por ejemplo, si escribes sobre “moda sostenible”, debes anticipar que un sistema de IA podría refinar esto en subconsultas sobre “impacto ambiental de la moda rápida”, “prácticas éticas de fabricación”, “materiales sostenibles”, “certificaciones de comercio justo” y “marcas sostenibles económicas”. Tu contenido debe abordar de manera completa estos ángulos refinados para maximizar el potencial de citación.

Además, las investigaciones indican que aproximadamente el 70% de los usuarios solo leen el primer tercio de los AI Overviews, lo que significa que ser citado temprano en la respuesta es mucho más valioso que aparecer más tarde. Esto sugiere que los creadores de contenido deben estructurar su información con las respuestas más críticas y resumidas al principio, en un formato claro y citables. El objetivo es convertirse en la fuente que el sistema de IA “debe” citar para proporcionar una respuesta creíble y completa a las consultas refinadas que genera.

El refinamiento de consultas efectivo requiere comprender e implementar varias técnicas clave. La primera técnica es la adición de detalles contextuales, donde los usuarios o sistemas añaden contexto específico para hacer las consultas más precisas. En lugar de buscar “zapatillas para correr”, una consulta refinada podría ser “mejores zapatillas impermeables para mujer con arco alto por menos de $150”. Este contexto adicional ayuda a los sistemas de IA a entender las restricciones y preferencias específicas que importan al usuario, permitiendo una recuperación de información más dirigida. Para los creadores de contenido, esto significa anticipar estos refinamientos contextuales y crear contenido que aborde casos de uso, demografías y limitaciones específicas.

La segunda técnica es la especificación de restricciones, donde los usuarios definen límites o parámetros para su búsqueda. Esto puede incluir rangos de precios, ubicaciones geográficas, marcos de tiempo o estándares de calidad. Los sistemas de IA reconocen estas restricciones y refinan su búsqueda en consecuencia. Por ejemplo, una consulta sobre “mejor software de gestión de proyectos para equipos remotos con menos de 50 empleados” incluye múltiples restricciones que deben guiar la creación de contenido. Tu contenido debe abordar explícitamente estos escenarios de restricción para aumentar la probabilidad de citación.

La tercera técnica es el seguimiento de preguntas, donde los usuarios realizan preguntas aclaratorias para refinar su comprensión. En sistemas de IA conversacionales como ChatGPT, los usuarios pueden preguntar “¿Puedes explicarlo más sencillo?” o “¿Cómo aplica eso a pequeñas empresas?”. Estas preguntas de seguimiento activan el refinamiento de consultas, donde el sistema ajusta su enfoque según la retroalimentación del usuario. Por eso, la profundidad conversacional y la capacidad de abordar múltiples ángulos de un tema son cada vez más importantes para la visibilidad del contenido.

La cuarta técnica es la descomposición de consultas, donde las preguntas complejas se dividen en preguntas más simples y componentes. Esto es especialmente importante para los sistemas de IA, que utilizan esta técnica para asegurar una cobertura completa de un tema. Si un usuario pregunta “¿Cuáles son las mejores prácticas para optimizar sitios de comercio electrónico para motores de búsqueda de IA?”, un sistema de IA podría descomponer esto en: “¿Qué son los motores de búsqueda de IA?”, “¿Cómo clasifican los sistemas de IA el contenido de comercio electrónico?”, “¿Qué optimizaciones técnicas importan?”, “¿Cómo deben estructurarse las descripciones de productos?” y “¿Qué papel juega el contenido generado por usuarios?”. El contenido que aborde de manera completa estas preguntas componentes tendrá más probabilidades de ser citado en múltiples consultas refinadas.

La Optimización para Motores Generativos (GEO), también conocida como Optimización para Grandes Modelos de Lenguaje (LLMO), se basa fundamentalmente en comprender y optimizar los procesos de refinamiento de consultas. El SEO tradicional se enfocaba en posicionarse para palabras clave específicas; GEO se centra en convertirse en fuente citada en las consultas refinadas que generan los sistemas de IA. Esto representa un cambio de paradigma en la forma en que los creadores de contenido deben abordar la optimización para búsqueda.

En el contexto GEO, el refinamiento de consultas no es algo que le suceda a tu contenido—es algo que debes anticipar y para lo que debes prepararte. Al crear contenido, debes pensar en todas las formas en que un sistema de IA podría refinar o descomponer tu tema en subconsultas. Por ejemplo, si escribes sobre “moda sostenible”, deberías crear contenido que aborde: el impacto ambiental de la moda convencional, materiales sostenibles y sus propiedades, prácticas éticas de fabricación y laborales, certificaciones y estándares, consideraciones de costos, recomendaciones de marcas y cómo hacer la transición hacia la moda sostenible. Al abordar de manera completa estos ángulos refinados, aumentas la probabilidad de que tu contenido sea citado en múltiples respuestas generadas por IA.

La investigación de las Estadísticas de SEO IA 2026 de Elementor muestra que el tráfico de búsqueda de IA creció un 527% interanual, con algunos sitios reportando ya más del 1% de sus sesiones totales provenientes de plataformas como ChatGPT, Perplexity y Copilot. Este crecimiento explosivo subraya la importancia de entender el refinamiento de consultas. Además, el tráfico proveniente de plataformas de IA es significativamente más valioso—los visitantes referidos por IA valen 4,4 veces más que los visitantes orgánicos tradicionales, con tasas de rebote un 27% menores y duraciones de sesión un 38% más largas para sitios de comercio minorista. Esto significa que optimizar para el refinamiento de consultas no es solo cuestión de visibilidad; se trata de atraer tráfico de alta calidad y listo para convertir.

El futuro del refinamiento de consultas avanza hacia sistemas cada vez más sofisticados, personalizados y autónomos. La generación de consultas sintéticas es cada vez más avanzada, con sistemas de IA capaces de generar consultas diversas y contextualmente adecuadas que simulan patrones reales de búsqueda de usuarios. Estas consultas sintéticas son esenciales para entrenar sistemas de IA que puedan manejar consultas nuevas o raramente usadas, aprovechando patrones aprendidos e información contextual. A medida que los sistemas de IA ganan capacidades, generarán subconsultas cada vez más matizadas y específicas, requiriendo que los creadores de contenido piensen aún más a fondo en los distintos ángulos y perspectivas de sus temas.

Otra tendencia emergente es el refinamiento de consultas con estado, donde los sistemas de IA mantienen el contexto a lo largo de varios turnos de conversación, permitiendo un refinamiento más sofisticado basado en las necesidades y preferencias cambiantes del usuario. En lugar de tratar cada consulta como independiente, estos sistemas comprenden cómo se relacionan las consultas con interacciones previas, permitiendo refinamientos más personalizados y contextualmente adecuados. Esto tiene implicaciones para la estrategia de contenido—tu contenido debe estar estructurado para apoyar conversaciones de varios turnos en las que los usuarios refinan progresivamente su comprensión.

La integración de aprendizaje por refuerzo en los sistemas de refinamiento de consultas también es significativa. Estos sistemas pueden aprender de la retroalimentación del usuario para mejorar continuamente la calidad de los refinamientos de consultas a lo largo del tiempo. Si los usuarios hacen clic consistentemente en ciertas fuentes o pasan más tiempo en páginas específicas, el sistema aprende a priorizar esas fuentes en futuros refinamientos. Esto crea una ventaja competitiva para los creadores de contenido que proporcionan información de alta calidad y autoridad, convirtiéndose en las fuentes “de referencia” que los sistemas de IA aprenden a citar.

Además, el auge de los agentes de IA y los sistemas de búsqueda autónomos sugiere que el refinamiento de consultas será aún más sofisticado. En lugar de que los usuarios refinen consultas manualmente, los agentes de IA generarán y ejecutarán consultas refinadas de forma autónoma en nombre de los usuarios, explorando espacios de información de manera completa para responder preguntas complejas. Esto significa que los creadores de contenido deben asegurarse de que su contenido sea descubrible no solo por humanos, sino también por agentes autónomos de IA que exploran y refinan consultas sistemáticamente en la web.

El panorama competitivo también está evolucionando. A medida que más plataformas implementan capacidades de refinamiento de consultas, la posibilidad de aparecer en consultas refinadas se convierte en un diferenciador clave. Los usuarios de AmICited que comprenden y monitorean su presencia en consultas refinadas en diferentes plataformas de IA tendrán una ventaja significativa sobre los competidores que solo se centran en los rankings de búsqueda tradicionales. El futuro pertenece a los creadores de contenido y marcas que reconocen el refinamiento de consultas como un aspecto fundamental de la visibilidad en búsqueda y optimizan en consecuencia.

El refinamiento de consultas se centra en mejorar la relevancia y precisión de los resultados de búsqueda ajustando o sugiriendo consultas basadas en el contexto del usuario y datos históricos, con el objetivo de proporcionar información más precisa. Por el contrario, la expansión de consultas implica generar consultas adicionales para mejorar el rendimiento del motor de búsqueda abordando problemas como consultas iniciales mal formuladas o resultados irrelevantes. Mientras que el refinamiento mejora una consulta existente, la expansión crea múltiples consultas relacionadas para ampliar el alcance de la búsqueda. Ambas técnicas funcionan juntas en los sistemas modernos de búsqueda de IA para mejorar la calidad de la recuperación de información.

Los motores de búsqueda de IA utilizan el refinamiento de consultas a través de un proceso llamado expansión de consultas, donde una sola consulta de usuario se descompone en múltiples subconsultas que se ejecutan simultáneamente en varias fuentes de datos. Por ejemplo, una pregunta compleja sobre 'mejores zapatillas impermeables para correr para pies planos' podría dividirse en subconsultas que exploran listados de productos, reseñas de expertos, experiencias de usuarios y especificaciones técnicas. Esta recuperación paralela de información de diferentes fuentes amplía significativamente el conjunto de información disponible para la síntesis de respuestas, permitiendo a la IA proporcionar respuestas más completas y precisas.

El procesamiento de lenguaje natural es fundamental para el refinamiento de consultas, ya que permite a los sistemas de IA interpretar el significado más allá de la simple coincidencia de palabras clave. El PLN utiliza patrones y relaciones contextuales entre palabras para descifrar cómo hablan los humanos, haciendo las búsquedas más intuitivas y precisas. Por ejemplo, el PLN permite que un sistema entienda que 'cafeterías abiertas' se refiere a negocios que están operando actualmente y ubicados cerca, no solo documentos que contienen esas palabras exactas. Esta comprensión contextual es la que permite a los sistemas de IA modernos refinar consultas de manera inteligente y proporcionar resultados que coincidan con la intención del usuario en lugar de solo coincidencias literales de palabras clave.

El refinamiento de consultas mejora la visibilidad de búsqueda en AI Overviews ayudando a los creadores de contenido a entender cómo los usuarios modifican sus búsquedas para encontrar mejores resultados. Al dirigirse tanto a las consultas iniciales como a las refinadas con contenido completo que anticipa las necesidades y preguntas de seguimiento del usuario, los sitios web pueden aumentar sus posibilidades de ser citados como fuentes. Las investigaciones muestran que ser presentado como fuente en AI Overviews incrementa la tasa de clics del 0,6% al 1,08%, haciendo que la comprensión del refinamiento de consultas sea esencial para la estrategia SEO moderna y la visibilidad de citaciones en IA.

Las consultas sintéticas son consultas generadas artificialmente por grandes modelos de lenguaje que simulan búsquedas reales de usuarios. Son cruciales para el refinamiento de consultas porque amplían los datos de entrenamiento etiquetados, mejoran la recuperación y permiten que la recuperación generativa escale a grandes conjuntos de datos al llenar vacíos de información. Las consultas sintéticas se generan mediante la minería de datos estructurados, el análisis de títulos de documentos y textos ancla, y el uso de conjuntos de reglas estructuradas. Ayudan a los sistemas de IA a comprender y refinar consultas proporcionando ejemplos diversos de cómo los usuarios pueden formular necesidades de información similares, mejorando en última instancia la capacidad del sistema para refinar y expandir consultas de usuarios de manera efectiva.

Las empresas pueden optimizar para el refinamiento de consultas analizando los datos de Google Search Console para identificar palabras clave relacionadas y variaciones de consultas que los usuarios buscan secuencialmente. Deben crear contenido completo que aborde tanto las consultas iniciales amplias como las variantes refinadas y específicas. Usando herramientas como seoClarity o plataformas similares, pueden extraer refinamientos de consultas y datos de autosuggest para encontrar variaciones relevantes en la investigación de palabras clave. Además, monitorear los rankings por refinamiento de consulta y rastrear cómo se desempeñan diferentes páginas facetadas ayuda a tomar decisiones sobre la estrategia de contenido e implementación técnica.

El refinamiento de consultas está profundamente conectado con la intención del usuario porque revela cómo evolucionan las necesidades de información de los usuarios a lo largo de su recorrido de búsqueda. Al analizar los patrones de refinamiento de consultas, las empresas pueden entender qué buscan realmente los usuarios en cada etapa de su proceso de toma de decisiones. Por ejemplo, un usuario puede comenzar con una intención amplia ('zapatillas para correr') y refinar progresivamente a una intención más específica ('mejores zapatillas impermeables para correr para pies planos'). Comprender estos patrones de refinamiento permite a los creadores de contenido desarrollar material dirigido para cada etapa del recorrido del usuario, mejorando finalmente tanto la visibilidad en búsqueda como las tasas de conversión.

Comienza a rastrear cómo los chatbots de IA mencionan tu marca en ChatGPT, Perplexity y otras plataformas. Obtén información procesable para mejorar tu presencia en IA.

Descubre cómo la reformulación de consultas ayuda a los sistemas de IA a interpretar y mejorar las consultas de los usuarios para una mejor recuperación de info...

Descubre cómo sistemas de IA modernos como Google AI Mode y ChatGPT descomponen una sola consulta en múltiples búsquedas. Aprende sobre los mecanismos de ramifi...

Aprende cómo la optimización de expansión de consultas mejora los resultados de búsqueda de IA al salvar las diferencias de vocabulario. Descubre técnicas, desa...

Consentimiento de Cookies

Usamos cookies para mejorar tu experiencia de navegación y analizar nuestro tráfico. See our privacy policy.