Cómo configurar robots.txt para rastreadores de IA: guía completa

Aprende a configurar robots.txt para controlar el acceso de rastreadores de IA como GPTBot, ClaudeBot y Perplexity. Gestiona la visibilidad de tu marca en respu...

Un archivo robots.txt es un archivo de texto plano ubicado en el directorio raíz de un sitio web que comunica instrucciones a los rastreadores web y bots de motores de búsqueda sobre qué URLs pueden o no pueden acceder. Sirve como un elemento fundamental del protocolo de exclusión de robots, ayudando a los propietarios de sitios web a gestionar el tráfico de rastreadores, optimizar el presupuesto de rastreo y proteger contenido sensible de ser indexado.

Un archivo robots.txt es un archivo de texto plano ubicado en el directorio raíz de un sitio web que comunica instrucciones a los rastreadores web y bots de motores de búsqueda sobre qué URLs pueden o no pueden acceder. Sirve como un elemento fundamental del protocolo de exclusión de robots, ayudando a los propietarios de sitios web a gestionar el tráfico de rastreadores, optimizar el presupuesto de rastreo y proteger contenido sensible de ser indexado.

Robots.txt es un archivo de texto plano ubicado en el directorio raíz de un sitio web (por ejemplo, www.ejemplo.com/robots.txt ) que comunica instrucciones a los rastreadores web y bots de motores de búsqueda sobre qué URLs pueden o no pueden acceder. Este archivo sirve como un elemento fundamental del protocolo de exclusión de robots, un estándar que ayuda a gestionar la actividad de los bots en los sitios web. Al especificar directivas como “allow” y “disallow”, los propietarios de sitios web pueden controlar cómo los motores de búsqueda y otros rastreadores interactúan con su contenido. Según Google Search Central, un archivo robots.txt indica a los rastreadores de motores de búsqueda a qué URLs puede acceder el rastreador en tu sitio, principalmente para evitar sobrecargar tu sitio con solicitudes y para optimizar la asignación del presupuesto de rastreo.

La importancia de robots.txt va más allá del simple control de acceso. Representa un mecanismo de comunicación crítico entre los propietarios de sitios web y los sistemas automatizados que indexan y analizan el contenido web. El archivo debe llamarse exactamente “robots.txt” y colocarse en el directorio raíz para que los rastreadores web lo reconozcan. Sin una configuración adecuada de robots.txt, los motores de búsqueda pueden desperdiciar un valioso presupuesto de rastreo en páginas duplicadas, contenido temporal o recursos no esenciales, reduciendo en última instancia la eficiencia de la indexación de páginas importantes. Esto hace que robots.txt sea un componente esencial de la SEO técnica y la estrategia de gestión de sitios web.

El protocolo de exclusión de robots se propuso por primera vez en 1994 como un estándar voluntario para que los rastreadores web respetaran las preferencias de los propietarios de sitios. La especificación original era simple pero eficaz, permitiendo a los webmasters comunicar reglas de acceso básicas sin sistemas de autenticación complejos. Con el paso de las décadas, robots.txt ha evolucionado para adaptarse a nuevos tipos de rastreadores, incluidos bots de motores de búsqueda, rastreadores de redes sociales y, más recientemente, rastreadores de entrenamiento de IA utilizados por empresas como OpenAI, Anthropic y Perplexity. El protocolo ha permanecido en gran medida compatible hacia atrás, asegurando que los sitios web creados hace décadas puedan seguir funcionando con rastreadores modernos.

La adopción de robots.txt ha crecido significativamente con el tiempo. Según el Web Almanac 2024, se realizaron solicitudes exitosas de archivos robots.txt en el 83.9% de los sitios web cuando se accedió como móvil y el 83.5% como escritorio, frente al 82.4% y 81.5% en 2022. Esta tendencia al alza refleja una creciente conciencia entre los propietarios de sitios web sobre la importancia de gestionar el tráfico de rastreadores. La investigación en sitios web de desinformación mostró una tasa de adopción del 96.4%, lo que sugiere que robots.txt ahora se considera una práctica estándar en diversas categorías de sitios web. La evolución de robots.txt continúa hoy en día, ya que los propietarios de sitios enfrentan nuevos desafíos, como bloquear bots de IA que pueden no respetar las directivas tradicionales de robots.txt o pueden utilizar rastreadores no declarados para evadir restricciones.

Cuando un rastreador web visita un sitio web, primero verifica si existe el archivo robots.txt en el directorio raíz antes de rastrear cualquier otra página. El rastreador lee el archivo e interpreta las directivas para determinar a qué URLs puede acceder. Este proceso ocurre mediante una solicitud HTTP al dominio raíz, y el servidor responde con el contenido del archivo robots.txt. Luego, el rastreador analiza el archivo según su implementación específica del protocolo de exclusión de robots, que puede variar ligeramente entre diferentes motores de búsqueda y tipos de bots. Esta verificación inicial asegura que los rastreadores respeten las preferencias del propietario del sitio antes de consumir recursos del servidor.

La directiva user-agent es clave para dirigir rastreadores específicos. Cada rastreador tiene un identificador único (cadena user-agent), como “Googlebot” para el rastreador de Google, “Bingbot” para el de Microsoft, o “GPTbot” para el de OpenAI. Los propietarios de sitios pueden crear reglas para user-agents específicos o usar el comodín “*” para aplicar reglas a todos los rastreadores. La directiva disallow especifica qué URLs o patrones de URL el rastreador no puede acceder, mientras que la directiva allow puede anular las reglas de disallow para páginas específicas. Este sistema jerárquico proporciona un control granular sobre el comportamiento de los rastreadores, permitiendo a los propietarios de sitios crear patrones de acceso complejos que optimizan tanto los recursos del servidor como la visibilidad en motores de búsqueda.

| Aspecto | Robots.txt | Metaetiqueta Robots | Encabezado X-Robots-Tag | Protección por Contraseña |

|---|---|---|---|---|

| Alcance | Todo el sitio o a nivel de directorio | A nivel de página individual | A nivel de página o recurso individual | Control de acceso a nivel de servidor |

| Implementación | Archivo de texto plano en el directorio raíz | Metaetiqueta HTML en el head de la página | Encabezado de respuesta HTTP | Autenticación del servidor |

| Propósito Principal | Gestionar el tráfico y presupuesto de rastreo | Controlar indexación y rastreo | Controlar indexación y rastreo | Prevenir todo acceso |

| Exigibilidad | Voluntaria (no vinculante legalmente) | Voluntaria (no vinculante legalmente) | Voluntaria (no vinculante legalmente) | Impuesta por el servidor |

| Cumplimiento por Bots de IA | Variable (algunos bots lo ignoran) | Variable (algunos bots lo ignoran) | Variable (algunos bots lo ignoran) | Altamente efectiva |

| Impacto en Resultados de Búsqueda | La página puede aparecer sin descripción | Página excluida de los resultados | Página excluida de los resultados | Página completamente oculta |

| Mejor Caso de Uso | Optimizar presupuesto de rastreo, gestionar carga del servidor | Prevenir la indexación de páginas específicas | Prevenir la indexación de recursos | Proteger datos sensibles |

| Facilidad de Implementación | Fácil (archivo de texto) | Fácil (metaetiqueta HTML) | Moderada (requiere configuración del servidor) | Moderada a compleja |

Un archivo robots.txt utiliza una sintaxis sencilla que los propietarios de sitios pueden crear y editar con cualquier editor de texto plano. La estructura básica consiste en una línea user-agent seguida de una o más líneas de directivas. Las directivas más utilizadas son disallow (que impide a los rastreadores acceder a URLs específicas), allow (que permite el acceso a URLs específicas aunque exista una regla de disallow más amplia), crawl-delay (que especifica cuánto debe esperar un rastreador entre solicitudes) y sitemap (que dirige a los rastreadores a la ubicación del sitemap XML). Cada directiva debe ir en una línea propia y el archivo debe tener el formato correcto para que los rastreadores lo reconozcan correctamente.

Por ejemplo, un archivo robots.txt básico podría verse así:

User-agent: *

Disallow: /admin/

Disallow: /private/

Allow: /private/public-page.html

Sitemap: https://www.example.com/sitemap.xml

Esta configuración indica a todos los rastreadores que eviten los directorios /admin/ y /private/, pero permite el acceso a la página específica /private/public-page.html. La directiva sitemap guía a los rastreadores hacia el sitemap XML para una indexación eficiente. Los propietarios de sitios pueden crear múltiples bloques de user-agent para aplicar diferentes reglas a distintos rastreadores. Por ejemplo, un sitio puede permitir que Googlebot rastree todo el contenido pero restringir el acceso a ciertos directorios para otros rastreadores. La directiva crawl-delay puede ralentizar rastreadores agresivos, aunque el Googlebot de Google no reconoce este comando y en su lugar utiliza la configuración de velocidad de rastreo en Google Search Console.

El presupuesto de rastreo se refiere a la cantidad de URLs que un motor de búsqueda rastreará en un sitio web dentro de un período determinado. Para sitios grandes con millones de páginas, el presupuesto de rastreo es un recurso finito que debe gestionarse estratégicamente. Robots.txt juega un papel crucial en la optimización del presupuesto de rastreo al evitar que los rastreadores desperdicien recursos en contenido de bajo valor como páginas duplicadas, archivos temporales o recursos no esenciales. Al usar robots.txt para bloquear URLs innecesarias, los propietarios de sitios pueden asegurar que los motores de búsqueda centren su presupuesto de rastreo en páginas importantes que deben ser indexadas y posicionadas. Esto es especialmente importante para sitios de comercio electrónico, medios de noticias y otros sitios de gran escala donde el presupuesto de rastreo impacta directamente en la visibilidad en búsquedas.

La guía oficial de Google enfatiza que robots.txt debe usarse para gestionar el tráfico de rastreo y evitar sobrecargar tu sitio con solicitudes. Para sitios grandes, Google ofrece recomendaciones específicas para gestionar el presupuesto de rastreo, incluyendo el uso de robots.txt para bloquear contenido duplicado, parámetros de paginación y archivos de recursos que no impactan significativamente en la visualización de la página. Los propietarios de sitios deben evitar bloquear archivos CSS, JavaScript o imágenes esenciales para la visualización de las páginas, ya que esto podría impedir que Google entienda correctamente el contenido de la página. El uso estratégico de robots.txt, combinado con otras prácticas de SEO técnico como sitemaps XML y enlazado interno, crea un entorno de rastreo eficiente que maximiza el valor del presupuesto de rastreo disponible.

Aunque robots.txt es una herramienta valiosa para gestionar el comportamiento de los rastreadores, tiene limitaciones importantes que los propietarios de sitios deben comprender. Primero, robots.txt no es legalmente exigible y funciona como un protocolo voluntario. Mientras que los motores de búsqueda principales como Google, Bing y Yahoo respetan las directivas de robots.txt, los bots maliciosos y los scrapers pueden optar por ignorar el archivo por completo. Esto significa que robots.txt no debe considerarse como un mecanismo de seguridad para proteger información sensible. Segundo, diferentes rastreadores interpretan la sintaxis de robots.txt de manera distinta, lo que puede llevar a comportamientos inconsistentes entre plataformas. Algunos rastreadores pueden no entender ciertas directivas avanzadas o pueden interpretar los patrones de URL de manera diferente a lo esperado.

En tercer lugar, y de forma crítica para la gestión web moderna, una página bloqueada en robots.txt aún puede ser indexada si es enlazada desde otros sitios web. Según la documentación de Google, si páginas externas enlazan a tu URL bloqueada con texto ancla descriptivo, Google aún puede indexar esa URL y mostrarla en los resultados de búsqueda sin descripción. Esto significa que robots.txt por sí solo no puede evitar la indexación; solo impide el rastreo. Para evitar la indexación correctamente, los propietarios de sitios deben utilizar métodos alternativos como la metaetiqueta noindex, encabezados HTTP o protección por contraseña. Además, investigaciones recientes han revelado que algunos rastreadores de IA eluden deliberadamente las restricciones de robots.txt utilizando cadenas de user-agent no declaradas, haciendo que robots.txt sea ineficaz contra ciertos bots de entrenamiento de IA.

El auge de los modelos de lenguaje grandes y los motores de búsqueda impulsados por IA ha creado nuevos desafíos para la gestión de robots.txt. Empresas como OpenAI (GPTbot), Anthropic (Claude) y Perplexity han desplegado rastreadores para entrenar sus modelos y potenciar sus funciones de búsqueda. Muchos propietarios de sitios han comenzado a bloquear estos bots de IA utilizando directivas robots.txt. La investigación del Senior Search Scientist de Moz muestra que GPTbot es el bot más bloqueado, con muchas publicaciones de noticias y creadores de contenido agregando reglas de disallow específicas para rastreadores de entrenamiento de IA. Sin embargo, la efectividad de robots.txt para bloquear bots de IA es cuestionable, ya que algunas empresas de IA han sido descubiertas utilizando rastreadores no declarados que no se identifican adecuadamente.

Cloudflare informó que Perplexity estaba utilizando rastreadores encubiertos y no declarados para evadir las directivas no-crawl de los sitios web, demostrando que no todos los bots de IA respetan las reglas de robots.txt. Esto ha llevado a discusiones en curso en las comunidades de SEO y desarrollo web sobre si robots.txt es suficiente para controlar el acceso de los bots de IA. Algunos propietarios de sitios han implementado medidas adicionales como reglas WAF (Web Application Firewall) para bloquear direcciones IP o cadenas de user-agent específicas. La situación resalta la importancia de monitorear la aparición de tu sitio web en resultados de búsqueda de IA y comprender qué bots realmente acceden a tu contenido. Para sitios preocupados por el uso de sus datos en el entrenamiento de IA, robots.txt debe combinarse con otras medidas técnicas y, potencialmente, acuerdos legales con empresas de IA.

Crear un archivo robots.txt efectivo requiere una planificación cuidadosa y mantenimiento continuo. Primero, coloca el archivo robots.txt en el directorio raíz de tu sitio web (por ejemplo, www.ejemplo.com/robots.txt ) y asegúrate de que se llame exactamente “robots.txt” y tenga codificación UTF-8 apropiada. Segundo, usa reglas disallow claras y específicas que solo bloqueen el contenido que deseas restringir, evitando reglas demasiado restrictivas que puedan evitar que páginas importantes sean rastreadas. Tercero, incluye una directiva sitemap que apunte a tu sitemap XML, ayudando a los rastreadores a descubrir y priorizar páginas importantes. Cuarto, prueba tu archivo robots.txt utilizando herramientas como la Herramienta de Prueba de Robots de Google o la función Site Crawl de Moz Pro para verificar que tus reglas funcionen como esperas.

Los propietarios de sitios deben revisar y actualizar regularmente sus archivos robots.txt a medida que cambie la estructura del sitio. Errores comunes incluyen:

El monitoreo regular mediante registros del servidor, Google Search Console y herramientas SEO ayuda a identificar problemas a tiempo. Si notas que páginas importantes no están siendo rastreadas o indexadas, revisa primero tu archivo robots.txt para asegurarte de que no las estés bloqueando accidentalmente. Para plataformas CMS como WordPress o Wix, muchas ofrecen interfaces integradas para gestionar robots.txt sin necesidad de editar archivos directamente, facilitando así a usuarios no técnicos la implementación de una gestión adecuada de rastreadores.

El futuro de robots.txt enfrenta tanto desafíos como oportunidades a medida que la web sigue evolucionando. La aparición de rastreadores de IA y bots de entrenamiento ha impulsado discusiones sobre si el estándar actual de robots.txt es suficiente para las necesidades modernas. Algunos expertos de la industria han propuesto mejoras al protocolo de exclusión de robots para abordar mejor preocupaciones específicas de la IA, como distinguir entre rastreadores usados para indexación de búsqueda frente a los utilizados para recopilación de datos de entrenamiento. La investigación continua del Web Almanac muestra que la adopción de robots.txt sigue creciendo, con más sitios web reconociendo su importancia para gestionar el tráfico de rastreadores y optimizar los recursos del servidor.

Otra tendencia emergente es la integración de la gestión de robots.txt en plataformas de monitoreo SEO y herramientas de seguimiento de IA más amplias. A medida que empresas como AmICited rastrean la aparición de marcas y dominios en motores de búsqueda de IA, comprender robots.txt se vuelve cada vez más importante para controlar cómo aparece el contenido en respuestas generadas por IA. Es posible que los propietarios de sitios deban implementar estrategias de robots.txt más sofisticadas que consideren múltiples tipos de rastreadores con diferentes propósitos y niveles de cumplimiento. La posible estandarización de la identificación y el comportamiento de los rastreadores de IA podría llevar a implementaciones de robots.txt más efectivas en el futuro. Además, a medida que las preocupaciones sobre privacidad y propiedad de contenido se vuelven más prominentes, robots.txt podría evolucionar para incluir controles más granulares sobre cómo los diferentes tipos de bots y sistemas de IA pueden usar el contenido.

Para las organizaciones que utilizan AmICited para monitorear la aparición de su marca y dominio en motores de búsqueda de IA, comprender robots.txt es esencial. Tu configuración de robots.txt impacta directamente en qué rastreadores de IA pueden acceder a tu contenido y cómo aparece en respuestas generadas por IA en plataformas como ChatGPT, Perplexity, Google AI Overviews y Claude. Si bloqueas ciertos bots de IA con robots.txt, puedes reducir tu visibilidad en sus resultados de búsqueda, lo cual puede ser una decisión estratégica dependiendo de tu contenido y objetivos de negocio. Sin embargo, como se mencionó antes, algunos bots de IA pueden no respetar las directivas de robots.txt, por lo que monitorear tu aparición real en respuestas de IA es crucial.

Las capacidades de monitoreo de AmICited te ayudan a entender el impacto real de tu configuración de robots.txt en la visibilidad en búsquedas de IA. Al rastrear dónde aparecen tus URLs en respuestas generadas por IA, puedes evaluar si tu estrategia de gestión de rastreadores está logrando los resultados deseados. Si deseas aumentar la visibilidad en motores de búsqueda de IA específicos, puede que necesites ajustar tu robots.txt para permitir a sus rastreadores. Por el contrario, si prefieres limitar el uso de tu contenido en entrenamientos o respuestas de IA, puedes implementar reglas robots.txt más restrictivas, aunque deberías combinar esto con otras medidas técnicas para una mayor efectividad. La intersección entre la gestión de robots.txt y el monitoreo de búsquedas de IA representa una nueva frontera en la estrategia de marketing digital y SEO.

El propósito principal de un archivo robots.txt es gestionar el tráfico de rastreadores y comunicarse con los bots de motores de búsqueda sobre qué partes de un sitio web pueden acceder. Según Google Search Central, robots.txt se utiliza principalmente para evitar sobrecargar tu sitio con solicitudes y para gestionar la asignación del presupuesto de rastreo. Ayuda a los propietarios de sitios web a dirigir a los rastreadores para que se centren en el contenido valioso mientras omiten páginas duplicadas o irrelevantes, optimizando finalmente los recursos del servidor y mejorando la eficiencia del SEO.

No, robots.txt no puede evitar de forma confiable que las páginas aparezcan en los resultados de búsqueda de Google. Según la documentación oficial de Google, si otras páginas enlazan a tu página con texto descriptivo, Google aún podría indexar la URL sin visitar la página. Para prevenir correctamente la indexación, utiliza métodos alternativos como la protección por contraseña, la metaetiqueta noindex o encabezados HTTP. Una página bloqueada por robots.txt aún puede aparecer en los resultados de búsqueda sin descripción.

Robots.txt es un archivo a nivel de sitio que controla el acceso de los rastreadores a directorios completos o a todo el sitio, mientras que las metaetiquetas robots son directivas HTML aplicadas a páginas individuales. Robots.txt gestiona el comportamiento de rastreo, mientras que las metaetiquetas robots (como noindex) controlan la indexación. Ambos sirven para propósitos diferentes: robots.txt evita el rastreo para ahorrar recursos del servidor, mientras que las metaetiquetas robots evitan la indexación incluso si una página es rastreada.

Puedes bloquear bots de IA agregando sus nombres de user-agent específicos a tu archivo robots.txt con directivas disallow. Por ejemplo, agregar 'User-agent: GPTbot' seguido de 'Disallow: /' bloquea el bot de OpenAI para que no rastree tu sitio. Las investigaciones muestran que GPTbot es el bot más bloqueado por los sitios web. Sin embargo, no todos los bots de IA respetan las directivas de robots.txt, y algunos pueden utilizar rastreadores no declarados para evadir restricciones, por lo que robots.txt por sí solo puede no garantizar una protección completa.

Las cinco directivas estándar en robots.txt son: User-agent (especifica a qué bots se aplica la regla), Disallow (impide que los rastreadores accedan a archivos o directorios específicos), Allow (anula reglas de disallow para páginas específicas), Crawl-delay (introduce retrasos entre solicitudes) y Sitemap (dirige a los rastreadores a la ubicación del sitemap). Cada directiva cumple una función específica en el control del comportamiento de los bots y la optimización de la eficiencia de rastreo.

No, robots.txt no es legalmente exigible. Funciona como un protocolo voluntario basado en el estándar de exclusión de robots. Aunque la mayoría de los bots bien comportados como Googlebot y Bingbot respetan las directivas de robots.txt, los bots maliciosos y los scrapers pueden optar por ignorarlo completamente. Para información sensible que debe protegerse, utiliza medidas de seguridad más sólidas como la protección por contraseña o controles de acceso a nivel de servidor en lugar de confiar únicamente en robots.txt.

Según el Web Almanac 2024, se realizaron solicitudes exitosas de archivos robots.txt en el 83.9% de los sitios web cuando se accedió como móvil y el 83.5% como escritorio, frente al 82.4% y 81.5% en 2022. La investigación en sitios web de desinformación mostró una tasa de adopción del 96.4%, lo que indica que robots.txt es un estándar ampliamente implementado en la web. Esto demuestra la importancia crítica de robots.txt en la gestión moderna de sitios web.

Comienza a rastrear cómo los chatbots de IA mencionan tu marca en ChatGPT, Perplexity y otras plataformas. Obtén información procesable para mejorar tu presencia en IA.

Aprende a configurar robots.txt para controlar el acceso de rastreadores de IA como GPTBot, ClaudeBot y Perplexity. Gestiona la visibilidad de tu marca en respu...

Aprende cómo configurar robots.txt para rastreadores de IA incluyendo GPTBot, ClaudeBot y PerplexityBot. Comprende las categorías de rastreadores de IA, estrate...

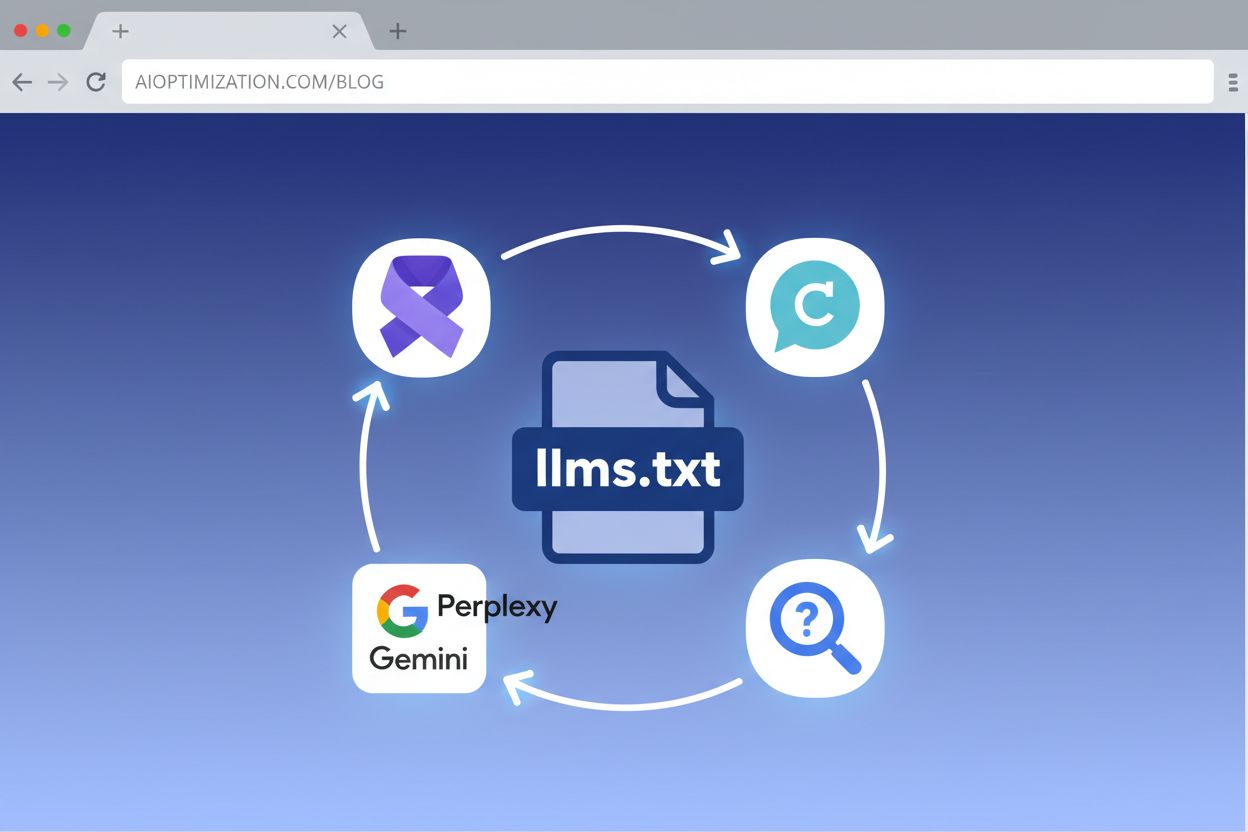

Aprende cómo implementar LLMs.txt en tu sitio web para ayudar a los sistemas de IA a comprender mejor tu contenido. Guía completa paso a paso para todas las pla...

Consentimiento de Cookies

Usamos cookies para mejorar tu experiencia de navegación y analizar nuestro tráfico. See our privacy policy.