Límites de Tokens y Optimización de Contenidos: Consideraciones Técnicas

Explora cómo los límites de tokens afectan el rendimiento de la IA y aprende estrategias prácticas para la optimización de contenidos, incluyendo RAG, fragmenta...

Un token es la unidad básica de texto procesada por los modelos de lenguaje, que representa palabras, subpalabras, caracteres o signos de puntuación convertidos en identificadores numéricos. Los tokens forman la base de cómo sistemas de IA como ChatGPT, Claude y Perplexity entienden y generan texto, asignando a cada token un valor entero único dentro del vocabulario del modelo.

Un token es la unidad básica de texto procesada por los modelos de lenguaje, que representa palabras, subpalabras, caracteres o signos de puntuación convertidos en identificadores numéricos. Los tokens forman la base de cómo sistemas de IA como ChatGPT, Claude y Perplexity entienden y generan texto, asignando a cada token un valor entero único dentro del vocabulario del modelo.

Un token es la unidad fundamental de texto que procesan y comprenden los modelos de lenguaje. Los tokens representan palabras, subpalabras, secuencias de caracteres o signos de puntuación, cada uno asignado a un identificador numérico único dentro del vocabulario del modelo. En vez de procesar el texto sin procesar directamente, los sistemas de IA como ChatGPT, Claude, Perplexity y Google AI Overviews convierten todo el texto de entrada en secuencias de tokens—esencialmente traduciendo el lenguaje humano a un formato numérico que las redes neuronales pueden computar. Este proceso de tokenización es el paso crítico inicial que permite a los modelos de lenguaje analizar relaciones semánticas, generar respuestas coherentes y mantener la eficiencia computacional. Comprender los tokens es esencial para cualquiera que trabaje con sistemas de IA, ya que el conteo de tokens influye directamente en los costos de API, la calidad de las respuestas y la capacidad del modelo para mantener el contexto en las conversaciones.

La tokenización es el proceso sistemático de descomponer el texto sin procesar en tokens discretos que un modelo de lenguaje puede procesar. Cuando introduces texto en un sistema de IA, el tokenizador primero analiza el texto y lo divide en unidades manejables. Por ejemplo, la frase “I heard a dog bark loudly” podría tokenizarse en tokens individuales: I, heard, a, dog, bark, loudly. Cada token recibe entonces un identificador numérico único—quizá I se convierte en el token ID 1, heard en 2, a en 3, y así sucesivamente. Esta representación numérica permite que la red neuronal realice operaciones matemáticas sobre los tokens, calculando relaciones y patrones que permiten al modelo comprender el significado y generar respuestas apropiadas.

La forma específica en que se tokeniza el texto depende del algoritmo de tokenización empleado por cada modelo. Diferentes modelos de lenguaje utilizan tokenizadores distintos, por lo que el mismo texto puede generar conteos de tokens diferentes en distintas plataformas. El vocabulario del tokenizador—el conjunto completo de tokens únicos que reconoce—suele oscilar entre decenas de miles y cientos de miles de tokens. Cuando el tokenizador encuentra texto no visto antes o palabras fuera de su vocabulario, aplica estrategias específicas para manejar estos casos, ya sea dividiéndolos en tokens subpalabra más pequeños o representándolos como combinaciones de tokens conocidos. Esta flexibilidad es crucial para manejar lenguas diversas, jerga técnica, errores tipográficos y combinaciones novedosas de palabras que aparecen en textos reales.

Diferentes enfoques de tokenización ofrecen ventajas y desventajas particulares. Comprender estos métodos es esencial para entender cómo distintas plataformas de IA procesan la información de manera diferente:

| Método de Tokenización | Cómo Funciona | Ventajas | Desventajas | Usado Por |

|---|---|---|---|---|

| A Nivel de Palabra | Divide el texto en palabras completas según espacios y puntuación | Sencillo de entender; preserva el significado completo de las palabras; secuencias de tokens más cortas | Vocabulario grande; no puede manejar palabras desconocidas o raras (OOV); inflexible ante errores tipográficos | Sistemas NLP tradicionales |

| A Nivel de Carácter | Trata cada carácter individual como un token, incluidos los espacios | Maneja cualquier texto; sin problemas de fuera de vocabulario; control de grano fino | Secuencias de tokens muy largas; requiere mayor computación; baja densidad semántica por token | Algunos modelos especializados; modelos para idioma chino |

| A Nivel de Subpalabra (BPE) | Fusiona iterativamente pares frecuentes de caracteres/subpalabras en tokens más grandes | Equilibra tamaño del vocabulario y cobertura; maneja palabras raras eficazmente; reduce errores OOV | Implementación más compleja; puede dividir unidades significativas; requiere entrenamiento | Modelos GPT, ChatGPT, Claude |

| WordPiece | Empieza con caracteres y fusiona progresivamente combinaciones frecuentes | Excelente para manejar palabras desconocidas; vocabulario eficiente; buena preservación semántica | Requiere preentrenamiento; más intensivo computacionalmente | BERT, Modelos de Google |

| SentencePiece | Método independiente del idioma que trata el texto como bytes en bruto | Excelente para modelos multilingües; maneja cualquier carácter Unicode; no necesita preprocesamiento | Menos intuitivo; requiere herramientas especializadas | Modelos multilingües, T5 |

Una vez que el texto se convierte en tokens, los modelos de lenguaje procesan estas secuencias numéricas a través de múltiples capas de redes neuronales. Cada token se representa como un vector multidimensional llamado embedding, que captura el significado semántico y las relaciones contextuales. Durante la fase de entrenamiento, el modelo aprende a reconocer patrones en cómo aparecen juntos los tokens, comprendiendo que ciertos tokens suelen co-ocurrir o aparecer en contextos similares. Por ejemplo, los tokens para “king” y “queen” desarrollan embeddings similares porque comparten propiedades semánticas, mientras que “king” y “paper” tienen embeddings más distantes debido a sus significados y usos diferentes.

El mecanismo de atención del modelo es crucial en este proceso. La atención permite que el modelo valore la importancia de distintos tokens en relación unos con otros al generar una respuesta. Al procesar la frase “The bank executive sat by the river bank”, el mecanismo de atención ayuda al modelo a entender que el primer “bank” se refiere a una institución financiera y el segundo a una orilla de río, en función de tokens contextuales como “executive” y “river”. Esta comprensión contextual surge de las relaciones aprendidas entre los embeddings de los tokens, permitiendo una comprensión sofisticada del lenguaje que va mucho más allá de la simple coincidencia de palabras.

Durante la inferencia (cuando el modelo genera respuestas), predice el siguiente token en una secuencia basándose en todos los tokens previos. El modelo calcula puntuaciones de probabilidad para cada token en su vocabulario y selecciona el siguiente token más probable. Este proceso se repite de manera iterativa: el nuevo token generado se añade a la secuencia, y el modelo utiliza este contexto ampliado para predecir el siguiente token. Esta generación token por token continúa hasta que el modelo predice un token especial de “fin de secuencia” o alcanza el límite máximo de tokens. Por ello es crucial comprender los límites de tokens: si tu mensaje y la respuesta deseada juntos superan la ventana de contexto del modelo, el modelo no podrá generar una respuesta completa.

Cada modelo de lenguaje tiene una ventana de contexto—un número máximo de tokens que puede procesar simultáneamente. Este límite combina tanto los tokens de entrada (tu mensaje) como los de salida (la respuesta del modelo). Por ejemplo, GPT-3.5-Turbo tiene una ventana de contexto de 4,096 tokens, mientras que GPT-4 ofrece ventanas que oscilan entre 8,000 y 128,000 tokens según la versión. Los modelos Claude 3 admiten ventanas de contexto de hasta 200,000 tokens, permitiendo el análisis de libros completos o documentos extensos. Comprender la ventana de contexto de tu modelo es esencial para planificar mensajes y gestionar presupuestos de tokens de manera efectiva.

Las herramientas de conteo de tokens son esenciales para optimizar el uso de la IA. OpenAI proporciona la biblioteca tiktoken, un tokenizador de código abierto que permite a los desarrolladores contar tokens antes de realizar llamadas a la API. Esto previene costos inesperados y posibilita una optimización precisa del mensaje. Por ejemplo, si usas GPT-4 con una ventana de contexto de 8,000 tokens y tu mensaje usa 2,000 tokens, tienes 6,000 tokens disponibles para la respuesta del modelo. Conocer esta restricción te ayuda a crear mensajes que encajen en el espacio de tokens disponible solicitando respuestas completas. Los diferentes modelos usan tokenizadores distintos—Claude usa su propio sistema de tokenización, Perplexity implementa su propio enfoque y Google AI Overviews utiliza otro método. Esta variación significa que el mismo texto produce diferentes conteos de tokens en distintas plataformas, por lo que el conteo específico por plataforma es esencial para una estimación precisa de costos y predicción de rendimiento.

Los tokens se han convertido en la unidad fundamental de valor económico en la industria de IA. La mayoría de los proveedores de servicios de IA cobran según el consumo de tokens, con tarifas separadas para tokens de entrada y de salida. La estructura de precios de OpenAI ejemplifica este modelo: a partir de 2024, GPT-4 cobra aproximadamente $0.03 por cada 1,000 tokens de entrada y $0.06 por cada 1,000 tokens de salida, lo que significa que los tokens de salida cuestan aproximadamente el doble que los de entrada. Esta estructura de precios refleja la realidad computacional de que generar nuevos tokens requiere más potencia de procesamiento que procesar tokens de entrada existentes. La estructura de precios de Claude sigue un patrón similar, mientras que Perplexity y otras plataformas implementan sus propios esquemas de precios basados en tokens.

Comprender la economía de los tokens es clave para gestionar costos de IA a escala. Un solo mensaje extenso puede consumir 500 tokens, mientras que uno conciso y bien estructurado logra el mismo objetivo con solo 200 tokens. A lo largo de miles de llamadas a la API, esta diferencia de eficiencia se traduce en importantes ahorros de costos. Investigaciones indican que las empresas que utilizan herramientas de monitoreo de contenido impulsadas por IA pueden reducir el consumo de tokens entre un 20% y un 40% mediante la optimización de mensajes y estrategias inteligentes de almacenamiento en caché. Además, muchas plataformas establecen límites de velocidad medidos en tokens por minuto (TPM), restringiendo cuántos tokens puede procesar un usuario en un periodo específico. Estos límites previenen abusos y aseguran una distribución justa de recursos entre los usuarios. Para las organizaciones que monitorean la presencia de su marca en respuestas de IA mediante plataformas como AmICited, comprender los patrones de consumo de tokens revela no solo implicaciones de costo sino también la profundidad y amplitud del compromiso de la IA con tu contenido.

Para plataformas dedicadas a monitorear la aparición de marcas y dominios en respuestas de IA, los tokens representan una métrica crítica para medir el engagement e influencia. Cuando AmICited rastrea cómo aparece tu marca en ChatGPT, Claude, Perplexity y Google AI Overviews, el conteo de tokens revela los recursos computacionales que estos sistemas dedican a tu contenido. Una cita que consume 50 tokens indica un engagement más sustancial que una mención breve que consume solo 5 tokens. Al analizar patrones de tokens entre diferentes plataformas de IA, las organizaciones pueden entender qué sistemas de IA priorizan su contenido, cuán exhaustivamente distintos modelos discuten su marca y si su contenido recibe un análisis profundo o un tratamiento superficial.

El seguimiento de tokens también permite un análisis sofisticado de la calidad y relevancia de las respuestas de IA. Cuando un sistema de IA genera una respuesta larga y detallada sobre tu marca usando cientos de tokens, indica alta confianza y conocimiento integral. Por el contrario, respuestas breves que usan pocos tokens pueden sugerir información limitada o menor relevancia. Esta distinción es clave para la gestión de marca en la era de la IA. Las organizaciones pueden usar el monitoreo a nivel de token para identificar qué aspectos de su marca reciben mayor atención de la IA, qué plataformas priorizan su contenido y cómo se compara su visibilidad con la de sus competidores. Además, los patrones de consumo de tokens pueden revelar tendencias emergentes—si el uso de tokens para tu marca aumenta repentinamente en varias plataformas de IA, puede indicar mayor relevancia o cobertura reciente de noticias que se está incorporando a los datos de entrenamiento de la IA.

El panorama de la tokenización sigue evolucionando a medida que los modelos de lenguaje se vuelven más sofisticados y capaces. Los primeros modelos de lenguaje usaban tokenización relativamente simple a nivel de palabra, pero los sistemas modernos emplean métodos avanzados de tokenización a nivel de subpalabra que equilibran eficiencia y preservación semántica. Byte-Pair Encoding (BPE), desarrollado por OpenAI y ahora estándar de la industria, representa un avance significativo sobre los enfoques anteriores. Sin embargo, investigaciones emergentes sugieren que podrían surgir métodos de tokenización aún más eficientes a medida que los modelos escalen para manejar contextos más largos y tipos de datos más diversos.

El futuro de la tokenización va más allá del texto. Los modelos multimodales como GPT-4 Vision y Claude 3 tokenizan imágenes, audio y video además de texto, creando representaciones unificadas de tokens entre modalidades. Esta expansión significa que un solo mensaje puede contener tokens de texto, imagen y audio, todos procesados por la misma arquitectura de red neuronal. A medida que estos sistemas multimodales maduren, comprender el consumo de tokens entre diferentes tipos de datos será cada vez más importante. Además, la aparición de modelos de razonamiento que generan “tokens de pensamiento” intermedios invisibles para los usuarios representa otra evolución. Estos modelos consumen muchos más tokens durante la inferencia—a veces 100 veces más que los modelos tradicionales—para producir razonamiento y resolución de problemas de mayor calidad. Este desarrollo sugiere que la industria de la IA podría pasar a medir el valor no solo por los tokens de salida, sino por el total de tokens computacionales consumidos, incluidos los procesos de razonamiento ocultos.

La estandarización del conteo de tokens entre plataformas sigue siendo un reto en curso. Aunque la biblioteca tiktoken de OpenAI se ha adoptado ampliamente, distintas plataformas mantienen tokenizadores propietarios que producen resultados variables. Esta fragmentación genera complejidad para las organizaciones que monitorean su presencia en múltiples sistemas de IA. Los futuros desarrollos pueden incluir estándares de tokens a nivel de industria, similar a cómo los estándares de codificación de caracteres (UTF-8) unificaron la representación de texto entre sistemas. Tal estandarización simplificaría la predicción de costos, permitiría comparar de manera justa los servicios de IA y facilitaría un mejor monitoreo de la presencia de marca en el ecosistema de IA. Para plataformas como AmICited dedicadas a rastrear apariciones de marca en respuestas de IA, métricas de tokens estandarizadas permitirían medir con mayor precisión cómo distintos sistemas de IA interactúan con el contenido y asignan recursos computacionales.

En promedio, un token representa aproximadamente 4 caracteres o cerca de tres cuartas partes de una palabra en texto en inglés. Sin embargo, esto varía significativamente según el método de tokenización utilizado. Palabras cortas como 'the' o 'a' suelen consumir un token, mientras que palabras más largas o complejas pueden requerir dos o más tokens. Por ejemplo, la palabra 'darkness' podría dividirse en 'dark' y 'ness' como dos tokens separados.

Los modelos de lenguaje son redes neuronales que procesan datos numéricos, no texto. Los tokens convierten el texto en representaciones numéricas (embeddings) que las redes neuronales pueden entender y procesar eficientemente. Este paso de tokenización es esencial porque estandariza la entrada, reduce la complejidad computacional y permite que el modelo aprenda relaciones semánticas entre diferentes fragmentos de texto mediante operaciones matemáticas sobre los vectores de los tokens.

Los tokens de entrada son los tokens de tu mensaje o pregunta enviados al modelo de IA, mientras que los tokens de salida son los que el modelo genera en su respuesta. La mayoría de los servicios de IA cobran de manera diferente por los tokens de entrada y de salida, siendo los de salida generalmente más costosos porque generar contenido nuevo requiere más recursos computacionales que procesar texto existente. Tu uso total de tokens es la suma tanto de tokens de entrada como de salida.

El conteo de tokens determina directamente los costos de la API para modelos de lenguaje. Servicios como OpenAI, Claude y otros cobran por token, con tarifas que varían según el modelo y el tipo de token. Un mensaje más largo con más tokens cuesta más procesar, y generar respuestas más extensas consume más tokens de salida. Entender la eficiencia de los tokens ayuda a optimizar los costos: mensajes concisos que transmiten la información necesaria minimizan el consumo de tokens manteniendo la calidad de la respuesta.

Una ventana de contexto es el número máximo de tokens que un modelo de lenguaje puede procesar a la vez, combinando tanto tokens de entrada como de salida. Por ejemplo, GPT-4 tiene una ventana de contexto de 8,000 a 128,000 tokens dependiendo de la versión. Este límite determina cuánta información el modelo puede 'ver' y recordar al generar respuestas. Ventanas de contexto más grandes permiten procesar documentos más largos, pero también requieren más recursos computacionales.

Los tres principales métodos de tokenización son: a nivel de palabra (dividiendo el texto en palabras completas), a nivel de carácter (tratando cada carácter como un token) y tokenización a nivel de subpalabra como Byte-Pair Encoding (BPE) usado por los modelos GPT. La tokenización de subpalabras es la más común en los LLM modernos porque equilibra el tamaño del vocabulario, maneja palabras raras eficazmente y reduce los errores de fuera de vocabulario (OOV) manteniendo el significado semántico.

Para plataformas como AmICited que monitorean respuestas de IA en ChatGPT, Perplexity, Claude y Google AI Overviews, el seguimiento de tokens es crucial para entender cuánta parte de tu contenido de marca o URLs están siendo procesadas y citadas por sistemas de IA. El conteo de tokens revela la profundidad del compromiso de la IA con tu contenido: un uso alto de tokens indica citas o referencias más sustanciales, ayudándote a medir la visibilidad e influencia de tu marca en las respuestas generadas por IA.

Sí, absolutamente. Diferentes modelos de lenguaje usan tokenizadores y vocabularios distintos, así que el mismo texto producirá diferentes conteos de tokens. Por ejemplo, la palabra 'antidisestablishmentarianism' produce 5 tokens en GPT-3 pero 6 tokens en GPT-4 debido a diferentes algoritmos de tokenización. Por esto es importante usar contadores de tokens específicos del modelo al estimar costos o planear mensajes para sistemas de IA particulares.

Comienza a rastrear cómo los chatbots de IA mencionan tu marca en ChatGPT, Perplexity y otras plataformas. Obtén información procesable para mejorar tu presencia en IA.

Explora cómo los límites de tokens afectan el rendimiento de la IA y aprende estrategias prácticas para la optimización de contenidos, incluyendo RAG, fragmenta...

Descubre cómo los modelos de IA procesan texto mediante tokenización, embeddings, bloques transformadores y redes neuronales. Comprende toda la cadena desde la ...

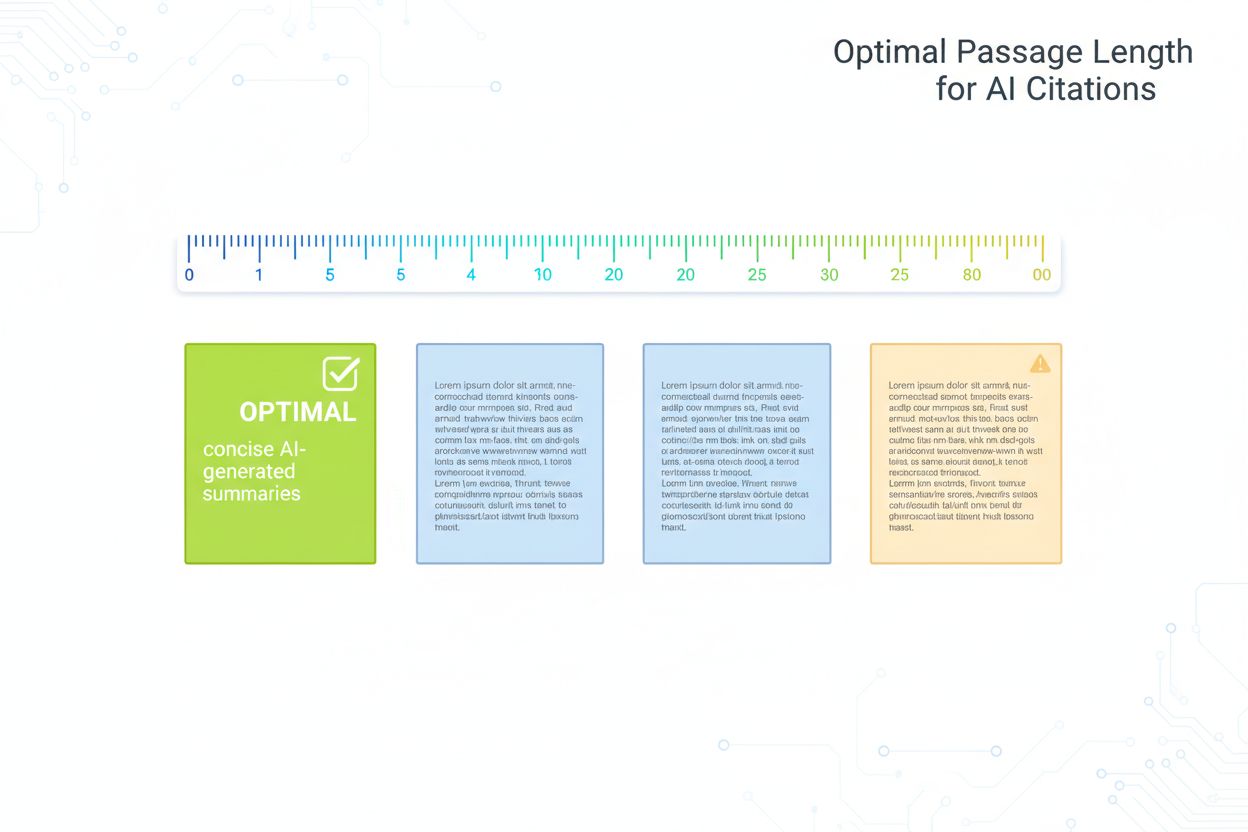

Guía respaldada por investigaciones sobre la longitud óptima de pasajes para citas de IA. Descubre por qué 75-150 palabras es lo ideal, cómo los tokens afectan ...