Arquitectura de la Información

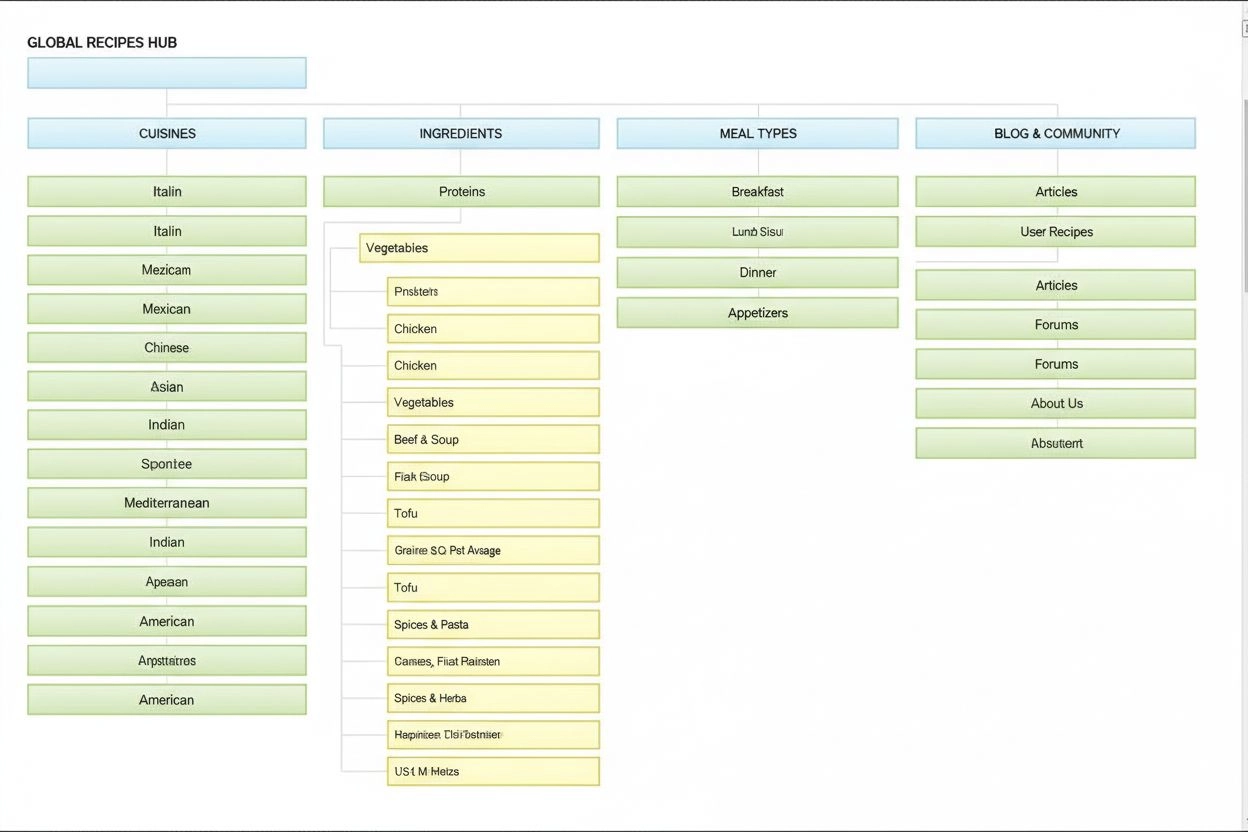

La Arquitectura de la Información es la práctica de organizar y estructurar el contenido para una usabilidad óptima. Descubre cómo la AI mejora la localización,...

Una arquitectura de red neuronal basada en mecanismos de autoatención multi-cabeza que procesa datos secuenciales en paralelo, permitiendo el desarrollo de modelos de lenguaje grandes modernos como ChatGPT, Claude y Perplexity. Introducida en el artículo de 2017 ‘Attention is All You Need’, los transformers se han convertido en la tecnología fundamental que subyace prácticamente a todos los sistemas de IA de vanguardia.

Una arquitectura de red neuronal basada en mecanismos de autoatención multi-cabeza que procesa datos secuenciales en paralelo, permitiendo el desarrollo de modelos de lenguaje grandes modernos como ChatGPT, Claude y Perplexity. Introducida en el artículo de 2017 'Attention is All You Need', los transformers se han convertido en la tecnología fundamental que subyace prácticamente a todos los sistemas de IA de vanguardia.

La Arquitectura Transformer es un diseño revolucionario de red neuronal introducido en el artículo de 2017 “Attention is All You Need” por investigadores de Google. Se basa fundamentalmente en mecanismos de autoatención multi-cabeza que permiten a los modelos procesar secuencias completas de datos en paralelo, en lugar de hacerlo secuencialmente. La arquitectura consiste en capas apiladas de codificador y decodificador, cada una con subcapas de autoatención y redes neuronales feed-forward, conectadas mediante conexiones residuales y normalización de capa. La Arquitectura Transformer se ha convertido en la tecnología fundamental que sustenta prácticamente todos los modelos de lenguaje grandes (LLMs) modernos, incluyendo ChatGPT, Claude, Perplexity y Google AI Overviews, siendo posiblemente la innovación más importante en redes neuronales de la última década.

La importancia de la Arquitectura Transformer va mucho más allá de su elegancia técnica. El artículo de 2017 “Attention is All You Need” ha sido citado más de 208,000 veces, siendo uno de los trabajos de investigación más influyentes en la historia del aprendizaje automático. Esta arquitectura cambió fundamentalmente la forma en que los sistemas de IA procesan y comprenden el lenguaje, permitiendo el desarrollo de modelos con miles de millones de parámetros capaces de razonamiento sofisticado, escritura creativa y resolución de problemas complejos. El mercado empresarial de LLMs, construido casi por completo sobre tecnología transformer, se valoró en 6.700 millones de dólares en 2024 y se proyecta que crecerá a una tasa de crecimiento anual compuesta del 26,1% hasta 2034, demostrando la importancia crítica de la arquitectura para la infraestructura de IA moderna.

El desarrollo de la Arquitectura Transformer representa un momento crucial en la historia del deep learning, surgido de décadas de investigación en redes neuronales para el procesamiento de datos secuenciales. Antes de los transformers, las redes neuronales recurrentes (RNN) y sus variantes, especialmente las redes LSTM (Long Short-Term Memory), dominaban las tareas de procesamiento de lenguaje natural. Sin embargo, estas arquitecturas tenían limitaciones fundamentales: procesaban secuencias de forma secuencial, un elemento a la vez, lo que las hacía lentas de entrenar y dificultaba la captura de dependencias entre elementos distantes en secuencias largas. El problema de desvanecimiento de gradiente limitaba aún más la capacidad de las RNN para aprender relaciones de largo alcance, ya que los gradientes disminuían exponencialmente al retropropagarse a través de muchas capas.

La introducción de los mecanismos de atención en 2014 por Bahdanau y colegas supuso un avance, permitiendo que los modelos se enfocaran en partes relevantes de las secuencias de entrada independientemente de la distancia. Sin embargo, la atención se usó inicialmente como un complemento a las RNN en lugar de un reemplazo. El artículo de Transformers de 2017 llevó este concepto más allá, proponiendo que la atención es todo lo que necesitas—es decir, que una arquitectura de red neuronal completa podría construirse solo con mecanismos de atención y capas feed-forward, eliminando totalmente la recurrencia. Este hallazgo resultó transformador. Al eliminar el procesamiento secuencial, los transformers permitieron la paralelización masiva, posibilitando a los investigadores entrenar con cantidades de datos sin precedentes usando GPUs y TPUs. El modelo transformer más grande del artículo original, entrenado en 8 GPUs durante 3,5 días, demostró que la escala y la paralelización podían conducir a mejoras dramáticas de rendimiento.

Tras el artículo original, la arquitectura evolucionó rápidamente. BERT (Bidirectional Encoder Representations from Transformers), lanzado por Google en 2019, demostró que los codificadores transformer podían preentrenarse en grandes corpus de texto y ajustarse para tareas diversas. El modelo más grande de BERT contenía 345 millones de parámetros y se entrenó en 64 TPUs especializadas durante cuatro días a un coste estimado de 7.000 dólares, logrando resultados de vanguardia en múltiples benchmarks de comprensión de lenguaje. Paralelamente, la serie GPT de OpenAI siguió un camino diferente, usando arquitecturas transformer solo de decodificador entrenadas en tareas de modelado de lenguaje. GPT-2, con 1.500 millones de parámetros, sorprendió a la comunidad al mostrar que el modelado de lenguaje por sí solo podía producir sistemas sumamente capaces. GPT-3, con 175 mil millones de parámetros, mostró capacidades emergentes—habilidades que solo aparecían a escala, como el few-shot learning y el razonamiento complejo—que cambiaron fundamentalmente las expectativas sobre lo que podía lograr la IA.

La Arquitectura Transformer consta de varios componentes técnicos interconectados que funcionan juntos para habilitar el procesamiento paralelo eficiente y una comprensión sofisticada del contexto. La capa de embedding de entrada convierte los tokens discretos (palabras o subunidades) en representaciones vectoriales continuas, típicamente de dimensión 512 o superior. Estos embeddings se amplían con codificación posicional, que añade información sobre la posición de cada token en la secuencia usando funciones seno y coseno a distintas frecuencias. Esta información es esencial porque, a diferencia de las RNN que preservan el orden gracias a su estructura recurrente, los transformers procesan todos los tokens a la vez y necesitan señales explícitas de posición para comprender el orden y las distancias relativas.

El mecanismo de autoatención es la innovación arquitectónica que distingue a los transformers de todos los diseños previos de redes neuronales. Para cada token en la secuencia de entrada, el modelo calcula tres vectores: un vector Consulta (representa la información que el token busca), vectores Clave (representan la información que tiene cada token) y vectores Valor (la información a transmitir). El mecanismo de atención calcula una puntuación de similitud entre la Consulta de cada token y las Claves de todos los tokens usando productos punto, normalizando estas puntuaciones con softmax para crear pesos de atención entre 0 y 1, y después utiliza estos pesos para crear una suma ponderada de los vectores Valor. Este proceso permite que cada token se enfoque selectivamente en otros tokens relevantes, permitiendo que el modelo comprenda contextos y relaciones.

La atención multi-cabeza lleva este concepto más allá ejecutando múltiples mecanismos de atención en paralelo, normalmente 8, 12 o 16 cabezas. Cada cabeza opera sobre distintas proyecciones lineales de los vectores Consulta, Clave y Valor, permitiendo que el modelo atienda a diferentes relaciones y patrones en distintos subespacios de representación. Por ejemplo, una cabeza puede enfocarse en relaciones sintácticas, mientras otra en relaciones semánticas o dependencias de largo alcance. Las salidas de todas las cabezas se concatenan y se transforman linealmente, proporcionando al modelo información contextual rica y multifacética. Este enfoque ha demostrado ser sumamente efectivo, con investigaciones mostrando que distintas cabezas aprenden a especializarse en fenómenos lingüísticos diferentes.

La estructura codificador-decodificador organiza estos mecanismos de atención en una jerarquía de procesamiento. El codificador consta de varias capas apiladas (típicamente 6 o más), cada una con una subcapa de autoatención multi-cabeza seguida de una red feed-forward. Las conexiones residuales alrededor de cada subcapa permiten que los gradientes fluyan directamente durante el entrenamiento, mejorando la estabilidad y permitiendo arquitecturas más profundas. La normalización de capa se aplica después de cada subcapa, normalizando las activaciones para mantener escalas consistentes. El decodificador tiene una estructura similar pero incluye una capa adicional de atención codificador-decodificador que permite al decodificador atender a la salida del codificador, enfocándose en partes relevantes de la entrada al generar cada token de salida. En arquitecturas solo de decodificador como GPT, el decodificador genera tokens de salida de manera autoregresiva, donde cada nuevo token depende de todos los tokens generados previamente.

| Aspecto | Arquitectura Transformer | RNN/LSTM | Redes Neuronales Convolucionales (CNN) |

|---|---|---|---|

| Método de procesamiento | Procesamiento paralelo de secuencias completas usando atención | Procesamiento secuencial, un elemento a la vez | Operaciones de convolución local en ventanas de tamaño fijo |

| Dependencias de largo alcance | Excelente; la atención conecta directamente tokens distantes | Deficiente; limitado por gradientes y secuencialidad | Limitado; el campo receptivo local requiere muchas capas |

| Velocidad de entrenamiento | Muy rápida; paralelización masiva en GPUs/TPUs | Lenta; el procesamiento secuencial impide paralelización | Rápida en entradas de tamaño fijo; menos adecuada para secuencias variables |

| Requerimientos de memoria | Altos; cuadráticos en la longitud de la secuencia por la atención | Bajos; lineales en la longitud de la secuencia | Moderados; depende del tamaño del kernel y la profundidad |

| Escalabilidad | Excelente; escala a miles de millones de parámetros | Limitada; difícil entrenar modelos muy grandes | Buena para imágenes; menos apta para secuencias |

| Aplicaciones típicas | Modelado de lenguaje, traducción automática, generación de texto | Series temporales, predicción secuencial (menos común ahora) | Clasificación de imágenes, detección de objetos, visión por computador |

| Flujo de gradiente | Estable; conexiones residuales permiten redes profundas | Problemático; gradientes desvanecen/explotan | Generalmente estable; conexiones locales ayudan al gradiente |

| Información de posición | Codificación posicional explícita requerida | Implícita mediante procesamiento secuencial | Implícita mediante estructura espacial |

| LLMs de vanguardia | GPT, Claude, Llama, Granite, Perplexity | Rara vez usados en LLMs modernos | No se usan para modelado de lenguaje |

La relación entre la Arquitectura Transformer y los modelos de lenguaje grandes modernos es fundamental e inseparable. Cada LLM importante de los últimos cinco años—incluyendo GPT-4 de OpenAI, Claude de Anthropic, Llama de Meta, Gemini de Google, Granite de IBM y los modelos de Perplexity AI—está construido sobre la arquitectura transformer. La capacidad de la arquitectura para escalar eficientemente tanto en tamaño de modelo como en datos de entrenamiento ha sido esencial para lograr las capacidades que definen los sistemas de IA actuales. Cuando los investigadores aumentaron el tamaño de los modelos de millones a miles de millones y luego a cientos de miles de millones de parámetros, la paralelización y los mecanismos de atención de los transformers permitieron este escalado sin aumentos proporcionales en el tiempo de entrenamiento.

El proceso de decodificación autoregresiva utilizado por la mayoría de los LLMs modernos es una aplicación directa de la arquitectura de decodificador transformer. Al generar texto, estos modelos procesan el prompt de entrada a través del codificador (o en modelos solo de decodificador, por el decodificador completo), y luego generan tokens de salida uno a uno. Cada nuevo token se genera calculando distribuciones de probabilidad sobre todo el vocabulario usando softmax, seleccionando el token de mayor probabilidad (o muestreando según la temperatura). Este proceso, repetido cientos o miles de veces, produce texto coherente y contextual. El mecanismo de autoatención permite al modelo mantener el contexto a lo largo de toda la secuencia generada, logrando pasajes largos y coherentes que mantienen temas, personajes y lógica consistentes.

Las capacidades emergentes observadas en grandes modelos transformer—habilidades que solo aparecen a escala suficiente, como el few-shot learning, razonamiento encadenado e in-context learning—son consecuencia directa del diseño de la arquitectura. La atención multi-cabeza capta relaciones diversas, y junto al elevado recuento de parámetros y entrenamiento en datos variados, permite que estos sistemas realicen tareas para las que no fueron entrenados explícitamente. Por ejemplo, GPT-3 pudo realizar aritmética, escribir código y responder trivia pese a entrenarse solo para modelado de lenguaje. Estas propiedades emergentes han convertido a los LLMs basados en transformers en la base de la revolución de la IA moderna, con aplicaciones que van desde la IA conversacional y generación de contenido hasta síntesis de código y asistencia en investigación científica.

El mecanismo de autoatención es la innovación arquitectónica que distingue fundamentalmente a los transformers y explica su rendimiento superior frente a enfoques previos. Para comprender la autoatención, piensa en la dificultad de interpretar pronombres ambiguos en el lenguaje. En la frase “El trofeo no cabe en la maleta porque es demasiado grande”, el pronombre “es” podría referirse al trofeo o a la maleta, pero el contexto deja claro que se refiere al trofeo. En “El trofeo no cabe en la maleta porque es demasiado pequeña”, el mismo pronombre ahora se refiere a la maleta. Un modelo transformer debe aprender a resolver estas ambigüedades comprendiendo las relaciones entre palabras.

La autoatención logra esto mediante un proceso matemático elegante. Para cada token en la secuencia de entrada, el modelo calcula un vector Consulta multiplicando el embedding del token por una matriz de pesos aprendida WQ. De forma similar, calcula vectores Clave (usando WK) y vectores Valor (usando WV) para todos los tokens. La puntuación de atención entre la Consulta de un token y la Clave de otro se calcula como el producto punto de estos vectores, normalizado por la raíz cuadrada de la dimensión de las claves (típicamente √64 ≈ 8). Estas puntuaciones se pasan por una función softmax, que las convierte en pesos de atención normalizados que suman 1. Finalmente, la salida de cada token se calcula como una suma ponderada de todos los vectores Valor, donde los pesos son las puntuaciones de atención. Este proceso permite que cada token agregue selectivamente información de todos los demás, aprendiendo durante el entrenamiento a captar relaciones significativas.

La elegancia matemática de la autoatención permite un cálculo eficiente. Todo el proceso se expresa como operaciones matriciales: Attention(Q, K, V) = softmax(QK^T / √d_k)V, donde Q, K y V son matrices con todos los vectores de consulta, clave y valor. Esta formulación matricial permite aceleración por GPU, haciendo posible que los transformers procesen secuencias completas en paralelo en vez de secuencialmente. Una secuencia de 512 tokens puede procesarse en casi el mismo tiempo que un solo token en una RNN, haciendo a los transformers mucho más rápidos de entrenar. Esta eficiencia computacional, junto a la capacidad de la atención para captar dependencias de largo alcance, explica por qué los transformers dominan el modelado de lenguaje.

La atención multi-cabeza amplía el mecanismo de autoatención ejecutando operaciones de atención paralelas, cada una aprendiendo diferentes aspectos de las relaciones entre tokens. En un transformer típico con 8 cabezas de atención, los embeddings de entrada se proyectan linealmente en 8 subespacios de representación distintos, cada uno con su propia matriz de pesos Consulta, Clave y Valor. Cada cabeza calcula los pesos de atención y produce vectores de salida de forma independiente. Luego, estas salidas se concatenan y transforman linealmente mediante una matriz final, produciendo la salida final de la atención multi-cabeza. Esta arquitectura permite al modelo atender simultáneamente a información de diferentes subespacios de representación en distintas posiciones.

La investigación sobre transformers entrenados ha revelado que diferentes cabezas de atención se especializan en fenómenos lingüísticos distintos. Algunas cabezas se enfocan en relaciones sintácticas, aprendiendo a atender a palabras gramaticalmente relacionadas (por ejemplo, verbos a sus sujetos y objetos). Otras se centran en relaciones semánticas, atendiendo a palabras con significados relacionados. Otras captan dependencias de largo alcance, atendiendo a palabras distantes pero relacionadas semánticamente. Incluso algunas cabezas aprenden a atender principalmente al propio token, actuando como operaciones de identidad. Esta especialización emerge naturalmente durante el entrenamiento sin supervisión explícita, demostrando el poder de la arquitectura multi-cabeza para aprender representaciones diversas y complementarias.

El número de cabezas de atención es un hiperparámetro clave. Los modelos grandes suelen usar más cabezas (16, 32 o incluso más), permitiendo captar relaciones más diversas. Sin embargo, la dimensionalidad total de la atención suele mantenerse constante, por lo que más cabezas implica menor dimensión por cabeza. Este diseño equilibra los beneficios de múltiples subespacios de representación con la eficiencia computacional. El enfoque multi-cabeza ha demostrado ser tan efectivo que es estándar en todas las implementaciones modernas, desde BERT y GPT hasta arquitecturas especializadas para visión, audio y multimodalidad.

La arquitectura original del transformer, como se describe en “Attention is All You Need”, utiliza una estructura codificador-decodificador optimizada para tareas de secuencia a secuencia como la traducción automática. El codificador procesa la secuencia de entrada y produce representaciones contextuales ricas. Cada capa del codificador contiene dos componentes principales: una subcapa de autoatención multi-cabeza que permite a los tokens atender a otros en la entrada, y una red feed-forward aplicada a cada posición. Estas subcapas se conectan mediante conexiones residuales (o skip connections), que suman la entrada a la salida de cada subcapa. Esta decisión de diseño, inspirada en las redes residuales de visión por computador, permite entrenar redes muy profundas permitiendo el flujo directo de gradientes.

El decodificador genera la secuencia de salida token por token, usando información tanto del codificador como de los tokens previos. Cada capa del decodificador contiene tres componentes clave: una subcapa de autoatención enmascarada que permite a cada token atender solo a los tokens previos (evitando que el modelo vea el futuro durante el entrenamiento), una subcapa de atención codificador-decodificador que permite a los tokens del decodificador atender a las salidas del codificador, y una red feed-forward. El enmascaramiento en la subcapa de autoatención es crucial: impide el flujo de información desde posiciones futuras a pasadas, asegurando que las predicciones de la posición i dependan solo de las salidas conocidas en posiciones menores a i. Esta estructura autoregresiva es esencial para generar secuencias token por token.

La arquitectura codificador-decodificador ha demostrado ser especialmente efectiva para tareas donde la entrada y la salida tienen diferentes estructuras o longitudes, como la traducción automática, la resumización y la respuesta a preguntas. Sin embargo, los LLMs modernos como GPT emplean arquitecturas solo de decodificador, donde una sola pila de capas de decodificador procesa tanto el prompt de entrada como la generación de salida. Esta simplificación reduce la complejidad y ha demostrado ser igualmente—o más—efectiva para el modelado de lenguaje, probablemente porque el modelo aprende a usar la autoatención para procesar la entrada y generar la salida de forma unificada.

Un desafío crítico en la arquitectura transformer es representar el orden de los tokens en una secuencia. A diferencia de las RNN, que preservan el orden mediante recurrencia, los transformers procesan todos los tokens en paralelo y no tienen noción interna de posición. Sin información explícita de posición, un transformer trataría la secuencia “El gato se sentó en la alfombra” igual que “alfombra la en sentó se gato El”, lo que sería desastroso para la comprensión del lenguaje. La solución es la codificación posicional, que añade vectores dependientes de la posición a los embeddings de los tokens antes del procesamiento.

El artículo original propone codificaciones posicionales sinusoidales, donde el vector de posición para la posición pos y dimensión i se calcula como:

Estas funciones sinusoidales crean un patrón único para cada posición, con distintas frecuencias según la dimensión. Las frecuencias bajas (i pequeño) varían lentamente, captando información posicional de largo alcance, mientras que las altas varían rápido, captando detalles finos de posición. Este diseño generaliza naturalmente a secuencias más largas que las vistas en el entrenamiento, proporciona transiciones suaves y permite aprender relaciones de posición relativa. Los vectores de codificación posicional simplemente se suman a los embeddings antes de la primera capa de atención, y el modelo aprende a usarlos durante el entrenamiento.

Se han propuesto y estudiado esquemas alternativos de codificación posicional, incluyendo representaciones de posición relativa (que codifican distancias entre tokens) y rotary position embeddings (RoPE) (que rotan los embeddings según la posición). Estas alternativas han mostrado mejoras en ciertos escenarios, especialmente para secuencias muy largas o al afinar en secuencias más largas que las de entrenamiento. La elección de codificación posicional puede impactar notablemente el rendimiento y sigue siendo un área activa de investigación en la optimización de transformers.

Comprender la Arquitectura Transformer es esencial para entender cómo los sistemas de IA modernos generan respuestas en plataformas como ChatGPT, Claude, Perplexity y Google AI Overviews. Estos sistemas, todos basados en tecnología transformer, procesan consultas de usuarios a través de múltiples capas de autoatención, permitiéndoles comprender el contexto y generar respuestas relevantes y coherentes. Cuando un usuario pregunta por una marca, producto o dominio, los mecanismos de atención del modelo determinan qué partes de sus datos de entrenamiento son más relevantes, y el decodificador genera una respuesta que puede mencionar o referenciar esa marca.

Para las organizaciones que usan plataformas de monitoreo de IA como AmICited, entender la arquitectura transformer aporta contexto fundamental para interpretar cómo y por qué aparece una marca en el contenido generado por IA. La capacidad de la autoatención para captar relaciones entre conceptos implica que las marcas mencionadas en los datos de entrenamiento pueden asociarse a ciertos temas, industrias o casos de uso. Cuando un usuario consulta un sistema de IA sobre esos temas, la atención puede activar conexiones con tu marca, resultando en menciones en las respuestas generadas. La estructura multi-cabeza significa que distintos aspectos de la presencia de tu marca en los datos pueden ser captados por diferentes cabezas, afectando cuán completa es la comprensión y representación de tu marca.

La dependencia de la arquitectura transformer en los datos de entrenamiento también explica por qué la visibilidad de marca en salidas de IA depende en gran medida de la calidad y cantidad de tu presencia online. Modelos entrenados en textos de internet tendrán representaciones más ricas de marcas con contenido web extenso y de calidad, menciones frecuentes en fuentes reputadas y fuertes asociaciones semánticas con temas relevantes. Las organizaciones que buscan mejorar su visibilidad en respuestas generadas por IA deben entender que, en esencia, están optimizando para su inclusión en los datos de entrenamiento de futuros modelos transformer. Esta comprensión une el SEO tradicional (optimización para buscadores) y lo que podría llamarse “GEO” (Generative Engine Optimization)—optimización para la visibilidad en sistemas de IA generativa.

La Arquitectura Transformer sigue evolucionando rápidamente, con investigadores explorando numerosas mejoras y variantes. Los transformers eficientes abordan la complejidad cuadrática en memoria de la atención estándar (que escala con el cuadrado de la longitud de la secuencia) mediante técnicas como atención dispersa, ventanas locales y aproximaciones lineales, permitiendo procesar secuencias mucho más largas, desde miles hasta millones de tokens, abriendo posibilidades como procesar documentos completos, bases de código o bases de conocimiento de una sola vez. Las arquitecturas de Mixture of Experts (MoE), usadas en modelos como Switch Transformer de Google, reemplazan las redes feed-forward densas por redes dispersas donde solo un subconjunto de parámetros se activa por token, aumentando enormemente la capacidad del modelo sin incrementar proporcionalmente el cómputo.

Los transformers multimodales extienden la arquitectura para procesar y generar múltiples tipos de datos simultáneamente. Los Vision Transformers (ViTs) aplican la arquitectura transformer a imágenes, dividiéndolas en parches que actúan como tokens, logrando resultados de vanguardia en clasificación y detección de imágenes. Modelos multimodales como GPT-4V y Claude 3 procesan texto e imágenes usando arquitecturas transformer unificadas, permitiendo capacidades como comprensión de imágenes y preguntas visuales. Los audio transformers procesan voz y música, y los transformers de video manejan secuencias temporales de fotogramas. Esta capacidad multimodal sugiere que los transformers podrían convertirse en la arquitectura universal para todas las tareas de IA, independientemente del tipo de dato.

Las implicaciones estratégicas del dominio de la arquitectura transformer son profundas. Las organizaciones que desarrollan sistemas de IA deben comprender las capacidades y limitaciones de los transformers para tomar decisiones informadas sobre selección, fine-tuning y despliegue de modelos. La naturaleza hambrienta de datos de la arquitectura significa que la calidad y diversidad de los datos de entrenamiento es una ventaja competitiva crítica. La interpretabilidad de la atención (comparada con otros enfoques de deep learning) crea oportunidades para IA explicable y detección de sesgos, aunque los pesos de atención por sí solos no explican todo el comportamiento del modelo. La eficiencia a gran escala sugiere que los modelos más grandes seguirán dominando, al menos hasta que surjan avances fundamentales en arquitecturas alternativas. Para el monitoreo de marca y visibilidad en IA, la dependencia de los transformers en los datos de entrenamiento implica que la estrategia de marca y contenido a largo plazo sigue siendo esencial para mantener la visibilidad en respuestas generadas por IA.

El mercado global de LLMs, impulsado casi por completo por la arquitectura transformer, se proyecta crecer de 8.070 millones de dólares en 2025 a 84.250 millones en 2033, con una tasa de crecimiento anual compuesta superior al 30%. Este crecimiento explosivo refleja el impacto transformador de la arquitectura transformer en las capacidades y aplicaciones de la IA. A medida que los transformers siguen mejorando y surgen nuevas variantes, su papel como tecnología fundamental de la IA moderna solo va a profundizarse, haciendo imprescindible comprender esta arquitectura para cualquier persona que trabaje en IA, ciencia de datos o estrategia digital.

La Arquitectura Transformer procesa secuencias completas en paralelo usando autoatención, mientras que las RNN y LSTM procesan secuencias de forma secuencial, un elemento a la vez. Esta paralelización hace que los transformers sean significativamente más rápidos de entrenar y mejores para captar dependencias de largo alcance entre palabras o tokens distantes. Los transformers también evitan el problema de desvanecimiento de gradiente que afectaba a las RNN, permitiendo que aprendan eficazmente de secuencias mucho más largas.

La autoatención calcula tres vectores (Consulta, Clave y Valor) para cada token en la secuencia de entrada. El vector Consulta de un token se compara con los vectores Clave de todos los tokens para determinar puntuaciones de relevancia, que se normalizan usando softmax. Estos pesos de atención se aplican luego a los vectores Valor para crear representaciones sensibles al contexto. Este mecanismo permite que cada token 'atienda' o se enfoque en otros tokens relevantes de la secuencia, permitiendo al modelo comprender el contexto y las relaciones.

Los componentes principales incluyen: (1) Embeddings de entrada y codificación posicional para representar tokens y sus posiciones, (2) Capas de autoatención multi-cabeza que calculan atención en múltiples subespacios de representación, (3) Redes neuronales feed-forward aplicadas de forma independiente a cada posición, (4) Pila de codificadores que procesa las secuencias de entrada, (5) Pila de decodificadores que genera las secuencias de salida, y (6) Conexiones residuales y normalización de capa para la estabilidad del entrenamiento. Estos componentes trabajan juntos para permitir el procesamiento paralelo eficiente y la comprensión del contexto.

La Arquitectura Transformer destaca en LLMs porque permite el procesamiento paralelo de secuencias completas, reduciendo drásticamente el tiempo de entrenamiento en comparación con RNN secuenciales. Captura dependencias de largo alcance de manera más efectiva mediante la autoatención, permitiendo que los modelos comprendan el contexto a lo largo de documentos completos. La arquitectura también escala eficientemente con conjuntos de datos y parámetros más grandes, lo que ha resultado esencial para entrenar modelos con miles de millones de parámetros que demuestran capacidades emergentes.

La atención multi-cabeza ejecuta múltiples mecanismos de atención paralelos (típicamente 8 o 16 cabezas) simultáneamente, cada uno operando en diferentes subespacios de representación. Cada cabeza aprende a enfocarse en distintos tipos de relaciones y patrones en los datos. Las salidas de todas las cabezas se concatenan y transforman linealmente, permitiendo que el modelo capture información contextual diversa. Este enfoque mejora significativamente la capacidad del modelo para comprender relaciones complejas y mejora el rendimiento general.

La codificación posicional añade información sobre la posición de los tokens a los embeddings de entrada usando funciones seno y coseno a diferentes frecuencias. Dado que los transformers procesan todos los tokens en paralelo (a diferencia de las RNN secuenciales), necesitan información explícita de posición para comprender el orden de las palabras. Los vectores de codificación posicional se suman a los embeddings de los tokens antes del procesamiento, permitiendo que el modelo aprenda cómo la posición afecta el significado y pudiendo generalizarse a secuencias más largas que las vistas durante el entrenamiento.

El codificador procesa la secuencia de entrada y crea representaciones contextuales ricas a través de múltiples capas de autoatención y redes feed-forward. El decodificador genera la secuencia de salida token por token, utilizando atención codificador-decodificador para enfocarse en partes relevantes de la entrada. Esta estructura es especialmente útil para tareas de secuencia a secuencia como la traducción automática, pero los LLMs modernos suelen usar arquitecturas solo de decodificador para tareas de generación de texto.

La Arquitectura Transformer impulsa los sistemas de IA que generan respuestas en plataformas como ChatGPT, Claude, Perplexity y Google AI Overviews. Comprender cómo los transformers procesan y generan texto es crucial para plataformas de monitoreo de IA como AmICited, que rastrean dónde aparecen marcas y dominios en respuestas generadas por IA. La capacidad de la arquitectura para entender el contexto y generar texto coherente afecta directamente cómo se mencionan y representan las marcas en las salidas de IA.

Comienza a rastrear cómo los chatbots de IA mencionan tu marca en ChatGPT, Perplexity y otras plataformas. Obtén información procesable para mejorar tu presencia en IA.

La Arquitectura de la Información es la práctica de organizar y estructurar el contenido para una usabilidad óptima. Descubre cómo la AI mejora la localización,...

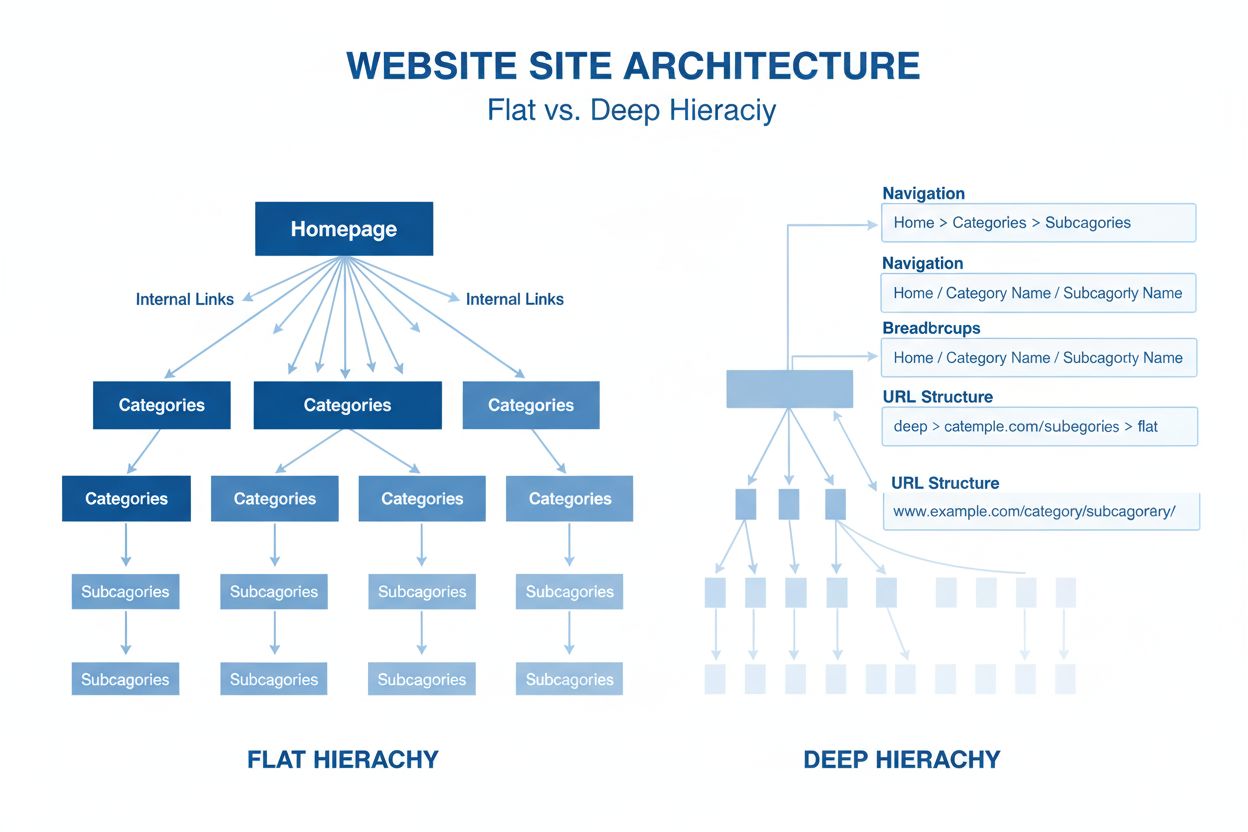

La arquitectura del sitio es la organización jerárquica de las páginas y contenido de un sitio web. Descubre cómo una estructura adecuada mejora el SEO, la expe...

GPT-4 es el avanzado LLM multimodal de OpenAI que combina procesamiento de texto e imagen. Conozca sus capacidades, arquitectura e impacto en la monitorización ...