¿Qué es la búsqueda vectorial y cómo funciona?

Aprende cómo la búsqueda vectorial utiliza embeddings de aprendizaje automático para encontrar elementos similares basándose en el significado en lugar de palab...

La búsqueda vectorial es un método para encontrar elementos similares en un conjunto de datos representando los datos como vectores matemáticos y comparándolos mediante métricas de distancia como la similitud de coseno o la distancia euclidiana. Este enfoque permite una comprensión semántica más allá de la coincidencia de palabras clave, permitiendo a los sistemas descubrir relaciones y similitudes basadas en el significado en lugar de coincidencias exactas de texto.

La búsqueda vectorial es un método para encontrar elementos similares en un conjunto de datos representando los datos como vectores matemáticos y comparándolos mediante métricas de distancia como la similitud de coseno o la distancia euclidiana. Este enfoque permite una comprensión semántica más allá de la coincidencia de palabras clave, permitiendo a los sistemas descubrir relaciones y similitudes basadas en el significado en lugar de coincidencias exactas de texto.

La búsqueda vectorial es un método para encontrar elementos similares en un conjunto de datos representando la información como vectores matemáticos y comparándolos mediante métricas de distancia para medir la similitud semántica. A diferencia de la búsqueda tradicional basada en palabras clave, que depende de coincidencias exactas de texto, la búsqueda vectorial comprende el significado y el contexto detrás de los datos al convertirlos en representaciones numéricas de alta dimensión llamadas embeddings vectoriales. Este enfoque permite a los sistemas descubrir relaciones y similitudes basadas en el contenido semántico y no solo en características superficiales, siendo especialmente potente para aplicaciones que requieren comprensión contextual. La búsqueda vectorial se ha vuelto fundamental en los sistemas modernos de IA, habilitando la búsqueda semántica, motores de recomendación, detección de anomalías y generación aumentada por recuperación (RAG) en plataformas como ChatGPT, Perplexity, Google AI Overviews y Claude.

En esencia, la búsqueda vectorial transforma los datos en representaciones numéricas donde la proximidad en el espacio indica similitud semántica. Cada punto de datos—ya sea texto, imagen o audio—se convierte en un vector, que es esencialmente un arreglo de números que representa características o significado. Por ejemplo, la palabra “restaurante” podría representarse como [0.2, -0.5, 0.8, 0.1], donde cada número captura diferentes aspectos del significado semántico de la palabra. El principio fundamental es que los elementos semánticamente similares tendrán vectores posicionados cerca en este espacio de alta dimensión, mientras que los elementos disímiles estarán alejados. Esta estructura matemática permite a las computadoras comparar conceptos basándose en el significado y no en coincidencias exactas de palabras clave, permitiendo que una búsqueda como “mejores lugares para cenar” devuelva resultados para “restaurantes mejor calificados” aunque no haya coincidencia exacta de palabras.

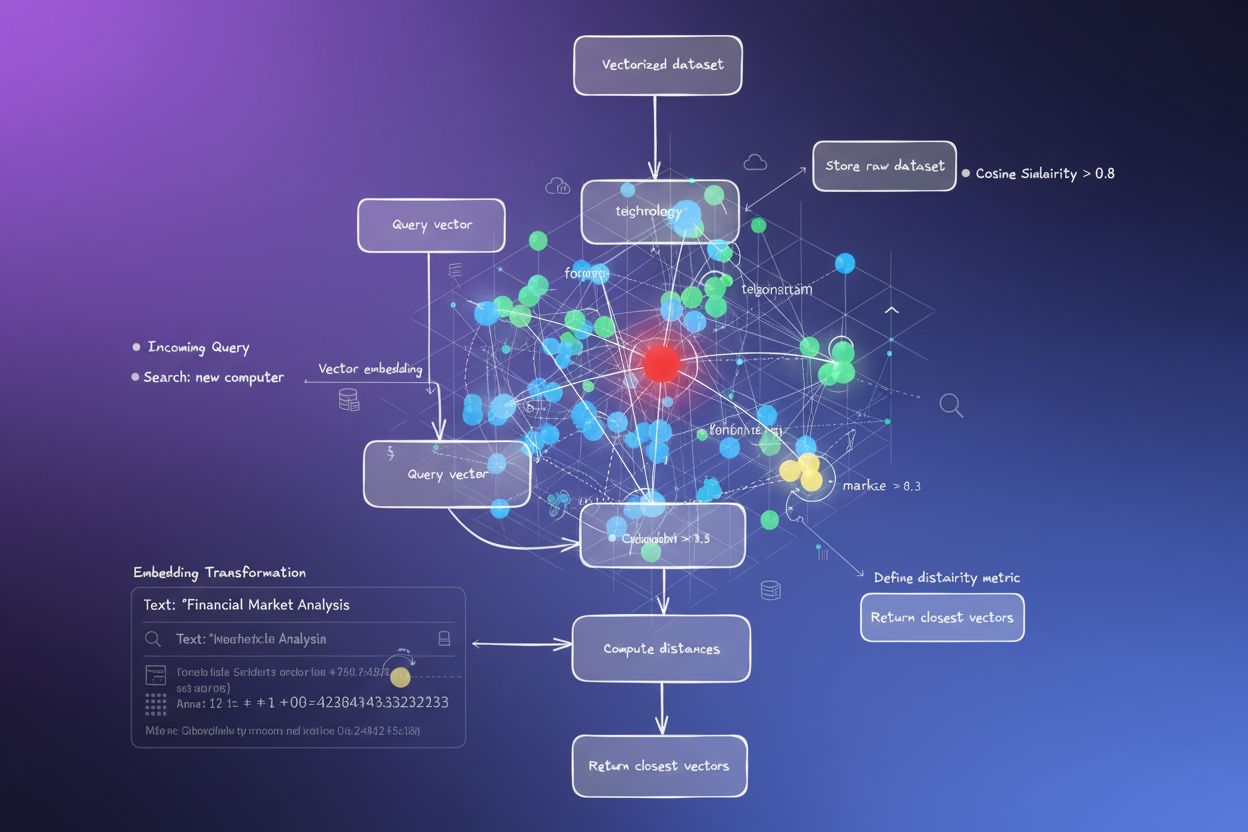

El proceso de convertir datos en vectores se llama embedding, realizado por modelos de aprendizaje automático entrenados con grandes volúmenes de datos. Estos modelos aprenden a mapear conceptos similares a ubicaciones cercanas en el espacio vectorial al exponerse a miles de millones de ejemplos. Algunos modelos comunes de embedding incluyen Word2Vec, que aprende relaciones entre palabras a partir del contexto; BERT (Bidirectional Encoder Representations from Transformers), que captura el significado contextual; y CLIP (Contrastive Language-Image Pre-training), que maneja datos multimodales. Los embeddings resultantes suelen tener entre 100 y más de 1,000 dimensiones, creando una rica representación matemática de relaciones semánticas. Cuando un usuario realiza una búsqueda, su consulta se convierte en un vector utilizando el mismo modelo de embedding, y el sistema calcula las distancias entre el vector de consulta y todos los vectores almacenados para identificar los elementos más similares.

La búsqueda vectorial depende de métricas de distancia para cuantificar cuán similares son dos vectores. Las tres métricas principales son similitud de coseno, distancia euclidiana y similitud por producto punto, cada una con propiedades matemáticas y usos distintos. La similitud de coseno mide el ángulo entre dos vectores, con valores de -1 a 1, donde 1 indica dirección idéntica (máxima similitud) y 0 indica vectores ortogonales (sin relación). Esta métrica es especialmente útil en aplicaciones de PLN porque se enfoca en la dirección semántica sin importar la magnitud, siendo ideal para comparar documentos de diferentes longitudes. La distancia euclidiana calcula la distancia en línea recta entre vectores en un espacio multidimensional, considerando tanto magnitud como dirección. Esta métrica es sensible a la escala, lo que la hace útil cuando la magnitud de los vectores lleva información relevante, como en sistemas de recomendación donde la frecuencia de compra importa.

La similitud por producto punto combina aspectos de ambas métricas, considerando magnitud y dirección y ofreciendo eficiencia computacional. Muchos modelos grandes de lenguaje utilizan producto punto para entrenamiento, por lo que es la elección apropiada en esos casos. La selección de la métrica correcta es crítica—las investigaciones muestran que usar la misma métrica con la que se entrenó tu modelo de embedding produce los mejores resultados. Por ejemplo, el modelo all-MiniLM-L6-v2 fue entrenado usando similitud de coseno, por lo que emplear esta métrica en tu índice generará los resultados más precisos. Las organizaciones que implementan búsqueda vectorial deben emparejar cuidadosamente la métrica seleccionada con el modelo de embedding y el caso de uso para asegurar precisión y rendimiento.

| Aspecto | Búsqueda Vectorial | Búsqueda por Palabras Clave | Búsqueda Híbrida |

|---|---|---|---|

| Método de Coincidencia | Similitud semántica basada en el significado | Coincidencia exacta de palabras o frases | Combina coincidencia semántica y por palabras clave |

| Comprensión de la Consulta | Comprende la intención y el contexto | Requiere palabras clave exactas presentes | Aprovecha ambos enfoques para resultados integrales |

| Manejo de Sinónimos | Encuentra automáticamente sinónimos y términos relacionados | Omite sinónimos a menos que se indexen explícitamente | Captura sinónimos mediante ambos métodos |

| Rendimiento con Consultas Vagamente Definidas | Excelente—comprende la intención | Deficiente—requiere palabras clave precisas | Muy bueno—cubre ambas interpretaciones |

| Costo Computacional | Superior—requiere embedding y cálculo de similitud | Inferior—simple coincidencia de cadenas | Moderado—ejecuta ambas búsquedas en paralelo |

| Escalabilidad | Requiere bases de datos vectoriales especializadas | Funciona con bases de datos tradicionales | Requiere sistemas híbridos |

| Casos de Uso | Búsqueda semántica, recomendaciones, RAG, detección de anomalías | Búsqueda exacta de frases, datos estructurados | Búsqueda empresarial, monitoreo de IA, seguimiento de marca |

| Ejemplo | Buscar “ideas de cenas saludables” encuentra “preparación de comidas nutritivas” | Solo encuentra resultados con las palabras exactas “saludable” y “cena” | Encuentra coincidencias exactas y contenido semánticamente relacionado |

Implementar búsqueda vectorial involucra varios pasos interconectados que transforman datos brutos en representaciones semánticas consultables. El primer paso es ingesta y preprocesamiento de datos, donde documentos, imágenes u otros datos se limpian y normalizan. Luego viene la transformación vectorial, donde un modelo de embedding convierte cada elemento en un vector numérico, generalmente entre 100 y más de 1,000 dimensiones. Estos vectores se almacenan en una base de datos vectorial o estructura de índice optimizada para datos de alta dimensionalidad. Cuando llega una consulta de búsqueda, atraviesa el mismo proceso de embedding para crear un vector de consulta. El sistema entonces utiliza métricas de distancia para calcular puntuaciones de similitud entre el vector de consulta y todos los vectores almacenados, clasificando los resultados según su proximidad a la consulta.

Para hacer eficiente este proceso a escala, los sistemas emplean algoritmos de Vecino Más Cercano Aproximado (ANN) como HNSW (Hierarchical Navigable Small World), IVF (Inverted File Index) o ScaNN (Scalable Nearest Neighbors). Estos algoritmos sacrifican precisión perfecta por velocidad, permitiendo búsquedas entre millones o miles de millones de vectores en milisegundos en lugar de segundos. Por ejemplo, HNSW organiza los vectores en una estructura de grafo multinivel donde las capas superiores contienen conexiones de largo alcance para una exploración rápida, mientras que las capas inferiores contienen conexiones de corto alcance para precisión. Este enfoque jerárquico reduce la complejidad de búsqueda de lineal O(n) a logarítmica O(log n), haciendo práctica la búsqueda vectorial a gran escala. La elección del algoritmo depende de factores como el tamaño del conjunto de datos, volumen de consultas, requisitos de latencia y recursos computacionales disponibles.

La búsqueda vectorial se ha vuelto esencial para plataformas de monitoreo de IA como AmICited que rastrean menciones de marca en sistemas de IA. El monitoreo tradicional basado en palabras clave perdería menciones parafraseadas, referencias contextuales y variaciones semánticas de nombres de marca o URLs de dominio. La búsqueda vectorial permite a estas plataformas detectar cuándo se menciona tu marca en respuestas generadas por IA incluso cuando la redacción exacta difiere. Por ejemplo, si tu dominio es “amicited.com”, la búsqueda vectorial puede identificar menciones como “plataforma de monitoreo de prompts de IA” o “visibilidad de marca en IA generativa” como relacionadas con tu negocio, incluso sin menciones explícitas de la URL. Esta comprensión semántica es crucial para un seguimiento integral de citas en IA en ChatGPT, Perplexity, Google AI Overviews y Claude.

El mercado de tecnología de búsqueda vectorial está experimentando un crecimiento explosivo, reflejando el reconocimiento empresarial de su valor. Según estudios de mercado, el mercado de bases de datos vectoriales estaba valorado en $1.97 mil millones en 2024 y se proyecta que alcanzará $10.60 mil millones para 2032, creciendo a una tasa anual compuesta (CAGR) de 23.38%. Además, Databricks reportó un crecimiento del 186% en la adopción de bases de datos vectoriales solo en el primer año tras la vista previa pública de búsqueda vectorial en diciembre de 2023. Esta rápida adopción demuestra que las empresas reconocen cada vez más la búsqueda vectorial como infraestructura crítica para aplicaciones de IA. Para organizaciones que monitorean su presencia en sistemas de IA, la búsqueda vectorial proporciona la comprensión semántica necesaria para captar todas las menciones significativas, no solo coincidencias exactas de palabras clave.

El rendimiento de la búsqueda vectorial a escala depende críticamente de sofisticadas técnicas de indexación que equilibran velocidad, precisión y uso de memoria. HNSW (Hierarchical Navigable Small World) se ha posicionado como uno de los enfoques más populares, organizando los vectores en un grafo multinivel donde cada capa contiene conexiones de alcance progresivamente más corto. El algoritmo inicia las búsquedas en la capa superior con conexiones de largo alcance para una exploración rápida, descendiendo a capas con conexiones cada vez más precisas. Las investigaciones demuestran que HNSW logra rendimiento de vanguardia con tasas de recall superiores al 99% manteniendo latencias de consulta inferiores al milisegundo. Sin embargo, HNSW exige considerable memoria—los benchmarks muestran que indexar 1 millón de vectores con HNSW puede requerir de 0.5GB a 5GB según los parámetros, haciendo importante la optimización de memoria en despliegues a gran escala.

IVF (Inverted File Index) ofrece un enfoque alternativo agrupando vectores e indexándolos por centroides de clúster. Esta técnica reduce el espacio de búsqueda al enfocarse solo en los clústeres relevantes en vez de todos los vectores. ScaNN (Scalable Nearest Neighbors), desarrollado por Google Research, está optimizado específicamente para búsqueda por producto interno y ofrece rendimiento sobresaliente en sistemas de recomendación. Product Quantization (PQ) comprime los vectores dividiéndolos en subvectores y cuantizando cada uno de forma independiente, reduciendo los requerimientos de memoria entre 10 y 100 veces a costa de algo de precisión. Las organizaciones que implementan búsqueda vectorial deben seleccionar cuidadosamente técnicas de indexación según sus requisitos específicos—ya sea que prioricen precisión de recall, velocidad de búsqueda, eficiencia de memoria o una combinación de estos. El campo sigue evolucionando rápidamente, con nuevos algoritmos y técnicas de optimización emergiendo regularmente para enfrentar los retos computacionales de operaciones vectoriales de alta dimensión.

La definición y aplicación de la búsqueda vectorial sigue evolucionando a medida que los sistemas de IA se sofisticaron y la adopción empresarial se acelera. La tendencia apunta hacia sistemas de búsqueda híbrida que combinan búsqueda vectorial con búsqueda tradicional por palabras clave y capacidades avanzadas de filtrado. Estos enfoques híbridos aprovechan la comprensión semántica de la búsqueda vectorial mientras mantienen la precisión y familiaridad de la coincidencia por palabras clave, ofreciendo resultados superiores para consultas complejas. Además, la búsqueda vectorial multimodal emerge como una capacidad crítica, permitiendo a los sistemas buscar simultáneamente en texto, imágenes, audio y video usando espacios de embedding unificados. Este desarrollo permitirá experiencias de búsqueda más intuitivas y completas a través de diversos tipos de datos.

Para las organizaciones que monitorean su presencia en sistemas de IA, la evolución de la búsqueda vectorial tiene profundas implicaciones. A medida que plataformas de IA como ChatGPT, Perplexity, Google AI Overviews y Claude dependen cada vez más de la búsqueda vectorial para la recuperación y clasificación de contenido, comprender cómo aparece semánticamente tu marca es tan importante como la visibilidad tradicional por palabras clave. El cambio hacia la comprensión semántica significa que el monitoreo de marca y el seguimiento de citas en IA deben ir más allá de la simple detección de palabras clave para captar menciones contextuales y relaciones semánticas. Las organizaciones que inviertan en entender la búsqueda vectorial y sus aplicaciones estarán mejor posicionadas para optimizar su visibilidad en sistemas de IA generativa. La convergencia de la tecnología de búsqueda vectorial con plataformas de monitoreo de IA representa un cambio fundamental en la forma en que las marcas comprenden y gestionan su presencia en el panorama informativo impulsado por la IA.

La búsqueda tradicional por palabras clave busca coincidencias exactas de palabras en los documentos, mientras que la búsqueda vectorial comprende el significado semántico y el contexto. La búsqueda vectorial convierte el texto en representaciones numéricas llamadas embeddings, lo que le permite encontrar resultados relevantes incluso cuando las palabras clave exactas no coinciden. Por ejemplo, al buscar 'auriculares inalámbricos' mediante búsqueda vectorial, también se obtendrán resultados para 'auriculares Bluetooth' porque comparten un significado semántico similar, mientras que la búsqueda por palabras clave pasaría por alto esta relación.

Los embeddings vectoriales son representaciones numéricas de datos (texto, imágenes, audio) convertidos en arreglos de números que capturan el significado semántico. Se crean utilizando modelos de aprendizaje automático como Word2Vec, BERT o modelos basados en transformers que aprenden a mapear conceptos similares cerca entre sí en un espacio de alta dimensionalidad. Por ejemplo, las palabras 'rey' y 'reina' tendrían embeddings posicionados cerca porque comparten relaciones semánticas, mientras que 'rey' y 'banana' estarían muy alejados.

Las tres métricas de distancia principales son la similitud de coseno (mide el ángulo entre vectores), la distancia euclidiana (mide la distancia en línea recta) y la similitud por producto punto (considera tanto la magnitud como la dirección). La similitud de coseno es la más común para aplicaciones de PLN porque se enfoca en la dirección semántica sin importar la magnitud del vector. La elección de la métrica debe coincidir con la utilizada para entrenar tu modelo de embeddings para una precisión óptima.

La búsqueda vectorial permite a plataformas de monitoreo de IA como AmICited rastrear menciones de marca a través de sistemas de IA (ChatGPT, Perplexity, Google AI Overviews, Claude) comprendiendo el contexto semántico en lugar de coincidencias exactas de palabras clave. Esto permite la detección de menciones parafraseadas, conceptos relacionados y referencias contextuales a tu marca, brindando visibilidad integral sobre cómo aparece tu dominio en respuestas generadas por IA en múltiples plataformas.

Los algoritmos ANN como HNSW (Hierarchical Navigable Small World) permiten búsquedas de similitud rápidas entre millones de vectores encontrando vecinos más cercanos aproximados en lugar de exactos. Estos algoritmos utilizan estructuras de grafos jerárquicos para reducir la complejidad de búsqueda de lineal a logarítmica, haciendo que la búsqueda vectorial sea práctica para aplicaciones a gran escala. HNSW organiza los vectores en grafos multinivel donde las conexiones de largo alcance existen en capas superiores para una exploración más rápida.

Las empresas generan grandes cantidades de datos no estructurados (correos, documentos, tickets de soporte) que la búsqueda tradicional por palabras clave no logra organizar eficazmente. La búsqueda vectorial permite la comprensión semántica de estos datos, impulsando aplicaciones como búsqueda inteligente, sistemas de recomendación, detección de anomalías y generación aumentada por recuperación (RAG). Según estudios de mercado, se proyecta que el mercado de bases de datos vectoriales crecerá de $2.65 mil millones en 2025 a $8.95 mil millones para 2030, reflejando su adopción empresarial.

Las bases de datos vectoriales son sistemas especializados optimizados para almacenar, indexar y consultar datos vectoriales de alta dimensionalidad. Implementan técnicas eficientes de indexación como HNSW, IVF (Inverted File Index) y ScaNN para habilitar búsquedas de similitud rápidas a escala. Ejemplos incluyen Milvus, Pinecone, Weaviate y Zilliz Cloud. Estas bases de datos gestionan la complejidad computacional de las operaciones vectoriales, permitiendo a las organizaciones construir aplicaciones de búsqueda semántica y de IA listas para producción sin gestionar la complejidad de la infraestructura.

Comienza a rastrear cómo los chatbots de IA mencionan tu marca en ChatGPT, Perplexity y otras plataformas. Obtén información procesable para mejorar tu presencia en IA.

Aprende cómo la búsqueda vectorial utiliza embeddings de aprendizaje automático para encontrar elementos similares basándose en el significado en lugar de palab...

La búsqueda semántica interpreta el significado y contexto de la consulta usando PLN y aprendizaje automático. Descubre cómo se diferencia de la búsqueda por pa...

Descubre cómo la búsqueda semántica utiliza la IA para comprender la intención y el contexto del usuario. Aprende en qué se diferencia de la búsqueda por palabr...