Existe-t-il un index de recherche IA ? Comment les moteurs IA indexent le contenu

Découvrez comment fonctionnent les index de recherche IA, les différences entre les méthodes d’indexation de ChatGPT, Perplexity et SearchGPT, et comment optimi...

Découvrez les différences fondamentales entre l’indexation par l’IA et l’indexation Google. Apprenez comment les LLM, les embeddings vectoriels et la recherche sémantique transforment la recherche d’information et ce que cela implique pour la visibilité de votre contenu.

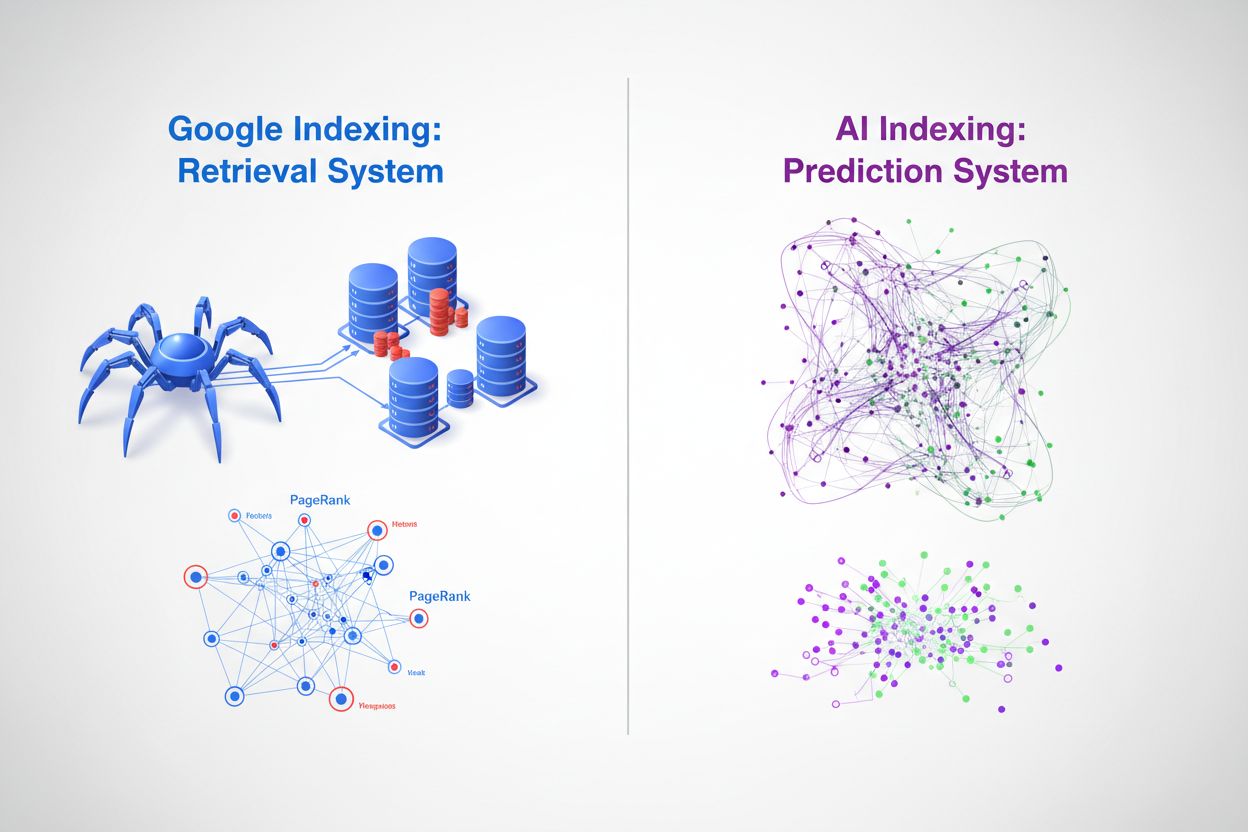

Au fond, l’indexation Google et l’indexation par l’IA représentent deux approches radicalement différentes pour organiser et retrouver l’information. Le moteur de recherche traditionnel de Google fonctionne comme un système de recherche — il explore le web, catalogue le contenu et retourne des liens classés lorsque les utilisateurs saisissent des mots-clés spécifiques. À l’inverse, l’indexation par l’IA via des grands modèles de langage (LLM) comme ChatGPT, Gemini et Copilot fonctionne comme un système de prédiction — il encode d’immenses quantités de données d’entraînement dans des réseaux neuronaux et génère directement des réponses contextuellement pertinentes. Tandis que Google pose la question « où est cette information ? », l’IA demande « quelle est la réponse la plus pertinente ? » Cette distinction change fondamentalement la façon dont le contenu est découvert, classé et présenté, créant deux écosystèmes d’information parallèles mais de plus en plus interconnectés.

Le processus d’indexation de Google suit un pipeline bien établi qui domine la recherche depuis plus de vingt ans. Les robots d’indexation Googlebot parcourent systématiquement le web, suivant les liens de page en page et collectant le contenu, ensuite traité par l’infrastructure d’indexation de Google. Le système extrait des signaux clés tels que les mots-clés, les métadonnées et la structure des liens, stockant ces informations dans des bases de données distribuées massives. L’algorithme propriétaire PageRank de Google évalue l’importance des pages selon la quantité et la qualité des liens entrants, partant du principe que les pages importantes reçoivent plus de liens d’autres pages importantes. La correspondance des mots-clés reste centrale dans la détermination de la pertinence — lorsqu’un utilisateur saisit une requête, le système de Google identifie les pages contenant ces termes exacts ou similaires et les classe selon des centaines de facteurs de classement, dont l’autorité du domaine, la fraîcheur du contenu, les signaux d’expérience utilisateur et la pertinence thématique. Cette approche excelle à trouver rapidement une information précise et s’est révélée très efficace pour les requêtes de navigation et transactionnelles, ce qui explique la domination de Google avec 89,56% de parts de marché de la recherche et le traitement de 8,5 à 13,7 milliards de requêtes par jour.

| Aspect | Indexation Google | Détails |

|---|---|---|

| Mécanisme principal | Exploration du web & Indexation | Googlebot parcourt systématiquement les pages web |

| Algorithme de classement | PageRank + 200+ facteurs | Liens, mots-clés, fraîcheur, expérience utilisateur |

| Représentation des données | Mots-clés & Liens | Jetons de texte et relations de liens hypertexte |

| Fréquence des mises à jour | Exploration continue | Indexation en temps réel du contenu nouveau/mis à jour |

| Traitement des requêtes | Correspondance de mots-clés | Correspondance exacte et sémantique de mots-clés |

| Part de marché | 89,56% mondial | 8,5-13,7 milliards de requêtes/jour |

Les modèles d’IA utilisent un mécanisme d’indexation fondamentalement différent, centré sur les embeddings vectoriels et la compréhension sémantique plutôt que sur la correspondance de mots-clés. Lors de l’entraînement, les LLM traitent des milliards de jetons de texte, apprenant à représenter les concepts, relations et significations sous forme de vecteurs de grande dimension lors du processus appelé génération d’embeddings. Ces embeddings capturent les relations sémantiques — par exemple, « roi » moins « homme » plus « femme » donne approximativement « reine » — permettant au modèle de comprendre le contexte et l’intention au-delà de la simple correspondance de chaînes de caractères. L’indexation dans les systèmes d’IA implique plusieurs mécanismes clés :

Cette approche permet aux systèmes d’IA de comprendre l’intention de l’utilisateur même si la requête utilise une terminologie différente du contenu source, et de synthétiser l’information à travers plusieurs concepts pour générer des réponses inédites. Il en résulte un paradigme de recherche radicalement différent où « l’index » est distribué dans les poids du réseau neuronal plutôt que stocké dans une base de données classique.

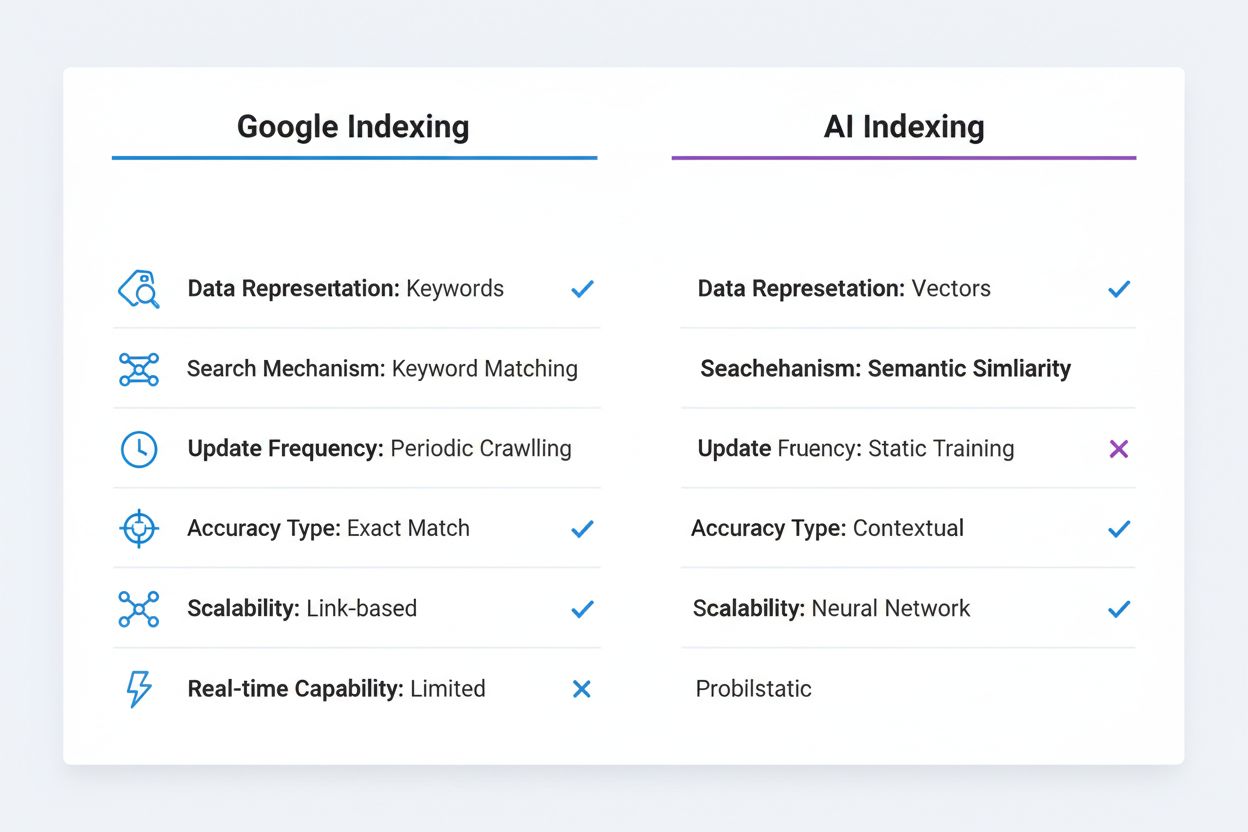

Les différences techniques entre l’indexation Google et l’indexation par l’IA ont d’importantes conséquences sur la découverte et la visibilité du contenu. La correspondance exacte de mots-clés, toujours importante dans l’algorithme de Google, devient largement irrélevante dans les systèmes d’IA — un LLM comprend que « automobile », « voiture » et « véhicule » sont équivalents sémantiquement sans qu’une optimisation explicite soit nécessaire. L’indexation Google est déterministe et reproductible : une même requête retourne les mêmes résultats classés pour tous les utilisateurs à un instant donné (hors personnalisation). L’indexation par l’IA est probabiliste et variable : une même requête peut générer différentes réponses selon les paramètres de température et d’échantillonnage, même si la base de connaissances reste cohérente. Le système de Google excelle avec l’information structurée et discrète comme les prix de produits, horaires d’ouverture ou données factuelles, qu’il peut extraire et afficher dans les snippets enrichis et panneaux de connaissance. Les systèmes d’IA ont du mal avec ce type d’information précise et à jour car leurs données d’entraînement ont une limite de connaissance et ils ne peuvent accéder de façon fiable à l’actualité sans outils externes. À l’inverse, les systèmes d’IA excellent dans la compréhension contextuelle et la synthèse, connectant des concepts disparates et expliquant des relations complexes en langage naturel. L’indexation Google exige des liens et citations explicites — le contenu doit être publié et lié pour être découvert. L’indexation par l’IA repose sur la connaissance implicite encodée lors de l’entraînement, ce qui signifie que l’information précieuse enfermée dans des PDF, du contenu payant ou des bases privées reste invisible pour les deux systèmes, mais pour des raisons différentes.

| Aspect de comparaison | Indexation Google | Indexation IA |

|---|---|---|

| Représentation des données | Mots-clés & Liens | Embeddings vectoriels |

| Mécanisme de recherche | Correspondance de mots-clés | Similarité sémantique |

| Fréquence de mise à jour | Exploration périodique | Données d’entraînement statiques |

| Type de précision | Focalisée sur la correspondance exacte | Compréhension contextuelle |

| Modèle de scalabilité | Autorité basée sur les liens | Poids du réseau neuronal |

| Capacité en temps réel | Oui (avec exploration) | Limitée (sans RAG) |

L’émergence des bases de données vectorielles représente un pont crucial entre l’indexation traditionnelle et la recherche alimentée par l’IA, permettant aux organisations de mettre en œuvre la recherche sémantique à grande échelle. Des bases de données comme Pinecone, Weaviate et Milvus stockent des embeddings de grande dimension et effectuent des recherches de similarité à l’aide de métriques telles que la similarité cosinus ou la distance euclidienne, ce qui permet de trouver un contenu pertinent même sans correspondance exacte de mots-clés. Cette technologie alimente la génération augmentée par la recherche (RAG), une technique où des systèmes IA interrogent des bases vectorielles pour récupérer un contexte pertinent avant de générer des réponses, ce qui améliore considérablement la précision et permet l’accès à des informations propriétaires ou à jour. Les systèmes RAG peuvent retrouver en quelques millisecondes les documents les plus proches sémantiquement d’une requête, fournissant au modèle IA des informations fiables à citer et à exploiter. Google a intégré la compréhension sémantique à son cœur algorithmique via BERT et ses successeurs, dépassant la simple correspondance de mots-clés pour comprendre l’intention de recherche et le sens du contenu. Les bases de données vectorielles permettent la récupération en temps réel d’informations pertinentes, offrant aux IA l’accès à des données actuelles, des bases de connaissances d’entreprise et des informations spécialisées sans nécessiter de réentraînement. Cette capacité est particulièrement puissante pour les applications professionnelles où il est crucial que l’IA réponde sur la base d’informations propriétaires tout en maintenant la précision et en fournissant des citations vérifiables.

L’essor de l’indexation par l’IA transforme fondamentalement la façon dont le contenu gagne en visibilité et génère du trafic. Le phénomène de recherche sans clic — où Google répond directement dans les résultats de recherche sans rediriger l’utilisateur vers les sites sources — s’est fortement accéléré avec l’intégration de l’IA, et les chatbots IA vont encore plus loin en générant des réponses sans aucune attribution visible. Le traditionnel trafic issu des clics est remplacé par les citations IA, où les créateurs de contenu gagnent en visibilité via des mentions dans les réponses générées par l’IA plutôt que par des clics. Ce changement est majeur : une marque citée dans une réponse de ChatGPT touche potentiellement des millions d’utilisateurs sans générer de trafic direct ni fournir de données analytiques sur l’engagement. L’autorité de marque et l’expertise thématique deviennent cruciales, car les IA sont entraînées à citer des sources fiables et à reconnaître l’expertise sectorielle, ce qui rend essentiel pour les organisations de renforcer leurs signaux d’autorité dans leur contenu. Le balisage des données structurées prend encore plus d’importance dans ce contexte, puisqu’il aide Google comme les IA à comprendre le contexte et la crédibilité du contenu. La visibilité ne dépend plus uniquement du classement sur les mots-clés — il s’agit désormais d’être reconnu comme source d’autorité digne de citation par des IA qui traitent des milliards de documents et doivent distinguer information fiable et désinformation.

Plutôt que l’indexation IA remplace l’indexation Google, l’avenir s’annonce comme une convergence et une coexistence. Google a déjà commencé à intégrer des capacités IA directement dans la recherche avec sa fonctionnalité AI Overview (anciennement SGE), qui génère des résumés IA à côté des résultats traditionnels, créant ainsi un système hybride combinant l’infrastructure d’indexation de Google avec les capacités de génération de l’IA. Cela permet à Google de conserver sa force principale — l’indexation web exhaustive et l’analyse de liens — tout en ajoutant la capacité de l’IA à synthétiser et contextualiser l’information. D’autres moteurs et entreprises IA suivent des stratégies similaires, Perplexity combinant la recherche web et la génération IA, Microsoft intégrant ChatGPT à Bing. Les systèmes de recherche les plus avancés emploieront probablement des stratégies d’indexation multimodales alliant la récupération traditionnelle par mots-clés pour la précision et la recherche sémantique/vectorielle pour la compréhension contextuelle. Les organisations et créateurs de contenu doivent donc préparer leur stratégie pour un environnement où le contenu doit être optimisé pour plusieurs modes de découverte en parallèle — SEO traditionnel pour l’algorithme de Google, données structurées pour les IA et richesse sémantique pour la recherche vectorielle.

Les stratèges de contenu et marketeurs doivent désormais adopter une approche de double optimisation couvrant à la fois la recherche traditionnelle et l’indexation par l’IA. Cela implique de maintenir de solides stratégies d’optimisation par mots-clés et de netlinking pour Google tout en assurant que le contenu fasse preuve d’autorité thématique, de profondeur sémantique et de richesse contextuelle reconnues et citées par l’IA. La mise en œuvre d’un balisage de données structurées complet (Schema.org) devient essentielle, car elle aide Google et les IA à comprendre le contexte, la crédibilité et les relations des contenus — c’est particulièrement important pour les signaux E-E-A-T (Expérience, Expertise, Autorité, Fiabilité) qui influencent le classement comme la probabilité de citation. Créer du contenu approfondi et complet qui couvre entièrement les sujets devient plus précieux que jamais, car les IA sont plus susceptibles de citer des sources faisant autorité, bien documentées et contextualisées que des pages superficielles optimisées uniquement pour les mots-clés. Les organisations devraient mettre en place des outils de suivi des citations pour surveiller les mentions dans les réponses générées par l’IA, à l’image du suivi des backlinks, en comprenant que la visibilité dans les résultats IA représente une nouvelle forme de média acquis. Construire une base de connaissances ou un hub de contenu affichant une expertise claire sur des domaines spécifiques accroît la probabilité d’être reconnu comme source d’autorité par l’IA. Enfin, l’essor du Generative Engine Optimization (GEO) implique que les marketeurs doivent comprendre comment structurer le contenu, utiliser des schémas de langage naturel et renforcer les signaux d’autorité qui plaisent aussi bien aux algorithmes de classement traditionnels qu’aux mécanismes de citation IA — une approche plus nuancée et sophistiquée que le SEO classique.

La distinction entre indexation IA et indexation Google n’est pas une question de remplacement, mais une expansion fondamentale de la façon dont l’information est organisée, retrouvée et présentée. L’approche de recherche de Google reste puissante pour trouver rapidement une information précise, tandis que l’approche de prédiction de l’IA excelle dans la synthèse, le contexte et la compréhension de l’intention utilisateur. Les organisations les plus performantes seront celles qui reconnaissent cette dualité et optimisent leur contenu et leur présence digitale pour les deux systèmes à la fois. En comprenant les différences techniques entre ces approches, en mettant en œuvre des données structurées, en développant l’autorité thématique et en surveillant la visibilité sur la recherche classique et les plateformes IA, les organisations garantissent la découvrabilité et la valeur de leur contenu dans un paysage informationnel de plus en plus complexe. L’avenir de la recherche ne sera pas unique — il sera pluriel, distribué et toujours plus intelligent.

L’indexation Google est un système de recherche qui explore le web, catalogue le contenu et retourne des liens classés selon les mots-clés et les liens. L’indexation par l’IA est un système de prédiction qui encode les données d’entraînement dans des réseaux neuronaux et génère directement des réponses contextuellement pertinentes. Google se demande « où est cette information ? » tandis que l’IA se demande « quelle est la réponse la plus pertinente ? »

Les embeddings vectoriels convertissent les textes et autres données en tableaux numériques de grande dimension qui captent la signification sémantique. Ces embeddings permettent aux systèmes d’IA de comprendre que « voiture », « automobile » et « véhicule » sont sémantiquement équivalents sans correspondance explicite de mots-clés. Les concepts similaires sont représentés par des vecteurs proches dans un espace de grande dimension.

Les modèles d’IA traditionnels ont une limite de connaissance et ne peuvent pas accéder de façon fiable à l’information en temps réel. Cependant, les systèmes RAG (Retrieval-Augmented Generation) peuvent interroger des bases de données vectorielles et des sources web pour récupérer des informations actuelles avant de générer des réponses, comblant ainsi cet écart.

Le GEO est une discipline émergente qui vise à optimiser le contenu pour les réponses générées par l’IA plutôt que pour les classements de recherche traditionnels. Il met l’accent sur l’autorité thématique, les données structurées, la profondeur sémantique et la crédibilité de la marque pour augmenter les chances d’être cité par les systèmes d’IA.

La recherche par mots-clés fait correspondre les mots exacts ou similaires dans les documents. La recherche sémantique comprend la signification et l’intention derrière les requêtes, ce qui lui permet de trouver des résultats pertinents même si une terminologie différente est utilisée. Par exemple, une recherche sémantique de « smartphone » peut aussi retourner des résultats pour « appareil mobile » ou « téléphone cellulaire ».

Plutôt qu’un remplacement, l’avenir semble être la convergence. Google intègre des capacités d’IA dans sa recherche via des fonctionnalités comme AI Overviews, créant des systèmes hybrides qui combinent indexation traditionnelle et IA générative. Les organisations doivent optimiser pour les deux systèmes simultanément.

Une base de données vectorielle stocke des embeddings de grande dimension et effectue des recherches de similarité à l’aide de métriques comme la similarité cosinus. Elle est cruciale pour mettre en œuvre la recherche sémantique et le RAG, permettant aux systèmes d’IA d’accéder à l’information pertinente à grande échelle en quelques millisecondes.

Les marketeurs doivent adopter une approche de double optimisation : maintenir le SEO traditionnel pour Google tout en développant l’autorité thématique, en mettant en place des données structurées, en créant du contenu complet et en suivant les citations IA. Il faut se concentrer sur la démonstration d’expertise et de crédibilité pour être reconnu comme source d’autorité par les systèmes d’IA.

Suivez l’apparition de votre marque dans les réponses générées par l’IA sur ChatGPT, Gemini, Perplexity et Google AI Overviews. Obtenez des insights en temps réel sur vos citations et votre visibilité dans l’IA.

Découvrez comment fonctionnent les index de recherche IA, les différences entre les méthodes d’indexation de ChatGPT, Perplexity et SearchGPT, et comment optimi...

Découvrez comment les moteurs d'IA comme ChatGPT, Perplexity et Gemini indexent et traitent le contenu web grâce à des crawlers avancés, au NLP et à l'apprentis...

Découvrez comment l'indexation de recherche IA convertit les données en vecteurs consultables, permettant à des systèmes IA comme ChatGPT et Perplexity de retro...