Rendu côté serveur vs CSR : impact sur la visibilité auprès de l’IA

Découvrez comment les stratégies de rendu SSR et CSR affectent la visibilité auprès des crawlers IA, les citations de marque dans ChatGPT et Perplexity, et votr...

Découvrez pourquoi les robots IA comme ChatGPT ne voient pas le contenu rendu en JavaScript et comment rendre votre site visible aux systèmes d’IA. Explorez les stratégies de rendu pour la visibilité auprès de l’IA.

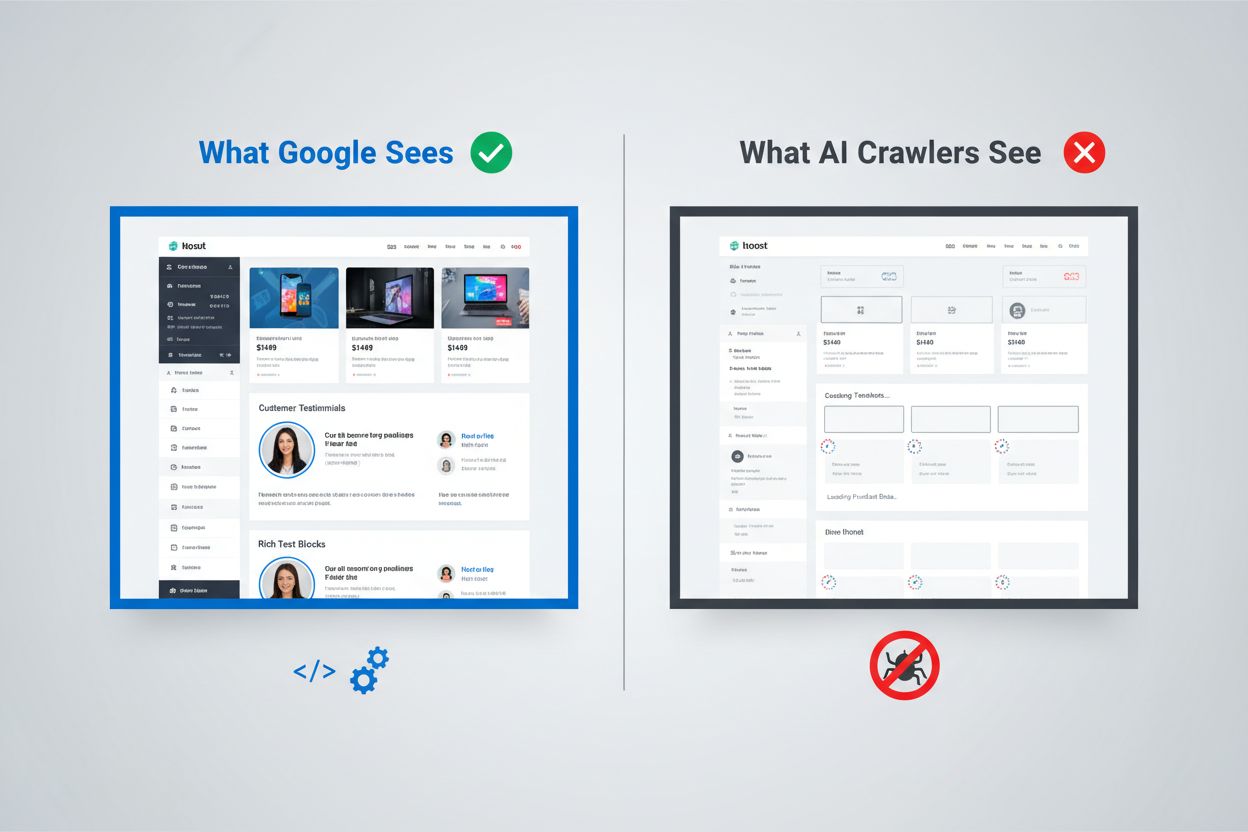

Le paysage numérique a profondément évolué, mais la plupart des organisations n’ont pas suivi le rythme. Alors que le pipeline de rendu sophistiqué de Google peut exécuter JavaScript et indexer le contenu dynamique, les robots IA comme ChatGPT, Perplexity et Claude fonctionnent selon des contraintes complètement différentes. Cela crée un véritable fossé de visibilité : un contenu qui s’affiche parfaitement pour les utilisateurs humains et même pour le moteur de recherche de Google peut rester totalement invisible pour les systèmes d’IA qui, de plus en plus, génèrent du trafic et influencent les décisions d’achat. Comprendre cette distinction n’est plus une simple curiosité technique : c’est devenu essentiel pour maintenir sa visibilité dans l’ensemble de l’écosystème numérique. Les enjeux sont importants, et les solutions sont plus subtiles que ce que la plupart des organisations imaginent.

L’approche de Google pour le rendu JavaScript est l’une des plus sophistiquées jamais conçues pour l’indexation du web. Le géant de la recherche emploie un système de rendu en deux vagues : les pages sont d’abord crawlées pour leur contenu HTML statique, puis re-rendues ultérieurement via un navigateur Chrome sans interface grâce à son Web Rendering Service (WRS). Lors de cette seconde vague, Google exécute le JavaScript, construit le DOM (Document Object Model) complet et capture l’état de la page entièrement rendue. Ce processus inclut la mise en cache du rendu, ce qui permet à Google de réutiliser les versions précédemment générées des pages pour économiser des ressources. Tout le système est conçu pour gérer la complexité des applications web modernes tout en restant capable de crawler des milliards de pages. Google investit d’énormes ressources informatiques dans cette capacité, en lançant des milliers d’instances de Chrome sans interface pour traiter le contenu riche en JavaScript du web. Pour les organisations dépendant de la recherche Google, cela signifie que leur contenu rendu côté client a une chance d’être visible — mais seulement parce que Google a construit une infrastructure exceptionnellement coûteuse pour cela.

Les robots IA fonctionnent avec des contraintes économiques et architecturales fondamentalement différentes qui rendent l’exécution de JavaScript peu pratique. Les contraintes de ressources sont la principale limitation : exécuter du JavaScript implique de lancer des moteurs de navigateur, de gérer la mémoire et de maintenir l’état entre les requêtes — autant d’opérations coûteuses à grande échelle. La plupart des robots IA opèrent avec des fenêtres de temps de 1 à 5 secondes, ce qui signifie qu’ils doivent récupérer et traiter le contenu très rapidement ou abandonner la requête. L’analyse coût-bénéfice ne favorise pas l’exécution de JavaScript pour les IA : elles peuvent traiter bien plus de contenu en se limitant au HTML statique qu’en rendant chaque page rencontrée. De plus, la chaîne de traitement des données pour l’entraînement des grands modèles de langage retire généralement CSS et JavaScript lors de l’ingestion, se concentrant uniquement sur le contenu HTML sémantique. La philosophie architecturale est donc fondamentalement différente : Google a intégré le rendu dans son système d’indexation car la pertinence de la recherche dépend de la compréhension du contenu rendu, tandis que les systèmes IA privilégient l’étendue de couverture à la profondeur de rendu. Ce n’est pas une limitation qui disparaîtra facilement — elle est inscrite dans l’économie fondamentale de ces systèmes.

Lorsque les robots IA demandent une page, ils reçoivent le fichier HTML brut sans aucune exécution de JavaScript, ce qui signifie souvent qu’ils voient une version très différente du contenu par rapport aux utilisateurs humains. Les applications monopage (SPA) construites avec React, Vue ou Angular sont particulièrement problématiques car elles fournissent généralement un HTML minimal et s’appuient entièrement sur JavaScript pour remplir le contenu de la page. Un robot IA qui demande un site e-commerce en React pourrait recevoir du HTML ne contenant que des balises <div id="root"></div> vides, sans informations produits, prix ou descriptions. Le robot voit le squelette de la page, mais pas la substance. Pour les sites riches en contenu, cela signifie que les catalogues produits, articles de blog, tableaux de prix et sections dynamiques n’existent tout simplement pas dans la vue du robot IA. Les exemples concrets abondent : le tableau comparatif des fonctionnalités d’une plateforme SaaS peut être totalement invisible, les recommandations produits d’un e-commerce non indexées, et les articles chargés dynamiquement d’un site d’actualité apparaître comme des pages vierges. Le HTML reçu par les robots IA n’est souvent que la coquille de l’application — le contenu réel se trouve dans des bundles JavaScript qui ne sont jamais exécutés. On se retrouve ainsi avec une page qui s’affiche parfaitement dans un navigateur mais qui paraît presque vide aux systèmes d’IA.

L’impact business de cet écart de rendu va bien au-delà de la technique et touche directement le chiffre d’affaires, la visibilité et le positionnement concurrentiel. Si les robots IA ne voient pas votre contenu, plusieurs fonctions business clés en pâtissent :

En cumulé, les organisations qui investissent massivement dans le contenu et l’expérience utilisateur risquent de devenir invisibles auprès d’une classe d’utilisateurs et de systèmes de plus en plus cruciale. Ce problème ne se résout pas tout seul — il nécessite une action délibérée.

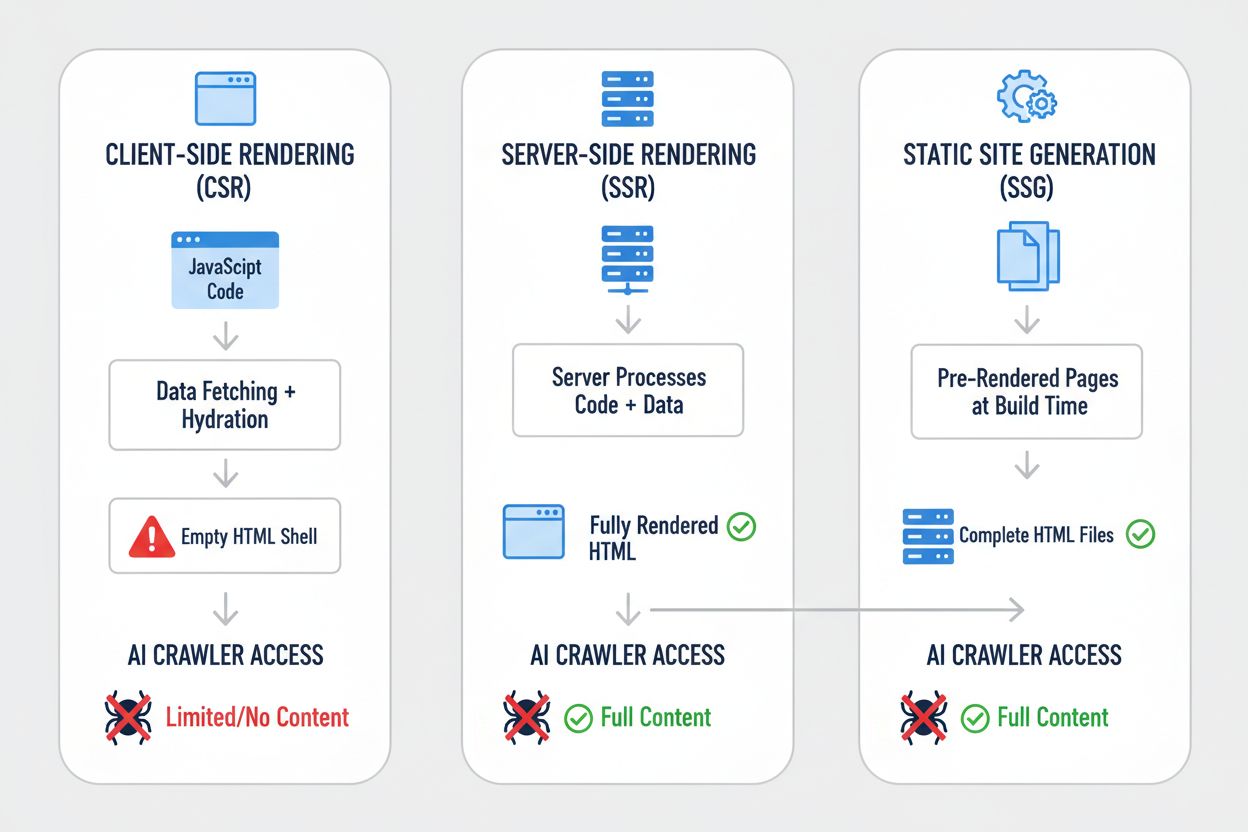

Différentes stratégies de rendu donnent des résultats radicalement différents du point de vue de la visibilité pour les robots IA. Le choix de la stratégie de rendu détermine fondamentalement ce que les systèmes IA peuvent voir et indexer. Voici comment se comparent les principales stratégies :

| Stratégie | Ce que voit l’IA | Impact sur la visibilité IA | Complexité | Idéal pour |

|---|---|---|---|---|

| Rendu côté serveur (SSR) | HTML complet avec tout le contenu rendu | Visibilité totale — l’IA voit tout | Élevée | Sites riches en contenu, applis critiques pour le SEO |

| Génération de site statique (SSG) | Fichiers HTML pré-rendus | Excellente visibilité — contenu en HTML statique | Moyenne | Blogs, documentation, sites marketing |

| Rendu côté client (CSR) | Coquille HTML vide, contenu minimal | Visibilité faible — l’IA ne voit que le squelette | Faible | Tableaux de bord temps réel, outils interactifs |

| Hybride (SSR + CSR) | HTML initial + enrichissements côté client | Bonne visibilité — contenu principal visible | Très élevée | Applications complexes à contenu dynamique |

| Service de pré-rendu | HTML rendu en cache | Bonne visibilité — selon la qualité du service | Moyenne | Sites CSR existants à corriger rapidement |

| API-first + balisage | Données structurées + contenu HTML | Excellente visibilité — si bien mis en œuvre | Élevée | Applications web modernes, CMS headless |

Chaque stratégie représente un compromis entre complexité de développement, performance, expérience utilisateur et visibilité IA. L’essentiel à retenir est que la visibilité auprès des systèmes IA dépend fortement de la présence du contenu dans le HTML statique — que ce HTML soit généré à la construction, à la volée ou servi depuis un cache. Les organisations doivent évaluer leur stratégie de rendu non seulement pour l’expérience utilisateur ou la performance, mais explicitement pour la visibilité auprès des robots IA.

Le rendu côté serveur (SSR) est la référence pour la visibilité IA car il fournit un HTML complet et rendu à chaque requête — aussi bien pour les navigateurs que pour les robots IA. Avec SSR, le serveur exécute votre code applicatif et génère la réponse HTML complète avant de l’envoyer au client, ce qui permet aux robots IA de recevoir la page complètement rendue dès la première requête. Les frameworks modernes comme Next.js, Nuxt.js et SvelteKit rendent le SSR bien plus accessible qu’avant, gérant la complexité de l’hydratation (là où le JavaScript côté client prend le relais du HTML rendu côté serveur) de façon transparente. Les bénéfices dépassent la simple visibilité IA : le SSR améliore généralement les Core Web Vitals, réduit le Time to First Contentful Paint et offre de meilleures performances pour les connexions lentes. Le revers de la médaille est une charge serveur accrue et une gestion plus complexe de l’état entre serveur et client. Pour les organisations où la visibilité IA est cruciale — sites riches en contenu, plateformes e-commerce, applications SaaS — le SSR est souvent le choix le plus défendable. L’investissement dans une infrastructure SSR porte ses fruits sur de nombreux plans : meilleure visibilité sur les moteurs, meilleure visibilité IA, meilleure expérience utilisateur et meilleurs indicateurs de performance.

La génération de site statique (SSG) adopte une autre approche en pré-rendant les pages à la construction, générant des fichiers HTML statiques pouvant être servis instantanément à tout demandeur. Des outils comme Hugo, Gatsby et Astro rendent le SSG de plus en plus puissant et flexible, prenant en charge le contenu dynamique via des API ou la régénération statique incrémentale. Quand un robot IA demande une page générée avec SSG, il reçoit un HTML complet, statique, avec tout le contenu rendu — visibilité parfaite. Les gains de performance sont exceptionnels : les fichiers statiques se servent plus vite que tout rendu dynamique, et les besoins infrastructurels sont minimes. La limite, c’est que le SSG fonctionne mieux pour du contenu qui change peu : les pages doivent être reconstruites et redéployées lors des mises à jour. Pour les blogs, sites de documentation, pages marketing et applications à fort contenu, le SSG est souvent optimal. La combinaison d’une excellente visibilité IA, de performances superbes et d’exigences infrastructurelles minimales rend le SSG très attractif. Cependant, pour les applications nécessitant de la personnalisation en temps réel ou du contenu fréquemment mis à jour, le SSG devient vite moins pratique sans ajouter de la complexité comme la régénération statique incrémentale.

Le rendu côté client (CSR) reste populaire malgré ses inconvénients majeurs pour la visibilité IA, principalement parce qu’il offre la meilleure expérience développeur et la plus grande flexibilité utilisateur pour les applications très interactives. Avec le CSR, le serveur envoie un HTML minimal et compte sur JavaScript pour construire la page dans le navigateur — ce qui signifie que les robots IA ne voient presque rien. Les applications React, Vue et Angular sont généralement en CSR par défaut, et beaucoup d’organisations ont bâti toute leur stack sur ce pattern. L’attrait est compréhensible : le CSR permet des expériences riches, interactives, des mises à jour en temps réel et une navigation fluide côté client. Le problème, c’est que cette flexibilité se paie par une perte de visibilité IA. Pour les applications nécessitant absolument du CSR — tableaux de bord temps réel, outils collaboratifs, applications interactives complexes — il existe des alternatives. Des services de pré-rendu comme Prerender.io peuvent générer des instantanés HTML statiques de pages CSR et les servir aux robots tout en proposant la version interactive aux navigateurs. Ou bien, on peut opter pour des approches hybrides où le contenu critique est rendu côté serveur, les fonctionnalités interactives restant côté client. L’essentiel est que le CSR doit être un choix délibéré fait en connaissance de cause sur les compromis de visibilité, pas une simple option par défaut.

Mettre en œuvre des solutions pratiques suppose une démarche systématique, qui commence par comprendre l’état actuel et va jusqu’à l’implémentation puis la surveillance continue. Commencez par un audit : utilisez des outils comme Screaming Frog, Semrush ou des scripts personnalisés pour crawler votre site comme le ferait un robot IA et vérifiez quel contenu est réellement visible dans le HTML brut. Mettez en place les améliorations de rendu selon les résultats de votre audit — cela peut impliquer une migration vers le SSR, l’adoption du SSG pour certaines sections ou la mise en place du pré-rendu pour les pages critiques. Testez soigneusement en comparant ce que voient les robots IA et ce que voient les navigateurs : utilisez des commandes curl pour récupérer le HTML brut et comparez-le à la version rendue. Surveillez en continu pour vous assurer que les changements de rendu ne cassent pas la visibilité dans le temps. Pour les grands sites complexes, il peut être judicieux de prioriser d’abord les pages à forte valeur (produits, tarifs, contenu clé), avant d’élargir à l’ensemble du site. Des outils comme Lighthouse, PageSpeed Insights et des solutions de suivi personnalisées permettent de suivre les performances de rendu et les indicateurs de visibilité. L’investissement dans une bonne gestion du rendu est rentable pour la visibilité dans la recherche, la visibilité auprès des IA, et la performance globale du site.

Tester et surveiller votre stratégie de rendu nécessite des techniques spécifiques pour révéler ce que voient réellement les robots IA. Le test le plus simple consiste à utiliser curl pour récupérer le HTML brut sans exécution de JavaScript :

curl -s https://example.com | grep -i "product\|price\|description"

Cela vous montre exactement ce que reçoit un robot IA : si votre contenu clé n’apparaît pas dans ce résultat, il ne sera pas visible pour les systèmes IA. Des tests dans le navigateur avec Chrome DevTools permettent de voir la différence entre le HTML initial et le DOM complètement rendu ; ouvrez DevTools, allez dans l’onglet Réseau et comparez la réponse HTML initiale à l’état final rendu. Pour une surveillance continue, mettez en place un monitoring synthétique qui récupère régulièrement vos pages comme le ferait un robot IA et vous alerte si la visibilité du contenu se dégrade. Suivez des métriques comme « pourcentage de contenu visible dans le HTML initial » et « temps jusqu’à la visibilité du contenu » pour comprendre vos performances de rendu. Certaines organisations mettent en place des tableaux de bord personnalisés qui comparent la visibilité IA entre concurrents, fournissant de la veille sur qui optimise pour l’IA et qui ne le fait pas. L’essentiel est de rendre ce suivi continu et actionnable : les problèmes de visibilité doivent être détectés et corrigés rapidement, pas découverts des mois plus tard suite à une chute de trafic inexpliquée.

L’avenir des capacités de rendu JavaScript par les robots IA reste incertain, mais il est peu probable que les limites actuelles changent radicalement à court terme. OpenAI a expérimenté des robots plus sophistiqués comme les navigateurs Comet et Atlas capables d’exécuter du JavaScript, mais cela reste expérimental et n’est pas déployé à grande échelle pour la collecte des données d’entraînement. Les fondamentaux économiques n’ont pas changé : exécuter du JavaScript massivement reste coûteux, et la chaîne d’ingestion des données profite toujours davantage de la quantité que de la profondeur. Même si les robots IA finissent par exécuter du JavaScript, l’optimisation que vous faites aujourd’hui ne sera pas vaine : le contenu rendu côté serveur offre de meilleures performances utilisateur, se charge plus vite et bénéficie du SEO dans tous les cas. La meilleure approche est donc d’optimiser dès maintenant pour la visibilité IA plutôt que d’attendre des progrès hypothétiques des robots. Cela implique de traiter la visibilité IA comme une préoccupation centrale de votre stratégie de rendu, pas comme un sujet secondaire. Les organisations qui opèrent ce virage dès aujourd’hui auront un avantage concurrentiel à mesure que les systèmes IA deviennent essentiels pour le trafic et la visibilité.

Surveiller votre visibilité IA et suivre les progrès dans le temps nécessite les bons outils et indicateurs. AmICited.com offre une solution pratique pour suivre la façon dont votre contenu apparaît dans les réponses générées par l’IA et surveiller votre visibilité à travers différents systèmes IA. En suivant quelles pages sont citées, reprises ou référencées dans le contenu généré par l’IA, vous pouvez mesurer concrètement l’impact de vos optimisations de rendu. La plateforme vous aide à identifier quel contenu est visible des systèmes IA et quel contenu reste invisible, vous fournissant ainsi des données tangibles sur l’efficacité de votre stratégie de rendu. À mesure que vous implémentez SSR, SSG ou des solutions de pré-rendu, AmICited.com vous permet de mesurer l’amélioration réelle de la visibilité IA — pour voir si vos efforts d’optimisation se traduisent par plus de citations et de références. Cette boucle de retour est essentielle pour justifier l’investissement dans l’amélioration du rendu et identifier les pages à optimiser en priorité. En combinant le suivi technique de ce que voient les robots IA et des indicateurs business sur la fréquence d’apparition de votre contenu dans les réponses IA, vous obtenez une vision complète de la performance de votre visibilité IA.

Non, ChatGPT et la plupart des robots IA ne peuvent pas exécuter du JavaScript. Ils ne voient que le HTML brut lors du chargement initial de la page. Tout contenu injecté via JavaScript après le chargement reste totalement invisible pour les systèmes d’IA, contrairement à Google qui utilise des navigateurs Chrome sans interface pour rendre le JavaScript.

Google utilise des navigateurs Chrome sans interface pour rendre le JavaScript, comme le ferait un vrai navigateur. C’est gourmand en ressources mais Google dispose de l’infrastructure pour le faire à grande échelle. Son système de rendu en deux vagues commence par crawler le HTML statique, puis ré-exécute les pages avec JavaScript pour capturer le DOM complet.

Désactivez JavaScript dans votre navigateur et chargez votre site, ou utilisez la commande curl pour voir le HTML brut. Si du contenu clé manque, les robots IA ne le verront pas non plus. Vous pouvez aussi utiliser des outils comme Screaming Frog en mode « Texte seulement » pour crawler votre site comme le ferait un robot IA.

Non. Vous pouvez aussi utiliser la génération de site statique, des services de pré-rendu ou des approches hybrides. La meilleure solution dépend du type de contenu et de la fréquence de mise à jour. Le SSR convient bien au contenu dynamique, le SSG au contenu stable, et les services de pré-rendu aux sites CSR existants.

Google gère le JavaScript, donc votre classement ne devrait pas être directement impacté. Cependant, optimiser pour les robots IA améliore souvent la qualité globale du site, sa performance et l’expérience utilisateur, ce qui peut indirectement bénéficier à votre classement Google.

Cela dépend de la fréquence de crawl de la plateforme IA. ChatGPT-User crawle à la demande lors des requêtes, alors que GPTBot le fait rarement avec de longs intervalles. Les changements peuvent prendre des semaines à apparaître dans les réponses IA, mais vous pouvez suivre la progression avec des outils comme AmICited.com.

Les services de pré-rendu sont plus faciles à mettre en place et à maintenir avec peu de changements de code, tandis que le SSR offre plus de contrôle et de meilleures performances pour le contenu dynamique. Choisissez en fonction de vos ressources techniques, de la fréquence de mise à jour du contenu et de la complexité de votre application.

Oui, vous pouvez utiliser robots.txt pour bloquer des robots IA spécifiques comme GPTBot. Mais votre contenu n’apparaîtra alors pas dans les réponses générées par l’IA, ce qui peut réduire la visibilité et le trafic issus des outils et assistants de recherche alimentés par l’IA.

Suivez la façon dont les systèmes d’IA référencent votre marque sur ChatGPT, Perplexity et Google AI Overviews. Identifiez les lacunes de visibilité et mesurez l’impact de vos optimisations de rendu.

Découvrez comment les stratégies de rendu SSR et CSR affectent la visibilité auprès des crawlers IA, les citations de marque dans ChatGPT et Perplexity, et votr...

Découvrez comment le prérendu rend le contenu JavaScript visible pour les robots d’IA comme ChatGPT, Claude et Perplexity. Découvrez les meilleures solutions te...

Découvrez comment le JavaScript influence la visibilité des robots d’IA. Comprenez pourquoi les bots d’IA ne peuvent pas rendre le JavaScript, quel contenu est ...