Rendu JavaScript pour l’IA

Découvrez comment le rendu JavaScript impacte la visibilité sur l’IA. Comprenez pourquoi les robots d’IA ne peuvent pas exécuter JavaScript, quels contenus sont...

Découvrez comment le prérendu rend le contenu JavaScript visible pour les robots d’IA comme ChatGPT, Claude et Perplexity. Découvrez les meilleures solutions techniques pour l’optimisation de la recherche IA et améliorez votre visibilité dans les résultats de recherche alimentés par l’IA.

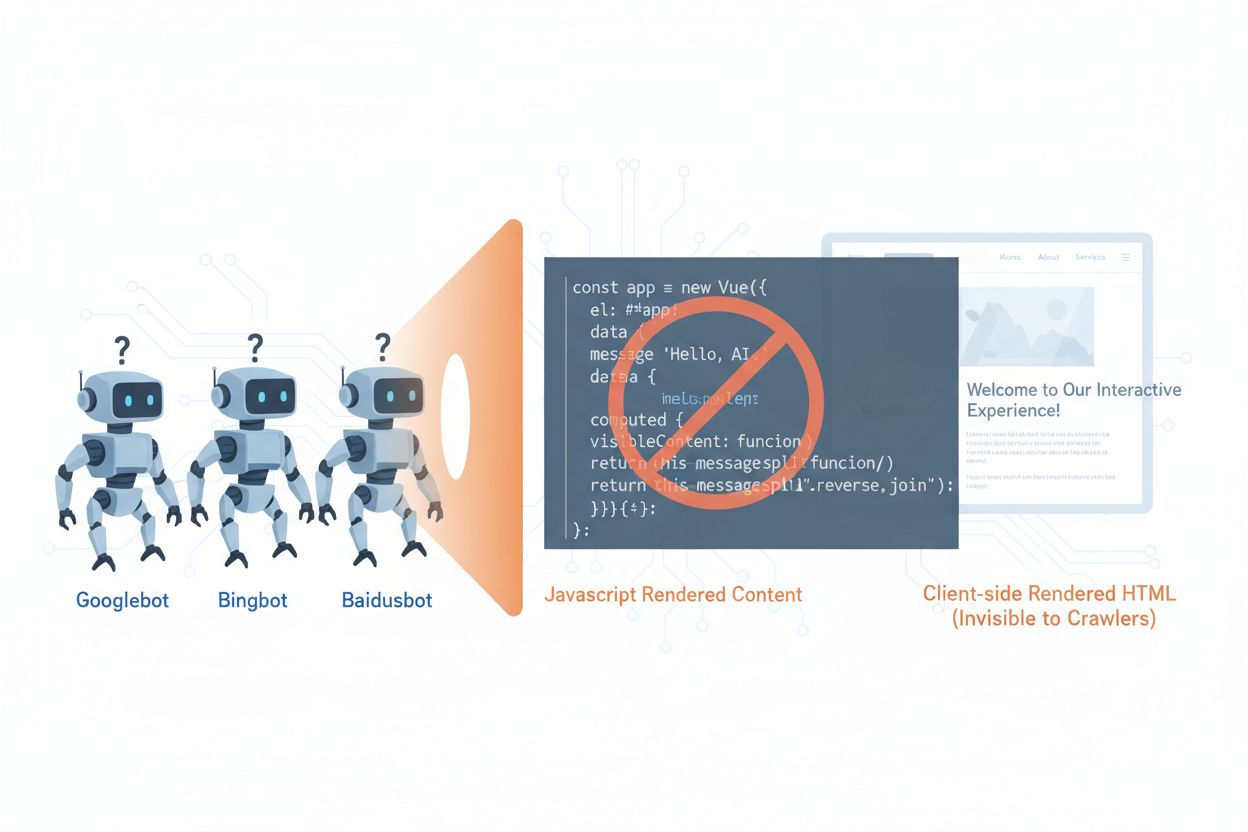

Les robots d’IA tels que GPTBot, ClaudeBot et PerplexityBot ont fondamentalement changé la façon dont le contenu est découvert et indexé sur le web, mais ils font face à une limitation critique : ils ne peuvent pas exécuter JavaScript. Cela signifie que tout contenu rendu dynamiquement via JavaScript—qui alimente les applications monopages modernes (SPA), les pages produits dynamiques et les tableaux de bord interactifs—reste totalement invisible pour ces robots. Selon des données récentes, les robots d’IA représentent désormais environ 28 % du trafic de Googlebot, ce qui en fait une part significative du budget de crawl de votre site et un facteur crucial pour l’accessibilité du contenu. Lorsqu’un robot d’IA demande une page, il reçoit la coquille HTML initiale sans le contenu rendu, voyant ainsi une version vide ou incomplète de votre site. Cela crée un paradoxe : votre contenu est parfaitement visible pour les utilisateurs humains disposant de navigateurs compatibles JavaScript, mais invisible pour les systèmes d’IA qui influencent de plus en plus la découverte, la synthèse et le classement du contenu dans les moteurs de recherche et applications alimentés par l’IA.

Les raisons techniques des limitations des robots d’IA face à JavaScript découlent de différences architecturales fondamentales entre la façon dont les navigateurs et les robots traitent le contenu web. Les navigateurs disposent d’un moteur JavaScript complet qui exécute le code, manipule le DOM (Document Object Model) et affiche le rendu final, tandis que les robots d’IA fonctionnent généralement avec peu ou pas de capacité d’exécution JavaScript, en raison de contraintes de ressources et de considérations de sécurité. Le chargement asynchrone—où le contenu est récupéré via des API après le chargement initial de la page—pose un autre défi majeur, car les robots ne reçoivent que l’HTML initial, avant l’arrivée du contenu. Les applications monopages (SPA) aggravent ce problème en reposant entièrement sur le routage et le rendu côté client, laissant aux robots uniquement un bundle JavaScript. Voici comment différents modes de rendu se comparent en termes de visibilité pour les robots d’IA :

| Méthode de rendu | Fonctionnement | Visibilité robot IA | Performance | Coût |

|---|---|---|---|---|

| CSR (rendu côté client) | Le navigateur exécute JavaScript pour afficher le contenu | ❌ Faible | Rapide pour les utilisateurs | Faible infrastructure |

| SSR (rendu côté serveur) | Le serveur génère le HTML à chaque requête | ✅ Excellente | Chargement initial plus lent | Infrastructure élevée |

| SSG (génération statique) | Contenu préconstruit au moment du build | ✅ Excellente | La plus rapide | Moyen (temps de build) |

| Prérendu | HTML statique mis en cache à la demande | ✅ Excellente | Rapide | Moyen (équilibré) |

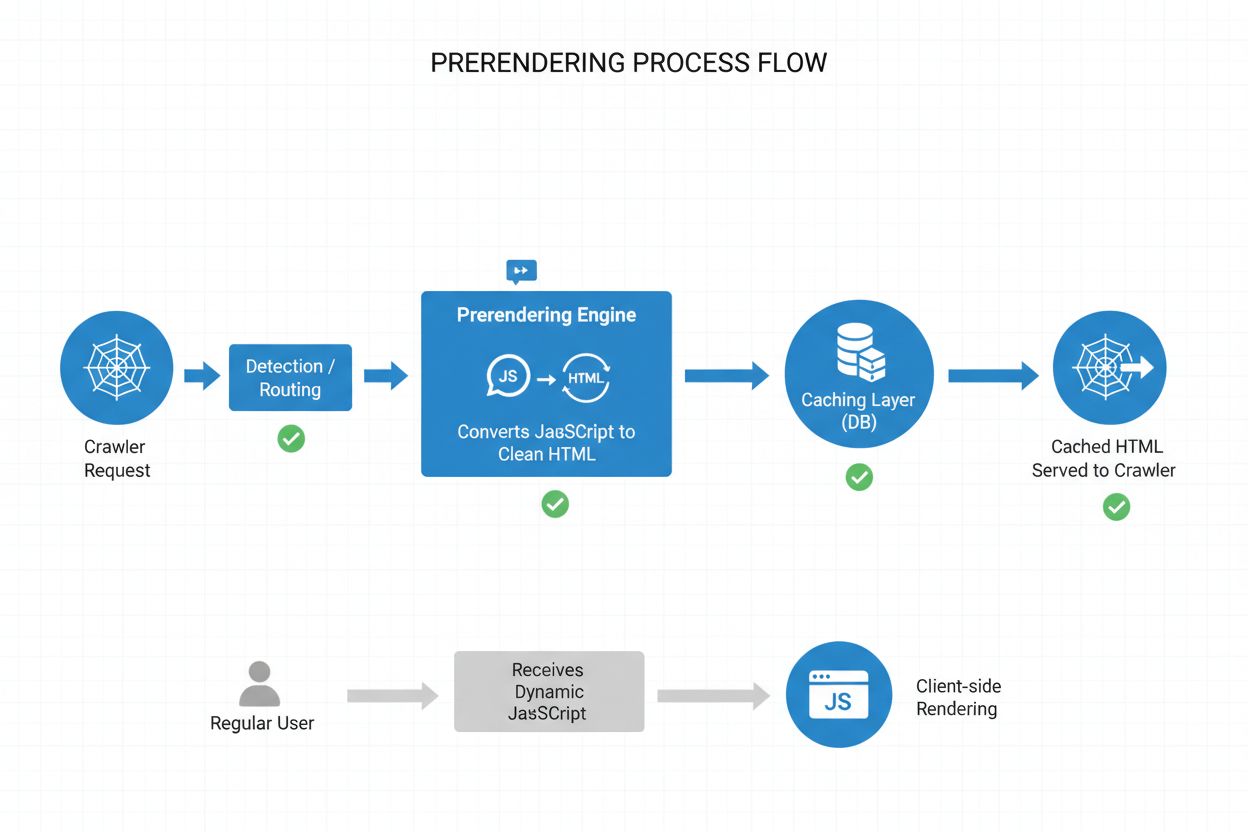

Le prérendu offre une solution élégante entre les exigences gourmandes en ressources du rendu côté serveur et les limitations du build du site statique. Au lieu de rendre le contenu à chaque requête (SSR) ou lors du build (SSG), le prérendu génère des instantanés HTML statiques à la demande lorsqu’un robot ou un bot demande une page, puis met en cache cette version pour les requêtes suivantes. Ainsi, les robots d’IA reçoivent un HTML entièrement rendu et statique contenant tout le contenu normalement généré par JavaScript, tandis que les utilisateurs continuent de recevoir la version dynamique et interactive de votre site, sans aucun changement dans leur expérience. Le prérendu est particulièrement économique, car il ne rend que les pages effectivement demandées par les robots, évitant la surcharge de pré-rendre tout le site ou de maintenir une infrastructure SSR coûteuse. La maintenance est minimale : votre code applicatif reste inchangé et la couche de prérendu fonctionne de manière transparente en arrière-plan, ce qui en fait une solution idéale pour les équipes souhaitant l’accessibilité aux robots IA sans refonte architecturale.

Le processus de prérendu fonctionne selon un flux sophistiqué mais simple, garantissant que les robots d’IA reçoivent un contenu optimisé tandis que les utilisateurs ne subissent aucune perturbation. Lorsqu’une requête arrive sur votre serveur, le système commence par détecter l’agent utilisateur pour identifier s’il s’agit d’un robot d’IA (GPTBot, ClaudeBot, PerplexityBot) ou d’un navigateur classique. Si un robot d’IA est détecté, la requête est redirigée vers le moteur de prérendu, qui lance une instance de navigateur sans interface, exécute tout le JavaScript, attend le chargement du contenu asynchrone et génère un instantané HTML statique complet de la page rendue. Cet HTML est alors mis en cache (généralement pour 24 à 48 heures) et servi directement au robot, en contournant totalement votre application et en allégeant la charge serveur. Pendant ce temps, les requêtes de navigateurs classiques contournent entièrement la couche de prérendu et reçoivent votre application dynamique habituelle, garantissant aux utilisateurs une expérience interactive complète avec mises à jour en temps réel et fonctionnalités dynamiques. L’ensemble du processus est transparent : les robots voient un contenu parfaitement rendu, les utilisateurs voient votre application inchangée et votre infrastructure reste efficace puisque le prérendu ne s’active que pour le trafic des bots.

Bien que le prérendu et le rendu côté serveur (SSR) résolvent tous deux le problème de visibilité du JavaScript, ils diffèrent considérablement en termes d’implémentation, de coût et d’évolutivité. Le SSR rend le contenu à chaque requête, ce qui oblige le serveur à lancer un moteur JavaScript, exécuter tout votre code applicatif et générer du HTML pour chaque visiteur—un processus qui devient prohibitif à grande échelle et peut augmenter le Time To First Byte (TTFB) pour tous les utilisateurs. Le prérendu, à l’inverse, met en cache les pages rendues et ne les régénère que lorsque le contenu change ou que le cache expire, réduisant considérablement la charge serveur et améliorant les temps de réponse pour les robots comme pour les utilisateurs. Le SSR est indiqué pour les contenus très personnalisés ou fréquemment mis à jour nécessitant un HTML unique pour chaque utilisateur, tandis que le prérendu excelle pour les contenus relativement statiques ou peu fréquemment modifiés—pages produits, articles de blog, documentation, pages marketing. De nombreuses implémentations sophistiquées adoptent une approche hybride : prérendu pour les robots IA et le contenu statique, SSR pour les expériences utilisateur personnalisées, et rendu côté client pour les fonctionnalités interactives. Cette stratégie en couches offre le meilleur des deux mondes : excellente accessibilité pour les robots IA, performance rapide pour les utilisateurs et coûts d’infrastructure raisonnables.

Les données structurées au format JSON-LD sont essentielles pour aider les robots d’IA à comprendre la signification et le contexte de votre contenu, mais la plupart des implémentations n’intègrent pas les limites des robots d’IA. Lorsque les données structurées sont injectées dans la page via JavaScript—pratique courante avec Google Tag Manager et les systèmes de gestion de balises similaires—les robots d’IA ne les voient jamais car ils n’exécutent pas le JavaScript qui crée ces structures de données. Cela signifie que les rich snippets, les informations produits, les détails d’organisation et autres balisages sémantiques restent invisibles pour les systèmes d’IA, même s’ils sont parfaitement visibles pour les moteurs de recherche traditionnels qui ont évolué pour gérer le JavaScript. La solution est simple : assurez-vous que toutes les données structurées critiques figurent dans le HTML généré côté serveur, et non injectées via JavaScript. Cela peut impliquer de déplacer les blocs JSON-LD de votre tag manager vers le template côté serveur de votre application, ou d’utiliser le prérendu pour capturer les données structurées injectées par JavaScript et les servir en HTML statique aux robots. Les robots d’IA s’appuient fortement sur les données structurées pour extraire des faits, des relations et des informations d’entités, ce qui rend la mise en œuvre côté serveur essentielle pour l’intégration aux moteurs de recherche IA et aux graphes de connaissances.

La mise en œuvre du prérendu nécessite une approche stratégique qui équilibre couverture, coût et maintenance. Suivez ces étapes pour démarrer :

Identifiez les pages riches en JavaScript : Auditez votre site pour repérer les pages où le contenu critique est rendu par JavaScript—généralement les SPA, pages produits dynamiques et tableaux de bord interactifs. Utilisez des outils comme Lighthouse ou une inspection manuelle pour repérer les pages où le HTML initial diffère du rendu final.

Choisissez un service de prérendu : Sélectionnez un fournisseur de prérendu comme Prerender.io, qui gère le rendu via navigateur sans interface, la mise en cache et la détection des robots. Évaluez selon le prix, la durée du cache, la fiabilité de l’API et la compatibilité avec votre stack technique.

Configurez la détection des agents utilisateurs : Paramétrez votre serveur ou CDN pour détecter les agents utilisateurs des robots d’IA (GPTBot, ClaudeBot, PerplexityBot, Bingbot, Googlebot) et les rediriger vers le service de prérendu tout en laissant passer normalement les navigateurs classiques.

Testez et validez : Utilisez des outils comme curl avec des agents utilisateurs personnalisés pour vérifier que les robots reçoivent du HTML entièrement rendu. Testez avec de vrais agents utilisateurs de robots IA pour garantir la visibilité du contenu et la présence des données structurées.

Surveillez les résultats : Mettez en place des logs et des outils d’analyse pour suivre l’efficacité du prérendu, les taux de cache et les éventuels échecs de rendu. Surveillez le tableau de bord de votre service de prérendu pour les métriques de performance et les erreurs.

La surveillance efficace est essentielle pour garantir que votre implémentation de prérendu fonctionne correctement et que les robots d’IA peuvent accéder à votre contenu. L’analyse des logs est votre outil principal : examinez les logs serveur pour identifier les requêtes des agents utilisateurs des robots d’IA, suivez les pages qu’ils consultent et repérez les tendances ou erreurs dans le comportement de crawl. La plupart des services de prérendu comme Prerender.io fournissent des tableaux de bord affichant les taux de cache, les métriques de succès/échec de rendu et les statistiques de performance, vous offrant une visibilité sur l’efficacité de votre contenu prérendu. Les métriques clés à suivre incluent le taux de cache (pourcentage de requêtes servies depuis le cache), le taux de succès de rendu (pourcentage de pages rendues sans erreur), le temps moyen de rendu et le volume de trafic des robots. Configurez des alertes pour les échecs de rendu ou des comportements de crawl inhabituels qui pourraient signaler des problèmes avec votre JavaScript ou contenu dynamique. En corrélant les métriques de prérendu avec votre trafic des moteurs de recherche IA et la visibilité du contenu, vous pouvez quantifier l’impact de votre implémentation et identifier des pistes d’optimisation.

Le succès du prérendu exige de la rigueur et une maintenance continue. Évitez ces erreurs fréquentes :

Ne prérendez pas les pages 404 : Paramétrez votre service de prérendu pour ignorer les pages qui retournent un code 404, car mettre en cache des pages d’erreur gaspille des ressources et brouille la structure de votre site pour les robots.

Assurez la fraîcheur du contenu : Définissez des durées d’expiration de cache adaptées à la fréquence de mise à jour de votre contenu. Les pages à fort trafic et mises à jour fréquentes peuvent nécessiter des fenêtres de 12 à 24 heures, tandis que le contenu statique peut bénéficier de durées plus longues.

Surveillez en continu : Ne mettez pas en place le prérendu pour l’oublier. Vérifiez régulièrement que les pages se rendent correctement, que les données structurées sont présentes et que les robots reçoivent le contenu attendu.

Évitez le cloaking : Ne servez jamais un contenu différent aux robots et aux utilisateurs—cela viole les directives des moteurs de recherche et nuit à la confiance. Le prérendu doit montrer aux robots le même contenu que voient les utilisateurs, simplement sous forme statique.

Testez avec de vrais robots : Utilisez de vrais agents utilisateurs de robots d’IA dans vos tests, pas seulement des identifiants de bots génériques. Différents robots peuvent avoir des exigences ou limitations de rendu spécifiques.

Gardez le contenu à jour : Si votre contenu prérendu devient obsolète, les robots indexeront des informations dépassées. Mettez en place des stratégies d’invalidation du cache pour rafraîchir les pages prérendues lors des changements de contenu.

L’importance de l’optimisation pour les robots d’IA ne fera que croître à mesure que ces systèmes deviennent centraux dans la découverte et l’extraction de connaissances. Si les robots d’IA actuels ont des capacités limitées d’exécution JavaScript, des technologies émergentes comme Comet et les navigateurs Atlas laissent penser que les robots futurs disposeront de capacités de rendu plus sophistiquées, même si le prérendu restera précieux pour des raisons de performance et de fiabilité. En mettant en œuvre le prérendu dès maintenant, vous ne résolvez pas seulement le problème actuel des robots d’IA—vous pérennisez votre contenu face à l’évolution des capacités des robots et garantissez l’accessibilité de votre site quelle que soit la progression des systèmes d’IA. La convergence du SEO traditionnel et de l’optimisation pour robots IA implique qu’il faut adopter une approche globale : optimiser pour les humains et pour l’IA, garantir l’accessibilité de votre contenu sous plusieurs formats, et rester flexible pour s’adapter à l’évolution du paysage. Le prérendu représente une solution pragmatique et scalable qui fait le lien entre les applications modernes riches en JavaScript et les exigences d’accessibilité des systèmes de recherche et de découverte alimentés par l’IA, et constitue un élément essentiel de toute stratégie SEO et contenu tournée vers l’avenir.

Le prérendu génère des instantanés HTML statiques à la demande et les met en cache, tandis que le rendu côté serveur (SSR) rend le contenu à chaque requête. Le prérendu est plus rentable et évolutif pour la plupart des cas d’utilisation, alors que le SSR est préférable pour les contenus très personnalisés ou fréquemment mis à jour nécessitant un HTML unique pour chaque utilisateur.

Non, le prérendu n’affecte que la façon dont les robots voient votre contenu. Les utilisateurs réguliers continuent d’accéder à votre application JavaScript dynamique et interactive exactement comme avant. Le prérendu fonctionne de manière transparente en arrière-plan et n’a aucun impact sur la fonctionnalité ou la performance côté utilisateur.

Les durées d’expiration du cache dépendent de la fréquence de mise à jour de votre contenu. Les pages à fort trafic avec des mises à jour fréquentes peuvent nécessiter des fenêtres de cache de 12 à 24 heures, tandis que le contenu statique peut utiliser des durées plus longues. La plupart des services de prérendu vous permettent de configurer les temps de cache par page ou par modèle.

Oui, le prérendu fonctionne bien avec du contenu dynamique. Vous pouvez définir des durées d’expiration du cache plus courtes pour les pages qui changent fréquemment, ou mettre en place des stratégies d’invalidation du cache pour actualiser les pages prérendues lors des mises à jour de contenu. Cela garantit que les robots voient toujours un contenu relativement frais.

Les principaux robots d’IA pour lesquels il faut optimiser sont GPTBot (ChatGPT), ClaudeBot (Claude) et PerplexityBot (Perplexity). Vous devez également continuer à optimiser pour les robots traditionnels comme Googlebot et Bingbot. La plupart des services de prérendu permettent la configuration pour tous les principaux robots d’IA et de recherche.

Si vous utilisez déjà le SSR, l’accessibilité de votre contenu pour les robots d’IA est bonne. Cependant, le prérendu peut encore offrir des avantages en réduisant la charge sur le serveur, en améliorant la performance et en apportant une couche de cache qui rend votre infrastructure plus efficace et scalable.

Surveillez le tableau de bord de votre service de prérendu pour les taux de succès de cache, les métriques de rendu et les statistiques de performance. Consultez les journaux de votre serveur pour les requêtes des robots d’IA et vérifiez qu’ils reçoivent du HTML entièrement rendu. Suivez l’évolution de votre visibilité dans la recherche IA et des citations de contenu au fil du temps.

Les coûts du prérendu varient selon le service et le volume d’utilisation. La plupart des fournisseurs proposent des tarifs en fonction du nombre de pages rendues par mois. Les coûts sont généralement bien inférieurs à ceux du maintien d’une infrastructure de rendu côté serveur, ce qui fait du prérendu une solution rentable pour la majorité des sites web.

Suivez comment les plateformes d’IA comme ChatGPT, Claude et Perplexity référencent votre contenu avec AmICited. Obtenez des informations en temps réel sur votre visibilité dans la recherche IA et optimisez votre stratégie de contenu.

Découvrez comment le rendu JavaScript impacte la visibilité sur l’IA. Comprenez pourquoi les robots d’IA ne peuvent pas exécuter JavaScript, quels contenus sont...

Découvrez comment le JavaScript influence la visibilité des robots d’IA. Comprenez pourquoi les bots d’IA ne peuvent pas rendre le JavaScript, quel contenu est ...

Découvrez comment les stratégies de rendu SSR et CSR affectent la visibilité auprès des crawlers IA, les citations de marque dans ChatGPT et Perplexity, et votr...