Fiche de Référence des Crawlers IA : Tous les Bots en un Coup d’Œil

Guide complet de référence des crawlers IA et bots. Identifiez GPTBot, ClaudeBot, Google-Extended et plus de 20 autres crawlers IA avec leurs user agents, fréqu...

Découvrez comment optimiser les sitemaps XML pour les crawlers IA comme GPTBot et ClaudeBot. Maîtrisez les meilleures pratiques en matière de sitemap pour améliorer la visibilité dans les réponses générées par l’IA et l’indexation des LLM.

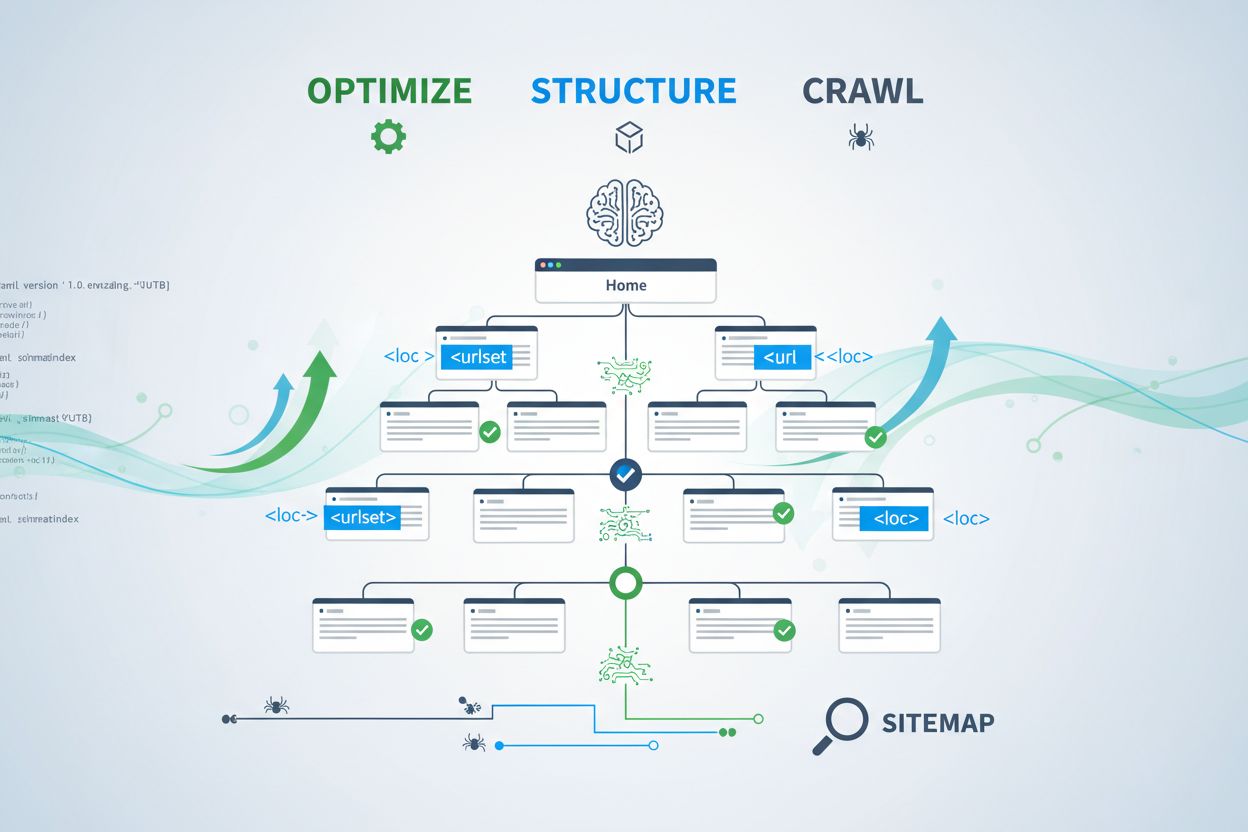

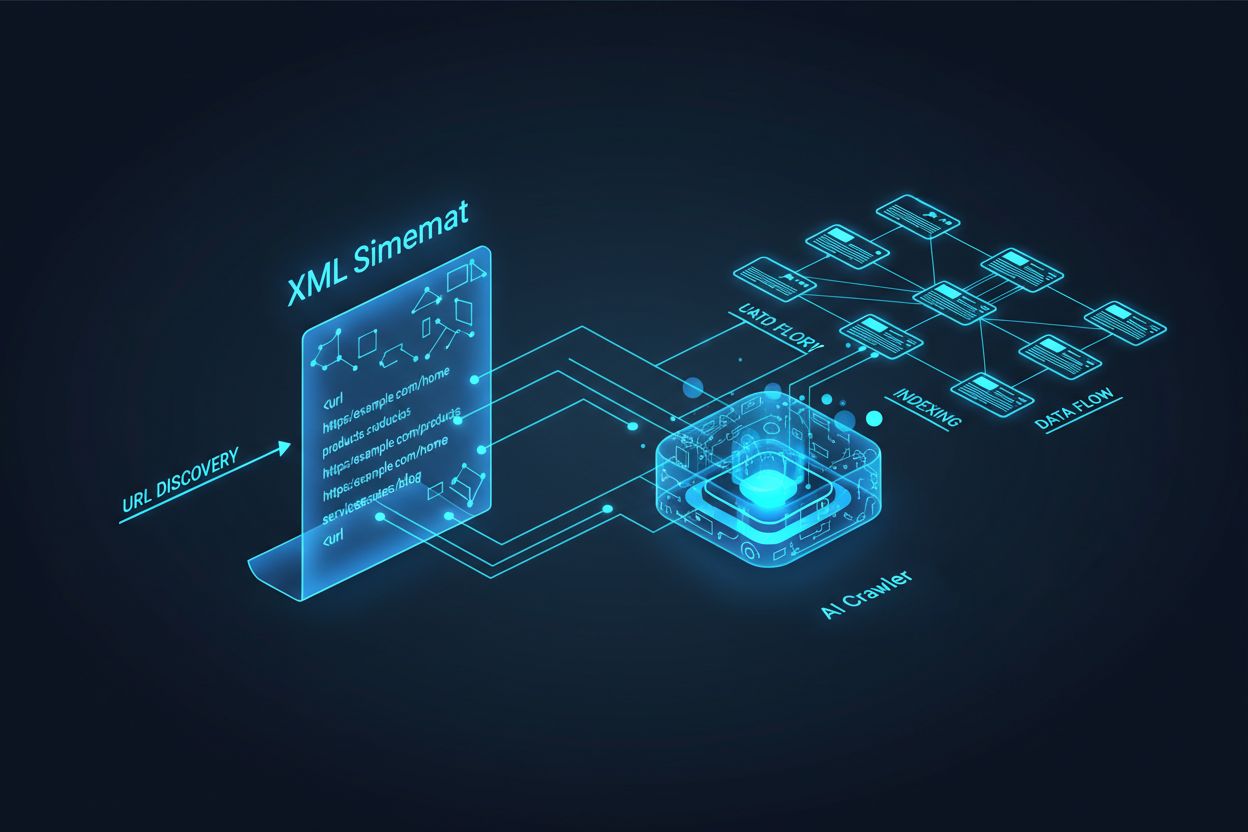

Les crawlers IA comme GPTBot, ClaudeBot et PerplexityBot fonctionnent fondamentalement différemment des bots des moteurs de recherche traditionnels. Alors que Googlebot indexe les pages pour le classement dans les résultats de recherche, les crawlers IA extraient des connaissances pour entraîner et alimenter les grands modèles de langage qui propulsent la recherche conversationnelle et les réponses générées par l’IA. Sans sitemap XML correctement optimisé, votre contenu reste invisible pour ces systèmes critiques, peu importe sa qualité rédactionnelle ou son autorité. Considérez votre sitemap comme une carte routière qui indique précisément aux systèmes IA où se trouvent vos contenus les plus précieux et comment ils sont organisés.

La distinction entre les crawlers de recherche traditionnels et les crawlers IA est cruciale pour comprendre pourquoi l’optimisation du sitemap est plus importante que jamais. Les moteurs de recherche traditionnels comme Google se concentrent sur le classement de pages individuelles pour des mots-clés spécifiques, tandis que les crawlers IA privilégient la capture de connaissances et la compréhension sémantique. Voici comment ils diffèrent :

| Aspect | Crawlers traditionnels (Googlebot) | Crawlers IA (GPTBot, ClaudeBot) |

|---|---|---|

| Objectif principal | Classer les pages dans les résultats de recherche | Extraire des connaissances pour l’entraînement LLM et les réponses en temps réel |

| Focalisation | Métadonnées, liens internes, signaux de classement | Structure du contenu, sens sémantique, densité de faits |

| Priorité d’exploration | Basée sur PageRank et la fraîcheur | Basée sur l’autorité, la pertinence thématique, et la valeur des connaissances |

| Impact des citations | Génère du trafic via des liens bleus | Détermine si votre contenu apparaît dans des réponses IA |

| Gestion du JavaScript | Exécute et rend le JavaScript | Ignore souvent JavaScript ; privilégie le HTML généré côté serveur |

Cette différence fondamentale signifie qu’optimiser uniquement pour le SEO traditionnel n’est plus suffisant. Votre sitemap doit désormais remplir une double mission : aider les moteurs de recherche traditionnels à comprendre la structure de votre site tout en guidant les systèmes IA vers vos contenus à forte valeur ajoutée.

Un sitemap XML sert de plan détaillé de votre site web, indiquant explicitement aux crawlers quelles pages existent et comment elles s’intègrent à votre stratégie globale de contenu. Pour les systèmes IA, les sitemaps jouent un rôle encore plus critique que pour la recherche traditionnelle. Les crawlers IA utilisent les sitemaps pour comprendre l’architecture thématique de votre site, identifier les contenus prioritaires et déterminer quelles pages méritent une analyse approfondie. Lorsque votre sitemap est exhaustif et bien organisé, les systèmes IA peuvent découvrir et évaluer plus efficacement votre contenu pour l’inclure dans des réponses générées. À l’inverse, un sitemap incomplet ou obsolète crée des angles morts qui empêchent les systèmes IA de trouver vos pages les plus importantes. L’impact est direct : les pages absentes de votre sitemap ont beaucoup moins de chances d’être citées par les systèmes IA, quelles que soient leur qualité ou leur pertinence.

Créer un sitemap efficace pour les crawlers IA nécessite plus que de simplement lister toutes les URLs de votre site. Votre sitemap doit être stratégiquement sélectionné pour n’inclure que les pages apportant une réelle valeur aux utilisateurs et aux systèmes IA. Voici les bonnes pratiques essentielles :

Un sitemap bien structuré agit comme un filtre de qualité, indiquant aux systèmes IA que votre contenu est soigneusement sélectionné et que chaque URL mérite l’attention. Cette approche stratégique augmente significativement vos chances d’être cité dans les réponses générées par l’IA.

La récence est l’un des facteurs de classement les plus puissants dans les systèmes de recherche propulsés par l’IA. Lorsqu’ils évaluent quelles sources citer, les crawlers IA accordent une grande importance à la fraîcheur du contenu. L’horodatage lastmod dans votre sitemap XML est le principal signal qui indique aux systèmes IA la dernière mise à jour de votre contenu. Des horodatages obsolètes ou manquants peuvent faire passer au second plan même du contenu faisant autorité, au profit de sources plus récentes. Si votre sitemap montre qu’une page n’a pas été mise à jour depuis des années, les systèmes IA peuvent supposer que l’information est dépassée et choisir le contenu d’un concurrent. À l’inverse, des horodatages lastmod exacts reflétant de réelles mises à jour de contenu indiquent aux crawlers IA que vos informations sont actuelles et fiables. Pour les sujets sensibles au temps comme les tarifs, la réglementation ou les tendances sectorielles, la précision des horodatages est encore plus critique. L’automatisation des mises à jour via votre CMS garantit que chaque changement est immédiatement reflété dans votre sitemap, maximisant votre visibilité dans les réponses IA.

Si les sitemaps invitent les crawlers à indexer votre contenu, les fichiers robots.txt contrôlent les parties de votre site accessibles aux crawlers. Ces deux fichiers doivent fonctionner de concert pour maximiser votre visibilité IA. Une erreur fréquente consiste à créer un sitemap complet tout en bloquant les crawlers IA dans le fichier robots.txt, ce qui crée une contradiction source de confusion et réduit votre visibilité. Votre robots.txt doit explicitement autoriser les principaux crawlers IA comme GPTBot, ClaudeBot et PerplexityBot à accéder à votre contenu. Vous pouvez utiliser robots.txt de façon stratégique pour bloquer uniquement les pages qui ne doivent pas être indexées, comme les tableaux de bord d’administration, pages de connexion ou versions dupliquées. L’essentiel est d’aligner les règles de robots.txt avec votre stratégie de sitemap : si une page figure dans votre sitemap, elle doit être accessible selon robots.txt. Des audits réguliers des deux fichiers permettent de détecter des erreurs de configuration susceptibles de limiter silencieusement votre visibilité IA.

Les stratégies d’optimisation IA les plus efficaces traitent sitemaps et données structurées comme deux systèmes complémentaires qui se renforcent mutuellement. Lorsque votre sitemap met en avant une page importante et que cette page inclut un balisage schema pertinent, vous envoyez aux crawlers IA des signaux cohérents sur le but et la valeur de la page. Par exemple, si votre sitemap priorise un guide pratique, cette page devrait inclure le balisage HowTo correspondant. De même, les pages produits dans votre sitemap doivent comporter le schema Product avec les informations de prix, disponibilité et avis. Cet alignement crée un ensemble cohérent de données facilement interprétables et fiables pour les systèmes IA. Quand les sitemaps et les données structurées divergent, les crawlers IA doutent de la vraie vocation de la page, ce qui diminue les chances de citation. En alignant stratégie de sitemap et implémentation schema, vous créez un signal unifié qui augmente nettement vos probabilités d’être sélectionné dans les réponses générées par l’IA.

Différents types de contenu exigent des stratégies de sitemap distinctes pour maximiser la visibilité IA. Articles de blog, fiches produit, descriptions de services et FAQ remplissent des rôles différents et doivent être optimisés en conséquence :

| Type de contenu | Stratégie de sitemap | Balisage schema recommandé | Considérations de priorité |

|---|---|---|---|

| Articles & billets de blog | Inclure avec dates de publication et de mise à jour précises | Article, NewsArticle, BlogPosting | Prioriser le contenu récent et intemporel ; mettre à jour lastmod régulièrement |

| Pages produit | Inclure avec mises à jour d’inventaire ; envisager un sitemap produit séparé | Product, Offer, AggregateRating | Mettre en avant les best-sellers et nouveautés ; actualiser fréquemment les prix |

| Pages de service | Inclure avec dates de mise à jour du service | Service, LocalBusiness, ProfessionalService | Prioriser les services principaux ; actualiser disponibilité et tarifs |

| Pages FAQ | Inclure avec dates de mise à jour du contenu | FAQPage, Question, Answer | Prioriser les FAQ complètes ; mettre à jour les réponses lors de changements d’information |

| Contenu vidéo | Inclure dans un sitemap vidéo avec vignette et durée | VideoObject, Video | Ajouter des transcriptions ; mettre à jour vues et engagement |

| Contenu image | Inclure dans un sitemap image avec légendes | ImageObject, Product (pour images produits) | Optimiser l’attribut alt ; inclure des légendes descriptives |

Cette approche différenciée garantit à chaque type de contenu une optimisation adéquate pour la découverte par l’IA. En adaptant votre stratégie de sitemap à votre mix de contenus, vous maximisez les chances que vos ressources soient trouvées et citées par les systèmes IA.

La norme llms.txt, proposée fin 2024, représente une approche expérimentale permettant aux systèmes IA de mieux comprendre la structure des sites web. Contrairement aux sitemaps XML, llms.txt est un fichier basé sur Markdown qui fournit une table des matières lisible par l’humain. Il recense vos pages et ressources les plus importantes dans un format plus accessible pour les modèles de langage. Bien que prometteur, l’impact actuel de llms.txt sur la visibilité IA reste limité comparé aux sitemaps XML traditionnels. Les principaux crawlers IA, comme GPTBot et ClaudeBot, continuent de se baser principalement sur les sitemaps XML pour la découverte des URLs et les signaux de fraîcheur. Plutôt que de remplacer votre sitemap XML, llms.txt doit être vu comme un outil complémentaire susceptible d’apporter un contexte additionnel aux systèmes IA. Si vous mettez en œuvre llms.txt, veillez à ce qu’il complète — et non remplace — votre stratégie de sitemap, et concentrez-vous d’abord sur la perfection de votre sitemap XML avec des horodatages précis et une sélection de contenu stratégique.

Même les sites bien gérés commettent souvent des erreurs de sitemap qui limitent silencieusement leur visibilité IA. Comprendre et éviter ces erreurs est essentiel pour maximiser votre présence dans les réponses générées par l’IA :

Corriger ces erreurs courantes peut améliorer immédiatement votre visibilité IA. Commencez par auditer votre sitemap actuel à l’aide de cette liste et corrigez les problèmes identifiés.

Maintenir un sitemap optimisé nécessite une surveillance et une validation continues. Plusieurs outils vous permettent de garantir l’efficacité de votre sitemap pour les crawlers IA. Google Search Console propose une validation intégrée des sitemaps et montre combien d’URLs ont été indexées à partir de votre sitemap. Screaming Frog SEO Spider permet d’explorer l’ensemble de votre site et de comparer les résultats avec votre sitemap, identifiant les URLs manquantes ou cassées. Les validateurs de sitemaps XML vérifient la syntaxe et la conformité au protocole XML sitemap. Pour les grandes entreprises, des plateformes SEO comme Semrush et Ahrefs intègrent des analyses de sitemap suivies dans le temps. Des audits réguliers — idéalement mensuels — vous aident à détecter les problèmes avant qu’ils n’affectent votre visibilité IA. Programmez des rappels pour réviser votre sitemap à chaque modification majeure de contenu, lancement de nouvelle section ou évolution de l’architecture du site.

Comprendre comment les crawlers IA interagissent avec votre sitemap nécessite une surveillance et une analyse actives. Vos logs serveurs contiennent des données précieuses sur les crawlers IA visitant votre site, la fréquence d’exploration et les pages prioritaires. En les analysant, vous pouvez identifier des tendances et optimiser votre sitemap en conséquence. Des outils comme AmICited.com vous aident à surveiller la fréquence à laquelle votre contenu est cité par des systèmes IA comme ChatGPT, Claude, Perplexity et les AI Overviews de Google, fournissant un retour direct sur l’efficacité de votre sitemap. Google Analytics peut être configuré pour suivre le trafic référent provenant des systèmes IA, vous indiquant quelles pages bénéficient le plus de visibilité IA. En croisant ces données avec la structure de votre sitemap, vous pouvez identifier quels types et sujets de contenus sont les plus appréciés par l’IA. Cette démarche data-driven vous permet d’affiner continuellement votre stratégie de sitemap, en priorisant les contenus générant le plus de citations et de visibilité IA.

Au-delà de l’optimisation basique, des stratégies avancées peuvent considérablement accroître votre visibilité IA. Créer des sitemaps séparés pour différents types de contenu — par exemple, un sitemap dédié aux blogs, aux produits, aux vidéos — permet d’appliquer des optimisations spécifiques. La génération dynamique de sitemap, où le sitemap est actualisé en temps réel à chaque modification de contenu, garantit que les crawlers IA voient toujours vos contenus les plus récents. Pour les grands sites d’entreprise comportant des milliers de pages, la mise en place de hiérarchies de sitemap et d’une priorisation stratégique aide les crawlers IA à cibler vos contenus à plus forte valeur ajoutée. Certaines organisations créent des sitemaps spécifiques à l’IA ne comportant que leurs pages à plus forte autorité et dignes de citation, signalant ainsi aux systèmes IA quels contenus méritent une attention prioritaire. L’intégration de la stratégie de sitemap à votre système de gestion de contenu garantit une optimisation automatique sans nécessiter d’interventions manuelles. Ces approches avancées exigent une plus grande sophistication technique mais peuvent procurer des gains notables de visibilité IA pour les organisations à l’écosystème de contenu complexe.

Le paysage des crawlers IA évolue rapidement, avec l’émergence régulière de nouveaux crawlers et l’adoption de normes comme llms.txt. Pérenniser votre stratégie de sitemap implique d’intégrer de la flexibilité à vos systèmes et de rester informé des évolutions du secteur. Mettez en place des systèmes de génération de sitemap pouvant s’adapter facilement aux nouvelles exigences des crawlers sans reconfiguration manuelle. Surveillez les annonces des principaux acteurs IA au sujet de nouveaux crawlers et ajustez vos robots.txt et stratégies de sitemap en conséquence. Réfléchissez à la valeur à long terme de la visibilité IA face au contrôle de votre contenu — alors que certaines organisations choisissent de bloquer les crawlers IA, la tendance montre que les citations IA deviendront un levier croissant de visibilité de marque. Définissez des politiques claires sur la gestion de l’accès des crawlers IA et l’utilisation de vos contenus. En traitant votre sitemap comme un document vivant qui évolue avec le paysage IA, vous assurez à votre contenu d’être toujours découvert et cité à mesure que les mécanismes de recherche et de découverte se transforment.

Vous devez mettre à jour votre sitemap chaque fois que vous publiez un nouveau contenu ou que vous apportez des modifications significatives à des pages existantes. Idéalement, mettez en place une génération automatisée du sitemap pour que les mises à jour aient lieu immédiatement. Pour les sites avec des changements fréquents, des mises à jour quotidiennes sont recommandées. Pour les sites statiques, un contrôle mensuel est suffisant.

La plupart des principaux crawlers IA, comme GPTBot et ClaudeBot, respectent les directives du robots.txt, mais ce n'est pas le cas de tous. La meilleure pratique consiste à autoriser explicitement les crawlers IA dans votre fichier robots.txt plutôt que de se fier au comportement par défaut. Surveillez vos logs serveurs pour vérifier que les crawlers se comportent comme prévu.

Les sitemaps XML sont des fichiers lisibles par machine qui listent toutes vos URLs avec des métadonnées comme les horodatages lastmod. llms.txt est une nouvelle norme basée sur Markdown conçue pour fournir aux systèmes IA une table des matières lisible par l'humain. Les sitemaps XML sont actuellement plus importants pour la visibilité IA, tandis que llms.txt doit être considéré comme complémentaire.

Vérifiez vos logs serveurs pour les user agents comme 'GPTBot', 'ClaudeBot', 'PerplexityBot' et 'Google-Extended'. Vous pouvez aussi utiliser des outils comme AmICited.com pour surveiller la fréquence à laquelle votre contenu est cité par les systèmes IA, ce qui indique un crawling et une indexation réussis.

Oui, créer des sitemaps distincts pour les blogs, produits, vidéos et images vous permet d'appliquer des stratégies d'optimisation spécifiques à chaque type. Cela aide également les crawlers IA à mieux comprendre la structure de votre contenu et peut améliorer l'efficacité d'exploration pour les sites volumineux.

Les sitemaps XML ne doivent pas contenir plus de 50 000 URLs par fichier. Pour les sites plus importants, utilisez des index de sitemaps pour organiser plusieurs fichiers de sitemap. Les crawlers IA peuvent gérer de grands sitemaps, mais les diviser en sections logiques améliore l'efficacité d'exploration et facilite la gestion.

Les horodatages lastmod signalent la fraîcheur du contenu aux crawlers IA. La récence est un facteur de classement important dans les systèmes IA, donc des horodatages précis aident votre contenu à être en compétition pour les citations. Utilisez toujours des systèmes automatisés pour mettre à jour les horodatages uniquement lorsque le contenu change réellement — ne définissez jamais manuellement de faux horodatages.

Oui, un sitemap mal entretenu peut nuire considérablement à votre visibilité IA. Les liens brisés, URLs obsolètes, horodatages inexacts et une couverture incomplète réduisent vos chances d'être cité par les systèmes IA. Des audits réguliers et une maintenance sont essentiels pour protéger votre visibilité IA.

Suivez la fréquence à laquelle votre contenu est cité par ChatGPT, Claude, Perplexity et Google AI Overviews. Optimisez votre stratégie de sitemap sur la base de données réelles de citations IA.

Guide complet de référence des crawlers IA et bots. Identifiez GPTBot, ClaudeBot, Google-Extended et plus de 20 autres crawlers IA avec leurs user agents, fréqu...

Découvrez comment structurer votre site pour un indexage optimal par les crawlers IA, incluant le HTML sémantique, l’architecture du site, l’organisation du con...

Découvrez comment rendre votre contenu visible pour les crawlers d'IA comme ChatGPT, Perplexity et l'IA de Google. Découvrez les exigences techniques, les meill...