Densité de mots-clés

La densité de mots-clés mesure la fréquence d’apparition d’un mot-clé dans un contenu par rapport au nombre total de mots. Découvrez les pourcentages optimaux, ...

Découvrez pourquoi la densité de mots-clés n’a plus d’importance pour la recherche IA. Découvrez ce que ChatGPT, Perplexity et Google AI Overviews privilégient réellement dans le classement et la citation du contenu.

La densité de mots-clés a un impact minimal sur les systèmes d’IA et les moteurs de recherche modernes. Les recherches montrent que les pages les mieux classées affichent en moyenne seulement 0,04 % de densité de mots-clés, tandis que les modèles d’IA privilégient la signification sémantique, l’autorité thématique et la profondeur du contenu plutôt que la fréquence des mots-clés. Concentrez-vous plutôt sur un langage naturel et une couverture complète du sujet.

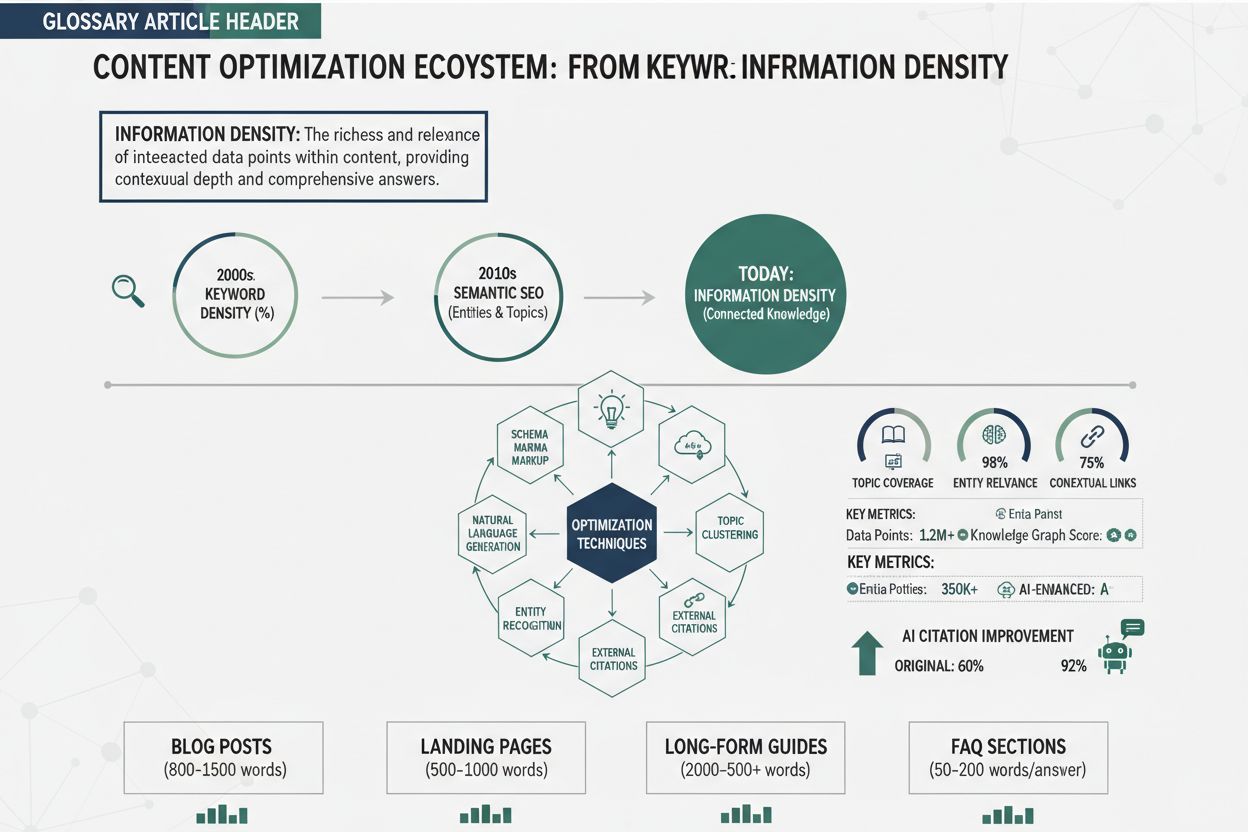

La densité de mots-clés désigne le pourcentage du nombre de fois où un mot-clé particulier apparaît sur une page Web par rapport au nombre total de mots. Historiquement, cette métrique était centrale dans la stratégie SEO : plus un mot-clé apparaissait fréquemment, plus une page semblait pertinente pour ce terme. Cependant, le paysage a radicalement changé avec l’essor de l’intelligence artificielle, des grands modèles de langage (LLM) et de la recherche sémantique. Aujourd’hui, la densité de mots-clés n’est plus un facteur de classement principal pour Google, ChatGPT, Perplexity, Google AI Overviews ou Claude. Ces systèmes évaluent plutôt le contenu en fonction de la signification sémantique, de l’autorité thématique, des relations d’entités et de l’intention de l’utilisateur. Comprendre ce changement est essentiel pour toute personne créant du contenu qui doit être bien positionné dans les résultats de recherche traditionnels et cité par les systèmes d’IA. L’évolution de l’optimisation centrée sur les mots-clés vers une optimisation centrée sur le sens représente l’un des changements les plus significatifs dans la stratégie de contenu numérique de la dernière décennie.

L’histoire du classement dans la recherche explique pourquoi la densité de mots-clés est devenue obsolète. Au début des années 2000, les moteurs de recherche comme Google s’appuyaient fortement sur la fréquence des mots-clés et les backlinks comme principaux signaux de classement. Cela a mené à une généralisation du bourrage de mots-clés—la pratique consistant à surcharger le contenu de mots-clés de façon artificielle pour manipuler les classements. Les pages répétaient maladroitement des phrases, au détriment de la lisibilité et de l’expérience utilisateur. L’ancien responsable Webspam de Google, Matt Cutts, a d’ailleurs déclaré qu’il y avait des “rendements décroissants” à la répétition de mots-clés, signalant ainsi le désengagement de l’entreprise envers cette métrique. En 2013, Google a lancé Hummingbird, une mise à jour de l’algorithme privilégiant l’intention de recherche par rapport à la correspondance exacte des mots-clés. Cela a été suivi par RankBrain (2015), BERT (2018) et MUM (2021)—chaque avancée permettant à Google de mieux comprendre le contexte, la sémantique et les relations entre les concepts. Les systèmes d’IA modernes analysent désormais la signification derrière les mots plutôt que de compter leur fréquence. Une étude de 2025 sur 1 536 résultats de recherche Google n’a trouvé aucune corrélation constante entre la densité de mots-clés et la position dans le classement, les 10 premiers résultats affichant en moyenne seulement 0,04 % de densité de mots-clés contre 0,07-0,08 % dans les positions inférieures. Ces données montrent de façon définitive qu’une densité de mots-clés plus faible est en réalité associée à de meilleurs classements.

| Aspect | Densité de mots-clés | Profondeur sémantique | Autorité thématique |

|---|---|---|---|

| Définition | Pourcentage de fois où un mot-clé apparaît dans le contenu | Degré auquel le contenu couvre de manière exhaustive un sujet et ses sous-thèmes | Ampleur de l’expertise démontrée sur un domaine |

| Comment c’est mesuré | (Fréquence du mot-clé / Total mots) × 100 | Couverture d’entités, cartographie des relations, regroupement de contenu | Volume et qualité du contenu connexe sur le domaine |

| Pertinence pour l’IA | Minimale voire nulle | Critique pour la citation et le classement par l’IA | Essentielle pour la confiance du système IA |

| Plage recommandée | 0,5-2 % (mais pas de règle stricte) | Groupes de contenus profonds et interconnectés | Plusieurs articles complets par sujet |

| Impact sur le classement | Négligeable ; peut nuire si excessif | Impact direct positif sur la visibilité | Fort impact positif sur les citations par l’IA |

| Expérience utilisateur | Peut réduire la lisibilité si forcée | Améliore la satisfaction et l’engagement | Renforce l’autorité et la confiance sur le long terme |

| Préférence du système IA | Ignorée ou pénalisée | Très valorisée pour les citations | Priorisée pour la sélection des sources |

Cette comparaison montre pourquoi les créateurs de contenu doivent repenser fondamentalement leur stratégie d’optimisation. La densité de mots-clés est une métrique mécanique qui ne reflète pas la façon dont les systèmes d’IA modernes évaluent le contenu. La profondeur sémantique et l’autorité thématique, en revanche, influencent directement la probabilité que des systèmes comme ChatGPT, Perplexity et Google AI Overviews citent votre contenu comme source de confiance.

Les grands modèles de langage et les moteurs de recherche IA utilisent des réseaux neuronaux sophistiqués pour comprendre la signification du contenu plutôt que de compter les mots-clés. BERT de Google (Bidirectional Encoder Representations from Transformers) peut comprendre le contexte des mots par rapport à tous les autres mots d’une phrase, et non seulement leur position ou leur fréquence. MUM (Multitask Unified Model) va plus loin, comprenant l’information à travers plusieurs langues et formats simultanément. Ces systèmes cartographient le contenu dans des graphiques de connaissances—des représentations structurées d’entités, de leurs attributs et de leurs relations. Lorsque vous recherchez “planification de la retraite”, les systèmes d’IA ne recherchent pas les pages avec la plus forte densité pour cette expression. Ils identifient plutôt les pages qui couvrent de manière exhaustive des entités connexes comme “401(k)”, “Roth IRA”, “régimes de retraite” et expliquent leurs attributs, comme “plafonds de cotisation”, “traitement fiscal” et “abondement employeur”. Des recherches menées par BrightEdge ont montré que 82,5 % des citations dans les AI Overviews pointent vers des “pages profondes” situées à deux clics ou plus de la page d’accueil—des pages avec un contenu conséquent et interconnecté plutôt que des résumés superficiels. Cela démontre que les systèmes IA privilégient la profondeur et l’exhaustivité plutôt que la fréquence des mots-clés. Lorsqu’ils sélectionnent des sources pour répondre, ils utilisent une technique de “query fan-out”, scindant les requêtes complexes en sous-thèmes liés et combinant des pages de soutien en réponses cohérentes. Les pages avec une forte couverture d’entités et une profondeur de sous-thèmes sont beaucoup plus susceptibles d’être sélectionnées comme sources.

Le bourrage de mots-clés est explicitement pénalisé par Google et les autres systèmes de recherche. Les politiques officielles de Google contre le spam stipulent que “remplir une page web de mots-clés ou de chiffres dans le but de manipuler le classement” viole leurs directives et peut entraîner des sanctions manuelles ou une rétrogradation algorithmique. Un contenu qui répète artificiellement des mots-clés se lit de façon peu naturelle tant pour les humains que pour les systèmes d’IA. Les modèles de langage modernes peuvent détecter l’usage forcé de mots-clés et reconnaître lorsque le contenu privilégie la manipulation des moteurs de recherche au détriment de l’utilisateur. Lorsque les systèmes IA rencontrent du contenu rempli de mots-clés, ils le dépriorisent car cela signale un contenu de faible qualité et hostile à l’utilisateur. De plus, le bourrage de mots-clés entraîne généralement de mauvais indicateurs d’engagement—les utilisateurs quittent rapidement les pages qui ne se lisent pas naturellement. Les moteurs de recherche surveillent le temps passé sur la page, la profondeur de défilement et les taux de clic comme signaux de qualité du contenu. Les pages à répétition forcée de mots-clés affichent généralement un mauvais engagement, ce qui dégrade encore leur classement. Le calcul risque/récompense est clair : essayer de manipuler les classements par la densité de mots-clés offre peu d’avantages et un risque important de pénalité.

Chaque grand système d’IA a ses particularités, mais tous partagent des critères d’évaluation communs qui n’ont rien à voir avec la densité de mots-clés. ChatGPT (avec la recherche activée) privilégie les sources faisant autorité, la couverture complète et la récence. Lorsqu’il cite des sources, ChatGPT sélectionne les pages qui répondent en profondeur à la requête avec des informations claires et bien organisées. Perplexity valorise de même la profondeur thématique, les compétences d’expert et la recherche originale. L’algorithme de la plateforme identifie les pages qui font preuve d’une véritable expertise et apportent des perspectives uniques, plutôt que de simples résumés génériques. Google AI Overviews (anciennement SGE) utilise les systèmes de classement existants de Google comme base, mais ajoute des critères supplémentaires pour l’exhaustivité et la fiabilité. Les pages qui apparaissent dans AI Overviews affichent généralement de forts signaux E-E-A-T (Expérience, Expertise, Autorité, Fiabilité), des informations claires sur l’auteur et des clusters de contenu interconnectés. Claude (l’IA d’Anthropic) met l’accent sur l’exactitude, la nuance et l’analyse originale. Lorsqu’il cite des sources, Claude privilégie les pages qui offrent des perspectives équilibrées et reconnaissent la complexité plutôt que celles qui simplifient à l’extrême. Dans tous ces systèmes, le constat est clair : la signification sémantique, l’autorité thématique et la profondeur du contenu comptent bien plus que la fréquence des mots-clés. Si vous souhaitez que votre contenu soit cité par l’IA, concentrez-vous sur l’établissement d’une autorité reconnue sur votre sujet grâce à des contenus complets et interconnectés, et non sur l’optimisation de la densité de mots-clés.

L’autorité thématique a remplacé la densité de mots-clés en tant que mesure clé de la pertinence pour la recherche traditionnelle comme pour les systèmes IA. L’autorité thématique désigne le niveau d’expertise, de crédibilité et de confiance qu’un site web démontre sur un sujet spécifique. Plutôt que de répéter les mots-clés, vous développez une autorité thématique en créant un contenu étendu et bien structuré qui traite un sujet et ses sous-thèmes en profondeur. Cette approche implique la création de clusters de contenu—des réseaux interconnectés de pages organisées autour d’un sujet principal pilier. Par exemple, un site de services financiers pourrait créer une page pilier sur la “planification de la retraite” soutenue par des sous-piliers sur les “régimes 401(k)”, les “Roth IRA” et les “régimes de retraite”, avec des pages de cluster traitant de questions précises comme “plafonds de cotisation 401(k)”, “avantages fiscaux Roth IRA” et “comparaison 401(k) vs Roth IRA”. Cette structure signale aux moteurs de recherche et aux systèmes IA que votre site dispose d’une expertise approfondie sur la planification de la retraite. Le maillage interne au sein de ces clusters renforce les relations d’entités et aide l’IA à comprendre comment les concepts sont liés. Lorsque vous bâtissez une autorité thématique, vous intégrez naturellement les mots-clés pertinents dans le contexte—non par répétition forcée, mais par une couverture exhaustive des sujets connexes. Un guide de plus de 3 000 mots sur la planification de la retraite inclura naturellement des mots-clés comme “401(k)”, “cotisation”, “impôt” et “abondement employeur” à plusieurs reprises, mais la densité restera faible (généralement 0,5-1,5 %) car le contenu vise à apporter de la valeur plutôt qu’à optimiser la densité.

Différentes plateformes IA ont des schémas de citation légèrement différents, mais aucune ne privilégie la densité de mots-clés. Google AI Overviews cite généralement des pages bien classées dans la recherche Google traditionnelle, ce qui signifie qu’elles privilégient les pages à forte autorité thématique, aux signaux E-E-A-T marqués et à la couverture complète. Les pages à la structure claire (hiérarchie de titres appropriée, balisage schema, information organisée) sont plus susceptibles d’être sélectionnées. Perplexity semble valoriser la recherche originale, les compétences d’expert et les perspectives uniques. Les pages qui citent des études, incluent des citations d’experts ou présentent des données originales sont souvent citées. ChatGPT (avec recherche) privilégie la récence pour les sujets d’actualité et l’autorité pour les sujets pérennes. Les pages de domaines établis et de confiance sont davantage citées. Claude met l’accent sur l’exactitude et la nuance, citant souvent des pages qui reconnaissent la complexité et offrent des points de vue équilibrés. Pour optimiser la citation sur ces plateformes, concentrez-vous sur : la création de contenus originaux fondés sur la recherche ; l’affichage de compétences d’auteur claires ; le développement de clusters de contenu interconnectés démontrant une profondeur thématique ; l’utilisation de données structurées (balisage schema) pour expliciter la signification du contenu ; et le maintien de standards d’exactitude élevés avec des citations et des vérifications de faits appropriées. Aucune de ces stratégies n’implique d’optimiser la densité de mots-clés.

Passer d’une logique axée sur la densité de mots-clés à une optimisation sémantique nécessite un changement fondamental de stratégie de contenu. Commencez par identifier vos sujets principaux et cartographiez-les avec les entités reconnues par Google dans son Knowledge Graph. Pour chaque sujet principal, créez une page pilier offrant une couverture complète, puis développez des sous-piliers et des pages cluster qui abordent des aspects spécifiques, des comparaisons et des questions d’utilisateurs. Utilisez un langage naturel partout : écrivez d’abord pour les humains, ensuite pour les moteurs de recherche. Intégrez vos mots-clés cibles naturellement dans le contexte d’un contenu utile et complet, sans jamais les forcer. Incorporez des variations sémantiques et des termes connexes pour aider les systèmes IA à appréhender toute l’étendue de votre sujet. Par exemple, au lieu de répéter des dizaines de fois “planification de la retraite”, utilisez des variantes comme “stratégie de retraite”, “épargne retraite”, “comptes de retraite” et “planification du revenu de retraite”. Structurez votre contenu avec des hiérarchies de titres claires (H1, H2, H3), des listes à puces, des tableaux comparatifs et des visuels pertinents. Cette mise en forme aide à la fois les utilisateurs et les IA à mieux comprendre votre contenu. Mettez en place le balisage schema (Article, FAQ, HowTo, Produit, etc.) pour indiquer explicitement aux moteurs de recherche le sujet de votre contenu. Utilisez le maillage interne de façon stratégique pour relier entre elles les pages de vos clusters, avec des ancres descriptives clarifiant la relation entre les pages. Surveillez vos performances avec Google Search Console afin d’identifier les requêtes qui génèrent des impressions et des clics, et utilisez l’analytics pour mesurer des indicateurs d’engagement comme le temps passé et la profondeur de défilement. Des outils comme AmICited peuvent vous aider à suivre où votre contenu apparaît sur les plateformes IA, vous donnant de la visibilité sur les pages citées et les sujets nécessitant plus de profondeur.

L’évolution du SEO vers la recherche pilotée par l’IA conduit à une nouvelle discipline appelée Generative Engine Optimization (GEO). Alors que le SEO traditionnel visait à se classer sur des mots-clés et que l’optimisation des AI Overviews (AIO) vise l’apparition dans les réponses générées par l’IA, le GEO adopte une vision plus large de la façon dont le contenu est découvert, récupéré et synthétisé par les systèmes d’IA. À l’ère du GEO, la stratégie de contenu doit prendre en compte la manière dont les grands modèles de langage récupèrent et combinent l’information issue de multiples sources. Cela implique de bâtir des écosystèmes de contenu sémantiquement riches où les pages sont interconnectées par des relations claires d’entités et une profondeur thématique. Les pages les plus susceptibles d’être citées dans les réponses IA sont celles qui démontrent une couverture exhaustive d’un sujet, une expertise claire et une information fiable. La densité de mots-clés est sans importance pour cet avenir. Ce qui compte, c’est la capacité de votre contenu à être facilement retrouvé, compris et cité par les systèmes IA comme source faisant autorité. À mesure que les IA gagnent en sophistication, elles privilégieront de plus en plus les contenus qui font preuve d’une expertise authentique et d’une valeur unique. Les sites qui investissent dès maintenant dans l’autorité thématique et la profondeur sémantique bénéficieront d’un avantage durable à mesure que la recherche évolue. L’abandon de la densité de mots-clés marque une maturité des technologies de recherche—du simple appariement mécanique à la véritable compréhension du sens et de l’expertise.

Suivez où votre contenu apparaît sur ChatGPT, Perplexity, Google AI Overviews et Claude. Comprenez ce qui pousse les systèmes d’IA à citer votre contenu et optimisez en conséquence.

La densité de mots-clés mesure la fréquence d’apparition d’un mot-clé dans un contenu par rapport au nombre total de mots. Découvrez les pourcentages optimaux, ...

Discussion communautaire sur l’importance éventuelle de la densité de mots-clés pour la recherche IA. Retours d’expérience de professionnels SEO testant l’impac...

Découvrez ce qu'est la densité d'information et comment elle améliore la probabilité de citation par l'IA. Découvrez des techniques pratiques pour optimiser le ...