Comprendre les facteurs de vitesse d’indexation par l’IA

La vitesse d’indexation par l’IA détermine la rapidité avec laquelle votre contenu devient visible dans les moteurs de recherche alimentés par l’IA comme ChatGPT, Perplexity et les AI Overviews de Google. Contrairement aux moteurs de recherche traditionnels qui associent simplement des mots-clés à des pages, les systèmes IA doivent crawler, comprendre et synthétiser votre contenu pour générer des réponses précises. La vitesse à laquelle cela se produit dépend de nombreux facteurs interconnectés qui impactent directement votre visibilité dans les réponses générées par l’IA et votre capacité à capter du trafic depuis les plateformes de recherche IA.

Performance du site et vitesse de chargement des pages

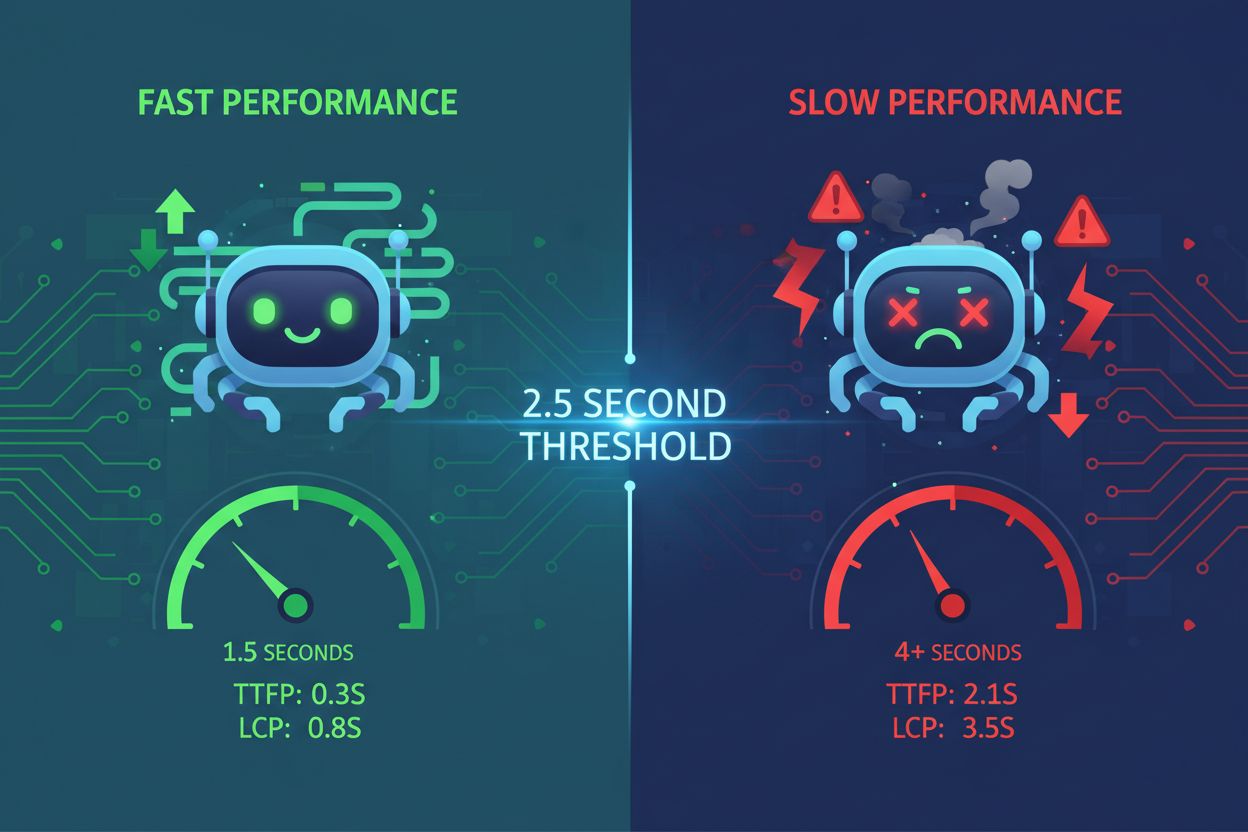

La vitesse de chargement des pages est l’un des facteurs les plus critiques affectant la vitesse d’indexation par l’IA. Les crawlers IA fonctionnent avec des contraintes de ressources et des délais stricts — généralement entre 1 et 5 secondes par requête de page. Si votre site se charge lentement, les crawlers passent plus de temps à récupérer le contenu, ce qui signifie que moins de pages sont indexées dans la fenêtre de crawl allouée. Cela crée un effet domino où une mauvaise performance réduit directement le nombre de pages que les systèmes IA peuvent traiter et indexer.

Les sites lents signalent un mauvais entretien aux systèmes IA. Lorsque les pages prennent trop de temps à s’afficher, les crawlers IA peuvent expirer avant d’accéder à votre contenu réel, laissant uniquement la structure HTML indexée. Cela est particulièrement problématique pour les sites fortement basés sur JavaScript, où le contenu se charge dynamiquement côté client. Le processus de rendu en deux étapes requis pour JavaScript ajoute une latence significative, compliquant l’extraction d’informations pertinentes par l’IA. Compresser les images, minifier le code, mettre en œuvre le lazy loading et utiliser des réseaux de diffusion de contenu (CDN) peuvent améliorer de façon spectaculaire les temps de chargement et permettre aux crawlers IA de traiter plus de pages efficacement.

| Indicateur de performance | Objectif | Impact sur l’indexation IA |

|---|

| Temps de chargement de page | Moins de 3 secondes | Permet de crawler plus de pages par session |

| Largest Contentful Paint (LCP) | Moins de 2,5 secondes | Garantit que l’IA voit rapidement un contenu pertinent |

| First Input Delay (FID) | Moins de 100ms | Améliore la réactivité des crawlers |

| Cumulative Layout Shift (CLS) | Proche de zéro | Prévient les erreurs d’extraction de contenu |

Ready to Monitor Your AI Visibility?

Track how AI chatbots mention your brand across ChatGPT, Perplexity, and other platforms.

Contraintes du budget de crawl

Le budget de crawl désigne le nombre limité de pages que les systèmes IA peuvent visiter dans un laps de temps donné. Chaque site reçoit une allocation de crawl finie de la part des moteurs de recherche IA, similaire à la gestion du budget de crawl chez Google. Lorsque votre budget de crawl est épuisé, les systèmes IA arrêtent d’indexer le nouveau contenu, peu importe sa qualité. Cette limitation devient particulièrement problématique pour les grands sites comportant des centaines ou des milliers de pages en compétition pour des ressources d’indexation limitées.

L’optimisation de l’allocation du budget de crawl est essentielle pour une indexation IA rapide. Vous devez prioriser les pages à forte valeur ajoutée — celles qui génèrent des revenus, attirent du trafic ou contiennent des informations critiques — par rapport aux pages à faible valeur comme les filtres de catégories en double ou les pages d’étiquettes redondantes. En utilisant judicieusement les fichiers robots.txt, vous pouvez bloquer l’accès des crawlers IA aux pages qui n’ont pas besoin d’être indexées, préservant ainsi votre budget de crawl pour le contenu important. De plus, maintenir un sitemap XML à jour et utiliser une structure de liens internes adéquate aide les systèmes IA à découvrir plus rapidement vos pages clés, garantissant leur indexation avant la fin du budget de crawl.

Qualité et originalité du contenu

Les systèmes IA pénalisent fortement le contenu dupliqué ou peu étoffé, ce qui ralentit considérablement l’indexation. Lorsque les crawlers IA rencontrent du contenu manquant d’originalité ou de substance, ils dépriorisent le crawl de pages similaires sur votre site. En effet, les systèmes IA évaluent la qualité du contenu à partir des signaux E-E-A-T (Expertise, Expérience, Autorité et Fiabilité). Un contenu perçu comme de faible effort, généré par IA sans relecture humaine, ou dupliqué d’autres sources reçoit une priorité moindre dans la file d’indexation.

Un contenu de haute qualité et complet est indexé plus rapidement par les systèmes IA. Un contenu dépassant les 3 000 mots et répondant de manière approfondie aux questions des utilisateurs selon divers angles bénéficie d’une indexation prioritaire. Les systèmes IA privilégient les contenus intégrant des données, statistiques, exemples concrets et études de cas, car ces éléments démontrent l’expertise et la fiabilité. En créant un contenu original et bien documenté qui apporte une réelle valeur, les crawlers IA allouent plus de ressources à l’indexation de vos pages, ce qui accélère leur découverte et leur inclusion dans les réponses générées par l’IA.

Stay Updated on AI Visibility Trends

Get the latest insights on AI mentions, brand monitoring, and optimization strategies.

Configuration SEO technique

Une mauvaise configuration du fichier robots.txt peut par inadvertance bloquer les crawlers IA et empêcher l’indexation de votre contenu. De nombreux sites empêchent involontairement les bots de recherche IA d’accéder à leurs pages en configurant mal les fichiers robots.txt. Différents systèmes IA utilisent des identifiants de crawler distincts — ChatGPT utilise OAI-SearchBot, Perplexity utilise PerplexityBot, d’autres utilisent AndiBot ou ExaBot. Si votre robots.txt n’autorise pas explicitement ces crawlers, ils ne pourront pas indexer votre contenu, quelle qu’en soit la qualité ou la pertinence.

Une structure HTML propre et un balisage sémantique accélèrent l’indexation IA. Les crawlers IA rencontrent des difficultés avec les implémentations lourdes en JavaScript et les structures imbriquées complexes. Utiliser les balises sémantiques HTML5 (article, section, nav), des hiérarchies de titres appropriées (H1-H6), des textes de lien descriptifs et des textes alternatifs pour les images rend votre contenu immédiatement accessible aux systèmes IA. Les frameworks de rendu côté serveur (SSR) comme Next.js ou Gatsby pré-rendent le contenu côté serveur, assurant que les crawlers IA reçoivent des pages complètes sans nécessité d’exécution JavaScript, ce qui accélère significativement l’indexation.

Indexation de la base de données et infrastructure

Une sur-indexation dans votre base de données crée de la latence qui ralentit la vitesse d’indexation IA. Lorsque les bases de données comportent trop d’index, des index redondants ou qui se chevauchent, chaque opération d’insertion, de mise à jour ou de suppression doit mettre à jour plusieurs index, créant ainsi des goulots d’étranglement en écriture. Cette surcharge impacte directement la rapidité avec laquelle votre CMS peut servir les pages aux crawlers IA. Les index redondants consomment de l’espace de stockage, introduisent de la latence et forcent les planificateurs de requêtes à prendre des décisions sous-optimales, ralentissant ainsi la livraison du contenu aux systèmes IA.

L’optimisation des index de base de données améliore la rapidité de livraison du contenu aux crawlers IA. Auditez régulièrement votre base de données pour identifier les index inutilisés ou redondants à l’aide d’outils comme pg_stat_user_indexes (PostgreSQL) ou sys.schema_unused_indexes (MySQL). Supprimez les index inactifs depuis des semaines ou des mois, consolidez les index qui se chevauchent et assurez-vous que votre schéma de base de données correspond aux besoins actuels des requêtes. Une base de données bien optimisée sert le contenu plus rapidement aux crawlers IA, permettant une indexation plus rapide et une inclusion optimale dans les réponses générées par l’IA.

Mise en œuvre du balisage schema

L’absence ou l’incomplétude du balisage schema retarde la compréhension et l’indexation IA du contenu. Le balisage schema fournit des données structurées qui aident les systèmes IA à comprendre rapidement le contexte, la signification et les relations de votre contenu. Sans une implémentation correcte du schema, les crawlers IA doivent passer plus de temps à déduire la structure du contenu et à en extraire les informations clés. Ce temps de traitement supplémentaire réduit la vitesse d’indexation, car les crawlers allouent davantage de ressources par page.

La mise en place d’un balisage schema complet accélère l’indexation IA. Les schémas FAQ, How-To, Article et Produit fournissent aux systèmes IA des informations pré-structurées immédiatement compréhensibles et indexables. En incluant des informations sur l’auteur, la date de publication, les notes et autres données structurées, les systèmes IA peuvent catégoriser et indexer rapidement votre contenu sans traitement additionnel. Des études montrent que 36,6 % des mots-clés de recherche déclenchent des extraits enrichis issus du balisage schema, démontrant ainsi l’impact direct des données structurées sur la visibilité et la vitesse d’indexation IA.

Structure de maillage interne

Un maillage interne faible empêche les crawlers IA de découvrir efficacement votre contenu. Les liens internes agissent comme une carte qui guide les crawlers IA à travers l’architecture de votre site. Sans maillage interne stratégique, les systèmes IA peuvent avoir du mal à découvrir les pages importantes, notamment les nouveaux contenus enfouis profondément dans la structure de votre site. Ce retard de découverte se traduit directement par une indexation plus lente, car les crawlers doivent passer plus de temps à trouver les pages à indexer.

Un maillage interne stratégique accélère la découverte et l’indexation IA du contenu. Relier les nouveaux contenus à partir de pages existantes pertinentes aide les crawlers IA à les trouver et à les indexer plus rapidement. Utiliser un texte d’ancrage descriptif indiquant clairement le contenu de la page liée aide les systèmes IA à comprendre les relations et le contexte. Une structure de maillage interne appropriée garantit que les pages à forte valeur reçoivent davantage d’attention lors du crawl, ce qui accélère leur indexation et leur priorité dans les réponses générées par l’IA.

Expérience utilisateur et accessibilité du contenu

Une mauvaise expérience utilisateur signale aux systèmes IA que votre contenu pourrait ne pas être pertinent. Un taux de rebond élevé, une durée de session courte et des métriques d’engagement faibles indiquent aux crawlers IA que votre contenu ne répond pas aux besoins des utilisateurs. Les systèmes IA s’appuient de plus en plus sur les signaux comportementaux pour évaluer la qualité du contenu, et les pages à mauvaise UX reçoivent une priorité d’indexation plus faible. Lorsque les utilisateurs quittent rapidement vos pages, les systèmes IA interprètent cela comme un signe que le contenu manque de valeur, ralentissant son inclusion dans les réponses générées par l’IA.

Une structure de contenu conviviale améliore la vitesse d’indexation IA. Un contenu formaté avec des paragraphes courts (2-3 phrases), des sous-titres descriptifs, des listes à puces, des listes numérotées et des tableaux est plus facile à traiter tant pour les utilisateurs que pour les systèmes IA. Cette meilleure lisibilité permet aux crawlers IA d’extraire rapidement les informations clés et de comprendre la structure du contenu sans traitement supplémentaire. Lorsque votre contenu est bien organisé et accessible, les systèmes IA peuvent l’indexer plus rapidement et avec davantage de confiance dans sa qualité et sa pertinence.

Infrastructure d’hébergement et temps de réponse du serveur

Une infrastructure d’hébergement lente crée des goulets d’étranglement qui retardent l’indexation IA. Les environnements d’hébergement mutualisé disposent souvent de ressources limitées et de temps de réponse plus lents, ce qui oblige les crawlers IA à attendre plus longtemps pour charger chaque page. Ce temps d’attente réduit le nombre de pages indexables dans la fenêtre de temps allouée au crawler. Le temps de réponse du serveur affecte directement l’efficacité du crawl — chaque milliseconde de retard réduit le nombre total de pages indexées par session.

Passer à un hébergement rapide et évolutif accélère l’indexation IA. Les hébergeurs WordPress gérés, les solutions VPS et les plateformes cloud comme Google Cloud ou AWS offrent des temps de réponse serveur plus rapides et une meilleure allocation des ressources. Les CDN comme Cloudflare mettent en cache le contenu à l’échelle mondiale et servent les pages plus rapidement aux crawlers, quel que soit leur emplacement géographique. Lorsque votre infrastructure d’hébergement délivre rapidement les pages, les crawlers IA peuvent traiter plus de contenu par session, ce qui accélère l’indexation globale et améliore la visibilité dans les réponses générées par l’IA.

Suivi et optimisation

La surveillance continue des performances d’indexation IA permet une optimisation proactive. Des outils comme Google Search Console, l’AI Results Tracker de SE Ranking et Peec.ai vous aident à suivre la rapidité d’apparition de votre contenu dans les résultats de recherche IA et à identifier les pages non indexées. En surveillant ces métriques, vous pouvez détecter les goulots d’étranglement et mettre en œuvre des améliorations ciblées impactant directement la vitesse d’indexation.

Des audits et mises à jour réguliers maintiennent une vitesse d’indexation IA optimale. Réalisez périodiquement des audits de performance avec des outils comme Google PageSpeed Insights, GTmetrix et WebPageTest pour identifier les ralentissements. Mettez à jour régulièrement votre sitemap XML, rafraîchissez le contenu pour conserver les signaux de fraîcheur et optimisez en continu votre base de données et votre infrastructure. Une optimisation constante garantit que votre vitesse d’indexation IA reste compétitive et que votre contenu continue d’apparaître rapidement dans les réponses générées par l’IA.