Optimisation du budget de crawl pour l'IA

Découvrez comment optimiser le budget de crawl pour les bots IA comme GPTBot et Perplexity. Apprenez à gérer les ressources serveur, améliorer la visibilité dan...

Découvrez ce que signifie le budget de crawl pour l’IA, en quoi il diffère des budgets de crawl traditionnels des moteurs de recherche, et pourquoi il est essentiel pour la visibilité de votre marque dans les réponses générées par l’IA et les moteurs de recherche IA.

Le budget de crawl pour l'IA fait référence à la quantité de ressources et de temps que les robots d'IA (comme GPTBot, ClaudeBot et les bots Perplexity) allouent pour explorer et indexer votre site web. Il détermine combien de pages sont découvertes, à quelle fréquence elles sont visitées et, en fin de compte, si votre contenu apparaît dans les réponses générées par l'IA.

Le budget de crawl pour l’IA est fondamentalement différent du budget de crawl traditionnel de Google, mais tout aussi crucial pour votre visibilité en ligne. Alors que Googlebot a passé des décennies à affiner son comportement de crawl et à respecter la capacité des serveurs, les robots IA comme GPTBot, ClaudeBot et les bots Perplexity sont plus récents, plus agressifs, et souvent moins raffinés dans leur approche. Ces bots IA consomment une quantité sans précédent de bande passante et de ressources serveur, certains sites rapportant que les robots d’OpenAI sollicitent leur infrastructure 12 fois plus fréquemment que Google. Comprendre et gérer ce nouveau budget de crawl est essentiel pour les marques qui souhaitent apparaître dans les réponses générées par l’IA et conserver le contrôle sur l’utilisation de leur contenu par les systèmes d’intelligence artificielle.

Le concept de budget de crawl pour l’IA va au-delà de la simple découverte de pages. Il englobe l’allocation des ressources de calcul, de la bande passante et de la capacité serveur que les systèmes d’entraînement IA consacrent à l’exploration de votre site web. Contrairement aux moteurs de recherche traditionnels qui visent principalement à indexer et classer le contenu, les robots IA collectent des données d’entraînement, extraient des informations pour la génération de réponses et construisent des modèles de connaissance. Cela signifie que votre budget de crawl pour l’IA a un impact direct sur la visibilité des informations de votre marque auprès des systèmes IA utilisés quotidiennement par des millions d’utilisateurs, de ChatGPT aux Overviews IA de Google.

La distinction entre budget de crawl IA et budget de crawl traditionnel des moteurs de recherche est cruciale pour le SEO moderne et la stratégie de contenu. Le budget de crawl traditionnel, géré par Googlebot, fonctionne selon des protocoles établis et respecte les limites de capacité serveur grâce à des algorithmes sophistiqués développés depuis plus de vingt ans. Googlebot ralentit lorsqu’il détecte une surcharge serveur, suit fidèlement les directives du robots.txt, et se comporte généralement comme un “bon citoyen” du web. En revanche, les robots IA sont souvent moins sophistiqués dans leur gestion des ressources, crawlant de manière agressive sans toujours interpréter le contenu généré par JavaScript, et ne respectant pas systématiquement les règles du robots.txt avec la même constance que Google.

| Aspect | Budget de crawl des moteurs de recherche traditionnels | Budget de crawl pour l’IA |

|---|---|---|

| Objectif principal | Indexation pour le classement en recherche | Collecte de données d’entraînement et génération de réponses |

| Sophistication du robot | Très raffiné, plus de 20 ans d’optimisation | Plus récent, moins raffiné, plus agressif |

| Rendu JavaScript | Exécute JavaScript pour comprendre le contenu | Ignore souvent le JavaScript, ne prend que le HTML brut |

| Respect du robots.txt | Respect très fiable | Respect variable selon les fournisseurs d’IA |

| Prise en compte de la charge serveur | Ralentit activement pour éviter la surcharge | Moins attentif à la capacité serveur |

| Fréquence de crawl | Adaptative selon la fraîcheur du contenu | Souvent plus fréquente et consommatrice de ressources |

| Impact sur la visibilité | Détermine le classement et l’indexation en recherche | Détermine l’apparition dans les réponses générées par l’IA |

| Consommation de bande passante | Modérée et prévisible | Élevée et souvent imprévisible |

Ce tableau illustre pourquoi la gestion du budget de crawl IA exige une stratégie différente de celle de l’optimisation pour la recherche traditionnelle. Alors que vous pourriez bloquer certaines pages pour Googlebot afin de préserver votre budget de crawl, vous voudrez peut-être au contraire autoriser les robots IA à accéder à votre contenu le plus faisant autorité pour garantir son apparition dans les réponses d’IA. Les enjeux sont différents : le budget de crawl traditionnel influe sur la visibilité en recherche, tandis que le budget de crawl IA détermine si votre marque est citée comme source dans les réponses générées par l’IA.

L’émergence du budget de crawl IA comme indicateur clé reflète un changement fondamental dans la façon dont l’information est découverte et consommée en ligne. Le trafic des robots IA a augmenté de 96 % entre mai 2024 et mai 2025, avec la part de GPTBot passant de 5 % à 30 % du trafic total des robots. Cette croissance explosive signifie que les systèmes IA sont désormais en concurrence avec les moteurs de recherche traditionnels pour vos ressources serveur et votre bande passante. Pour de nombreux sites web, les robots IA consomment désormais plus de bande passante que Google, créant une nouvelle catégorie de défis techniques qui n’existaient pas il y a seulement deux ans.

L’importance de gérer le budget de crawl IA ne se limite pas aux performances serveur. Lorsque les robots IA découvrent et comprennent efficacement votre contenu, ils sont plus susceptibles de citer votre marque dans les réponses générées par l’IA. C’est particulièrement précieux pour l’Answer Engine Optimization (AEO), où l’objectif n’est plus seulement d’apparaître dans les résultats de recherche mais d’être sélectionné comme source dans les réponses IA. Si votre budget de crawl IA est gaspillé sur des pages à faible valeur, du contenu obsolète ou des pages mal rendues pour les systèmes IA, votre contenu le plus faisant autorité et le plus précieux risque de ne jamais atteindre les modèles IA qui génèrent des réponses pour des millions d’utilisateurs chaque jour.

Comprendre la mécanique du budget de crawl IA implique d’examiner ses deux composantes fondamentales : la limite de capacité de crawl et la demande de crawl. Ces éléments déterminent ensemble la quantité de contenu de votre site découverte et traitée par les systèmes IA.

La limite de capacité de crawl représente le plafond technique — le nombre maximum de connexions simultanées et de requêtes que les robots IA peuvent effectuer sur votre serveur sans dégrader ses performances. Cette limite dépend du temps de réponse de votre serveur, de la bande passante disponible et de sa capacité à gérer les requêtes concurrentes. Contrairement à Googlebot, qui surveille activement la santé du serveur et réduit son rythme en cas de surcharge, de nombreux robots IA sont moins attentifs à la capacité serveur, ce qui peut entraîner des pics de consommation de ressources inattendus. Si votre serveur répond lentement ou renvoie des erreurs, la limite de capacité de crawl peut être réduite, mais cela se produit de façon moins prévisible avec les bots IA qu’avec Google.

La demande de crawl pour les systèmes IA est dictée par d’autres facteurs que pour la recherche traditionnelle. Alors que la demande de crawl de Google dépend de la fraîcheur, la popularité et la qualité perçue du contenu, la demande de crawl IA est motivée par la valeur perçue de votre contenu pour l’entraînement et la génération de réponses. Les systèmes IA privilégient les contenus factuels, bien structurés, faisant autorité et pertinents pour les questions courantes. Si votre site offre des informations complètes et bien organisées sur des sujets nécessaires aux systèmes IA pour répondre aux requêtes des utilisateurs, votre demande de crawl sera plus élevée. À l’inverse, si votre contenu est faible, obsolète ou mal structuré, les robots IA peuvent délaisser votre site.

Les différences de comportement entre les robots IA et Googlebot ont des implications majeures sur la gestion de votre budget de crawl IA. Googlebot a évolué pour être très respectueux des ressources serveur et suit méticuleusement les standards du web. Il respecte les directives du robots.txt, comprend les balises canoniques, et gère activement son rythme de crawl pour éviter de surcharger les serveurs. Les robots IA, au contraire, fonctionnent souvent avec moins de sophistication et plus d’agressivité.

Beaucoup de robots IA n’exécutent pas le JavaScript, ce qui signifie qu’ils ne voient que le HTML brut servi initialement. C’est une distinction cruciale car si votre contenu essentiel est chargé via JavaScript, les robots IA risquent de ne pas le voir du tout. Ils récupèrent la réponse HTML initiale et passent à la suite, manquant des informations importantes que Googlebot découvrirait grâce à son Web Rendering Service. De plus, les robots IA sont moins constants dans le respect des règles du robots.txt. Bien que certains fournisseurs IA comme Anthropic publient des directives pour leurs robots, d’autres sont moins transparents sur leur comportement, rendant difficile la gestion du budget de crawl IA par les moyens traditionnels.

Les schémas de crawl des bots IA diffèrent aussi sensiblement. Certains robots IA, comme ClaudeBot, ont été observés effectuant un crawl avec un ratio très déséquilibré entre crawl et referral — pour chaque visiteur référé par Claude, le bot crawle des dizaines de milliers de pages. Cela signifie que les robots IA consomment une énorme part de votre budget de crawl tout en générant un trafic retour minime, créant un déséquilibre que les moteurs de recherche traditionnels n’exhibent pas à ce niveau.

La gestion efficace du budget de crawl IA nécessite une approche multi-niveaux qui équilibre la découverte de votre meilleur contenu par les systèmes IA avec la protection des ressources serveur et la prévention du gaspillage de crawl. La première étape consiste à identifier quels robots IA accèdent à votre site et à comprendre leurs schémas de comportement. Des outils comme Cloudflare Firewall Analytics permettent de filtrer le trafic par chaînes user-agent pour voir précisément quels bots IA visitent votre site et à quelle fréquence. En examinant vos logs serveur, vous pouvez déterminer si les robots IA investissent leur budget sur du contenu à forte valeur ou gaspillent des ressources sur des pages secondaires.

Une fois vos schémas de crawl IA compris, vous pouvez mettre en place des contrôles stratégiques pour optimiser votre budget de crawl. Cela peut inclure l’utilisation du robots.txt pour bloquer l’accès des robots IA à des sections à faible valeur telles que les résultats de recherche interne, la pagination au-delà des premières pages, ou le contenu d’archives obsolète. Cependant, cette stratégie doit être utilisée avec précaution — bloquer complètement les robots IA signifie que votre contenu n’apparaîtra pas dans les réponses générées par l’IA, ce qui peut représenter une perte importante de visibilité. Préférez donc le blocage sélectif de certains modèles d’URL ou répertoires pour préserver le budget de crawl pour votre contenu le plus important.

Les contrôles au niveau serveur constituent un autre levier puissant pour gérer le budget de crawl IA. En utilisant des règles de reverse proxy dans Nginx ou Apache, vous pouvez limiter spécifiquement le taux d’accès des robots IA à votre site. Cloudflare et des services similaires offrent des fonctionnalités de gestion des bots permettant de fixer des limites différentes selon les crawlers, garantissant que les bots IA ne monopolisent pas vos ressources serveur tout en leur permettant de découvrir vos contenus clés. Ces contrôles sont plus efficaces que le robots.txt car ils opèrent au niveau de l’infrastructure et ne dépendent pas du respect des directives par les robots.

La question de savoir s’il faut bloquer totalement les robots IA est l’une des décisions stratégiques les plus importantes pour les propriétaires de sites web aujourd’hui. La réponse dépend entièrement de votre modèle économique et de votre positionnement concurrentiel. Pour les éditeurs et marques qui dépendent fortement de la visibilité organique et souhaitent apparaître dans les réponses générées par l’IA, bloquer les robots IA est généralement contre-productif. Si vous empêchez les systèmes IA d’accéder à votre contenu, ce sont ceux de vos concurrents qui seront utilisés à la place, leur donnant potentiellement un avantage dans les résultats de recherche pilotés par l’IA.

Cependant, il existe des situations légitimes où le blocage de certains robots IA est justifié. Les contenus sensibles sur le plan juridique ou de la conformité doivent parfois être protégés de l’entraînement IA. Par exemple, un cabinet d’avocats disposant d’archives législatives anciennes pourrait ne pas vouloir que des systèmes IA citent des informations juridiques obsolètes susceptibles d’induire en erreur. De même, les informations propriétaires ou confidentielles doivent être bloquées pour éviter toute utilisation non autorisée. Certaines entreprises choisiront également de bloquer les robots IA si elles subissent une forte charge serveur sans bénéfice commercial clair lié à la visibilité IA.

L’approche la plus nuancée consiste au blocage sélectif — autoriser les robots IA à accéder à votre contenu le plus faisant autorité et le plus précieux, tout en les bloquant sur les sections secondaires. Cette stratégie maximise les chances que vos meilleurs contenus apparaissent dans les réponses IA tout en minimisant le gaspillage de budget sur des pages peu pertinentes. Vous pouvez appliquer cela via une configuration soignée du robots.txt, via la norme émergente llms.txt (encore peu adoptée), ou via des contrôles serveur permettant différents niveaux d’accès selon les robots.

Au-delà de la gestion de l’allocation du budget de crawl, il convient d’optimiser votre contenu pour qu’il soit facilement découvert et compris par les robots IA. Cela implique plusieurs considérations techniques et éditoriales. Premièrement, assurez-vous que votre contenu critique est présent dans le HTML statique plutôt que généré via JavaScript. Puisque de nombreux robots IA n’exécutent pas JavaScript, le contenu chargé dynamiquement après le rendu de la page leur sera invisible. Le rendu côté serveur (SSR) ou la génération de HTML statique garantit que les robots IA voient l’intégralité de votre contenu dès la première requête.

Les balises de données structurées sont de plus en plus importantes pour les robots IA. Utiliser le balisage Schema.org pour FAQPage, HowTo, Article et autres types pertinents aide les systèmes IA à comprendre rapidement l’objectif et le contenu de vos pages. Ces informations structurées facilitent l’extraction de réponses et la citation correcte de votre contenu. En fournissant une structure claire et lisible par machine, vous augmentez la valeur de votre contenu pour les systèmes IA, et la probabilité qu’ils privilégient le crawl et la citation de vos pages.

La clarté du contenu et l’exactitude des faits influent directement sur la façon dont l’IA traite votre contenu. Les robots IA recherchent des informations fiables, bien sourcées, pouvant servir à générer des réponses exactes. Si votre contenu est superficiel, contradictoire ou mal organisé, il sera dépriorisé. À l’inverse, un contenu approfondi, bien documenté, avec un formatage clair, des listes à puces et une structure logique, a plus de chances d’être crawlé fréquemment et cité dans les réponses IA. Cela signifie que l’optimisation du budget de crawl IA est indissociable de l’optimisation de la qualité de contenu.

La gestion efficace du budget de crawl IA nécessite une surveillance et une mesure continue. Google Search Console fournit des données précieuses sur l’activité de crawl traditionnelle, mais n’offre pas encore d’informations détaillées sur le comportement des robots IA. Il faut donc s’appuyer sur l’analyse des logs serveur pour comprendre comment les bots IA interagissent avec votre site. Des outils comme Log File Analyzer de Screaming Frog ou des solutions d’entreprise comme Splunk permettent de filtrer les logs pour isoler les requêtes des robots IA et analyser leurs schémas.

Les indicateurs clés à surveiller incluent :

En suivant ces indicateurs dans le temps, vous pouvez identifier des tendances et prendre des décisions éclairées pour optimiser votre budget de crawl IA. Si vous constatez que les robots IA passent 80 % de leur temps sur des pages à faible valeur, vous pouvez appliquer des blocages robots.txt ou des contrôles serveur pour réorienter ce budget vers votre contenu le plus stratégique.

À mesure que les systèmes IA deviennent plus sophistiqués et omniprésents, gérer le budget de crawl IA sera aussi important que gérer le budget de crawl traditionnel. L’émergence de nouveaux robots IA, l’agressivité croissante des existants, et l’importance grandissante des réponses générées par l’IA dans les moteurs de recherche annoncent un futur où l’optimisation du budget de crawl IA sera un pilier du SEO technique.

Le développement de standards comme llms.txt (similaire à robots.txt mais spécifique aux robots IA) offrira peut-être des outils plus efficaces pour la gestion du budget de crawl IA. Toutefois, l’adoption reste limitée à ce jour et il n’est pas certain que tous les fournisseurs IA respecteront ces standards. En attendant, les contrôles au niveau serveur et l’optimisation stratégique du contenu restent les leviers les plus fiables pour gérer l’interaction des systèmes IA avec votre site.

L’avantage concurrentiel ira aux marques qui prennent en main leur budget de crawl IA, veillant à ce que leur meilleur contenu soit découvert et cité par les systèmes IA tout en protégeant leurs ressources serveur du gaspillage. Cela nécessite une combinaison de mise en œuvre technique, d’optimisation de contenu et de surveillance continue — mais le gain en visibilité dans les réponses générées par l’IA en vaut largement l’effort.

Suivez la manière dont votre contenu apparaît dans les réponses générées par l'IA sur ChatGPT, Perplexity et d'autres moteurs de recherche IA. Assurez-vous que votre marque bénéficie d'une visibilité adéquate là où les systèmes d'IA citent des sources.

Découvrez comment optimiser le budget de crawl pour les bots IA comme GPTBot et Perplexity. Apprenez à gérer les ressources serveur, améliorer la visibilité dan...

Discussion communautaire sur la gestion du budget de crawl des IA. Comment traiter GPTBot, ClaudeBot et PerplexityBot sans sacrifier la visibilité.

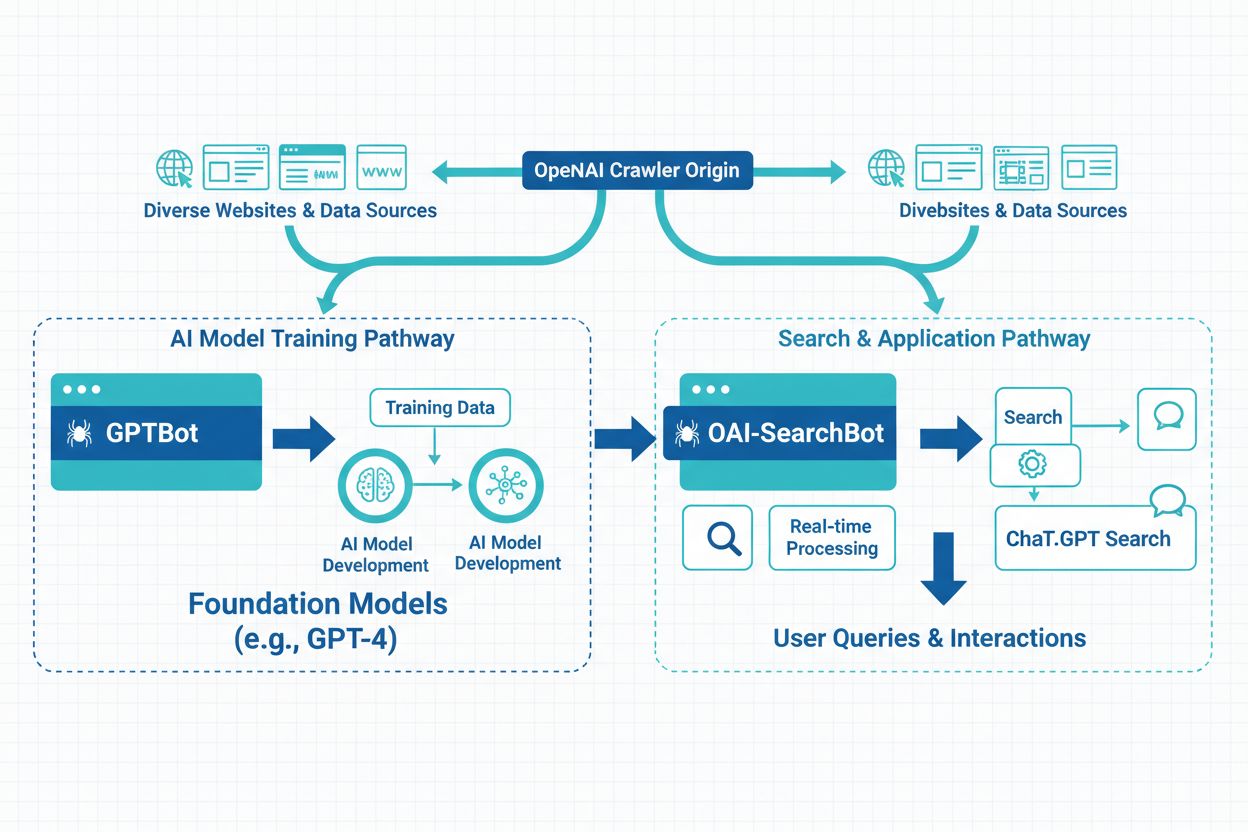

Découvrez les principales différences entre les crawlers GPTBot et OAI-SearchBot. Comprenez leurs objectifs, leurs comportements d'exploration et comment les gé...