GPTBot

Découvrez ce qu’est GPTBot, son fonctionnement et s’il faut le bloquer sur votre site web. Comprenez l’impact sur le SEO, la charge serveur et la visibilité de ...

Découvrez ce qu’est GPTBot, comment il fonctionne et s’il faut autoriser ou bloquer le robot d’exploration web d’OpenAI. Comprenez l’impact sur la visibilité de votre marque dans les moteurs de recherche IA et ChatGPT.

GPTBot est le robot d'exploration web d'OpenAI qui collecte des données sur les sites web accessibles au public afin d'entraîner des modèles d'IA comme ChatGPT. L'autoriser ou non dépend de vos priorités : autorisez-le pour une meilleure visibilité de votre marque dans les résultats de recherche IA et les réponses de ChatGPT, ou bloquez-le si vous avez des préoccupations concernant l'utilisation de votre contenu, la propriété intellectuelle ou les ressources de votre serveur.

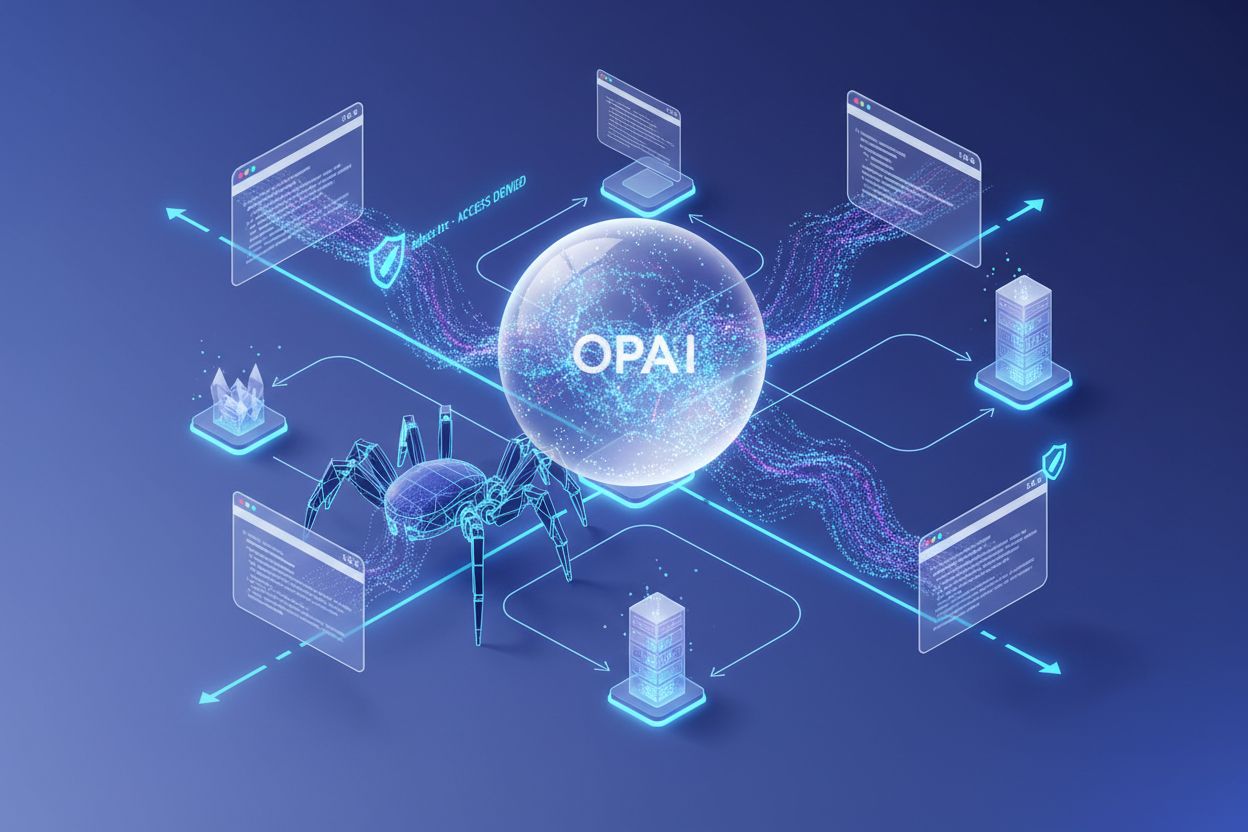

GPTBot est le robot d’exploration web officiel d’OpenAI conçu pour scanner systématiquement les sites web accessibles au public et collecter des données afin d’entraîner des modèles de langage tels que ChatGPT et GPT-4. Contrairement aux robots d’exploration des moteurs de recherche traditionnels comme Googlebot, qui indexent le contenu pour les résultats de recherche, GPTBot a un objectif fondamentalement différent : rassembler des informations pour améliorer la compréhension par l’IA des modèles de langage, des événements actuels et des connaissances du monde réel. Lorsque GPTBot visite votre site web, il s’identifie avec une chaîne user agent claire qui apparaît dans vos journaux de serveur sous la forme Mozilla/5.0 AppleWebKit/537.36 (KHTML, like Gecko; compatible; GPTBot/1.3; +https://openai.com/gptbot), ce qui permet aux webmasters de reconnaître et de surveiller facilement son activité.

Le robot fonctionne avec transparence et respecte les normes web établies. Avant d’accéder à tout contenu de votre site, GPTBot vérifie votre fichier robots.txt, qui est le mécanisme standard utilisé par les webmasters pour indiquer aux robots automatisés quelles parties de leur site peuvent ou non être consultées. Si vous incluez une règle de refus pour GPTBot dans votre fichier robots.txt, le robot respectera votre préférence et s’abstiendra d’accéder à votre site. Cette conformité volontaire au robots.txt démontre l’engagement d’OpenAI envers des pratiques de crawl responsables, bien qu’il soit important de noter que l’application de ces règles dépend en fin de compte de l’intégrité de l’opérateur du robot.

GPTBot n’explore que le contenu accessible au public et ne peut pas contourner les paywalls, pages de connexion ou sections restreintes de votre site. Le robot n’essaie pas d’accéder à des informations privées, des zones authentifiées ou du contenu marqué comme privé. Cette limitation signifie que les données sensibles, le contenu réservé aux membres et les contenus par abonnement restent protégés de GPTBot. Les informations recueillies par GPTBot sont utilisées exclusivement pour améliorer la compréhension de l’IA en matière de langage, de contexte et d’actualité, sans impact direct sur votre classement dans les moteurs de recherche traditionnels ni sur la manière dont votre site apparaît dans les résultats de recherche Google.

Des données récentes révèlent la montée spectaculaire de GPTBot comme force dominante du crawl web. Entre mai 2024 et mai 2025, la part de GPTBot dans le trafic des robots IA est passée de seulement 5 % à 30 %, soit une augmentation stupéfiante de 305 % du nombre de requêtes. Cette croissance explosive reflète l’investissement massif d’OpenAI dans la collecte de données d’entraînement et l’importance croissante des modèles d’IA dans l’écosystème numérique. GPTBot est devenu le deuxième robot le plus bloqué sur le web aujourd’hui et le robot le plus bloqué via les fichiers robots.txt, avec plus de 3,5 % des sites web mettant actuellement en place des règles de blocage à son encontre.

Les grands éditeurs et créateurs de contenu ont remarqué cette tendance. Le New York Times, CNN et plus de 30 des 100 plus grands sites web ont déjà mis en place des règles de blocage contre GPTBot, signe de préoccupations croissantes concernant l’utilisation des contenus et les droits de propriété intellectuelle. Cependant, cette tendance au blocage ne raconte pas toute l’histoire. Alors que certains sites considèrent GPTBot comme une menace pour leur modèle économique, d’autres y voient l’opportunité de s’assurer que leur contenu atteigne les milliards d’utilisateurs qui interagissent chaque jour avec ChatGPT et d’autres systèmes d’IA. La décision d’autoriser ou de bloquer GPTBot est devenue un choix stratégique qui reflète les valeurs, le modèle économique et la vision à long terme de chaque organisation pour sa présence numérique.

| Indicateur | Valeur | Signification |

|---|---|---|

| Croissance de GPTBot (mai 2024 - mai 2025) | +305% | Robot IA à la croissance la plus rapide |

| Part actuelle du trafic des robots IA | 30% | Robot IA dominant en volume |

| Sites bloquant GPTBot | 3,5%+ | Deuxième robot le plus bloqué |

| Top 100 sites bloquant | 30+ | Grands éditeurs bloquant l’accès |

| Utilisateurs hebdomadaires de ChatGPT | 800 millions | Portée potentielle de l’audience |

Les propriétaires de sites choisissent de bloquer GPTBot pour plusieurs raisons légitimes et interconnectées, reflétant de réelles préoccupations concernant l’utilisation du contenu, la viabilité de leur activité et la protection des données. La préoccupation la plus importante porte sur l’utilisation du contenu sans compensation. Publier du contenu de qualité demande du temps, des ressources et de l’expertise. Lorsque les systèmes d’IA extraient ce travail pour entraîner des modèles qui répondent aux questions des utilisateurs—souvent sans renvoyer vers la source d’origine—l’arrangement semble fondamentalement injuste pour de nombreux créateurs de contenu. Cette inquiétude est particulièrement aiguë chez les éditeurs, journalistes et créateurs spécialisés qui dépendent du trafic et de l’attribution pour faire vivre leur activité. On craint qu’à mesure que les IA deviendront plus aptes à répondre directement aux questions, les internautes soient moins incités à visiter les sites d’origine, ce qui éroderait le trafic et la valeur de l’investissement initial dans le contenu.

La sécurité et les ressources serveur constituent un autre facteur important dans la décision de blocage. Bien que GPTBot respecte les règles du robots.txt comme les autres robots, des questions subsistent quant à l’impact cumulé de multiples robots IA accédant simultanément à votre contenu. Les robots comme GPTBot et ClaudeBot peuvent consommer une bande passante importante, certains sites signalant des pics allant jusqu’à 30 téraoctets de trafic, ce qui met à rude épreuve les serveurs—en particulier dans les environnements mutualisés. Même si GPTBot n’est pas malveillant en soi, l’ajout d’un système automatisé supplémentaire complexifie la surveillance du site, la configuration des pare-feux et la gestion des robots. Il existe également une inquiétude concernant l’exposition de données par recoupement, où des contenus en apparence anodins révèlent plus que prévu lorsqu’ils sont combinés et analysés par des systèmes d’apprentissage automatique.

L’incertitude juridique ajoute une autre source d’hésitation pour de nombreux propriétaires de sites. Les outils pilotés par l’IA comme GPTBot évoluent dans une zone grise concernant la protection des données, le droit d’auteur et la propriété intellectuelle. Certains marketeurs craignent qu’autoriser GPTBot à extraire du contenu puisse involontairement enfreindre des réglementations telles que le RGPD ou le CCPA, notamment si des données personnelles ou du contenu généré par les utilisateurs sont concernés. Même si le contenu est accessible publiquement, le débat juridique sur le fair use dans l’entraînement des IA n’est pas tranché. L’angle de la propriété intellectuelle ajoute une couche de complexité : si vos écrits originaux se retrouvent paraphrasés dans une réponse de ChatGPT, à qui appartient ce résultat ? Pour l’heure, aucun précédent juridique clair ne répond à cette question. Pour les marques opérant dans des secteurs réglementés comme la finance, la santé ou le droit, l’approche conservatrice consistant à bloquer l’accès pendant que le cadre juridique évolue fait sens stratégiquement.

Malgré les préoccupations légitimes liées au blocage, il existe des raisons convaincantes d’autoriser GPTBot à accéder à votre contenu. L’avantage le plus important est la visibilité de votre marque dans ChatGPT et dans les résultats de recherche IA. ChatGPT compte environ 800 millions d’utilisateurs hebdomadaires et traite des milliards de requêtes chaque mois. Nombre de ces utilisateurs posent des questions auxquelles votre contenu peut répondre. Si GPTBot ne peut pas accéder à votre site, le modèle s’appuie sur des informations de seconde main ou des sources obsolètes pour parler de votre marque, de vos produits ou de votre expertise. Cela représente une opportunité manquée et un risque potentiel pour votre réputation. Autoriser GPTBot à explorer votre contenu aide à garantir que les réponses de ChatGPT reflètent fidèlement vos messages, offres et expertise. C’est en quelque sorte de la gestion de réputation automatisée—votre contenu est représenté dans l’un des systèmes d’IA les plus utilisés au monde.

Le trafic de recherche IA convertit bien mieux que le trafic organique traditionnel. Les premières données montrent que les visiteurs provenant des plateformes de recherche IA convertissent 23 fois mieux que les visiteurs issus de la recherche organique classique. Si la recherche IA représente aujourd’hui moins de 1 % du trafic web total, la qualité de ces visites est parlante. Les utilisateurs de la recherche IA arrivent généralement à un stade avancé de leur parcours de décision. Ils ont déjà utilisé l’IA pour rechercher des options, comparer des caractéristiques et réduire leurs choix avant de cliquer sur votre site. Cela signifie qu’ils sont plus qualifiés, mieux informés, et plus susceptibles de devenir clients ou d’accomplir les actions souhaitées. À mesure que les outils IA deviendront un moyen privilégié de rechercher, découvrir et consommer du contenu, ignorer la recherche IA pourrait signifier prendre du retard sur la concurrence qui optimise activement ce canal émergent.

Préparer l’avenir de votre présence numérique est un autre aspect crucial. À mesure que les outils IA deviennent centraux dans la découverte d’informations, bloquer les robots IA peut signifier sortir du futur de la recherche. L’optimisation pour les moteurs génératifs représente la prochaine évolution de la visibilité en ligne, et ChatGPT représente plus de 80 % du trafic de référencement IA, rendant le robot d’OpenAI particulièrement important pour la visibilité à long terme. Le web et la recherche évoluent rapidement, et les organisations qui se positionnent dès maintenant pour faire partie de l’écosystème IA bénéficieront d’avantages significatifs à mesure que ces technologies mûriront et deviendront centrales dans la manière dont les internautes trouvent l’information.

Bloquer GPTBot est simple et réversible via votre fichier robots.txt, qui est le mécanisme standard pour communiquer avec les robots d’exploration. Pour bloquer complètement GPTBot de votre site, ajoutez ces lignes à votre fichier robots.txt :

User-agent: GPTBot

Disallow: /

Cela indique au robot d’OpenAI d’éviter l’intégralité de votre site. Si vous souhaitez un contrôle plus fin, vous pouvez autoriser un accès partiel en remplaçant le / par des répertoires ou pages spécifiques à rendre disponibles. Par exemple, pour bloquer GPTBot sur votre répertoire /private/ tout en autorisant l’accès au reste de votre site :

User-agent: GPTBot

Disallow: /private/

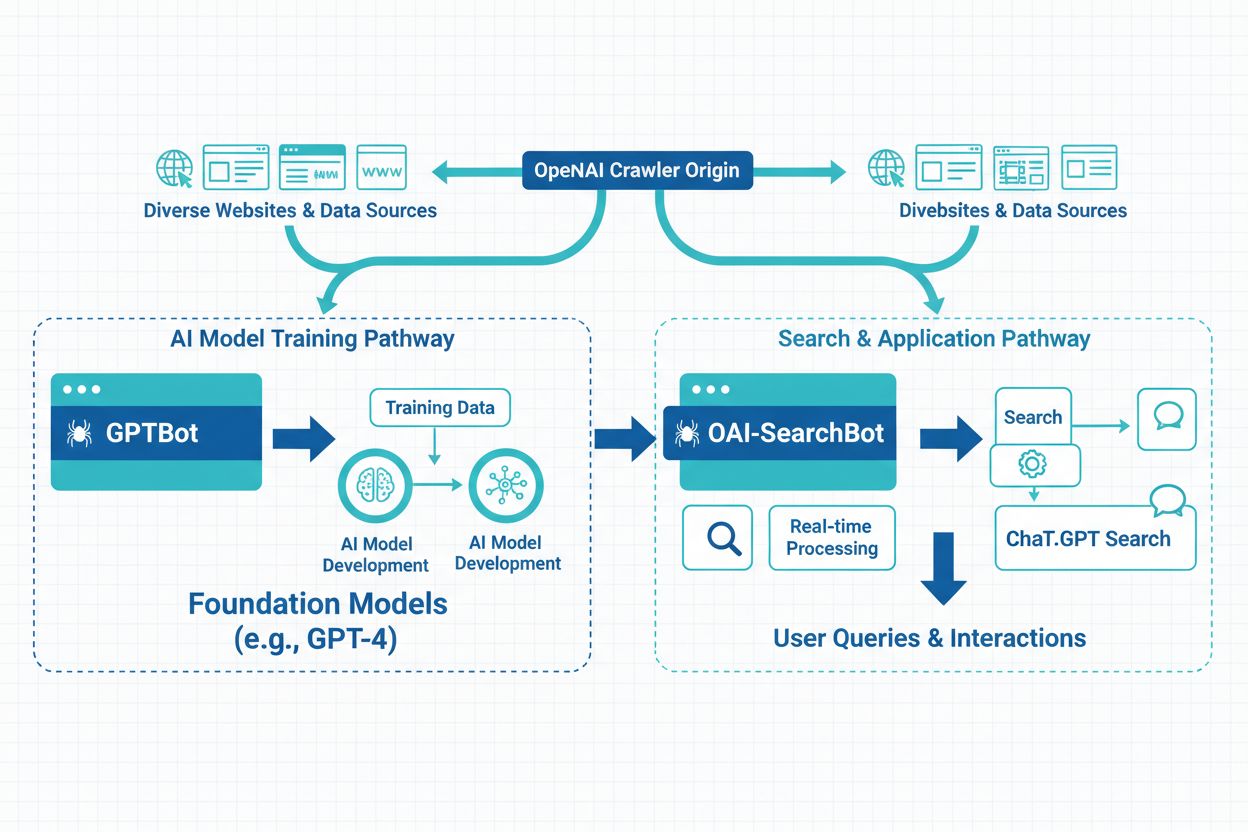

Si vous souhaitez bloquer toutes les activités d’exploration liées à OpenAI, ajoutez des règles pour les trois robots qu’OpenAI exploite :

User-agent: GPTBot

Disallow: /

User-agent: ChatGPT-User

Disallow: /

User-agent: OAI-SearchBot

Disallow: /

D’autres méthodes de blocage offrent un contrôle encore plus poussé mais requièrent davantage de compétences techniques. Le blocage par IP permet de refuser les plages d’adresses IP d’OpenAI via votre pare-feu serveur ou panneau d’administration, mais il faut maintenir la liste IP à jour au gré de l’évolution de l’infrastructure d’OpenAI. La limitation de débit (rate limiting) restreint le nombre de requêtes par minute ou par heure pour éviter la surcharge serveur. Les pare-feux applicatifs web (WAF) mettent en place des règles de blocage côté serveur selon l’adresse IP du robot ou la chaîne user agent, offrant un contrôle plus sophistiqué du trafic de robots. Vous pouvez surveiller l’activité des robots dans vos journaux serveur ou via des outils comme Cloudflare ou Google Search Console pour vérifier que GPTBot respecte vos instructions.

Certains secteurs ont des raisons particulièrement fortes de limiter l’accès des robots pour protéger données, revenus et intérêts des utilisateurs. Les entreprises de presse et de médias voient leur modèle économique directement menacé, car elles dépendent du trafic et des revenus publicitaires. Les éditeurs souhaitent que les internautes visitent leur site directement, et non via des résumés générés par une IA. Des exemples majeurs incluent le New York Times, Associated Press et Reuters, qui ont tous mis en place des règles de blocage. Les plateformes e-commerce protègent descriptions de produits uniques et tarifications des concurrents et outils de scraping, préservant ainsi leur avantage compétitif. Les plateformes de contenu généré par les utilisateurs comme Reddit protègent les contenus communautaires et les données sous licence d’une extraction non contrôlée qui pourrait déprécier leurs actifs. Les sites de données à haute autorité dans des secteurs sensibles comme le droit, la médecine ou la finance contrôlent l’accès à des contenus spécialisés à base de recherche pour rester en conformité et protéger leurs informations propriétaires.

Vous pouvez vérifier si GPTBot visite votre site de plusieurs façons. L’examen des journaux serveur est la méthode la plus directe—recherchez les chaînes user agent contenant “GPTBot” dans vos journaux d’accès pour voir quand et à quelle fréquence le robot visite votre site. L’utilisation d’outils d’analyse est une autre possibilité, beaucoup de plateformes d’analyse affichant le trafic des robots et permettant un filtrage par user agent pour une identification simple. Les logiciels de suivi SEO rapportent l’activité des robots, y compris ceux d’OpenAI, ce qui vous donne une visibilité sur la fréquence d’accès de GPTBot à votre contenu. Une surveillance régulière vous aide à comprendre la fréquence des visites de GPTBot et si le robot impacte la performance de votre site. Si vous constatez de l’activité de GPTBot et souhaitez contrôler l’accès, vous pouvez facilement gérer les permissions via votre fichier robots.txt ou mettre en place des blocages plus sophistiqués via votre hébergeur ou votre pare-feu applicatif web.

La décision d’autoriser ou de bloquer GPTBot doit être alignée sur vos objectifs d’entreprise, votre stratégie de contenu et votre vision à long terme. Bloquez GPTBot si vous publiez du contenu propriétaire ou opérez dans un secteur fortement réglementé où la protection des données est primordiale, si vous n’êtes pas prêt à alimenter l’écosystème IA et préférez garder le contrôle total de l’utilisation de votre contenu, si vous privilégiez le contrôle du contenu, la conformité légale ou la sécurité à la visibilité IA potentielle, si vos ressources serveur sont limitées et que le trafic des robots cause des problèmes de performance mesurables, ou si vous avez de fortes inquiétudes concernant la propriété intellectuelle et les droits sur votre contenu. Autorisez GPTBot si vous souhaitez augmenter votre visibilité à l’ère de l’IA, l’influence et la pertinence de votre marque sur les plateformes génératives, si vous souhaitez une représentation fidèle de votre marque auprès des 800 millions d’utilisateurs hebdomadaires de ChatGPT, si vous construisez pour l’avenir et souhaitez faire partie de l’écosystème de recherche IA, si vous voulez améliorer l’optimisation générative de votre site et capter le trafic IA très qualifié, ou si vous visez la visibilité et la portée à long terme de votre marque dans un environnement numérique de plus en plus piloté par l’IA.

Le web et la recherche évoluent rapidement, et quoi qu’il en soit, vous devez décider de la place de votre contenu dans ce futur et agir en conséquence. Le choix entre autoriser et bloquer GPTBot n’est pas définitif—vous pouvez modifier votre fichier robots.txt à tout moment pour changer de préférence. L’essentiel est de prendre une décision éclairée en fonction de vos priorités métier, de comprendre les implications pour la visibilité de votre marque dans les systèmes IA, et de surveiller les résultats de votre choix dans le temps.

Suivez la façon dont votre marque apparaît dans ChatGPT, Perplexity et d'autres générateurs de réponses IA. Obtenez des informations en temps réel sur votre visibilité dans la recherche IA et optimisez votre stratégie de contenu.

Découvrez ce qu’est GPTBot, son fonctionnement et s’il faut le bloquer sur votre site web. Comprenez l’impact sur le SEO, la charge serveur et la visibilité de ...

Découvrez les principales différences entre les crawlers GPTBot et OAI-SearchBot. Comprenez leurs objectifs, leurs comportements d'exploration et comment les gé...

Découvrez ce qu'est OAI-SearchBot, comment il fonctionne et comment optimiser votre site web pour le robot de recherche dédié d'OpenAI utilisé par SearchGPT et ...