Sélection des sources par l'IA

Découvrez comment les systèmes d'IA sélectionnent et classent les sources à citer. Découvrez les algorithmes, signaux et facteurs qui déterminent quels sites we...

Découvrez le biais de sélection des sources en IA, son impact sur les modèles d’apprentissage automatique, des exemples concrets et les stratégies pour détecter et atténuer ce problème critique d’équité.

Le biais de sélection des sources survient lorsque les données d'entraînement ne sont pas représentatives de la population globale ou de la distribution réelle, ce qui conduit les modèles d'IA à formuler des prédictions inexactes pour des groupes ou des scénarios sous-représentés.

Le biais de sélection des sources est un problème fondamental en intelligence artificielle qui se produit lorsque les données utilisées pour entraîner les modèles d’apprentissage automatique ne représentent pas fidèlement la population réelle ou la distribution pour laquelle ils sont conçus. Ce type de biais apparaît lorsque les ensembles de données sont choisis de manière à exclure ou sous-représenter systématiquement certains groupes, scénarios ou caractéristiques. La conséquence est que les modèles d’IA apprennent des schémas à partir de données incomplètes ou biaisées, ce qui conduit à des prédictions inexactes, injustes ou discriminatoires envers les populations sous-représentées. Comprendre ce biais est essentiel pour toute personne développant, déployant ou utilisant des systèmes d’IA, car il affecte directement l’équité, la précision et la fiabilité de la prise de décision automatisée dans tous les secteurs.

Le biais de sélection des sources se distingue des autres formes de biais car il trouve son origine dès l’étape de la collecte des données. Plutôt que d’émerger à partir de choix algorithmiques ou d’hypothèses humaines lors du développement du modèle, le biais de sélection des sources est ancré dans la base même de l’ensemble de données d’entraînement. Cela le rend particulièrement insidieux, car les modèles entraînés sur des données sources biaisées vont perpétuer et amplifier ces biais dans leurs prédictions, quel que soit le degré de sophistication de l’algorithme. Le problème devient encore plus critique lorsque les systèmes d’IA sont déployés dans des domaines sensibles comme la santé, la finance, la justice pénale ou le recrutement, où des prédictions biaisées peuvent avoir de graves conséquences pour les individus et les communautés.

Le biais de sélection des sources se développe à travers plusieurs mécanismes distincts lors du processus de collecte et de curation des données. Le chemin le plus courant passe par le biais de couverture, où certaines populations ou scénarios sont systématiquement exclus de l’ensemble de données d’entraînement. Par exemple, si un système de reconnaissance faciale est principalement entraîné sur des images de personnes à la peau claire, il aura une couverture médiocre des visages à la peau foncée, ce qui entraînera des taux d’erreur plus élevés pour ces populations. Cela se produit parce que les collecteurs de données peuvent avoir un accès limité à des populations diverses, ou bien ils peuvent inconsciemment privilégier certains groupes lors de la collecte.

Un autre mécanisme critique est le biais de non-réponse, également appelé biais de participation, qui survient lorsque certains groupes sont moins susceptibles de participer aux processus de collecte de données. Prenons l’exemple d’un ensemble de données basé sur des enquêtes pour prédire les préférences des consommateurs : si certains groupes démographiques sont significativement moins enclins à répondre aux enquêtes, leurs préférences seront sous-représentées dans les données d’entraînement. Cela crée un ensemble de données qui semble équilibré mais reflète en réalité les schémas de participation plutôt que les caractéristiques réelles de la population. En santé, par exemple, si les données d’essais cliniques proviennent principalement de populations urbaines disposant d’un accès à des infrastructures médicales avancées, les modèles d’IA qui en résultent peuvent ne pas bien se généraliser aux communautés rurales ou mal desservies.

Le biais d’échantillonnage représente un troisième mécanisme où la randomisation appropriée n’est pas utilisée lors de la collecte des données. Au lieu de sélectionner aléatoirement les points de données, les collecteurs peuvent choisir les premiers échantillons disponibles ou utiliser des méthodes d’échantillonnage de commodité. Cela introduit des erreurs systématiques car les échantillons choisis ne sont pas représentatifs de la population globale. Par exemple, si un modèle d’IA de prédiction des défauts de crédit est entraîné sur des données collectées dans une région géographique ou une période spécifique, il peut ne pas prédire précisément les défauts dans d’autres régions ou dans des conditions économiques différentes.

| Type de biais | Mécanisme | Exemple concret |

|---|---|---|

| Biais de couverture | Exclusion systématique de populations | Reconnaissance faciale entraînée uniquement sur des visages à peau claire |

| Biais de non-réponse | Écarts de participation lors de la collecte de données | Modèles de santé entraînés uniquement sur des populations urbaines |

| Biais d’échantillonnage | Mauvaise randomisation lors de la sélection | Modèles de prédiction de prêts formés sur une seule région géographique |

| Biais temporel | Données provenant de périodes spécifiques | Modèles entraînés sur des données pré-pandémiques appliqués après la pandémie |

| Biais de diversité des sources | Sources de données limitées | Jeux de données d’imagerie médicale provenant d’un seul système hospitalier |

Les conséquences du biais de sélection des sources dans les systèmes d’IA sont profondes et étendues, affectant à la fois les individus et les organisations. Dans le domaine de la santé, ce biais a conduit à des systèmes de diagnostic qui fonctionnent nettement moins bien pour certains groupes de patients. Des recherches ont montré que les algorithmes d’IA pour le diagnostic du cancer de la peau présentent une précision nettement inférieure pour les patients à la peau foncée, certaines études indiquant seulement la moitié de la précision diagnostique par rapport aux patients à la peau claire. Cette disparité se traduit directement par des diagnostics retardés, des recommandations de traitement inadaptées et de moins bons résultats sanitaires pour les populations sous-représentées. Lorsque les données d’entraînement proviennent majoritairement d’un groupe démographique, les modèles qui en résultent apprennent des schémas propres à ce groupe et échouent à se généraliser aux autres.

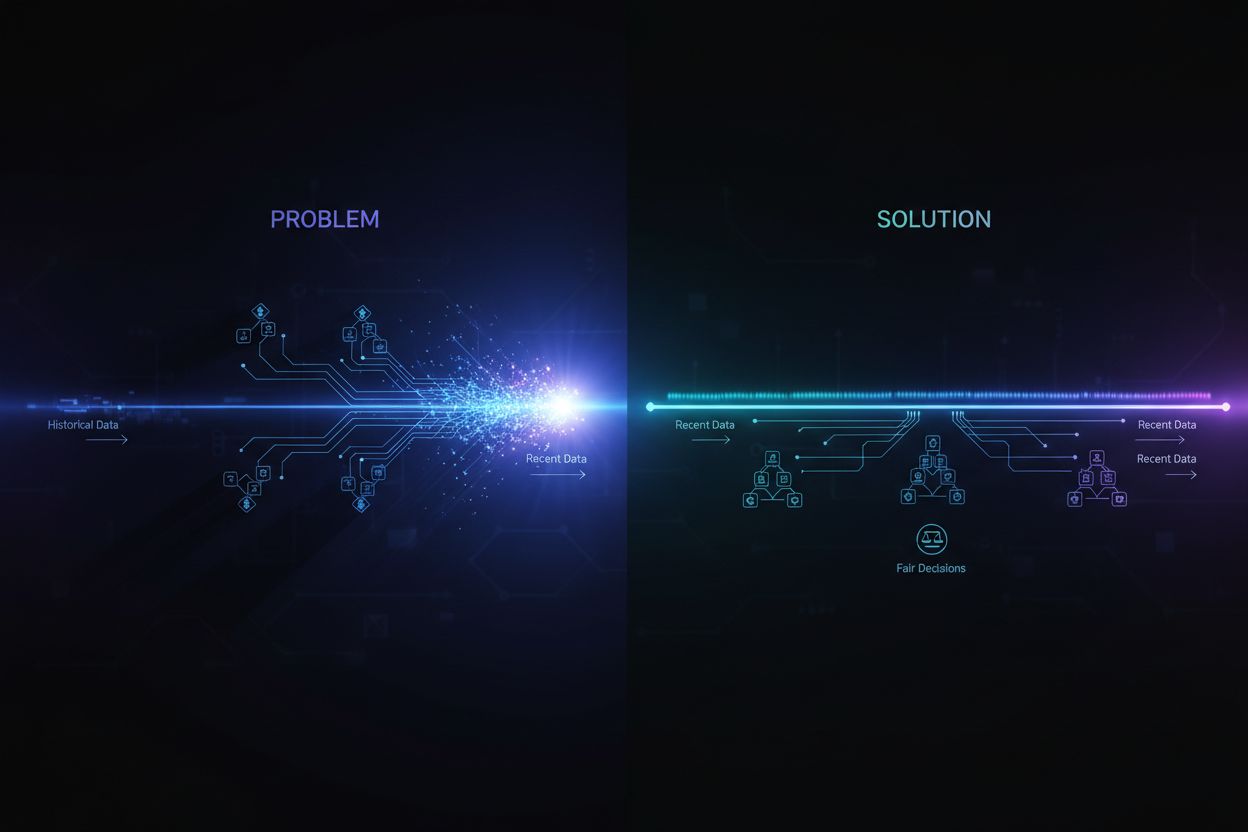

Dans les services financiers, le biais de sélection des sources dans les algorithmes de scoring de crédit et de prêt a perpétué la discrimination historique. Les modèles formés sur des données d’approbation de prêts reflétant des pratiques discriminatoires passées reproduiront ces mêmes biais lors de nouvelles décisions de prêt. Si certains groupes ont historiquement été privés de crédit en raison d’une discrimination systémique, et que ces données historiques servent à entraîner les modèles d’IA, ceux-ci apprendront à refuser le crédit à des groupes similaires à l’avenir. Cela crée un cercle vicieux où les inégalités historiques s’ancrent dans la prise de décision algorithmique, affectant l’accès au capital et aux opportunités économiques.

Le recrutement et l’embauche constituent un autre domaine critique où le biais de sélection des sources cause des préjudices importants. Des outils d’IA utilisés pour le tri de CV se sont révélés biaisés selon la race ou le genre perçus, certaines études montrant que les noms associés à des personnes blanches étaient favorisés dans 85% des cas dans certains systèmes. Lorsque les données d’entraînement proviennent d’historiques d’embauche reflétant des discriminations ou des schémas homogènes, les modèles d’IA qui en résultent apprennent à reproduire ces biais. Le biais de sélection des sources dans les données de recrutement perpétue donc la discrimination à grande échelle et limite la diversité au sein des entreprises.

Dans la justice pénale, le biais de sélection des sources dans les systèmes de police prédictive a conduit à un ciblage disproportionné de certaines communautés. Lorsque les données d’entraînement proviennent d’historiques d’arrestations eux-mêmes biaisés contre des groupes marginalisés, les modèles qui en résultent amplifient ces biais en prédisant des taux de criminalité plus élevés dans ces communautés. Cela crée une boucle de rétroaction où des prédictions biaisées entraînent une surveillance policière accrue dans certaines zones, ce qui génère plus de données d’arrestations dans ces mêmes endroits, renforçant encore le biais du modèle.

Détecter le biais de sélection des sources nécessite une approche systématique combinant analyse quantitative, évaluation qualitative et surveillance continue tout au long du cycle de vie du modèle. La première étape consiste à réaliser un audit complet des données qui examine les sources, les méthodes de collecte et la représentativité de vos données d’entraînement. Cela implique de documenter l’origine des données, la manière dont elles ont été collectées et si le processus de collecte a pu exclure systématiquement certaines populations ou scénarios. Posez des questions critiques : tous les groupes démographiques pertinents étaient-ils représentés lors de la collecte ? Y avait-il des obstacles à la participation qui ont pu décourager certains groupes ? La période de collecte ou la portée géographique ont-elles limité la représentativité ?

L’analyse de la parité démographique offre une approche quantitative pour détecter ce biais. Elle consiste à comparer la distribution des caractéristiques clés dans vos données d’entraînement à celle de la population réelle ciblée par votre modèle. Si vos données sous-représentent significativement certains groupes démographiques, tranches d’âge, régions géographiques ou autres caractéristiques pertinentes, vous avez la preuve d’un biais de sélection des sources. Par exemple, si vos données comportent seulement 5% de femmes alors que la population cible en compte 50%, cela indique un sérieux biais de couverture susceptible d’entraîner de mauvaises performances pour les femmes.

L’analyse de performance par sous-groupes est une autre technique essentielle, où vous évaluez les performances de votre modèle séparément pour différents groupes démographiques et sous-populations. Même si la précision globale semble acceptable, les performances peuvent varier fortement selon les groupes. Si votre modèle atteint 95% de précision globale mais seulement 70% pour un groupe démographique particulier, cela suggère que le biais de sélection des sources a conduit le modèle à apprendre des schémas propres au groupe majoritaire tout en négligeant ceux du groupe minoritaire. Cette analyse doit être menée non seulement sur la précision globale mais aussi sur des indicateurs d’équité comme les “equalized odds” ou l’impact disparate.

Les tests adversariaux consistent à créer délibérément des cas de test destinés à révéler d’éventuels biais. Cela peut inclure le test de votre modèle sur des données issues de populations sous-représentées, de cas limites ou de scénarios peu présents dans les données d’entraînement. En mettant votre modèle à l’épreuve via des entrées diverses, vous pouvez identifier là où le biais de sélection des sources a créé des angles morts. Par exemple, si votre modèle a été principalement entraîné sur des données urbaines, testez-le largement sur des données rurales pour voir si les performances se dégradent. Si vos données proviennent d’une période spécifique, testez le modèle sur d’autres périodes pour détecter un biais temporel.

Atténuer le biais de sélection des sources nécessite une intervention à plusieurs étapes du cycle de vie du développement de l’IA, depuis la collecte des données jusqu’à l’évaluation et le déploiement du modèle. L’approche la plus efficace est l’atténuation centrée sur les données, qui traite le biais à sa source en améliorant la qualité et la représentativité des données d’entraînement. Cela commence par une collecte de données diversifiée où vous travaillez activement à inclure des populations et scénarios sous-représentés dans votre ensemble de données. Plutôt que de s’appuyer sur l’échantillonnage de commodité ou des jeux de données existants, les organisations devraient mener des efforts ciblés pour garantir une représentation adéquate de tous les groupes démographiques et cas d’usage pertinents.

Les techniques de rééchantillonnage et de réaffectation de poids offrent des méthodes pratiques pour corriger les déséquilibres dans les ensembles de données existants. Le sur-échantillonnage aléatoire duplique les exemples de groupes sous-représentés, tandis que le sous-échantillonnage réduit les exemples des groupes sur-représentés. Des approches plus sophistiquées comme l’échantillonnage stratifié assurent une représentation proportionnelle sur plusieurs dimensions simultanément. La réaffectation de poids donne plus d’importance aux échantillons sous-représentés lors de l’entraînement du modèle, indiquant ainsi à l’algorithme de prêter davantage attention aux schémas des groupes minoritaires. Ces techniques sont plus efficaces lorsqu’elles sont combinées à la collecte de données plus diversifiées, plutôt que de s’appuyer uniquement sur le rééchantillonnage de données limitées.

La génération de données synthétiques offre une autre voie pour traiter ce biais, notamment lorsque la collecte de données réelles auprès de populations sous-représentées est difficile ou coûteuse. Des techniques comme les réseaux antagonistes génératifs (GAN) et les autoencodeurs variationnels (VAE) peuvent créer des exemples synthétiques réalistes pour ces groupes. Des approches spécifiques comme SMOTE (Synthetic Minority Over-sampling Technique) fabriquent des exemples en interpolant entre les instances minoritaires existantes. Cependant, les données synthétiques doivent être utilisées avec précaution et soigneusement validées, car elles peuvent introduire leurs propres biais si elles sont mal générées.

Les algorithmes sensibles à l’équité constituent une autre stratégie d’atténuation qui intervient lors de l’entraînement du modèle. Ces algorithmes intègrent explicitement des contraintes d’équité dans le processus d’apprentissage, garantissant que le modèle obtient des performances acceptables pour tous les groupes démographiques, et pas seulement pour le groupe majoritaire. La “débiaisisation adversariale”, par exemple, utilise un réseau adversarial pour faire en sorte que les prédictions du modèle ne permettent pas d’inférer des caractéristiques protégées comme la race ou le genre. Les régularisations d’équité ajoutent des termes de pénalité dans la fonction de perte pour décourager les comportements discriminatoires. Ces approches permettent de trouver un compromis explicite entre la précision globale et l’équité, en choisissant l’équilibre qui correspond à vos priorités éthiques.

La surveillance continue et la ré-entrainement garantissent que le biais de sélection des sources n’apparaît pas ou ne s’aggrave pas avec le temps. Même si vos données d’entraînement initiales sont représentatives, la population réelle servie par votre modèle peut évoluer en raison de changements démographiques, économiques ou autres. Mettre en place des systèmes de suivi des performances qui évaluent la précision du modèle séparément pour différents groupes démographiques permet de détecter l’apparition de biais. En cas de dégradation des performances, le ré-entrainement avec des données actualisées reflétant la distribution actuelle peut restaurer l’équité. Ce processus continu reconnaît que l’atténuation des biais n’est pas un effort ponctuel mais une responsabilité permanente.

Comprendre le biais de sélection des sources devient de plus en plus important dans le contexte de la surveillance des réponses IA et du suivi de la présence de marque. À mesure que des systèmes d’IA comme ChatGPT, Perplexity et autres générateurs de réponses deviennent des sources d’information majeures pour les utilisateurs, les sources que ces systèmes citent et l’information qu’ils présentent sont façonnées par leurs données d’entraînement. Si les données utilisées pour construire ces systèmes présentent un biais de sélection des sources, les réponses générées le refléteront. Par exemple, si les données d’entraînement d’un système d’IA sur-représentent certains sites web, publications ou points de vue tout en sous-représentant d’autres, le système sera plus susceptible de citer et amplifier l’information issue des sources sur-représentées.

Cela a des implications directes pour la surveillance de marque et la visibilité des contenus. Si votre marque, domaine ou URL est sous-représenté dans les données d’entraînement des principaux systèmes d’IA, votre contenu peut être systématiquement exclu ou sous-représenté dans les réponses générées par l’IA. À l’inverse, si des marques concurrentes ou des sources de désinformation sont sur-représentées, elles bénéficieront d’une visibilité disproportionnée dans les réponses IA. Surveiller la façon dont votre marque apparaît dans les réponses générées par l’IA sur différentes plateformes vous aide à comprendre si le biais de sélection des sources dans ces systèmes affecte votre visibilité et votre réputation. En suivant les sources citées, la fréquence d’apparition de votre contenu et la justesse des informations présentées, vous pouvez identifier d’éventuels biais dans la manière dont les systèmes d’IA représentent votre marque et votre secteur.

Le biais de sélection des sources en IA est un problème d’équité crucial qui prend racine dès la collecte des données et se propage à toutes les applications en aval des modèles d’apprentissage automatique. Il se produit lorsque les données d’entraînement excluent ou sous-représentent systématiquement certaines populations, scénarios ou caractéristiques, aboutissant à des modèles qui produisent des prédictions inexactes ou injustes pour les groupes sous-représentés. Les conséquences sont graves et étendues, affectant la santé, l’accès financier, les opportunités professionnelles et les décisions judiciaires. Détecter ce biais nécessite des audits de données approfondis, des analyses de parité démographique, des analyses de performance par sous-groupes et des tests adversariaux. L’atténuation de ce biais requiert une approche multifacette incluant la collecte de données diversifiées, le rééchantillonnage et la réaffectation de poids, la génération de données synthétiques, des algorithmes sensibles à l’équité et une surveillance continue. Les organisations doivent reconnaître que traiter le biais de sélection des sources n’est pas optionnel mais essentiel pour bâtir des systèmes d’IA justes, précis et dignes de confiance pour toutes les populations et tous les cas d’usage.

Assurez-vous que votre marque apparaît avec précision dans les réponses générées par l'IA sur ChatGPT, Perplexity et d'autres plateformes d'IA. Suivez comment les systèmes d'IA citent votre contenu et identifiez les biais potentiels dans les réponses IA.

Découvrez comment les systèmes d'IA sélectionnent et classent les sources à citer. Découvrez les algorithmes, signaux et facteurs qui déterminent quels sites we...

Découvrez le biais de récence dans les systèmes d'IA, son impact sur la visibilité du contenu, les algorithmes de recommandation et les décisions commerciales. ...

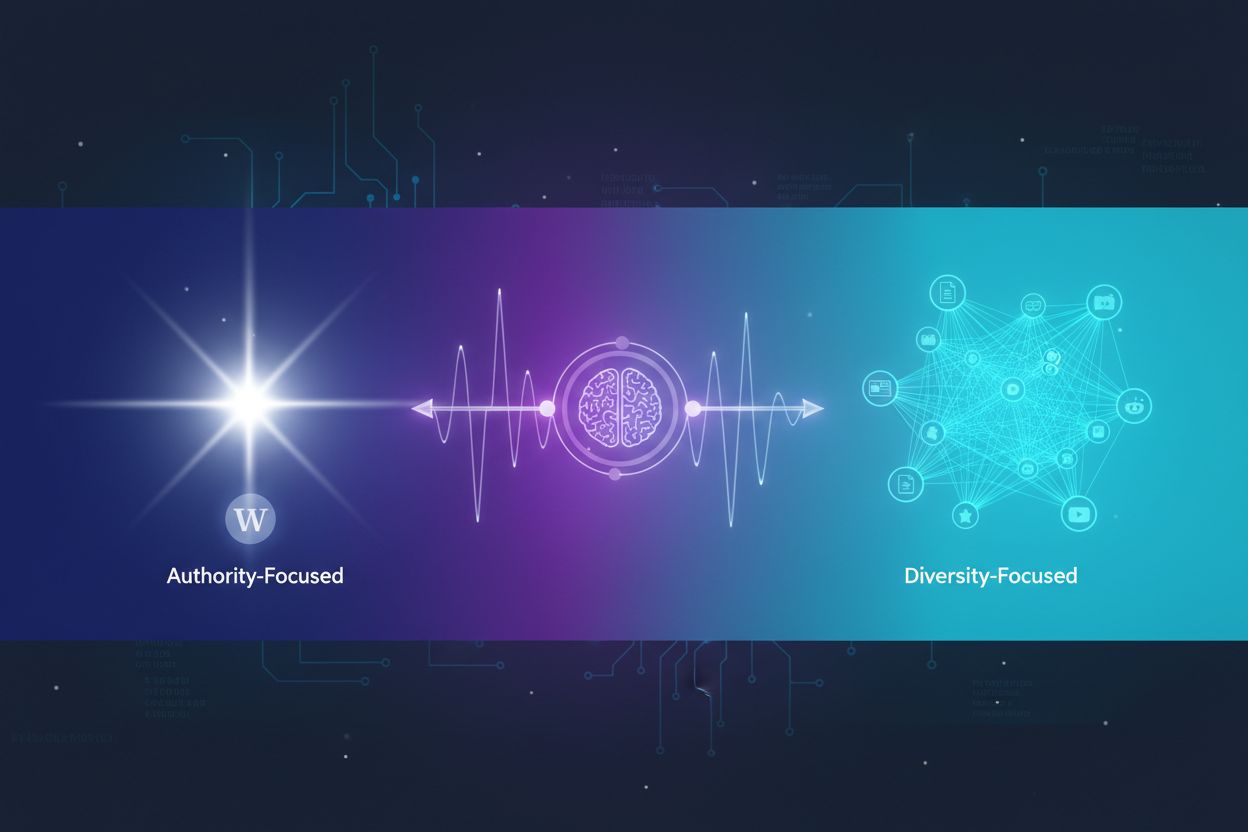

Découvrez comment les systèmes d’IA choisissent entre la citation de multiples sources et la concentration sur des sources autorisées. Comprenez les schémas de ...