Comment réaliser un audit de visibilité IA : méthodologie complète

Découvrez la méthodologie complète et détaillée pour réaliser un audit de visibilité IA. Apprenez à mesurer les mentions de marque, les citations et la visibili...

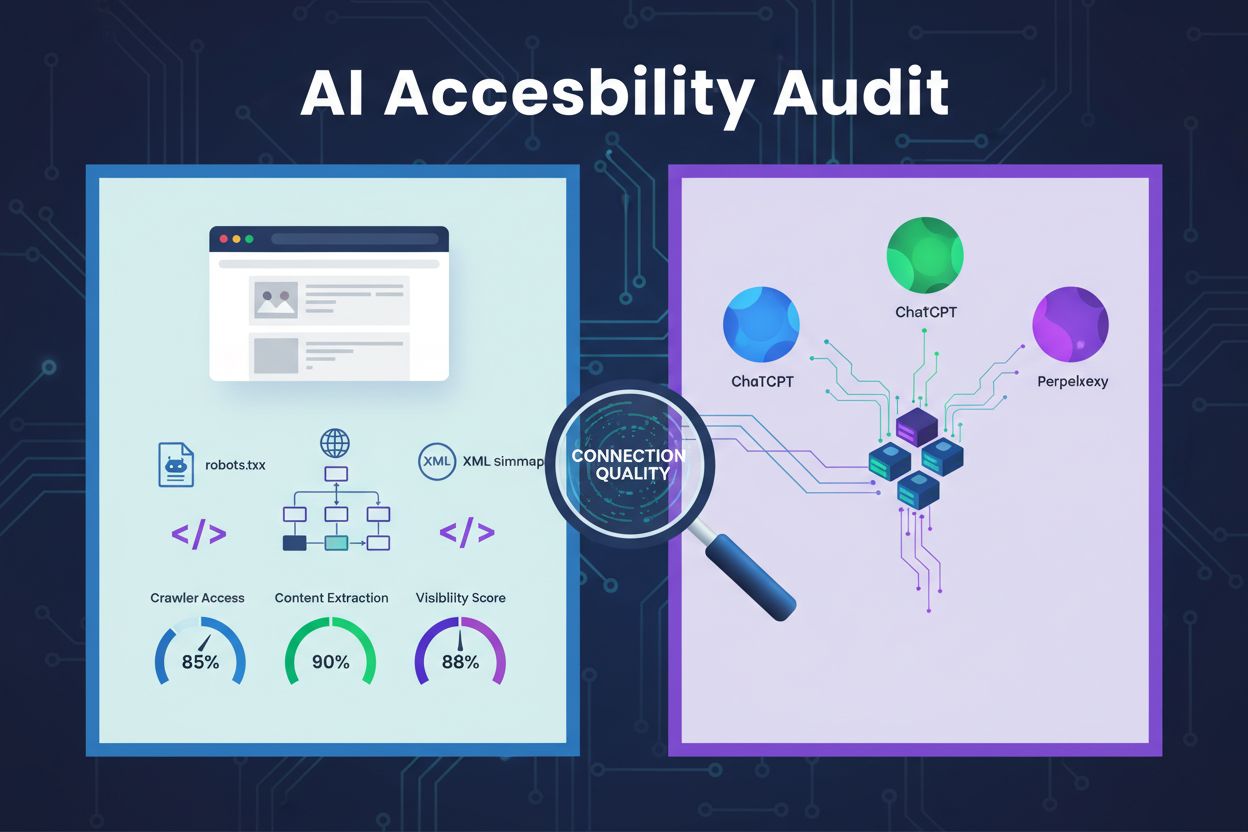

Un examen technique de l’architecture du site web, de la configuration et de la structure du contenu pour déterminer si les crawlers IA peuvent effectivement accéder, comprendre et extraire le contenu. Évalue la configuration du robots.txt, les sitemaps XML, la crawlabilité du site, le rendu JavaScript et la capacité d’extraction de contenu afin de garantir la visibilité sur les plateformes de recherche alimentées par l’IA telles que ChatGPT, Claude et Perplexity.

Un examen technique de l'architecture du site web, de la configuration et de la structure du contenu pour déterminer si les crawlers IA peuvent effectivement accéder, comprendre et extraire le contenu. Évalue la configuration du robots.txt, les sitemaps XML, la crawlabilité du site, le rendu JavaScript et la capacité d'extraction de contenu afin de garantir la visibilité sur les plateformes de recherche alimentées par l'IA telles que ChatGPT, Claude et Perplexity.

Un audit d’accessibilité à l’IA est un examen technique de l’architecture, de la configuration et de la structure de contenu de votre site web pour déterminer si les crawlers IA peuvent effectivement accéder à votre contenu, le comprendre et l’extraire. Contrairement aux audits SEO traditionnels axés sur les classements de mots-clés et les backlinks, les audits d’accessibilité à l’IA examinent les fondations techniques qui permettent à des systèmes IA comme ChatGPT, Claude et Perplexity de découvrir et de citer votre contenu. Cet audit évalue des éléments essentiels tels que la configuration du robots.txt, les sitemaps XML, la crawlabilité du site, le rendu JavaScript et la capacité d’extraction de contenu pour garantir la pleine visibilité de votre site dans l’écosystème de recherche piloté par l’IA.

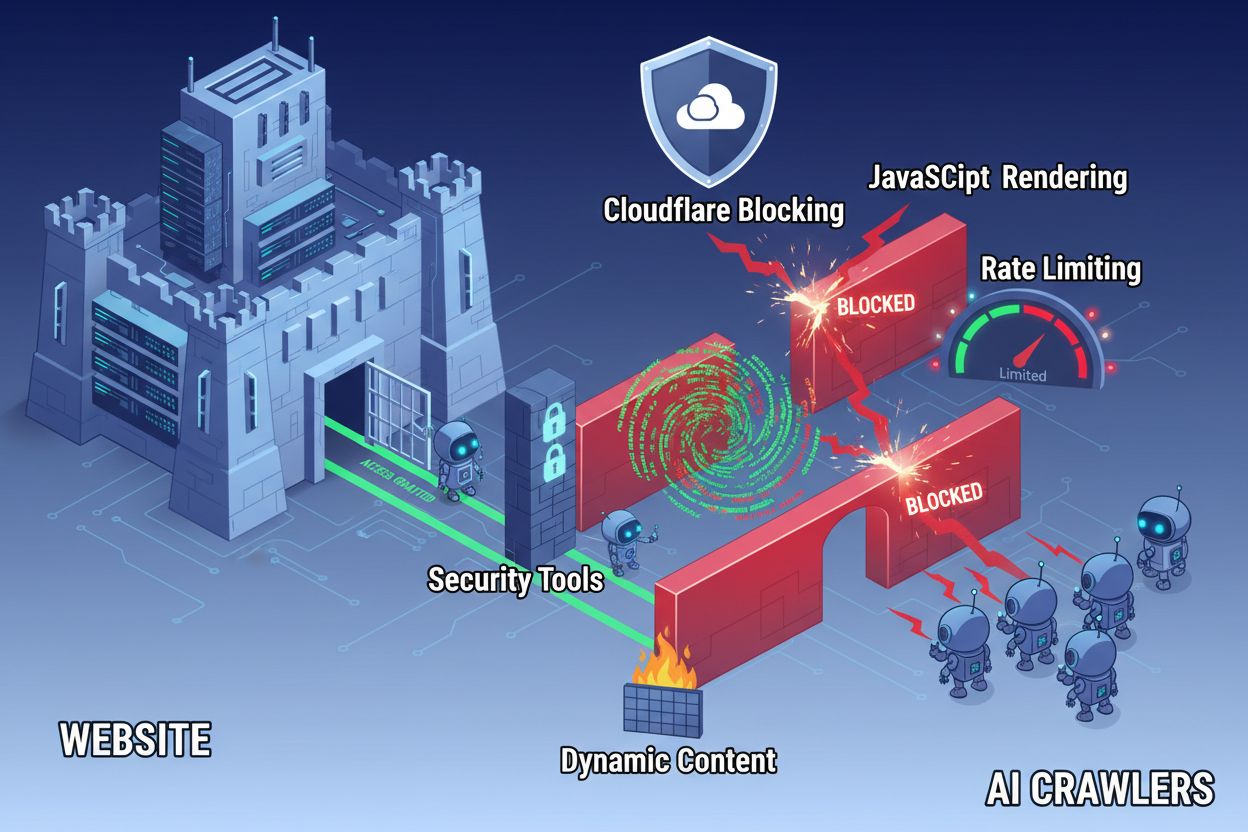

Malgré les avancées technologiques du web, les crawlers IA font face à d’importants obstacles lors de l’accès aux sites modernes. Le principal défi est que beaucoup de sites actuels s’appuient fortement sur le rendu JavaScript pour afficher dynamiquement le contenu, alors que la plupart des crawlers IA ne peuvent pas exécuter de code JavaScript. Cela signifie qu’environ 60 à 90 % du contenu des sites modernes reste invisible pour les systèmes IA, même si ce contenu s’affiche parfaitement dans les navigateurs utilisateurs. De plus, des outils de sécurité comme Cloudflare bloquent par défaut les crawlers IA, les considérant comme des menaces potentielles plutôt que comme des robots d’indexation légitimes. Des études montrent que 35 % des sites d’entreprise bloquent involontairement les crawlers IA, empêchant ainsi la découverte et la citation de contenu précieux par les systèmes IA.

Obstacles courants empêchant l’accès des crawlers IA :

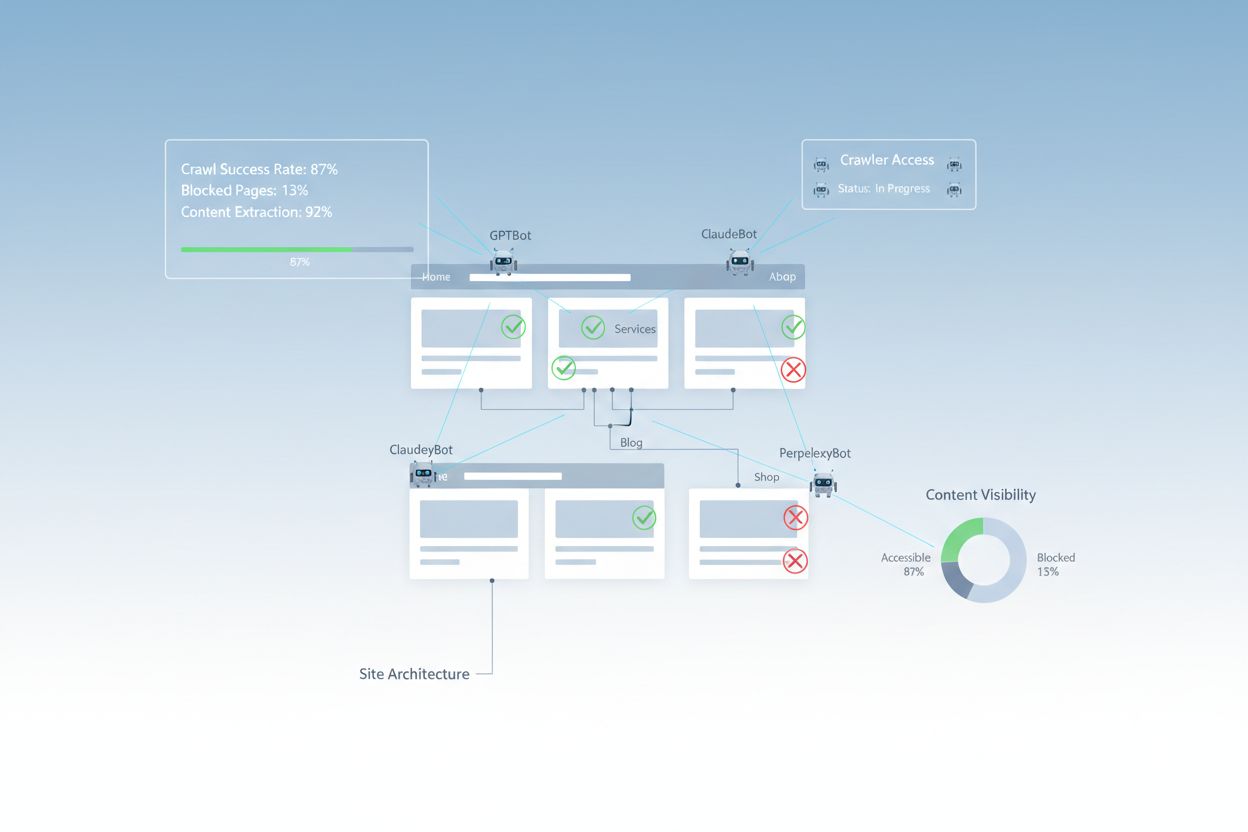

Un audit d’accessibilité à l’IA complet examine plusieurs éléments techniques et structurels qui influencent la manière dont les systèmes IA interagissent avec votre site web. Chaque composant joue un rôle distinct dans la visibilité de votre contenu sur les plateformes de recherche IA. Le processus d’audit comprend des tests de crawlabilité, la vérification des fichiers de configuration, l’évaluation de la structure du contenu et la surveillance du comportement réel des crawlers. En évaluant systématiquement ces composants, vous pouvez identifier des obstacles précis et mettre en œuvre des solutions ciblées pour améliorer votre visibilité IA.

| Composant | Objectif | Impact sur la visibilité IA |

|---|---|---|

| Configuration du robots.txt | Contrôle quels crawlers peuvent accéder à certaines sections du site | Critique – Une mauvaise configuration bloque totalement les crawlers IA |

| Sitemaps XML | Guident les crawlers vers les pages importantes et la structure du contenu | Élevé – Aide les systèmes IA à prioriser et découvrir le contenu |

| Crawlabilité du site | Assure l’accès aux pages sans authentification ni navigation complexe | Critique – Les pages bloquées sont invisibles pour l’IA |

| Rendu JavaScript | Détermine si le contenu dynamique est visible pour les crawlers | Critique – 60 à 90 % du contenu peut être manquant sans pré-rendu |

| Extraction de contenu | Évalue la capacité des systèmes IA à analyser et comprendre le contenu | Élevé – Une mauvaise structure réduit les chances de citation |

| Configuration des outils de sécurité | Gère les règles de pare-feu affectant l’accès des crawlers | Critique – Des règles trop restrictives bloquent les bots IA légitimes |

| Implémentation du balisage schema | Fournit un contexte lisible par la machine sur le contenu | Moyen – Améliore la compréhension IA et la probabilité de citation |

| Structure de maillage interne | Établit des relations sémantiques entre les pages | Moyen – Aide l’IA à comprendre l’autorité et la pertinence des sujets |

Votre fichier robots.txt est le principal mécanisme de contrôle de l’accès des crawlers à votre site web. Placé à la racine de votre domaine, ce simple fichier texte contient des directives qui informent les crawlers s’ils sont autorisés à accéder à certaines sections de votre site. Pour l’accessibilité à l’IA, une configuration appropriée du robots.txt est essentielle car des règles mal configurées peuvent bloquer totalement les principaux crawlers IA tels que GPTBot (OpenAI), ClaudeBot (Anthropic) et PerplexityBot (Perplexity). L’essentiel est d’autoriser explicitement ces crawlers tout en maintenant la sécurité en bloquant les bots malveillants et en protégeant les zones sensibles.

Exemple de configuration robots.txt pour les crawlers IA :

# Autoriser tous les crawlers IA

User-agent: GPTBot

User-agent: ChatGPT-User

User-agent: ClaudeBot

User-agent: Claude-Web

User-agent: PerplexityBot

User-agent: Google-Extended

Allow: /

# Bloquer les zones sensibles

Disallow: /admin/

Disallow: /private/

Disallow: /api/

# Sitemaps

Sitemap: https://yoursite.com/sitemap.xml

Sitemap: https://yoursite.com/ai-sitemap.xml

Cette configuration permet explicitement aux principaux crawlers IA d’accéder à votre contenu public tout en protégeant les sections administratives et privées. Les directives Sitemap aident les crawlers à découvrir efficacement vos pages les plus importantes.

Un sitemap XML sert de plan pour les crawlers, listant les URLs que vous souhaitez indexer et fournissant des métadonnées sur chaque page. Pour les systèmes IA, les sitemaps sont particulièrement précieux car ils aident les crawlers à comprendre la structure de votre site, à prioriser le contenu important et à découvrir des pages qui pourraient autrement être manquées lors d’un crawl standard. Contrairement aux moteurs de recherche traditionnels qui peuvent inférer la structure du site via les liens, les crawlers IA bénéficient grandement d’une indication explicite sur les pages les plus importantes. Un sitemap bien structuré avec des métadonnées appropriées augmente la probabilité que votre contenu soit découvert, compris et cité par les systèmes IA.

Exemple de structure de sitemap XML pour l’optimisation IA :

<?xml version="1.0" encoding="UTF-8"?>

<urlset xmlns="http://www.sitemaps.org/schemas/sitemap/0.9">

<!-- Contenu prioritaire pour les crawlers IA -->

<url>

<loc>https://yoursite.com/about</loc>

<lastmod>2025-01-03</lastmod>

<priority>1.0</priority>

</url>

<url>

<loc>https://yoursite.com/products</loc>

<lastmod>2025-01-03</lastmod>

<priority>0.9</priority>

</url>

<url>

<loc>https://yoursite.com/blog/ai-guide</loc>

<lastmod>2025-01-02</lastmod>

<priority>0.8</priority>

</url>

<url>

<loc>https://yoursite.com/faq</loc>

<lastmod>2025-01-01</lastmod>

<priority>0.7</priority>

</url>

</urlset>

L’attribut priority indique aux crawlers IA quelles pages sont les plus importantes, tandis que lastmod renseigne sur la fraîcheur du contenu. Cela aide les systèmes IA à allouer efficacement les ressources de crawl et à comprendre la hiérarchie de votre contenu.

Au-delà des fichiers de configuration, plusieurs obstacles techniques peuvent empêcher les crawlers IA d’accéder efficacement à votre contenu. Le rendu JavaScript reste le défi principal, car les frameworks web modernes comme React, Vue et Angular rendent le contenu dynamiquement dans le navigateur, laissant les crawlers IA face à des HTML vides. Cloudflare et des outils de sécurité similaires bloquent souvent par défaut les crawlers IA, considérant leur volume élevé de requêtes comme des attaques potentielles. La limitation de taux peut empêcher une indexation complète, tandis qu’une architecture de site complexe et un chargement dynamique du contenu compliquent encore l’accès des crawlers. Heureusement, plusieurs solutions existent pour surmonter ces obstacles.

Solutions pour améliorer l’accès des crawlers IA :

Les systèmes IA doivent non seulement accéder à votre contenu, mais aussi le comprendre. L’extraction de contenu désigne la capacité des crawlers IA à analyser, comprendre et extraire des informations significatives de vos pages. Ce processus dépend fortement de la structure HTML sémantique, qui utilise des hiérarchies de titres appropriées, des textes descriptifs et une organisation logique pour transmettre le sens. Lorsque votre contenu est bien structuré avec des titres clairs (H1, H2, H3), des paragraphes descriptifs et une logique cohérente, les systèmes IA peuvent plus facilement identifier les informations clés et comprendre le contexte. De plus, le balisage schema apporte des métadonnées lisibles par la machine qui indiquent explicitement aux systèmes IA le sujet de votre contenu, améliorant fortement la compréhension et la probabilité de citation.

Une bonne structure sémantique inclut aussi l’utilisation d’éléments HTML sémantiques tels que <article>, <section>, <nav> et <aside> plutôt que des balises <div> génériques. Cela aide les systèmes IA à comprendre la fonction et l’importance des différentes sections de contenu. Combiné à des données structurées comme les schémas FAQ, Produit ou Organisation, votre contenu devient beaucoup plus accessible aux systèmes IA, augmentant la probabilité d’être repris dans des réponses générées par l’IA.

Après avoir mis en place des améliorations, il est essentiel de vérifier que les crawlers IA peuvent effectivement accéder à votre contenu et de surveiller les performances dans la durée. Les journaux du serveur offrent une preuve directe de l’activité des crawlers, indiquant quels bots ont visité votre site, quelles pages ils ont consultées et s’ils ont rencontré des erreurs. Google Search Console fournit des informations sur la façon dont les crawlers Google interagissent avec votre site, tandis que des outils spécialisés de surveillance de la visibilité IA suivent la présence de votre contenu sur différentes plateformes IA. AmICited.com surveille spécifiquement la façon dont les systèmes IA citent votre marque sur ChatGPT, Perplexity et Google AI Overviews, offrant une visibilité sur les pages citées et la fréquence de citation.

Outils et méthodes pour surveiller l’accès des crawlers IA :

L’optimisation de votre site pour l’accès des crawlers IA nécessite une approche stratégique et continue. Plutôt que de traiter l’accessibilité à l’IA comme un projet ponctuel, les organisations performantes mettent en place des processus de surveillance et d’amélioration permanents. La stratégie la plus efficace combine une configuration technique appropriée avec l’optimisation du contenu, afin que votre infrastructure et vos contenus soient prêts pour l’IA.

À faire pour l’accessibilité à l’IA :

À éviter pour l’accessibilité à l’IA :

La stratégie d’accessibilité à l’IA la plus efficace considère les crawlers comme des partenaires de distribution de contenu plutôt que comme des menaces à bloquer. En veillant à ce que votre site soit techniquement solide, correctement configuré et sémantiquement clair, vous maximisez la probabilité que les systèmes IA découvrent, comprennent et citent votre contenu dans leurs réponses aux utilisateurs.

Les audits d'accessibilité à l'IA se concentrent sur la structure sémantique, le contenu lisible par la machine et l'éligibilité à la citation pour les systèmes IA, tandis que les audits SEO traditionnels mettent l'accent sur les mots-clés, les backlinks et le classement dans les moteurs de recherche. Les audits IA examinent si les crawlers peuvent accéder et comprendre votre contenu, alors que les audits SEO se concentrent sur les facteurs de classement pour les résultats de recherche Google.

Vérifiez les journaux de votre serveur pour les user agents des crawlers IA comme GPTBot, ClaudeBot et PerplexityBot. Utilisez Google Search Console pour surveiller l'activité de crawl, testez votre fichier robots.txt avec des outils de validation et utilisez des plateformes spécialisées comme AmICited pour suivre la façon dont les systèmes IA référencent votre contenu sur différentes plateformes.

Les obstacles les plus courants incluent les limitations de rendu JavaScript (les crawlers IA ne peuvent pas exécuter JavaScript), le blocage par Cloudflare et d'autres outils de sécurité (35 % des sites d'entreprise bloquent les crawlers IA), la limitation du taux de requêtes qui empêche l'indexation complète, une architecture de site complexe et un chargement dynamique du contenu. Chaque obstacle nécessite des solutions différentes.

La plupart des entreprises bénéficient de l'autorisation des crawlers IA, car ils augmentent la visibilité de la marque dans les résultats de recherche et interfaces conversationnelles alimentées par l'IA. Cependant, la décision dépend de votre stratégie de contenu, de votre positionnement concurrentiel et de vos objectifs commerciaux. Vous pouvez utiliser le robots.txt pour autoriser certains crawlers tout en en bloquant d'autres selon vos besoins spécifiques.

Réalisez un audit complet chaque trimestre ou à chaque fois que vous effectuez des modifications importantes dans l'architecture de votre site, votre stratégie de contenu ou la configuration de la sécurité. Surveillez en continu l'activité des crawlers via les journaux du serveur et des outils spécialisés. Mettez à jour votre robots.txt et vos sitemaps à chaque lancement de nouvelles sections de contenu ou modification des structures d'URL.

Le robots.txt est votre principal mécanisme de contrôle de l'accès des crawlers IA. Une bonne configuration permet explicitement aux principaux crawlers IA (GPTBot, ClaudeBot, PerplexityBot) d'accéder à votre site tout en protégeant les zones sensibles. Un robots.txt mal configuré peut bloquer complètement les crawlers IA, rendant votre contenu invisible aux systèmes IA quelle que soit sa qualité.

Bien que l'optimisation technique soit importante, vous pouvez aussi améliorer la visibilité IA via l'optimisation du contenu : utilisation d'une structure HTML sémantique, mise en place de balisage schema, amélioration du maillage interne et complétude du contenu. Cependant, les obstacles techniques comme le rendu JavaScript et le blocage par les outils de sécurité nécessitent généralement des solutions techniques pour une accessibilité IA complète.

Utilisez l'analyse des journaux du serveur pour suivre l'activité des crawlers, Google Search Console pour les statistiques de crawl, les validateurs de robots.txt pour vérifier la configuration, les validateurs de balisage schema pour les données structurées, et des plateformes spécialisées comme AmICited pour surveiller les citations IA. De nombreux outils SEO comme Screaming Frog offrent également des capacités de simulation de crawl pour tester l'accessibilité IA.

Suivez comment ChatGPT, Perplexity, Google AI Overviews et d'autres systèmes IA référencent votre marque avec AmICited. Obtenez des analyses en temps réel sur votre visibilité dans la recherche IA et optimisez votre stratégie de contenu.

Découvrez la méthodologie complète et détaillée pour réaliser un audit de visibilité IA. Apprenez à mesurer les mentions de marque, les citations et la visibili...

Découvrez comment auditer l'accès des crawlers IA à votre site web. Identifiez quels bots peuvent voir votre contenu et corrigez les obstacles empêchant la visi...

Découvrez ce qu’est un audit de la visibilité concurrentielle sur l’IA, pourquoi il est essentiel pour le positionnement concurrentiel et comment analyser la vi...