IA générative

L’IA générative crée de nouveaux contenus à partir de données d’entraînement grâce à des réseaux neuronaux. Découvrez son fonctionnement, ses applications dans ...

Une image générée par IA est une image numérique créée par des algorithmes d’intelligence artificielle et des modèles d’apprentissage automatique, plutôt que par des artistes ou photographes humains. Ces images sont produites en entraînant des réseaux neuronaux sur d’immenses ensembles de données d’images étiquetées, permettant à l’IA d’apprendre des schémas visuels et de générer des visuels originaux et réalistes à partir d’instructions textuelles, de croquis ou d’autres données d’entrée.

Une image générée par IA est une image numérique créée par des algorithmes d’intelligence artificielle et des modèles d’apprentissage automatique, plutôt que par des artistes ou photographes humains. Ces images sont produites en entraînant des réseaux neuronaux sur d’immenses ensembles de données d’images étiquetées, permettant à l’IA d’apprendre des schémas visuels et de générer des visuels originaux et réalistes à partir d’instructions textuelles, de croquis ou d’autres données d’entrée.

Une image générée par IA est une image numérique créée par des algorithmes d’intelligence artificielle et des modèles d’apprentissage automatique, plutôt que par des artistes ou photographes humains. Ces images sont produites grâce à des réseaux neuronaux sophistiqués entraînés sur d’immenses ensembles de données d’images étiquetées, permettant à l’IA d’apprendre des schémas visuels, des styles et les relations entre concepts. La technologie permet aux systèmes IA de générer des visuels originaux et réalistes à partir de diverses entrées — le plus souvent des instructions textuelles, mais aussi des croquis, images de référence ou autres sources de données. Contrairement à la photographie traditionnelle ou à l’art manuel, les images générées par IA peuvent représenter tout ce qui est imaginable, y compris des scénarios impossibles, des mondes fantastiques et des concepts abstraits qui n’ont jamais existé dans la réalité physique. Le processus est remarquablement rapide, produisant souvent des images de haute qualité en quelques secondes, ce qui en fait une technologie transformatrice pour les industries créatives, le marketing, le design produit et la création de contenu.

L’aventure de la génération d’images par IA a débuté avec les recherches fondamentales en deep learning et réseaux neuronaux, mais la technologie n’est devenue grand public qu’au début des années 2020. Les réseaux antagonistes génératifs (GANs), introduits par Ian Goodfellow en 2014, furent parmi les premières approches réussies, utilisant deux réseaux neuronaux concurrents pour générer des images réalistes. Cependant, la véritable percée est venue avec l’émergence des modèles de diffusion et des architectures à base de transformers, plus stables et capables de produire des résultats de meilleure qualité. En 2022, Stable Diffusion fut publié en open source, démocratisant l’accès à la génération d’images par IA et déclenchant une adoption massive. Peu après, DALL-E 2 d’OpenAI et Midjourney ont attiré une grande attention, popularisant la génération d’images par IA auprès du grand public. Selon des statistiques récentes, 71 % des images sur les réseaux sociaux sont désormais générées par IA, et le marché mondial des générateurs d’images IA était évalué à 299,2 millions de dollars en 2023, avec des projections de croissance annuelle de 17,4 % jusqu’en 2030. Cette croissance explosive reflète à la fois la maturation technologique et l’adoption massive par les entreprises de tous secteurs.

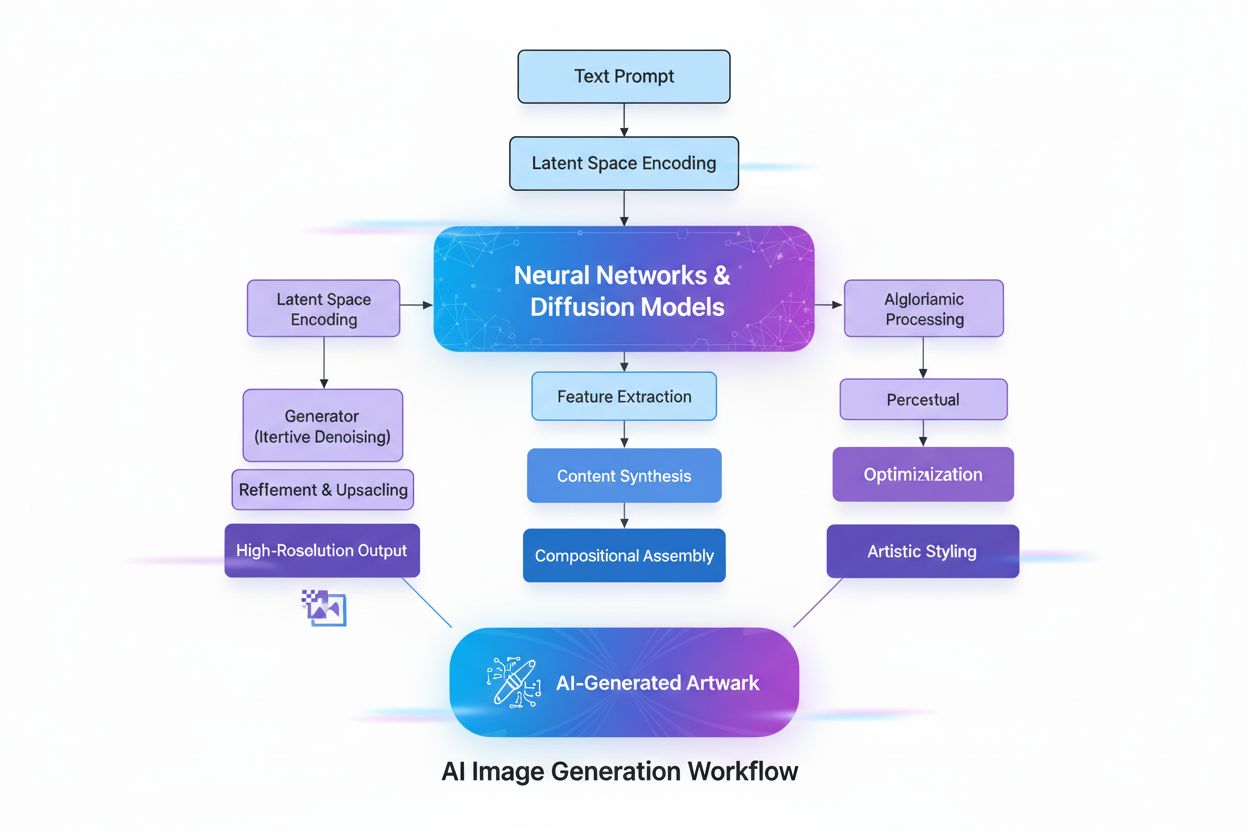

La création d’images générées par IA implique plusieurs processus techniques sophistiqués travaillant de concert pour transformer des concepts abstraits en réalité visuelle. Le processus commence par la compréhension du texte via le traitement du langage naturel (NLP), où l’IA convertit le langage humain en représentations numériques appelées embeddings. Des modèles comme CLIP (Contrastive Language-Image Pre-training) encodent les instructions textuelles en vecteurs de grande dimension capturant le sens et le contexte sémantiques. Par exemple, lorsqu’un utilisateur saisit “une pomme rouge sur un arbre”, le modèle NLP décompose cela en coordonnées numériques représentant “rouge”, “pomme”, “arbre” et leurs relations spatiales. Cette carte numérique guide ensuite la génération d’image, servant de cahier des charges indiquant à l’IA quels éléments inclure et comment ils doivent interagir.

Les modèles de diffusion, qui alimentent de nombreux générateurs d’images IA modernes dont DALL-E 2 et Stable Diffusion, fonctionnent selon un processus itératif élégant. Le modèle commence avec un bruit aléatoire pur — essentiellement un motif chaotique de pixels — et le raffine progressivement via plusieurs étapes de débruitage. Lors de l’entraînement, le modèle apprend à inverser le processus d’ajout de bruit aux images, apprenant ainsi à “débruiter” des versions corrompues pour les ramener à leur forme d’origine. Lors de la génération d’images, le modèle applique ce processus appris en sens inverse : il part du bruit aléatoire et le transforme progressivement en une image cohérente. L’instruction textuelle guide cette transformation à chaque étape, garantissant que le résultat final correspond à la description de l’utilisateur. Ce raffinement pas à pas permet un contrôle exceptionnel et produit des images remarquablement détaillées et de haute qualité.

Les réseaux antagonistes génératifs (GANs) utilisent une approche fondamentalement différente basée sur la théorie des jeux. Un GAN se compose de deux réseaux neuronaux concurrents : un générateur qui crée de fausses images à partir d’une entrée aléatoire, et un discriminateur qui tente de distinguer les images réelles des fausses. Ces réseaux s’affrontent dans un jeu adversarial où le générateur s’améliore continuellement pour tromper le discriminateur, tandis que ce dernier devient plus performant pour détecter les faux. Cette dynamique compétitive conduit les deux réseaux à l’excellence, produisant au final des images presque indiscernables de vraies photographies. Les GANs sont particulièrement efficaces pour générer des visages humains photoréalistes et réaliser des transferts de style, bien qu’ils soient parfois moins stables à entraîner que les modèles de diffusion.

Les modèles à base de transformers constituent une autre architecture majeure, adaptant la technologie des transformers issue du traitement du langage naturel. Ces modèles excellent dans la compréhension des relations complexes au sein des instructions textuelles et dans la correspondance entre les tokens de langage et les caractéristiques visuelles. Ils utilisent des mécanismes d’auto-attention pour capter le contexte et la pertinence, ce qui leur permet de gérer des instructions nuancées et complexes avec une grande précision. Les transformers peuvent générer des images qui correspondent étroitement à des descriptions textuelles détaillées, les rendant idéaux pour des applications nécessitant un contrôle précis des caractéristiques des images produites.

| Technologie | Principe de fonctionnement | Forces | Faiblesses | Cas d’usage privilégiés | Outils exemples |

|---|---|---|---|---|---|

| Modèles de diffusion | Débruitage itératif d’un bruit aléatoire en images structurées guidées par des instructions textuelles | Résultats détaillés de haute qualité, excellente correspondance texte-image, entraînement stable, contrôle fin du raffinement | Processus de génération plus lent, nécessite plus de ressources informatiques | Génération texte-image, art haute résolution, visualisations scientifiques | Stable Diffusion, DALL-E 2, Midjourney |

| GANs | Deux réseaux neuronaux concurrents (générateur et discriminateur) créent des images réalistes via entraînement adversarial | Génération rapide, excellent photoréalisme, idéal pour le transfert de style et l’amélioration d’images | Instabilité à l’entraînement, problèmes de collapse de mode, contrôle textuel moins précis | Visages photoréalistes, transfert de style, upscaling d’images | StyleGAN, Progressive GAN, ArtSmart.ai |

| Transformers | Conversion d’instructions textuelles en images via auto-attention et embeddings de tokens | Synthèse texte-image exceptionnelle, gestion des instructions complexes, compréhension sémantique forte | Exige d’importantes ressources informatiques, technologie plus récente et moins optimisée | Génération créative d’images à partir de texte détaillé, design et publicité, concept art imaginatif | DALL-E 2, Runway ML, Imagen |

| Transfert de style neuronal | Fusionne le contenu d’une image avec le style artistique d’une autre | Contrôle artistique, préservation du contenu tout en appliquant un style, processus interprétable | Limité aux tâches de transfert de style, nécessite des images de référence, moins flexible que d’autres méthodes | Création artistique, application de styles, enrichissement créatif | DeepDream, Prisma, Artbreeder |

L’adoption des images générées par IA dans les secteurs professionnels a été remarquablement rapide et transformatrice. Dans le e-commerce et la distribution, les entreprises utilisent la génération d’images IA pour produire des photos de produits à grande échelle, éliminant le besoin de séances photo coûteuses. Selon des données récentes, 80 % des dirigeants du retail s’attendent à adopter l’automatisation IA d’ici 2025, et les sociétés du secteur ont dépensé 19,71 milliards de dollars en outils IA en 2023, la génération d’images représentant une part significative. Le marché de l’édition d’images IA est évalué à 88,7 milliards de dollars en 2025 et devrait atteindre 8,9 milliards d’ici 2034, avec les entreprises représentant environ 42 % de toutes les dépenses.

En marketing et publicité, 62 % des marketeurs utilisent l’IA pour créer de nouveaux visuels, et les entreprises recourant à l’IA pour la génération de contenu sur les réseaux sociaux constatent des augmentations de 15 à 25 % des taux d’engagement. La capacité à générer rapidement de multiples variantes créatives permet des tests A/B à une échelle inédite, optimisant les campagnes avec une précision data-driven. Le magazine Cosmopolitan a fait sensation en juin 2022 en publiant une couverture entièrement conçue avec DALL-E 2, première du genre pour une grande publication. L’instruction utilisée était : “A wide angle shot from below of a female astronaut with an athletic female body walking with swagger on Mars in an infinite universe, synthwave, digital art.”

En imagerie médicale, les images générées par IA sont explorées à des fins diagnostiques et pour la génération de données synthétiques. Des recherches ont montré que DALL-E 2 peut générer des images radiologiques réalistes à partir d’instructions textuelles et même reconstituer des éléments manquants dans des images médicales. Cette capacité a des implications majeures pour la formation médicale, le partage de données respectueux de la vie privée entre institutions et l’accélération du développement de nouveaux outils diagnostiques. Le marché des réseaux sociaux pilotés par IA devrait atteindre 12 milliards de dollars d’ici 2031, contre 2,1 milliards en 2021, illustrant le rôle central de la technologie dans la création de contenu numérique.

La prolifération rapide des images générées par IA soulève d’importantes questions éthiques et juridiques auxquelles l’industrie et les régulateurs tentent encore de répondre. Les questions de droit d’auteur et de propriété intellectuelle sont sans doute les plus épineuses. La plupart des générateurs d’images IA sont entraînés sur d’immenses ensembles de données d’images collectées sur internet, dont beaucoup sont des œuvres protégées créées par des artistes et photographes. En janvier 2023, trois artistes ont intenté un procès historique contre Stability AI, Midjourney et DeviantArt, accusant ces sociétés d’avoir utilisé des images protégées pour entraîner leurs algorithmes IA sans consentement ni compensation. Cette affaire illustre la tension plus large entre innovation technologique et droits des artistes.

La question de la propriété et des droits sur les images générées par IA reste juridiquement ambigüe. Lorsqu’une œuvre générée par IA a remporté le premier prix lors d’un concours d’arts plastiques à la Colorado State Fair en 2022, soumise par Jason Allen via Midjourney, une vive polémique a éclaté. Beaucoup ont soutenu que, l’IA ayant généré l’œuvre, elle ne devrait pas être considérée comme une création humaine originale. L’Office américain du droit d’auteur a indiqué que les œuvres créées entièrement par IA sans intervention humaine pourraient ne pas bénéficier de protection, bien que ce domaine évolue avec des litiges et des régulations en cours.

Les deepfakes et la désinformation représentent un autre enjeu crucial. Les générateurs d’images IA peuvent produire des images très réalistes d’événements fictifs, facilitant la diffusion de fausses informations. En mars 2023, de fausses images d’arrestation de l’ancien président Donald Trump, créées avec Midjourney, ont circulé sur les réseaux sociaux, certains utilisateurs croyant initialement à leur véracité. Cette sophistication croissante complique la détection, posant des défis aux plateformes sociales et aux médias dans la préservation de l’authenticité des contenus.

Le biais dans les données d’entraînement constitue également un enjeu éthique majeur. Les modèles IA apprennent à partir de jeux de données susceptibles de contenir des biais culturels, de genre ou raciaux. Le projet Gender Shades mené par Joy Buolamwini au MIT Media Lab a mis en lumière d’importants biais dans des systèmes commerciaux de classification de genre, avec des taux d’erreur bien plus élevés pour les femmes à la peau foncée que pour les hommes à la peau claire. Des biais similaires peuvent se retrouver dans la génération d’images, perpétuant potentiellement des stéréotypes nuisibles ou sous-représentant certains groupes. Réduire ces biais exige une sélection rigoureuse des données, une diversité des jeux d’entraînement et une évaluation continue des résultats produits.

La qualité des images générées par IA dépend fortement de la précision et du détail des instructions fournies. L’ingénierie de prompt — l’art de formuler des descriptions textuelles efficaces — est devenue une compétence clé pour obtenir des résultats optimaux. Les instructions efficaces sont spécifiques et détaillées, incluent des indications de style ou de médium (ex. “peinture numérique”, “aquarelle”, “photoréaliste”), intègrent des informations d’ambiance et d’éclairage (“heure dorée”, “éclairage cinématographique”, “ombres dramatiques”) et établissent des relations claires entre les éléments.

Par exemple, au lieu de demander simplement “un chat”, un prompt plus efficace serait : “un chat tigré orange et duveteux assis sur un rebord de fenêtre au coucher du soleil, lumière dorée traversant la fenêtre, photoréaliste, photographie professionnelle.” Ce niveau de détail guide l’IA sur l’apparence, le cadre, la lumière et l’esthétique désirée. Des études montrent que des instructions structurées, hiérarchisées, donnent des résultats plus cohérents et satisfaisants. Les utilisateurs emploient souvent des techniques comme la spécification de styles artistiques, l’ajout d’adjectifs descriptifs, l’utilisation de termes techniques photographiques ou la référence à des artistes/mouvements artistiques pour orienter l’IA vers le résultat attendu.

Différentes plateformes de génération d’images IA présentent des caractéristiques, atouts et usages propres. DALL-E 2, développé par OpenAI, génère des images détaillées à partir d’instructions textuelles et propose des fonctionnalités avancées de retouche et d’inpainting. Il fonctionne sur un système de crédits, les utilisateurs achetant des crédits pour chaque génération. DALL-E 2 est reconnu pour sa polyvalence et sa capacité à traiter des instructions complexes et nuancées, ce qui en fait un outil prisé des professionnels et créatifs.

Midjourney se concentre sur la création d’images artistiques et stylisées, apprécié des designers et artistes pour ses sensibilités esthétiques uniques. La plateforme fonctionne via un bot Discord, les utilisateurs saisissant leurs instructions via la commande /imagine. Midjourney est réputé pour produire des images visuellement attrayantes, aux couleurs harmonieuses, à l’éclairage équilibré et aux détails nets. Plusieurs abonnements sont proposés, de 10 à 120 dollars par mois, les formules supérieures offrant davantage de générations mensuelles.

Stable Diffusion, développé en collaboration entre Stability AI, EleutherAI et LAION, est un modèle open source qui démocratise la génération d’images IA. Son caractère open source permet aux développeurs et chercheurs de personnaliser et déployer le modèle, idéal pour les projets expérimentaux et les implémentations en entreprise. Stable Diffusion repose sur une architecture de diffusion latente, permettant une génération efficace sur des cartes graphiques grand public. La plateforme est tarifée à 0,0023 $ par image, avec des essais gratuits disponibles pour les nouveaux venus.

Imagen de Google est un autre acteur majeur, proposant des modèles de diffusion texte-image avec un photoréalisme inédit et une compréhension linguistique approfondie. Ces plateformes illustrent la diversité des approches et des modèles économiques dans l’univers de la génération d’images par IA, chacune répondant à des usages et besoins différents.

Le secteur de la génération d’images par IA évolue rapidement, avec plusieurs tendances majeures. L’amélioration et l’efficacité des modèles progressent à un rythme soutenu, les nouveaux modèles offrant des résolutions plus élevées, une meilleure correspondance texte-image et des temps de génération plus courts. Le marché des générateurs d’images IA devrait croître de 17,4 % par an jusqu’en 2030, signe d’un investissement et d’une innovation continus. Parmi les tendances émergentes : génération de vidéos à partir de texte, où l’IA étend la génération d’images à la création de clips vidéo courts ; génération de modèles 3D, permettant à l’IA de créer directement des objets tridimensionnels ; et génération d’images en temps réel, réduisant la latence pour permettre des workflows créatifs interactifs.

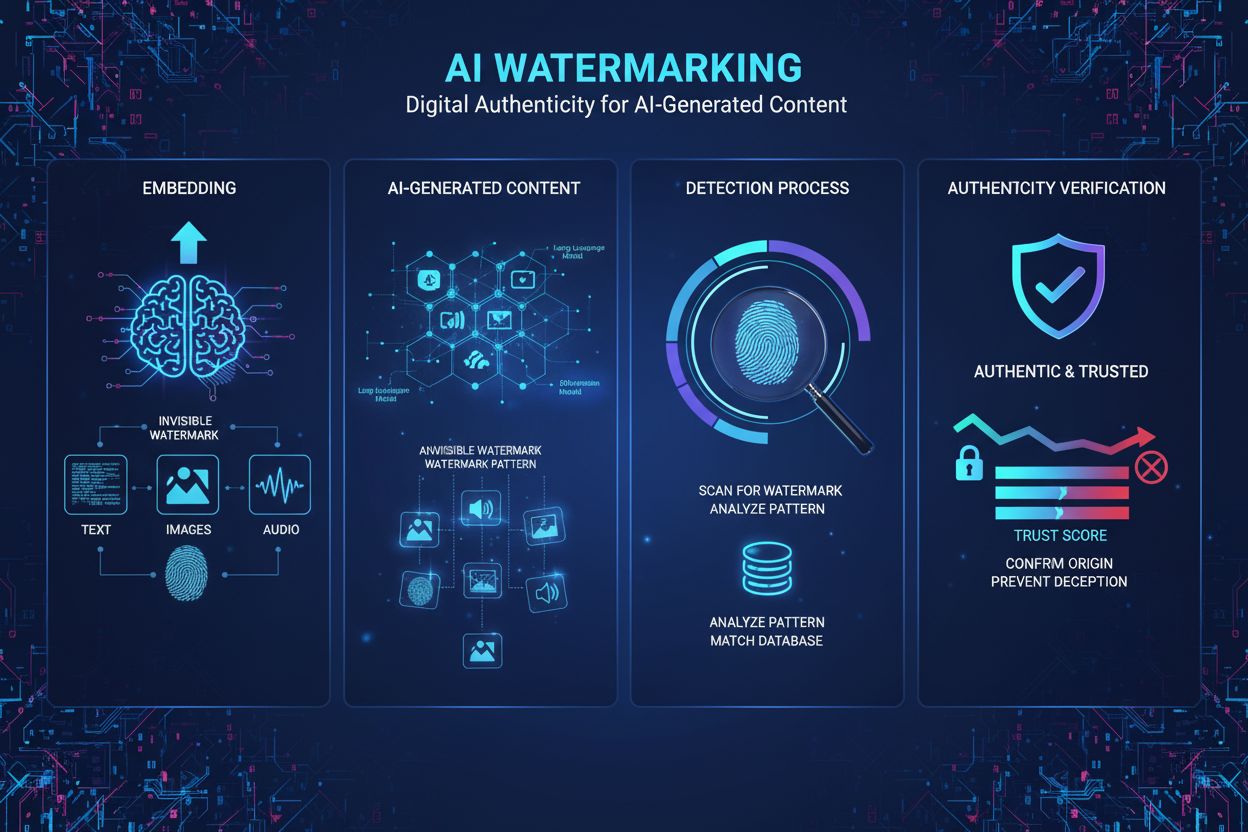

Des cadres réglementaires commencent à émerger à l’échelle mondiale, autorités publiques et organismes sectoriels développant des standards pour la transparence, la protection du droit d’auteur et l’usage éthique. Le NO FAKES Act et d’autres législations proposent d’imposer le filigrane des contenus générés par IA et la mention obligatoire de l’utilisation de l’IA lors de la création. 62 % des marketeurs mondiaux estiment que l’obligation de signaler les contenus générés par IA aurait un effet positif sur la performance sur les réseaux sociaux, signe d’une prise de conscience sectorielle de l’importance de la transparence.

L’intégration avec d’autres systèmes IA s’accélère, la génération d’images s’intégrant dans des plateformes et workflows plus larges. Les systèmes IA multimodaux combinant texte, image, audio et vidéo deviennent de plus en plus sophistiqués. La technologie se dirige aussi vers plus de personnalisation et de sur-mesure, les modèles pouvant être ajustés à des styles artistiques, esthétiques de marque ou préférences individuelles spécifiques. À mesure que les images générées par IA se généralisent sur les plateformes numériques, l’importance de la veille de marque et du suivi des citations dans les réponses IA augmente d’autant, rendant les outils de suivi de la visibilité de marque dans les contenus générés par IA essentiels pour les entreprises souhaitant maintenir leur notoriété à l’ère de l’IA générative.

Les images générées par IA sont créées entièrement par des algorithmes d’apprentissage automatique à partir d’instructions textuelles ou d’autres entrées, tandis que la photographie traditionnelle capture des scènes réelles à travers l’objectif d’un appareil photo. Les images IA peuvent représenter tout ce qui est imaginable, y compris des scénarios impossibles, alors que la photographie est limitée à ce qui existe ou peut être mis en scène physiquement. La génération par IA est généralement plus rapide et plus rentable que l’organisation de séances photo, ce qui la rend idéale pour la création rapide de contenu et le prototypage.

Les modèles de diffusion fonctionnent en partant d’un bruit aléatoire pur et en le raffinant progressivement par des étapes itératives de débruitage. L’instruction textuelle est convertie en représentations numériques qui guident ce processus de débruitage, transformant progressivement le bruit en une image cohérente correspondant à la description. Cette approche étape par étape permet un contrôle précis et produit des résultats de haute qualité, détaillés et en parfaite adéquation avec le texte d’entrée.

Les trois technologies principales sont les réseaux antagonistes génératifs (GANs), qui utilisent des réseaux neuronaux concurrents pour créer des images réalistes ; les modèles de diffusion, qui transforment de manière itérative le bruit aléatoire en images structurées ; et les transformers, qui convertissent des instructions textuelles en images grâce à des mécanismes d’auto-attention. Chaque architecture possède des atouts distincts : les GANs excellent dans le photoréalisme, les modèles de diffusion produisent des résultats très détaillés, et les transformers gèrent de manière exceptionnelle la synthèse complexe texte-image.

La propriété intellectuelle des images générées par IA reste juridiquement ambiguë et varie selon la juridiction. Dans de nombreux cas, le droit d’auteur peut appartenir à la personne ayant créé l’instruction, au développeur du modèle IA, ou potentiellement à personne si l’IA fonctionne de façon autonome. L’Office américain du droit d’auteur a indiqué que les œuvres créées entièrement par IA sans intervention créative humaine pourraient ne pas bénéficier de protection, bien que ce domaine juridique évolue avec des litiges et régulations en cours.

Les images générées par IA sont largement utilisées dans le e-commerce pour la photographie de produits, en marketing pour la création de visuels de campagne et de contenu pour les réseaux sociaux, dans le développement de jeux pour la création de personnages et d’assets, en imagerie médicale pour la visualisation diagnostique, et en publicité pour le test rapide de concepts. Selon des données récentes, 62 % des marketeurs utilisent l’IA pour créer de nouveaux visuels, et le marché de l’édition d’images par IA est évalué à 88,7 milliards de dollars en 2025, ce qui montre une adoption significative par les entreprises de tous secteurs.

Les générateurs d’images IA actuels ont du mal à produire des mains et des visages humains anatomiquement corrects, générant souvent des caractéristiques inhabituelles comme des doigts supplémentaires ou des éléments faciaux asymétriques. Ils dépendent aussi fortement de la qualité des données d’entraînement, ce qui peut introduire des biais et limiter la diversité des résultats. De plus, obtenir des détails spécifiques nécessite une rédaction d’instructions soignée, et la technologie produit parfois des résultats peu naturels ou qui ne reflètent pas l’intention créative recherchée.

La plupart des générateurs d’images IA sont entraînés sur d’immenses ensembles de données d’images collectées sur internet, dont beaucoup sont protégées par le droit d’auteur. Cela a entraîné d’importants litiges, des artistes ayant intenté des procès contre des entreprises comme Stability AI et Midjourney pour l’utilisation d’images protégées sans autorisation ni compensation. Certaines plateformes comme Getty Images et Shutterstock ont interdit les soumissions d’images générées par IA en raison de ces préoccupations non résolues, et des cadres réglementaires sont encore en cours d’élaboration pour traiter la transparence des données et la rémunération équitable.

Le marché mondial des générateurs d’images IA était évalué à 299,2 millions de dollars en 2023 et devrait croître à un taux composé annuel de 17,4 % jusqu’en 2030. Le marché plus large de l’édition d’images par IA est évalué à 88,7 milliards de dollars en 2025 et devrait atteindre 8,9 milliards en 2034. Par ailleurs, 71 % des images sur les réseaux sociaux sont désormais générées par IA, et le marché des réseaux sociaux pilotés par IA devrait atteindre 12 milliards de dollars d’ici 2031, montrant une croissance explosive et une adoption généralisée.

Commencez à suivre comment les chatbots IA mentionnent votre marque sur ChatGPT, Perplexity et d'autres plateformes. Obtenez des informations exploitables pour améliorer votre présence IA.

L’IA générative crée de nouveaux contenus à partir de données d’entraînement grâce à des réseaux neuronaux. Découvrez son fonctionnement, ses applications dans ...

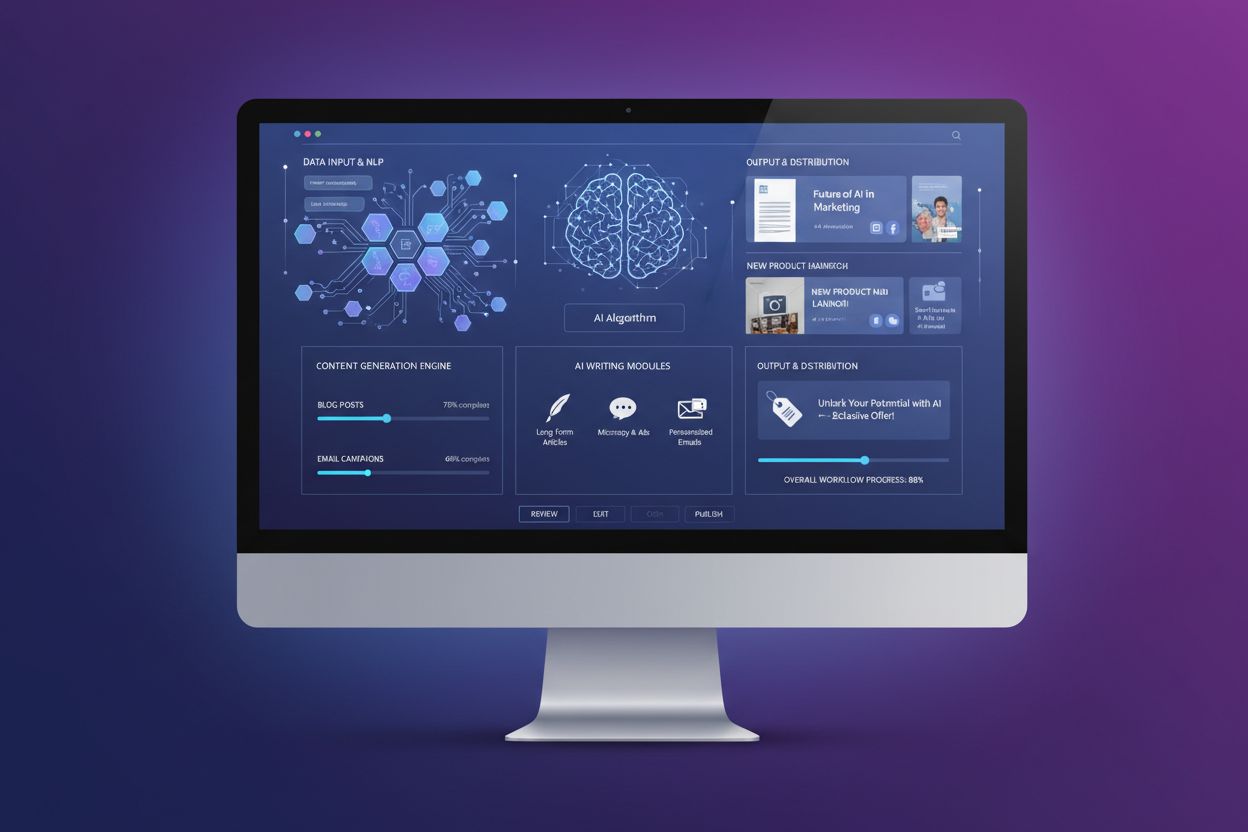

Découvrez ce qu'est la génération de contenu par IA, son fonctionnement, ses avantages et défis, ainsi que les meilleures pratiques pour utiliser les outils d'I...

Le filigranage du contenu généré par l’IA intègre des marqueurs numériques dans le matériel généré par l’IA pour vérifier son authenticité. Découvrez les techni...