Ajustement fin

Définition de l’ajustement fin : adaptation de modèles d’IA pré-entraînés à des tâches spécifiques via un entraînement ciblé. Découvrez comment l’ajustement fin...

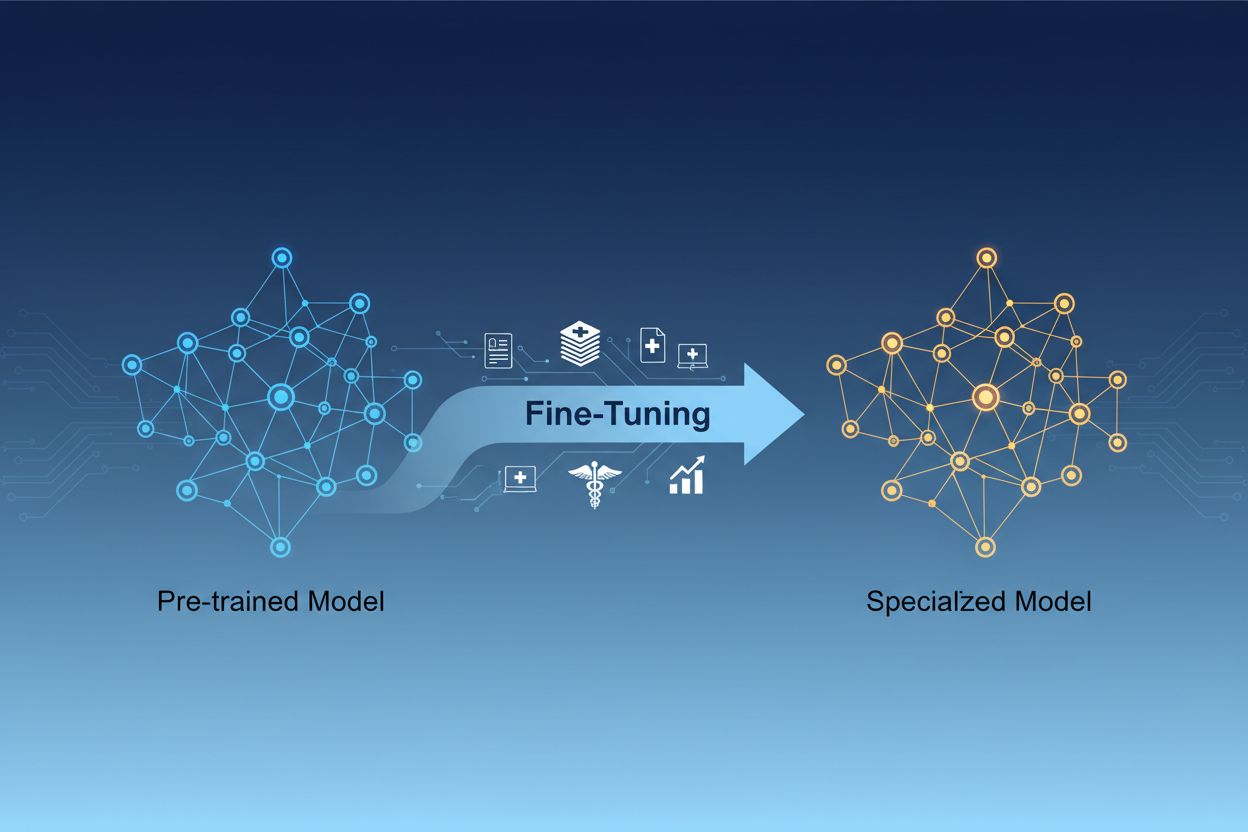

L’ajustement fin de modèle IA est le processus d’adaptation de modèles d’intelligence artificielle pré-entraînés pour accomplir des tâches spécifiques ou travailler avec des données spécialisées, en ajustant leurs paramètres via un entraînement supplémentaire sur des ensembles de données propres à un domaine. Cette approche exploite les connaissances fondamentales existantes tout en personnalisant les modèles pour des applications métiers particulières, permettant aux organisations de créer des systèmes IA hautement spécialisés sans le coût computationnel d’un entraînement depuis zéro.

L’ajustement fin de modèle IA est le processus d’adaptation de modèles d’intelligence artificielle pré-entraînés pour accomplir des tâches spécifiques ou travailler avec des données spécialisées, en ajustant leurs paramètres via un entraînement supplémentaire sur des ensembles de données propres à un domaine. Cette approche exploite les connaissances fondamentales existantes tout en personnalisant les modèles pour des applications métiers particulières, permettant aux organisations de créer des systèmes IA hautement spécialisés sans le coût computationnel d’un entraînement depuis zéro.

L’ajustement fin de modèle IA est le processus qui consiste à prendre un modèle d’intelligence artificielle pré-entraîné et à l’adapter pour réaliser des tâches spécifiques ou traiter des données spécialisées. Plutôt que d’entraîner un modèle depuis zéro, l’ajustement fin exploite les connaissances fondamentales déjà présentes dans un modèle pré-entraîné et ajuste ses paramètres via un entraînement supplémentaire sur des ensembles de données spécifiques à un domaine ou une tâche. Cette approche combine l’efficacité de l’apprentissage par transfert avec la personnalisation requise pour des applications métiers particulières. L’ajustement fin permet aux organisations de créer des modèles IA hautement spécialisés sans les coûts computationnels et le temps nécessaires à un entraînement complet, ce qui en fait une technique essentielle dans le développement moderne de l’apprentissage automatique.

La distinction entre l’ajustement fin et l’entraînement depuis zéro représente l’une des décisions les plus importantes dans le développement de l’apprentissage automatique. Lorsqu’on entraîne un modèle depuis zéro, on commence avec des poids initialisés aléatoirement et il faut tout enseigner au modèle : schémas linguistiques, caractéristiques visuelles ou connaissances spécifiques via d’immenses ensembles de données et des ressources computationnelles conséquentes. Cette approche peut nécessiter des semaines ou des mois d’entraînement ainsi que l’accès à du matériel spécialisé comme des GPU ou TPU. L’ajustement fin, à l’inverse, commence avec un modèle qui comprend déjà des schémas et concepts fondamentaux, ne nécessitant qu’une fraction des données et de la puissance de calcul pour l’adapter à vos besoins spécifiques. Le modèle pré-entraîné a déjà appris des caractéristiques générales au cours de sa phase initiale, donc l’ajustement fin se concentre sur l’adaptation de ces caractéristiques à votre cas d’usage particulier. Ce gain d’efficacité fait de l’ajustement fin l’approche privilégiée par la plupart des organisations, car il réduit à la fois le temps de mise sur le marché et les coûts d’infrastructure tout en offrant souvent de meilleures performances que l’entraînement de petits modèles depuis zéro.

| Aspect | Ajustement fin | Entraînement depuis zéro |

|---|---|---|

| Temps d’entraînement | Jours à semaines | Semaines à mois |

| Besoins en données | Milliers à millions d’exemples | Millions à milliards d’exemples |

| Coût computationnel | Modéré (un seul GPU souvent suffisant) | Extrêmement élevé (plusieurs GPU/TPU requis) |

| Connaissances initiales | Utilise des poids pré-entraînés | Démarre avec une initialisation aléatoire |

| Performance | Souvent supérieure avec peu de données | Meilleure avec d’immenses ensembles de données |

| Expertise requise | Intermédiaire | Avancée |

| Niveau de personnalisation | Élevé pour des tâches spécifiques | Flexibilité maximale |

| Infrastructure | Ressources cloud standard | Clusters matériels spécialisés |

L’ajustement fin est devenu une capacité essentielle pour les organisations souhaitant déployer des solutions IA offrant un avantage concurrentiel. En adaptant des modèles pré-entraînés à votre contexte métier spécifique, vous créez des systèmes IA capables de comprendre la terminologie de votre secteur, les préférences de vos clients et vos contraintes opérationnelles avec une grande précision. Cette personnalisation permet d’atteindre des niveaux de performance que des modèles génériques ne peuvent égaler, notamment dans des domaines pointus comme la santé, le droit ou le support technique. Le rapport coût-efficacité de l’ajustement fin signifie que même des entreprises de taille modeste peuvent accéder à des capacités IA de niveau entreprise sans investissements massifs en infrastructure. De plus, les modèles ajustés finement peuvent être déployés plus rapidement, permettant une réaction rapide aux opportunités de marché et à la pression concurrentielle. La possibilité d’améliorer continuellement les modèles en les ajustant sur de nouvelles données garantit que vos systèmes IA restent pertinents et performants à mesure que votre environnement évolue.

Principaux avantages métier de l’ajustement fin :

Plusieurs techniques éprouvées se sont imposées comme bonnes pratiques dans l’ajustement fin, chacune présentant des avantages selon vos besoins spécifiques. L’ajustement fin complet consiste à mettre à jour tous les paramètres du modèle pré-entraîné, offrant une flexibilité maximale et souvent les meilleures performances, mais nécessitant d’importantes ressources computationnelles et de grands ensembles de données pour éviter le surajustement. Les méthodes d’ajustement fin efficace telles que LoRA (Low-Rank Adaptation) et QLoRA ont révolutionné le domaine en permettant une adaptation efficace des modèles tout en n’ajustant qu’une petite fraction des paramètres, réduisant de façon spectaculaire les besoins en mémoire et le temps d’entraînement. Ces techniques ajoutent des matrices de faible rang entraînables aux matrices de poids du modèle, capturant les adaptations spécifiques à la tâche sans modifier les poids pré-entraînés. Les modules adaptateurs représentent une autre approche, insérant de petits réseaux entraînables entre les couches du modèle gelé, pour un ajustement efficace avec peu de paramètres supplémentaires. L’ajustement basé sur les prompts vise à optimiser les instructions d’entrée plutôt que les poids du modèle, utile quand l’accès aux paramètres est limité. L’ajustement sur instructions forme les modèles à suivre des consignes précises, particulièrement important pour les grands modèles de langage qui doivent répondre à des demandes diverses. Le choix entre ces techniques dépend de vos contraintes computationnelles, de la taille de votre ensemble de données, de vos objectifs de performance et de l’architecture du modèle utilisé.

L’ajustement fin des grands modèles de langage (LLM) présente des opportunités et défis spécifiques par rapport à l’ajustement de modèles plus petits ou d’autres réseaux de neurones. Les LLM modernes, de type GPT, comptent des milliards de paramètres, rendant un ajustement complet prohibitif pour la plupart des organisations. Cette réalité a encouragé l’adoption de techniques efficaces permettant une adaptation pertinente sans infrastructure à l’échelle entreprise. L’ajustement sur instructions est devenu particulièrement important pour les LLM, où les modèles sont entraînés sur des exemples d’instructions associées à des réponses de qualité, pour mieux suivre les directives des utilisateurs. L’apprentissage par renforcement à partir de feedback humain (RLHF) est une approche avancée affinant les modèles selon les préférences et évaluations humaines, améliorant leur alignement avec les attentes humaines. La faible quantité de données spécifiques requises pour ajuster des LLM—souvent quelques centaines à quelques milliers d’exemples—rend cette approche accessible sans d’énormes ensembles annotés. Cependant, l’ajustement de LLM exige une attention particulière au choix des hyperparamètres, à la planification du taux d’apprentissage et à la prévention de l’oubli catastrophique, où le modèle perd ses acquis initiaux en s’adaptant à de nouvelles tâches.

Les organisations de tous secteurs ont trouvé des applications puissantes aux modèles IA ajustés finement, générant une réelle valeur métier. L’automatisation du service client est l’un des cas d’usage les plus courants : les modèles sont ajustés sur les tickets de support, informations produits et styles de communication propres à l’entreprise pour créer des chatbots capables de traiter les demandes clients avec expertise sectorielle et cohérence de marque. L’analyse de documents médicaux et juridiques exploite l’ajustement fin pour adapter des modèles généraux à la compréhension de terminologies spécialisées, de réglementations et de formats propres au secteur, permettant une extraction et une classification précises de l’information. L’analyse de sentiment et la modération de contenu sont grandement améliorées en ajustant les modèles sur des exemples issus de votre secteur ou communauté, pour saisir des nuances et contextes que les modèles génériques ignorent. La génération de code et l’assistance au développement logiciel bénéficient de l’ajustement sur votre propre base de code, vos conventions de programmation et vos architectures, afin de générer du code aligné sur vos standards. Les systèmes de recommandation sont fréquemment ajustés sur les données comportementales des utilisateurs et les catalogues produits pour proposer des suggestions personnalisées générant engagement et chiffre d’affaires. La reconnaissance d’entités nommées et l’extraction d’informations dans des documents sectoriels—rapports financiers, articles scientifiques, spécifications techniques—sont considérablement améliorées grâce à un ajustement sur des exemples pertinents. Ces applications diverses montrent que l’ajustement fin n’est pas limité à un secteur ou usage unique, mais constitue une capacité fondamentale pour créer des systèmes IA générant un avantage concurrentiel dans presque tous les domaines d’activité.

Le processus d’ajustement fin suit un flux de travail structuré, de la préparation minutieuse à la surveillance post-déploiement. La préparation des données est l’étape cruciale, nécessitant de collecter, nettoyer et formater votre jeu de données sectoriel de manière conforme à la structure d’entrée-sortie attendue par le modèle pré-entraîné. Ce jeu de données doit être représentatif des tâches que votre modèle ajusté devra réaliser en production, la qualité primant sur la quantité : un petit jeu d’exemples de haute qualité surpasse généralement un grand ensemble de données bruitées ou incohérentes. La répartition entraînement-validation-test permet d’évaluer correctement la performance du modèle, avec des répartitions classiques de 70-80 % pour l’entraînement, 10-15 % pour la validation et 10-15 % pour le test. Le choix des hyperparamètres consiste à sélectionner taux d’apprentissage, taille de lot, nombre d’époques d’entraînement et autres paramètres qui régissent l’ajustement fin ; ces choix ont un impact majeur sur la performance et l’efficacité de l’entraînement. L’initialisation du modèle utilise les poids pré-entraînés comme point de départ, conservant les connaissances fondamentales tout en permettant une adaptation à votre tâche. L’exécution de l’entraînement consiste à mettre à jour les paramètres du modèle sur vos données d’entraînement en surveillant la validation pour éviter le surajustement. L’évaluation et l’itération s’appuient sur votre jeu de test pour mesurer la performance finale et déterminer si un ajustement supplémentaire, d’autres hyperparamètres ou plus de données seraient bénéfiques. La préparation au déploiement inclut l’optimisation du modèle pour la rapidité d’inférence et l’efficacité des ressources, éventuellement via la quantification ou la distillation. Enfin, la surveillance et la maintenance en production garantissent que le modèle reste performant malgré l’évolution des données, avec des réentraînements périodiques pour maintenir la précision.

L’ajustement fin, bien plus efficace que l’entraînement depuis zéro, présente ses propres défis à relever avec soin. Le surajustement survient lorsque le modèle mémorise les données d’entraînement au lieu de généraliser, risque accentué avec de petits jeux de données ; il se maîtrise via l’arrêt anticipé, la régularisation et l’augmentation de données. L’oubli catastrophique apparaît lorsque l’ajustement fin fait perdre au modèle ses acquis précédents, problématique lors de l’adaptation d’un modèle généraliste à une tâche spécialisée ; un choix judicieux du taux d’apprentissage et des techniques comme la distillation des connaissances permettent de préserver les savoirs fondamentaux. La qualité et l’annotation des données constituent un défi pratique majeur, l’ajustement fin nécessitant des exemples de haute qualité représentant fidèlement votre domaine et vos cas d’usage. La gestion des ressources computationnelles impose de trouver un équilibre entre gains de performance, temps d’entraînement et coûts d’infrastructure, surtout avec de grands modèles. La sensibilité aux hyperparamètres implique que la performance de l’ajustement fin peut varier fortement selon le taux d’apprentissage, la taille de lot, etc., nécessitant des expérimentations et validations systématiques.

Bonnes pratiques pour réussir son ajustement fin :

Les organisations doivent souvent choisir entre trois approches complémentaires pour adapter les modèles IA à des tâches précises : l’ajustement fin, la génération augmentée par récupération (RAG) et l’ingénierie de prompt. L’ingénierie de prompt consiste à rédiger soigneusement des instructions et exemples pour guider le comportement du modèle sans en modifier les paramètres ; cette méthode est rapide et ne nécessite pas d’entraînement, mais son efficacité est limitée pour les tâches complexes et ne permet pas d’apprendre de nouvelles connaissances au modèle. RAG enrichit les réponses du modèle en récupérant des documents ou données externes avant de générer une réponse, donnant accès à des informations à jour ou spécifiques au domaine sans ajuster les paramètres ; cette approche convient aux tâches intensives en connaissances mais ajoute de la latence et de la complexité à l’inférence. L’ajustement fin modifie les paramètres du modèle pour y intégrer profondément des connaissances et schémas spécifiques à la tâche, offrant la meilleure performance pour des tâches bien définies et avec suffisamment de données, mais nécessitant plus de temps et de ressources que les autres méthodes. La solution optimale combine souvent ces techniques : ingénierie de prompt pour prototyper rapidement, RAG pour les applications nécessitant des connaissances à jour, et ajustement fin pour les systèmes critiques où l’investissement en entraînement est justifié. L’ajustement fin est idéal pour des comportements cohérents et performants sur des tâches précises, lorsqu’on dispose de données d’entraînement suffisantes et que le gain de performance justifie l’effort. RAG est pertinent pour les applications devant accéder à de l’information actuelle ou propriétaire évoluant fréquemment. L’ingénierie de prompt sert d’excellent point de départ pour le prototypage avant de s’engager dans des approches plus coûteuses. Comprendre les forces et limites de chaque méthode permet aux organisations de faire des choix éclairés selon les composantes de leurs systèmes IA.

L’apprentissage par transfert est le concept général consistant à exploiter les connaissances acquises sur une tâche pour améliorer la performance sur une autre, tandis que l’ajustement fin est une mise en œuvre spécifique de cette approche. L’ajustement fin consiste à prendre un modèle pré-entraîné et à ajuster ses paramètres sur de nouvelles données, alors que l’apprentissage par transfert peut aussi inclure l’extraction de caractéristiques, où l’on fige les poids pré-entraînés et n’entraîne que de nouvelles couches. Tout ajustement fin implique un apprentissage par transfert, mais tout apprentissage par transfert ne nécessite pas un ajustement fin.

Le temps d’ajustement fin varie considérablement selon la taille du modèle, celle de l’ensemble de données et le matériel disponible. Avec des techniques efficaces comme LoRA, un modèle de 13 milliards de paramètres peut être ajusté finement en environ 5 heures sur un seul GPU A100. Des modèles plus petits ou des méthodes efficaces peuvent ne prendre que quelques heures, tandis qu’un ajustement complet de grands modèles peut prendre des jours ou des semaines. L’avantage principal est que l’ajustement fin est beaucoup plus rapide que l’entraînement depuis zéro, qui peut prendre des mois.

Oui, l’ajustement fin est précisément conçu pour fonctionner efficacement avec peu de données. Les modèles pré-entraînés ont déjà appris des schémas généraux, il ne faut donc généralement que quelques centaines à quelques milliers d’exemples pour un ajustement efficace, contre des millions pour un entraînement depuis zéro. Toutefois, la qualité des données prime sur la quantité : un petit ensemble d’exemples de haute qualité et représentatifs surpassera un grand ensemble de données avec des labels incohérents ou bruités.

LoRA (Low-Rank Adaptation) est une technique d’ajustement fin efficace qui ajoute des matrices de faible rang entraînables aux matrices de poids d’un modèle, au lieu de mettre à jour tous les paramètres. Cette méthode réduit le nombre de paramètres entraînables de plusieurs ordres de grandeur tout en maintenant des performances comparables à un ajustement complet. LoRA est important car il rend l’ajustement fin accessible sur du matériel standard, réduit considérablement les besoins en mémoire et permet d’ajuster de grands modèles sans infrastructure coûteuse.

Le surajustement se produit lorsque la perte d’entraînement diminue mais que la perte de validation augmente, indiquant que le modèle mémorise les données d’entraînement au lieu d’apprendre des schémas généralisables. Surveillez les deux métriques pendant l’entraînement : si la performance en validation stagne ou se dégrade alors que celle sur l’entraînement continue de s’améliorer, votre modèle surajuste probablement. Mettez en place un arrêt anticipé pour stopper l’entraînement lorsque la validation n’évolue plus, et utilisez des techniques comme la régularisation et l’augmentation de données pour prévenir le surajustement.

Les coûts de l’ajustement fin incluent les ressources computationnelles (temps GPU/TPU), la préparation et l’étiquetage des données, le stockage du modèle et l’infrastructure de déploiement, ainsi que la surveillance et la maintenance continue. Cependant, ces coûts sont généralement 10 à 100 fois inférieurs à ceux de l’entraînement depuis zéro. L’utilisation de techniques efficaces comme LoRA peut réduire les coûts computationnels de 80 à 90 % par rapport à un ajustement complet, rendant l’ajustement fin économique pour la plupart des organisations.

Oui, l’ajustement fin améliore généralement significativement la précision du modèle pour des tâches spécifiques. En s’entraînant sur des données propres à un domaine, les modèles apprennent des schémas et une terminologie pertinents que les modèles génériques ignorent. Des études montrent que l’ajustement fin peut augmenter la précision de 10 à 30 % ou plus selon la tâche et la qualité de l’ensemble de données. Le gain est le plus marqué lorsque la tâche d’ajustement fin diffère de la tâche de pré-entraînement, car le modèle adapte ses acquis à vos besoins spécifiques.

L’ajustement fin permet aux organisations de conserver les données sensibles sur leur propre infrastructure, sans les envoyer vers des API tierces. Vous pouvez ajuster localement des modèles sur des données propriétaires ou réglementées sans les exposer à des services externes, assurant ainsi la conformité avec des réglementations telles que le RGPD, HIPAA ou d’autres exigences sectorielles. Cette approche offre à la fois sécurité et conformité tout en maintenant les avantages de performance liés à l’utilisation de modèles pré-entraînés.

Suivez comment des systèmes IA comme GPTs, Perplexity et Google AI Overviews citent et mentionnent votre marque grâce à la plateforme de veille IA d’AmICited.

Définition de l’ajustement fin : adaptation de modèles d’IA pré-entraînés à des tâches spécifiques via un entraînement ciblé. Découvrez comment l’ajustement fin...

Découvrez comment un formatage adapté à l’IA avec des tableaux, listes et sections claires améliore la précision de l’analyse par l’IA et augmente la visibilité...

Les paramètres du modèle sont des variables apprenables dans les modèles d’IA qui déterminent le comportement. Comprenez les poids, les biais et comment les par...