Centre d’Excellence pour la Visibilité de l’IA

Découvrez ce qu’est un Centre d’Excellence pour la Visibilité de l’IA, ses principales responsabilités, ses capacités de surveillance et comment il permet aux o...

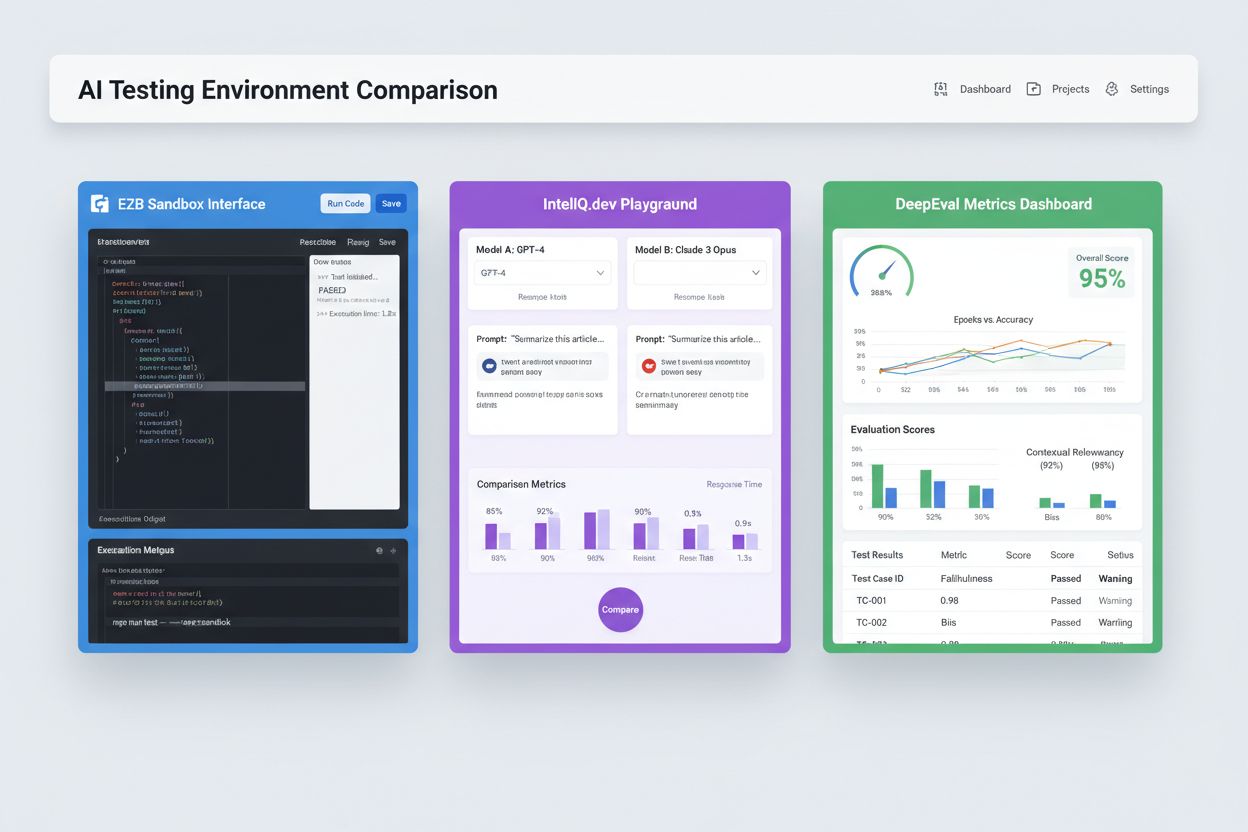

Environnements isolés de type sandbox conçus pour valider, évaluer et déboguer les modèles et applications d’intelligence artificielle avant le déploiement en production. Ces espaces contrôlés permettent de tester les performances des contenus IA sur différentes plateformes, de mesurer des indicateurs et de garantir la fiabilité sans impacter les systèmes en production ni exposer de données sensibles.

Environnements isolés de type sandbox conçus pour valider, évaluer et déboguer les modèles et applications d’intelligence artificielle avant le déploiement en production. Ces espaces contrôlés permettent de tester les performances des contenus IA sur différentes plateformes, de mesurer des indicateurs et de garantir la fiabilité sans impacter les systèmes en production ni exposer de données sensibles.

Un environnement de test IA est un espace informatique contrôlé et isolé, conçu pour valider, évaluer et déboguer les modèles et applications d’intelligence artificielle avant leur déploiement sur des systèmes de production. Il sert de sandbox où développeurs, data scientists et équipes QA peuvent exécuter en toute sécurité des modèles IA, tester différentes configurations et mesurer la performance selon des indicateurs prédéfinis, sans impacter les systèmes en production ni exposer de données sensibles. Ces environnements répliquent les conditions de production tout en maintenant une isolation totale, permettant aux équipes d’identifier les problèmes, d’optimiser le comportement des modèles et d’assurer la fiabilité dans divers scénarios. L’environnement de test constitue une étape qualité essentielle dans le cycle de développement IA, faisant le lien entre le prototypage expérimental et le déploiement en entreprise.

Un environnement de test IA complet se compose de plusieurs couches techniques interconnectées qui assurent l’ensemble des capacités de test. La couche d’exécution du modèle gère l’inférence et le calcul, en supportant divers frameworks (PyTorch, TensorFlow, ONNX) et types de modèles (LLMs, vision par ordinateur, séries temporelles). La couche de gestion des données administre les jeux de données de test, fixtures et la génération de données synthétiques, tout en assurant l’isolation et la conformité. Le cadre d’évaluation inclut des moteurs de métriques, des bibliothèques d’assertions et des systèmes de score qui comparent les sorties du modèle aux résultats attendus. La couche de surveillance et de journalisation capture les traces d’exécution, les indicateurs de performance, les temps de latence et les logs d’erreurs pour l’analyse post-test. La couche d’orchestration gère les workflows de test, l’exécution parallèle, l’allocation des ressources et la mise à disposition des environnements. Voici une comparaison des principaux éléments architecturaux selon les types d’environnements de test :

| Composant | Test LLM | Vision par ordinateur | Séries temporelles | Multi-modal |

|---|---|---|---|---|

| Exécution du modèle | Inférence Transformer | Inférence accélérée GPU | Traitement séquentiel | Exécution hybride |

| Format des données | Texte/tokens | Images/tensors | Séquences numériques | Médias mixtes |

| Indicateurs d’évaluation | Similarité sémantique, hallucination | Précision, IoU, score F1 | RMSE, MAE, MAPE | Alignement cross-modal |

| Exigences de latence | 100-500ms typique | 50-200ms typique | <100ms typique | 200-1000ms typique |

| Méthode d’isolation | Conteneur/VM | Conteneur/VM | Conteneur/VM | microVM Firecracker |

Les environnements de test IA modernes doivent supporter des écosystèmes de modèles hétérogènes, afin de permettre l’évaluation simultanée d’applications sur différents fournisseurs de LLM, frameworks et cibles de déploiement. Les tests multiplateforme offrent aux organisations la possibilité de comparer les sorties des modèles d’OpenAI GPT-4, Anthropic Claude, Mistral et des alternatives open-source comme Llama au sein d’un même banc de test, facilitant ainsi les choix de modèles éclairés. Des plateformes comme E2B offrent des sandboxes isolés capables d’exécuter du code généré par n’importe quel LLM, avec la prise en charge de Python, JavaScript, Ruby et C++ et un accès complet au système de fichiers, au terminal et à l’installation de packages. IntelIQ.dev permet la comparaison côte à côte de plusieurs modèles IA avec des interfaces unifiées, pour tester prompts gardés et templates sensibles aux politiques sur différents fournisseurs. Les environnements de test doivent gérer :

Les environnements de test IA répondent à des besoins organisationnels variés dans le développement, l’assurance qualité et la conformité. Les équipes de développement utilisent ces environnements pour valider le comportement des modèles lors du développement itératif, tester des variations de prompts, affiner les paramètres et déboguer des résultats inattendus avant intégration. Les équipes data science évaluent la performance des modèles sur des jeux de données de validation, comparent différentes architectures et mesurent des métriques telles que la précision, le rappel et les scores F1. La surveillance en production implique des tests continus des modèles déployés par rapport à des indicateurs de référence, la détection de la dégradation des performances et le déclenchement de pipelines de réentraînement si les seuils de qualité sont dépassés. Les équipes conformité et sécurité valident que les modèles respectent la réglementation, n’induisent pas de biais et gèrent correctement les données sensibles. Exemples d’applications :

L’écosystème des tests IA comprend des plateformes spécialisées selon les scénarios de test et les échelles organisationnelles. DeepEval est un framework open-source d’évaluation LLM proposant plus de 50 métriques issues de la recherche (exactitude des réponses, similarité sémantique, détection d’hallucinations, scoring de toxicité), avec une intégration native à Pytest pour les workflows CI/CD. LangSmith (par LangChain) offre des capacités complètes d’observabilité, d’évaluation et de déploiement, avec traçage intégré, gestion de versions de prompts et datasets pour applications LLM. E2B fournit des sandboxes isolés et sécurisés propulsés par des microVM Firecracker, pour exécuter du code avec des temps de démarrage sous 200ms, des sessions jusqu’à 24h et l’intégration avec les principaux fournisseurs LLM. IntelIQ.dev met l’accent sur la confidentialité avec chiffrement de bout en bout, contrôles d’accès par rôle et prise en charge de plusieurs modèles IA, dont GPT-4, Claude et des alternatives open-source. Le tableau suivant compare les principales fonctionnalités :

| Outil | Focalisation principale | Indicateurs | Intégration CI/CD | Support multi-modèles | Modèle tarifaire |

|---|---|---|---|---|---|

| DeepEval | Évaluation LLM | 50+ métriques | Pytest native | Limité | Open-source + cloud |

| LangSmith | Observabilité & évaluation | Métriques personnalisées | API | Écosystème LangChain | Freemium + entreprise |

| E2B | Exécution de code | Performances | GitHub Actions | Tous LLM | À l’usage + entreprise |

| IntelIQ.dev | Tests confidentialité | Métriques personnalisées | Workflow builder | GPT-4, Claude, Mistral | Abonnement |

Les environnements de test IA d’entreprise doivent appliquer des contrôles de sécurité rigoureux pour protéger les données sensibles, assurer la conformité et prévenir les accès non autorisés. L’isolation des données impose que les données de test ne fuient jamais vers des APIs externes ou services tiers ; des plateformes comme E2B utilisent des microVM Firecracker pour une isolation totale des processus, sans accès au noyau partagé. Les standards de chiffrement doivent inclure le chiffrement de bout en bout des données au repos et en transit, avec prise en charge des exigences HIPAA, SOC 2 Type 2 et RGPD. Les contrôles d’accès doivent appliquer des permissions par rôle, la journalisation des accès et des workflows d’approbation pour les scénarios de test sensibles. Les bonnes pratiques recommandent : des jeux de données de test distincts sans données de production, le masquage des données personnelles (PII), l’utilisation de données synthétiques pour des tests réalistes sans risque de vie privée, des audits réguliers de la sécurité de l’infrastructure de test et la documentation complète des résultats pour la conformité. Les organisations doivent aussi mettre en place des mécanismes de détection des biais pour repérer les comportements discriminants, utiliser des outils d’interprétabilité comme SHAP ou LIME pour comprendre les décisions des modèles, et instaurer une journalisation des décisions afin de tracer comment les modèles produisent certains résultats pour répondre aux obligations réglementaires.

Les environnements de test IA doivent s’intégrer sans couture aux pipelines d’intégration et de déploiement continus existants pour activer des gates qualité automatisés et des cycles de développement rapides. L’intégration CI/CD native permet de lancer automatiquement les tests lors de commits, pull requests ou sur planification, via GitHub Actions, GitLab CI ou Jenkins. L’intégration Pytest de DeepEval permet d’écrire des cas de test comme des tests Python standards, exécutés dans les workflows CI existants et dont les résultats sont affichés avec les tests unitaires classiques. L’évaluation automatisée peut mesurer les indicateurs de performance des modèles, comparer les sorties avec des versions de référence et bloquer les déploiements si les seuils de qualité ne sont pas atteints. La gestion des artefacts implique le stockage des datasets de test, checkpoints de modèles et résultats d’évaluation dans des systèmes de gestion de versions ou des dépôts d’artefacts pour la traçabilité et l’audit. Les schémas d’intégration incluent :

Le paysage des environnements de test IA évolue rapidement pour répondre aux défis émergents de complexité, d’échelle et d’hétérogénéité des modèles. Les tests agentiques deviennent cruciaux, les systèmes IA dépassant l’inférence d’un seul modèle pour réaliser des workflows multi-étapes où les agents utilisent des outils, prennent des décisions et interagissent avec des systèmes externes – ce qui exige de nouveaux cadres d’évaluation pour mesurer l’achèvement des tâches, la sécurité et la fiabilité. L’évaluation distribuée permet de tester à grande échelle avec des milliers d’instances en parallèle dans le cloud, essentielle pour l’apprentissage par renforcement et l’entraînement massif de modèles. La surveillance en temps réel évolue du batch vers des tests continus, de niveau production, pour détecter la dégradation des performances, la dérive des données et l’apparition de biais sur les systèmes en ligne. Des plateformes d’observabilité comme AmICited émergent comme outils clés de monitoring et de visibilité IA, avec des tableaux de bord centralisés qui suivent la performance, les usages et la qualité des modèles sur l’ensemble du portefeuille IA. Les environnements de test de demain intégreront de plus en plus la remédiation automatisée, où les systèmes détectent les problèmes et déclenchent automatiquement du réentraînement ou la mise à jour des modèles, ainsi que l’évaluation cross-modal, permettant de tester simultanément des modèles texte, image, audio et vidéo dans des frameworks unifiés.

Un environnement de test IA est un espace isolé de type sandbox où vous pouvez tester en toute sécurité des modèles, des prompts et des configurations sans impacter les systèmes ou utilisateurs en production. Le déploiement en production correspond à l’environnement en direct où les modèles servent de vrais utilisateurs. Les environnements de test permettent de détecter les problèmes, d’optimiser les performances et de valider les changements avant la mise en production, réduisant ainsi les risques et assurant la qualité.

Oui, les environnements de test IA modernes supportent les tests multi-modèles. Des plateformes comme E2B, IntelIQ.dev et DeepEval permettent de tester le même prompt ou la même entrée sur différents fournisseurs de LLM (OpenAI, Anthropic, Mistral, etc.) en même temps, et ainsi comparer directement les sorties et les indicateurs de performance.

Les environnements de test IA d’entreprise mettent en œuvre plusieurs couches de sécurité, y compris l’isolation des données (containerisation ou microVM), le chiffrement de bout en bout, les contrôles d’accès basés sur les rôles, la journalisation des audits et les certifications de conformité (SOC 2, RGPD, HIPAA). Les données ne quittent jamais l’environnement isolé sauf exportation explicite, protégeant ainsi les informations sensibles.

Les environnements de test permettent la conformité en fournissant des pistes d’audit pour toutes les évaluations de modèles, en prenant en charge le masquage de données et la génération de données synthétiques, en appliquant des contrôles d’accès et en maintenant une isolation complète des données de test par rapport aux systèmes de production. Cette documentation et ce contrôle aident les organisations à répondre aux exigences réglementaires telles que le RGPD, HIPAA et SOC 2.

Les indicateurs clés dépendent de votre cas d’usage : pour les LLM, suivez la précision, la similarité sémantique, les taux d’hallucination et la latence ; pour les systèmes RAG, mesurez la précision/le rappel du contexte et la fidélité ; pour les modèles de classification, surveillez la précision, le rappel et les scores F1 ; pour tous les modèles, suivez la dégradation des performances dans le temps et les indicateurs de biais.

Les coûts varient selon les plateformes : DeepEval est open-source et gratuit ; LangSmith propose une offre gratuite avec des forfaits payants à partir de 39 $/mois ; E2B propose une tarification à l’usage basée sur le temps d’exécution du sandbox ; IntelIQ.dev propose une tarification par abonnement. De nombreuses plateformes proposent également des tarifs entreprise pour des déploiements à grande échelle.

Oui, la plupart des environnements de test modernes prennent en charge l’intégration CI/CD. DeepEval s’intègre nativement à Pytest, E2B fonctionne avec GitHub Actions et GitLab CI, et LangSmith fournit une intégration via API. Cela permet d’automatiser les tests à chaque commit de code et d’appliquer des gates de déploiement.

Les tests end-to-end considèrent l’ensemble de votre application IA comme une boîte noire, vérifiant la sortie finale par rapport aux résultats attendus. Les tests au niveau composant évaluent séparément chaque élément (appels LLM, récupérateurs, utilisation d’outils) à l’aide de traçage et d’instrumentation. Les tests au niveau composant offrent une analyse plus fine des problèmes potentiels, tandis que les tests end-to-end valident le comportement global du système.

AmICited suit la façon dont les systèmes IA référencent votre marque et vos contenus sur ChatGPT, Claude, Perplexity et Google AI. Bénéficiez d’une visibilité en temps réel sur votre présence IA grâce à une surveillance et une analyse complètes.

Découvrez ce qu’est un Centre d’Excellence pour la Visibilité de l’IA, ses principales responsabilités, ses capacités de surveillance et comment il permet aux o...

Découvrez comment l'intégration de l'écosystème IA connecte les assistants IA aux applications et services pour étendre les fonctionnalités. Découvrez les API, ...

Découvrez comment tester la présence de votre marque dans les moteurs IA grâce au test des invites. Découvrez des méthodes manuelles et automatisées pour survei...