Fenêtre de contexte

La fenêtre de contexte expliquée : le nombre maximal de jetons qu’un LLM peut traiter à la fois. Découvrez comment les fenêtres de contexte influencent la préci...

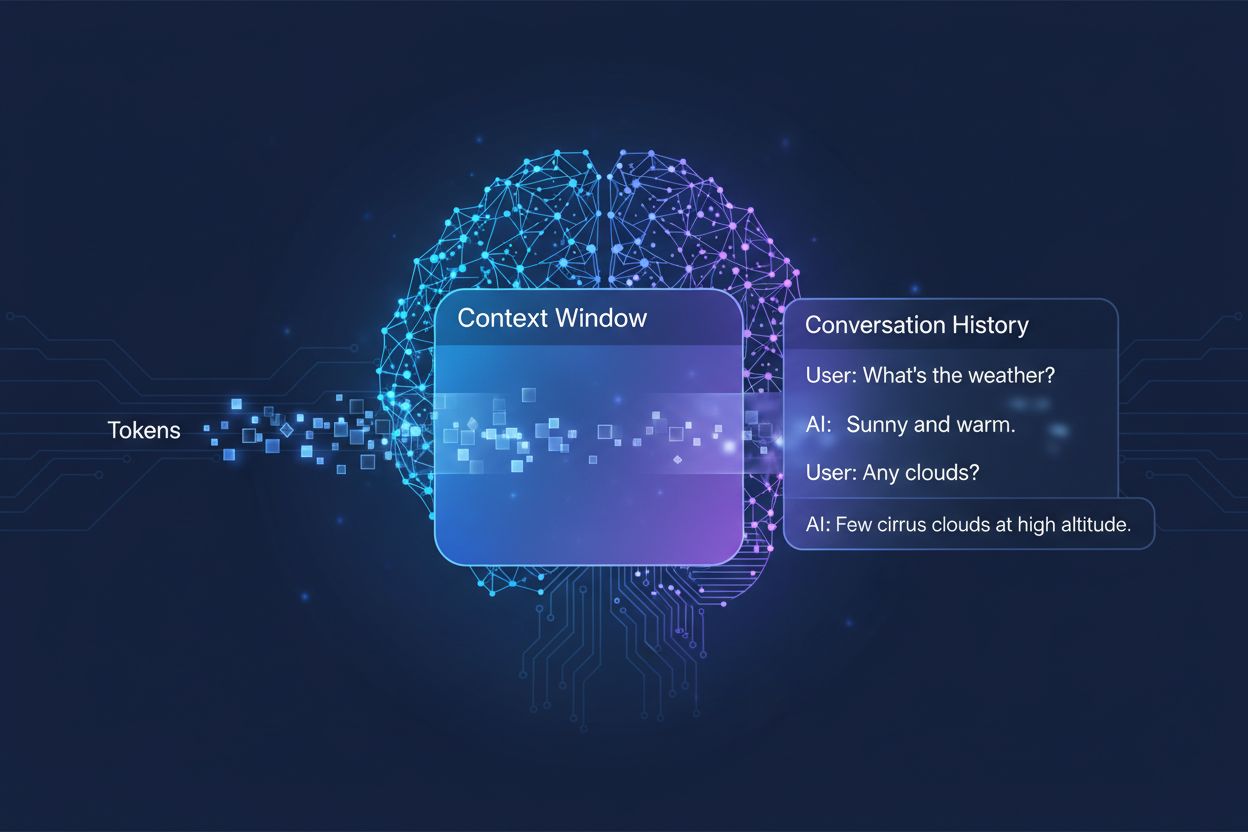

La quantité de conversation précédente qu’un système d’IA prend en compte lors de la génération de réponses, mesurée en tokens. Elle détermine la quantité de texte qu’une IA peut traiter simultanément et a un impact direct sur la qualité et la cohérence de ses sorties lors de conversations à plusieurs tours.

La quantité de conversation précédente qu'un système d'IA prend en compte lors de la génération de réponses, mesurée en tokens. Elle détermine la quantité de texte qu'une IA peut traiter simultanément et a un impact direct sur la qualité et la cohérence de ses sorties lors de conversations à plusieurs tours.

Une fenêtre de contexte est la quantité maximale de texte qu’un modèle de langage d’IA peut traiter et référencer en une seule fois lors d’une conversation ou d’une tâche. Pensez-y comme à la mémoire de travail du modèle—tout comme les humains ne peuvent garder qu’une quantité limitée d’informations à l’esprit, les modèles d’IA ne peuvent “voir” qu’une certaine quantité de texte avant et après leur position actuelle. Cette capacité est mesurée en tokens, qui sont de petites unités de texte représentant généralement des mots ou des fragments de mots (en moyenne, un mot anglais équivaut à environ 1,5 token). Comprendre la fenêtre de contexte de votre modèle est crucial car cela détermine directement la quantité d’informations que l’IA peut prendre en compte lors de la génération de réponses, constituant ainsi une limite fondamentale à la capacité du modèle à gérer efficacement des conversations complexes à plusieurs tours ou des documents longs.

Les modèles de langage modernes, en particulier les architectures à base de transformeur, traitent le texte en le convertissant en tokens puis en analysant simultanément les relations entre tous les tokens présents dans la fenêtre de contexte. L’architecture transformeur, introduite dans l’article fondateur de 2017 “Attention is All You Need”, utilise un mécanisme appelé auto-attention pour déterminer quelles parties de l’entrée sont les plus pertinentes les unes par rapport aux autres. Ce mécanisme d’attention permet au modèle de pondérer l’importance des différents tokens entre eux, lui permettant ainsi de comprendre le contexte et le sens sur toute la fenêtre. Cependant, ce processus devient coûteux en calcul à mesure que la fenêtre de contexte grandit, car le mécanisme d’attention doit calculer les relations entre chaque token et tous les autres—un problème de mise à l’échelle quadratique. Le tableau suivant illustre comment différents grands modèles d’IA se comparent en termes de capacités de fenêtre de contexte :

| Modèle | Fenêtre de contexte (tokens) | Date de sortie |

|---|---|---|

| GPT-4 | 128 000 | Mars 2023 |

| Claude 3 Opus | 200 000 | Mars 2024 |

| Gemini 1.5 Pro | 1 000 000 | Mai 2024 |

| GPT-4 Turbo | 128 000 | Novembre 2023 |

| Llama 2 | 4 096 | Juillet 2023 |

Ces capacités variables reflètent différents choix de conception et compromis informatiques effectués par chaque organisation, de plus grandes fenêtres permettant des applications plus sophistiquées mais nécessitant davantage de puissance de traitement.

L’évolution vers des fenêtres de contexte plus larges représente l’un des progrès les plus significatifs en matière de capacités de l’IA au cours de la dernière décennie. Les premiers réseaux neuronaux récurrents (RNN) et modèles LSTM avaient du mal avec le contexte, car ils traitaient le texte de façon séquentielle et peinaient à retenir l’information provenant de parties éloignées de l’entrée. Le tournant est venu en 2017 avec l’introduction de l’architecture transformeur, permettant le traitement parallèle des séquences entières et améliorant radicalement la capacité du modèle à maintenir le contexte sur des textes plus longs. Cela a conduit à GPT-2 en 2019, qui a démontré une génération linguistique impressionnante avec une fenêtre de 1 024 tokens, suivi de GPT-3 en 2020 avec 2 048 tokens, puis de GPT-4 en 2023 avec 128 000 tokens. Chaque progrès était important car il élargissait le champ des possibles : des fenêtres plus grandes permettaient aux modèles de traiter des documents plus longs, de maintenir la cohérence dans des conversations à plusieurs tours et de comprendre des relations nuancées entre des concepts éloignés dans le texte. La croissance exponentielle de la taille des fenêtres de contexte reflète à la fois des innovations architecturales et l’augmentation des ressources de calcul disponibles pour les grands laboratoires d’IA.

Des fenêtres de contexte plus grandes élargissent fondamentalement ce que les modèles d’IA peuvent accomplir, rendant possibles des applications auparavant impossibles ou très limitées. Voici les principaux avantages :

Meilleure continuité de la conversation : les modèles peuvent garder à l’esprit l’ensemble de l’historique de la conversation, réduisant la nécessité de réexpliquer le contexte et permettant des dialogues plus naturels et cohérents, réellement continus plutôt que fragmentés.

Traitement de documents à grande échelle : de plus grandes fenêtres permettent à l’IA d’analyser des documents entiers, des articles de recherche ou des bases de code en une seule passe, identifiant des motifs et relations sur l’ensemble du contenu sans perdre d’informations des sections précédentes.

Raisonnement et analyse améliorés : avec plus de contexte disponible, les modèles peuvent effectuer des tâches de raisonnement plus sophistiquées nécessitant la compréhension des relations entre plusieurs concepts, les rendant plus efficaces pour la recherche, l’analyse et la résolution de problèmes complexes.

Réduction de la surcharge due aux changements de contexte : les utilisateurs n’ont plus besoin de résumer ou de réintroduire manuellement des informations ; le modèle peut se référer à tout l’historique de la conversation, réduisant les frictions et améliorant l’efficacité dans les flux de travail collaboratifs.

Meilleure gestion des tâches nuancées : des applications telles que la relecture de documents juridiques, l’analyse de dossiers médicaux et l’audit de code bénéficient grandement de la capacité à prendre en compte un contexte exhaustif, ce qui conduit à des résultats plus précis et plus complets.

Flux de travail multi-documents sans couture : les professionnels peuvent travailler simultanément sur plusieurs documents liés, permettant au modèle de croiser les informations et d’identifier des liens impossibles à détecter avec de petites fenêtres de contexte.

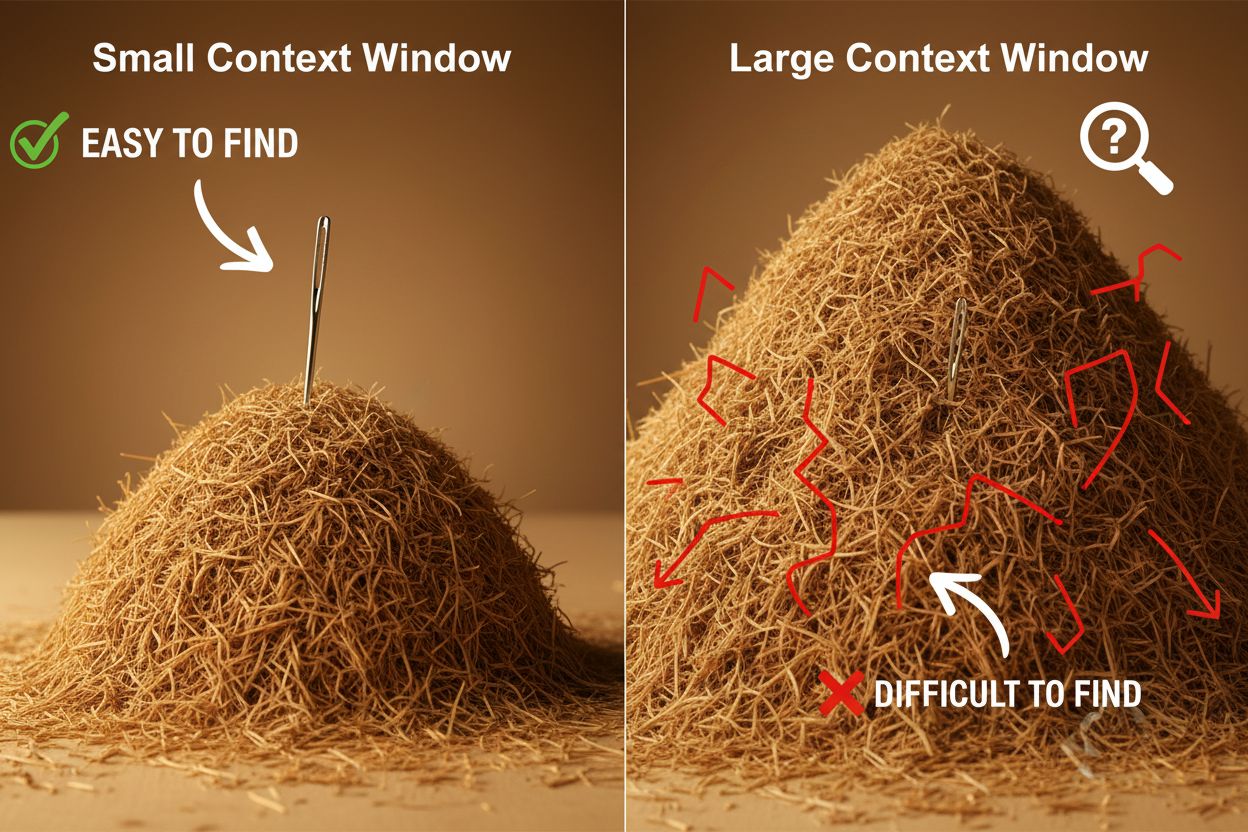

Malgré leurs avantages, les grandes fenêtres de contexte posent des défis techniques et pratiques importants que les développeurs et utilisateurs doivent gérer avec soin. Le défi le plus évident est le coût informatique : le traitement de longues séquences exige exponentiellement plus de mémoire et de puissance de calcul en raison de la mise à l’échelle quadratique du mécanisme d’attention, rendant les grandes fenêtres de contexte nettement plus coûteuses à exécuter. Cette demande accrue en calcul crée aussi des problèmes de latence, car de plus grandes fenêtres de contexte impliquent des temps de réponse plus lents—ce qui est critique pour les applications en temps réel où les utilisateurs attendent des réponses rapides. Un autre problème subtil mais important est le phénomène de “l’aiguille dans la botte de foin”, où les modèles ont du mal à localiser et utiliser les informations pertinentes lorsqu’elles sont noyées dans une très grande fenêtre de contexte, parfois avec de moins bons résultats qu’avec de petites fenêtres. De plus, le pourrissement du contexte intervient lorsque les informations situées au début d’une longue fenêtre de contexte deviennent moins influentes sur la sortie du modèle, car le mécanisme d’attention peut déprioriser les tokens distants au profit des plus récents. Ces défis signifient que simplement maximiser la taille de la fenêtre de contexte n’est pas toujours la meilleure solution pour chaque cas d’usage.

Comprendre le pourrissement du contexte est essentiel pour bien utiliser de grandes fenêtres de contexte : à mesure que les séquences s’allongent, les tokens placés au début du contexte tendent à avoir de moins en moins d’influence sur la sortie du modèle, si bien que des informations cruciales peuvent être effectivement “oubliées” même si elles sont techniquement dans la fenêtre. Cela s’explique par le fait que le budget d’attention—la capacité du modèle à porter une attention significative à tous les tokens—est dilué sur une plus grande portion de texte. Heureusement, plusieurs techniques sophistiquées ont émergé pour pallier ces limitations. La génération augmentée par récupération (RAG) résout ce problème en stockant l’information dans des bases de données externes et en ne récupérant que les éléments les plus pertinents au moment voulu, offrant ainsi au modèle une base de connaissances élargie sans nécessiter une immense fenêtre de contexte. Les techniques de compaction du contexte résument ou compressent les informations moins importantes, préservant les détails essentiels tout en réduisant le nombre de tokens utilisés. Les approches de prise de notes structurée encouragent les utilisateurs à organiser l’information de façon hiérarchique, facilitant la priorisation et la localisation des concepts clés par le modèle. Ces solutions consistent à être stratégique quant à l’information qui entre dans la fenêtre de contexte et à la façon dont elle est organisée, plutôt que d’essayer simplement de tout faire tenir en mémoire à la fois.

L’élargissement des fenêtres de contexte des modèles d’IA modernes a permis de nombreuses applications réelles auparavant impraticables ou impossibles. Les systèmes de support client peuvent désormais examiner tout l’historique d’un ticket et la documentation associée en une seule requête, offrant des réponses plus précises et adaptées au contexte sans que les clients aient à réexpliquer leur situation. L’analyse documentaire et la recherche ont été transformées par des modèles capables d’ingérer des articles scientifiques entiers, des contrats juridiques ou des spécifications techniques, identifiant les informations clés et répondant à des questions détaillées sur un contenu qui prendrait des heures à un humain à parcourir. La relecture de code et le développement logiciel bénéficient de fenêtres de contexte assez larges pour contenir des fichiers entiers, voire plusieurs fichiers liés, permettant à l’IA de comprendre les schémas architecturaux et de fournir des suggestions plus intelligentes. La création de contenu long format et les flux de travail d’écriture itérative gagnent en efficacité lorsque le modèle peut garder à l’esprit le ton, le style et la trame narrative de tout un document lors du processus de révision. L’analyse de transcriptions de réunions et la synthèse de recherche exploitent de grandes fenêtres de contexte pour extraire des insights à partir d’heures de conversations ou de dizaines de documents sources, identifiant des thèmes et des liens difficiles à repérer manuellement. Ces applications démontrent que la taille de la fenêtre de contexte se traduit directement par une valeur pratique pour les professionnels de nombreux secteurs.

La trajectoire de développement des fenêtres de contexte laisse présager une expansion encore plus spectaculaire à court terme, avec Gemini 1.5 Pro démontrant déjà une fenêtre de contexte de 1 000 000 tokens et les laboratoires de recherche explorant des capacités encore plus grandes. Au-delà de la taille brute, l’avenir verra probablement des fenêtres de contexte dynamiques qui ajustent intelligemment leur taille selon la tâche, allouant plus de capacité au besoin et la réduisant pour les requêtes simples afin d’améliorer l’efficacité et de réduire les coûts. Les chercheurs progressent également sur des mécanismes d’attention plus efficaces qui réduisent la pénalité computationnelle liée à de grandes fenêtres, avec la perspective de dépasser la barrière de mise à l’échelle quadratique qui limite actuellement la taille du contexte. À mesure que ces technologies mûrissent, il faut s’attendre à ce que les fenêtres de contexte deviennent moins une contrainte et plus un problème résolu, permettant aux développeurs de se concentrer sur d’autres aspects des capacités et de la fiabilité de l’IA. La convergence de fenêtres plus grandes, d’une meilleure efficacité et d’une gestion plus intelligente du contexte définira probablement la prochaine génération d’applications d’IA, permettant des cas d’usage encore inimaginés.

Une fenêtre de contexte est la quantité totale de texte (mesurée en tokens) qu'un modèle d'IA peut traiter en une fois, tandis que la limite de tokens fait référence au nombre maximal de tokens que le modèle peut gérer. Ces termes sont souvent utilisés de façon interchangeable, mais la fenêtre de contexte désigne spécifiquement la mémoire de travail disponible lors d'une inférence unique, tandis que la limite de tokens peut également faire référence à des contraintes de sortie ou à des limites d'utilisation de l'API.

Des fenêtres de contexte plus larges améliorent généralement la qualité des réponses en permettant au modèle de prendre en compte plus d'informations pertinentes et de mieux maintenir la continuité de la conversation. Cependant, des fenêtres extrêmement grandes peuvent parfois nuire à la qualité en raison du phénomène de 'pourrissement du contexte', où le modèle a du mal à prioriser les informations importantes parmi de grandes quantités de texte. La taille optimale de la fenêtre de contexte dépend de la tâche spécifique et de la façon dont l'information est organisée.

Les grandes fenêtres de contexte nécessitent plus de puissance de calcul en raison de la mise à l'échelle quadratique du mécanisme d'attention dans les modèles de type transformeur. Le mécanisme d'attention doit calculer les relations entre chaque token et tous les autres, de sorte que doubler la fenêtre de contexte quadruple à peu près les besoins en calcul. C'est pourquoi les grandes fenêtres de contexte sont plus coûteuses à exécuter et produisent des temps de réponse plus lents.

Le problème de 'l'aiguille dans la botte de foin' se produit lorsqu'un modèle d'IA a du mal à localiser et à utiliser l'information pertinente (l'aiguille) lorsqu'elle est noyée dans une très grande fenêtre de contexte (la botte de foin). Les modèles donnent parfois de moins bons résultats avec des fenêtres de contexte extrêmement grandes, car le mécanisme d'attention est dilué sur trop d'informations, rendant plus difficile l'identification de ce qui est réellement important.

Pour maximiser l'efficacité de la fenêtre de contexte, organisez les informations de manière claire et hiérarchique, placez les informations les plus importantes au début ou à la fin du contexte, utilisez des formats structurés comme JSON ou markdown, et envisagez l'utilisation de la génération augmentée par récupération (RAG) pour charger dynamiquement uniquement les informations les plus pertinentes. Évitez de submerger le modèle avec des détails non pertinents qui consomment des tokens sans valeur ajoutée.

La fenêtre de contexte est la capacité technique du modèle à traiter un texte en une fois, tandis que l'historique de conversation est l'enregistrement réel des messages précédents dans une conversation. L'historique de conversation doit tenir dans la fenêtre de contexte, mais la fenêtre de contexte comprend aussi l'espace pour les prompts système, instructions et autres métadonnées. Un historique de conversation peut être plus long que la fenêtre de contexte, nécessitant alors un résumé ou une coupure.

Aucun modèle d'IA ne dispose actuellement de fenêtres de contexte véritablement illimitées, car tous les modèles ont des contraintes architecturales et computationnelles. Cependant, certains modèles comme Gemini 1.5 Pro offrent des fenêtres extrêmement grandes (1 000 000 tokens), et des techniques comme la génération augmentée par récupération (RAG) peuvent efficacement étendre la base de connaissances du modèle au-delà de sa fenêtre de contexte en récupérant dynamiquement des informations au besoin.

La taille de la fenêtre de contexte affecte directement le coût des API car de plus grandes fenêtres nécessitent plus de ressources informatiques pour être traitées. La plupart des fournisseurs d'API d'IA facturent en fonction de l'utilisation des tokens, donc une fenêtre de contexte plus grande signifie plus de tokens traités et des coûts plus élevés. Certains fournisseurs appliquent également des tarifs premium pour les modèles dotés de grandes fenêtres de contexte, ce qui rend important le choix de la taille du modèle selon vos besoins.

AmICited suit la façon dont des systèmes d'IA tels que ChatGPT, Perplexity et Google AI Overviews citent et font référence à votre contenu. Comprenez votre visibilité auprès de l'IA et surveillez les mentions de votre marque sur les plateformes d'IA.

La fenêtre de contexte expliquée : le nombre maximal de jetons qu’un LLM peut traiter à la fois. Découvrez comment les fenêtres de contexte influencent la préci...

Découvrez ce que sont les fenêtres de contexte dans les modèles de langage IA, leur fonctionnement, leur impact sur les performances des modèles et pourquoi ell...

Discussion communautaire sur les fenêtres de contexte de l'IA et leurs implications pour le marketing de contenu. Comprendre comment les limites de contexte aff...