Fiche de Référence des Crawlers IA : Tous les Bots en un Coup d’Œil

Guide complet de référence des crawlers IA et bots. Identifiez GPTBot, ClaudeBot, Google-Extended et plus de 20 autres crawlers IA avec leurs user agents, fréqu...

Une approche stratégique permettant aux propriétaires de sites web d’autoriser sélectivement certains crawlers d’IA tout en en bloquant d’autres, en fonction des objectifs commerciaux, des accords de licence de contenu et de l’évaluation de la valeur. Plutôt que d’appliquer des politiques globales, l’accès différentiel évalue chaque crawler individuellement pour déterminer s’il génère du trafic, respecte les conditions de licence ou s’aligne sur les objectifs de monétisation. Les éditeurs utilisent des outils comme robots.txt, les en-têtes HTTP et des contrôles spécifiques aux plateformes pour mettre en œuvre des politiques d’accès granulaires. Cette méthode équilibre les opportunités d’innovation avec la protection du contenu et une rémunération équitable.

Une approche stratégique permettant aux propriétaires de sites web d’autoriser sélectivement certains crawlers d’IA tout en en bloquant d’autres, en fonction des objectifs commerciaux, des accords de licence de contenu et de l’évaluation de la valeur. Plutôt que d’appliquer des politiques globales, l’accès différentiel évalue chaque crawler individuellement pour déterminer s’il génère du trafic, respecte les conditions de licence ou s’aligne sur les objectifs de monétisation. Les éditeurs utilisent des outils comme robots.txt, les en-têtes HTTP et des contrôles spécifiques aux plateformes pour mettre en œuvre des politiques d’accès granulaires. Cette méthode équilibre les opportunités d’innovation avec la protection du contenu et une rémunération équitable.

L’explosion des crawlers IA a fondamentalement bouleversé la relation vieille de plusieurs décennies entre propriétaires de sites web et bots. Pendant des années, Internet fonctionnait sur un échange simple : les moteurs de recherche comme Google indexaient le contenu et redirigeaient le trafic vers les sources originales, créant une relation symbiotique récompensant la création de contenu de qualité. Aujourd’hui, une nouvelle génération de crawlers IA—including GPTBot, ClaudeBot, PerplexityBot, et des dizaines d’autres—fonctionne selon des règles différentes. Ces bots extraient du contenu non pas pour l’indexer mais pour l’alimenter directement dans des modèles d’IA générant des réponses sans renvoyer l’utilisateur à la source originale. L’impact est frappant : selon les données de Cloudflare, GPTBot d’OpenAI affiche un ratio crawl/renvoi d’environ 1 700:1, tandis que ClaudeBot d’Anthropic atteint 73 000:1, ce qui signifie que pour chaque visiteur redirigé vers le site d’un éditeur, des milliers de pages sont crawlées à des fins d’entraînement. Cet échange rompu pousse les éditeurs à repenser leurs politiques d’accès aux crawlers, abandonnant le choix binaire « tout autoriser » ou « tout bloquer » au profit d’une stratégie plus nuancée : l’accès différentiel aux crawlers. Plutôt que d’appliquer des politiques globales, les éditeurs avisés évaluent désormais chaque crawler individuellement, en posant des questions cruciales sur la valeur, la licence et l’alignement avec les objectifs commerciaux.

Comprendre les différents types de crawlers IA est essentiel pour mettre en place une stratégie d’accès différentiel efficace, chacun remplissant des fonctions distinctes avec des impacts variés sur votre activité. Les crawlers IA se divisent en trois grandes catégories : les crawlers d’entraînement (GPTBot, ClaudeBot, anthropic-ai, CCBot, Bytespider) qui collectent du contenu pour l’entraînement des modèles ; les crawlers de recherche (OAI-SearchBot, PerplexityBot, Google-Extended) qui indexent le contenu pour les résultats de recherche IA ; et les agents activés par l’utilisateur (ChatGPT-User, Claude-Web, Perplexity-User) qui n’extraient du contenu que sur demande explicite d’un utilisateur. La proposition de valeur diffère fortement selon les catégories. Les crawlers d’entraînement génèrent généralement très peu de trafic retour vers votre site—ils extraient de la valeur sans bénéfice réciproque—et sont donc de bons candidats au blocage. Les crawlers de recherche, à l’inverse, peuvent générer un trafic de recommandation significatif et des conversions d’abonnés, à l’image des moteurs de recherche classiques. Les agents activés par l’utilisateur occupent une position intermédiaire, n’étant sollicités que lors d’une interaction active avec le système IA. The Atlantic, l’un des plus grands éditeurs numériques, a mis en place une grille d’évaluation sophistiquée suivant à la fois le volume de trafic et les conversions d’abonnés pour chaque bot. Leur analyse a révélé que si certains crawlers apportent une réelle valeur ajoutée, d’autres ne génèrent pratiquement aucun trafic tout en consommant une bande passante considérable. Cette approche basée sur les données permet aux éditeurs de prendre des décisions éclairées plutôt que de se fier à des suppositions.

| Type de crawler | Exemples | Objectif principal | Valeur de trafic typique | Accès recommandé |

|---|---|---|---|---|

| Entraînement | GPTBot, ClaudeBot, anthropic-ai, CCBot, Bytespider | Jeux de données d’entraînement de modèles | Très faible (ratio 1 700:1 à 73 000:1) | Souvent bloqués |

| Recherche | OAI-SearchBot, PerplexityBot, Google-Extended | Indexation IA pour la recherche | Moyenne à élevée | Souvent autorisés |

| Activé par l’utilisateur | ChatGPT-User, Claude-Web, Perplexity-User | Requêtes directes des utilisateurs | Variable | Au cas par cas |

La mise en œuvre de l’accès différentiel aux crawlers nécessite une combinaison d’outils techniques et de décisions stratégiques, avec plusieurs méthodes disponibles selon vos capacités techniques et vos besoins commerciaux. L’outil fondamental est le robots.txt, un simple fichier texte à la racine de votre site qui communique vos préférences d’accès via des directives User-agent. Bien que robots.txt soit volontaire et que seulement 40 à 60 % des bots IA le respectent, il reste la première ligne de défense et ne coûte rien à mettre en place. Pour les éditeurs souhaitant un contrôle renforcé, robots.txt géré par Cloudflare crée et met à jour automatiquement les directives crawler, les ajoutant à votre fichier existant sans maintenance manuelle. Au-delà de robots.txt, plusieurs mécanismes d’application offrent un contrôle supplémentaire :

L’approche la plus efficace combine plusieurs couches : robots.txt pour les crawlers conformes, règles WAF pour l’application, et outils de surveillance pour suivre l’efficacité et détecter de nouvelles menaces.

Mettre en œuvre l’accès différentiel aux crawlers implique de dépasser l’approche technique pour élaborer une stratégie commerciale cohérente, alignée sur votre modèle de revenus et votre positionnement concurrentiel. L’approche de The Atlantic fournit un cadre pratique : ils évaluent chaque crawler selon deux métriques principales—volume de trafic et conversions d’abonnés—en se demandant si le crawler génère une valeur suffisante pour justifier l’accès au contenu. Pour un éditeur dont la valeur annuelle d’abonné est de 80 $, un crawler générant 1 000 abonnés représente 80 000 $ par an, ce qui change radicalement la décision d’accès. Cependant, le trafic et les conversions ne sont qu’une partie de l’équation. Les éditeurs doivent aussi considérer :

Les éditeurs les plus stratégiques mettent en œuvre des politiques d’accès par niveaux : autoriser les crawlers de recherche générant du trafic, bloquer ceux d’entraînement sans valeur et négocier des accords de licence avec les acteurs IA à forte valeur ajoutée. Cette approche maximise la visibilité et les revenus tout en protégeant la propriété intellectuelle.

Bien que l’accès différentiel aux crawlers offre de nombreux avantages, la réalité est plus complexe que la théorie, avec plusieurs défis fondamentaux limitant son efficacité et nécessitant une gestion continue. La principale limite est que robots.txt est volontaire—les crawlers qui le respectent le font par choix, non par obligation. Les recherches indiquent que robots.txt ne bloque que 40 à 60 % des bots IA, 30 à 40 % supplémentaires étant stoppés par le blocage d’User-agent, laissant 10 à 30 % de crawlers opérer sans restriction. Certaines entreprises IA et acteurs malveillants ignorent délibérément les directives robots.txt, considérant que l’accès au contenu prime sur la conformité. De plus, les techniques d’évasion des crawlers évoluent : des bots sophistiqués usurpent les User-agents pour se faire passer pour des navigateurs légitimes, utilisent des IP distribuées pour éviter la détection et recourent à des navigateurs headless mimant le comportement humain. Le dilemme Google-Extended illustre la complexité : bloquer Google-Extended empêche l’entraînement de Gemini AI sur votre contenu, mais Google AI Overviews (présenté dans les résultats de recherche) utilise les règles standard Googlebot, ce qui rend impossible de refuser les AI Overviews sans sacrifier la visibilité dans la recherche. La surveillance et l’application nécessitent aussi des ressources importantes—suivre les nouveaux crawlers, adapter les politiques et en valider l’efficacité demande une attention constante. Enfin, le cadre juridique reste incertain : bien que le droit d’auteur protège en principe le contenu, faire respecter ses droits face aux entreprises IA est coûteux et les résultats sont imprévisibles, laissant les éditeurs avec un contrôle technique sans réelle garantie juridique.

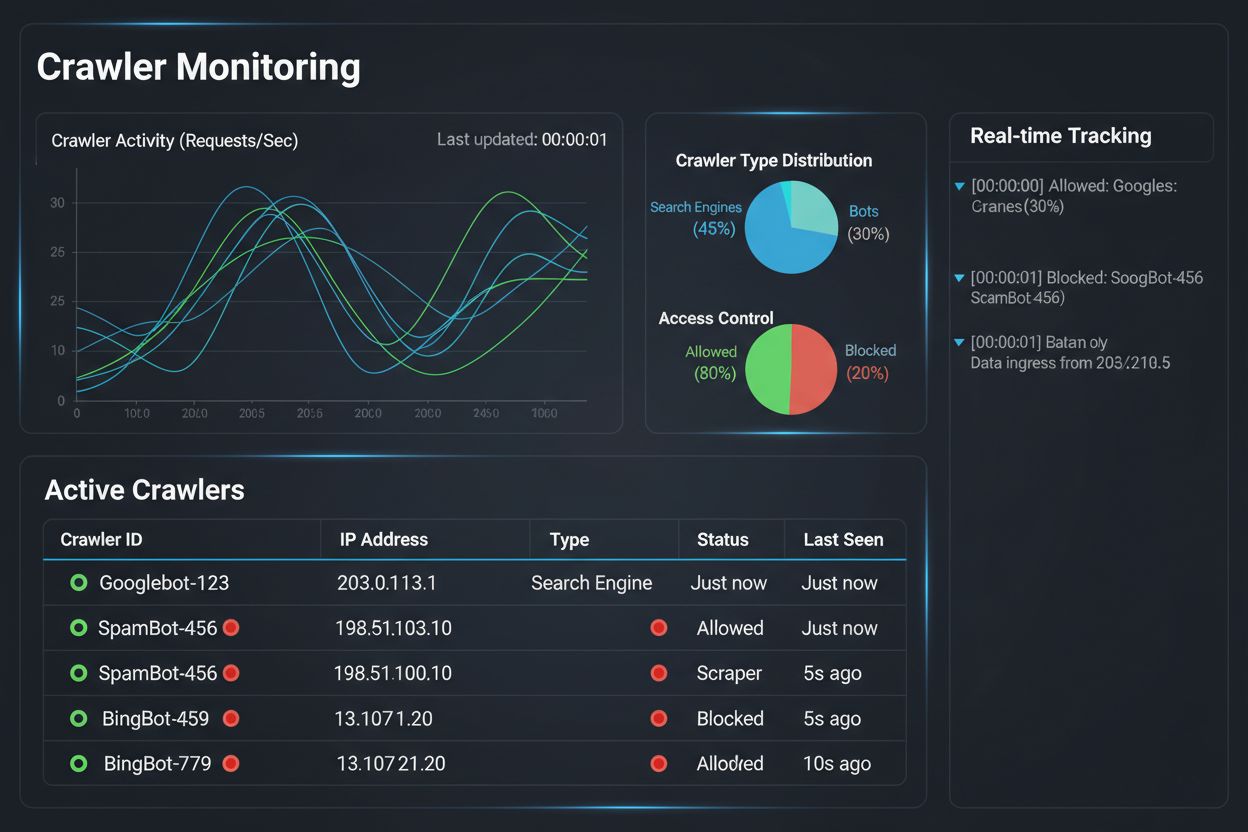

Mettre en place une stratégie d’accès différentiel aux crawlers n’est qu’une partie du travail ; l’autre consiste à comprendre l’impact réel de vos politiques grâce à une surveillance et une mesure approfondies. C’est là qu’AmICited.com devient essentiel dans votre gestion des crawlers. AmICited est spécialisé dans la surveillance de la façon dont les systèmes IA mentionnent et citent votre marque à travers GPTs, Perplexity, Google AI Overviews et d’autres plateformes IA—vous offrant une visibilité sur les crawlers utilisant réellement votre contenu et la manière dont il apparaît dans les réponses générées par l’IA. Plutôt que de se fier aux journaux serveurs et aux suppositions, le tableau de bord AmICited affiche précisément quels systèmes IA ont accédé à votre contenu, à quelle fréquence et surtout, si votre contenu est cité ou simplement absorbé dans les jeux d’entraînement sans attribution. Cette intelligence éclaire directement vos décisions d’accès différentiel : si un crawler accède à votre contenu sans jamais le citer dans les réponses IA, le blocage devient une décision commerciale évidente. AmICited permet aussi un benchmark concurrentiel, montrant la visibilité de votre contenu dans les systèmes IA par rapport à vos concurrents, pour savoir si vos politiques d’accès sont trop restrictives ou permissives. Les alertes en temps réel de la plateforme vous avertissent lorsqu’un nouveau système IA commence à référencer votre contenu, vous permettant d’ajuster rapidement vos politiques. En combinant la surveillance AmICited aux outils d’application Cloudflare, les éditeurs bénéficient d’une visibilité et d’un contrôle complets : ils voient quels crawlers accèdent à leur contenu, mesurent l’impact commercial et ajustent les politiques en conséquence. Cette approche basée sur la donnée transforme la gestion des crawlers d’un simple contrôle technique en une fonction commerciale stratégique.

Le paysage de l’accès différentiel aux crawlers évolue rapidement, de nouveaux standards et modèles d’affaires redéfinissant la relation entre éditeurs et sociétés IA autour du contenu. La proposition AI preferences de l’IETF représente une avancée notable, établissant des moyens standardisés pour les sites web de communiquer leurs préférences concernant l’entraînement, l’inférence et l’utilisation en recherche par l’IA. Plutôt que de dépendre de robots.txt—une norme vieille de 30 ans conçue pour les moteurs de recherche—ce nouveau cadre offre un contrôle explicite et granulaire sur l’utilisation du contenu par les systèmes IA. Parallèlement, les modèles business basés sur la permission gagnent du terrain, l’initiative Pay Per Crawl de Cloudflare ouvrant la voie à un modèle où les sociétés IA rémunèrent les éditeurs pour l’accès au contenu, transformant les crawlers de menaces en sources de revenus. Ce passage du blocage à la licence représente un changement fondamental de l’économie d’Internet : au lieu de lutter pour l’accès, éditeurs et sociétés IA négocient une rémunération équitable. Les standards d’authentification et de vérification des crawlers progressent aussi, des méthodes de vérification cryptographique permettant de confirmer l’identité d’un crawler et d’éviter l’usurpation. À l’avenir, on peut s’attendre à un renforcement des cadres réglementaires autour des données d’entraînement IA, imposant potentiellement le consentement explicite et la rémunération pour l’utilisation du contenu. La convergence de ces tendances—standards techniques, modèles de licence, mécanismes d’authentification et pression réglementaire—laisse entrevoir que l’accès différentiel aux crawlers évoluera d’une stratégie défensive vers une fonction commerciale sophistiquée, où les éditeurs gèrent, surveillent et monétisent activement l’accès des crawlers IA. Les éditeurs mettant en place dès aujourd’hui des politiques stratégiques et une surveillance exhaustive seront les mieux placés pour tirer parti de ces opportunités émergentes.

Bloquer tous les crawlers retire entièrement votre contenu des systèmes d’IA, éliminant à la fois les risques et les opportunités. L’accès différentiel vous permet d’évaluer chaque crawler individuellement, en bloquant ceux qui n’apportent pas de valeur tout en autorisant ceux qui génèrent du trafic ou offrent des opportunités de licence. Cette approche nuancée maximise à la fois la visibilité et les revenus tout en protégeant la propriété intellectuelle.

Vous pouvez surveiller l’activité des crawlers via les journaux du serveur, le tableau de bord analytique de Cloudflare ou des outils de surveillance spécialisés comme AmICited.com. AmICited suit spécifiquement quels systèmes d’IA accèdent à votre contenu et comment votre marque apparaît dans les réponses générées par l’IA, offrant des informations commerciales au-delà des journaux techniques.

Non. Bloquer les crawlers d’entraînement IA comme GPTBot, ClaudeBot et CCBot n’affecte pas vos classements sur Google ou Bing. Les moteurs de recherche traditionnels utilisent d’autres crawlers (Googlebot, Bingbot) qui fonctionnent indépendamment. Ne les bloquez que si vous souhaitez disparaître complètement des résultats de recherche.

Oui, c’est l’approche la plus stratégique pour de nombreux éditeurs. Vous pouvez autoriser les crawlers axés sur la recherche comme OAI-SearchBot et PerplexityBot (qui génèrent du trafic) tout en bloquant les crawlers d’entraînement comme GPTBot et ClaudeBot (qui généralement n’en génèrent pas). Cela maintient la visibilité dans les résultats de recherche IA tout en protégeant le contenu de l’entraînement des modèles.

Alors que les principaux crawlers d’OpenAI, Anthropic et Google respectent robots.txt, certains bots l’ignorent délibérément. Si un crawler ne respecte pas votre robots.txt, vous aurez besoin de méthodes d’application supplémentaires comme des règles WAF, le blocage d’IP ou les fonctionnalités de gestion des bots de Cloudflare. C’est pourquoi des outils de surveillance comme AmICited sont essentiels : ils montrent quels crawlers respectent réellement vos politiques.

Examinez vos politiques au moins une fois par trimestre, car les entreprises d’IA introduisent régulièrement de nouveaux crawlers. Anthropic a fusionné ses bots ‘anthropic-ai’ et ‘Claude-Web’ en ‘ClaudeBot’, donnant au nouveau bot un accès temporairement illimité aux sites n’ayant pas mis à jour leurs règles. Une surveillance régulière avec des outils comme AmICited vous permet d’anticiper les changements.

Googlebot est le crawler de recherche de Google qui indexe le contenu pour les résultats de recherche. Google-Extended est un jeton de contrôle qui détermine spécifiquement si votre contenu est utilisé pour l’entraînement de Gemini AI. Vous pouvez bloquer Google-Extended sans affecter le référencement, mais notez que Google AI Overviews (qui apparaissent dans les résultats de recherche) utilisent les règles standard de Googlebot, donc il n’est pas possible de se désinscrire des AI Overviews sans sacrifier la visibilité dans la recherche.

Oui, de nouveaux modèles de licence comme Pay Per Crawl de Cloudflare permettent aux éditeurs de facturer les entreprises d’IA pour l’accès au contenu. Cela transforme les crawlers en sources de revenus. Cependant, cela nécessite des négociations avec les entreprises d’IA et peut impliquer des accords juridiques. La surveillance par AmICited vous aide à identifier quels crawlers représentent les opportunités de licence les plus rentables.

Suivez quels systèmes d’IA accèdent à votre contenu et comment votre marque apparaît dans les réponses générées par l’IA. Obtenez des informations en temps réel sur le comportement des crawlers et mesurez l’impact commercial de vos politiques d’accès différentiel.

Guide complet de référence des crawlers IA et bots. Identifiez GPTBot, ClaudeBot, Google-Extended et plus de 20 autres crawlers IA avec leurs user agents, fréqu...

Découvrez comment utiliser robots.txt pour contrôler quels bots d'IA accèdent à votre contenu. Guide complet pour bloquer GPTBot, ClaudeBot et d'autres crawlers...

Découvrez comment prendre des décisions stratégiques concernant le blocage des crawlers IA. Évaluez le type de contenu, les sources de trafic, les modèles de re...