Définition de l’IA générative

L’IA générative est une catégorie d’intelligence artificielle qui crée de nouveaux contenus originaux à partir de motifs appris sur des données d’entraînement. Contrairement aux systèmes d’IA traditionnels qui classent ou prédisent des informations, les modèles d’IA générative produisent de manière autonome des résultats inédits tels que du texte, des images, des vidéos, de l’audio, du code et d’autres types de données en réponse à des consignes ou des requêtes utilisateur. Ces systèmes exploitent des modèles d’apprentissage profond sophistiqués et des réseaux neuronaux pour identifier des motifs et des relations complexes au sein d’immenses ensembles de données, puis utilisent ces connaissances pour générer des contenus qui ressemblent aux données d’entraînement sans les reproduire exactement. Le terme « génératif » souligne la capacité du modèle à générer — à créer du neuf plutôt qu’à simplement analyser ou catégoriser l’existant. Depuis la mise à disposition publique de ChatGPT en novembre 2022, l’IA générative est devenue l’une des technologies les plus transformatrices de l’informatique, révolutionnant la création de contenu, la résolution de problèmes et la prise de décision dans pratiquement tous les secteurs.

Contexte historique et évolution de l’IA générative

Les fondations de l’IA générative remontent à plusieurs décennies, bien que la technologie ait considérablement évolué ces dernières années. Les premiers modèles statistiques du XXe siècle ont posé les bases de la compréhension des distributions de données, mais la véritable IA générative a émergé avec les progrès de l’apprentissage profond et des réseaux neuronaux dans les années 2010. L’introduction des auto-encodeurs variationnels (VAE) en 2013 a constitué une avancée majeure, permettant de générer des variations réalistes de données comme des images ou de la voix. En 2014, les réseaux antagonistes génératifs (GAN) et les modèles de diffusion sont apparus, améliorant encore la qualité et le réalisme des contenus générés. Le tournant a eu lieu en 2017 avec la publication de « Attention is All You Need », qui introduit l’architecture transformeur — une percée qui a fondamentalement changé la façon dont les modèles d’IA générative traitent et génèrent des données séquentielles. Cette innovation a permis le développement des grands modèles de langage (LLM) comme la série GPT d’OpenAI, qui ont démontré des capacités inédites de compréhension et de génération du langage humain. Selon une étude de McKinsey, un tiers des organisations utilisaient déjà l’IA générative régulièrement dans au moins une fonction métier en 2023, et Gartner prévoit que plus de 80 % des entreprises auront déployé des applications d’IA générative ou utilisé des API d’IA générative d’ici 2026. Cette accélération fulgurante du stade de la recherche à la nécessité en entreprise représente l’un des cycles d’adoption technologique les plus rapides de l’histoire.

Ready to Monitor Your AI Visibility?

Track how AI chatbots mention your brand across ChatGPT, Perplexity, and other platforms.

Fonctionnement de l’IA générative : architecture technique

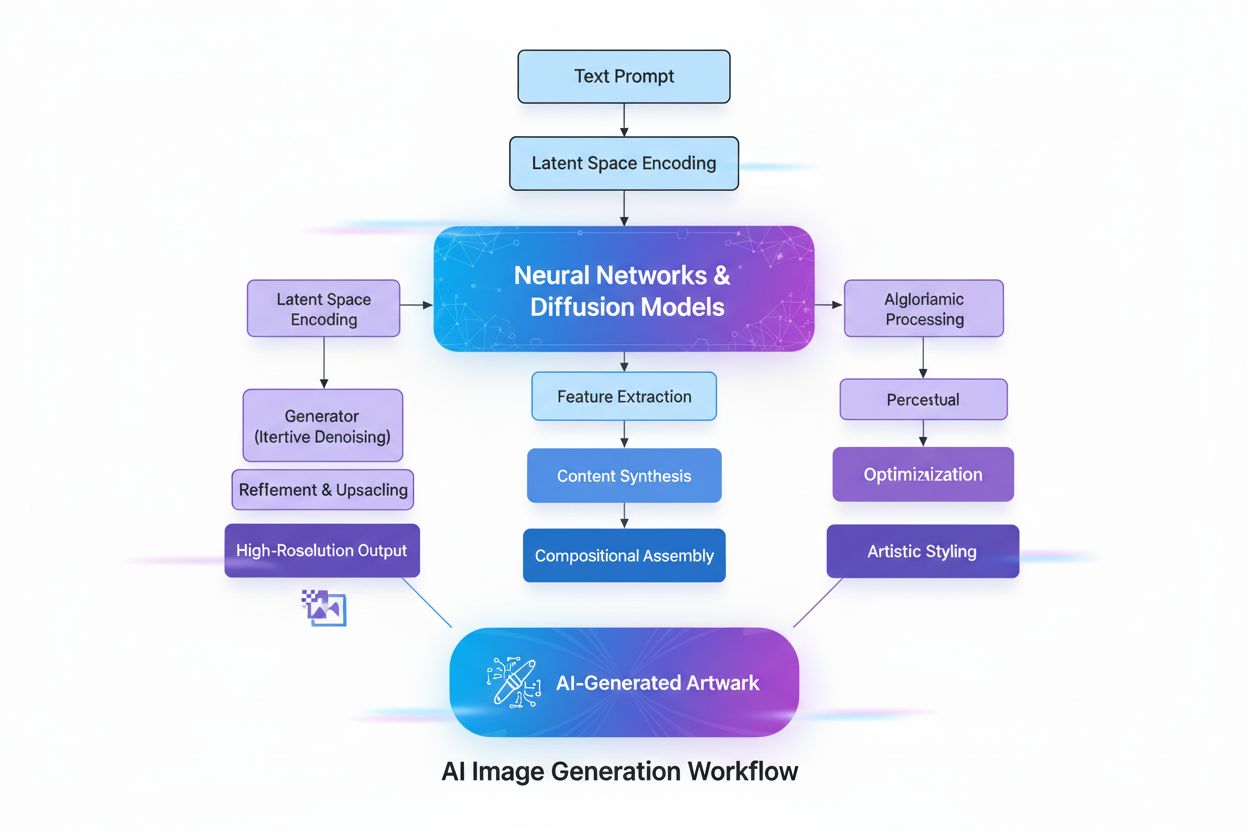

L’IA générative fonctionne selon un processus en plusieurs phases, débutant par l’entraînement sur d’immenses ensembles de données, suivi d’une personnalisation pour des applications spécifiques, puis de cycles continus de génération, d’évaluation et de réajustement. Lors de la phase d’entraînement, les praticiens alimentent les algorithmes d’apprentissage profond avec des téraoctets de données brutes et non structurées — textes, images ou dépôts de code — et l’algorithme effectue des millions d’exercices de « remplissage de blanc », prédisant le prochain élément d’une séquence et s’ajustant pour minimiser les erreurs. Ce processus crée un réseau neuronal de paramètres qui encode les motifs, entités et relations découverts dans les données d’entraînement. Le résultat est un modèle fondamental — un grand modèle pré-entraîné capable de réaliser de multiples tâches dans différents domaines. Des modèles fondamentaux comme GPT-3, GPT-4 et Stable Diffusion servent de base à de nombreuses applications spécialisées. La phase de personnalisation consiste à affiner le modèle fondamental avec des données étiquetées spécifiques à une tâche, ou à utiliser l’apprentissage par renforcement avec retour humain (RLHF), où des évaluateurs humains notent différentes sorties pour guider le modèle vers plus de précision et de pertinence. Développeurs et utilisateurs évaluent en continu les sorties et affinent les modèles — parfois chaque semaine — pour améliorer les performances. Une autre technique d’optimisation, le Retrieval Augmented Generation (RAG), étend le modèle fondamental pour accéder à des sources externes pertinentes, garantissant un accès continu à l’information la plus actuelle tout en assurant la transparence sur les sources utilisées.

Comparaison des architectures de modèles d’IA générative

| Type de modèle | Approche d’entraînement | Vitesse de génération | Qualité de sortie | Diversité | Meilleurs cas d’usage |

|---|

| Modèles de diffusion | Suppression itérative du bruit depuis des données aléatoires | Lent (plusieurs itérations) | Très élevée (photoréaliste) | Élevée | Génération d’images, synthèse haute fidélité |

| Réseaux antagonistes génératifs (GAN) | Compétition générateur vs discriminateur | Rapide | Élevée | Plus faible | Génération spécifique à un domaine, transfert de style |

| Auto-encodeurs variationnels (VAE) | Encodeur-décodeur avec espace latent | Modérée | Modérée | Modérée | Compression de données, détection d’anomalies |

| Modèles transformeurs | Auto-attention sur données séquentielles | Modérée à rapide | Très élevée (texte/code) | Très élevée | Génération de langage, synthèse de code, LLM |

| Approches hybrides | Combinaison de plusieurs architectures | Variable | Très élevée | Très élevée | Génération multimodale, tâches complexes |

Stay Updated on AI Visibility Trends

Get the latest insights on AI mentions, brand monitoring, and optimization strategies.

Technologies clés permettant l’IA générative

L’architecture transformeur est la technologie la plus influente à la base de l’IA générative moderne. Les transformeurs utilisent des mécanismes d’auto-attention pour déterminer quelles parties des données d’entrée sont les plus importantes lors du traitement de chaque élément, ce qui leur permet de capter des dépendances à longue portée et le contexte. L’encodage positionnel représente l’ordre des éléments en entrée, permettant aux transformeurs de comprendre la structure séquentielle sans traitement séquentiel. Cette capacité de traitement parallèle accélère considérablement l’entraînement par rapport aux anciens réseaux neuronaux récurrents (RNN). La structure encodeur-décodeur du transformeur, combinée à plusieurs couches de têtes d’attention, permet au modèle de considérer simultanément différents aspects des données et de raffiner les embeddings contextuels à chaque couche. Ces embeddings capturent aussi bien la grammaire et la syntaxe que des significations complexes. Les grands modèles de langage (LLM) comme ChatGPT, Claude et Gemini sont construits sur des architectures de transformeurs et comptent des milliards de paramètres — représentations encodées des motifs appris. L’échelle de ces modèles, combinée à un entraînement sur des données à l’échelle d’Internet, leur permet de réaliser des tâches variées, de la traduction à la génération créative en passant par la programmation. Les modèles de diffusion, autre architecture clé, fonctionnent en ajoutant du bruit aux données d’entraînement jusqu’à ce qu’elles deviennent aléatoires, puis en entraînant l’algorithme à supprimer ce bruit de façon itérative afin de révéler la sortie désirée. Bien que les modèles de diffusion nécessitent plus de temps d’entraînement que les VAE ou les GAN, ils offrent un contrôle supérieur sur la qualité de sortie, notamment pour les outils de génération d’images haute fidélité comme DALL-E et Stable Diffusion.

Impact business et adoption en entreprise de l’IA générative

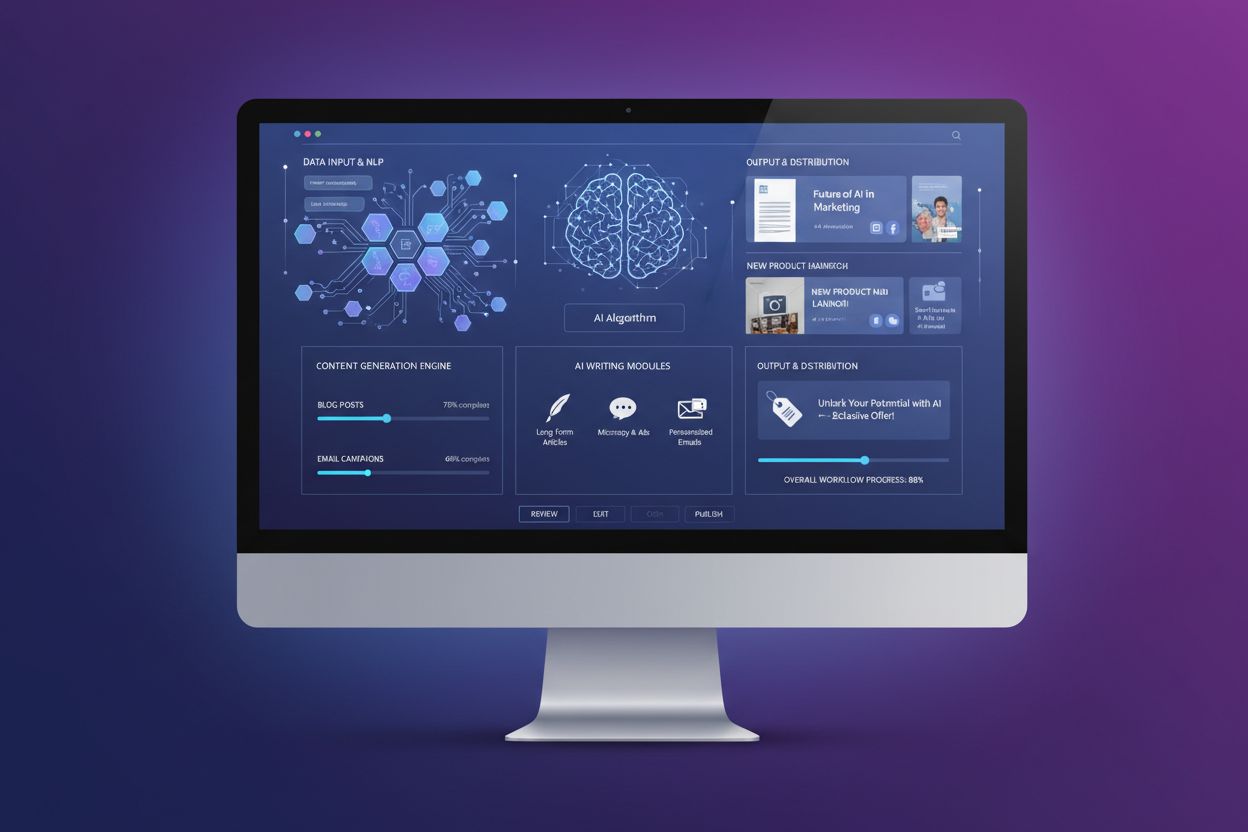

L’IA générative présente un argument commercial convaincant : les entreprises constatent des gains de productivité et des économies mesurables. Selon le rapport entreprise IA 2025 d’OpenAI, les utilisateurs déclarent gagner 40 à 60 minutes par jour grâce aux applications d’IA générative, ce qui se traduit par une nette amélioration de la productivité dans les organisations. Le marché de l’IA générative était évalué à 16,87 milliards de dollars US en 2024 et devrait atteindre 109,37 milliards de dollars US d’ici 2030, avec un TCAC de 37,6 % — l’un des taux de croissance les plus rapides de l’histoire des logiciels d’entreprise. Les dépenses des entreprises en IA générative ont atteint 37 milliards de dollars en 2025, contre 11,5 milliards en 2024, soit une multiplication par 3,2 sur un an. Cette accélération reflète une confiance croissante dans le retour sur investissement, les acheteurs d’IA convertissant à 47 % contre 25 % pour le SaaS traditionnel, ce qui indique que l’IA générative apporte une valeur immédiate suffisante pour justifier son adoption rapide. Les organisations déploient l’IA générative dans de nombreuses fonctions : les équipes support client utilisent des chatbots IA pour des réponses personnalisées et une résolution dès le premier contact ; le marketing s’appuie sur la génération de contenu pour les blogs, emails et réseaux sociaux ; les équipes de développement de logiciels s’aident d’outils de génération de code pour accélérer les cycles de développement ; et les équipes de recherche exploitent les modèles génératifs pour analyser des jeux de données complexes et proposer des solutions inédites. Les entreprises de services financiers utilisent l’IA générative pour la détection de fraude et le conseil financier personnalisé, tandis que le secteur de la santé l’applique à la découverte de médicaments et à l’analyse d’images médicales. La polyvalence de la technologie dans tous les secteurs témoigne de son potentiel transformateur pour les opérations des entreprises.

Applications de l’IA générative dans les secteurs et domaines

Les applications de l’IA générative couvrent pratiquement tous les secteurs et fonctions. En génération de texte, les modèles produisent des contenus cohérents et contextuellement pertinents, notamment de la documentation, des textes marketing, des articles de blog, des papiers de recherche et des œuvres créatives. Ils excellent dans l’automatisation de tâches rédactionnelles fastidieuses comme la synthèse de documents ou la génération de métadonnées, libérant ainsi les auteurs pour des travaux plus créatifs. Les outils de génération d’images comme DALL-E, Midjourney et Stable Diffusion créent des images photoréalistes, des œuvres originales, et réalisent du transfert de style ou de la retouche d’image. Les capacités de génération de vidéo permettent de créer des animations à partir de consignes textuelles et d’appliquer des effets spéciaux plus rapidement qu’avec les méthodes traditionnelles. La génération audio et musicale synthétise une voix naturelle pour des chatbots ou assistants numériques, crée des narrations d’audiobooks et génère de la musique originale imitant des compositions professionnelles. La génération de code permet aux développeurs d’écrire du code original, d’autocompléter des extraits, de traduire entre langages et de déboguer des applications. En santé, l’IA générative accélère la découverte de médicaments en générant de nouvelles séquences protéiques ou structures moléculaires. La génération de données synthétiques crée des jeux de données étiquetés pour l’apprentissage machine, précieux lorsque les données réelles sont limitées, indisponibles ou insuffisantes pour certains cas particuliers. Dans l’automobile, l’IA générative conçoit des simulations 3D pour le développement de véhicules et génère des données synthétiques pour l’entraînement des véhicules autonomes. Les entreprises des médias et du divertissement s’en servent pour créer des animations, des scripts, des environnements de jeu ou des recommandations personnalisées. Les entreprises de l’énergie appliquent les modèles génératifs à la gestion de réseaux, à l’optimisation de la sécurité opérationnelle et à la prévision de la production. L’étendue des applications montre que l’IA générative est une technologie fondamentale qui reconfigure la création, l’analyse et l’innovation organisationnelle.

Capacités clés et avantages de l’IA générative

- Création de contenu à grande échelle : Générer des contenus variés et de haute qualité (texte, image, vidéo, audio), réduire le temps et les coûts de production tout en permettant la personnalisation

- Recherche et innovation accélérées : Analyser des ensembles de données complexes, identifier des motifs cachés et proposer des solutions inédites, accélérant la découverte en pharmacie, science des matériaux, etc.

- Productivité accrue : Automatiser les tâches répétitives, suggérer du code, créer de la documentation, soutenir les flux de travail des employés, recentrant les équipes sur des missions à plus forte valeur

- Amélioration de la prise de décision : Extraire des insights pertinents de grands volumes de données, générer des hypothèses et recommandations, soutenir la prise de décision data-driven pour dirigeants et analystes

- Personnalisation dynamique : Analyser préférences et historique utilisateur pour générer des contenus, recommandations et expériences personnalisés en temps réel, augmentant l’engagement et la satisfaction client

- Disponibilité 24/7 : Fonctionner en continu, sans fatigue, pour un support client, des chatbots ou des réponses automatisées disponibles à toute heure

- Réduction des coûts : Diminuer les coûts de main-d’œuvre pour la création de contenu, le service client et les processus courants tout en améliorant l’efficacité et la qualité

- Différenciation concurrentielle : Permettre aux organisations d’innover plus vite, de lancer plus rapidement de nouveaux produits et de créer des expériences clients uniques difficiles à reproduire

Défis, limites et gestion des risques de l’IA générative

Malgré ses capacités remarquables, l’IA générative présente des défis majeurs que les organisations doivent relever. Les hallucinations de l’IA — résultats plausibles mais incorrects — surviennent car les modèles génératifs prédisent la suite la plus probable plutôt que de vérifier la véracité. Un avocat a par exemple utilisé ChatGPT pour des recherches juridiques et obtenu de fausses citations de cas, avec fausses références et extraits. Les biais et questions d’équité proviennent des biais sociétaux présents dans les données d’entraînement, ce qui peut conduire à des contenus injustes ou offensants. Les résultats incohérents découlent de la nature probabiliste des modèles génératifs, où des entrées identiques peuvent générer des réponses différentes — un problème pour les chatbots devant assurer une constance. Le manque d’explicabilité rend difficile la compréhension des choix du modèle ; même les ingénieurs peinent à expliquer les décisions de ces « boîtes noires ». Les risques de sécurité et de confidentialité apparaissent si des données propriétaires servent à l’entraînement ou si les modèles révèlent des informations confidentielles ou enfreignent la propriété intellectuelle d’autrui. Les deepfakes — images, vidéos ou sons générés ou manipulés par l’IA pour tromper — sont particulièrement préoccupants, notamment avec leur utilisation par des cybercriminels pour des arnaques vocales ou des fraudes financières. Les coûts informatiques restent élevés : entraîner un grand modèle fondamental requiert des milliers de GPU et des semaines de calcul pour des budgets de plusieurs millions de dollars. Les organisations atténuent ces risques au moyen de garde-fous limitant le modèle à des sources fiables, d’une évaluation et personnalisation continues pour réduire les hallucinations, de données d’entraînement diversifiées pour limiter les biais, d’ingénierie de prompt pour assurer la constance, et de protocoles de sécurité pour protéger les informations sensibles. La transparence sur l’usage de l’IA et la supervision humaine des décisions critiques restent des bonnes pratiques essentielles.

Suivi de la visibilité IA générative et présence de marque

À mesure que les systèmes d’IA générative deviennent une source d’information majeure pour des millions d’utilisateurs, les organisations doivent comprendre comment leurs marques, produits et contenus apparaissent dans les réponses générées par l’IA. Le suivi de la visibilité IA consiste à surveiller systématiquement la façon dont les principales plateformes d’IA générative — dont ChatGPT, Perplexity, Google AI Overviews et Claude — décrivent les marques, produits et concurrents. Ce suivi est crucial, car les systèmes d’IA citent souvent des sources et référencent de l’information sans les métriques de visibilité des moteurs de recherche classiques. Les marques absentes des réponses IA manquent des opportunités de visibilité et d’influence dans le paysage de la recherche pilotée par l’IA. Des outils comme AmICited permettent aux organisations de suivre les mentions de marque, surveiller l’exactitude des citations, identifier quels domaines et URL sont référencés dans les réponses IA, et comprendre comment leur positionnement concurrentiel est représenté. Ces données aident à optimiser le contenu pour la citation IA, à identifier la désinformation ou les représentations erronées, et à maintenir la visibilité concurrentielle alors que l’IA devient l’interface principale entre utilisateurs et information. La pratique du GEO (Generative Engine Optimization) vise à optimiser spécifiquement le contenu pour la citation et la visibilité IA, en complément du SEO traditionnel. Les organisations qui surveillent et optimisent proactivement leur visibilité IA prennent un avantage concurrentiel dans l’écosystème informationnel émergent de l’IA.

Tendances futures et perspectives stratégiques pour l’IA générative

Le paysage de l’IA générative évolue rapidement, avec plusieurs tendances structurantes. Les systèmes multimodaux intégrant texte, image, vidéo et audio deviennent de plus en plus sophistiqués, rendant possible une génération de contenu plus complexe et nuancée. L’IA agentique — systèmes autonomes capables d’accomplir des tâches et d’atteindre des objectifs sans intervention humaine — représente l’étape suivante, avec des agents IA utilisant le contenu généré pour interagir avec des outils et prendre des décisions. Des modèles plus petits et plus efficients apparaissent comme alternatives aux modèles fondamentaux massifs, permettant aux organisations de déployer l’IA générative à moindre coût et avec des vitesses d’inférence plus rapides. Le Retrieval Augmented Generation (RAG) progresse, autorisant les modèles à accéder à l’information actuelle et à des sources de connaissance externes, ce qui limite les hallucinations et améliore la précision. Des cadres réglementaires se développent dans le monde, les gouvernements instaurant des directives pour un développement et un déploiement responsables de l’IA. La personnalisation d’entreprise via l’affinage et les modèles spécifiques aux domaines s’accélère, les organisations cherchant à adapter l’IA générative à leur contexte métier. Les pratiques éthiques deviennent un facteur différenciant, les entreprises privilégiant la transparence, l’équité et un déploiement responsable. La convergence de ces tendances suggère que l’IA générative sera de plus en plus intégrée aux opérations, plus efficiente et accessible à tous types d’organisations, et soumise à une gouvernance et une éthique renforcées. Les organisations qui investissent dans la compréhension de l’IA générative, le suivi de leur visibilité IA et la mise en œuvre de pratiques responsables seront les mieux placées pour tirer profit de cette technologie transformatrice tout en maîtrisant les risques associés.