Qu'est-ce que le score de perplexité dans le contenu ?

Découvrez ce que signifie le score de perplexité dans le contenu et les modèles de langage. Comprenez comment il mesure l'incertitude du modèle, la précision de...

Le score de perplexité est une mesure quantitative qui évalue l’incertitude ou la prévisibilité d’un texte par un modèle de langage, calculée comme la moyenne exponentielle du log-vraisemblance négatif des jetons prédits. Des scores de perplexité plus bas indiquent une plus grande confiance du modèle et une meilleure capacité de prédiction du texte, tandis que des scores plus élevés reflètent une plus grande incertitude dans la prédiction du mot suivant dans une séquence.

Le score de perplexité est une mesure quantitative qui évalue l’incertitude ou la prévisibilité d’un texte par un modèle de langage, calculée comme la moyenne exponentielle du log-vraisemblance négatif des jetons prédits. Des scores de perplexité plus bas indiquent une plus grande confiance du modèle et une meilleure capacité de prédiction du texte, tandis que des scores plus élevés reflètent une plus grande incertitude dans la prédiction du mot suivant dans une séquence.

Le score de perplexité est une métrique fondamentale en traitement automatique du langage qui quantifie l’incertitude ou la prévisibilité d’un texte généré par des modèles de langage. Formellement défini comme la moyenne exponentielle du log-vraisemblance négatif d’une séquence, le score de perplexité mesure dans quelle mesure un modèle probabiliste prédit un échantillon en calculant le nombre moyen de choix de mots également probables qu’un modèle envisage lors de la prédiction du jeton suivant. La métrique est apparue en 1977 grâce à des chercheurs d’IBM travaillant sur la reconnaissance vocale, dirigés par Frederick Jelinek, qui cherchaient à mesurer la difficulté rencontrée par un modèle statistique lors des tâches de prédiction. Dans le contexte des systèmes d’IA modernes comme ChatGPT, Claude, Perplexity AI et Google AI Overviews, le score de perplexité sert de mécanisme d’évaluation essentiel pour mesurer la confiance du modèle et la qualité de génération du texte. Des scores de perplexité plus bas indiquent que le modèle est plus certain de ses prédictions et attribue des probabilités plus élevées aux bons mots, tandis que des scores plus élevés reflètent une plus grande incertitude et une confusion sur le mot qui devrait suivre dans la séquence.

Le concept de score de perplexité est issu des principes de la théorie de l’information établis par Claude Shannon dans les années 1940 et 1950, qui a développé les bases mathématiques de l’entropie et son application au langage. Le travail révolutionnaire de Shannon sur la « Prédiction et l’entropie de l’anglais imprimé » a démontré que les humains pouvaient prédire les caractères suivants d’un texte avec une précision remarquable, posant ainsi les fondements théoriques de la modélisation computationnelle du langage. Tout au long des années 1980 et 1990, le score de perplexité est devenu la métrique dominante pour l’évaluation des modèles de langage n-grammes, qui étaient la référence avant l’essor de l’apprentissage profond. Sa popularité a perduré avec l’apparition des modèles neuronaux, des réseaux récurrents et des architectures de type transformeur, en faisant l’un des standards d’évaluation les plus durables du PLN. Aujourd’hui, le score de perplexité reste largement utilisé aux côtés de métriques plus récentes telles que BERTScore, ROUGE et les évaluations LLM-as-a-Judge, bien que les chercheurs reconnaissent de plus en plus la nécessité de le combiner à d’autres mesures pour une évaluation complète. Sa longévité reflète à la fois son élégance mathématique et son utilité pratique, même si les applications modernes ont révélé d’importantes limites nécessitant des approches d’évaluation complémentaires.

La base mathématique du score de perplexité repose sur trois concepts interconnectés de la théorie de l’information : l’entropie, l’entropie croisée et la log-vraisemblance. L’entropie mesure l’incertitude moyenne au sein d’une distribution de probabilité, c’est-à-dire à quel point le prochain mot est imprévisible selon le contexte antérieur. L’entropie croisée étend ce concept en mesurant la différence entre la distribution réelle des données et celle prédite par le modèle, pénalisant les prédictions inexactes. Le calcul formel du score de perplexité s’exprime ainsi : PPL(X) = exp{-1/t ∑ log p_θ(x_i|x_<i)}, où t représente le nombre total de jetons dans une séquence et p_θ(x_i|x_<i) la probabilité prédite du i-ème jeton conditionnée à tous les jetons précédents. Cette formule transforme la moyenne du log-vraisemblance négatif en une métrique interprétable par application de la fonction exponentielle, « annulant » ainsi le logarithme pour ramener la mesure dans l’espace des probabilités. La valeur résultante représente le facteur de branchement effectif — le nombre moyen de choix de mots également probables que le modèle considère à chaque étape de prédiction. Par exemple, un score de perplexité de 10 signifie qu’en moyenne, le modèle choisit entre 10 options également probables pour le prochain mot, tandis qu’un score de 100 indique que le modèle envisage 100 alternatives possibles, reflétant une bien plus grande incertitude.

| Métrique | Définition | Mesure | Interprétation | Limites |

|---|---|---|---|---|

| Score de perplexité | Moyenne exponentielle du log-vraisemblance négatif | Incertitude et confiance du modèle dans les prédictions | Plus bas = plus confiant ; Plus haut = plus incertain | Ne mesure pas l’exactitude ni la compréhension sémantique |

| Entropie | Incertitude moyenne d’une distribution de probabilité | Imprévisibilité inhérente des résultats | Entropie élevée = langage plus imprévisible | Ne compare pas les distributions prédite et réelle |

| Entropie croisée | Différence entre distributions réelle et prédite | Qualité d’approximation des prédictions du modèle | Plus bas = meilleure adéquation à la distribution réelle | Exprimée en espace log, moins intuitive que la perplexité |

| Score BLEU | Précision du chevauchement de n-grammes entre texte généré et référence | Qualité de la traduction et du résumé | Plus haut = plus similaire à la référence | Ne capte pas le sens sémantique ni la fluidité |

| Score ROUGE | Rappel du chevauchement de n-grammes entre texte généré et référence | Couverture du résumé et du contenu | Plus haut = meilleure couverture de la référence | Limité à l’évaluation basée sur référence |

| Exactitude | Pourcentage de prédictions ou classifications correctes | Justesse des sorties du modèle | Plus haut = plus de prédictions correctes | Ne mesure pas la confiance ni l’incertitude |

| BERTScore | Similarité contextuelle via les embeddings BERT | Similarité sémantique entre texte généré et référence | Plus haut = plus grande similarité sémantique | Coûteux en calcul ; nécessite un texte de référence |

Le score de perplexité fonctionne en évaluant la capacité du modèle de langage à prédire chaque jeton d’une séquence, compte tenu de tous les jetons précédents. Lorsqu’un modèle traite un texte, il génère une distribution de probabilité sur l’ensemble de son vocabulaire pour chaque position, attribuant des probabilités plus élevées aux mots jugés plus probables et des probabilités plus faibles aux autres. Le modèle calcule la log-probabilité du mot réel qui apparaît ensuite dans les données de test, puis fait la moyenne de ces log-probabilités sur tous les jetons de la séquence. Cette moyenne est multipliée par -1 pour obtenir une valeur positive, puis exponentiée pour revenir de l’espace log à l’espace des probabilités. Le score de perplexité ainsi obtenu représente à quel point le modèle est « surpris » ou « perplexe » face au texte réel — un score faible indique que le modèle a attribué de fortes probabilités aux mots effectivement présents, tandis qu’un score élevé montre que le modèle leur avait accordé de faibles probabilités. Dans la pratique, avec les modèles transformeurs modernes tels que GPT-2, GPT-3 ou Claude, le calcul implique la tokenisation du texte d’entrée, son passage dans le modèle pour obtenir des logits (scores bruts de prédiction), la conversion de ces logits en probabilités via softmax, puis le calcul de la moyenne du log-vraisemblance négatif sur les jetons valides en masquant les jetons de remplissage. La stratégie de fenêtre glissante est souvent utilisée pour les modèles à contexte fixe : la fenêtre de contexte se déplace dans le texte pour offrir le maximum de contexte disponible à chaque prédiction, ce qui donne des estimations de perplexité plus précises qu’avec des segments non chevauchés.

Dans les contextes professionnels et de recherche, le score de perplexité sert de métrique essentielle d’assurance qualité pour le déploiement et la surveillance des modèles de langage. Les organisations utilisent le score de perplexité pour identifier les besoins de réentraînement, d’ajustement ou d’amélioration architecturale des modèles, car la dégradation du score signale souvent une baisse de performance. Pour des plateformes de surveillance de l’IA comme AmICited, le score de perplexité fournit une preuve chiffrée de la confiance avec laquelle les systèmes d’IA génèrent des réponses sur les marques, domaines et URLs suivis sur des plateformes telles que ChatGPT, Perplexity AI, Claude et Google AI Overviews. Un modèle affichant une perplexité constamment faible sur les requêtes liées à une marque suggère des schémas de citation stables et confiants, tandis qu’une perplexité en hausse peut indiquer une incertitude ou une incohérence dans la façon dont le système d’IA mentionne certaines entités. Les études montrent qu’environ 78 % des entreprises intègrent désormais des métriques d’évaluation automatisées, dont la perplexité, dans leurs cadres de gouvernance de l’IA, reconnaissant que la compréhension de la confiance du modèle est cruciale pour les applications à fort enjeu comme le conseil médical, la documentation juridique ou l’analyse financière. Dans ces domaines, une réponse très confiante mais incorrecte présente plus de risques qu’une réponse incertaine qui appelle à une vérification humaine. Le score de perplexité permet aussi une surveillance en temps réel lors de l’entraînement et de l’ajustement des modèles, donnant aux data scientists la possibilité de détecter le surapprentissage, le sous-apprentissage ou des problèmes de convergence en quelques minutes plutôt qu’en attendant les résultats sur des tâches aval. Son efficacité computationnelle — un seul passage avant dans le modèle suffit — le rend adapté à la surveillance continue en production, même lorsque les ressources de calcul sont limitées.

Différentes plateformes d’IA mettent en œuvre l’évaluation du score de perplexité selon des méthodologies et des contextes variés. ChatGPT et d’autres modèles OpenAI sont évalués via des jeux de données et des cadres propriétaires qui mesurent la perplexité dans divers domaines, bien que les scores exacts ne soient pas publiquement divulgués. Claude, développé par Anthropic, utilise aussi la perplexité dans sa suite d’évaluation, des recherches suggérant de bonnes performances sur les tâches de compréhension à long contexte malgré les limites connues de la perplexité sur les dépendances longues. Perplexity AI, plateforme IA axée sur la recherche, met l’accent sur la récupération d’informations en temps réel et la précision des citations, où le score de perplexité aide à évaluer la confiance du système dans la génération de réponses avec attribution de sources. Google AI Overviews (anciennement SGE) utilise des métriques de perplexité pour évaluer la cohérence et la constance des réponses lors de la synthèse d’informations de plusieurs sources. Pour la surveillance AmICited, comprendre ces implémentations spécifiques est crucial car chaque système peut tokeniser différemment, utiliser des tailles de vocabulaire et des stratégies de fenêtre de contexte distinctes, impactant directement les scores de perplexité obtenus. Une réponse sur une marque peut obtenir une perplexité de 15 sur une plateforme et 22 sur une autre, non à cause de différences qualitatives, mais pour des raisons architecturales et de prétraitement. D’où l’importance pour AmICited de suivre non seulement les valeurs absolues de perplexité mais aussi les tendances, la constance et les métriques comparatives entre plateformes pour fournir des analyses pertinentes sur la façon dont les systèmes d’IA font référence aux entités suivies.

Mettre en œuvre l’évaluation du score de perplexité nécessite une attention particulière à plusieurs aspects techniques et méthodologiques. Premièrement, la cohérence de la tokenisation est primordiale : utiliser différentes méthodes de tokenisation (au niveau des caractères, mots, sous-mots) produit des scores de perplexité radicalement différents, rendant les comparaisons intermodèles problématiques sans standardisation. Deuxièmement, la stratégie de fenêtre de contexte influence fortement les résultats ; l’approche par fenêtre glissante avec une foulée égale à la moitié de la longueur de contexte maximale donne typiquement des estimations plus précises que les segments non chevauchés, au prix d’un coût de calcul accru. Troisièmement, le choix du jeu de données est crucial : les scores de perplexité sont spécifiques à chaque jeu de données et ne peuvent être comparés entre différents ensembles de test sans normalisation rigoureuse. Les bonnes pratiques incluent : établir des scores de perplexité de référence sur des jeux standardisés tels que WikiText-2 ou Penn Treebank pour l’étalonnage ; utiliser des pipelines de prétraitement cohérents pour toutes les évaluations de modèles ; documenter les méthodes de tokenisation et les stratégies de fenêtre de contexte dans tous les résultats ; combiner la perplexité avec des métriques complémentaires comme BLEU, ROUGE, exactitude factuelle et évaluation humaine pour une analyse globale ; et surveiller les tendances de perplexité dans le temps plutôt que de s’en tenir à des mesures ponctuelles. Pour les organisations intégrant le score de perplexité dans leurs systèmes de surveillance en production, l’alerte automatique sur la dégradation de la perplexité peut déclencher une enquête sur des problèmes de qualité de données, de dérive du modèle ou d’infrastructure avant que les utilisateurs finaux n’en subissent les conséquences.

Malgré sa large adoption et son élégance théorique, le score de perplexité présente des limites importantes qui l’empêchent de servir de métrique d’évaluation autonome. Surtout, le score de perplexité ne mesure ni la compréhension sémantique ni l’exactitude factuelle : un modèle peut obtenir une faible perplexité en prédisant avec confiance des mots et phrases courants tout en générant un contenu absurde ou incorrect. Des recherches publiées en 2024 montrent que la perplexité ne corrèle pas bien avec la compréhension à long terme, probablement parce qu’elle n’évalue que la prédiction du jeton suivant sans capturer la cohérence ou la logique à long terme des séquences. La sensibilité à la tokenisation pose aussi problème : des modèles au niveau des caractères peuvent obtenir une perplexité plus basse que des modèles au niveau des mots tout en produisant un texte de moindre qualité, et différentes méthodes de sous-mots (BPE, WordPiece, SentencePiece) rendent les scores incomparables. La perplexité peut être artificiellement abaissée en attribuant de fortes probabilités aux mots courants, à la ponctuation et aux répétitions, sans que cela n’améliore la qualité ou l’utilité du texte. La métrique est également très sensible aux caractéristiques du jeu de données : les scores de perplexité ne sont pas comparables entre jeux de test, et les textes de domaine produisent souvent une perplexité plus élevée que les textes généraux, indépendamment de la qualité du modèle. Enfin, les limites de la fenêtre de contexte dans les modèles à longueur fixe font que les calculs de perplexité ne reflètent pas toujours la vraie décomposition autorégressive, surtout pour les longues séquences où le modèle ne dispose pas de tout le contexte.

L’avenir du score de perplexité dans l’évaluation de l’IA s’oriente vers une intégration avec des métriques complémentaires plutôt qu’un remplacement ou une obsolescence. À mesure que les modèles de langage deviennent plus grands et puissants, les chercheurs reconnaissent de plus en plus que le score de perplexité doit être associé à des métriques de compréhension sémantique, d’exactitude factuelle et à des évaluations humaines pour une analyse pertinente. Les travaux émergents explorent des variantes contextuelles de la perplexité qui capturent mieux la cohérence et les dépendances à long terme, pour pallier l’une des limites fondamentales de la métrique. L’essor des systèmes IA multimodaux traitant texte, images, audio et vidéo stimule le développement de cadres de perplexité généralisés au-delà de la modélisation purement textuelle. AmICited et des plateformes similaires intègrent la perplexité avec d’autres métriques pour suivre non seulement ce que disent les systèmes d’IA sur les marques et domaines, mais aussi la confiance avec laquelle ils le disent, permettant la détection de l’incohérence, des hallucinations et de la dérive de citation. L’adoption industrielle de la surveillance par perplexité s’accélère, les grands laboratoires d’IA et les entreprises mettant en place un suivi continu de la perplexité dans leurs cadres de gouvernance des modèles. Les développements futurs incluront probablement des tableaux de bord de perplexité en temps réel pour alerter sur la dégradation des modèles, une normalisation interplateformes de la perplexité pour comparer équitablement différents systèmes d’IA, et une analyse interprétable de la perplexité pour identifier quels jetons ou contextes spécifiques génèrent une forte incertitude. À mesure que les systèmes d’IA s’intègrent dans des fonctions critiques pour les entreprises et la société, comprendre et surveiller le score de perplexité aux côtés d’autres métriques restera essentiel pour garantir un déploiement fiable et digne de confiance de l’IA.

Le score de perplexité est calculé comme PPL(X) = exp{-1/t ∑ log p_θ(x_i|x_

Le score de perplexité mesure la confiance et l’incertitude du modèle dans les prédictions, pas leur justesse. Un modèle peut avoir une faible perplexité mais être incorrect, ou une haute perplexité mais être précis. Les métriques de précision évaluent si les prédictions sont correctes ou non, tandis que la perplexité quantifie à quel point le modèle est certain de ses prédictions, ce qui en fait des approches d’évaluation complémentaires pour une analyse complète du modèle.

Le score de perplexité aide les plateformes de surveillance de l’IA à suivre la confiance avec laquelle des modèles de langage comme ChatGPT, Claude et Perplexity génèrent des réponses concernant des marques ou des domaines spécifiques. En mesurant la prévisibilité du texte, AmICited peut évaluer si les systèmes d’IA génèrent des citations cohérentes et confiantes ou des mentions incertaines et variables des entités suivies, ce qui permet une meilleure compréhension de la fiabilité des réponses de l’IA.

Le score de perplexité ne mesure pas la compréhension sémantique, la véracité des faits ou la cohérence à long terme. Il peut être faussé par la ponctuation et les répétitions de texte, et est sensible aux méthodes de tokenisation et à la taille du vocabulaire. Les recherches montrent que la perplexité ne corrèle pas bien avec la compréhension à long terme, ce qui la rend insuffisante comme métrique d’évaluation autonome sans mesures complémentaires comme BLEU, ROUGE ou une évaluation humaine.

Différents modèles de langage atteignent des scores de perplexité variés selon leur architecture, leurs données d’entraînement et leurs méthodes de tokenisation. GPT-2 atteint environ 19,44 de perplexité sur WikiText-2 avec un contexte non chevauché, tandis que des modèles plus grands comme GPT-3 et Claude obtiennent généralement de meilleurs scores. Les scores de perplexité ne sont pas directement comparables entre modèles en raison des différences de taille de vocabulaire, de longueur de contexte et de prétraitement, nécessitant des ensembles d’évaluation standardisés pour une comparaison équitable.

Le score de perplexité est mathématiquement dérivé des concepts d’entropie et d’entropie croisée issus de la théorie de l’information. Alors que l’entropie mesure l’incertitude dans une seule distribution de probabilité, l’entropie croisée mesure la différence entre la distribution réelle et celle prédite. La perplexité applique la fonction exponentielle à l’entropie croisée, la convertissant de l’espace logarithmique à l’espace de probabilité, la rendant plus interprétable comme le nombre effectif de choix de mots considérés par le modèle.

Le score de perplexité s’améliore grâce à des ensembles de données d’entraînement plus volumineux, des fenêtres de contexte plus longues, de meilleures stratégies de tokenisation et des architectures de modèles plus sophistiquées. L’ajustement sur des données spécifiques à un domaine, l’augmentation du nombre de paramètres du modèle et l’utilisation de stratégies d’évaluation par fenêtre glissante pendant l’évaluation peuvent réduire la perplexité. Cependant, les améliorations doivent être équilibrées avec d’autres métriques pour s’assurer que les modèles génèrent un texte non seulement confiant mais aussi exact, cohérent et contextuellement approprié.

Commencez à suivre comment les chatbots IA mentionnent votre marque sur ChatGPT, Perplexity et d'autres plateformes. Obtenez des informations exploitables pour améliorer votre présence IA.

Découvrez ce que signifie le score de perplexité dans le contenu et les modèles de langage. Comprenez comment il mesure l'incertitude du modèle, la précision de...

Discussion communautaire sur le score de perplexité dans le contenu et les modèles linguistiques. Rédacteurs et experts en IA débattent de son importance pour l...

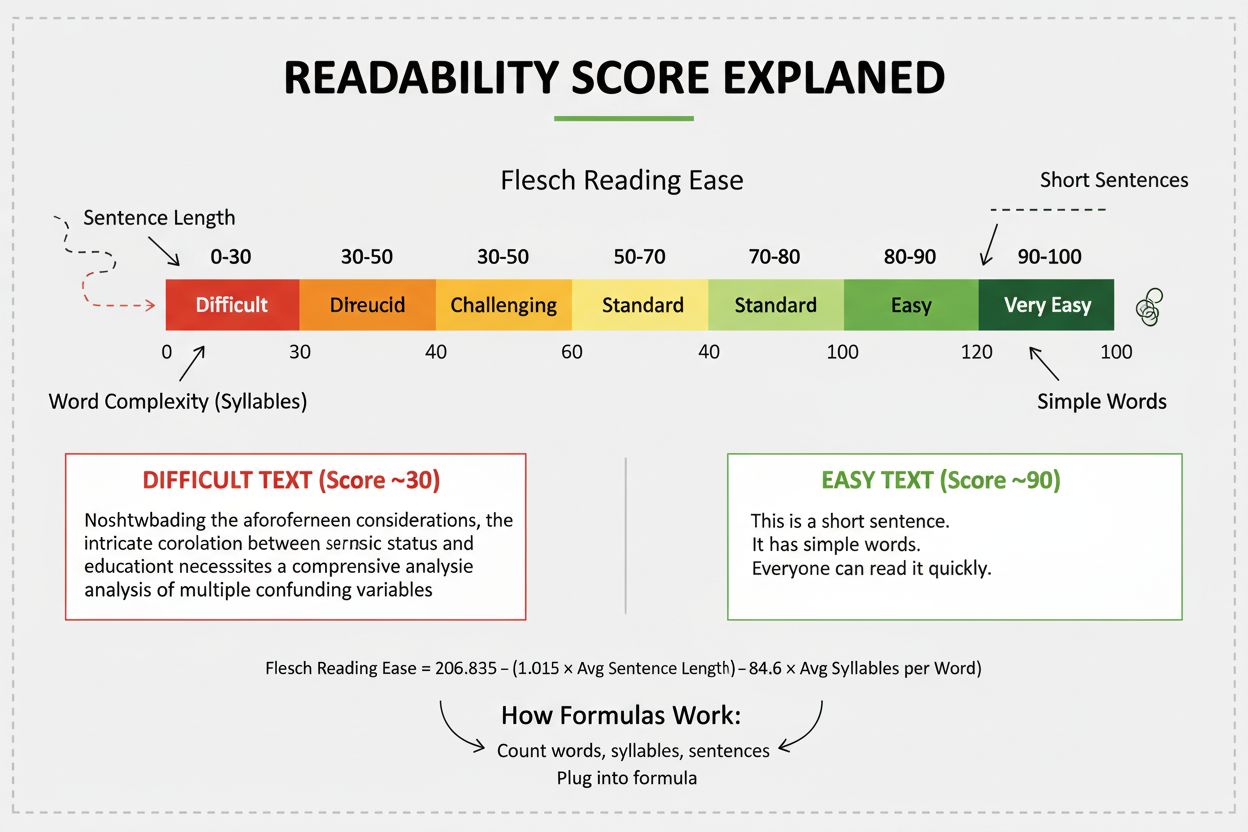

Le score de lisibilité mesure la difficulté de compréhension d'un contenu à l'aide d'une analyse linguistique. Découvrez comment les formules Flesch, Gunning Fo...