Affinage de requête

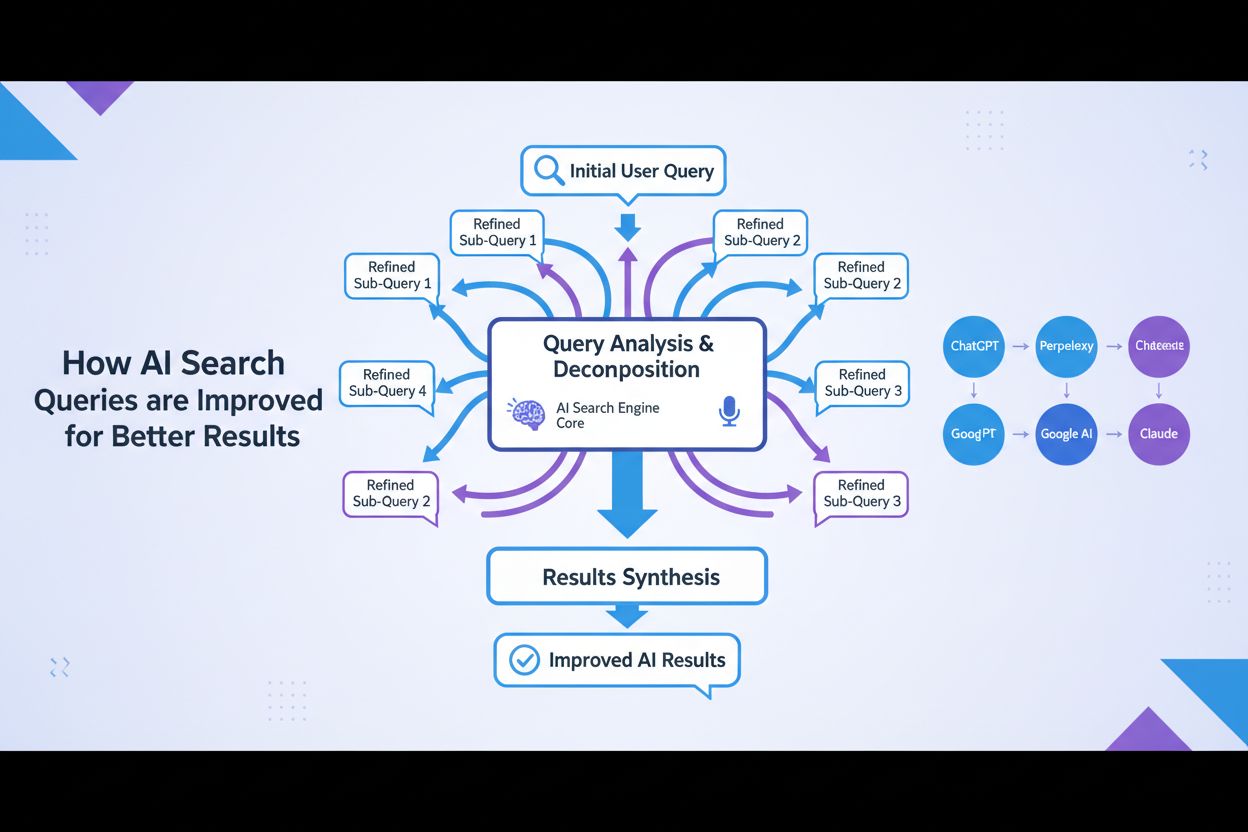

L’affinage de requête est le processus itératif d’optimisation des requêtes de recherche pour de meilleurs résultats dans les moteurs de recherche IA. Découvrez...

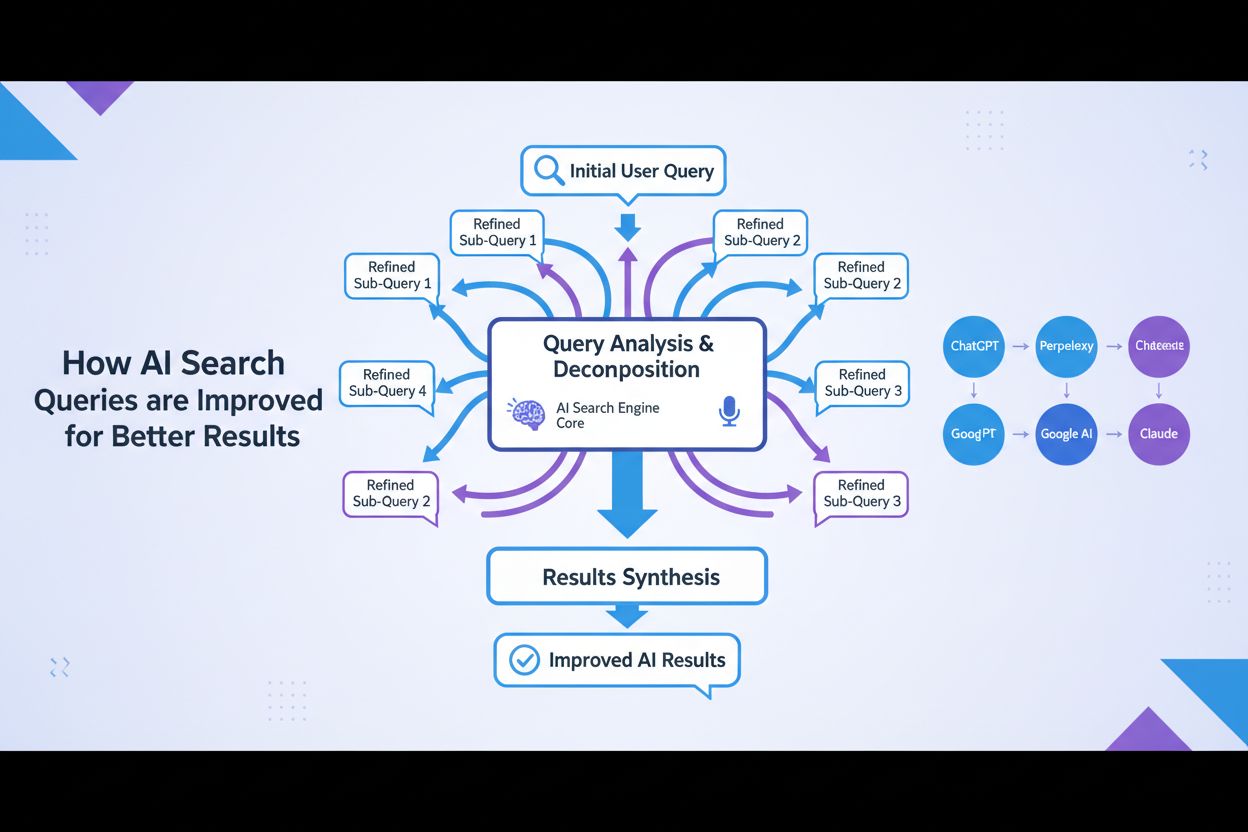

L’optimisation de l’expansion de requête est le processus d’amélioration des requêtes de recherche des utilisateurs avec des termes associés, des synonymes et des variantes contextuelles afin d’améliorer la précision de la récupération et la pertinence du contenu dans les systèmes d’IA. Elle comble les écarts de vocabulaire entre les requêtes des utilisateurs et les documents pertinents, garantissant que les systèmes d’IA tels que GPT et Perplexity peuvent trouver et référencer un contenu plus approprié. Cette technique est essentielle pour améliorer à la fois l’exhaustivité et la précision des réponses générées par l’IA. En élargissant intelligemment les requêtes, les plateformes d’IA peuvent considérablement améliorer la découverte et la citation de sources pertinentes.

L'optimisation de l'expansion de requête est le processus d'amélioration des requêtes de recherche des utilisateurs avec des termes associés, des synonymes et des variantes contextuelles afin d'améliorer la précision de la récupération et la pertinence du contenu dans les systèmes d'IA. Elle comble les écarts de vocabulaire entre les requêtes des utilisateurs et les documents pertinents, garantissant que les systèmes d'IA tels que GPT et Perplexity peuvent trouver et référencer un contenu plus approprié. Cette technique est essentielle pour améliorer à la fois l'exhaustivité et la précision des réponses générées par l'IA. En élargissant intelligemment les requêtes, les plateformes d'IA peuvent considérablement améliorer la découverte et la citation de sources pertinentes.

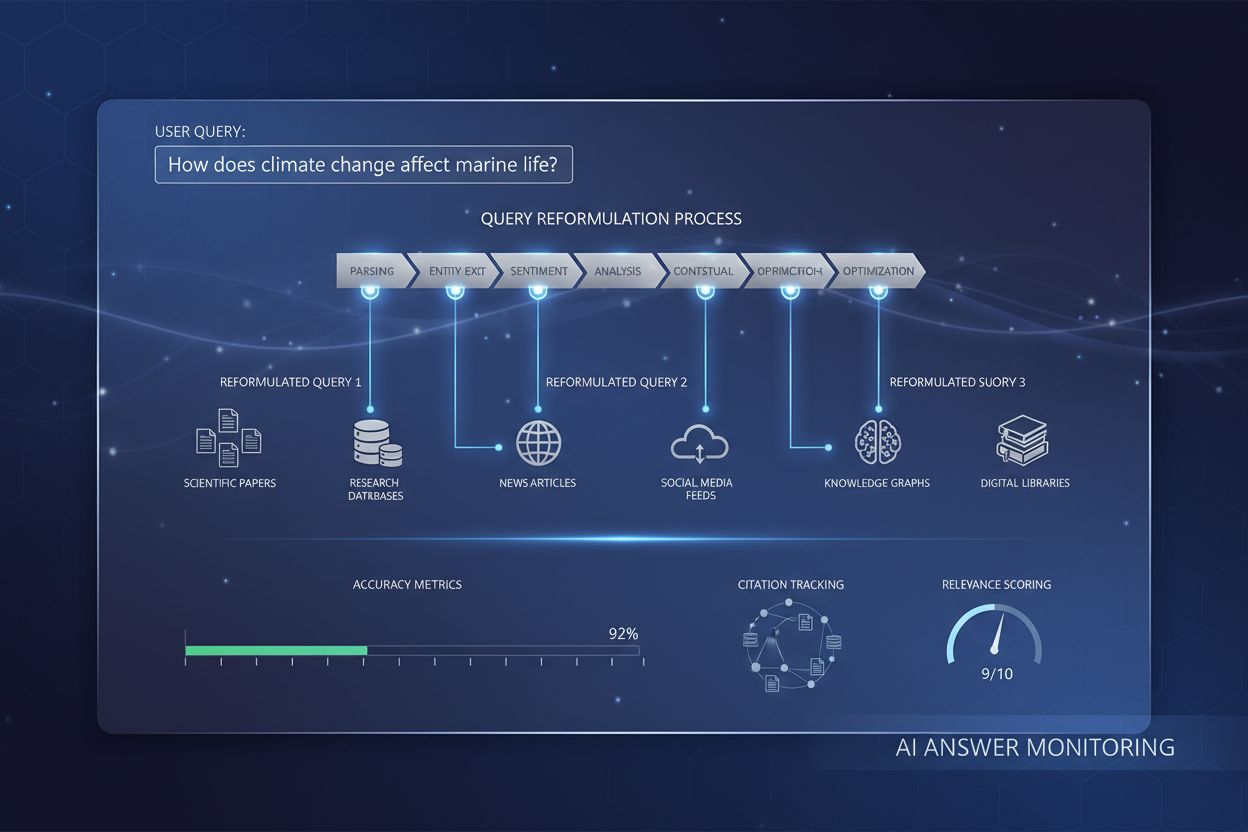

L’optimisation de l’expansion de requête est le processus de reformulation et d’amélioration des requêtes de recherche en ajoutant des termes associés, des synonymes et des variations sémantiques afin d’améliorer la performance de la récupération et la qualité des réponses. Au cœur du concept, l’expansion de requête répond au problème de décalage de vocabulaire : le défi fondamental selon lequel les utilisateurs et les systèmes d’IA emploient souvent une terminologie différente pour décrire les mêmes concepts, ce qui conduit à manquer des résultats pertinents. Cette technique est essentielle pour les systèmes d’IA car elle comble l’écart entre la façon dont les personnes expriment naturellement leurs besoins en information et la façon dont le contenu est réellement indexé et stocké. En élargissant intelligemment les requêtes, les plateformes d’IA peuvent considérablement améliorer la pertinence et l’exhaustivité de leurs réponses.

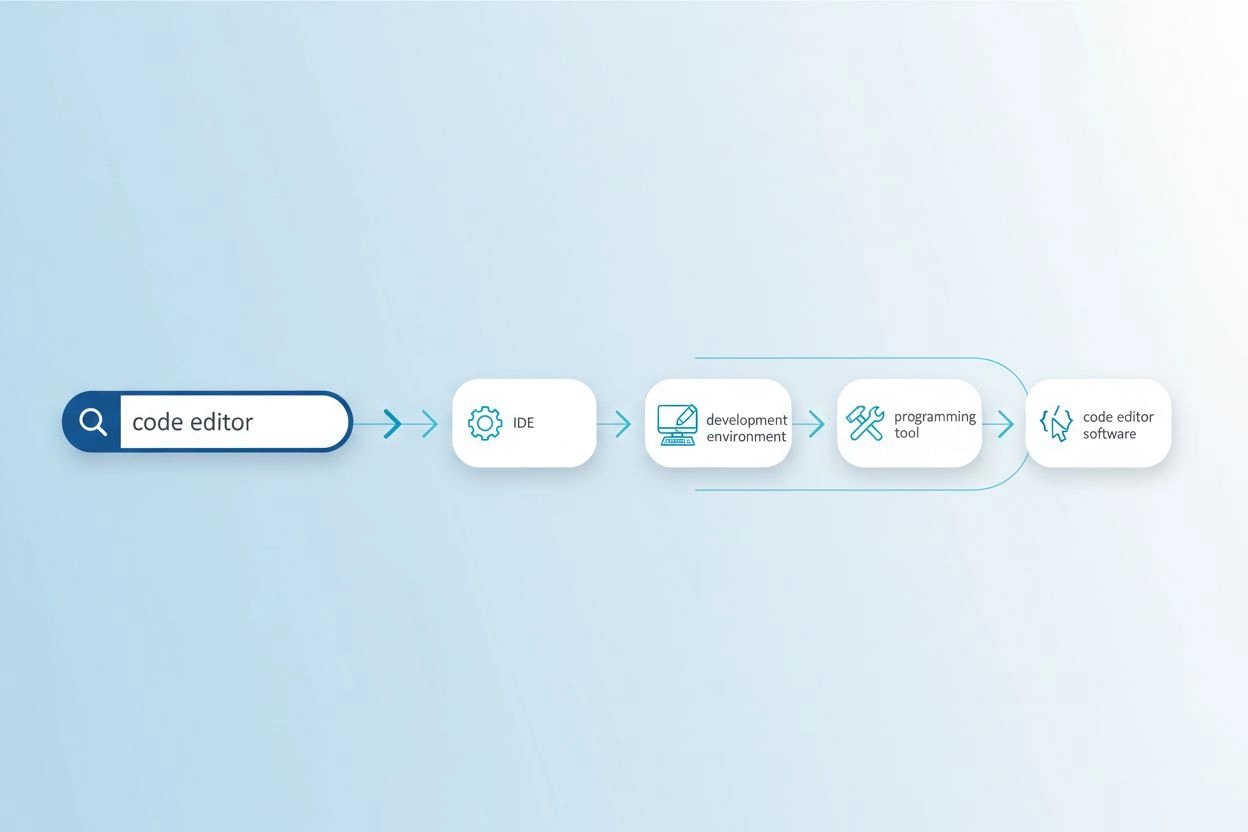

Le problème de décalage de vocabulaire survient lorsque les mots exacts utilisés dans une requête ne correspondent pas à la terminologie trouvée dans les documents pertinents, empêchant les systèmes de recherche de détecter des informations précieuses. Par exemple, un utilisateur cherchant « éditeur de code » pourrait passer à côté de résultats concernant les « IDE » (environnements de développement intégrés) ou les « éditeurs de texte », alors qu’il s’agit d’alternatives très pertinentes. De même, une personne recherchant « véhicule » ne trouvera peut-être pas de résultats étiquetés « voiture », « automobile » ou « véhicule à moteur », malgré un chevauchement sémantique évident. Ce problème devient de plus en plus aigu dans les domaines spécialisés où plusieurs termes techniques décrivent un même concept, et il impacte directement la qualité des réponses générées par l’IA en limitant la matière première disponible pour la synthèse. L’expansion de requête résout ce problème en générant automatiquement des variantes de requête associées qui capturent différentes façons d’exprimer la même information.

| Requête d’origine | Requête élargie | Impact |

|---|---|---|

| éditeur de code | IDE, éditeur de texte, environnement de développement, éditeur de code source | Trouve 3 à 5 fois plus de résultats pertinents |

| apprentissage automatique | IA, intelligence artificielle, deep learning, réseaux neuronaux | Capture les variations terminologiques propres au domaine |

| véhicule | voiture, automobile, véhicule à moteur, transport | Inclut les synonymes courants et termes associés |

| mal de tête | migraine, céphalée de tension, soulagement de la douleur, traitement du mal de tête | Prend en compte les variations terminologiques médicales |

L’expansion de requête moderne utilise plusieurs techniques complémentaires, chacune présentant des avantages distincts selon le cas d’usage et le domaine :

Chaque technique propose différents compromis entre coût computationnel, qualité d’expansion et spécificité du domaine, les approches LLM offrant la meilleure qualité mais nécessitant plus de ressources.

L’expansion de requête améliore les réponses de l’IA en offrant aux modèles de langage et aux systèmes de récupération un ensemble de sources plus riche et plus exhaustif pour générer des réponses. Lorsqu’une requête est élargie pour inclure des synonymes, des concepts associés et des formulations alternatives, le système de récupération peut accéder à des documents utilisant une terminologie différente mais contenant des informations tout aussi pertinentes, augmentant considérablement le rappel du processus de recherche. Ce contexte étendu permet aux systèmes d’IA de synthétiser des réponses plus complètes et nuancées, car ils ne sont plus limités par les choix de vocabulaire spécifiques de la requête d’origine. Cependant, l’expansion de requête introduit un compromis précision/rappel : alors que les requêtes élargies récupèrent plus de documents pertinents, elles peuvent également introduire du bruit et des résultats moins pertinents si l’expansion est trop agressive. La clé de l’optimisation consiste à calibrer l’intensité de l’expansion pour maximiser les gains de pertinence tout en minimisant le bruit, afin que les réponses IA deviennent plus complètes sans sacrifier la précision.

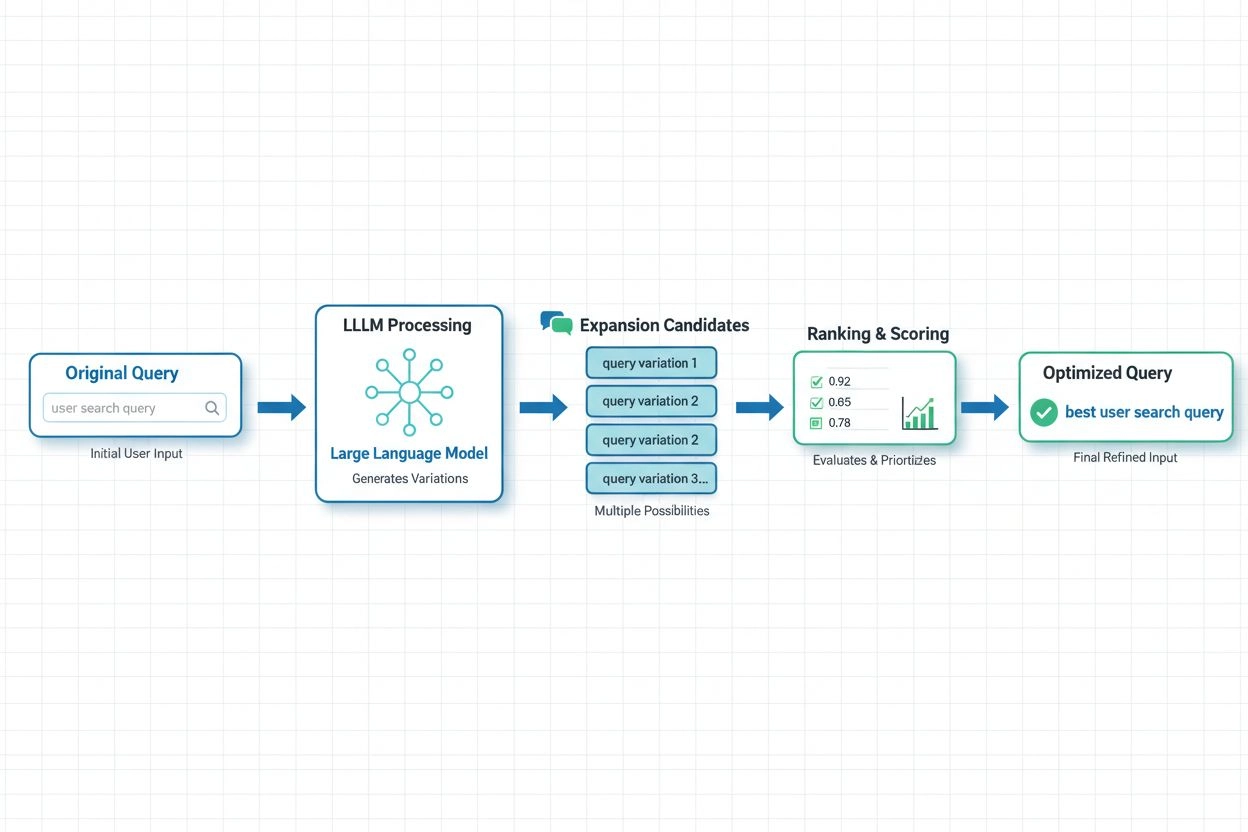

Dans les systèmes d’IA modernes, l’expansion de requête basée sur les LLM s’impose comme l’approche la plus sophistiquée, tirant parti des capacités de compréhension sémantique des grands modèles de langage pour générer des variantes de requête contextuellement appropriées. Des recherches récentes de Spotify illustrent la puissance de cette approche : leur mise en œuvre utilisant des techniques d’alignement des préférences (combinaison des méthodes RSFT et DPO) a permis une réduction d’environ 70 % du temps de traitement tout en améliorant simultanément la précision de récupération top-1. Ces systèmes fonctionnent en entraînant les modèles de langage à comprendre les préférences et l’intention de l’utilisateur, puis à générer des expansions alignées sur ce que les utilisateurs jugent réellement pertinent, plutôt que d’ajouter arbitrairement des synonymes. Les approches d’optimisation en temps réel adaptent continuellement les stratégies d’expansion sur la base des retours utilisateurs et des résultats de récupération, permettant aux systèmes d’apprendre quelles expansions fonctionnent le mieux selon le type de requête et le domaine. Cette approche dynamique est particulièrement précieuse pour les plateformes de monitoring IA, car elle permet de suivre l’impact de l’expansion de requête sur la précision des citations et la découverte de contenu selon les sujets et les secteurs.

Malgré ses avantages, l’expansion de requête présente des défis importants qui nécessitent des stratégies d’optimisation rigoureuses. Le problème de sur-expansion survient lorsque trop de variantes de requête sont ajoutées, introduisant du bruit et récupérant des documents non pertinents qui diluent la qualité des réponses et augmentent les coûts computationnels. L’ajustement spécifique au domaine est essentiel car les techniques d’expansion efficaces pour la recherche web générale peuvent échouer dans des domaines spécialisés comme la recherche médicale ou la documentation juridique, où la précision terminologique est cruciale. Les organisations doivent trouver un équilibre entre couverture et précision : étendre suffisamment pour capter les variantes pertinentes sans aller jusqu’à ce que les résultats non pertinents submergent le signal. Les approches de validation efficaces incluent les tests A/B de différentes stratégies d’expansion évaluées par des jugements humains de pertinence, la surveillance de métriques telles que précision@k et rappel@k, et l’analyse continue des expansions qui améliorent réellement les performances sur les tâches en aval. Les implémentations les plus réussies utilisent une expansion adaptative qui ajuste l’intensité selon les caractéristiques de la requête, le contexte du domaine et la qualité de récupération observée, au lieu d’appliquer des règles uniformes à toutes les requêtes.

Pour AmICited.com et les plateformes de monitoring IA, l’optimisation de l’expansion de requête est fondamentale pour suivre avec précision la manière dont les systèmes d’IA citent et référencent les sources selon les sujets et contextes de recherche. Lorsque les systèmes d’IA utilisent en interne des requêtes élargies, ils accèdent à une gamme plus large de sources potentielles, ce qui affecte directement les citations dans leurs réponses et leur couverture de l’information disponible. Cela signifie que la surveillance de la qualité des réponses IA nécessite de comprendre non seulement ce que les utilisateurs demandent, mais aussi quelles variantes élargies de la requête le système IA utilise en coulisses pour récupérer les informations justificatives. Les marques et créateurs de contenu doivent optimiser leur stratégie de contenu en considérant comment leur matériel pourrait être découvert via l’expansion de requête : utiliser plusieurs variantes terminologiques, des synonymes et des concepts associés dans l’ensemble de leur contenu pour garantir la visibilité à travers différentes formulations de requête. AmICited aide les organisations à suivre cela en surveillant comment leur contenu apparaît dans les réponses générées par l’IA selon divers types et expansions de requête, révélant les lacunes où le contenu pourrait être manqué en raison de décalages de vocabulaire et apportant des éclairages sur la façon dont les stratégies d’expansion de requête influent sur les schémas de citation et la découverte de contenu dans les systèmes d’IA.

L'expansion de requête ajoute des termes associés et des synonymes à la requête originale tout en conservant l'intention principale, tandis que la réécriture de requête reformule entièrement la requête pour mieux correspondre aux capacités du système de recherche. L'expansion de requête est additive—elle élargit le champ de la recherche—alors que la réécriture est transformative, modifiant la façon dont la requête est exprimée. Les deux techniques améliorent la récupération, mais l'expansion est généralement moins risquée car elle préserve l'intention de la requête d'origine.

L'expansion de requête impacte directement les sources que les systèmes d'IA découvrent et citent car elle modifie les documents disponibles pour la récupération. Lorsque les systèmes d'IA utilisent des requêtes élargies en interne, ils accèdent à une gamme plus large de sources potentielles, ce qui affecte les citations apparaissant dans leurs réponses. Cela signifie que la surveillance de la qualité des réponses IA nécessite de comprendre non seulement ce que les utilisateurs demandent, mais aussi quelles variantes élargies de la requête le système IA peut utiliser en coulisses.

Oui, une expansion excessive peut introduire du bruit et récupérer des documents non pertinents qui diluent la qualité des réponses. Cela se produit lorsque trop de variantes de requêtes sont ajoutées sans filtrage adéquat. La clé est de trouver un équilibre dans l'intensité de l'expansion pour maximiser les gains de pertinence tout en minimisant le bruit non pertinent. Les implémentations efficaces utilisent une expansion adaptative qui ajuste l'intensité en fonction des caractéristiques de la requête et de la qualité observée de la récupération.

Les grands modèles de langage ont révolutionné l'expansion de requête en permettant une compréhension sémantique de l'intention de l'utilisateur et en générant des variantes de requête contextuellement appropriées. L'expansion basée sur les LLM utilise des techniques d'alignement des préférences pour entraîner les modèles à générer des expansions qui améliorent réellement les résultats de récupération, plutôt que d'ajouter simplement des synonymes arbitraires. Des recherches récentes montrent que les approches basées sur les LLM peuvent réduire le temps de traitement d'environ 70 % tout en améliorant la précision de récupération.

Les marques doivent utiliser plusieurs variantes de terminologie, des synonymes et des concepts associés dans leur contenu afin d'assurer la visibilité à travers différentes formulations de requêtes. Cela signifie considérer comment votre matériel pourrait être découvert via l'expansion de requête—en utilisant à la fois des termes techniques et familiers, en incluant des formulations alternatives et en abordant des concepts connexes. Cette stratégie garantit que votre contenu est découvrable quelle que soit la variante de requête utilisée par les systèmes d'IA.

Les indicateurs clés incluent la précision@k (pertinence des k premiers résultats), le rappel@k (couverture du contenu pertinent dans les k premiers résultats), le rang réciproque moyen (position du premier résultat pertinent) et la performance sur les tâches en aval. Les organisations surveillent également le temps de traitement, les coûts informatiques et les mesures de satisfaction des utilisateurs. Les tests A/B de différentes stratégies d'expansion, évalués par des jugements humains de pertinence, offrent la validation la plus fiable.

Non, ce sont des techniques complémentaires mais distinctes. L'expansion de requête modifie la requête d'entrée pour améliorer la récupération, tandis que la recherche sémantique utilise des embeddings et des représentations vectorielles pour trouver du contenu conceptuellement similaire. L'expansion de requête peut faire partie d'une chaîne de traitement en recherche sémantique, mais la recherche sémantique peut aussi fonctionner sans expansion explicite. Les deux techniques traitent le décalage de vocabulaire mais via des mécanismes différents.

AmICited suit comment les systèmes d'IA citent et référencent les sources à travers différents sujets et contextes de recherche, révélant quelles requêtes élargies conduisent à la mention de votre marque. En surveillant les schémas de citation à travers divers types de requêtes et expansions, AmICited fournit des informations sur la façon dont les stratégies d'expansion de requête affectent la découverte de contenu et la précision des citations dans les systèmes d'IA comme GPT et Perplexity.

L'optimisation de l'expansion de requête affecte la façon dont les systèmes d'IA comme GPT et Perplexity découvrent et citent votre contenu. Utilisez AmICited pour suivre quelles requêtes élargies conduisent à la mention de votre marque dans les réponses IA.

L’affinage de requête est le processus itératif d’optimisation des requêtes de recherche pour de meilleurs résultats dans les moteurs de recherche IA. Découvrez...

Découvrez comment la reformulation de requête aide les systèmes d’IA à interpréter et enrichir les requêtes utilisateur pour une meilleure recherche d’informati...

Découvrez comment l'Expansion FAQ développe des paires questions-réponses complètes pour les systèmes d'IA. Découvrez des stratégies pour améliorer les citation...