Élagage de contenu

L’élagage de contenu est la suppression ou la mise à jour stratégique du contenu sous-performant pour améliorer le SEO, l’expérience utilisateur et la visibilit...

Un site de scraping est un site web qui copie automatiquement du contenu provenant d’autres sources sans autorisation et le republie, souvent avec des modifications minimes. Ces sites utilisent des robots automatisés pour collecter des données, des textes, des images et d’autres contenus provenant de sites web légitimes afin d’alimenter leurs propres pages, généralement à des fins frauduleuses, de plagiat ou pour générer des revenus publicitaires.

Un site de scraping est un site web qui copie automatiquement du contenu provenant d'autres sources sans autorisation et le republie, souvent avec des modifications minimes. Ces sites utilisent des robots automatisés pour collecter des données, des textes, des images et d'autres contenus provenant de sites web légitimes afin d'alimenter leurs propres pages, généralement à des fins frauduleuses, de plagiat ou pour générer des revenus publicitaires.

Un site de scraping est un site web qui copie automatiquement du contenu d’autres sources sans autorisation et le republie, souvent avec des modifications ou des reformulations minimes. Ces sites utilisent des robots automatisés pour collecter des données, des textes, des images, des descriptions de produits et d’autres contenus provenant de sites web légitimes afin d’alimenter leurs propres pages. Cette pratique est techniquement illégale au regard du droit d’auteur et viole les conditions d’utilisation de la plupart des sites web. Le scraping de contenu se distingue fondamentalement du web scraping légitime car il implique la copie non autorisée de contenus publiés à des fins malveillantes, notamment la fraude, le plagiat, la génération de revenus publicitaires et le vol de propriété intellectuelle. La nature automatisée du scraping permet aux acteurs malveillants de copier des milliers de pages en quelques minutes, créant ainsi d’énormes problèmes de contenu dupliqué sur Internet.

Le scraping de contenu existe depuis les débuts d’Internet, mais le problème s’est considérablement aggravé avec les progrès de l’automatisation et de l’intelligence artificielle. Au début des années 2000, les scrapeurs étaient relativement simples et faciles à détecter. Cependant, les robots de scraping modernes sont de plus en plus sophistiqués, utilisant des techniques telles que les algorithmes de reformulation, la rotation d’adresses IP et l’automatisation de navigateur pour échapper à la détection. L’essor de la génération de contenu alimentée par l’IA a aggravé le problème, les scrapeurs utilisant désormais l’apprentissage automatique pour réécrire le contenu volé de manière à ce qu’il soit plus difficile à identifier comme dupliqué. Selon des rapports sectoriels, les sites de scraping représentent une part importante du trafic de robots malveillants, certaines estimations suggérant que les bots automatisés représentent plus de 40 % du trafic Internet total. L’arrivée de moteurs de recherche IA comme ChatGPT, Perplexity et Google AI Overviews a créé de nouveaux défis, ces systèmes pouvant citer accidentellement des sites de scraping au lieu des créateurs de contenu originaux, amplifiant ainsi le problème.

Les robots de scraping fonctionnent via un processus automatisé en plusieurs étapes nécessitant très peu d’intervention humaine. D’abord, le robot explore les sites cibles en suivant les liens et en accédant aux pages, téléchargeant le code HTML et tout le contenu associé. Le robot analyse ensuite le HTML pour extraire les données pertinentes, telles que le texte des articles, les images, les métadonnées et les informations sur les produits. Ce contenu extrait est stocké dans une base de données, où il peut être retravaillé à l’aide d’outils de reformulation ou de logiciels de réécriture alimentés par l’IA pour créer des variantes qui semblent différentes de l’original. Enfin, le contenu copié est republié sur le site de scraping, souvent avec une attribution minimale ou de fausses revendications d’auteur. Certains scrapeurs sophistiqués utilisent des proxies rotatifs et le spoofing user-agent pour déguiser leurs requêtes en trafic humain légitime, les rendant plus difficiles à détecter et à bloquer. L’ensemble du processus peut être entièrement automatisé, permettant à une seule opération de scraper des milliers de pages chaque jour sur plusieurs sites simultanément.

| Aspect | Site de Scraping | Site de contenu original | Agrégateur de données légitime |

|---|---|---|---|

| Origine du contenu | Copié sans autorisation | Créé à l’origine | Curé avec attribution et liens |

| Statut légal | Illégal (violation du droit d’auteur) | Protégé par le droit d’auteur | Légal (avec licence appropriée) |

| Attribution | Minimale ou fausse | Auteur original crédité | Sources citées et liées |

| Objectif | Fraude, plagiat, revenus publicitaires | Apporter de la valeur à l’audience | Agréger et organiser l’information |

| Impact SEO | Négatif (contenu dupliqué) | Positif (contenu original) | Neutre à positif (avec canonisation appropriée) |

| Expérience utilisateur | Médiocre (contenu de faible qualité) | Excellente (contenu unique et pertinent) | Bonne (contenu organisé et sourcé) |

| Conditions d’utilisation | Viole les CGU | Conforme à ses propres CGU | Respecte les CGU et robots.txt des sites |

| Méthodes de détection | Suivi IP, signatures de robots | N/A | Schémas de crawl transparents |

Les sites de scraping fonctionnent selon plusieurs modèles économiques distincts, tous conçus pour générer des revenus à partir de contenus volés. Le modèle le plus courant est la monétisation publicitaire, où les scrapeurs remplissent leurs pages de publicités provenant de réseaux comme Google AdSense ou d’autres régies. En republiant du contenu populaire, les scrapeurs attirent du trafic de recherche organique et génèrent des impressions et des clics publicitaires sans créer de valeur originale. Un autre modèle courant est la fraude e-commerce, où les scrapeurs créent de fausses boutiques en ligne qui imitent des détaillants légitimes, copiant descriptions, images et prix des produits. Les clients non avertis achètent sur ces sites frauduleux, recevant soit des produits contrefaits, soit se faisant voler leurs informations de paiement. La collecte d’emails est un autre modèle de scraping important, où les coordonnées sont extraites des sites web et revendues à des spammeurs ou utilisées pour des campagnes de phishing ciblées. Certains scrapeurs pratiquent également la fraude à l’affiliation, copiant des avis produits et du contenu tout en insérant leurs propres liens d’affiliation pour percevoir des commissions. Les faibles coûts opérationnels du scraping—nécessitant uniquement un hébergement et des logiciels automatisés—rendent ces modèles très rentables malgré leur illégalité.

Les conséquences du scraping pour les créateurs originaux sont graves et multiples. Lorsque des scrapeurs republient votre contenu sur leurs domaines, ils créent du contenu dupliqué qui embrouille les moteurs de recherche sur la version originale. L’algorithme de Google peut avoir du mal à identifier la source d’autorité, ce qui peut entraîner le déclassement des versions originale et copiée dans les résultats de recherche. Cela impacte directement le trafic organique, car votre contenu soigneusement optimisé perd en visibilité au profit de sites de scraping qui n’ont rien apporté à sa création. Au-delà des classements, les scrapeurs faussent vos analyses web en générant du trafic fictif de robots, rendant difficile la compréhension du comportement réel des utilisateurs et des indicateurs d’engagement. Vos ressources serveur sont également gaspillées à traiter les requêtes des robots de scraping, augmentant les coûts de bande passante et pouvant ralentir votre site pour vos visiteurs légitimes. L’impact SEO négatif s’étend à l’autorité de domaine et au profil de liens, car les scrapeurs peuvent créer des liens de mauvaise qualité pointant vers votre site ou utiliser votre contenu dans des contextes de spam. De plus, lorsque les scrapeurs se classent mieux que votre contenu original, vous perdez l’occasion de vous positionner comme leader d’opinion dans votre secteur, au détriment de votre réputation et de votre crédibilité.

Identifier les sites de scraping nécessite une approche combinant méthodes manuelles et automatisées. Google Alerts est l’un des outils gratuits les plus efficaces, vous permettant de surveiller les titres de vos articles, phrases uniques et nom de marque pour repérer les republications non autorisées. Lorsqu’une alerte Google correspond, vous pouvez vérifier s’il s’agit d’une citation légitime ou d’un site de scraping. La surveillance des pingbacks est particulièrement utile sur WordPress, car les pingbacks sont générés lorsqu’un autre site crée un lien vers votre contenu. Si vous recevez des pingbacks de domaines inconnus ou suspects, il peut s’agir de sites de scraping ayant copié vos liens internes. Les outils SEO comme Ahrefs, SEM Rush et Grammarly offrent des fonctionnalités de détection de contenu dupliqué qui analysent le web à la recherche de pages similaires à votre contenu. Ces outils identifient aussi bien les doublons exacts que les versions reformulées de vos articles. L’analyse des logs serveur fournit des informations techniques sur les schémas de trafic des robots, révélant des adresses IP suspectes, des taux de requêtes inhabituels et des chaînes user-agent de robots. La recherche inversée d’images via Google Images ou TinEye permet de voir où vos images sont republiées sans autorisation. Une surveillance régulière de votre Google Search Console peut révéler des anomalies d’indexation et des problèmes de contenu dupliqué pouvant indiquer une activité de scraping.

Le scraping de contenu viole plusieurs niveaux de protection juridique, ce qui en fait l’une des formes de fraude en ligne les plus réprimandables. Le droit d’auteur protège automatiquement tout contenu original, qu’il soit publié en ligne ou sur support physique, donnant aux créateurs des droits exclusifs de reproduction, de distribution et de diffusion de leur œuvre. Copier du contenu sans autorisation constitue une contrefaçon directe, exposant les scrapeurs à des sanctions civiles, y compris des dommages et intérêts et des injonctions. Le Digital Millennium Copyright Act (DMCA) offre une protection supplémentaire en interdisant le contournement des mesures techniques de protection. Si vous mettez en place des contrôles d’accès ou des dispositifs anti-scraping, le DMCA rend illégal leur contournement. Le Computer Fraud and Abuse Act (CFAA) peut également s’appliquer, notamment lorsque les robots accèdent sans autorisation à des systèmes ou vont au-delà de l’accès autorisé. Les conditions d’utilisation des sites web interdisent explicitement le scraping, et leur violation peut entraîner des poursuites pour rupture de contrat. De nombreux créateurs ont déjà engagé avec succès des actions contre des scrapeurs, obtenant des ordonnances de suppression et l’arrêt des activités de scraping. Certaines juridictions reconnaissent également le scraping comme une forme de concurrence déloyale, permettant aux entreprises de demander des dommages et intérêts pour perte de revenus et préjudice commercial.

L’émergence des moteurs de recherche IA et des grands modèles de langage (LLM) a ajouté une nouvelle dimension au problème des sites de scraping. Lorsque des IA comme ChatGPT, Perplexity, Google AI Overviews ou Claude explorent le web pour collecter des données d’entraînement ou générer des réponses, elles peuvent rencontrer des sites de scraping aux côtés du contenu original. Si le site de scraping apparaît plus fréquemment ou bénéficie d’un meilleur SEO technique, l’IA peut citer le site copié plutôt que la source d’origine. Cela pose un problème car les citations IA jouent un rôle majeur dans la visibilité et l’autorité de la marque. Si un site de scraping est cité dans une réponse IA à la place de votre contenu original, vous perdez l’opportunité d’asseoir votre marque comme source d’autorité dans les résultats IA. En outre, les scrapeurs peuvent introduire des inexactitudes ou des informations obsolètes dans les données d’entraînement IA, conduisant les systèmes à générer des réponses incorrectes ou trompeuses. Le problème est aggravé par le manque de transparence des systèmes IA sur l’attribution des sources, rendant difficile la vérification de l’origine du contenu. Des outils de surveillance comme AmICited permettent aux créateurs de contenu de suivre où leur marque et leur contenu apparaissent sur les plateformes IA, pour identifier quand des scrapeurs leur volent la visibilité dans les réponses IA.

Protéger votre contenu contre le scraping nécessite une approche technique et opérationnelle multi-couches. Les outils de détection et de blocage de robots comme Bot Zapping de ClickCease permettent d’identifier et de bloquer les robots malveillants avant qu’ils n’accèdent à votre contenu, en les redirigeant vers des pages d’erreur. La configuration du robots.txt vous permet de restreindre l’accès des robots à certains dossiers ou pages, même si les scrapeurs déterminés peuvent ignorer ces directives. Les balises noindex peuvent être appliquées aux pages sensibles ou au contenu généré automatiquement (comme les pages d’étiquettes et de catégories WordPress) pour éviter qu’ils ne soient indexés et copiés. Le content gating oblige les utilisateurs à remplir un formulaire ou à se connecter pour accéder au contenu premium, compliquant la collecte automatisée à grande échelle. La limitation de débit sur votre serveur restreint le nombre de requêtes par adresse IP sur une période donnée, ralentissant les robots de scraping et rendant leurs opérations moins efficaces. Les CAPTCHA permettent de vérifier que les requêtes proviennent d’humains et non de robots, même si certains robots sophistiqués peuvent les contourner. La surveillance côté serveur des schémas de requêtes permet d’identifier les activités suspectes et de bloquer les adresses IP problématiques de façon proactive. Des sauvegardes régulières de votre contenu servent de preuve de la date de création originale, utile en cas d’action en justice contre les scrapeurs.

Le paysage du scraping continue d’évoluer à mesure que la technologie progresse et que de nouvelles opportunités apparaissent. Le paraphrasage alimenté par l’IA devient de plus en plus sophistiqué, rendant le contenu copié difficile à détecter comme dupliqué via les outils classiques de détection de plagiat. Les scrapeurs investissent dans des techniques avancées de rotation de proxy et d’automatisation de navigateur pour contourner les systèmes de détection. L’essor du scraping de données d’entraînement pour l’IA ouvre une nouvelle frontière, où les scrapeurs ciblent le contenu spécifiquement pour entraîner des modèles de machine learning, souvent sans aucune compensation pour les créateurs originaux. Certains scrapeurs utilisent désormais des navigateurs headless et le rendu JavaScript pour accéder à du contenu dynamique auparavant inatteignable. L’intégration du scraping avec les réseaux d’affiliation et les systèmes de fraude publicitaire complexifie et rend plus discrètes les opérations des scrapeurs. Toutefois, des évolutions positives émergent : les systèmes de détection IA s’améliorent dans l’identification du contenu copié, et les moteurs de recherche pénalisent de plus en plus les sites de scraping dans leurs algorithmes. La mise à jour Google core de novembre 2024 a spécifiquement ciblé les sites de scraping, entraînant une perte de visibilité majeure pour de nombreux domaines de ce type. Les créateurs de contenu adoptent également des technologies de watermarking et des solutions de vérification par blockchain pour prouver l’originalité et la propriété. À mesure que les moteurs de recherche IA mûrissent, ils mettent en œuvre une meilleure attribution des sources et des mécanismes de transparence afin de garantir aux créateurs originaux un crédit et une visibilité appropriés.

Pour les créateurs de contenu et responsables de marque, la lutte contre les sites de scraping va désormais au-delà des moteurs de recherche traditionnels pour s’étendre aux systèmes émergents de recherche et de réponse pilotés par l’IA. AmICited propose une surveillance spécialisée pour suivre où votre marque, votre contenu et votre domaine apparaissent sur les plateformes IA, y compris Perplexity, ChatGPT, Google AI Overviews et Claude. En surveillant votre visibilité IA, vous pouvez identifier quand des sites de scraping cherchent à obtenir des citations dans les réponses IA, quand votre contenu original est correctement attribué, et quand des copies non autorisées gagnent en visibilité. Ces informations vous permettent d’agir proactivement pour protéger votre propriété intellectuelle et maintenir l’autorité de votre marque dans les résultats de recherche pilotés par l’IA. Comprendre la différence entre l’agrégation légitime de contenu et le scraping malveillant est crucial à l’ère de l’IA, car les enjeux de visibilité et d’autorité de marque n’ont jamais été aussi élevés.

Oui, le scraping de contenu est techniquement illégal dans la plupart des juridictions. Il viole les lois sur le droit d'auteur qui protègent le contenu numérique de la même manière que les publications physiques. De plus, le scraping viole souvent les conditions d'utilisation des sites web et peut entraîner des poursuites judiciaires en vertu du Digital Millennium Copyright Act (DMCA) et du Computer Fraud and Abuse Act (CFAA). Les propriétaires de sites web peuvent engager la responsabilité civile et pénale contre les scrapeurs.

Les sites de scraping ont un impact négatif sur le SEO de plusieurs façons. Lorsque du contenu dupliqué issu de sites de scraping se classe mieux que l'original, cela dilue la visibilité du site d'origine et son trafic organique. L'algorithme de Google a du mal à identifier quelle version est l'originale, ce qui peut entraîner un classement inférieur pour toutes les versions. De plus, les scrapeurs gaspillent le budget de crawl de votre site et peuvent fausser vos analyses, rendant difficile la compréhension du comportement réel des utilisateurs et des indicateurs de performance.

Les sites de scraping servent plusieurs objectifs malveillants : créer de faux magasins en ligne pour commettre des fraudes, héberger des sites web usurpés qui imitent des marques légitimes, générer des revenus publicitaires grâce à un trafic frauduleux, plagier du contenu pour remplir des pages sans effort, et collecter des listes d'emails et des informations de contact pour des campagnes de spam. Certains scrapeurs ciblent également les informations tarifaires, les détails de produits et le contenu des réseaux sociaux à des fins d'intelligence concurrentielle ou de revente.

Vous pouvez détecter le contenu copié grâce à plusieurs méthodes : configurez des Google Alerts pour les titres de vos articles ou des phrases uniques, recherchez les titres de votre contenu dans Google pour voir si des doublons apparaissent, vérifiez les pingbacks sur les liens internes (surtout sur WordPress), utilisez des outils SEO comme Ahrefs ou SEM Rush pour trouver du contenu dupliqué, et surveillez les schémas de trafic de votre site pour repérer une activité inhabituelle de robots. Une surveillance régulière vous aide à identifier rapidement les scrapeurs.

Le web scraping est un terme technique plus large désignant l'extraction de données à partir de sites web, ce qui peut être légitime lorsqu'il est effectué avec autorisation à des fins de recherche ou d'analyse de données. Le scraping de contenu fait spécifiquement référence à la copie non autorisée de contenus publiés comme des articles, des descriptions de produits et des images pour une republication. Alors que le web scraping peut être légal, le scraping de contenu est intrinsèquement malveillant et illégal car il viole le droit d'auteur et les conditions d'utilisation.

Les robots de scraping utilisent des logiciels automatisés pour explorer les sites web, télécharger le contenu HTML, extraire le texte et les images et les stocker dans des bases de données. Ces robots simulent le comportement de navigation humaine pour contourner les méthodes de détection de base. Ils peuvent accéder à la fois au contenu visible publiquement et parfois à des bases de données cachées si la sécurité est faible. Les données collectées sont ensuite traitées, parfois reformulées à l'aide d'outils d'IA, puis republiées sur les sites de scraping avec des modifications minimales pour éviter la détection dupliquée exacte.

Les stratégies de prévention efficaces incluent la mise en place d'outils de détection et de blocage des robots, l'utilisation de robots.txt pour restreindre l'accès des robots, l'ajout de balises noindex sur les pages sensibles, la protection du contenu premium derrière des formulaires de connexion, la surveillance régulière de votre site avec Google Alerts et des outils SEO, l'utilisation de CAPTCHA, la limitation du débit sur votre serveur, et la surveillance des logs serveur pour détecter les adresses IP et schémas de trafic suspects. Une approche multi-couches est la plus efficace.

Les sites de scraping posent un défi important pour les moteurs de recherche IA comme ChatGPT, Perplexity et Google AI Overviews. Lorsque les systèmes d'IA explorent le web pour obtenir des données d'entraînement ou générer des réponses, ils peuvent rencontrer du contenu copié et citer des sites de scraping au lieu des sources originales. Cela dilue la visibilité des créateurs de contenu légitimes dans les réponses IA et peut amener les systèmes IA à propager de la désinformation. Des outils de suivi comme AmICited vous aident à identifier où votre marque et votre contenu apparaissent sur les plateformes IA.

Commencez à suivre comment les chatbots IA mentionnent votre marque sur ChatGPT, Perplexity et d'autres plateformes. Obtenez des informations exploitables pour améliorer votre présence IA.

L’élagage de contenu est la suppression ou la mise à jour stratégique du contenu sous-performant pour améliorer le SEO, l’expérience utilisateur et la visibilit...

Le contenu piraté est un matériel de site web non autorisé, modifié par des cybercriminels. Découvrez comment les sites compromis affectent le SEO, les résultat...

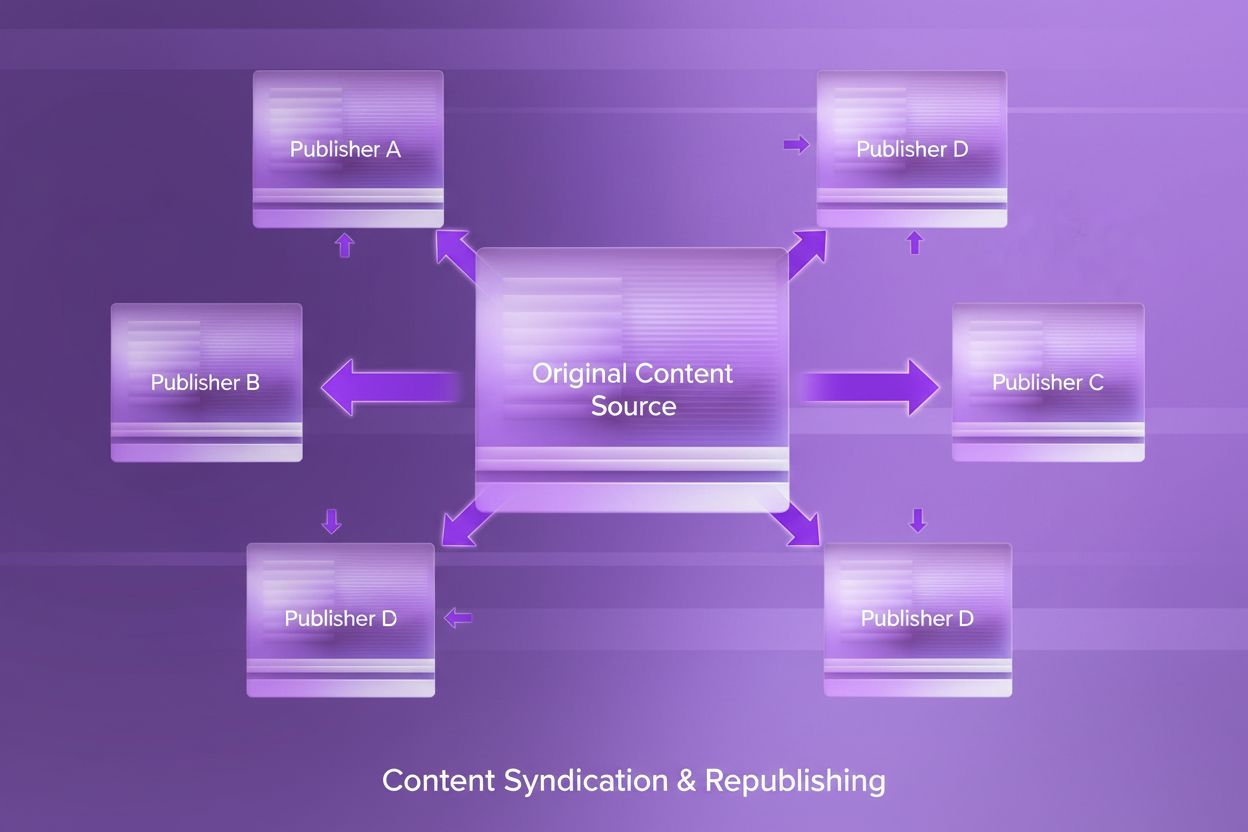

Découvrez ce qu’est la syndication de contenu, comment elle fonctionne, ses implications SEO et les bonnes pratiques pour republier du contenu sur différentes p...