Détection du spam

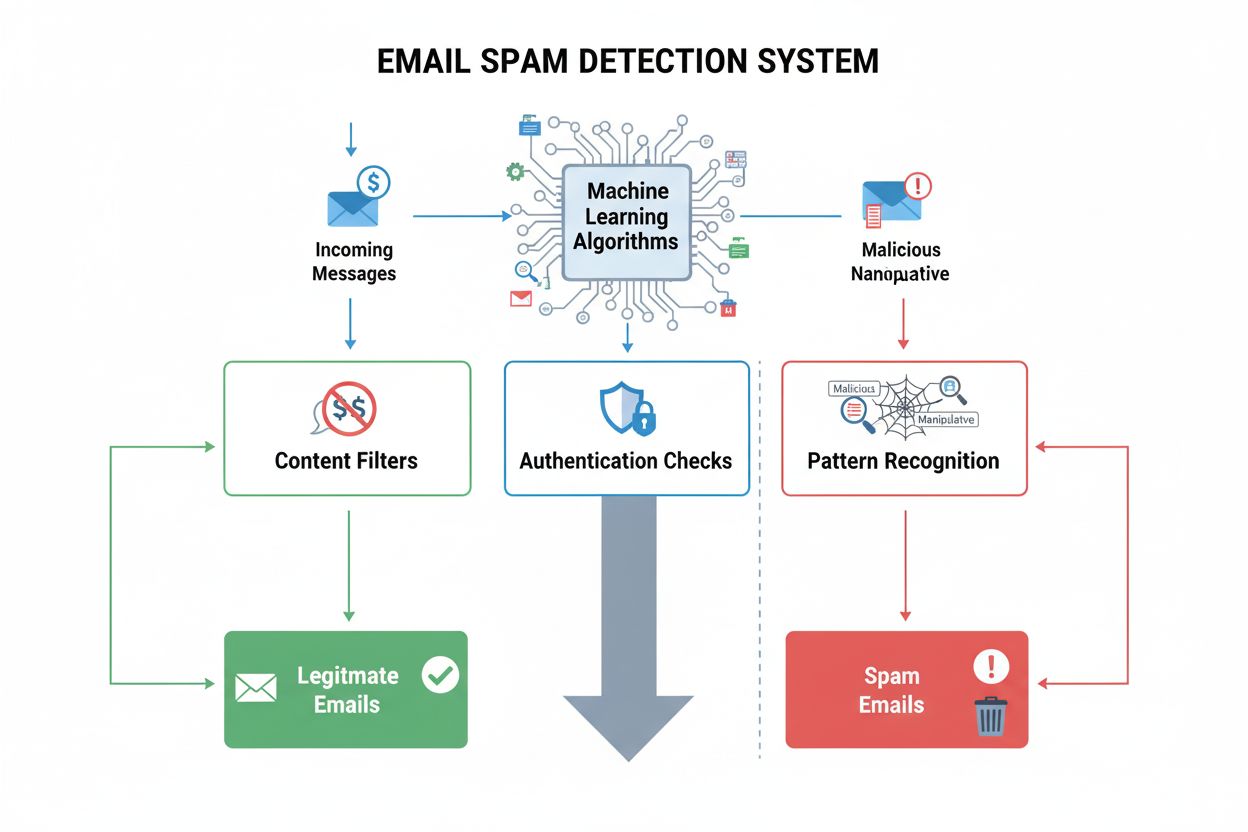

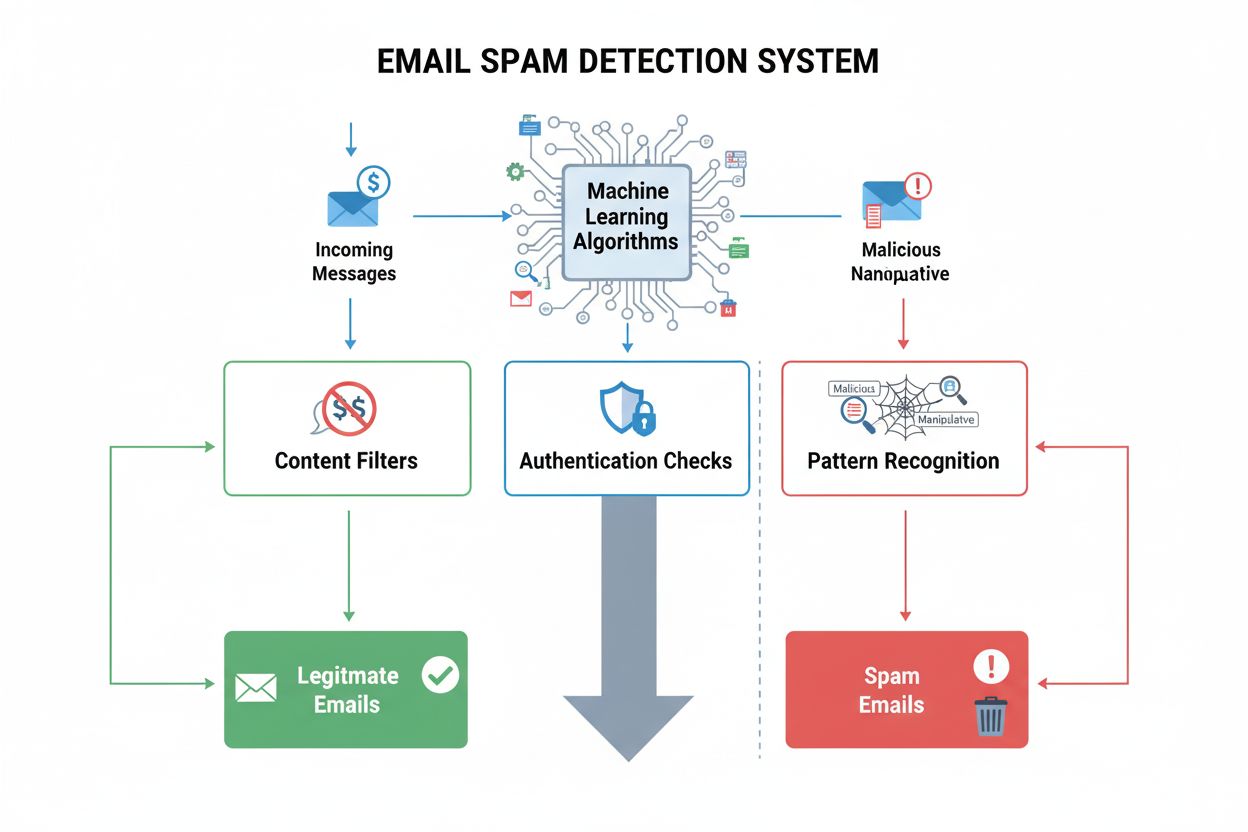

La détection du spam identifie les contenus indésirables et manipulateurs à l'aide d'algorithmes de ML et d'analyses comportementales. Découvrez comment les sys...

Le spam des moteurs de recherche fait référence aux tactiques de manipulation délibérées utilisées pour influencer artificiellement le classement dans les moteurs de recherche via des techniques trompeuses qui enfreignent les directives des moteurs de recherche. Ces pratiques incluent le bourrage de mots-clés, le cloaking, les fermes de liens et le texte caché, conçus pour tromper les algorithmes plutôt que d’apporter une réelle valeur aux utilisateurs.

Le spam des moteurs de recherche fait référence aux tactiques de manipulation délibérées utilisées pour influencer artificiellement le classement dans les moteurs de recherche via des techniques trompeuses qui enfreignent les directives des moteurs de recherche. Ces pratiques incluent le bourrage de mots-clés, le cloaking, les fermes de liens et le texte caché, conçus pour tromper les algorithmes plutôt que d’apporter une réelle valeur aux utilisateurs.

Le spam des moteurs de recherche, également appelé spamdexing, fait référence à la manipulation délibérée des index des moteurs de recherche à l’aide de techniques trompeuses conçues pour gonfler artificiellement le classement d’un site web. Le terme recouvre un large éventail de pratiques non éthiques qui enfreignent les directives des moteurs de recherche, notamment le bourrage de mots-clés, le cloaking, les fermes de liens, le texte caché et les redirections sournoises. Ces tactiques visent à tromper les algorithmes de recherche plutôt qu’à offrir une réelle valeur aux utilisateurs, sapant fondamentalement l’intégrité des résultats. Lorsqu’un moteur de recherche détecte du spam sur un site, il impose généralement des sanctions allant de la baisse de classement à la suppression complète de l’index, rendant le site invisible pour les visiteurs potentiels.

Le spam des moteurs de recherche existe depuis les débuts d’Internet, lorsque les algorithmes de recherche étaient moins sophistiqués et plus faciles à manipuler. Dans les années 1990 et au début des années 2000, les techniques de spamdexing se sont multipliées à mesure que les webmestres découvraient qu’ils pouvaient booster artificiellement leur classement grâce à la simple répétition de mots-clés et à la manipulation des liens. Avec l’évolution des moteurs de recherche, notamment après l’introduction du PageRank de Google et les mises à jour d’algorithme comme Panda (2011) et Penguin (2012), la détection et la sanction du spam sont devenues de plus en plus sophistiquées. L’émergence de SpamBrain, le système de prévention du spam basé sur l’IA lancé par Google en 2022, a marqué une évolution majeure vers la détection du spam pilotée par le machine learning. Aujourd’hui, les moteurs de recherche utilisent des algorithmes avancés analysant des centaines de facteurs de classement, rendant les tactiques de spam traditionnelles largement inefficaces tout en ouvrant de nouvelles opportunités de manipulation sophistiquée.

Le bourrage de mots-clés demeure l’une des tactiques de spam les plus reconnaissables, consistant à répéter de manière non naturelle des mots-clés cibles dans le contenu de la page, les balises meta et les éléments cachés. Cette pratique gonfle artificiellement la densité des mots-clés sans fournir d’informations cohérentes ou de valeur au lecteur. Le cloaking représente une approche plus trompeuse, affichant un contenu différent aux crawlers des moteurs de recherche qu’aux utilisateurs, généralement via des techniques JavaScript ou côté serveur pour différencier bots et visiteurs humains. Les fermes de liens et les PBN (Private Blog Networks) constituent une autre catégorie majeure de spam, impliquant des réseaux de sites de faible qualité créés uniquement pour générer des liens artificiels vers des sites cibles. Ces réseaux exploitent le fait que les moteurs de recherche ont longtemps accordé beaucoup de poids aux backlinks comme signal de classement, bien que les algorithmes modernes sachent désormais détecter et dévaloriser ces schémas de liens artificiels.

Les redirections sournoises manipulent le comportement des utilisateurs en les envoyant vers des URLs différentes de celles crawlées par les moteurs, souvent vers du contenu non pertinent ou malveillant après un clic depuis les résultats de recherche. Le texte et les liens cachés consistent à placer du contenu dans des couleurs identiques à l’arrière-plan, en polices minuscules ou hors écran—rendant le texte invisible pour les visiteurs humains mais visible pour les crawlers. Le spam de commentaires et le spam de forums exploitent les plateformes à contenu généré par les utilisateurs en postant automatiquement des liens et du contenu promotionnel sur les blogs, forums et réseaux sociaux. Le scraping de contenu consiste à copier du contenu d’autres sites web sans autorisation ou modification, puis à le republier pour gonfler artificiellement le volume de pages et capter du trafic. Chacune de ces tactiques vise à tromper les algorithmes de recherche plutôt qu’à mériter un classement par des moyens légitimes.

| Aspect | Spam des moteurs de recherche (Black Hat) | SEO légitime (White Hat) | SEO Gray Hat |

|---|---|---|---|

| Objectif principal | Manipulation des algorithmes par la tromperie | Apporter de la valeur aux utilisateurs et obtenir un classement naturel | Exploitation des zones grises des directives |

| Qualité du contenu | Faible, bourré de mots-clés ou dupliqué | De haute qualité, original, orienté utilisateur | Qualité mixte avec certaines pratiques discutables |

| Netlinking | Liens artificiels (fermes, PBN, sites piratés) | Liens naturels gagnés via du contenu de qualité | Achat de liens ou échanges de liens |

| Méthodes techniques | Cloaking, texte caché, redirections sournoises | HTML propre, balises meta correctes, données structurées | Redirections JavaScript, pages satellites |

| Expérience utilisateur | Médiocre : contenu pour les algorithmes, non pour l’humain | Excellente : contenu pensé pour l’utilisateur | Moyenne : certains compromis UX |

| Sanctions moteur de recherche | Actions manuelles, désindexation, baisse de classement | Aucune : progression continue | Risque de sanction si détecté |

| Viabilité à long terme | Non viable : sanctions inévitables | Durable : autorité pérenne | Risqué : dépend de la détection |

| Temps de récupération | Mois à années ; certains avantages perdus à jamais | N/A : aucune sanction | Semaines à mois si détecté |

SpamBrain représente un changement fondamental dans la lutte contre le spam grâce à l’intelligence artificielle et au machine learning. Lancé par Google en 2022, SpamBrain analyse les schémas de milliards de sites pour identifier les caractéristiques du spam avec une précision inédite. Le système fonctionne en continu, examinant à la fois les facteurs on-page (qualité du contenu, répartition des mots-clés, structure) et les signaux off-page (profils de liens, historique de domaine, comportements utilisateurs). Les modèles de machine learning de SpamBrain sont entraînés sur de vastes ensembles de données de sites spammés et légitimes, permettant d’identifier de nouvelles variantes de spam avant même leur généralisation. L’IA repère des tentatives sophistiquées pouvant échapper aux systèmes de détection par règles, notamment les schémas de liens coordonnés, la manipulation de contenu et l’exploitation de sites piratés. Selon Google, les améliorations de SpamBrain ont réduit d’environ 45 % la présence de contenu de faible qualité et non original dans les résultats de recherche depuis sa mise en œuvre, preuve de l’efficacité de la détection antispam pilotée par l’IA.

La prolifération du spam détériore directement la qualité et l’utilité des résultats de recherche pour l’utilisateur final. Quand du contenu spammy est bien classé, les internautes se retrouvent face à des informations non pertinentes, médiocres ou trompeuses plutôt que des sources fiables répondant à leur requête. Cette dégradation de la qualité nuit à la confiance envers les moteurs de recherche et oblige les plateformes à investir massivement dans la détection et la suppression du spam. La présence de spam crée aussi une concurrence déloyale où les entreprises légitimes peinent à rivaliser avec des sites utilisant des méthodes non éthiques, du moins temporairement. Les moteurs de recherche répondent à la prolifération du spam par des mises à jour antispam périodiques—des améliorations notables de leurs systèmes de détection, annoncées et suivies distinctement des mises à jour algorithmiques principales. L’update antispam de Google de décembre 2024, par exemple, a été déployée à l’échelle mondiale sur toutes les langues et a pris jusqu’à une semaine pour être totalement effective, illustrant l’ampleur et la fréquence des efforts de lutte contre le spam. Cette course technologique permanente entre spammeurs et moteurs consomme des ressources informatiques et humaines considérables qui pourraient autrement améliorer la qualité des recherches.

Les sites pratiquant le spam risquent un large éventail de sanctions, de la pénalité algorithmique aux actions manuelles, jusqu’à la désindexation totale. Les actions manuelles sont la réponse la plus directe de Google : des examinateurs identifient les violations et appliquent des sanctions spécifiques via Google Search Console. Ces actions informent les propriétaires des violations précises—liens non naturels, bourrage de mots-clés, cloaking—et entraînent généralement de fortes chutes de classement ou la suppression des résultats. Les pénalités algorithmiques interviennent lorsque les systèmes automatisés de Google détectent des schémas de spam et réduisent la visibilité d’un site sans intervention humaine. Ces sanctions peuvent être temporaires, le temps que le spam soit supprimé et le site recrawlé, ou permanentes si les violations sont graves ou répétées. Dans les cas extrêmes, les sites sont totalement désindexés, c’est-à-dire qu’ils n’apparaissent plus du tout sur Google, perdant toute visibilité organique. La récupération après une action manuelle nécessite une remise en conformité complète, une documentation détaillée des changements et une demande de réexamen via Search Console. Toutefois, même en cas de récupération, les avantages de classement obtenus via des liens spammy sont définitivement perdus.

L’émergence de systèmes de recherche alimentés par l’IA tels que ChatGPT, Perplexity, Google AI Overviews ou Claude ajoute une nouvelle dimension au problème du spam. Ces systèmes s’appuient sur le contenu du web pour générer leurs réponses, les rendant vulnérables au spam et aux contenus de faible qualité pouvant influencer leurs résultats. Contrairement aux moteurs classiques qui affichent une liste ordonnée, les IA synthétisent l’information en langage naturel, ce qui peut amplifier l’impact du spam si celui-ci pollue les données d’entraînement ou les mécanismes de recherche. Des organisations comme AmICited se sont créées pour répondre à ce défi, en proposant des plateformes de surveillance de prompts IA permettant de suivre où les marques et domaines apparaissent dans les réponses générées. Cette capacité est cruciale, car la présence de contenu spammy dans les réponses IA peut nuire à la réputation et la visibilité d’une marque d’une manière différente des résultats traditionnels. À mesure que l’IA s’impose dans la découverte d’informations, la surveillance et la prévention du spam dans ces nouveaux paradigmes de recherche deviennent essentielles. Le défi pour les systèmes IA est de distinguer les sources d’autorité du contenu spammy lors de la sélection des informations à intégrer dans leurs réponses.

Les organisations souhaitant une visibilité durable doivent mettre en place des stratégies intégrales pour éviter le spam et rester conformes aux directives des moteurs. La stratégie de contenu doit privilégier la création de contenus originaux, de haute qualité, centrés sur l’utilisateur, intégrant naturellement les mots-clés sans répétition ni manipulation artificielle. Les actions de netlinking doivent viser l’obtention de liens naturels grâce à la qualité du contenu, aux relations sectorielles et à une prospection légitime, plutôt qu’à l’achat ou la participation à des schémas de liens. Le SEO technique doit reposer sur un HTML propre, des balises meta correctes, la mise en œuvre de données structurées et des redirections transparentes, identiques pour moteurs et utilisateurs. Des audits réguliers du contenu, des liens et des aspects techniques du site aident à identifier les risques de spam en amont. Les outils de surveillance permettent de suivre les classements, les profils de liens et la visibilité pour détecter toute anomalie indiquant un problème de spam ou une attaque concurrentielle. L’optimisation de l’expérience utilisateur garantit que le contenu profite d’abord à l’humain, l’optimisation pour les moteurs restant secondaire. Les organisations doivent également établir des politiques internes claires interdisant le spam et sensibiliser leurs équipes aux risques et conséquences de telles pratiques.

L’avenir de la détection du spam reposera de plus en plus sur des systèmes d’intelligence artificielle et de machine learning capables d’identifier en temps réel des manipulations sophistiquées. SpamBrain et des systèmes similaires continueront d’évoluer pour repérer de nouveaux types de spam plus rapidement que les spammeurs ne peuvent les inventer, accélérant la course entre détection et contournement. L’intégration des systèmes de recherche IA dans les usages courants imposera de nouvelles approches de détection adaptées à la façon dont ces outils récupèrent et synthétisent l’information. Les moteurs de recherche mettront sans doute en œuvre des analyses comportementales plus poussées pour repérer le spam sur la base des interactions réelles des utilisateurs, et non plus seulement sur des signaux purement techniques. La surveillance multiplateforme deviendra cruciale à mesure que les spammeurs cibleront simultanément moteurs traditionnels, IA conversationnelles et nouveaux paradigmes de recherche. L’essor du contenu généré par l’IA crée de nouveaux défis, les systèmes automatisés pouvant produire en masse du contenu plausible mais médiocre ou trompeur. Des organisations telles qu’AmICited joueront un rôle croissant pour aider les marques à surveiller leur visibilité sur des systèmes diversifiés et détecter les menaces de spam avant qu’elles n’affectent leur visibilité. Au final, la prévention la plus efficace combinera détection algorithmique avancée, expertise humaine, retours utilisateurs et collaboration sectorielle pour préserver la qualité de la recherche et la confiance des utilisateurs.

Le spam des moteurs de recherche enfreint les directives des moteurs de recherche et utilise des tactiques trompeuses pour manipuler les classements, tandis que le SEO légitime suit des pratiques éthiques (white hat) qui apportent une réelle valeur aux utilisateurs. Le SEO légitime se concentre sur la création de contenu de qualité, l’obtention de liens naturels et l’amélioration de l’expérience utilisateur, alors que des tactiques de spam comme le bourrage de mots-clés et le cloaking tentent de tromper les algorithmes. Les directives de Google interdisent explicitement les tactiques de spam, et les sites qui les utilisent risquent des pénalités manuelles ou une désindexation complète des résultats de recherche.

Google utilise **SpamBrain**, un système de prévention du spam basé sur l’IA qui surveille en continu les sites web pour détecter les violations des politiques antispam. SpamBrain emploie des algorithmes d’apprentissage automatique pour identifier les schémas associés au spam, y compris les profils de liens non naturels, le bourrage de mots-clés, le cloaking et d’autres techniques trompeuses. Le système analyse à la fois des facteurs on-page et off-page, les signaux de comportement des utilisateurs et les métriques de qualité du contenu pour distinguer le contenu légitime du spam. Google effectue également des examens manuels et reçoit des signalements via Search Console pour identifier et sanctionner les sites spammés.

Les principales tactiques de spam des moteurs de recherche incluent le **bourrage de mots-clés** (surcharge des pages avec des mots-clés), le **cloaking** (affichage de contenus différents aux moteurs de recherche et aux utilisateurs), les **redirections sournoises** (rediriger les utilisateurs vers d’autres pages que celles vues par les moteurs), les **fermes de liens** (réseaux de sites de faible qualité créés uniquement pour les liens), le **texte et les liens cachés** (contenus invisibles pour les utilisateurs mais visibles pour les crawlers), et le **spam de commentaires** (spam automatisé posté dans les commentaires et forums). Chaque tactique tente de manipuler les algorithmes par la tromperie plutôt que d’apporter une réelle valeur à l’utilisateur.

Google impose plusieurs sanctions pour le spam des moteurs de recherche, allant de la baisse de classement à la désindexation complète. Les sites peuvent recevoir des **actions manuelles** via Google Search Console indiquant des violations spécifiques, ou être affectés par des mises à jour algorithmiques antispam qui réduisent automatiquement leur visibilité. Dans les cas graves, les sites peuvent être complètement retirés de l’index Google, les rendant invisibles dans les résultats de recherche. La récupération nécessite d’identifier et de supprimer tous les éléments de spam, puis de demander un réexamen via Search Console. Ce processus peut prendre des mois, et certains avantages de classement perdus à cause de liens spammy ne peuvent pas être retrouvés.

Le spam des moteurs de recherche pose d’importants défis pour les systèmes de recherche alimentés par l’IA tels que **ChatGPT**, **Perplexity** et **Google AI Overviews**. Ces systèmes s’appuient sur le contenu web pour générer des réponses, et le contenu spammy peut polluer leurs données d’entraînement ou influencer leurs résultats. Des plateformes comme AmICited surveillent où les marques et domaines apparaissent dans les réponses IA, aidant les organisations à suivre si du spam ou du contenu de faible qualité affecte leur visibilité. À mesure que les systèmes d’IA se généralisent, la détection du spam devient de plus en plus cruciale pour assurer la fiabilité des informations fournies aux utilisateurs.

Oui, les sites web peuvent se remettre de sanctions pour spam, mais cela nécessite une remise à niveau complète. Les propriétaires doivent identifier tous les éléments de spam—including bourrage de mots-clés, liens non naturels, cloaking et contenu caché—et les supprimer totalement. Après le nettoyage, ils doivent soumettre une demande de réexamen via Google Search Console avec une documentation détaillée des changements. La récupération prend généralement plusieurs mois, le temps que Google recrawle et réévalue le site. Cependant, les avantages de classement précédemment obtenus par des liens spammy ne peuvent pas être récupérés, et les sites doivent se concentrer sur la construction d’une autorité légitime via du contenu de qualité et des liens naturels.

Surveiller le spam des moteurs de recherche est crucial car le contenu spammy peut nuire à la réputation et à la visibilité d’une marque sur les plateformes de recherche. Des concurrents peuvent utiliser des tactiques de spam ciblant votre marque, ou votre propre site peut être compromis et utilisé pour du spam. Des outils comme **AmICited** aident les organisations à suivre leurs mentions de marque sur les systèmes de recherche IA et les moteurs de recherche traditionnels, identifiant si du spam ou du contenu de faible qualité apparaît à la place d’informations légitimes sur la marque. Cette surveillance permet une détection proactive des problèmes de spam et aide à préserver l’intégrité de la marque dans les résultats de recherche et les réponses générées par l’IA.

Commencez à suivre comment les chatbots IA mentionnent votre marque sur ChatGPT, Perplexity et d'autres plateformes. Obtenez des informations exploitables pour améliorer votre présence IA.

La détection du spam identifie les contenus indésirables et manipulateurs à l'aide d'algorithmes de ML et d'analyses comportementales. Découvrez comment les sys...

Le cloaking est une technique SEO black-hat qui montre un contenu différent aux moteurs de recherche et aux utilisateurs. Découvrez son fonctionnement, ses risq...

Découvrez ce qu'est le bourrage de mots-clés et comment les systèmes d'IA comme ChatGPT et Perplexity le détectent. Comprenez les méthodes de détection de l'IA ...