Spam des moteurs de recherche

Découvrez ce qu’est le spam des moteurs de recherche, y compris les tactiques de référencement black hat comme le bourrage de mots-clés, le cloaking et les ferm...

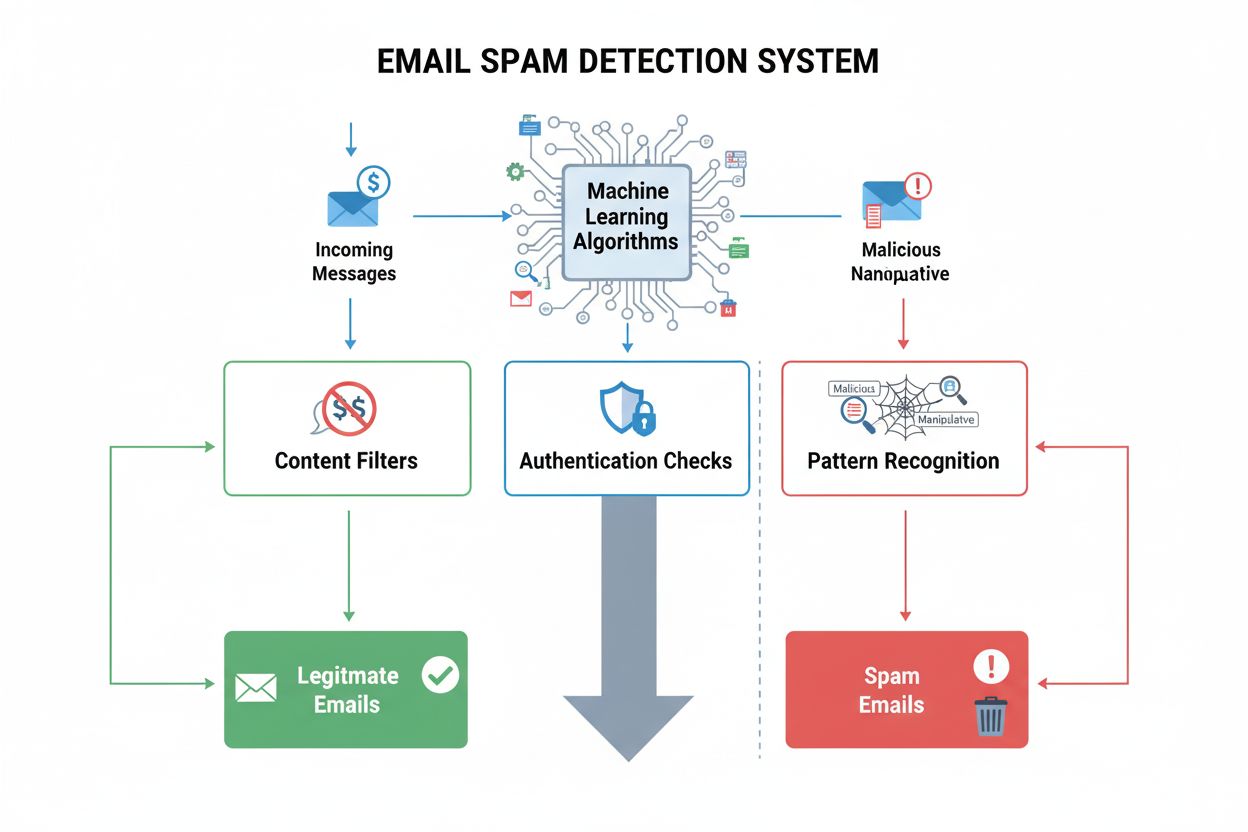

La détection du spam est le processus automatisé d’identification et de filtrage des contenus indésirables, non sollicités ou manipulateurs—including emails, messages, and social media posts—en utilisant des algorithmes d’apprentissage automatique, l’analyse de contenu et des signaux comportementaux pour protéger les utilisateurs et maintenir l’intégrité des plateformes.

La détection du spam est le processus automatisé d'identification et de filtrage des contenus indésirables, non sollicités ou manipulateurs—including emails, messages, and social media posts—en utilisant des algorithmes d'apprentissage automatique, l'analyse de contenu et des signaux comportementaux pour protéger les utilisateurs et maintenir l'intégrité des plateformes.

La détection du spam est le processus automatisé d’identification et de filtrage des contenus indésirables, non sollicités ou manipulateurs—including emails, messages, social media posts, and AI-generated responses—en utilisant des algorithmes d’apprentissage automatique, l’analyse de contenu, des signaux comportementaux et des protocoles d’authentification. Le terme englobe à la fois les mécanismes techniques qui identifient les spams et la pratique plus large de la protection des utilisateurs contre les communications trompeuses, malveillantes ou répétitives. Dans le contexte des systèmes d’IA modernes et des plateformes numériques, la détection du spam sert de rempart essentiel contre les attaques de phishing, les fraudes, l’usurpation de marque et les comportements inauthentiques coordonnés. La définition s’étend au-delà du simple filtrage des emails pour inclure la détection de contenus manipulateurs sur les réseaux sociaux, les plateformes d’avis, les chatbots IA et les résultats de recherche, où des acteurs malveillants tentent d’augmenter artificiellement la visibilité, de manipuler l’opinion publique ou de tromper les utilisateurs par des pratiques trompeuses.

L’histoire de la détection du spam suit l’évolution de la communication numérique elle-même. Aux débuts de l’email, le spam était principalement identifié par de simples systèmes à base de règles qui signalaient les messages contenant certains mots-clés ou adresses d’expéditeur. Les travaux fondateurs de Paul Graham en 2002, “A Plan for Spam”, ont introduit le filtrage bayésien à la sécurité des emails, révolutionnant le domaine en permettant aux systèmes d’apprendre par l’exemple plutôt qu’en se basant sur des règles prédéfinies. Cette approche statistique a considérablement amélioré la précision et l’adaptabilité, permettant aux filtres d’évoluer au gré des tactiques des spammeurs. Dès le milieu des années 2000, les techniques de machine learning comme les classificateurs bayésiens naïfs, les arbres de décision et les machines à vecteurs de support sont devenues la norme dans les systèmes de messagerie d’entreprise. L’émergence des réseaux sociaux a introduit de nouveaux défis—comportements inauthentiques coordonnés, réseaux de bots, faux avis—nécessitant des systèmes capables d’analyser les réseaux et les comportements utilisateurs au-delà du simple contenu du message. Aujourd’hui, la détection du spam intègre des modèles de deep learning, des architectures de transformateurs et une analyse comportementale en temps réel, atteignant 95 à 98 % de précision dans le filtrage des emails tout en s’attaquant aux menaces émergentes telles que le phishing généré par l’IA (en hausse de 466 % au T1 2025) et la manipulation par deepfake.

Les systèmes de détection du spam fonctionnent par couches complémentaires qui évaluent simultanément le contenu entrant sur différents axes. La première couche concerne la vérification de l’authentification, où les systèmes contrôlent les enregistrements SPF (Sender Policy Framework) pour confirmer les serveurs d’envoi autorisés, valident les signatures cryptographiques DKIM (DomainKeys Identified Mail) pour garantir l’intégrité du message et appliquent les politiques DMARC (Domain-based Message Authentication, Reporting, and Conformance) pour indiquer aux serveurs destinataires comment traiter les échecs d’authentification. L’application obligatoire de l’authentification pour les expéditeurs en masse dépassant 5 000 emails quotidiens par Microsoft en mai 2025, avec le code d’erreur SMTP “550 5.7.515 Access denied” pour les non-conformes, signifie l’échec total de la livraison plutôt qu’un simple placement en spam. La seconde couche est l’analyse de contenu, où les systèmes examinent le texte du message, les objets, la mise en forme HTML et les liens intégrés à la recherche de caractéristiques associées au spam. Les filtres modernes ne se contentent plus de la recherche de mots-clés (inefficace face à l’adaptation du langage par les spammeurs), mais analysent les modèles linguistiques, les ratios image/texte, la densité d’URL et les anomalies structurelles. La troisième couche applique l’inspection des en-têtes, examinant les informations de routage, les détails d’authentification de l’expéditeur et les enregistrements DNS pour déceler des incohérences suggérant un spoofing ou une infrastructure compromise. La quatrième couche évalue la réputation de l’expéditeur en croisant les domaines et IP avec des listes noires, en analysant les historiques d’envoi et en mesurant l’engagement des campagnes précédentes.

| Méthode de détection | Fonctionnement | Taux de précision | Cas d’usage principal | Points forts | Limites |

|---|---|---|---|---|---|

| Filtrage par règles | Applique des critères prédéfinis (mots-clés, adresses expéditeur, types de pièces jointes) | 60-75 % | Systèmes anciens, simples listes de blocage | Rapide, transparent, facile à mettre en œuvre | Ne s’adapte pas aux nouvelles tactiques, fort taux de faux positifs |

| Filtrage bayésien | Utilise l’analyse de probabilité statistique des fréquences de mots entre spam et emails légitimes | 85-92 % | Systèmes email, filtres personnels | Apprend du retour utilisateur, s’adapte dans le temps | Nécessite des données d’apprentissage, inefficace contre les attaques nouvelles |

| Machine learning (Naive Bayes, SVM, Random Forests) | Analyse des vecteurs de caractéristiques (métadonnées, contenu, engagement) | 92-96 % | Email d’entreprise, réseaux sociaux | Gère des modèles complexes, réduit les faux positifs | Nécessite des données labellisées, coûteux en calcul |

| Deep learning (LSTM, CNN, Transformers) | Traite les données séquentielles et le contexte via des réseaux neuronaux | 95-98 % | Systèmes email avancés, plateformes IA | Précision maximale, détecte les manipulations sophistiquées | Exige de gros jeux de données, décisions difficiles à interpréter |

| Analyse comportementale en temps réel | Surveille dynamiquement les interactions, l’engagement et les réseaux utilisateurs | 90-97 % | Réseaux sociaux, détection de fraudes | Détecte attaques coordonnées, s’adapte aux préférences | Problèmes de vie privée, surveillance continue nécessaire |

| Méthodes d’ensemble | Combine plusieurs algorithmes (vote, stacking) pour tirer parti des forces de chacun | 96-99 % | Gmail, systèmes d’entreprise | Fiabilité maximale, équilibre précision/rappel | Mise en œuvre complexe, gourmand en ressources |

La base technique de la détection du spam moderne repose sur des algorithmes d’apprentissage supervisé qui classent les messages en spam ou légitimes à partir de données labellisées. Les classificateurs bayésiens naïfs calculent la probabilité qu’un email soit du spam selon la fréquence des mots—certains mots apparaissant plus souvent dans les spams augmentent le score de probabilité. Cette approche reste populaire car efficace, interprétable et performante malgré ses hypothèses simplistes. Les machines à vecteurs de support (SVM) créent des hyperplans en espace de caractéristiques pour séparer spam et messages légitimes, excellant dans la gestion des relations complexes et non linéaires. Les random forests génèrent plusieurs arbres de décision pour agréger leurs prédictions, limitant le surapprentissage et résistant mieux aux manipulations adverses. Plus récemment, les réseaux LSTM (Long Short-Term Memory) et autres réseaux récurrents surpassent les précédents en analysant les séquences de texte—comprenant que certaines suites de mots signalent mieux le spam que les mots isolés. Les modèles de transformateurs, qui alimentent GPT et BERT, révolutionnent la détection du spam en capturant le contexte sur l’ensemble du message, permettant de repérer des manipulations sophistiquées échappant aux algorithmes simples. La recherche indique que les systèmes basés LSTM atteignent 98 % de précision sur des benchmarks, bien que la performance réelle dépende de la qualité des données, de l’entraînement du modèle et de la sophistication des attaques.

Le contenu manipulateur recouvre un vaste éventail de pratiques conçues pour tromper les utilisateurs, gonfler artificiellement la visibilité ou nuire à la réputation. Les attaques de phishing usurpent l’identité d’organisations pour voler des identifiants ou de l’argent, le phishing propulsé par l’IA ayant augmenté de 466 % au T1 2025 à mesure que l’IA générative efface les fautes qui trahissaient auparavant la malveillance. Les comportements inauthentiques coordonnés impliquent des réseaux de faux comptes ou bots gonflant l’engagement et créant une fausse impression de consensus. Les deepfakes utilisent l’IA générative pour produire des images, vidéos ou audios trompeurs pouvant nuire à une marque ou diffuser de la désinformation. Les faux avis gonflent ou réduisent artificiellement les notes produits, manipulant la perception des consommateurs et sapant la confiance. Le spam de commentaires inonde les publications de messages hors-sujet, liens promotionnels ou contenus malveillants, détournant l’attention des discussions légitimes. L’usurpation d’email forge des adresses d’expéditeur pour imiter des organisations de confiance et livrer des charges malicieuses. Le credential stuffing utilise des outils automatisés pour tester des couples identifiant/mot de passe volés sur diverses plateformes, compromettant les comptes et facilitant la manipulation. Les systèmes modernes de détection du spam doivent repérer ces tactiques variées par l’analyse comportementale, la reconnaissance de schémas réseau et la vérification d’authenticité des contenus—défi croissant à mesure que les attaquants déploient des techniques IA sophistiquées.

Selon la plateforme, la détection du spam varie en sophistication et en adaptation aux menaces et publics visés. Gmail utilise des méthodes d’ensemble combinant règles, filtrage bayésien, classificateurs ML et analyse comportementale, bloquant 99,9 % des spams avant la boîte de réception et maintenant un taux de faux positifs inférieur à 0,1 %. Le système traite plus de 100 millions d’emails par jour, adaptant ses modèles en continu grâce aux retours utilisateurs (signalement de spam ou non). Microsoft Outlook propose un filtrage multi-couche incluant authentification, analyse de contenu, réputation d’expéditeur et modèles ML entraînés sur des milliards d’emails. Perplexity et autres plateformes de recherche IA doivent détecter le contenu manipulateur dans les réponses générées par IA, incluant l’injection de prompt, les citations hallucinéess et les tentatives coordonnées d’augmenter les mentions de marque. ChatGPT et Claude mettent en place des systèmes de modération qui filtrent les requêtes nuisibles, détectent les contournements des règles de sécurité et identifient les prompts manipulateurs générant de fausses informations. Les réseaux sociaux comme Facebook et Instagram utilisent des filtres IA de commentaires pour supprimer automatiquement discours haineux, arnaques, bots, tentatives de phishing et spam dans les commentaires. AmICited, en tant que plateforme de surveillance des prompts IA, doit distinguer les citations de marque authentiques du spam et du contenu manipulateur sur ces systèmes, nécessitant des algorithmes sophistiqués capables de comprendre le contexte, l’intention et l’authenticité selon les formats propres à chaque plateforme.

L’évaluation d’un système de détection du spam requiert la compréhension de plusieurs indicateurs. La précision mesure le pourcentage de classifications correctes (vrais positifs et vrais négatifs), mais ce chiffre peut être trompeur si le spam est minoritaire (un système qui marque tout comme légitime aurait une forte précision si seulement 10 % des messages sont du spam). La précision (precision) mesure le pourcentage des messages marqués comme spam qui le sont réellement, ciblant directement le taux de faux positifs qui nuisent à l’expérience utilisateur. Le rappel (recall) mesure la part de spam effectivement détectée, s’attaquant aux faux négatifs où le contenu nuisible passe. Le F1-score équilibre précision et rappel en une seule métrique. En détection du spam, la précision est généralement priorisée car les faux positifs (emails légitimes en spam) nuisent plus que les faux négatifs (spam qui passe), le blocage de communications business légitimes minant la confiance. Les systèmes modernes affichent 95-98 % de précision, 92-96 % de taux de précision, 90-95 % de rappel sur des benchmarks, même si la réalité dépend des données, de l’entraînement et de la sophistication adverse. Les taux de faux positifs dans les emails d’entreprise varient de 0,1 à 0,5 %, soit 1 à 5 messages légitimes filtrés sur 1 000 envoyés. Selon EmailWarmup, un placement moyen de 83,1 % en boîte de réception chez les principaux fournisseurs signifie qu’un email sur six échoue totalement, avec 10,5 % en spam et 6,4 % qui disparaissent—soulignant la difficulté de concilier sécurité et délivrabilité.

L’avenir de la détection du spam sera marqué par la course entre attaques de plus en plus sophistiquées et défenses avancées. Les attaques IA évoluent vite—le phishing généré par IA a crû de 466 % au T1 2025, éliminant les maladresses linguistiques qui trahissaient le spam. Les systèmes devront donc aller au-delà de la reconnaissance de modèles vers la compréhension de l’intention, du contexte et de l’authenticité. La détection des deepfakes deviendra cruciale à mesure que l’IA génère images, vidéos et sons faux—les systèmes devront analyser incohérences visuelles, artefacts audio et comportements suspects pour déceler l’artificiel. La biométrie comportementale jouera un rôle croissant, analysant les interactions (frappes clavier, mouvements souris, timing) pour distinguer humains, bots et comptes compromis. L’apprentissage fédéré permettra d’améliorer collectivement la détection sans partager de données sensibles, répondant aux préoccupations de vie privée tout en tirant parti de l’intelligence collective. Le partage d’intelligence sur les menaces en temps réel accélérera la réponse face aux nouvelles attaques, les plateformes diffusant rapidement l’information sur les vecteurs et tactiques émergents. Les cadres réglementaires (RGPD, CAN-SPAM, réglementations IA à venir) façonneront les systèmes, exigeant transparence, explicabilité et contrôle utilisateur sur le filtrage. Pour des plateformes comme AmICited surveillant les mentions de marque dans les systèmes IA, le défi s’intensifiera avec les techniques de manipulation sophistiquées visant à influencer les réponses IA, exigeant une évolution constante des algorithmes pour distinguer citations authentiques et manipulations coordonnées. La convergence entre progrès IA, pression réglementaire et sophistication adverse implique que la détection du spam future reposera sur une collaboration humain-IA, où l’automatisation gère le volume et la reconnaissance de motifs tandis que les experts humains traitent les cas limites, menaces inédites et questions éthiques que les algorithmes seuls ne sauraient résoudre.

La détection du spam identifie spécifiquement les messages non sollicités, répétitifs ou manipulateurs à l'aide d'algorithmes automatisés et de la reconnaissance de modèles, tandis que la modération de contenu est la pratique plus large de l'examen et de la gestion du contenu généré par les utilisateurs pour détecter les violations de politiques, les contenus nuisibles et le respect des standards communautaires. La détection du spam se concentre sur le volume, la réputation de l’expéditeur et les caractéristiques du message, alors que la modération de contenu traite du contexte, de l’intention et de la conformité aux politiques de la plateforme. Les deux systèmes fonctionnent souvent ensemble sur les plateformes modernes pour maintenir la sécurité des utilisateurs et la qualité de l'expérience.

Les systèmes modernes de détection du spam atteignent des taux de précision de 95 à 98 % grâce à des modèles avancés de machine learning comme les LSTM (Long Short-Term Memory) et des méthodes d'ensemble combinant plusieurs algorithmes. Cependant, la précision varie selon les plateformes et les implémentations—Gmail signale que 99,9 % des spams sont bloqués avant d’atteindre les boîtes de réception, tandis que les taux de faux positifs (emails légitimes marqués comme spam) se situent généralement entre 0,1 et 0,5 %. Le défi consiste à équilibrer la précision (éviter les faux positifs) et le rappel (capturer tout le spam), car manquer du spam est souvent considéré comme moins nuisible que de bloquer des messages légitimes.

Les systèmes d'IA analysent des modèles, des contextes et des relations qui peuvent échapper aux humains, permettant la détection de tactiques de manipulation sophistiquées telles que les comportements inauthentiques coordonnés, les deepfakes et le phishing généré par l'IA. Les modèles de machine learning entraînés sur des millions d’exemples peuvent identifier des modèles linguistiques subtils, des anomalies comportementales et des structures de réseau indicatives de manipulation. Cependant, les attaques alimentées par l’IA ont également évolué—le phishing généré par l’IA a augmenté de 466 % au premier trimestre 2025—nécessitant des mises à jour continues des modèles et des tests adverses pour rester efficaces face aux nouvelles menaces.

Les filtres anti-spam équilibrent la précision (minimiser les faux positifs où les emails légitimes sont bloqués) et le rappel (capturer tout le spam réel). La plupart des systèmes privilégient la précision car le blocage des emails légitimes nuit davantage à la confiance des utilisateurs que le fait de laisser passer un peu de spam. Les filtres bayésiens apprennent des retours des utilisateurs—lorsque les destinataires marquent des emails filtrés comme « non spam », les systèmes ajustent les seuils. Les systèmes d’entreprise mettent souvent en place des zones de quarantaine où les emails suspects sont retenus pour un examen administrateur plutôt que supprimés, ce qui permet de récupérer les messages légitimes tout en maintenant la sécurité.

La détection du spam utilise de multiples techniques complémentaires : les systèmes à base de règles appliquent des critères prédéfinis, les filtres bayésiens utilisent l’analyse statistique de probabilités, les algorithmes de machine learning identifient des modèles complexes, et l’analyse en temps réel inspecte dynamiquement les URL et pièces jointes. Les filtres de contenu examinent le texte et la mise en forme du message, les filtres d’en-tête analysent les informations de routage et l’authentification, les filtres de réputation vérifient l’historique de l’expéditeur sur des listes noires, et les filtres comportementaux surveillent les modèles d’engagement des utilisateurs. Les systèmes modernes superposent ces techniques simultanément—un message peut passer les contrôles de contenu mais échouer l'authentification, nécessitant une évaluation globale sur toutes les dimensions.

Pour les plateformes de surveillance d’IA qui suivent les mentions de marque sur ChatGPT, Perplexity, Google AI Overviews et Claude, la détection du spam permet de distinguer les citations de marque légitimes du contenu manipulateur, des faux avis et des comportements inauthentiques coordonnés. Une détection efficace du spam garantit que les données de surveillance reflètent de véritables interactions utilisateurs plutôt que du bruit généré par des bots ou des manipulations adverses. Ceci est essentiel pour une évaluation précise de la réputation de la marque, car le spam et le contenu manipulateur peuvent artificiellement gonfler ou réduire les métriques de visibilité, entraînant des décisions stratégiques erronées.

Les faux positifs dans la détection du spam engendrent des coûts importants pour les entreprises et l’expérience utilisateur : les emails marketing légitimes n’atteignent pas les clients, ce qui réduit les taux de conversion et les revenus ; des messages transactionnels importants (réinitialisations de mot de passe, confirmations de commande) peuvent être manqués, générant de la frustration ; et la réputation de l’expéditeur se détériore avec l’augmentation des réclamations. Des études montrent qu’un placement moyen de 83,1 % en boîte de réception signifie qu’un email sur six échoue totalement, les faux positifs contribuant largement à cette perte. Pour les entreprises, même un taux de faux positifs de 1 % sur des millions d’emails représente des milliers d’opportunités manquées et des relations clients détériorées.

Commencez à suivre comment les chatbots IA mentionnent votre marque sur ChatGPT, Perplexity et d'autres plateformes. Obtenez des informations exploitables pour améliorer votre présence IA.

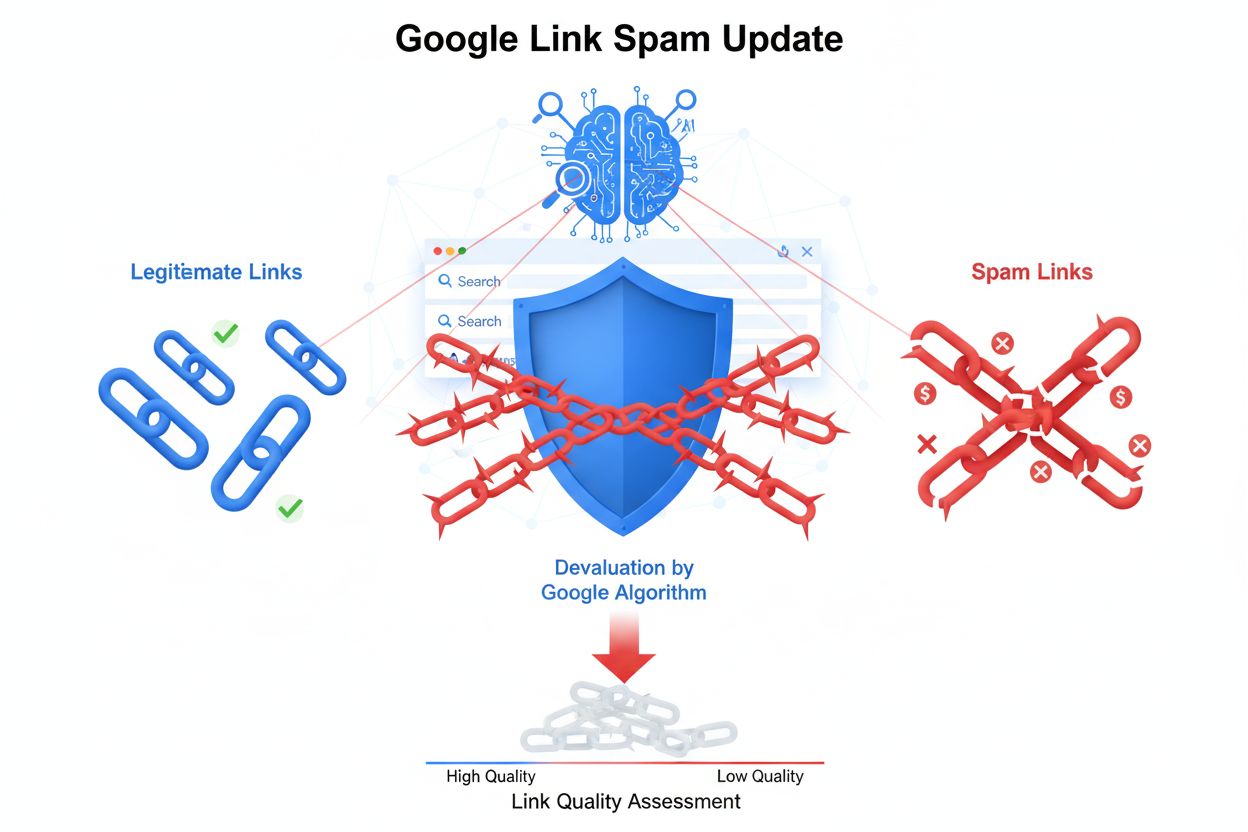

Découvrez ce qu’est le spam des moteurs de recherche, y compris les tactiques de référencement black hat comme le bourrage de mots-clés, le cloaking et les ferm...

Découvrez ce qu'est la détection de contenu par l'IA, comment fonctionnent les outils de détection grâce à l'apprentissage automatique et au traitement du langa...

Découvrez la mise à jour contre le spam de liens de Google qui dévalorise les backlinks manipulateurs. Comprenez comment SpamBrain détecte le spam de liens, ses...