SEO de contenu

Le SEO de contenu est la création stratégique et l’optimisation de contenus de haute qualité pour améliorer les classements dans les moteurs de recherche et la ...

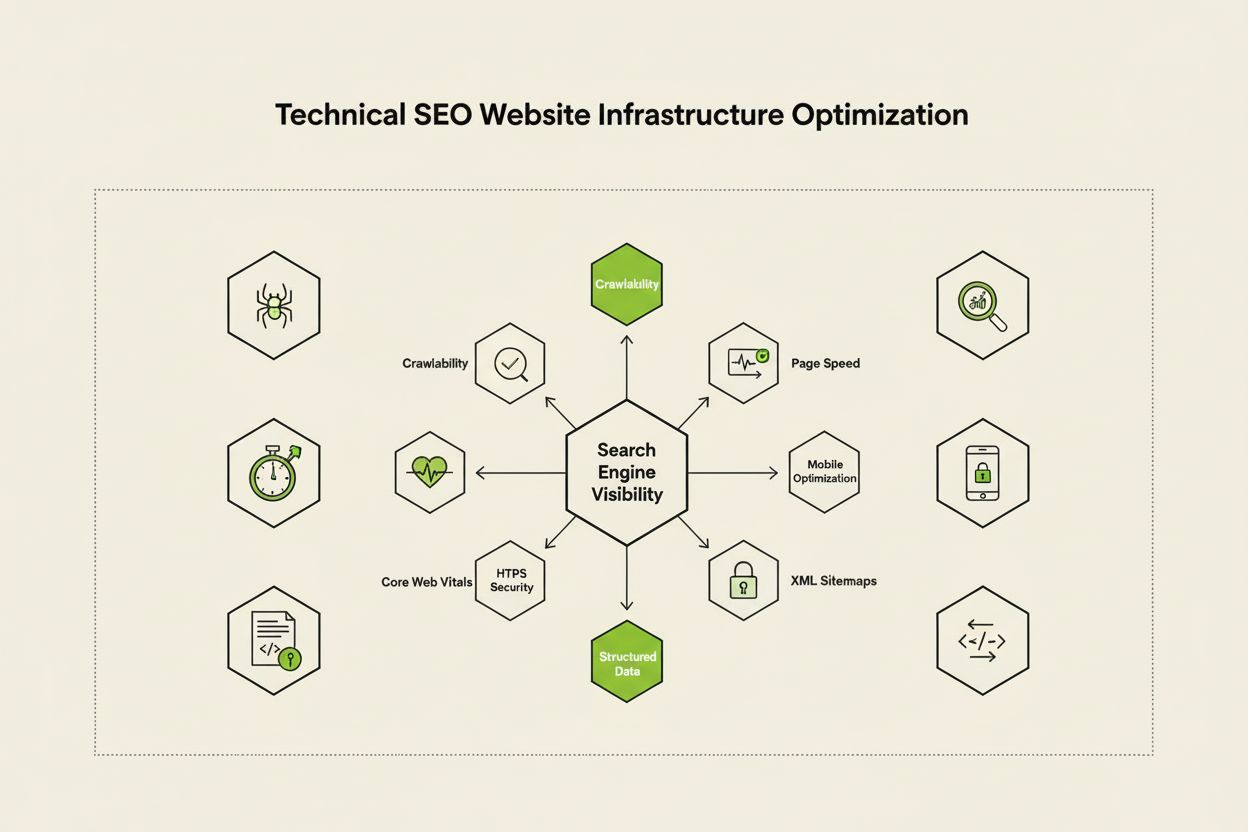

Le SEO technique est le processus d’optimisation de l’infrastructure d’un site web afin que les moteurs de recherche puissent explorer, rendre, indexer et diffuser le contenu correctement et efficacement. Cela inclut la vitesse du site, la compatibilité mobile, l’architecture du site, la sécurité et la mise en œuvre de données structurées pour garantir que les moteurs de recherche puissent découvrir et classer vos pages.

Le SEO technique est le processus d’optimisation de l’infrastructure d’un site web afin que les moteurs de recherche puissent explorer, rendre, indexer et diffuser le contenu correctement et efficacement. Cela inclut la vitesse du site, la compatibilité mobile, l’architecture du site, la sécurité et la mise en œuvre de données structurées pour garantir que les moteurs de recherche puissent découvrir et classer vos pages.

Le SEO technique est le processus d’optimisation de l’infrastructure backend d’un site web afin de garantir que les moteurs de recherche puissent explorer, rendre, indexer et diffuser efficacement le contenu. Contrairement au SEO on-page, qui se concentre sur la qualité du contenu et l’optimisation des mots-clés, le SEO technique traite les éléments fondamentaux qui déterminent si les moteurs de recherche peuvent même accéder à votre site et le comprendre. Cela inclut la vitesse du site, la compatibilité mobile, l’architecture du site, les protocoles de sécurité, la mise en œuvre de données structurées et les facteurs liés à l’explorabilité. Le SEO technique agit comme la fondation invisible sur laquelle reposent toutes les autres actions SEO—sans lui, même le meilleur contenu reste invisible pour les moteurs de recherche et les utilisateurs. Selon les recherches du secteur, 91 % des marketeurs ont déclaré que le SEO avait amélioré les performances de leur site en 2024, l’optimisation technique jouant un rôle crucial dans l’obtention de résultats mesurables. L’importance du SEO technique s’est intensifiée à mesure que les moteurs de recherche deviennent plus sophistiqués et que les plateformes de recherche pilotées par l’IA apparaissent, obligeant les sites à respecter des standards techniques toujours plus exigeants pour être visibles.

Le SEO technique repose sur quatre piliers interconnectés qui fonctionnent ensemble pour maximiser la visibilité dans les moteurs de recherche. L’explorabilité détermine si Googlebot et les autres robots d’exploration peuvent accéder aux pages de votre site via les liens, les sitemaps et la navigation interne. L’indexabilité garantit que les pages explorées sont réellement stockées dans l’index de Google et éligibles à l’affichage dans les résultats de recherche. La performance et les Core Web Vitals mesurent la rapidité de chargement des pages et leur réactivité aux interactions utilisateurs—des facteurs qui influencent directement le classement et l’expérience utilisateur. L’optimisation mobile garantit le bon fonctionnement de votre site sur smartphones et tablettes, qui représentent désormais plus de 60 % du trafic de recherche selon les recherches Sistrix. Ces quatre piliers sont interdépendants ; une faiblesse dans un domaine peut saper l’efficacité des autres. Par exemple, un site de bureau rapide mais peu performant sur mobile aura du mal à se classer dans l’index mobile-first de Google, même si son explorabilité est optimale. Comprendre la façon dont ces piliers interagissent est essentiel pour élaborer une stratégie de SEO technique globale couvrant tous les aspects de la visibilité dans la recherche.

Bien qu’elles soient souvent confondues, l’explorabilité et l’indexabilité représentent deux étapes distinctes du pipeline de recherche. L’explorabilité désigne la capacité d’un moteur de recherche à découvrir et accéder aux pages de votre site en suivant les liens internes, les backlinks externes et les sitemaps XML. Elle répond à la question : « Googlebot peut-il atteindre cette page ? » Si une page n’est pas explorable—par exemple parce qu’elle est bloquée par robots.txt, cachée derrière du JavaScript ou orpheline sans liens internes—elle ne peut pas passer à l’indexation. L’indexabilité, à l’inverse, détermine si une page explorée est effectivement stockée dans l’index de Google et peut apparaître dans les résultats de recherche. Une page peut être parfaitement explorable mais ne pas être indexée si elle contient une balise noindex, présente du contenu dupliqué ou ne respecte pas les critères de qualité de Google. Selon le guide technique complet de Search Engine Land, comprendre cette distinction est crucial car la correction des problèmes d’explorabilité nécessite des solutions différentes de celles pour l’indexabilité. Les problèmes d’explorabilité concernent généralement la structure du site, la configuration du robots.txt et le maillage interne, tandis que les problèmes d’indexabilité sont souvent liés aux balises méta, aux balises canoniques, à la qualité du contenu et aux problèmes de rendu. Les deux doivent être traités pour une visibilité optimale dans la recherche.

Les Core Web Vitals sont trois indicateurs spécifiques utilisés par Google pour mesurer l’expérience utilisateur réelle et qui influencent directement le classement. Largest Contentful Paint (LCP) mesure la rapidité de chargement du plus grand élément visible sur une page—Google recommande un LCP de 2,5 secondes ou moins. Interaction to Next Paint (INP), qui a remplacé First Input Delay en 2024, mesure la réactivité d’une page aux interactions des utilisateurs telles que les clics et les appuis—l’objectif est de rester sous 200 millisecondes. Cumulative Layout Shift (CLS) mesure la stabilité visuelle en suivant les changements inattendus de mise en page lors du chargement—un score inférieur à 0,1 est considéré comme bon. Les recherches de DebugBear indiquent que les sites doivent offrir à 75 % des utilisateurs une « bonne » expérience sur ces trois indicateurs pour bénéficier d’un maximum d’avantages en matière de classement. Le passage à l’INP comme facteur de classement reflète l’engagement de Google à évaluer la réactivité globale des pages tout au long de l’interaction utilisateur, et pas seulement au chargement initial. L’optimisation des Core Web Vitals nécessite une approche multifacette : améliorer le LCP passe par l’optimisation des images, l’utilisation de CDN et le report du JavaScript non critique ; améliorer l’INP nécessite de fractionner les tâches JavaScript longues et d’optimiser les gestionnaires d’événements ; réduire le CLS implique de réserver de l’espace pour le contenu dynamique et d’éviter les publicités qui déplacent la mise en page. Ces indicateurs sont devenus incontournables pour un SEO compétitif, car les pages avec de mauvais Core Web Vitals subissent des pénalités de classement et des taux de rebond plus élevés.

L’architecture du site désigne la façon dont les pages de votre site sont organisées, structurées et reliées entre elles par des liens internes. Une architecture bien pensée remplit plusieurs fonctions essentielles : elle aide les moteurs de recherche à comprendre la hiérarchie du contenu, distribue l’équité des liens (puissance de classement) sur l’ensemble du site, assure la découverte facile des pages importantes et améliore la navigation utilisateur. L’architecture idéale suit une hiérarchie claire avec la page d’accueil au sommet, les pages catégories au second niveau et les pages de contenu individuel en profondeur. La meilleure pratique veut que toutes les pages importantes soient accessibles en trois clics depuis la page d’accueil, afin que Googlebot ne gaspille pas de budget d’exploration sur des pages profondes et isolées. Le maillage interne fait office de tissu conjonctif de l’architecture, guidant utilisateurs et moteurs de recherche à travers le contenu. Un maillage stratégique consolide les signaux de classement sur les pages prioritaires, établit des liens thématiques entre contenus liés et aide les moteurs de recherche à déterminer les pages les plus importantes. Par exemple, un modèle en hub and spoke—où une page pilier complète fait des liens vers plusieurs sous-pages thématiques, qui renvoient à leur tour vers la page pilier—crée une structure puissante qui signale l’autorité thématique à Google. Une mauvaise architecture, caractérisée par des pages orphelines, une navigation incohérente et une arborescence trop profonde, pousse les moteurs de recherche à gaspiller le budget d’exploration sur du contenu moins important et rend difficile l’établissement d’une autorité thématique. Les entreprises qui restructurent leur architecture constatent souvent des améliorations spectaculaires de la vitesse d’indexation et des performances de classement.

L’indexation mobile-first signifie que Google utilise principalement la version mobile de votre site web pour l’exploration, l’indexation et le classement—et non la version bureau. Ce changement fondamental reflète le fait que plus de 60 % des recherches proviennent désormais d’appareils mobiles. Pour le SEO technique, cela implique que votre expérience mobile doit être irréprochable : design responsive qui s’adapte à toutes les tailles d’écran, navigation tactile avec un espacement adéquat entre les éléments cliquables, tailles de police lisibles sans zoom et temps de chargement rapides optimisés pour les réseaux mobiles. Le design responsive utilise des mises en page fluides et des images flexibles pour s’ajuster automatiquement à toutes les tailles d’écran, garantissant une fonctionnalité cohérente sur tous les appareils. Les erreurs courantes d’optimisation mobile incluent les interstitiels intrusifs (pop-ups) qui masquent le contenu principal, un texte trop petit pour être lu sans zoom, des boutons trop proches pour des appuis précis et des pages lentes sur les réseaux mobiles. Le test de compatibilité mobile de Google et les audits Lighthouse permettent d’identifier ces problèmes, mais des tests réels sur appareils restent essentiels. Le lien entre optimisation mobile et classement est direct : les pages avec une mauvaise expérience mobile sont pénalisées, tandis que celles optimisées pour mobile gagnent en visibilité. Pour les sites e-commerce, SaaS et les éditeurs de contenu, l’optimisation mobile n’est pas une option—c’est la base d’une visibilité compétitive.

Les sitemaps XML servent de plan pour les moteurs de recherche, listant toutes les URL que vous souhaitez voir indexées, avec des métadonnées comme la date de modification et le niveau de priorité. Un sitemap bien entretenu doit inclure uniquement des URL canoniques et indexables—en excluant les redirections, pages 404 et le contenu dupliqué. Robots.txt est un fichier texte à la racine de votre site qui dicte aux robots des moteurs de recherche quels dossiers et fichiers ils peuvent ou non explorer. Bien que robots.txt puisse bloquer l’exploration, il n’empêche pas l’indexation si la page est découverte autrement ; pour une exclusion totale, utilisez plutôt la balise meta noindex. Le budget d’exploration désigne le nombre de pages que Googlebot va explorer sur votre site dans un laps de temps donné—une ressource limitée à gérer stratégiquement. Les grands sites avec des millions de pages doivent optimiser ce budget en s’assurant que Googlebot se concentre sur le contenu à forte valeur et non sur les pages secondaires, le contenu dupliqué ou les variantes générées par la navigation à facettes. Le gaspillage de budget d’exploration provient souvent de paramètres d’URL générant des variantes à l’infini, d’environnements de préproduction exposés aux robots ou de pages à contenu faible recevant trop de liens internes. Selon les recommandations officielles de Google, la gestion du budget d’exploration est cruciale pour les grands sites, car une exploration inefficace peut retarder la découverte et l’indexation du nouveau contenu. Les outils comme le rapport Crawl Stats de Google Search Console et l’analyse des logs serveurs révèlent exactement quelles pages sont visitées par Googlebot et à quelle fréquence, permettant une optimisation du budget d’exploration basée sur les données.

Les données structurées, mises en œuvre via le balisage schema, aident les moteurs de recherche à comprendre le sens et le contexte de votre contenu au-delà de la simple analyse du texte. Le balisage schema utilise un vocabulaire standardisé (schema.org) pour décrire différents types de contenu—produits, articles, recettes, événements, entreprises locales, etc. Lorsqu’il est correctement mis en œuvre, le balisage schema permet l’affichage de résultats enrichis dans la recherche, où Google affiche des informations supplémentaires comme des notes, des prix, des temps de cuisson ou des dates d’événements directement dans les résultats. Cette visibilité accrue peut significativement améliorer le taux de clics et l’engagement utilisateur. Différents types de contenu nécessitent des schémas différents : schema Article pour les blogs et actualités, schema Produit pour les pages e-commerce, schema FAQ pour les questions fréquentes, schema Local Business pour les points de vente physiques, et schema Event pour les événements à venir. La mise en œuvre utilise généralement le format JSON-LD, la méthode préférée de Google. Toutefois, le balisage doit refléter fidèlement le contenu réel de la page—un schema trompeur ou inventé peut entraîner des pénalités manuelles. Selon les recherches de Search Engine Land, seules les pages avec un balisage schema valide et pertinent peuvent obtenir des résultats enrichis, d’où l’importance de la précision de la mise en œuvre. Les organisations qui mettent en œuvre un balisage schema complet sur leurs pages stratégiques constatent souvent une meilleure visibilité dans la recherche traditionnelle et sur les plateformes IA, car ces systèmes s’appuient sur les données structurées pour comprendre et citer correctement le contenu.

Le HTTPS (Hypertext Transfer Protocol Secure) chiffre les données transmises entre le navigateur de l’utilisateur et votre serveur web, protégeant les informations sensibles et signalant la fiabilité aux utilisateurs comme aux moteurs de recherche. Google a confirmé que le HTTPS est un facteur de classement, et les sites sans HTTPS subissent à la fois des pénalités directes et des conséquences indirectes comme des avertissements de navigateur qui découragent l’engagement. Mettre en place le HTTPS nécessite l’obtention d’un certificat SSL/TLS auprès d’une autorité de certification reconnue et la configuration de votre serveur pour forcer le HTTPS sur toutes les pages. Au-delà de la mise en œuvre de base, des headers de sécurité comme Content-Security-Policy, Strict-Transport-Security et X-Content-Type-Options offrent une protection supplémentaire contre les vulnérabilités web courantes. Les erreurs de contenu mixte—lorsque des pages HTTPS chargent des ressources HTTP—compromettent la sécurité et peuvent déclencher des avertissements. Le lien entre sécurité et SEO va au-delà du classement : un site sécurisé inspire confiance, réduit le taux de rebond et améliore les conversions. Pour les sites e-commerce traitant des paiements, les plateformes SaaS avec données utilisateurs ou tout site collectant des informations personnelles, la sécurité n’est pas négociable. Des audits réguliers via le rapport Problèmes de sécurité de Google Search Console et des scanners tiers aident à identifier et corriger les failles avant qu’elles n’affectent le classement ou la confiance.

| Aspect | SEO technique | SEO on-page | SEO off-page |

|---|---|---|---|

| Objectif principal | Infrastructure du site, vitesse, explorabilité, indexabilité | Qualité du contenu, mots-clés, balises méta, titres | Backlinks, mentions de marque, signaux sociaux |

| Accès des moteurs de recherche | Garantit l’exploration et l’indexation des pages | Aide à comprendre la pertinence des pages | Construit l’autorité et les signaux de confiance |

| Éléments clés | Vitesse du site, optimisation mobile, Core Web Vitals, architecture, HTTPS, données structurées | Placement des mots-clés, profondeur du contenu, liens internes, meta descriptions | Profil de backlinks, autorité du domaine, mentions de marque |

| Outils utilisés | PageSpeed Insights, Google Search Console, Screaming Frog, Lighthouse | Yoast SEO, Surfer SEO, Content Genius | Ahrefs, Semrush, Moz, Majestic |

| Impact sur le classement | Fondamental—sans lui, les pages ne peuvent pas se classer | Direct—améliore la pertinence sur les mots-clés | Significatif—construit autorité et confiance |

| Impact sur l’expérience utilisateur | Élevé—impacte la vitesse, l’ergonomie et l’accessibilité | Moyen—impacte la lisibilité et l’engagement | Faible—indirect via la perception de la marque |

| Délais de mise en œuvre | Continu—nécessite suivi et optimisation permanents | Continu—mise à jour et optimisation du contenu | Long terme—stratégie de netlinking soutenue |

| Mesure du ROI | Efficacité de l’exploration, taux d’indexation, scores Core Web Vitals, classement | Classement mots-clés, trafic organique, taux de clics | Croissance des backlinks, autorité du domaine, trafic référent |

Le SEO JavaScript traite les défis spécifiques aux sites fortement basés sur JavaScript, aux applications monopage (SPA) et au rendu dynamique du contenu. Historiquement, Googlebot avait des difficultés avec JavaScript car il nécessitait un rendu—l’exécution du code JavaScript pour obtenir la page finale—ce qui ajoutait de la complexité et des délais à l’exploration. Le Googlebot moderne rend désormais la plupart des pages avant indexation, mais cela introduit de nouveaux enjeux techniques. Le rendu côté serveur (SSR) génère le HTML complet sur le serveur avant envoi au navigateur, assurant que les moteurs de recherche voient tout le contenu immédiatement, sans attendre l’exécution du JavaScript. La génération de sites statiques (SSG) pré-rend les pages lors de la compilation, créant des fichiers HTML statiques qui se chargent instantanément. Le rendu dynamique sert du HTML pré-rendu aux moteurs de recherche et du JavaScript aux utilisateurs, bien que Google considère cela comme une solution temporaire. Le principe clé : tout le contenu essentiel, les balises méta et les données structurées doivent être visibles dans le HTML initial, et non chargés dynamiquement après exécution du JavaScript. Les pages qui masquent des contenus critiques derrière du JavaScript risquent une indexation partielle ou retardée. Les frameworks React, Vue et Angular nécessitent une attention particulière—beaucoup d’organisations adoptent Next.js ou Nuxt.js spécifiquement pour gérer le rendu côté serveur et améliorer les performances SEO. Tester le rendu de vos pages via l’outil d’inspection d’URL de Google Search Console et l’aperçu rendu permet de vérifier si le contenu dépendant du JavaScript est bien indexé.

Pour être efficace, le SEO technique doit suivre une approche systématique qui priorise les optimisations à fort impact. Commencez par les éléments fondamentaux : assurez-vous que votre site est explorable en vérifiant le robots.txt et le maillage interne, contrôlez que les pages importantes sont indexables (pas de balises noindex ni de problèmes canoniques) et établissez une base de référence sur les performances Core Web Vitals. Ensuite, passez à l’optimisation des performances : compressez et optimisez les images, implémentez le lazy loading pour le contenu en dessous de la ligne de flottaison, reportez le JavaScript non critique et utilisez des CDNs pour accélérer la livraison. Puis, optimisez la structure du site : assurez-vous que les pages importantes sont accessibles en trois clics, implémentez une navigation à fil d’Ariane avec balisage schema et créez des schémas de liens internes clairs à la fois pour les utilisateurs et les moteurs de recherche. Implémentez les données structurées pour vos contenus clés—produits, articles, informations locales ou événements—en format JSON-LD et validez-les avec le test de résultats enrichis de Google. Surveillez en continu via Google Search Console pour les problèmes d’indexation, PageSpeed Insights pour les Core Web Vitals et les logs serveurs pour les schémas d’exploration. Rendez des comptes en suivant des métriques clés comme le nombre de pages indexées, les scores Core Web Vitals et l’efficacité de l’exploration dans le temps. Les organisations qui considèrent le SEO technique comme un processus continu et non un audit ponctuel surpassent systématiquement leurs concurrents en visibilité et expérience utilisateur.

À mesure que des plateformes de recherche pilotées par l’IA comme Google AI Overviews, Perplexity, ChatGPT et Claude prennent de l’importance, le SEO technique devient incontournable, au-delà même de la recherche Google classique. Ces systèmes IA s’appuient sur un contenu correctement indexé et bien structuré pour générer des réponses et citations. Le SEO technique permet à votre contenu d’être découvert et correctement interprété par l’IA via plusieurs mécanismes : une bonne indexation rend le contenu accessible à l’entraînement et à la récupération par l’IA, les données structurées aident à comprendre le contexte et le sens, et la richesse sémantique permet à l’IA de reconnaître votre contenu comme pertinent et faisant autorité. Selon des études de Conductor et Botify, les pages qui apparaissent dans AI Overviews proviennent majoritairement de sites techniquement solides, bien indexés et riches sémantiquement. La relation est à double sens : si le SEO classique vise le classement sur des mots-clés, la recherche IA vise à fournir des réponses complètes qui peuvent citer plusieurs sources. Cela signifie que le SEO technique doit soutenir les deux paradigmes—assurer l’indexation pour la recherche traditionnelle et une richesse sémantique suffisante pour l’IA. Les organisations qui surveillent leur visibilité sur plusieurs plateformes IA, via des outils comme AmICited, identifient quelles optimisations techniques améliorent le mieux leur taux de citation et leur visibilité dans les résultats génératifs.

Le SEO technique efficace nécessite le suivi de métriques spécifiques, indicatrices de la santé du site et de l’accessibilité pour les moteurs de recherche. Le nombre de pages indexées montre combien de pages prévues sont réellement dans l’index Google—le comparer au total des pages indexables donne votre ratio d’efficacité d’indexation. L’efficacité d’exploration mesure l’usage du budget d’exploration par Googlebot, calculé en divisant le nombre de pages explorées par le total de pages du site. Les scores Core Web Vitals indiquent la qualité de l’expérience utilisateur (vitesse, interactivité, stabilité visuelle). Les problèmes d’ergonomie mobile relevés dans Google Search Console informent sur les cibles tactiles trop petites, les erreurs de configuration du viewport ou les interstitiels intrusifs. La longueur des chaînes de redirection doit être minimisée pour préserver l’équité des liens et éviter les délais d’exploration. La couverture du balisage structuré montre le pourcentage de pages avec un schema valide. Les métriques de vitesse comme First Contentful Paint (FCP), Time to Interactive (TTI) et Total Blocking Time (TBT) donnent une vision détaillée des performances. Les organisations doivent établir des mesures de base, fixer des objectifs d’amélioration et suivre les progrès mensuellement ou par trimestre. Toute variation soudaine de ces indicateurs signale souvent un problème technique avant qu’il n’affecte le classement, permettant une correction proactive. Les outils comme Google Search Console, PageSpeed Insights, Lighthouse ou des plateformes comme Semrush fournissent des tableaux de bord complets pour surveiller ces métriques sur l’ensemble du site.

Le paysage du SEO technique évolue sans cesse au gré des mises à jour d’algorithme, des technologies émergentes et des changements de comportement utilisateur. L’indexation et le classement pilotés par l’IA influenceront de plus en plus quelles pages sont indexées et comment elles sont classées, le SEO technique devant alors faciliter la compréhension sémantique et la reconnaissance d’entités. Le edge computing et les architectures serverless permettent une diffusion plus rapide du contenu et une optimisation en temps réel à la périphérie du réseau, réduisant la latence et améliorant les Core Web Vitals. Un accent accru sur les signaux E-E-A-T (Expérience, Expertise, Autorité, Fiabilité) impose au SEO technique de soutenir la crédibilité via le balisage d’auteur, les dates de publication et les signaux de confiance. L’optimisation multi-surfaces deviendra la norme à mesure que les plateformes IA se multiplient, obligeant les sites à optimiser leur visibilité sur Google, Perplexity, ChatGPT, Claude et d’autres. Les analytics privacy-first et la collecte de données first-party transformeront la mesure de l’impact du SEO technique, en s’éloignant des cookies tiers vers le suivi côté serveur et la mesure fondée sur le consentement. La maturité des frameworks JavaScript continuera d’améliorer les capacités SEO, avec Next.js, Nuxt.js ou Remix devenant standards pour les applications SEO-friendly. L’automatisation du SEO technique grâce à l’IA permettra une détection et correction plus rapide des problèmes, avec des plateformes identifiant automatiquement et suggérant des corrections pour l’explorabilité, l’indexabilité et les performances. Les organisations restant à la pointe de ces tendances en modernisant en continu leur infrastructure technique et en surveillant les meilleures pratiques conserveront un avantage compétitif en visibilité organique.

Le SEO technique se concentre sur l’optimisation de l’infrastructure backend d’un site web—comme la vitesse du site, l’explorabilité, l’indexabilité et la configuration du serveur—pour aider les moteurs de recherche à découvrir et traiter le contenu. Le SEO on-page, en revanche, se concentre sur l’optimisation des éléments individuels de la page comme le placement des mots-clés, les balises méta, les titres et la qualité du contenu afin d’améliorer la pertinence pour des requêtes spécifiques. Alors que le SEO technique garantit l’accès des moteurs de recherche à votre site, le SEO on-page leur permet de comprendre de quoi parle votre contenu et pourquoi il est important pour les utilisateurs.

Les Core Web Vitals—Largest Contentful Paint (LCP), Interaction to Next Paint (INP) et Cumulative Layout Shift (CLS)—sont des facteurs de classement confirmés qui mesurent l’expérience utilisateur réelle. Selon les recherches de DebugBear, les sites web doivent offrir à 75 % des utilisateurs une expérience « Bonne » sur les trois indicateurs pour obtenir un maximum de bénéfices en termes de classement. De mauvaises Core Web Vitals peuvent entraîner des pénalités de classement, une baisse du taux de clics et un taux de rebond plus élevé, ce qui affecte directement la visibilité organique et l’engagement des utilisateurs.

L’explorabilité détermine si les robots des moteurs de recherche peuvent accéder à votre site et suivre les liens internes. Si Googlebot ne peut pas explorer vos pages à cause de ressources bloquées, d’une mauvaise structure de site ou de restrictions dans le fichier robots.txt, ces pages ne pourront pas être indexées ou classées. Sans explorabilité adéquate, même un contenu de haute qualité reste invisible pour les moteurs de recherche, rendant impossible toute visibilité organique quel que soit la qualité du contenu ou le profil de liens entrants.

Alors que des plateformes de recherche pilotées par l’IA comme Google AI Overviews et Perplexity prennent de l’ampleur, le SEO technique reste fondamental. Ces systèmes IA s’appuient sur un contenu correctement indexé, bien structuré et provenant de l’index de Google pour générer des réponses. Le SEO technique permet à votre contenu d’être découvert, correctement affiché et suffisamment riche sémantiquement pour être cité et référencé par les systèmes IA. Sans de solides bases techniques, votre contenu n’apparaîtra pas dans les AI Overviews ou d’autres résultats de recherche générative.

Pour la plupart des sites, il est recommandé de réaliser un audit SEO technique complet chaque trimestre, avec un suivi mensuel des problèmes critiques. Les sites d’entreprise de grande taille avec des mises à jour fréquentes devraient auditer chaque mois ou mettre en place des systèmes de surveillance continue. Après des changements majeurs sur le site, des migrations ou des refontes, des audits immédiats sont essentiels. Des audits réguliers permettent de détecter les problèmes tôt, avant qu’ils n’affectent le classement, assurant une explorabilité, une indexabilité et des performances optimales.

L’architecture du site détermine comment les moteurs de recherche naviguent et comprennent la hiérarchie de votre contenu. Une architecture bien optimisée garantit que les pages importantes sont accessibles en trois clics depuis la page d’accueil, distribue efficacement l’équité des liens et aide les moteurs de recherche à prioriser l’exploration du contenu à forte valeur ajoutée. Une mauvaise architecture peut entraîner des pages orphelines, un gaspillage du budget d’exploration et des difficultés à établir une autorité thématique, ce qui nuit au classement et à la visibilité.

La vitesse des pages a un impact direct sur le classement dans la recherche et sur le comportement des utilisateurs. Google a confirmé que les Core Web Vitals—qui mesurent la vitesse de chargement, l’interactivité et la stabilité visuelle—sont des facteurs de classement. Les pages lentes présentent des taux de rebond plus élevés, un engagement plus faible et des conversions réduites. Les études montrent que les pages se chargeant en moins de 2,5 secondes offrent une bien meilleure rétention des utilisateurs et de meilleures performances de classement par rapport aux pages plus lentes, ce qui rend l’optimisation de la vitesse essentielle à la réussite SEO.

Commencez à suivre comment les chatbots IA mentionnent votre marque sur ChatGPT, Perplexity et d'autres plateformes. Obtenez des informations exploitables pour améliorer votre présence IA.

Le SEO de contenu est la création stratégique et l’optimisation de contenus de haute qualité pour améliorer les classements dans les moteurs de recherche et la ...

Le SEO d'entreprise est la pratique consistant à optimiser de grands sites web complexes comprenant des milliers de pages pour les moteurs de recherche. Découvr...

Le SEO JavaScript optimise les sites web rendus par JavaScript pour l’exploration et l’indexation des moteurs de recherche. Découvrez les meilleures pratiques, ...