GPT-4

GPT-4 est le LLM multimodal avancé d'OpenAI combinant traitement de texte et d'image. Découvrez ses capacités, son architecture et son impact sur la surveillanc...

Une architecture de réseau de neurones basée sur des mécanismes d’auto-attention multi-têtes qui traite les données séquentielles en parallèle, permettant le développement des grands modèles de langage modernes comme ChatGPT, Claude et Perplexity. Introduite dans l’article de 2017 « Attention is All You Need », les transformers sont devenus la technologie fondamentale à la base de quasiment tous les systèmes d’IA de pointe.

Une architecture de réseau de neurones basée sur des mécanismes d’auto-attention multi-têtes qui traite les données séquentielles en parallèle, permettant le développement des grands modèles de langage modernes comme ChatGPT, Claude et Perplexity. Introduite dans l’article de 2017 « Attention is All You Need », les transformers sont devenus la technologie fondamentale à la base de quasiment tous les systèmes d’IA de pointe.

L’architecture Transformer est une conception révolutionnaire de réseau de neurones introduite dans l’article de 2017 « Attention is All You Need » par des chercheurs de Google. Elle repose fondamentalement sur des mécanismes d’auto-attention multi-têtes qui permettent aux modèles de traiter des séquences entières de données en parallèle, plutôt que de façon séquentielle. L’architecture consiste en des couches encodeur et décodeur empilées, chacune contenant des sous-couches d’auto-attention et des réseaux de neurones feed-forward, reliées par des connexions résiduelles et une normalisation de couche. L’architecture Transformer est devenue la technologie fondamentale qui sous-tend quasiment tous les grands modèles de langage (LLMs) modernes, y compris ChatGPT, Claude, Perplexity et Google AI Overviews, ce qui en fait sans doute l’innovation en réseau de neurones la plus importante de la dernière décennie.

La portée de l’architecture Transformer va bien au-delà de son élégance technique. L’article « Attention is All You Need » de 2017 a été cité plus de 208 000 fois, ce qui en fait l’un des articles de recherche les plus influents de l’histoire du machine learning. Cette architecture a fondamentalement changé la façon dont les systèmes d’IA traitent et comprennent le langage, permettant le développement de modèles avec des milliards de paramètres capables de raisonnement sophistiqué, d’écriture créative et de résolution de problèmes complexes. Le marché des LLMs en entreprise, bâti presque entièrement sur la technologie transformer, était évalué à 6,7 milliards $ en 2024 et devrait croître à un taux annuel composé de 26,1% jusqu’en 2034, illustrant l’importance critique de l’architecture dans l’infrastructure moderne de l’IA.

Le développement de l’architecture Transformer représente un moment charnière dans l’histoire du deep learning, fruit de décennies de recherche sur les réseaux de neurones pour le traitement des données séquentielles. Avant les transformers, les réseaux de neurones récurrents (RNN) et leurs variantes, notamment les réseaux LSTM (Long Short-Term Memory), dominaient les tâches de traitement du langage naturel. Cependant, ces architectures avaient des limites fondamentales : elles traitaient les séquences de manière séquentielle, un élément à la fois, ce qui les rendait lentes à entraîner et peu efficaces pour capturer les dépendances entre des éléments distants d’une longue séquence. Le problème du gradient qui s’annule limitait encore davantage la capacité des RNN à apprendre des relations à longue portée, les gradients devenant exponentiellement plus petits lorsqu’ils se propageaient à travers de nombreuses couches.

L’introduction des mécanismes d’attention en 2014 par Bahdanau et ses collègues a constitué une percée, permettant aux modèles de se concentrer sur des parties pertinentes des séquences d’entrée indépendamment de leur distance. Mais l’attention était d’abord utilisée comme un complément aux RNN plutôt qu’un remplacement. L’article Transformer de 2017 a poussé ce concept plus loin, proposant que l’attention est tout ce dont on a besoin — c’est-à-dire qu’une architecture complète de réseau de neurones pouvait être construite uniquement sur les mécanismes d’attention et les couches feed-forward, en éliminant totalement la récurrence. Cette intuition s’est révélée transformatrice. En supprimant le traitement séquentiel, les transformers ont permis une parallélisation massive, permettant l’entraînement sur des volumes de données sans précédent avec des GPU et des TPU. Le plus grand modèle transformer de l’article original, entraîné sur 8 GPU pendant 3,5 jours, a démontré que l’échelle et la parallélisation pouvaient conduire à des performances spectaculairement améliorées.

Après l’article fondateur, l’architecture a évolué rapidement. BERT (Bidirectional Encoder Representations from Transformers), publié par Google en 2019, a montré que les encodeurs transformers pouvaient être pré-entraînés sur d’immenses corpus textuels puis adaptés à des tâches variées. Le plus grand modèle BERT comptait 345 millions de paramètres et a été entraîné sur 64 TPU spécialisés pendant quatre jours pour un coût estimé à 7 000 $, tout en établissant de nouveaux records sur de nombreux benchmarks de compréhension du langage. Parallèlement, la série GPT d’OpenAI a suivi une autre voie, utilisant des architectures transformer décodeur-seul entraînées sur des tâches de modélisation du langage. GPT-2, avec 1,5 milliard de paramètres, a surpris la communauté en démontrant que la seule modélisation du langage pouvait produire des systèmes remarquablement compétents. GPT-3, fort de 175 milliards de paramètres, a révélé des capacités émergentes — des aptitudes n’apparaissant qu’à très grande échelle, comme le few-shot learning et le raisonnement complexe — qui ont fondamentalement changé les attentes envers les systèmes d’IA.

L’architecture Transformer comprend plusieurs composants techniques interconnectés qui permettent le traitement parallèle efficace et la compréhension sophistiquée du contexte. La couche d’embedding d’entrée convertit les tokens discrets (mots ou sous-unités) en vecteurs continus, généralement de dimension 512 ou plus. Ces embeddings sont enrichis par un encodage positionnel, qui ajoute des informations sur la position de chaque token dans la séquence à l’aide de fonctions sinusoïdales et cosinus à différentes fréquences. Cette information positionnelle est essentielle car, contrairement aux RNN qui préservent naturellement l’ordre des séquences via leur structure récurrente, les transformers traitent tous les tokens simultanément et nécessitent des signaux explicites de position pour comprendre l’ordre des mots et les distances relatives.

Le mécanisme d’auto-attention est l’innovation architecturale qui distingue les transformers de toutes les conceptions précédentes. Pour chaque token de la séquence d’entrée, le modèle calcule trois vecteurs : un vecteur Query (ce que le token cherche à savoir), des vecteurs Key (ce que chaque token contient comme information), et des vecteurs Value (l’information à transmettre). Le mécanisme d’attention calcule un score de similarité entre le Query de chaque token et tous les Keys à l’aide de produits scalaires, normalise ces scores avec softmax pour créer des poids d’attention entre 0 et 1, puis utilise ces poids pour créer une somme pondérée des Value. Ce processus permet à chaque token de se concentrer sélectivement sur d’autres tokens pertinents, donnant au modèle la capacité de comprendre le contexte et les relations.

L’attention multi-têtes étend ce concept en exécutant plusieurs mécanismes d’attention en parallèle, en général 8, 12 ou 16 têtes. Chaque tête opère sur des projections linéaires différentes des vecteurs Query, Key et Value, permettant au modèle de s’attarder sur des types variés de relations et de motifs dans différents sous-espaces de représentation. Par exemple, une tête peut se focaliser sur les relations syntaxiques, une autre sur les relations sémantiques ou les dépendances à longue portée. Les sorties de toutes les têtes sont concaténées puis transformées linéairement, ce qui fournit au modèle une information contextuelle riche et variée. Cette approche s’est révélée d’une efficacité remarquable, la recherche montrant que différentes têtes se spécialisent dans des phénomènes linguistiques distincts.

La structure encodeur-décodeur organise ces mécanismes d’attention en un pipeline hiérarchique. L’encodeur consiste en plusieurs couches empilées (généralement 6 ou plus), chacune contenant une sous-couche d’auto-attention multi-têtes suivie d’un réseau feed-forward appliqué position par position. Les connexions résiduelles autour de chaque sous-couche permettent au gradient de circuler aisément pendant l’entraînement, améliorant la stabilité et permettant des architectures plus profondes. La normalisation de couche est appliquée après chaque sous-couche, normalisant les activations pour garder des échelles cohérentes dans tout le réseau. Le décodeur a une structure similaire mais inclut une couche d’attention encodeur-décodeur supplémentaire qui permet au décodeur de s’attarder sur les sorties de l’encodeur, ce qui aide à se concentrer sur les parties pertinentes de l’entrée lors de la génération de chaque token. Dans les architectures décodeur-seul comme GPT, le décodeur génère les tokens de sortie de façon auto-régressive, chaque nouveau token étant conditionné par tous les tokens précédemment générés.

| Aspect | Architecture Transformer | RNN/LSTM | Réseaux de Neurones Convolutifs (CNN) |

|---|---|---|---|

| Méthode de traitement | Traitement parallèle des séquences entières via attention | Traitement séquentiel, un élément à la fois | Convolutions locales sur fenêtres de taille fixe |

| Dépendances à longue portée | Excellente ; l’attention relie directement des tokens distants | Faible ; limité par le gradient qui s’annule et le goulot d’étranglement séquentiel | Limité ; champ réceptif local nécessite de nombreuses couches |

| Vitesse d’entraînement | Très rapide ; parallélisation massive sur GPU/TPU | Lent ; le traitement séquentiel empêche la parallélisation | Rapide pour les entrées de taille fixe ; moins adapté aux séquences variables |

| Besoins mémoire | Élevés ; quadratique selon la longueur de la séquence (attention) | Plus faibles ; linéaire avec la longueur de séquence | Modérés ; dépend de la taille du noyau et de la profondeur |

| Scalabilité | Excellente ; s’adapte à des milliards de paramètres | Limitée ; difficile d’entraîner de très grands modèles | Bonne pour les images ; moins adaptée aux séquences |

| Applications typiques | Modélisation du langage, traduction, génération de texte | Séries temporelles, prédiction séquentielle (moins commun aujourd’hui) | Classification d’images, détection d’objets, vision par ordinateur |

| Propagation du gradient | Stable ; connexions résiduelles pour des réseaux très profonds | Problématique ; gradients qui s’annulent/explosent | Généralement stable ; connexions locales aident la propagation |

| Information de position | Encodage positionnel explicite requis | Implicite via le traitement séquentiel | Implicite via la structure spatiale |

| LLMs de pointe | GPT, Claude, Llama, Granite, Perplexity | Rarement utilisés dans les LLMs modernes | Jamais utilisés pour la modélisation du langage |

La relation entre l’architecture Transformer et les grands modèles de langage modernes est fondamentale et indissociable. Tous les principaux LLMs lancés ces cinq dernières années — y compris GPT-4 d’OpenAI, Claude d’Anthropic, Llama de Meta, Gemini de Google, Granite d’IBM et les modèles IA de Perplexity — sont bâtis sur l’architecture transformer. La capacité de l’architecture à s’adapter efficacement à la fois à la taille du modèle et aux données d’entraînement s’est avérée essentielle pour obtenir les capacités qui définissent l’IA moderne. En augmentant la taille des modèles de millions à des milliards, puis à des centaines de milliards de paramètres, la parallélisation et les mécanismes d’attention des transformers ont permis cet agrandissement sans augmentation proportionnelle du temps d’entraînement.

Le décodage auto-régressif utilisé par la plupart des LLMs modernes est une application directe du décodeur transformer. Lors de la génération de texte, ces modèles traitent l’invite via l’encodeur (ou, dans les modèles décodeur-seul, via l’ensemble du décodeur), puis produisent les tokens un à un. Chaque nouveau token est généré en calculant une distribution de probabilités sur tout le vocabulaire avec softmax, le modèle sélectionnant le token le plus probable (ou en échantillonnant selon les réglages de température). Ce processus, répété des centaines ou milliers de fois, produit des textes cohérents et contextuellement pertinents. Le mécanisme d’auto-attention permet au modèle de maintenir le contexte sur toute la séquence générée, autorisant la production de passages longs, thématiques et logiques.

Les capacités émergentes observées dans les grands modèles transformer — comme le few-shot learning, le chain-of-thought reasoning, et l’apprentissage en contexte — découlent directement de la conception de l’architecture. L’attention multi-têtes permet de capturer des relations diverses, et, combinée à un nombre massif de paramètres et à un apprentissage sur des données variées, d’accomplir des tâches pour lesquelles le modèle n’a pas été explicitement entraîné. Par exemple, GPT-3 pouvait effectuer des calculs, écrire du code ou répondre à des questions de culture générale alors qu’il n’a été entraîné que sur de la modélisation du langage. Ces propriétés émergentes ont fait des LLMs à base de transformers la fondation de la révolution IA, avec des applications allant de l’IA conversationnelle et la génération de contenu à la synthèse de code et l’assistance à la recherche scientifique.

Le mécanisme d’auto-attention est l’innovation architecturale qui distingue fondamentalement les transformers et explique leur supériorité par rapport aux approches précédentes. Pour comprendre l’auto-attention, pensez à la difficulté d’interpréter des pronoms ambigus. Dans la phrase « Le trophée ne rentre pas dans la valise parce qu’il est trop grand », le pronom « il » peut désigner soit le trophée, soit la valise, mais le contexte indique le trophée. Dans « Le trophée ne rentre pas dans la valise parce qu’elle est trop petite », le pronom désigne cette fois la valise. Un modèle transformer doit apprendre à lever ces ambiguïtés en comprenant les relations entre les mots.

L’auto-attention accomplit cela via un processus mathématique élégant. Pour chaque token de la séquence d’entrée, le modèle calcule un vecteur Query en multipliant l’embedding du token par une matrice de poids WQ apprise. De même, il calcule les vecteurs Key (avec WK) et Value (avec WV) pour tous les tokens. Le score d’attention entre le Query d’un token et le Key d’un autre s’obtient par produit scalaire, normalisé par la racine carrée de la dimension des clés (généralement √64 ≈ 8). Ces scores sont ensuite normalisés par softmax pour donner des poids d’attention qui totalisent 1. Enfin, la sortie de chaque token est calculée comme une somme pondérée de tous les Value, selon ces poids d’attention. Ce processus permet à chaque token d’agréger sélectivement l’information de tous les autres tokens, les poids étant appris pour capturer des relations pertinentes.

L’élégance mathématique de l’auto-attention permet un calcul efficace. Tout le processus s’exprime en opérations matricielles : Attention(Q, K, V) = softmax(QK^T / √d_k)V, où Q, K, V sont des matrices contenant tous les vecteurs query, key et value. Cette formulation matricielle autorise l’accélération GPU, permettant aux transformers de traiter des séquences entières en parallèle plutôt que séquentiellement. Une séquence de 512 tokens peut être traitée presque aussi vite qu’un seul token dans un RNN, ce qui rend l’entraînement des transformers bien plus rapide. Cette efficacité computationnelle, alliée à la capacité de l’attention à capter les dépendances à longue portée, explique la domination de l’architecture pour la modélisation du langage.

L’attention multi-têtes étend l’auto-attention en effectuant plusieurs opérations d’attention en parallèle, chacune apprenant des aspects différents des relations entre tokens. Dans un transformer typique à 8 têtes, les embeddings d’entrée sont projetés linéairement dans 8 sous-espaces de représentation différents, chacun avec ses propres matrices de poids Query, Key, Value. Chaque tête calcule indépendamment ses poids d’attention et produit des sorties. Celles-ci sont ensuite concaténées et transformées linéairement, produisant la sortie finale multi-têtes. Cette architecture permet au modèle de prêter attention simultanément à des informations provenant de différents sous-espaces de représentation à différentes positions.

Des analyses de modèles transformers entraînés ont révélé que différentes têtes d’attention se spécialisent dans des phénomènes linguistiques variés. Certaines têtes se concentrent sur les relations syntaxiques, apprenant à relier des mots grammaticalement liés (par exemple, les verbes à leurs sujets/compléments). D’autres se focalisent sur les relations sémantiques, reliant des mots de sens proche. D’autres encore captent des dépendances longues, reliant des mots éloignés dans la séquence mais liés sémantiquement. Certaines têtes agissent même comme une identité, n’attendant que le token lui-même. Cette spécialisation émerge naturellement lors de l’entraînement, sans supervision explicite, illustrant le pouvoir de l’architecture multi-têtes à apprendre des représentations complémentaires et variées.

Le nombre de têtes d’attention est un hyperparamètre clé. Les grands modèles utilisent généralement davantage de têtes (16, 32 ou plus), ce qui leur permet de capturer une plus grande diversité de relations. Cependant, la dimension totale de l’attention reste généralement constante, donc davantage de têtes implique une dimension par tête plus faible. Ce choix équilibre la variété des sous-espaces de représentation et l’efficacité computationnelle. L’approche multi-têtes est devenue la norme dans tous les transformers modernes, de BERT et GPT aux architectures spécialisées pour la vision, l’audio ou le multimodal.

L’architecture transformer originale, telle que décrite dans « Attention is All You Need », utilise une structure encodeur-décodeur optimisée pour les tâches séquence-à-séquence comme la traduction automatique. L’encodeur traite la séquence d’entrée et produit une séquence de représentations riches en contexte. Chaque couche encodeur comporte deux éléments principaux : une sous-couche d’auto-attention multi-têtes permettant aux tokens de s’attarder sur d’autres tokens de la séquence d’entrée, et un réseau feed-forward positionnel appliquant une transformation non linéaire à chaque position. Ces sous-couches sont reliées par des connexions résiduelles (ou skip connections), qui ajoutent l’entrée à la sortie de chaque sous-couche. Ce choix, inspiré des réseaux résiduels en vision, autorise l’entraînement de réseaux très profonds en facilitant la circulation du gradient.

Le décodeur génère la séquence de sortie un token à la fois, en utilisant à la fois les informations de l’encodeur et les tokens déjà générés. Chaque couche décodeur contient trois principaux éléments : une sous-couche d’auto-attention masquée (qui ne permet à chaque token de s’attarder que sur les précédents pour empêcher la triche lors de l’entraînement), une sous-couche d’attention encodeur-décodeur (pour s’attarder sur les sorties de l’encodeur), et un réseau feed-forward positionnel. Le masquage dans l’auto-attention est crucial : il interdit toute fuite d’information depuis les positions futures, garantissant que la prédiction d’une position i dépend seulement des sorties aux positions <i. Cette structure auto-régressive est essentielle pour la génération séquentielle.

L’architecture encodeur-décodeur s’avère particulièrement efficace pour les tâches où l’entrée et la sortie diffèrent en structure ou en longueur : traduction, résumé, question/réponse. Cependant, les LLMs modernes comme GPT utilisent des architectures décodeur-seul, dans lesquelles une seule pile de couches décodeur traite à la fois l’invite et la génération de texte. Cette simplification réduit la complexité et s’est révélée aussi, voire plus, efficace pour la modélisation du langage, probablement car le modèle peut apprendre à utiliser l’auto-attention pour traiter l’entrée et générer la sortie de façon unifiée.

Un défi majeur de l’architecture Transformer est de représenter l’ordre des tokens dans une séquence. Contrairement aux RNN, qui le préservent par leur structure, les transformers traitent tous les tokens en parallèle et n’ont aucune notion innée de position. Sans information explicite, un transformer traiterait « Le chat est assis sur le tapis » comme « tapis le sur assis est chat le », ce qui serait catastrophique pour la compréhension. La solution est l’encodage positionnel, qui ajoute un vecteur dépendant de la position à chaque embedding avant traitement.

L’article fondateur propose un encodage positionnel sinusoïdal, où le vecteur de position pour la position pos et la dimension i est calculé comme :

Ces fonctions sinusoïdales créent un motif unique pour chaque position, avec différentes fréquences selon la dimension. Les basses fréquences varient lentement, captant l’information globale, tandis que les hautes fréquences varient rapidement, captant les détails fins. Cette conception a plusieurs avantages : elle généralise naturellement à des séquences plus longues que lors de l’entraînement, fournit des transitions douces et permet au modèle d’apprendre les relations de position relative. Les vecteurs d’encodage positionnel sont simplement ajoutés aux embeddings avant la première couche d’attention, et le modèle apprend à utiliser ces informations lors de l’entraînement.

Des alternatives ont été proposées, comme l’encodage de position relative (qui encode les distances entre tokens) ou les rotary position embeddings (RoPE) (qui font tourner les vecteurs embedding selon la position). Ces alternatives montrent des gains sur les séquences très longues ou en cas d’adaptation à des séquences plus grandes que celles vues à l’entraînement. Le choix de l’encodage positionnel a donc un impact significatif sur les performances et reste un sujet actif de recherche.

Comprendre l’architecture Transformer est essentiel pour comprendre comment les systèmes d’IA modernes génèrent les réponses visibles sur des plateformes comme ChatGPT, Claude, Perplexity et Google AI Overviews. Tous reposent sur la technologie transformer et traitent les requêtes utilisateurs via de multiples couches d’auto-attention, ce qui leur permet de comprendre le contexte et de générer des réponses cohérentes et pertinentes. Quand un utilisateur pose une question sur une marque, un produit ou un domaine, les mécanismes d’attention du modèle déterminent quelles parties de ses données d’entraînement sont les plus pertinentes, puis le décodeur génère une réponse susceptible de mentionner la marque.

Pour les organisations utilisant des plateformes de surveillance IA comme AmICited, comprendre l’architecture transformer éclaire la façon d’interpréter la présence d’une marque dans le contenu généré par l’IA. La capacité de l’auto-attention à capter les relations entre concepts fait que les marques mentionnées dans les données d’entraînement seront associées à des sujets, des industries ou des usages spécifiques. Lorsqu’un utilisateur interroge une IA sur ces sujets, l’attention peut activer ces liens avec la marque, générant ainsi des mentions. La structure multi-têtes implique que divers aspects de la présence de la marque dans les données d’entraînement puissent être capturés par différentes têtes, ce qui influence la compréhension et la représentation de la marque.

La dépendance de l’architecture transformer à la qualité des données d’entraînement explique pourquoi la visibilité de la marque dans les sorties IA dépend fortement de la qualité et de la quantité de votre présence en ligne. Les modèles entraînés sur le texte du web auront une représentation plus riche des marques à la présence en ligne étoffée, avec des contenus de qualité, des mentions fréquentes sur des sources réputées et des associations sémantiques fortes avec des sujets pertinents. Les organisations qui souhaitent accroître leur visibilité dans les réponses IA doivent comprendre qu’elles optimisent en réalité leur inclusion dans les données d’entraînement des futurs modèles transformer. Cette compréhension fait le pont entre le SEO traditionnel et ce que l’on pourrait appeler le « GEO » (Generative Engine Optimization) — optimiser sa visibilité dans les systèmes génératifs d’IA.

L’architecture Transformer continue d’évoluer rapidement, les chercheurs développant de nombreuses variantes et améliorations. Les transformers efficaces s’attaquent à la complexité quadratique de la mémoire de l’attention standard (qui croît avec le carré de la longueur de séquence) via l’attention clairsemée, les fenêtres locales, ou les approximations linéaires. Ces innovations permettent de traiter des séquences bien plus longues — des milliers à des millions de tokens — ouvrant la voie au traitement de documents, de bases de code ou de bases de connaissances entières en un seul passage. Les architectures Mixture of Experts (MoE), comme le Switch Transformer de Google, remplacent les réseaux feed-forward denses par des réseaux clairsemés où seul un sous-ensemble de paramètres est activé pour chaque token, augmentant considérablement la capacité du modèle sans coût computationnel proportionnel.

Les transformers multimodaux étendent l’architecture au traitement et à la génération de plusieurs types de données simultanément. Les Vision Transformers (ViTs) appliquent le transformer à l’image en découpant celle-ci en patchs assimilés à des tokens, atteignant l’état de l’art en classification et détection visuelle. Les modèles multimodaux comme GPT-4V et Claude 3 traitent texte et image via une architecture transformer unifiée, permettant la compréhension d’images et les questions visuelles. Des transformers audio traitent la parole et la musique, tandis que des transformers vidéo analysent des séquences de frames. Cette capacité multimodale suggère que le transformer pourrait devenir l’architecture universelle de l’IA, quel que soit le type de donnée.

Les implications stratégiques de la domination du transformer sont profondes. Les organisations développant de l’IA doivent comprendre ses capacités et ses limites pour choisir, adapter et déployer les modèles de façon optimale. La soif de données de l’architecture fait de la qualité et diversité des données d’entraînement un avantage concurrentiel clé. L’interprétabilité relative de l’attention (par rapport aux autres approches de deep learning) ouvre la voie à l’IA explicable et à la détection des biais, même si l’attention seule n’explique pas tout le comportement du

L’architecture Transformer traite des séquences entières en parallèle à l’aide de l’auto-attention, tandis que les RNN et LSTM traitent les séquences de manière séquentielle, un élément à la fois. Cette parallélisation rend les transformers nettement plus rapides à entraîner et meilleurs pour capturer les dépendances à longue distance entre des mots ou tokens éloignés. Les transformers évitent également le problème du gradient qui s’annule, ce qui permet d’apprendre efficacement à partir de séquences bien plus longues.

L’auto-attention calcule trois vecteurs (Query, Key et Value) pour chaque token dans la séquence d’entrée. Le vecteur Query d’un token est comparé aux vecteurs Key de tous les tokens pour déterminer des scores de pertinence, qui sont normalisés avec softmax. Ces poids d’attention sont ensuite appliqués aux vecteurs Value pour créer des représentations tenant compte du contexte. Ce mécanisme permet à chaque token de « s’attarder sur » ou se concentrer sur d’autres tokens pertinents dans la séquence, permettant au modèle de comprendre le contexte et les relations.

Les principaux composants incluent : (1) l’encodage des entrées et l’encodage positionnel pour représenter les tokens et leurs positions, (2) des couches d’auto-attention multi-têtes qui calculent l’attention sur plusieurs sous-espaces de représentation, (3) des réseaux de neurones feed-forward appliqués indépendamment à chaque position, (4) un empilement d’encodeurs qui traite les séquences d’entrée, (5) un empilement de décodeurs qui génère les séquences de sortie, et (6) des connexions résiduelles et une normalisation de couche pour la stabilité de l’entraînement. Ces composants fonctionnent ensemble pour permettre un traitement parallèle efficace et la compréhension du contexte.

L’architecture Transformer excelle pour les LLMs car elle permet le traitement en parallèle de séquences entières, réduisant considérablement le temps d’entraînement par rapport aux RNN séquentiels. Elle capture les dépendances à longue portée plus efficacement grâce à l’auto-attention, permettant aux modèles de comprendre le contexte à l’échelle de documents entiers. L’architecture s’adapte également efficacement à des ensembles de données et à des paramètres plus volumineux, ce qui s’avère essentiel pour entraîner des modèles comportant des milliards de paramètres et présentant des capacités émergentes.

L’attention multi-têtes exécute plusieurs mécanismes d’attention en parallèle (généralement 8 ou 16 têtes), chacun opérant sur différents sous-espaces de représentation. Chaque tête apprend à se concentrer sur différents types de relations et de motifs dans les données. Les sorties de toutes les têtes sont concaténées et transformées linéairement, permettant au modèle de capturer des informations contextuelles variées. Cette approche améliore considérablement la capacité du modèle à comprendre des relations complexes et améliore les performances globales.

L’encodage positionnel ajoute des informations sur la position des tokens aux embeddings d’entrée à l’aide de fonctions sinusoïdales et cosinus à différentes fréquences. Les transformers traitant tous les tokens en parallèle (contrairement aux RNN séquentiels), ils ont besoin d’une information explicite sur la position pour comprendre l’ordre des mots. Les vecteurs d’encodage positionnel sont ajoutés aux embeddings des tokens avant traitement, permettant au modèle d’apprendre l’effet de la position sur le sens et de généraliser à des séquences plus longues que celles vues durant l’entraînement.

L’encodeur traite la séquence d’entrée et crée des représentations contextuelles riches via plusieurs couches d’auto-attention et de réseaux feed-forward. Le décodeur génère la séquence de sortie un token à la fois, en utilisant l’attention encodeur-décodeur pour se concentrer sur les parties pertinentes de l’entrée. Cette structure est particulièrement utile pour les tâches séquence-à-séquence comme la traduction automatique, mais les LLMs modernes utilisent souvent des architectures décodeur seul pour les tâches de génération de texte.

L’architecture Transformer alimente les systèmes d’IA qui génèrent des réponses sur des plateformes comme ChatGPT, Claude, Perplexity et Google AI Overviews. Comprendre comment les transformers traitent et génèrent du texte est crucial pour les plateformes de surveillance de l’IA comme AmICited, qui suivent les apparitions de marques et de domaines dans les réponses générées par l’IA. La capacité de l’architecture à comprendre le contexte et à générer un texte cohérent affecte directement la façon dont les marques sont mentionnées et représentées dans les sorties d’IA.

Commencez à suivre comment les chatbots IA mentionnent votre marque sur ChatGPT, Perplexity et d'autres plateformes. Obtenez des informations exploitables pour améliorer votre présence IA.

GPT-4 est le LLM multimodal avancé d'OpenAI combinant traitement de texte et d'image. Découvrez ses capacités, son architecture et son impact sur la surveillanc...

ChatGPT est l’assistant IA conversationnel d’OpenAI, propulsé par les modèles GPT. Découvrez son fonctionnement, son impact sur le monitoring de l’IA, la visibi...

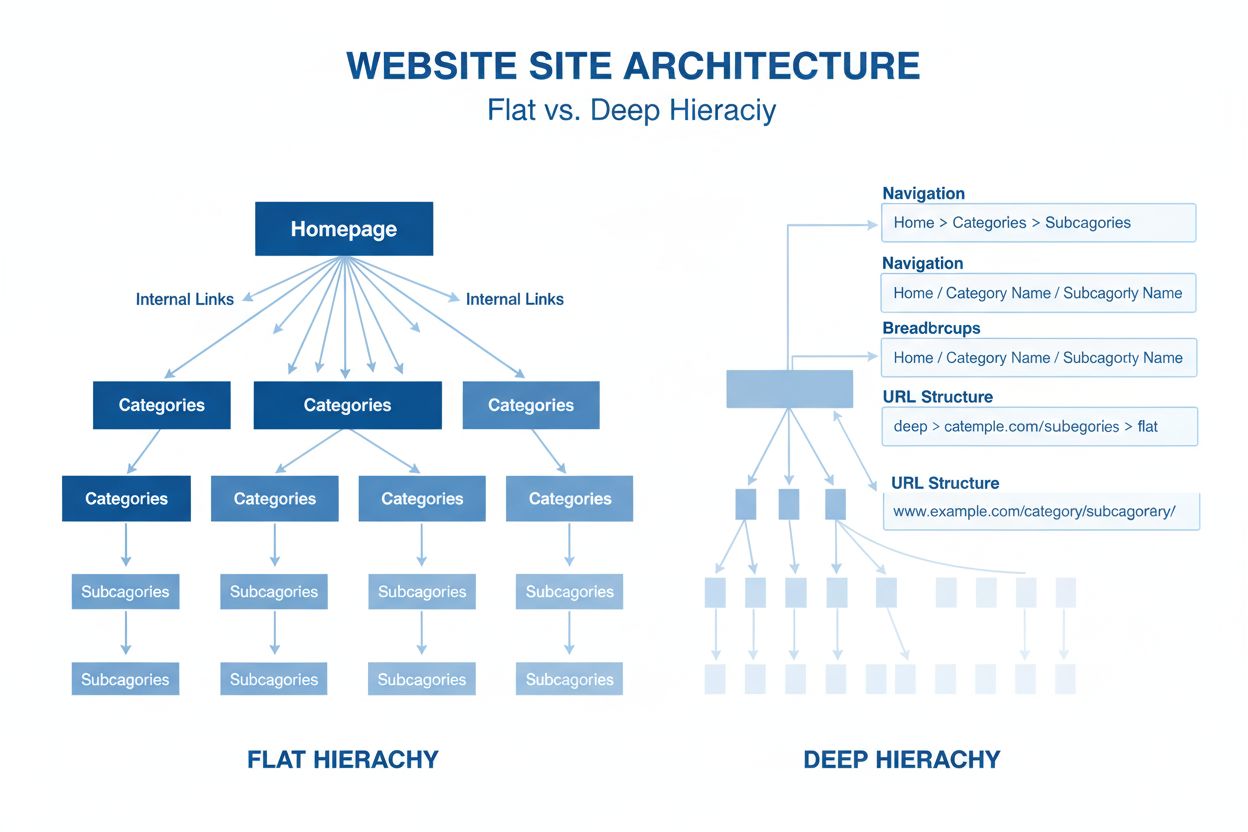

L’architecture de site est l’organisation hiérarchique des pages et du contenu d’un site web. Découvrez comment une structure de site appropriée améliore le SEO...